港科大&MSRA研究:關于圖像到圖像轉換,F(xiàn)inetuning is all you need

許多內容制作項目需要將簡單的草圖轉換為逼真的圖片,這就涉及圖像到圖像的轉換(image-to-image translation),它使用深度生成模型學習給定輸入的自然圖片的條件分布。

圖像到圖像轉換的基本概念是利用預訓練的神經網絡來捕捉自然圖片流形(manifold)。圖像轉換類似于遍歷流形并定位可行的輸入語義點。系統(tǒng)使用許多圖片對合成網絡進行預訓練,以從其潛在空間的任何采樣中提供可靠的輸出。通過預訓練的合成網絡,下游訓練將用戶輸入調整為模型的潛在表征。

多年來,我們已經看到許多特定于任務的方法達到了 SOTA 水平,但目前的解決方案還是難以創(chuàng)建用于實際使用的高保真圖片。

在最近的一篇論文中,香港科技大學和微軟亞洲研究院的研究者認為,對于圖像到圖像的轉換,預訓練才是 All you need。以往方法需要專門的架構設計,并從頭開始訓練單個轉換模型,因而難以高質量地生成復雜場景,尤其是在配對訓練數(shù)據(jù)不充足的情況下。

因此,研究者將每個圖像到圖像的轉換問題視為下游任務,并引入了一個簡單通用框架,該框架采用預訓練的擴散模型來適應各種圖像到圖像的轉換。他們將提出的預訓練圖像到圖像轉換模型稱為 PITI(pretraining-based image-to-image translation)。此外,研究者還提出用對抗訓練來增強擴散模型訓練中的紋理合成,并與歸一化指導采樣結合以提升生成質量。

最后,研究者在 ADE20K、COCO-Stuff 和 DIODE 等具有挑戰(zhàn)性的基準上對各種任務進行了廣泛的實證比較,表明 PITI 合成的圖像顯示出了前所未有的真實感和忠實度。

- 論文鏈接:https://arxiv.org/pdf/2205.12952.pdf

- 項目主頁:https://tengfei-wang.github.io/PITI/index.html

GAN 已死,擴散模型永存

作者沒有使用在特定領域表現(xiàn)最佳的 GAN,而是使用了擴散模型,合成了廣泛多樣的圖片。其次,它應該從兩種類型的潛在代碼中生成圖片:一種描述視覺語義,另一種針對圖像波動進行調整。語義、低維潛在對于下游任務至關重要。否則,就不可能將模態(tài)輸入轉換為復雜的潛在空間。鑒于此,他們使用 GLIDE 作為預訓練的生成先驗,這是一種可以生成不同圖片的數(shù)據(jù)驅動模型。由于 GLIDE 使用了潛在的文本,它允許語義潛在空間。

擴散和基于分數(shù)的方法表現(xiàn)出跨基準的生成質量。在類條件 ImageNet 上,這些模型在視覺質量和采樣多樣性方面與基于 GAN 的方法相媲美。最近,用大規(guī)模文本圖像配對訓練的擴散模型顯示出驚人的能力。訓練有素的擴散模型可以為合成提供通用的生成先驗。

框架

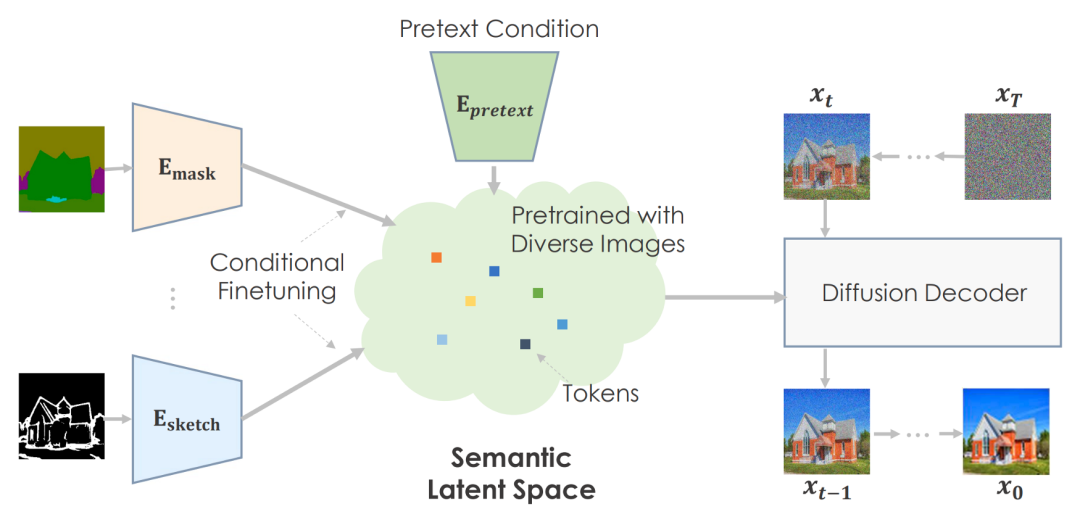

作者可以使用前置(pretext)任務對大量數(shù)據(jù)進行預訓練,并開發(fā)一個非常有意義的潛在空間來預測圖片統(tǒng)計。

對于下游任務,他們有條件地微調語義空間以映射特定于任務的環(huán)境。該機器根據(jù)預先訓練的信息創(chuàng)建可信的視覺效果。

作者建議使用語義輸入對擴散模型進行預訓練。他們使用文本條件、圖像訓練的 GLIDE 模型。Transformer 網絡對文本輸入進行編碼,并為擴散模型輸出 token。按照計劃,文本嵌入空間是有意義的。

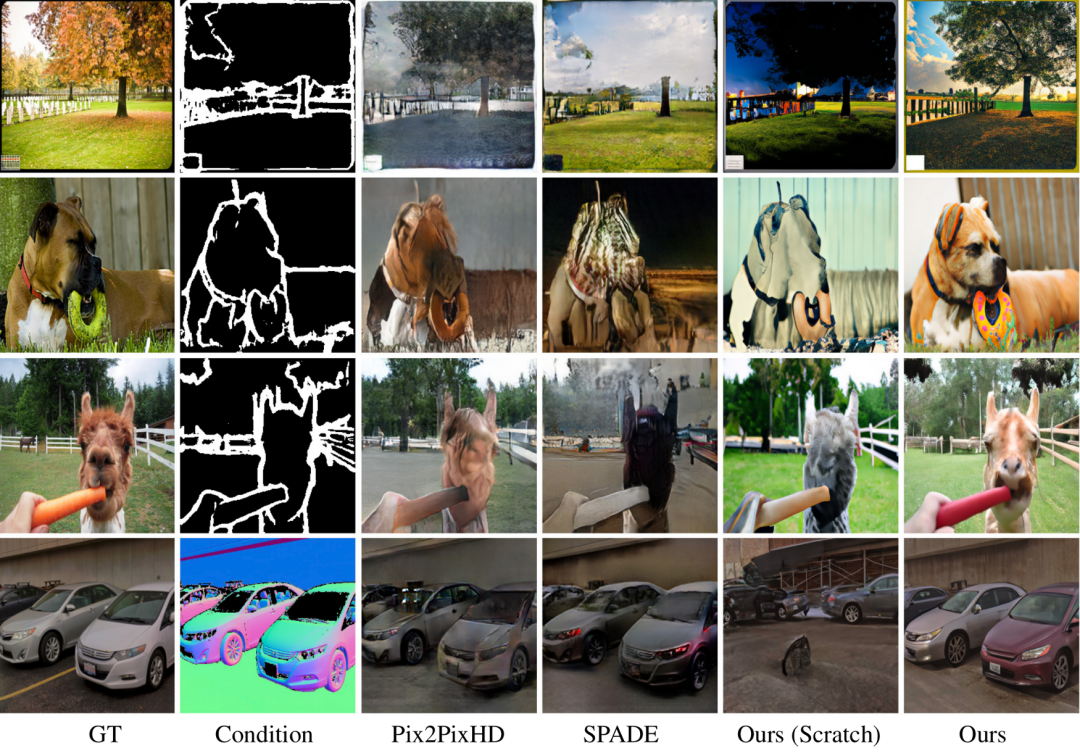

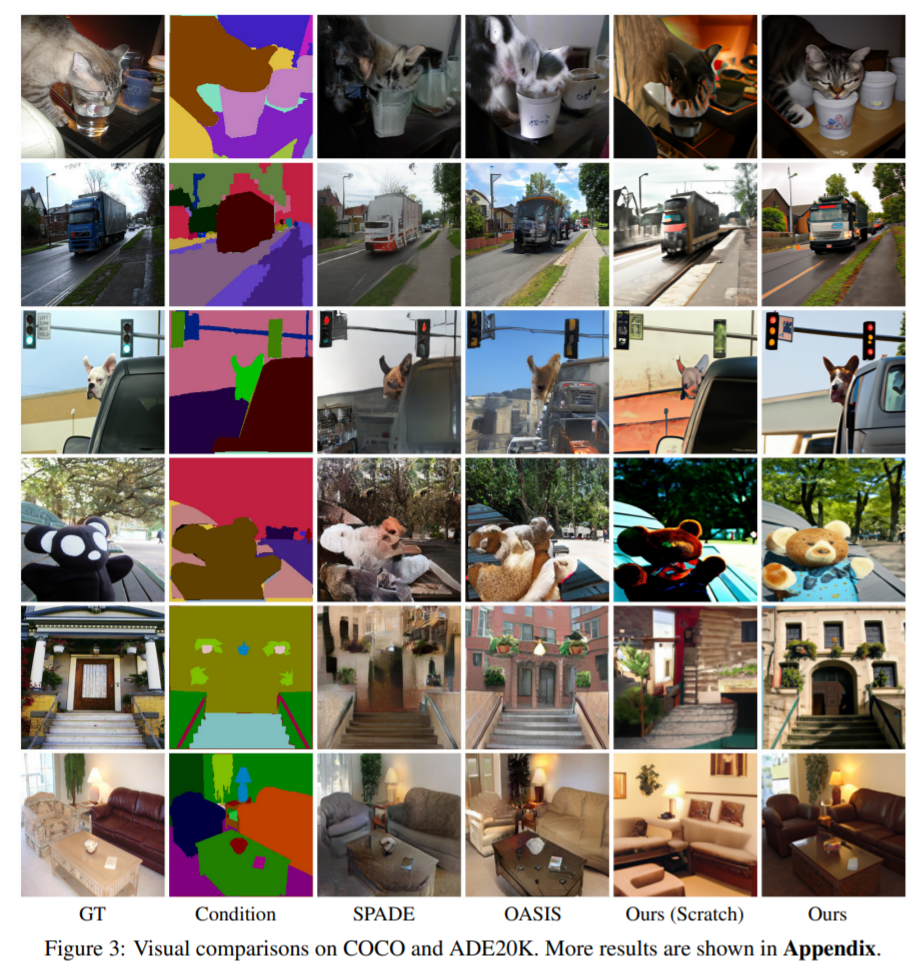

上圖是作者的作品。與從頭開始的技術相比,預訓練模型提高了圖片質量和多樣性。由于 COCO 數(shù)據(jù)集具有眾多類別和組合,因此基本方法無法通過引人注目的架構提供美觀的結果。他們的方法可以為困難的場景創(chuàng)建具有精確語義的豐富細節(jié)。圖片展示了他們方法的多功能性。

實驗及影響

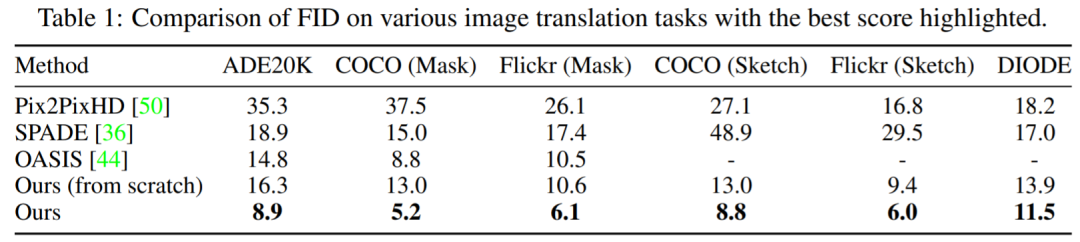

表 1 顯示,該研究所提方法性能始終優(yōu)于其他模型。與較為領先的 OASIS 相比,在掩碼到圖像合成方面,PITI 在 FID 方面獲得了顯著的改進。此外,該方法在草圖到圖像和幾何到圖像合成任務中也顯示出良好的性能。

圖 3 展示了該研究在不同任務上的可視化結果。實驗可得,與從頭開始訓練的方法相比,預訓練模型顯著提高了生成圖像的質量和多樣性。該研究所用方法可以產生生動的細節(jié)和正確的語義,即使是具有挑戰(zhàn)性的生成任務。

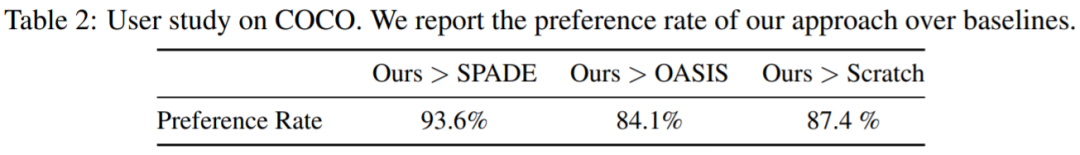

該研究還在 Amazon Mechanical Turk 上的 COCO-Stuff 上進行了一項關于掩碼到圖像合成的用戶研究,獲得了 20 名參與者的 3000 票。參與者一次會得到兩張圖片,并被要求選擇一張更真實的進行投票。如表 2 所示,所建議的方法在很大程度上優(yōu)于從零開始的模型和其他基線。

條件圖像合成可創(chuàng)建符合條件的高質量圖片。計算機視覺和圖形學領域使用它來創(chuàng)建和操作信息。大規(guī)模預訓練改進了圖片分類、對象識別和語義分割。未知的是大規(guī)模預訓練是否有利于一般生成任務。

能源使用和碳排放是圖片預訓練的關鍵問題。預訓練是耗能的,但只需要一次。條件微調讓下游任務可以使用相同的預訓練模型。預訓練允許用更少的訓練數(shù)據(jù)訓練生成模型,當數(shù)據(jù)由于隱私問題或昂貴的注釋成本而受到限制時,可以提升圖像合成效果。