提示工程夭折?MIT斯坦福讓大模型主動(dòng)提問(wèn),自己搞明白你想要什么

我就說(shuō)嘛,提示工程正在消失,這篇新研究即可解釋原因。

AI圈百萬(wàn)粉絲大V的一條推特,可把大家給驚到了。

要知道,提示工程可是ChatGPT趨勢(shì)中的大熱詞。由它衍生出的新崗位提示工程師年薪可高達(dá)幾十萬(wàn)美元,“未來(lái)人人都要學(xué)會(huì)提示工程”的觀點(diǎn)更是引發(fā)熱議……

結(jié)果現(xiàn)在,提示工程就開(kāi)始消失了???

而且有理有據(jù)。

博主伊森·莫利克提到的這篇論文,由MIT、斯坦福和Anthropic(Claude2打造者)共同提出。

論文提出了一種新型的機(jī)器學(xué)習(xí)框架,能讓大模型學(xué)會(huì)主動(dòng)向人類(lèi)提問(wèn),自己搞明白用戶(hù)的偏好。

他們使用GPT-4進(jìn)行實(shí)驗(yàn),結(jié)果發(fā)現(xiàn)和提示工程、監(jiān)督學(xué)習(xí)等方法比,在這個(gè)框架的輔助下GPT-4在多個(gè)任務(wù)上更懂人類(lèi)了。

如果大模型能更容易揣度出人類(lèi)想啥,也就意味著人類(lèi)自己不用絞盡腦汁表達(dá)自己的想法了。

所以伊森·莫利克覺(jué)得,這不就不用每個(gè)人都去學(xué)習(xí)提示工程了么?

有網(wǎng)友補(bǔ)充說(shuō),這是不是說(shuō)某種程度上,我們未來(lái)是不是可以不用語(yǔ)言和LLM進(jìn)行交流。讓大模型通過(guò)提問(wèn)來(lái)弄清楚我們?cè)谙胧裁矗@真是一個(gè)巨大的進(jìn)步。

讓AI來(lái)提示你

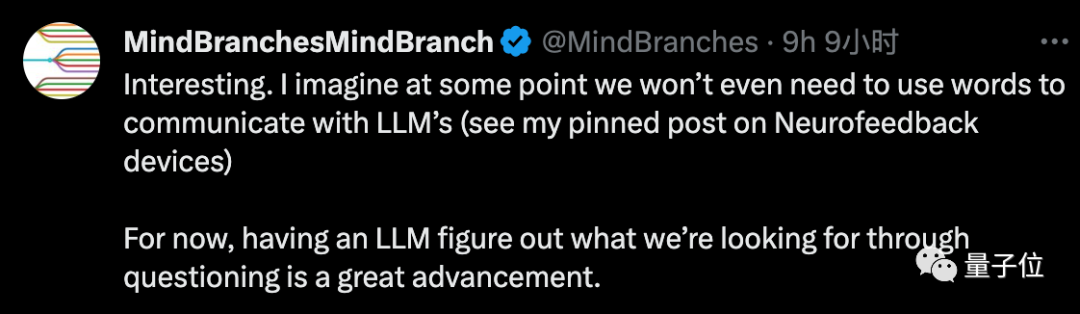

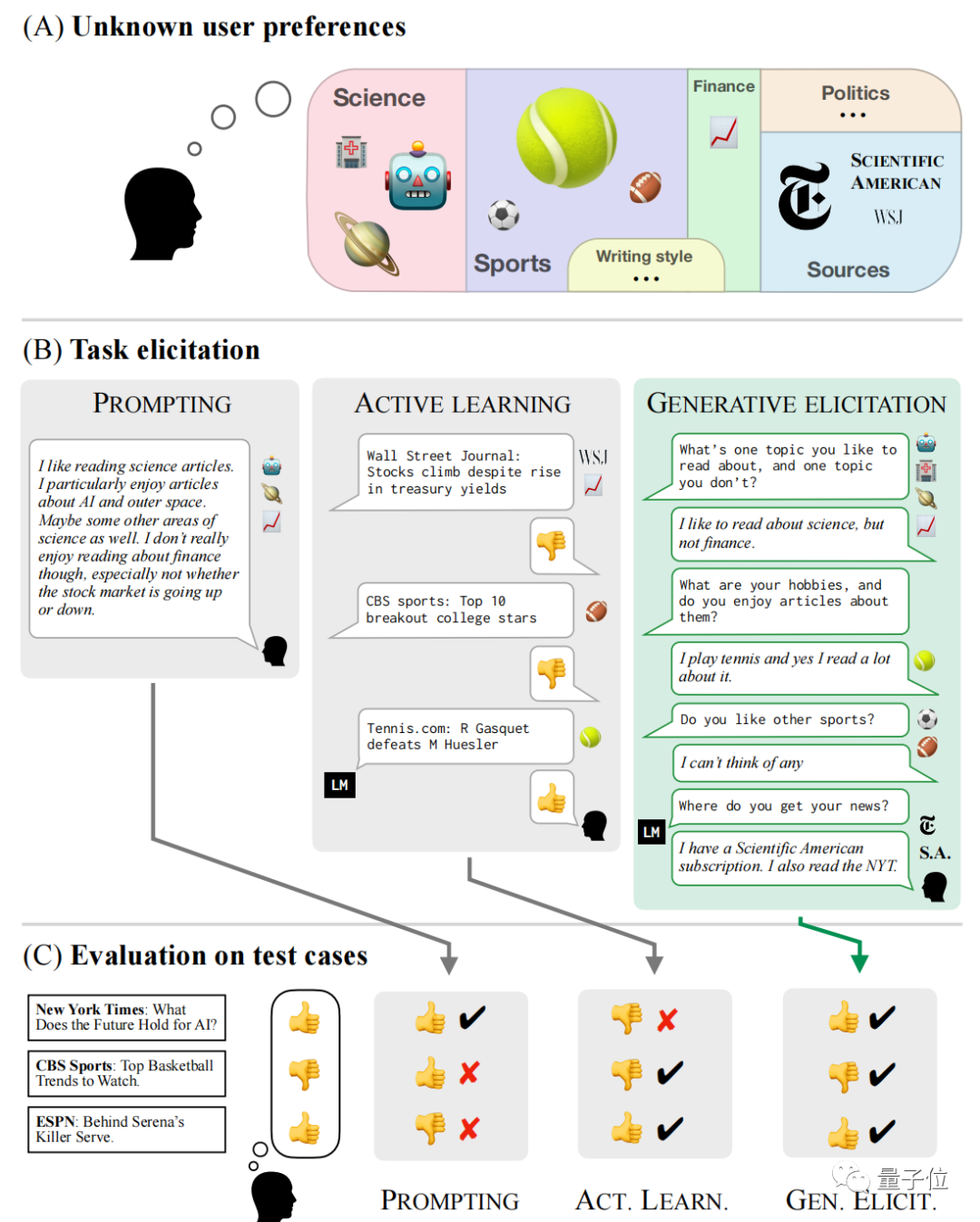

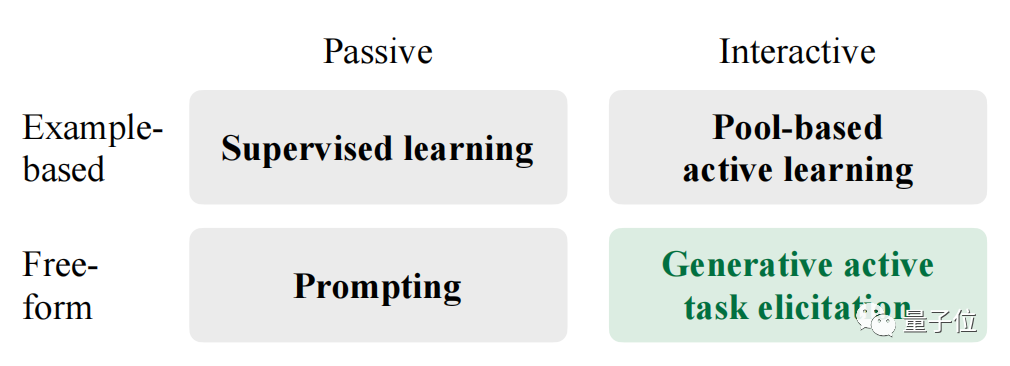

具體來(lái)看,這項(xiàng)研究提出了一種新型學(xué)習(xí)框架GATE(Generative active task elicitation)。

它能基于大模型本身的能力,來(lái)引出、推理人類(lèi)用戶(hù)的喜好。

研究團(tuán)隊(duì)將這稱(chēng)為一種更主動(dòng)的方式,具體表現(xiàn)形式就是讓大模型來(lái)對(duì)用戶(hù)提問(wèn),以讓人類(lèi)的偏好想法能更加明確地被表達(dá)出來(lái)。

對(duì)應(yīng)來(lái)看,監(jiān)督學(xué)習(xí)和提示工程都屬于被動(dòng)的方式,監(jiān)督學(xué)習(xí)和少量主動(dòng)學(xué)習(xí)還要基于示例。

為什么要“反客為主”提示人類(lèi)?

因?yàn)槿祟?lèi)給出的提示存在局限性,不一定能準(zhǔn)確完整表達(dá)出自己的喜好。

比如很多人都不懂提示工程;或者在提示過(guò)程中提供了存在誤導(dǎo)性的資料……這些都會(huì)導(dǎo)致大模型表現(xiàn)變差。

論文中列舉了一個(gè)例子。假如一個(gè)用戶(hù)說(shuō)自己很喜歡讀網(wǎng)球相關(guān)的文章,對(duì)網(wǎng)球巡回賽、發(fā)球技術(shù)感興趣。但是從他提供的文章參考里,無(wú)法判斷他是否對(duì)網(wǎng)球方面的其他話題感興趣。

所以,如果大模型能學(xué)會(huì)一些提問(wèn)技巧,就能將用戶(hù)的偏好鎖定在更小范圍內(nèi)。

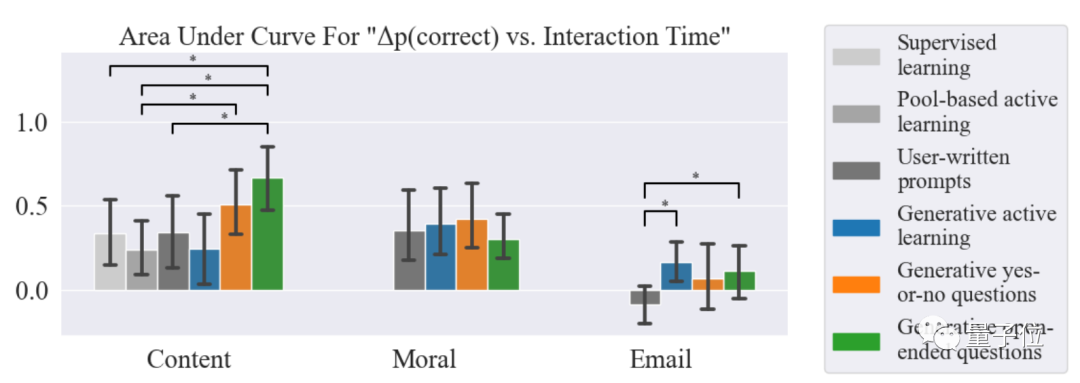

本項(xiàng)研究讓大模型嘗試了多種提問(wèn)方式,比如主動(dòng)生成用戶(hù)標(biāo)注的樣本、是非類(lèi)提問(wèn)、開(kāi)放式提問(wèn)等。

主要測(cè)試的任務(wù)為內(nèi)容推薦、道德推理和郵箱驗(yàn)證。

結(jié)果顯示,在三項(xiàng)任務(wù)中,GATE包含的辦法效果都優(yōu)于其他方法。

使用這一框架的大模型,使用起來(lái)也不那么“燒腦”了(如下左圖)。

以及這種方法的引入也不會(huì)影響人類(lèi)用戶(hù)本來(lái)的偏好(如下右圖)。

作者認(rèn)為更大的模型可能是更好的引導(dǎo)者,實(shí)驗(yàn)中他們使用的是GPT-4。

如醫(yī)療、法律等需要做出復(fù)雜決策的領(lǐng)域,會(huì)是GATE框架未來(lái)拓展的方向。

本項(xiàng)工作由MIT、Anthropic和斯坦福學(xué)者聯(lián)合推出。

“我們現(xiàn)在仍依賴(lài)提示工程”

而以這篇研究為核心,也引發(fā)了一波關(guān)于提示工程的討論。

并不是所有人都贊同“提示工程正在消失”這一觀點(diǎn)。

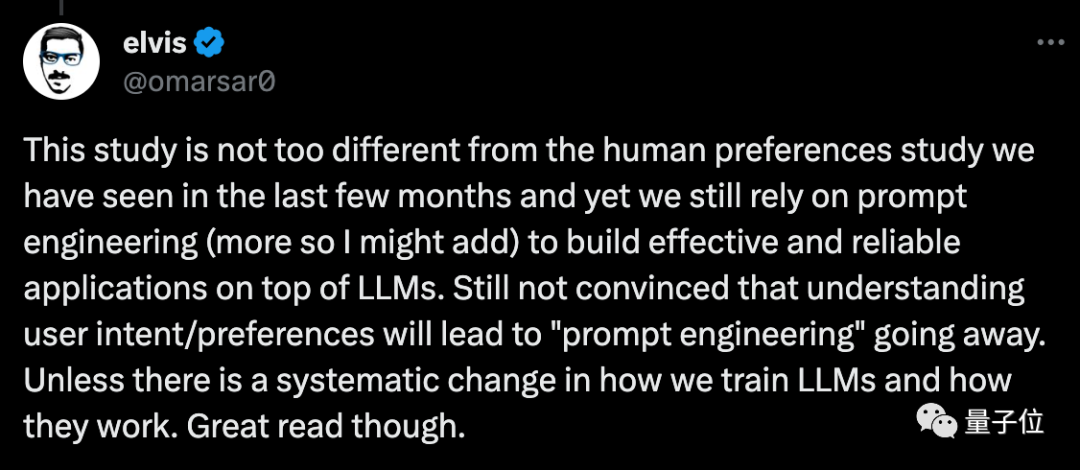

另一位AI圈大V elvis就表示,這篇研究和之前那些研究人類(lèi)偏好的工作沒(méi)有太大不同,我們現(xiàn)在還是要依賴(lài)提示工程。

我不認(rèn)為“理解人類(lèi)意圖/喜好”會(huì)導(dǎo)致提示工程消失,除非LLM訓(xùn)練和工作的方式發(fā)生系統(tǒng)性變化。

也有人覺(jué)得提示工程只是會(huì)從前端消失,形式上發(fā)生改變。

還有人提問(wèn),要是提示工程消失了,那花重金雇傭提示工程師的人可咋辦?

不過(guò)回到研究本身,的確提示工程對(duì)于很多人來(lái)說(shuō)還是有難度,有網(wǎng)友覺(jué)得,這是阻礙很多人擁抱ChatGPT的一大原因。

你覺(jué)得呢?

論文地址:https://arxiv.org/abs/2310.11589