DeepMind提出基于視覺的強化學習模型,十八般兵器對機器人不在話下

人類是擅于模仿的,我們和其他動物通過觀察行為來模仿,理解它對環境狀態的感知影響,并找出我們的身體可以采取什么行動來達到類似的結果。

對于機器人學習任務來說,模仿學習是一個強大的工具。但在這類環境感知任務中,使用強化學習來指定一個回報函數卻是很困難的。

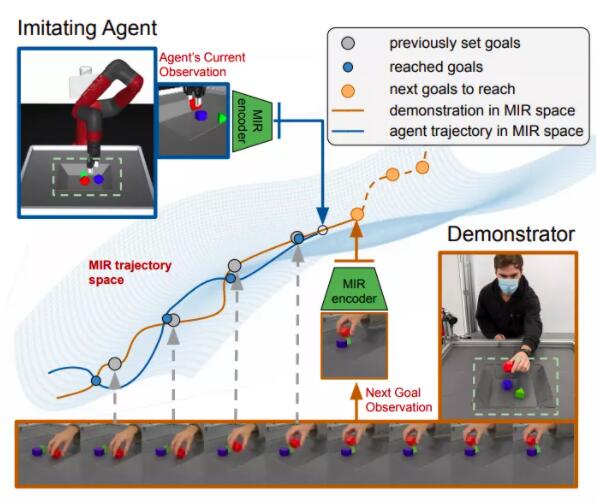

DeepMind最新論文主要探索了僅從第三人稱視覺模仿操作軌跡的可能性,而不依賴action狀態,團隊的靈感來自于一個機器人機械手模仿視覺上演示的復雜的行為。

DeepMind提出的方法主要分為兩個階段:

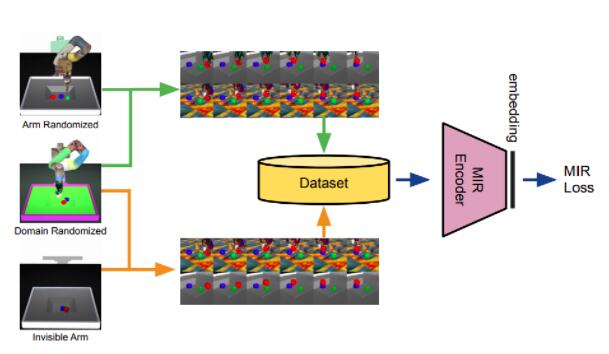

1、提出一種操作器無關的表示(MIR, Manipulation-Independent Representations),即不管是機械手、人手或是其他設備,保證這種表示都能夠用于后續任務的學習

2、使用強化學習來學習action策略

與操作器無關的表示

領域適應性問題是機器人模擬現實中最關鍵的問題,即解決視覺仿真和現實之間的差別。

1、 隨機使用各種類型操作器,各種仿真環境用來模擬現實世界

2、加入去除操作臂后的觀察

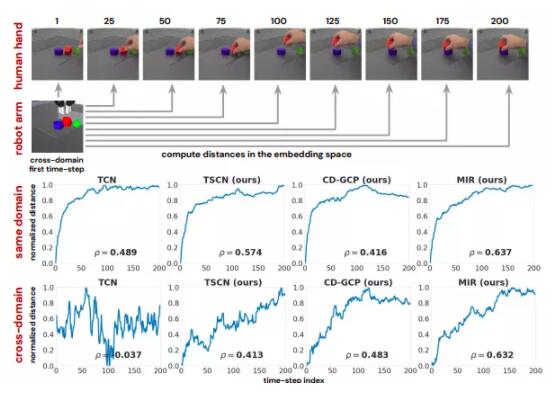

3、時序平滑對抗網絡(TSCN, Temporally-Smooth Contrastive Networks),相比TCN來說,在softmax交叉熵目標函數中增加了一個分布系數p,使得學習過程更加平滑,尤其是在cross-domain的情況。

使用強化學習

MIR表示空間的需求是actionable的,即可用于強化學習,表示為具體的action。

一個解決方案是使用goal-conditioned來訓練策略,輸入為當前狀態o和目標狀態g。這篇文章提出一種擴展方式,cross-domain goal-conditional policies,輸入當前狀態o和跨域的目標狀態o',最小化到達目標的行動次數。

數據和實驗

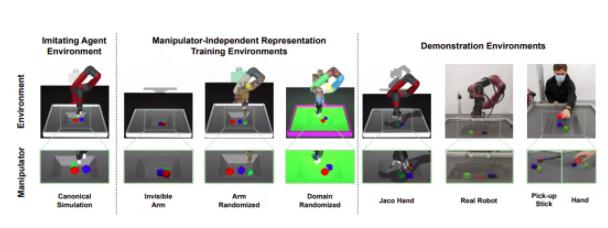

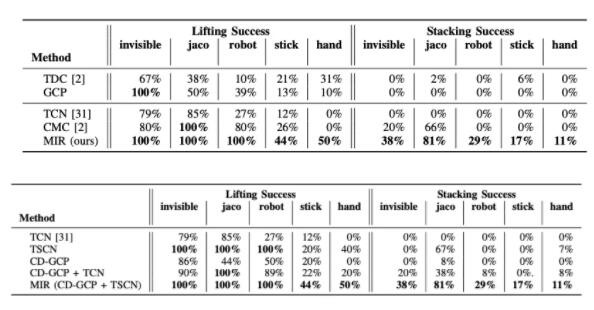

研究小組在8個環境和場景(規范模擬、隱形手臂、隨機手臂、隨機域、Jaco Hand、真機器人、手杖和人手)上進行了實驗,以評估通過未知機械手模擬無約束操作軌跡的性能。

他們還用了一些基線方法,如樸素的goal conditioned plicies (GCP)和temporal distance。

MIR 在所有測試領域都取得了最好的性能。它在疊加成功率方面的表現顯著提高,并且以100% 的分數很好地模仿了模擬的 Jaco Hand 和 Invisible Arm。

這項研究論證了視覺模仿表征在視覺模仿中的重要性,并驗證了操作無關表征在視覺模仿中的成功應用。

未來工廠中的機器人將擁有更強大的學習能力,并不局限于一種特定工具,一種特定任務。