人工智能,有必要像人類一樣嗎?

機器會思考嗎?人工智能可以像人類一樣聰明嗎?

一項最新研究表明,人工智能或許可以做到了。

在一項非語言圖靈測試中,意大利技術(shù)研究院 Agnieszka Wykowska 教授領(lǐng)銜的研究團隊發(fā)現(xiàn),類人行為變異性(Behavioral variability)可以模糊人與機器之間的區(qū)別,即可以幫助機器人看起來更像人類。

具體來說,他們的人工智能程序在與人類隊友玩有關(guān)形狀和顏色匹配的游戲時,模擬了人類反應(yīng)時間的行為變異性,通過了非語言圖靈測試。

相關(guān)研究論文以“Human-like behavioral variability blurs the distinction between a human and a machine in a nonverbal Turing test”為題,已發(fā)表在科學(xué)期刊 Science Robotics 上。

研究團隊表示,這一工作可以為未來的機器人設(shè)計提供指導(dǎo),賦予機器人具有人類可以感知的類似人類的行為。

對于這一研究,林雪平大學(xué)認(rèn)知系統(tǒng)教授 Tom Ziemke 和博士后研究員 Sam Thellman 認(rèn)為,研究結(jié)果“模糊了人與機器之間的區(qū)別”,為人們對人類社會認(rèn)知的科學(xué)理解等方面做出了非常有價值的貢獻(xiàn)。

但是,“人類相似性不一定是人工智能和機器人技術(shù)發(fā)展的理想目標(biāo),讓人工智能不那么像人類可能是一種更加明智的做法。”

通過圖靈測試

1950 年,“計算機科學(xué)與人工智能之父”艾倫·圖靈(Alan Turing)提出了一種用于判定機器是否具有智能的測試方法,即圖靈測試。

圖靈測試的關(guān)鍵思想是,有關(guān)機器思維和智能可能性的復(fù)雜問題,可以通過測試人類是否能夠分辨出他們是在與另一個人還是與一臺機器在交互來驗證。

如今,圖靈測試被科學(xué)家用來評估應(yīng)該在人工智能體上實現(xiàn)什么樣的行為特征,才能使人類不可能將計算機程序和人類行為區(qū)分開。

人工智能先驅(qū)司馬賀(Herbert Simon)就曾表示:“如果程序表現(xiàn)出的行為類似于人類表現(xiàn)出來的,那我們就稱它們是智能的。” 類似地,Elaine Rich 將人工智能定義為“研究如何讓計算機去做目前人做得更好的事情”。

而非語言圖靈測試,是圖靈測試的一種形式。對于人工智能來說,通過非語言圖靈測試并不容易,因為它們在檢測和區(qū)分其他人(物體)的微妙行為特征方面,表現(xiàn)得并不像人類那樣熟練。

那么,一個類人機器人是否能夠通過非語言圖靈測試,在其物理行為中體現(xiàn)人類特征呢?在非語言圖靈測試中,研究團隊試圖搞清楚能否通過編程讓人工智能在類似于人類行為變異的范圍內(nèi)改變反應(yīng)時間,從而被視為人類。

為了做到這一點,他們將人類和機器人安排在一個屏幕上有不同顏色、形狀的房間里。

圖|機器人與人類共同執(zhí)行任務(wù)。(來源:該論文)

圖|機器人與人類共同執(zhí)行任務(wù)。(來源:該論文)

當(dāng)形狀或顏色改變時,參與者就會按下按鈕,而機器人則通過點擊屏幕上顯示的相反顏色或形狀來響應(yīng)這一信號。

圖|通過按下按鈕來響應(yīng)(來源:該論文)

圖|通過按下按鈕來響應(yīng)(來源:該論文)

在測試過程中,機器人有時由人類遠(yuǎn)程控制,有時由被訓(xùn)練模仿行為變異性的人工智能控制。

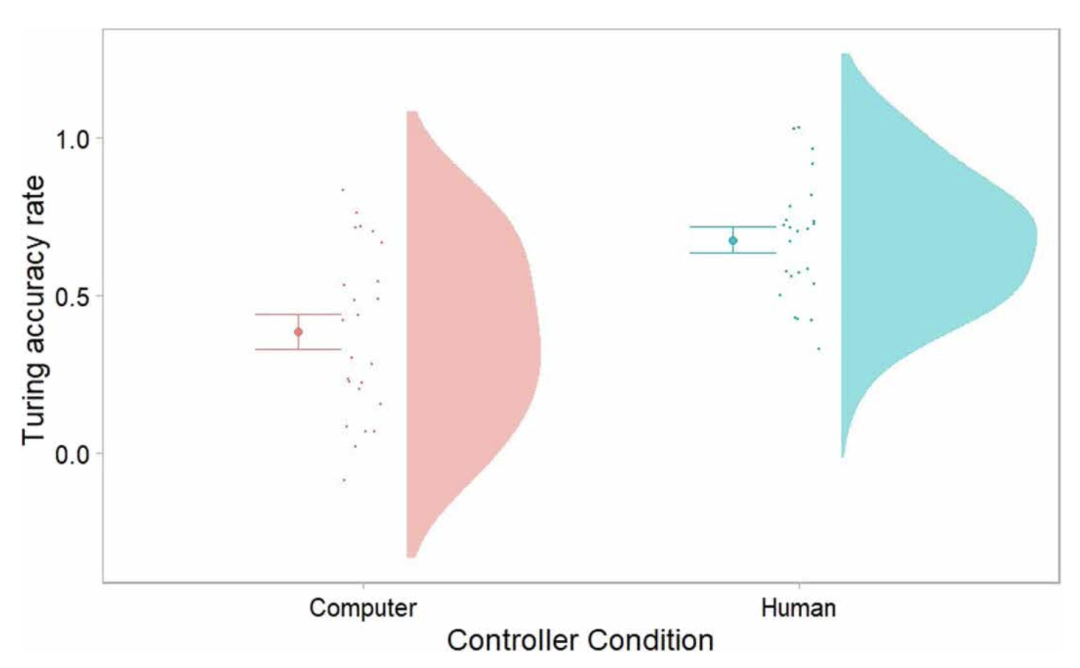

圖|參與者被要求判斷機器人行為是預(yù)先編程的還是由人類控制的。(來源:該論文)

結(jié)果表明,參與者可以很容易地分辨出機器人何時是被另一個人操作的。

但是,當(dāng)機器人被人工智能操作時,參與者猜錯的概率卻超過了 50%。

圖|圖靈測試的平均準(zhǔn)確率。(來源:該論文)

這就意味著,他們的人工智能通過了非語言圖靈測試。

但是,研究人員也表示,類人行為的可變性可能只是通過實體人工智能的非語言圖靈測試的一個必要不充分條件,因為它在人類環(huán)境中也可以表現(xiàn)出來。

人工智能,有必要像人類一樣嗎?

長期以來,人工智能研究一直將人類相似性作為目標(biāo)和衡量標(biāo)準(zhǔn),Wykowska 團隊的研究證明,行為變異性或許可以用來讓機器人更像人類。

Ziemke 等人卻認(rèn)為讓人工智能不那么像人類可能是一種更加明智的做法,并以自動駕駛汽車和聊天機器人兩個案例做了闡述。

比如,當(dāng)你在馬路上準(zhǔn)備穿過人行橫道時,看到一輛汽車正在接近你,從遠(yuǎn)處看,你可能無法判斷它是否是一輛自動駕駛汽車,所以你只能根據(jù)汽車的行為來判斷。

(來源:Pixabay)

但是,即使你看到有人坐在方向盤前面,你也不能確定這個人是在主動控制車輛,還是僅僅在監(jiān)控車輛的行駛操作。

“這對交通安全有著非常重要的影響,如果自動駕駛汽車不能向其他人表明它是否處于自動駕駛模式,可能就會導(dǎo)致不安全的人機互動。”

也許有些人會說,理想情況下,你并不需要知道一輛車是不是自動駕駛,因為從長遠(yuǎn)來看,自動駕駛汽車可能比人類更擅長駕駛。但是,目前而言,人們對自動駕駛汽車的信任還遠(yuǎn)遠(yuǎn)不夠。

聊天機器人,則是更接近圖靈最初測試的現(xiàn)實場景。許多公司在他們的在線客戶服務(wù)中使用聊天機器人,其中的對話話題和互動方式相對有限。在這種情況下,聊天機器人通常或多或少與人類沒有區(qū)別。

(來源:Pixabay)

那么,問題就來了,企業(yè)是否應(yīng)該將聊天機器人的非人類身份告訴客戶呢?一旦告訴了,往往會導(dǎo)致消費者產(chǎn)生負(fù)面反應(yīng),比如信任下降。

正如上述案例所說明的那樣,雖然從工程學(xué)的角度來看,類人行為可能是一項令人印象深刻的成就,但人機的不可區(qū)分性卻帶來了明顯的心理、倫理和法律問題。

一方面,與這些系統(tǒng)交互的人必須知道他們所交互的內(nèi)容的性質(zhì),以避免欺騙。以聊天機器人為例,美國加州自 2018 年起就制定了聊天機器人信息披露法,明確披露是一項嚴(yán)格的要求。

另一方面,還有比聊天機器人和人類客服更無法區(qū)分的例子。例如,當(dāng)涉及到自動駕駛時,自動駕駛汽車和其他道路用戶之間的交互并沒有同樣明確的起點和終點,它們通常不是一對一的,而且它們有一定的實時約束。

因此,問題在于,關(guān)于自動駕駛汽車的身份和能力,應(yīng)該在何時、以何種方式來傳達(dá)。

此外,完全自動化的汽車可能還需要幾十年的時間才能出現(xiàn)。因此,在可預(yù)見的未來,混合交通和不同程度的部分自動化可能會成為現(xiàn)實。

關(guān)于自動駕駛汽車可能需要以什么樣的外部接口來與人交流,已有很多研究。然而,人們對于兒童、殘疾人等弱勢道路使用者實際上能夠和愿意應(yīng)對的復(fù)雜性,還知之甚少。

因此,上述的一般規(guī)則,即“與這樣的系統(tǒng)交互的人必須被告知交互對象的性質(zhì)”,可能只有在更明確的情況下才有可能遵循。

同樣,這一矛盾心理也反映在社交機器人研究的討論中:鑒于人類傾向于將精神狀態(tài)擬人化并賦予其類似人類的屬性,許多研究人員旨在讓機器人在外觀和行為上更像人類,這樣它們就可以或多或少地以類似人類的方式進(jìn)行互動。

然而,也有人認(rèn)為,機器人應(yīng)該很容易被識別為機器,以避免過度擬人化的屬性和不切實際的期望。

“因此,更明智的做法可能是利用這些發(fā)現(xiàn)讓機器人變得不那么像人類。”在人工智能的早期,模仿人類可能是一個業(yè)內(nèi)的共同目標(biāo),“但在人工智能已經(jīng)成為人們?nèi)粘I畹囊徊糠值慕裉欤覀冎辽傩枰伎迹谑裁捶较蚺崿F(xiàn)類似人類的人工智能才真正有意義”。