Meta這篇語言互譯大模型研究,結(jié)果對比都是「套路」

今年 7 月初,Meta AI 發(fā)布了一個新的翻譯模型,名為 No Language Left behind (NLLB),我們可以將其直譯為「一個語言都不能少」。

顧名思義,NLLB 可以支持 200 + 語言之間任意互譯,Meta AI 還把它開源了。平時你都沒見到的語言如盧干達(dá)語、烏爾都語等它都能翻譯。

- 論文地址:https://research.facebook.com/publications/no-language-left-behind/

- 開源地址:https://github.com/facebookresearch/fairseq/tree/nllb

不過,近日這項研究遭到了質(zhì)疑,有人認(rèn)為 Meta AI 在 NLLB 中提出的許多主張是沒有根據(jù)的,具有誤導(dǎo)性,并且評估結(jié)果有嚴(yán)重的缺陷。此外,質(zhì)疑者還表示根據(jù) Meta AI 的評估方法,很容易獲得比他們報告更高的數(shù)字。

質(zhì)疑者為自然語言處理研究科學(xué)家 Benjamin Marie,他精通翻譯技術(shù)。他質(zhì)疑的內(nèi)容可概括為 Meta AI 將 spBLEU 和 BLEU 放在一起進(jìn)行比較。

對于這項質(zhì)疑,有研究者表示:spBLEU 是一個合理的度量標(biāo)準(zhǔn),前提是文本沒有空格(泰語等)。但是比較 spBLEU 和 BLEU 絕對是不正確的。

網(wǎng)友 Arle Lommel 在回復(fù) Benjamin Marie 時表示:這是一個很棒的觀點。這也教會我,對于機器學(xué)習(xí)的研究,要非常謹(jǐn)慎地對待缺乏證實的研究。你在這里的發(fā)現(xiàn)確實表明,當(dāng)人們只引用分?jǐn)?shù)而不控制它們的產(chǎn)生方式時,問題會變得很復(fù)雜。

論文作者之一 Vedanuj Goswami 表示:「我們 100% 同意作者的觀點,即你不能將 BLEU 分?jǐn)?shù)與不同的 tokenizer 比較。但作者的主要論點是,我們論文中的大多數(shù)結(jié)果是不可比較的是不成立的。

在我們的論文中,表 30 和表 31 使用相同的 tokenizer 進(jìn)行 spBLEU 評估(FLORES-101 spm tokenizer),專門用于可比性。我們不使用 FLORES-200 spm tokenizer。我們在表 30 的標(biāo)題和第 8.3.1 節(jié)中對此進(jìn)行了詳細(xì)說明。同樣,表 35、36、37、38 都使用可比較的指標(biāo) / tokenizer 進(jìn)行適當(dāng)比較。我們對論文進(jìn)行了更新

總的來說,目前的機器翻譯評價方法還不完善,不同的論文采用了不同的方法。」

下面我們介紹 Benjamin Marie 質(zhì)疑的具體內(nèi)容:?

評估方法有缺陷

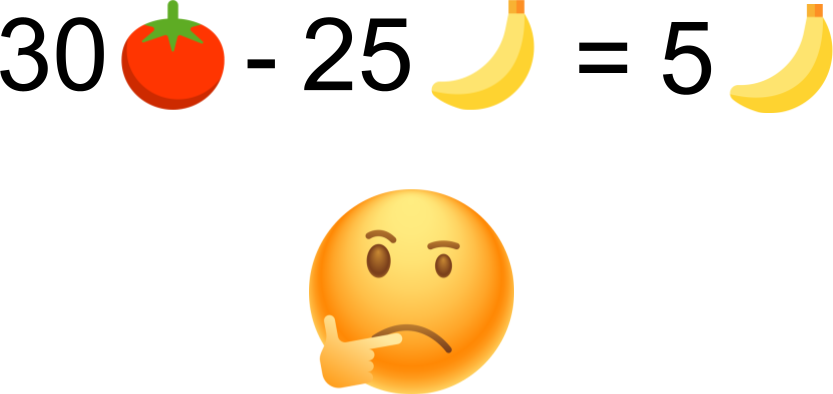

首先讓我們做一個簡單的類比:

Paul 有 25 個香蕉,Bill 有 30 個西紅柿。你會說 Bill 比 Paul 多 5 個香蕉嗎?

BLEU 好比香蕉,spBLEU 好比西紅柿。將 Paul 替換為 Previous work,將 Bill 替換為 NLLB。我們現(xiàn)在可以寫下這樣的內(nèi)容:

之前的工作在 25 BLEU 下執(zhí)行,NLLB 在 30 spBLEU 下執(zhí)行。你會說 NLLB 比以前的工作好 5 個 BLEU 點嗎?

有了上面的類比,下面介紹的內(nèi)容可能就會更容易理解。

此前,Meta AI 發(fā)布了一篇論文,對 NLLB 進(jìn)行了全面解釋和評估。在論文摘要中,他們聲稱模型相對于之前 SOTA 方法實現(xiàn)了 44% 的 BLEU 提升。換句話說,NLLB 會比以往研究結(jié)果更好。

關(guān)于 BLEU,在機器翻譯研究史上很少見到 BLEU 比以前的 SOTA 技術(shù)提高 44%。所以論文中這簡單的一句話,代表了科學(xué)進(jìn)步。有些媒體直接報道了這一說法,并且沒有經(jīng)過進(jìn)一步的驗證,就將 Meta AI 定位在語言機器翻譯的最高點。?

如果 Meta AI 選擇發(fā)布如此大的技術(shù)研究,他們就應(yīng)該提供非常可靠的科學(xué)證據(jù)。否則,在沒有任何證據(jù)的情況下,Meta AI 聲稱自己做得比別人好,這只會破壞其他研究機構(gòu)已經(jīng)做過和正在做的非常艱苦的工作。

Marie 為了解釋 NLLB 的錯誤問題,他嘗試證明 Meta AI 是如何被它自己的結(jié)果誤導(dǎo)的。Marie 使用 NLLB 中的簡單示例和自己找到的類似示例,證明當(dāng)使用 NLLB 有缺陷的評估方法時其實很容易超越 SOTA 的水平。最后,Marie 指出并具體解釋他們評估中的主要錯誤。?

Meta AI 將其模型和 20 多個以前的研究數(shù)據(jù)進(jìn)行比較后得出結(jié)論,NLLB 明顯優(yōu)于以前的研究。為了使如此多的比較具有可行性,他們依賴于機器翻譯評估的自動評估指標(biāo),這些指標(biāo)主要是 BLEU 和 spBLEU。?

BLEU 在機器翻譯中極受歡迎,盡管其存在著缺陷。

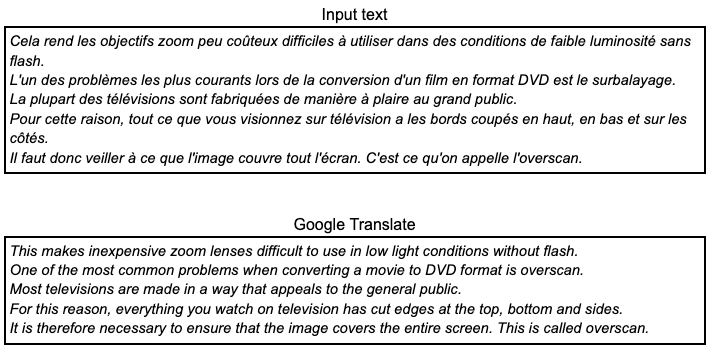

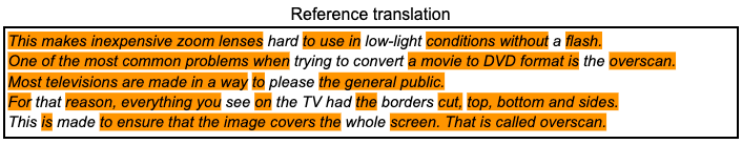

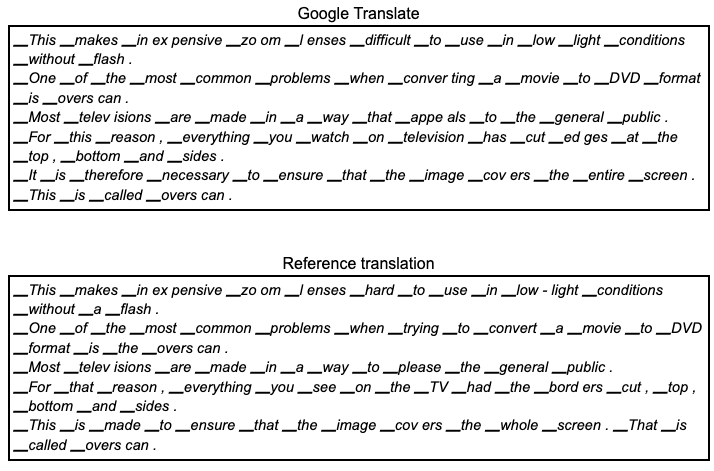

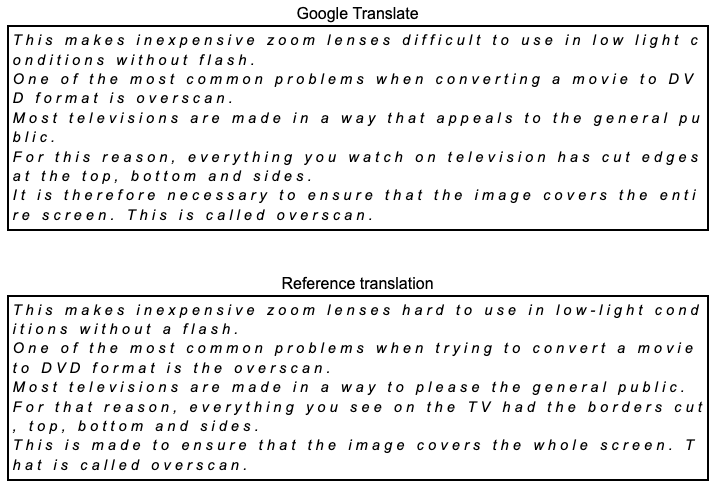

例如,我們想用谷歌翻譯將以下來自 FLORES101 的數(shù)據(jù)集的法語文本翻譯成英語。如果你會說法語,你會注意到,這是一個質(zhì)量很差的翻譯:語法錯誤、術(shù)語不一致、讀起來不自然。事實上,由于數(shù)據(jù)集是從英語創(chuàng)建的,因此 Meta AI 在翻譯成英語時只評估機器翻譯。

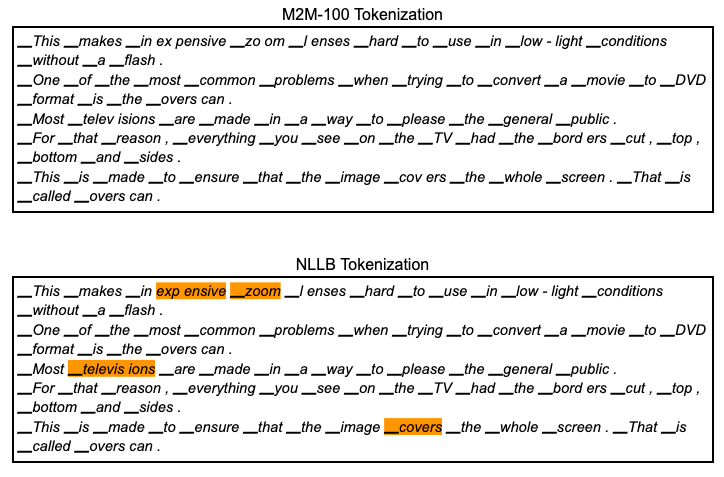

我們可以通過計算谷歌翻譯中有多少 token 也在這個參考翻譯中,將其與參考翻譯進(jìn)行比較。在這里定義一個 token 是由一個空格分隔的字符序列。橘色突出顯示了上面谷歌翻譯中出現(xiàn)在下面參考翻譯中的所有 token 序列。

僅考慮到所有匹配的 token,可以計算出 BLEU 分?jǐn)?shù)為 50.8 BLEU。僅僅這個分?jǐn)?shù)是沒有任何意義,只有與另一個 BLEU 分?jǐn)?shù)相比,它才有意義。

這里需要理解的關(guān)鍵點是,分?jǐn)?shù)是基于 token 計算的,這在大多數(shù)機器翻譯研究中會被忽視。使用 SacreBLEU 計算 BLEU 分?jǐn)?shù),SacreBLEU 執(zhí)行自己的內(nèi)部 tokenization,基本上只在標(biāo)點符號之前添加空格。這是計算 BLEU 分?jǐn)?shù)最可靠和可重復(fù)的方法之一。而 Meta AI 使用的是 spBLEU。

那么 spBLEU 是什么?它是 BLEU,但使用了不同的 tokenization。它將谷歌翻譯和參考翻譯的 token 化如下。

與 spBLEU 相關(guān)的 token 通過將單詞分解成更小的片段來生成 token(附加到 token 的▁ 在這里并不重要,請嘗試忽略它)。使用 spBLEU token 化的直接后果是,我們最終得到的翻譯和參考都有更多的 token。由于有更多的 token,我們可以期望谷歌翻譯從參考中匹配更多的 token。然后分?jǐn)?shù)會增長。事實上,這里的的 spBLEU 分?jǐn)?shù)是 54.8。

我們不禁會問比上面使用 SacreBLEU 內(nèi)部 tokenization 計算的 BLEU 分?jǐn)?shù)高 4 分?那么翻譯是不是越來越好了?

顯然沒有,翻譯保持不變。比較 BLEU 和 spBLEU 根本沒有意義。BLEU 和 spBLEU 以不同的方式處理谷歌翻譯和參考翻譯,而且僅用于評估目的。它們實際上是不同的指標(biāo)。如果它們是相同的指標(biāo),我們就不必對它們進(jìn)行不同的命名。正如我們在機器翻譯研究社區(qū)經(jīng)常讀到和聽到的那樣,使用不同甚至幾乎相似的 token 計算的 BLEU 分?jǐn)?shù)來比較翻譯質(zhì)量并不是公平的,甚至是不公平的。如果你希望你的研究具有科學(xué)可信度,你只需要使用完全相同的 tokenization 一致地計算你的 BLEU 分?jǐn)?shù)。?

Meta AI 聲稱 NLLB 比之前的研究好得多,因為他們始終可以獲得比之前公布的 BLEU 分?jǐn)?shù)更好的 spBLEU 分?jǐn)?shù),事實相反。因為對于給定的翻譯,讓 spBLEU 分?jǐn)?shù)低于 BLEU 分?jǐn)?shù)是一項極其困難的任務(wù)。更讓人無法理解的是,如果他們的目標(biāo)是獲得最高分?jǐn)?shù),為什么不直接使用 chrBLEU 指標(biāo)。

例如在谷歌翻譯和參考翻譯中,每個字符都會成為一個 token 換句話說,在字符之間添加了空格)。

然后我們計算 chrBLEU 值為 75.5,比 spBLEU 高 20.7 點。根據(jù) NLLB 的評估,這將是一個重大的改進(jìn),這將是機器翻譯的新高點,而原來的谷歌翻譯保持不變。

論文中的錯誤示例?

現(xiàn)在,讓我們來看看 NLLB 評估的具體示例。

Meta AI 聲稱,通過將其數(shù)字與之前發(fā)布的數(shù)字進(jìn)行比較,發(fā)現(xiàn)其表現(xiàn)優(yōu)于之前的工作。在本文中,從表 30、31、32、35、36、37 和 38 中得出結(jié)論,這些結(jié)論與以前的工作進(jìn)行了比較。

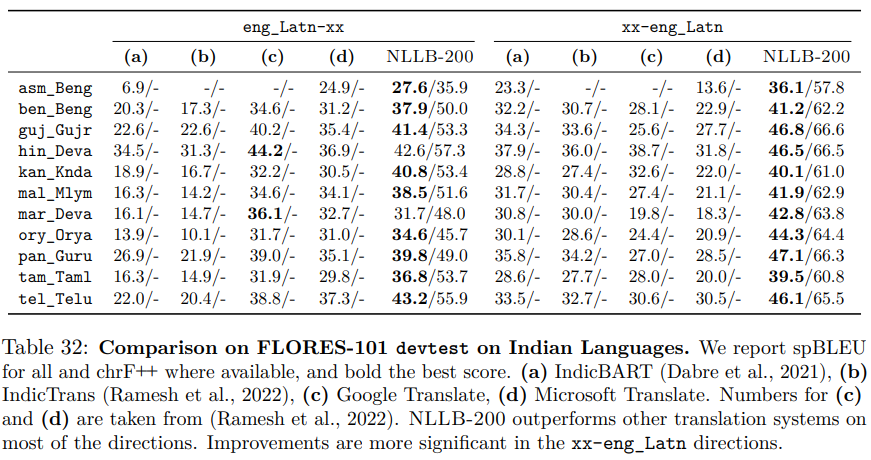

將從表 32 開始。這是最具說明性的例子之一,因為它存在著各種不同類型的錯誤。

從表中可得,除 NLLB-200 列外,所有數(shù)字均直接復(fù)制自之前發(fā)表的論文 IndicBART 和 IndicTrans。為了便于閱讀,Meta AI 用粗體標(biāo)出了每種語言的最高分?jǐn)?shù),粗體列表示相應(yīng)的系統(tǒng)是最好的。

表中為 spBLEU for all,這具有誤導(dǎo)性。實際上,all 的意思是只有 NLLB-200,因為 IndicBART 和 IndicTrans 使用的不是 spBLEU,而是 BLEU。然而比較后發(fā)現(xiàn),NLLB 的 spBLEU 分?jǐn)?shù)高于之前工作的 BLEU 分?jǐn)?shù)。但這是否意味著 NLLB 更好?這就好比 30 個西紅柿比 25 個香蕉好嗎?

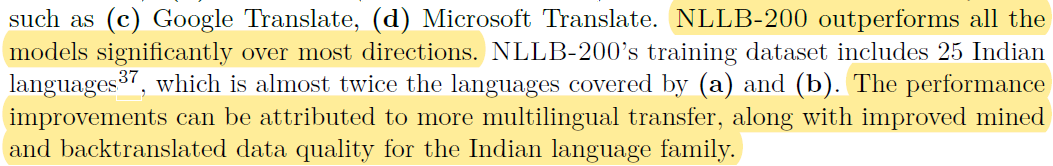

在解釋結(jié)果的文本中,我們可以看到:

例如(c)谷歌翻譯,(d)微軟翻譯。NLLB-200 在大多數(shù)方向上顯著優(yōu)于所有模型。NLLB-200 的訓(xùn)練數(shù)據(jù)集包括 25 種印度語言,幾乎是(a)和(b)所涵蓋語言的兩倍。性能的提高可以歸因于更多的多語言傳輸,以及印度語系挖掘和反譯數(shù)據(jù)質(zhì)量的提高。

換句話說,NLLB 的番茄比之前的研究中的香蕉多。所以 NLLB 有更多的香蕉。

spBLEU 分?jǐn)?shù)高于 BLEU 分?jǐn)?shù),因為它們是在更小的而且不同的 token 上計算的。然而,NLLB 的翻譯更好嗎?我們根本無法回答。更糟糕的是,IndicBART 和 IndicTrans 也不具有可比性,因為它們都使用了兩種不同的 token 方法。

上面列出的大多數(shù)表格都有類似的問題,或多或少都有錯誤。

如果你看一下 IndicBART 和 IndicTrans 發(fā)表的論文來檢查這些數(shù)字,你會發(fā)現(xiàn)還有其他問題。表 32 中的(a、b)列全部交換,IndicBART 數(shù)字是 indicatrans 中的數(shù)字,反之亦然。

如果你看表 30,問題就更大了。 不過表 30 在論文中更新了,Benjamin Marie 表示非常感謝 Vedanuj 更新了文章。表 30 確實提到了 tokenizer 是相同的。我承認(rèn)我的錯誤。

不過表 30 在論文中更新了,Benjamin Marie 表示非常感謝 Vedanuj 更新了文章。表 30 確實提到了 tokenizer 是相同的。我承認(rèn)我的錯誤。

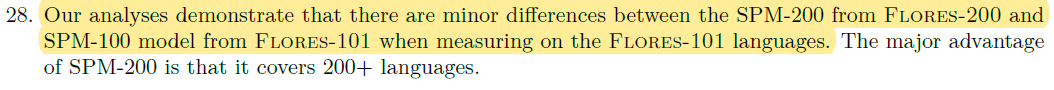

如表 32 所示,Meta AI 聲稱 NLLB 優(yōu)于以前的 DeltaLM 和 Deepnet,同時比較了使用不同計算方法得出的 BLEU 分?jǐn)?shù)。這里的新內(nèi)容是,他們還將 NLLB 與自己以前的研究 M2M-100 進(jìn)行了比較,也使用 spBLEU 進(jìn)行了評估。那么這個比較有意義嗎?沒有。即使他們都使用 spBLEU,但實際上他們使用了不同的 tokenizer,這使比較變得失去可能性。他們在腳注 28 中作出以下聲明:

「我們的分析表明,當(dāng)在 FLORES-101 語言上進(jìn)行測量時,F(xiàn)LORES-200 的 SPM-200 和 FLORES-101 的 SPM-100 模型之間存在微小差異。SPM-200 的主要優(yōu)點是它涵蓋 200 多種語言。」

微小的差異也是差異。在這種情況下,這些差異很重要,因為我們在做科學(xué)研究。

與他們在 M2M-100 上的工作相比,NLLB 的一個進(jìn)步是向模型和數(shù)據(jù)集添加了更多的語言。它包括 tokenization 模型。從技術(shù)上講,如果向這個 tokenizer 添加更多具有不同書寫系統(tǒng)的語言,同時保持詞匯表的大小不變,那么將機械地獲得具有較小 token 的詞匯表。正如在上面看到的,使用較小的 token 可能會獲得更好的分?jǐn)?shù)。讓我們驗證一下。

如下圖所示:

此 tokenization 生成 95 個 token,而 NLLB 生成 97 個 token。這只是一個微妙的區(qū)別,如果使用 M2M-100 tokenization 計算 spBLEU,則得分為 53.8,比 NLLB tokenization 低 1 分。根據(jù)機器翻譯研究文獻(xiàn),通常 1 分的差異足以聲稱系統(tǒng)明顯更好。正如預(yù)期的那樣,NLLB 將產(chǎn)生比 M2M-100 更高的分?jǐn)?shù)。

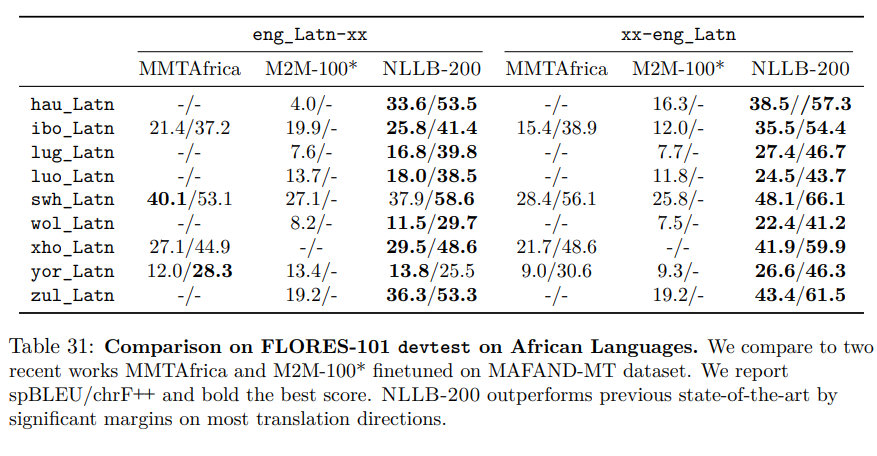

下一張表是本文的最后一張表:表 31。

同樣,我們也有上文提到的相同的問題:

1. M2M-100 和 NLLB 使用兩種不同的 tokenization 進(jìn)行評分,因此無法進(jìn)行比較。2. MMTAfrica 似乎在他們的論文中使用了 M2M-100 tokenization。它可以與 M2M-100 相比,但不能與 NLLB 相比。

文中還有一些問題,在這就不一一介紹了。在 NLLB 中,Meta AI 所犯的主要錯誤是機器翻譯評估中的一個非常常見的錯誤,不過我們應(yīng)該承認(rèn),這項工作確實令人驚嘆,而且可能為許多語言提供了更高的翻譯質(zhì)量。