圖像大面積缺失,也能逼真修復(fù),新模型CM-GAN兼顧全局結(jié)構(gòu)和紋理細(xì)節(jié)

圖像修復(fù)是指對圖像缺失區(qū)域進(jìn)行補(bǔ)全,是計算機(jī)視覺的基本任務(wù)之一。該方向有許多實際應(yīng)用,例如物體移除、圖像重定向、圖像合成等。

早期的修復(fù)方法基于圖像塊合成或顏色擴(kuò)散來填充圖像缺失部分。為了完成更復(fù)雜的圖像結(jié)構(gòu),研究人員開始轉(zhuǎn)向數(shù)據(jù)驅(qū)動的方案,他們利用深度生成網(wǎng)絡(luò)來預(yù)測視覺內(nèi)容和外觀。通過在大量圖像上進(jìn)行訓(xùn)練,并借助重建和對抗損失,生成式修復(fù)模型已被證明可以在包括自然圖像和人臉在內(nèi)的各種類型輸入數(shù)據(jù)上產(chǎn)生更具視覺吸引力的結(jié)果。

然而,現(xiàn)有工作只能在完成簡單的圖像結(jié)構(gòu)方面顯示出良好的結(jié)果,生成整體結(jié)構(gòu)復(fù)雜和細(xì)節(jié)高保真的圖像內(nèi)容仍然是一個巨大的挑戰(zhàn),特別是當(dāng)圖像空洞(hole)很大的時候。

從本質(zhì)上講,圖像修復(fù)面臨兩個關(guān)鍵問題:一個是如何將全局上下文準(zhǔn)確地傳播到不完整區(qū)域,另一個是合成與全局線索一致的真實局部細(xì)節(jié)。為了解決全局上下文傳播問題,現(xiàn)有網(wǎng)絡(luò)利用編碼器 - 解碼器結(jié)構(gòu)、空洞卷積、上下文注意力或傅里葉卷積來整合長程特征依賴,擴(kuò)大有效感受野。此外,兩階段方法和迭代空洞填充依靠預(yù)測粗略結(jié)果來增強(qiáng)全局結(jié)構(gòu)。然而,這些模型缺乏一種機(jī)制來捕獲未掩碼區(qū)域的高級語義,并有效地將它們傳播到空洞中以合成一個整體的全局結(jié)構(gòu)。

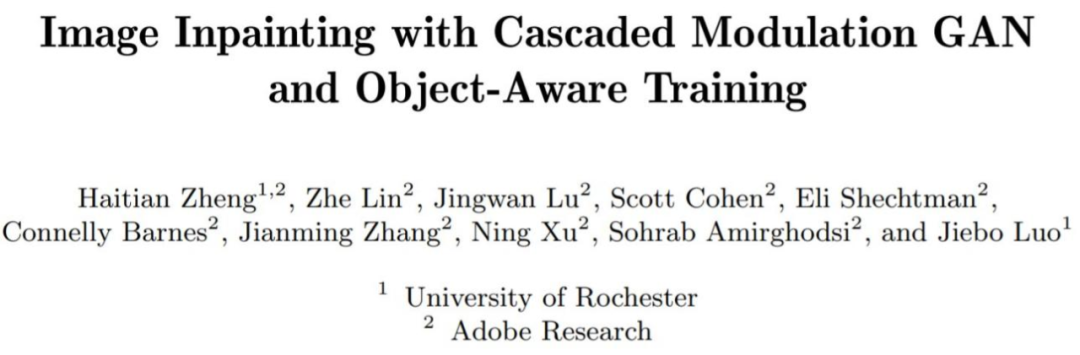

基于此,來自羅徹斯特大學(xué)和 Adobe Research 的研究者提出了一種新的生成網(wǎng)絡(luò):CM-GAN(cascaded modulation GAN),該網(wǎng)絡(luò)可以更好地合成整體結(jié)構(gòu)和局部細(xì)節(jié)。CM-GAN 中包括一個帶有傅里葉卷積塊的編碼器,用于從帶有空洞的輸入圖像中提取多尺度特征表征。CM-GAN 中還有一個雙流解碼器,該解碼器在每個尺度層都設(shè)置一個新型級聯(lián)的全局空間調(diào)制塊。

在每個解碼器塊中,研究者首先應(yīng)用全局調(diào)制來執(zhí)行粗略和語義感知的結(jié)構(gòu)合成,然后進(jìn)行空間調(diào)制來進(jìn)一步以空間自適應(yīng)方式調(diào)整特征圖。此外,該研究設(shè)計了一種物體感知訓(xùn)練方案,以防止空洞內(nèi)產(chǎn)生偽影,從而滿足現(xiàn)實場景中物體移除任務(wù)的需求。該研究進(jìn)行了廣泛的實驗表明,CM-GAN 在定量和定性評估方面都顯著優(yōu)于現(xiàn)有方法。

- 論文地址:https://arxiv.org/pdf/2203.11947.pdf

- 項目地址:https://github.com/htzheng/CM-GAN-Inpainting

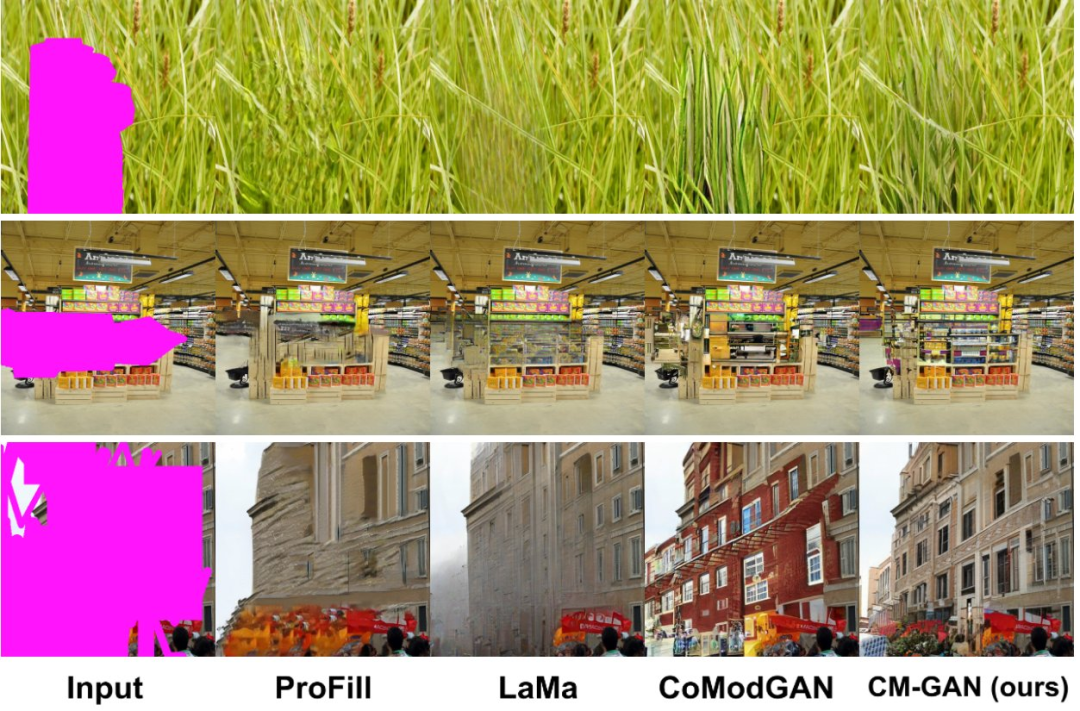

我們先來看下圖像修復(fù)效果,與其他方法相比,CM-GAN 可以重建更好的紋理:

CM-GAN 可以合成更好的全局結(jié)構(gòu):

CM-GAN 具有更好的物體邊界:

下面我們來看下該研究的方法和實驗結(jié)果。

方法

級聯(lián)調(diào)制 GAN?

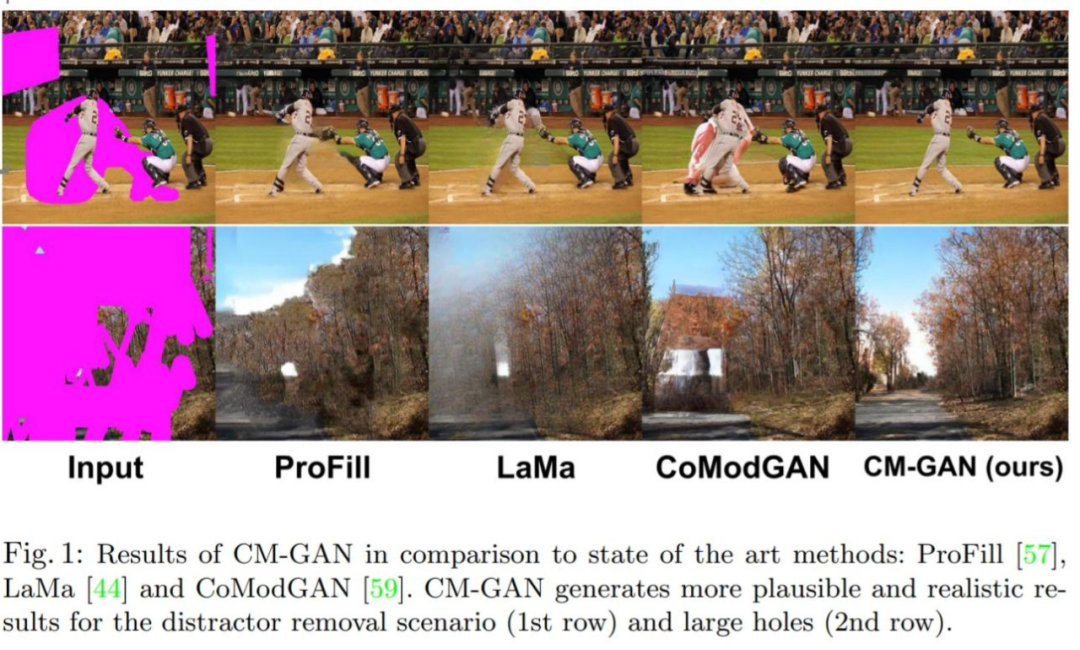

為了更好地建模圖像補(bǔ)全的全局上下文,該研究提出一種將全局碼調(diào)制與空間碼調(diào)制級聯(lián)的新機(jī)制。該機(jī)制有助于處理部分無效的特征,同時更好地將全局上下文注入空間域內(nèi)。新架構(gòu) CM-GAN 可以很好地綜合整體結(jié)構(gòu)和局部細(xì)節(jié),如下圖 1 所示。

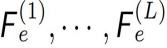

如下圖 2(左) 所示,CM-GAN 基于一個編碼器分支和兩個并行級聯(lián)解碼器分支來生成視覺輸出。編碼器以部分圖像和掩碼為輸入,生成多尺度特征圖 。

。

與大多數(shù)編碼器 - 解碼器方法不同,為了完成整體結(jié)構(gòu),該研究從全連接層的最高級別特征 中提取全局樣式代碼 s,然后進(jìn)行

中提取全局樣式代碼 s,然后進(jìn)行 歸一化。此外,基于 MLP 的映射網(wǎng)絡(luò)從噪聲中生成樣式代碼 w,以模擬圖像生成的隨機(jī)性。代碼 w 與 s 結(jié)合產(chǎn)生一個全局代碼 g = [s; w],用于之后的解碼步驟。

歸一化。此外,基于 MLP 的映射網(wǎng)絡(luò)從噪聲中生成樣式代碼 w,以模擬圖像生成的隨機(jī)性。代碼 w 與 s 結(jié)合產(chǎn)生一個全局代碼 g = [s; w],用于之后的解碼步驟。

全局空間級聯(lián)調(diào)制。為了在解碼階段更好地連接全局上下文,該研究提出了全局空間級聯(lián)調(diào)制 (CM,cascaded modulation)。如圖 2(右)所示,解碼階段基于全局調(diào)制塊(GB)和空間調(diào)制塊(SB)兩個分支,并行上采樣全局特征 F_g 和局部特征 F_s。

與現(xiàn)有方法不同,CM-GAN 引入了一種將全局上下文注入空洞區(qū)域的新方法。在概念層面上,它由每個尺度的特征之間的級聯(lián)全局和空間調(diào)制組成,并且自然地集成了全局上下文建模的三種補(bǔ)償機(jī)制:1)特征上采樣;2) 全局調(diào)制;3)空間調(diào)制。

物體感知訓(xùn)練

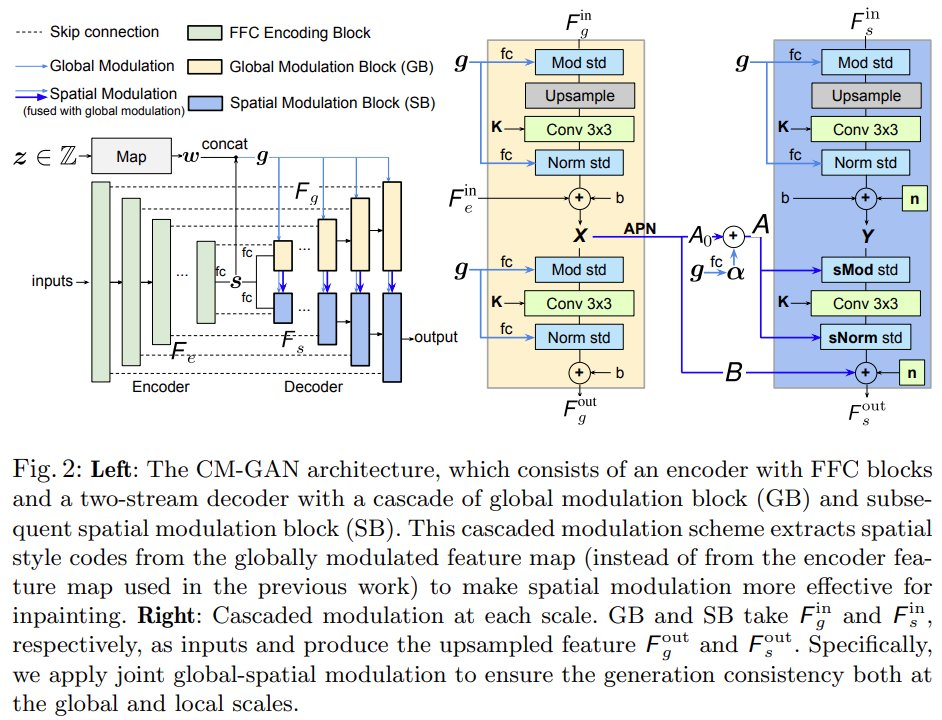

為訓(xùn)練生成掩碼的算法至關(guān)重要。本質(zhì)上,采樣的掩碼應(yīng)該類似于在實際用例中繪制的掩碼,并且掩碼應(yīng)避免覆蓋整個物體或任何新物體的大部分。過度簡化的掩碼方案可能會導(dǎo)致偽影。

為了更好地支持真實的物體移除用例,同時防止模型在空洞內(nèi)合成新物體,該研究提出了一種物體感知訓(xùn)練方案,在訓(xùn)練期間生成了更真實的掩碼,如下圖 4 所示。

具體來說,該研究首先將訓(xùn)練圖像傳遞給 全景分割網(wǎng)絡(luò) PanopticFCN 以生成高度準(zhǔn)確的實例級分割注釋,然后對自由空洞和物體空洞的混合進(jìn)行采樣作為初始掩碼,最后計算空洞和圖像中每個實例之間的重疊率。如果重疊率大于閾值,該方法將前景實例從空洞中排除;否則,空洞不變并模擬物體完成,其中閾值設(shè)為 0.5。該研究隨機(jī)擴(kuò)展和平移物體掩碼以避免過度擬合。此外,該研究還擴(kuò)大了實例分割邊界上的空洞,以避免將空洞附近的背景像素泄漏到修復(fù)區(qū)域中。

訓(xùn)練目標(biāo)與 Masked-R_1 正則化?

該模型結(jié)合對抗性損失和基于分割的感知損失進(jìn)行訓(xùn)練。實驗表明,該方法在純粹使用對抗性損失時也能取得很好的效果,但加入感知損失可以進(jìn)一步提高性能。

此外,該研究還提出了一種專門用于穩(wěn)定修復(fù)任務(wù)的對抗性訓(xùn)練的 masked-R_1 正則化,其中利用掩碼 m 來避免計算掩碼外的梯度懲罰。

實驗

該研究在 Places2 數(shù)據(jù)集上以 512 × 512 分辨率進(jìn)行了圖像修復(fù)實驗,并給出了模型的定量和定性評估結(jié)果。

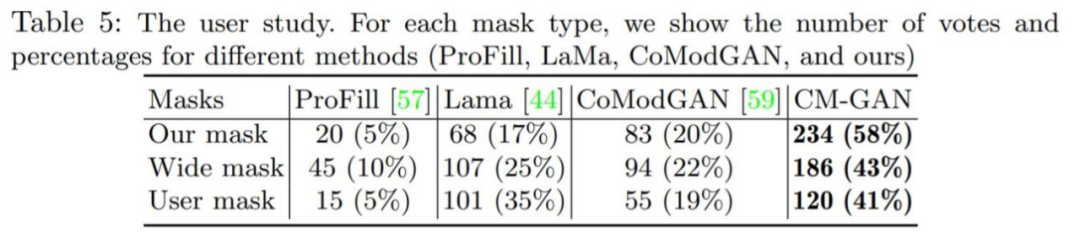

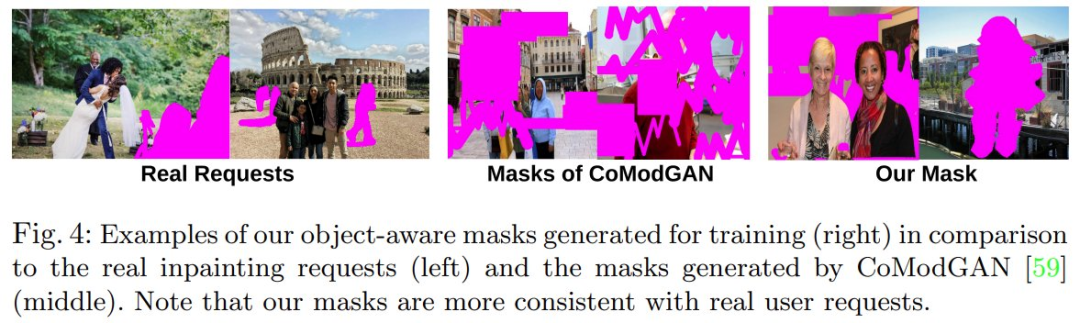

定量評估:下表 1 為 CM-GAN 與其他掩碼方法的比較。結(jié)果表明,CM-GAN 在 FID、LPIPS、U-IDS 和 P-IDS 方面明顯優(yōu)于其他方法。在感知損失的幫助下,LaMa、CM-GAN 比 CoModGAN 和其他方法獲得了明顯更好的 LPIPS 分?jǐn)?shù),這歸功于預(yù)訓(xùn)練感知模型提供的額外語義指導(dǎo)。與 LaMa/CoModGAN 相比,CM-GAN 將 FID 從 3.864/3.724 降低到 1.628。

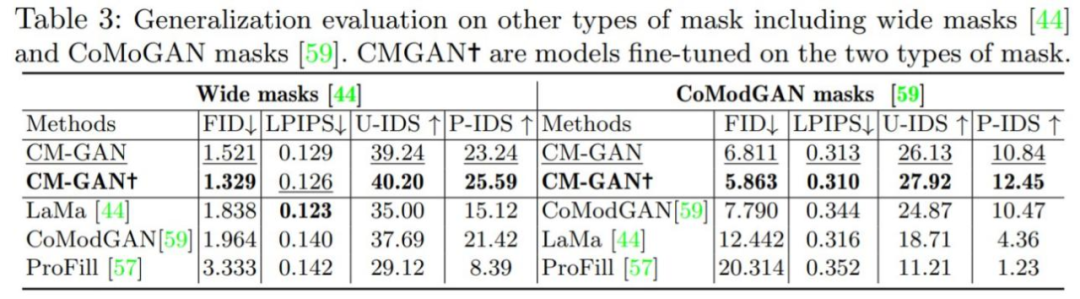

如下表 3 所示,在有無微調(diào)的情況下,CM-GAN 在 LaMa 和 CoModGAN 掩碼上都取得了明顯優(yōu)于 LaMa 和 CoModGAN 的性能增益,表明該模型具有泛化能力。值得注意的是,在 CoModGAN 掩碼,物體感知掩碼上訓(xùn)練的 CM-GAN 性能依然優(yōu)于 CoModGAN 掩碼,證實了 CM-GAN 具有更好的生成能力。

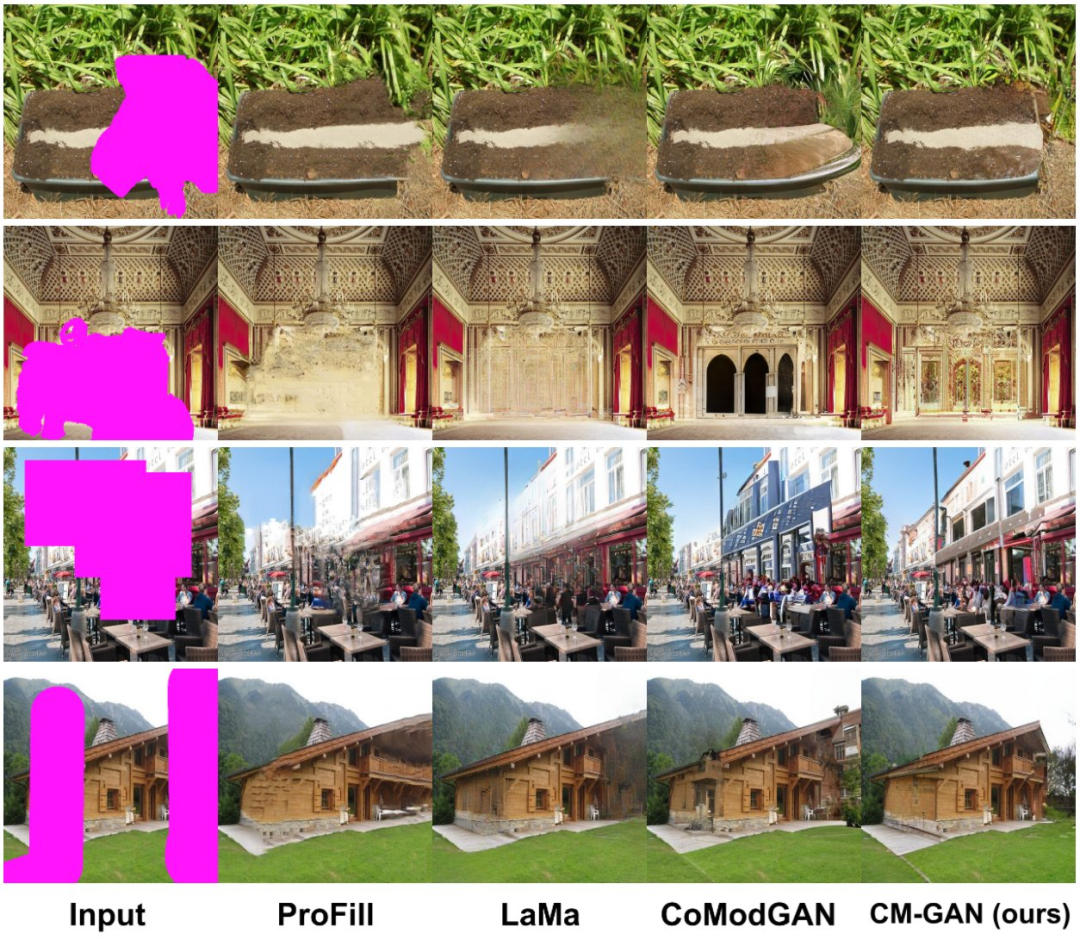

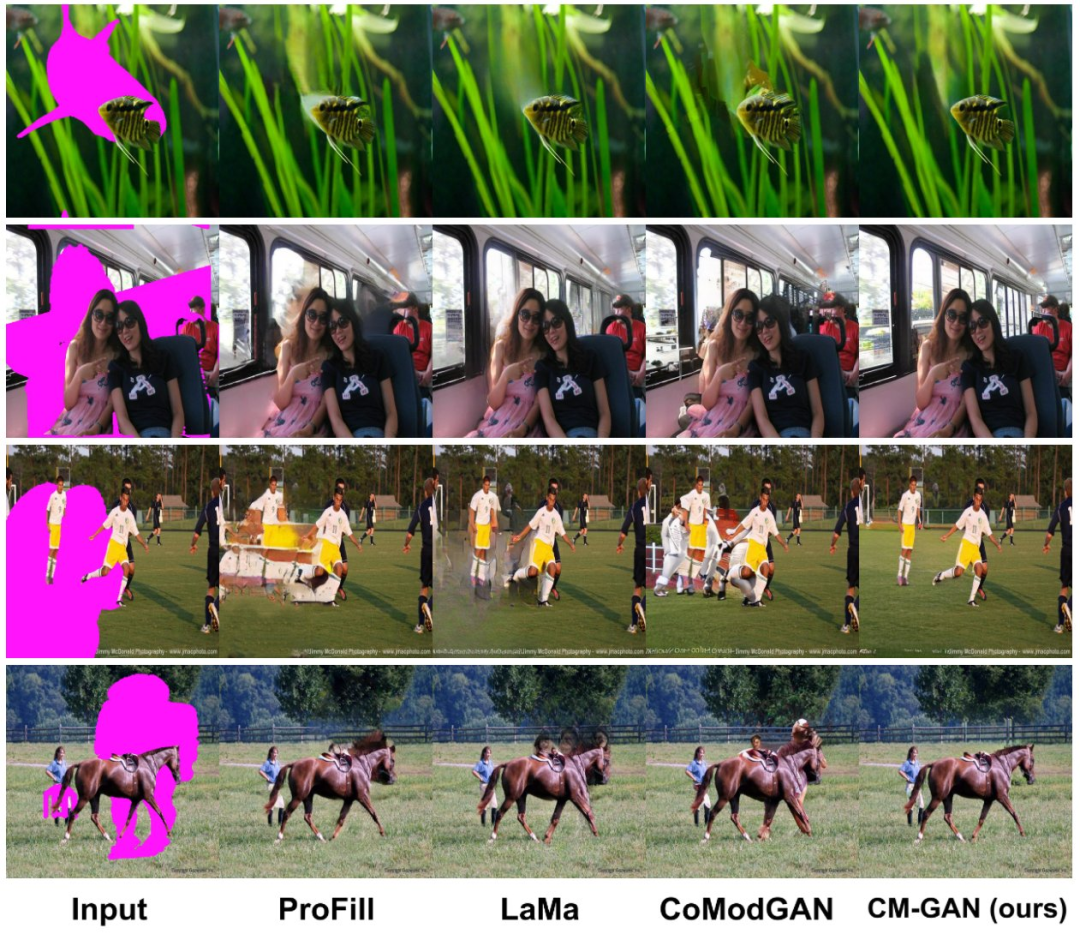

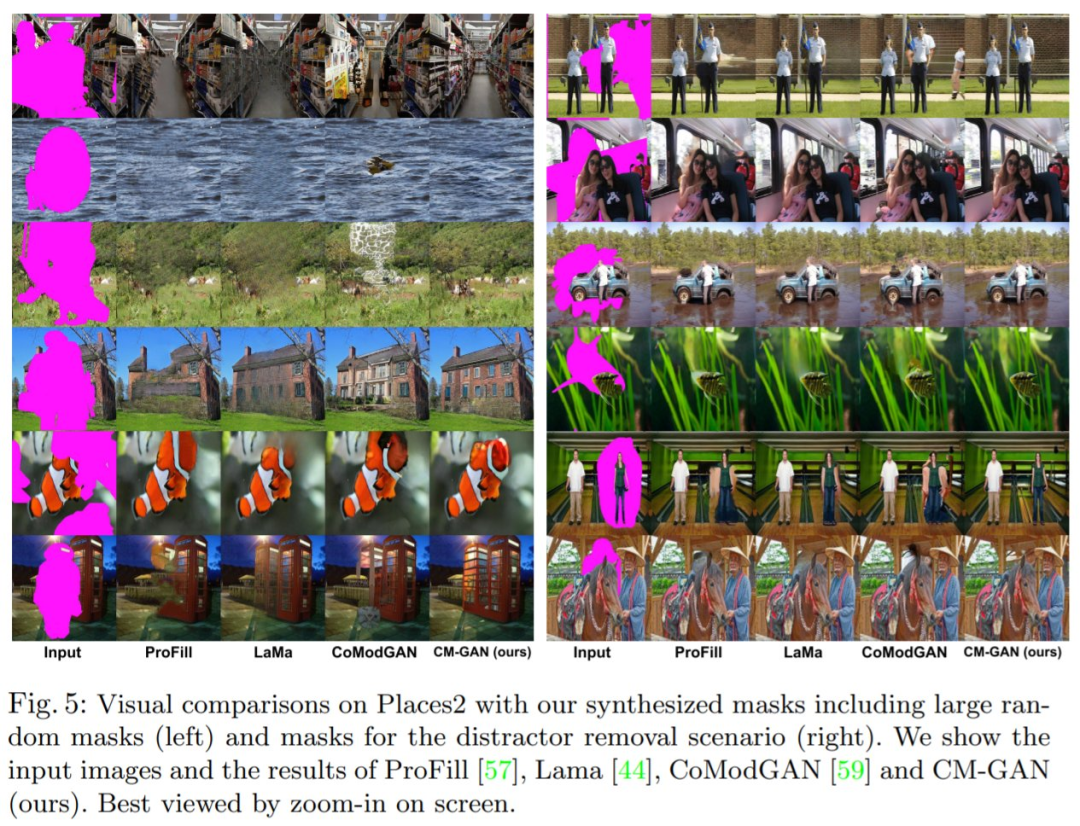

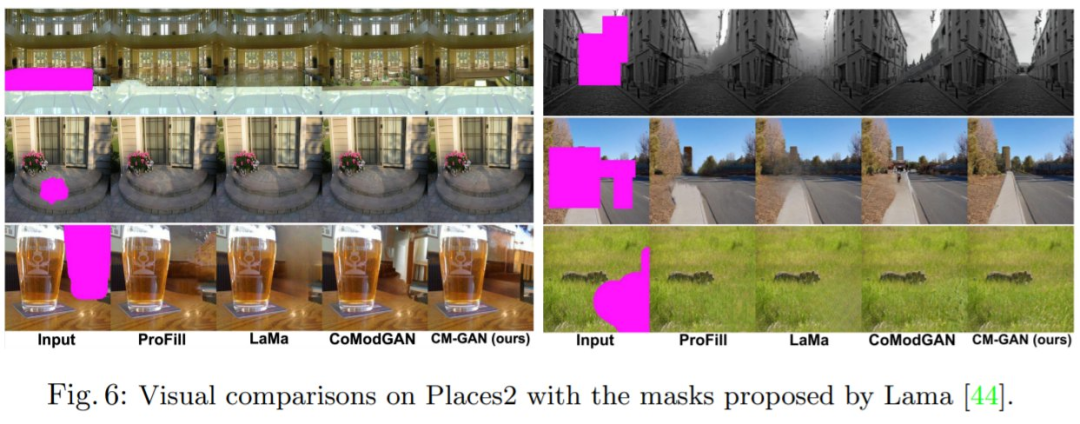

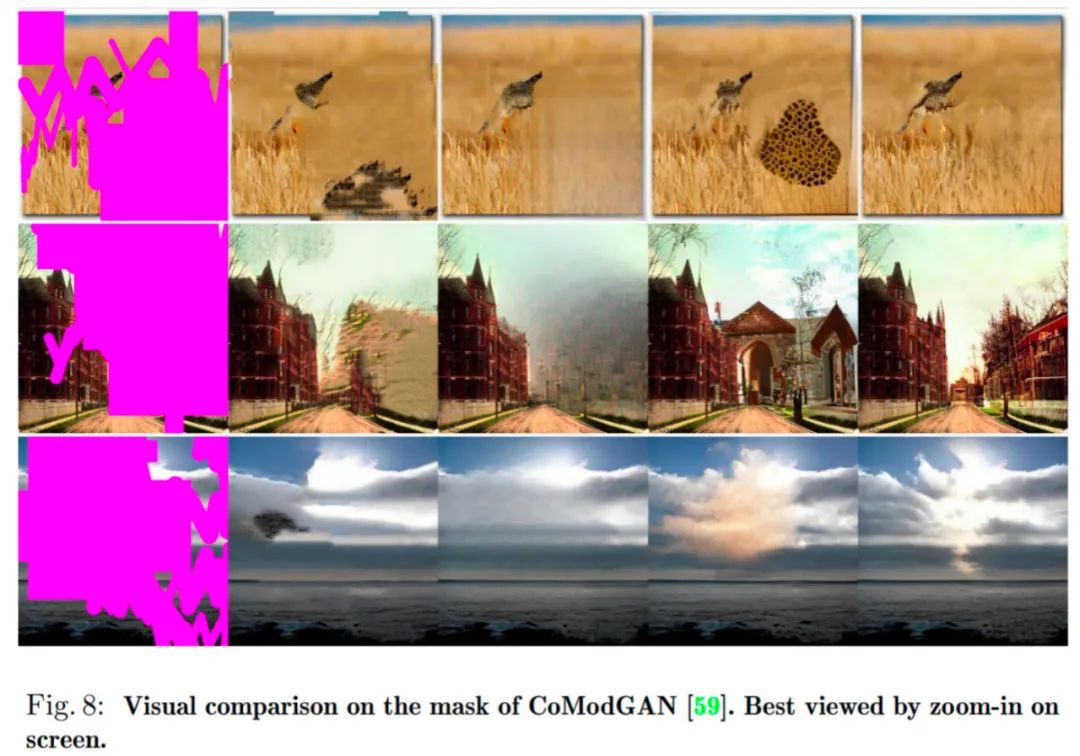

定性評估:圖 5、圖 6、圖 8 展示了 CM-GAN 與 SOTA 方法在合成掩碼方面的可視化比較結(jié)果。ProFill 能夠生成不連貫的全局結(jié)構(gòu),CoModGAN 產(chǎn)生結(jié)構(gòu)偽影和顏色斑點,LaMa 在自然場景上容易產(chǎn)生較大的圖像模糊。相比之下,CM-GAN 方法產(chǎn)生了更連貫的語義結(jié)構(gòu)、紋理更清晰,可適用于不同場景。

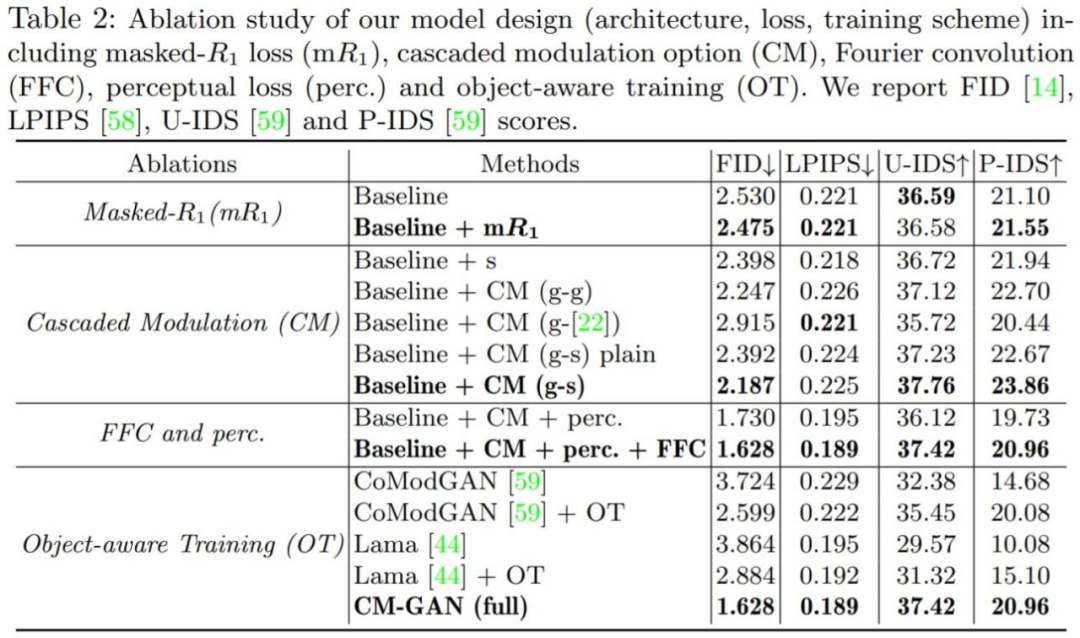

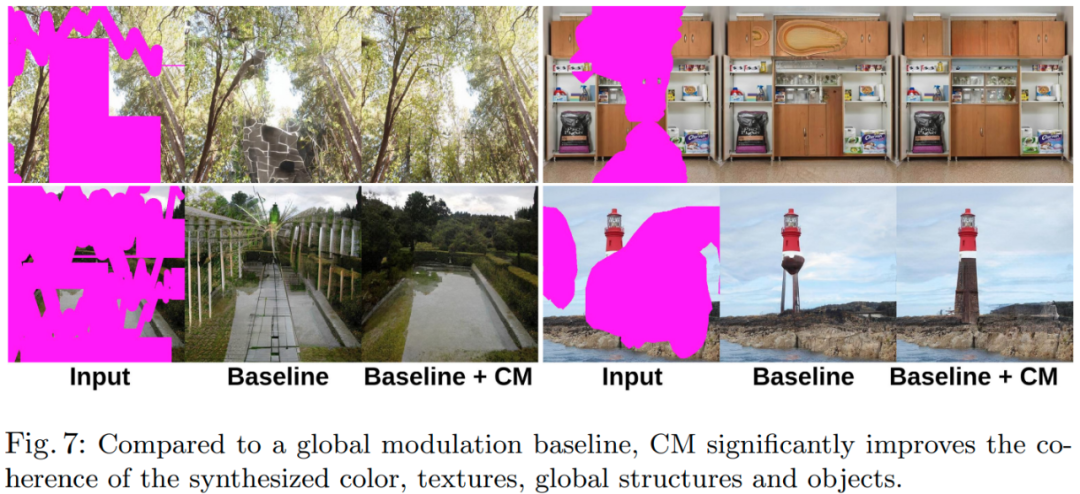

為了驗證模型中每個組件的重要性,該研究進(jìn)行了一組消融實驗,所有模型都在 Places2 數(shù)據(jù)集上進(jìn)行訓(xùn)練和評估。消融實驗結(jié)果如下表 2 和圖 7 所示。

該研究還進(jìn)行了用戶研究,以更好地評估 CM-GAN 方法的視覺生成質(zhì)量,結(jié)果如下表 5 所示。此外,附錄提供了更多的視覺比較和實驗分析以供讀者參閱。

? ?