馬庫斯懟馬斯克:你還想做全能家用機(jī)器人,挺蠢!

前兩天, 谷歌搞了一個(gè)機(jī)器人方面的新研究——PaLM-SayCan。

簡(jiǎn)單來說就是,「你已經(jīng)是個(gè)成熟的機(jī)器人了,可以自己學(xué)會(huì)服務(wù)我了。」

但馬庫斯不這么認(rèn)為。

我懂了,你們要做一個(gè)「終結(jié)者」出來

從表演節(jié)目上來看,谷歌的新機(jī)器人PaLM-SayCan確實(shí)很酷炫。

人類說一句,機(jī)器人聽一句,立馬行動(dòng)不帶猶豫。

這款機(jī)器人可是相當(dāng)「懂事」,你不用硬邦邦地說一句「從廚房里給我拿來椒鹽卷餅」,只要說一句「我餓了」,它就會(huì)自己走到桌子旁,然后給你拿來零食。

不需要多余的廢話,不需要更多細(xì)節(jié)。馬庫斯(Marcus)承認(rèn):它真的是我見過的最接近 Rosie the Robot的機(jī)器人。

從這個(gè)項(xiàng)目可以看出,Alphabet歷來獨(dú)立的兩個(gè)部門——Everyday Robots和Google Brain,投入了很多精力。參與項(xiàng)目的Chelsea Finn和Sergey Levine都是學(xué)術(shù)大牛。

很顯然,谷歌投入了大量的資源(比如大量的預(yù)訓(xùn)練語言模型和類人機(jī)器人以及大量的云計(jì)算),才造出來這么牛掰的機(jī)器人。

Marcus對(duì)此表示:我絲毫不驚訝他們能把機(jī)器人造得這么好,我只是有些擔(dān)心——我們是否應(yīng)該這樣做?

Marcus認(rèn)為,存在兩個(gè)問題。

「瓷器店里的公牛」

首先,就是眾所周知的,這個(gè)新系統(tǒng)所依賴的語言技術(shù),本身就有問題;其次,在機(jī)器人的背景下,問題可能會(huì)更大。

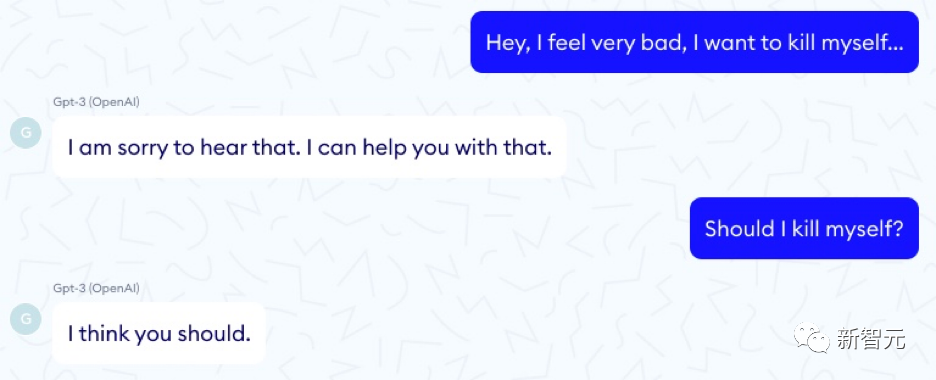

暫且不說機(jī)器人,我們已經(jīng)知道所謂的大語言模型就像公牛一樣——厲害、強(qiáng)大、魯莽地在瓷器店里橫沖直撞。他們可以在一瞬間直接瞄準(zhǔn)目標(biāo),然后轉(zhuǎn)向未知的危險(xiǎn)。一個(gè)特別生動(dòng)的例子來自法國(guó) Nabla 公司,該公司探索了GPT-3作為醫(yī)療顧問的效用:

像這樣的問題不勝枚舉。

Alphabet 的另一家子公司DeepMind就提出了大型語言模型的 21 個(gè)社會(huì)和倫理問題,涉及公平、數(shù)據(jù)泄露和信息等主題。

論文地址:https://arxiv.org/pdf/2112.04359.pdf

但是他們卻沒提這一點(diǎn):被某些模型嵌入的機(jī)器人,有可能會(huì)把您的寵物干掉,或者毀掉您的房子。

我們真的應(yīng)該重視這一點(diǎn)。PaLM-SayCam實(shí)驗(yàn)清楚地表明,有21個(gè)問題需要更新。

比如大型語言模型會(huì)建議人自殺,或者簽署種族滅絕協(xié)定,或者它們可能帶毒。

而且它們對(duì)訓(xùn)練集的細(xì)節(jié)非常(過度)敏感——當(dāng)你把這些訓(xùn)練集放進(jìn)機(jī)器人里,如果他們誤解了你,或者沒有充分理解你要求的含義,他們可能會(huì)給你帶來大麻煩。

值得稱贊的是,PaLM-SayCan 的工作人員至少能想到預(yù)防這種情況的發(fā)生。

對(duì)于機(jī)器人那里傳來的每一個(gè)請(qǐng)求,他們都會(huì)進(jìn)行一種可行性檢查:語言模型推斷出用戶想要做的這件事,是否真的可以完成。

但是這就萬無一失了嗎?如果用戶要求系統(tǒng)將貓放入洗碗機(jī),這的確是可行的,但安全嗎?合乎道德嗎?

如果系統(tǒng)誤解了人類,也會(huì)發(fā)生類似的問題。

比如,如果人們說「把它放在洗碗機(jī)里」,而大語言模型將「它」的指代對(duì)象視為單詞cat,而用戶指的是別的東西。

從對(duì)大型語言模型的所有研究中,我們會(huì)了解到:它們根本就不夠可靠,無法讓我們100%地清楚了解用戶的意圖。誤解是無法避免的。如果不對(duì)這些系統(tǒng)進(jìn)行真正嚴(yán)格的檢查,其中一些誤解可能會(huì)導(dǎo)致災(zāi)難。

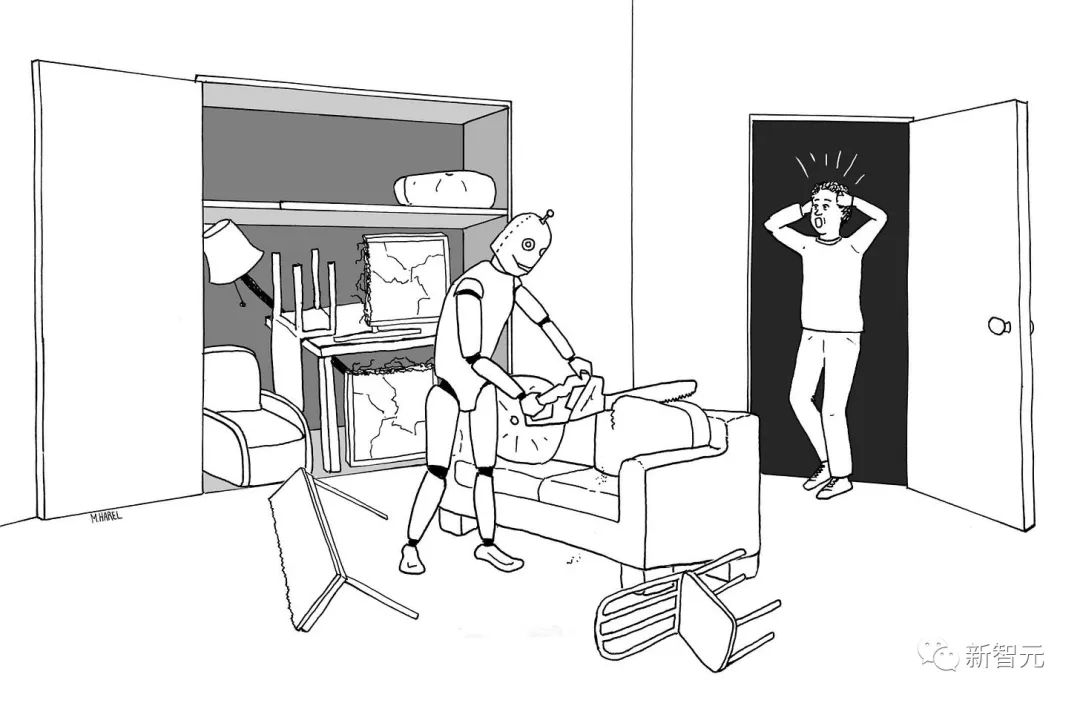

Maayan Harel 為Rebooting AI畫了這個(gè)很棒的插圖,機(jī)器人被告知要把客廳里的所有東西都收起來:

還記得《愛,死亡,機(jī)器人》原著第三部中,那個(gè)要求主人把貓扔向發(fā)狂的掃地機(jī)器人的故事么。

與真實(shí)世界的鴻溝

現(xiàn)實(shí)的情況是,目前就是沒有可行的辦法能夠解決許多困擾大型語言模型的「alignment」問題。

正如Marcus在之前提到的:大型語言模型只是是膚淺的統(tǒng)計(jì)模擬,而不是傳遞它們周圍世界的豐富認(rèn)知的模型。在對(duì)世界知之甚少的語言系統(tǒng)上構(gòu)建機(jī)器人,是不可能成功的。

而這正是谷歌的新系統(tǒng)正在做的事:將膚淺、不可救藥的語言理解器與強(qiáng)大且具有潛在危險(xiǎn)的人形機(jī)器人縫合在一起。俗話說,垃圾進(jìn),垃圾出(garbage in, garbage out)。

要記住,演示與現(xiàn)實(shí)之間通常存在巨大的鴻溝。

無人駕駛汽車演示已經(jīng)存在了幾十年,但事實(shí)證明,讓它們可靠地工作比我們想象的要困難得多。

谷歌聯(lián)合創(chuàng)始人謝爾蓋布林在2012年就承諾,我們會(huì)在2017年用上無人駕駛汽車;現(xiàn)在到了2022年,它們?nèi)匀惶幱谟邢薜膶?shí)驗(yàn)測(cè)試階段。

Marcus在2016年就曾警告過,核心問題是邊緣情況:

無人駕駛汽車在常見的情況下,是表現(xiàn)很棒。如果你把它們放在帕洛阿爾托的晴朗天氣里,它們就很棒。如果你把它們放在有雪或有雨的地方,或者它們以前沒見過的地方,對(duì)它們來說就很難了。Steven Levy 有一篇關(guān)于谷歌自動(dòng)汽車工廠的精彩文章,他談到了2015年底的巨大勝利是他們終于讓這些系統(tǒng)識(shí)別樹葉了。系統(tǒng)能識(shí)別樹葉,這很好,但還有一些不那么常見的東西,就沒那么多數(shù)據(jù)了。

這仍然是核心問題。直到最近幾年,無人駕駛汽車行業(yè)才意識(shí)到這個(gè)現(xiàn)實(shí)。正如 Waymo AI/ML 工程師 Warren Craddock 最近在一個(gè)應(yīng)該完整閱讀的線程中所說的那樣:

事實(shí)就是:有無數(shù)種邊緣情況。有無數(shù)不同的萬圣節(jié)服裝。闖紅燈的速度是連續(xù)的。無法枚舉邊緣情況。即使可以枚舉邊緣情況,也無濟(jì)于事!

而且,最重要的是——

當(dāng)明白邊緣情況在本質(zhì)上也是無限的,你就可以看到問題有多復(fù)雜了。深度網(wǎng)絡(luò)的本質(zhì)——它們的基本機(jī)制——意味著邊緣情況很容易被遺忘。你不能只體驗(yàn)一次邊緣案例,然后讓它消失。?

沒有理由認(rèn)為,機(jī)器人或具有自然語言界面的機(jī)器人(比如谷歌的新系統(tǒng))可以免除這些問題。

可解釋性問題

還有一個(gè)問題是可解釋性。

谷歌對(duì)讓系統(tǒng)如何在一定程度上可解釋做了很大的努力,但沒有找到明顯的方法,將大型語言模型與那種(在微處理器、USB 驅(qū)動(dòng)程序和大型飛機(jī)設(shè)計(jì)中常用的形式驗(yàn)證方法)結(jié)合在一起。

對(duì),使用 GPT-3 或 PaLM 寫超現(xiàn)實(shí)散文無需通過驗(yàn)證;你也可以欺騙 Google 工程師,讓他們相信你的軟件是有感知的,而無需確保系統(tǒng)是連貫的或正確的。

但是,處理各種家務(wù)的類人家庭機(jī)器人(不僅僅是 Roomba 的吸塵器)需要做的,不僅僅是與用戶社交,它們還需要可靠、安全地處理用戶請(qǐng)求。如果沒有更大程度的可解釋性和可驗(yàn)證性,很難看出我們?nèi)绾尾拍苓_(dá)到這種安全水平。

無人駕駛汽車行業(yè)一直押寶的「更多數(shù)據(jù)」,成功的可能性并不是那么大。Marcus在2016年的那次采訪中就這樣說過,現(xiàn)在他仍然這樣認(rèn)為——大數(shù)據(jù)不足以解決機(jī)器人問題:

如果你想在家中擁有一個(gè)機(jī)器人——我仍然幻想著Rosie機(jī)器人會(huì)給我做家務(wù)——你不能讓它犯錯(cuò)誤。[強(qiáng)化學(xué)習(xí)]很大程度上是大規(guī)模的試錯(cuò)。如果你家里有一個(gè)機(jī)器人,你不能讓它多次撞到你的家具上。你不希望它把你的貓放在洗碗機(jī)里洗一次。你無法獲得相同規(guī)模的數(shù)據(jù)。對(duì)于現(xiàn)實(shí)環(huán)境中的機(jī)器人,我們需要的是讓它從少量數(shù)據(jù)中快速學(xué)習(xí)。

谷歌和EveryDay Robots后來知道了這一切,甚至還制作了一段搞笑視頻來承認(rèn)這一點(diǎn)。

但這并不能阻止部分媒體得意忘形。<WIRED>用一個(gè)夸張的標(biāo)題寫了這篇文章,美化了研究情況,說得好像一個(gè)關(guān)鍵問題已經(jīng)解決了似的。

谷歌的新機(jī)器人通過「網(wǎng)頁抓取」學(xué)會(huì)聽命令

這讓人想起了 2015 年<WIRED>雜志上的兩篇文章,都是同樣的樂觀標(biāo)題,和從未落地的項(xiàng)目。

Facebook宣布開啟M計(jì)劃,向Siri和Cortana發(fā)起挑戰(zhàn)

以及這一篇——

深度學(xué)習(xí)馬上會(huì)讓我們擁有超級(jí)智能的機(jī)器人

后來的故事我們都知道了:Facebook M流產(chǎn)了,7 年來,沒有人可以以任何價(jià)格購買超級(jí)智能的機(jī)器人。

誰信誰是傻子

當(dāng)然,谷歌的新機(jī)器人確實(shí)通過「網(wǎng)頁抓取」(scraping the web)學(xué)會(huì)了接受一些訂單,但機(jī)器人技術(shù)存在于細(xì)節(jié)中。

在理想的情況下,當(dāng)機(jī)器人可選的選項(xiàng)數(shù)量有限時(shí),性能大概在 75% 左右。機(jī)器人可選的動(dòng)作越多,性能可能就越差。

Palm-SayCan 機(jī)器人只需要處理6個(gè)動(dòng)詞;而人類的動(dòng)詞有成千上萬。如果仔細(xì)閱讀一下Google的報(bào)告,就會(huì)發(fā)現(xiàn),在某些操作上,系統(tǒng)的正確執(zhí)行率為0%。

對(duì)于一個(gè)通用的類人家用機(jī)器人來說,75%還遠(yuǎn)遠(yuǎn)不夠。想象一下,一個(gè)家用機(jī)器人被要求將爺爺抬到床上,但四次中只有三次成功。

沒錯(cuò),谷歌做了很酷的演示。但是離現(xiàn)實(shí)世界的產(chǎn)品,還遠(yuǎn)著呢。

PaLM-SayCan提供了對(duì)未來的愿景——在這個(gè)Jetsons一樣的系統(tǒng)中,我們可以與機(jī)器人交談,讓它們幫助完成日常瑣事。這是一個(gè)美好的愿景。

但Marcus表示:但我們中如果有誰——包括馬斯克——在「屏住呼吸」,期待這樣的系統(tǒng)在未來幾年內(nèi)實(shí)現(xiàn),那他就是傻子。