Meta千億參數大模型OPT-IML「升級版」來了,完整模型和代碼公布!

今年五月,MetaAI官宣發布了基于1750億參數的超大模型OPT-175B,還對所有社區免費開放。

12月22日,該模型的更新版本OPT-IML(Open Pre-trained Transformer)正式上線,Meta稱其「對2000個語言任務進行了微調,包含1750 億個參數」,還將為非商業研究用途免費開放。

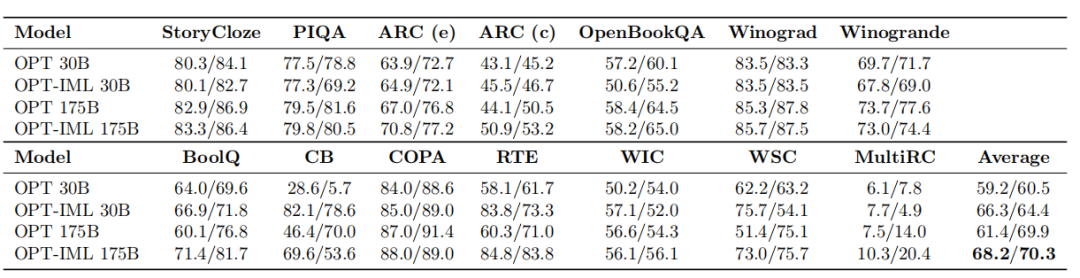

這次更新的OPT-IML的性能表現如何,先上兩張圖來看看。

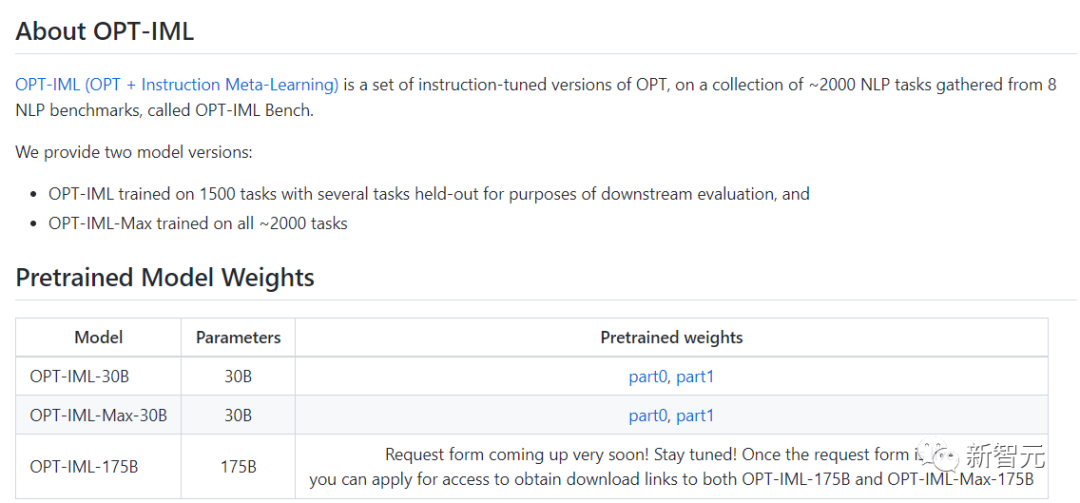

這次的OPT-IML創建了兩種模型尺寸,分別是30B和175B。

與舊版OPT模型相比,OPT-IML在14個標準NLP評估任務中的平均表現均優于OPT。

在零次學習任務上兩種模型大小分別好7%~ 和32-shot 任務分別好4%~ 和 0.4%~。

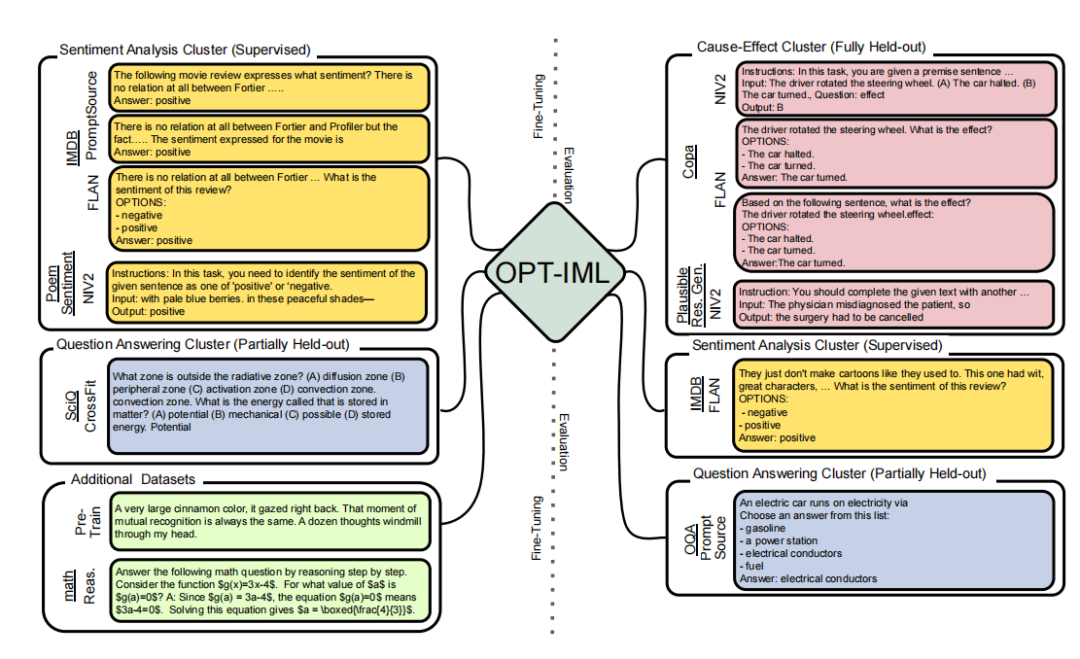

在這項研究中,研究人員描述了增加模型和基準大小如何影響指令調整決策對下游任務性能的影響。

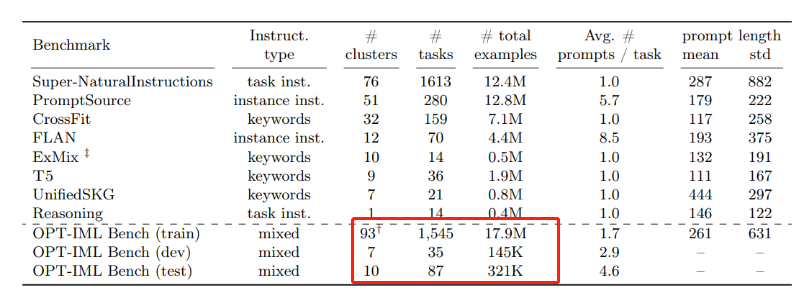

為此他們開發了 OPT-IML Bench,這是一個相當大的指令元學習 (IML) 基準,包含2000個NLP任務,這些任務根據現有的八個基準分為任務類別。

為訓練OPT-IML 30B和175B,研究人員首先從該框架的角度對應用于 OPT-30B 的指令調優決策提出了見解。

在具有不同目標和輸入格式的四個評估基準(PromptSource、FLAN、Super-NaturalInstructions 和 UnifiedSKG)上,OPT-IML 在兩個尺度上展示了所有三種泛化技能。

它不僅在所有基準測試中顯著優于OPT,而且以極具競爭力的方式優于針對該特定基準優化的現有模型。

此外OPT-IML已經開源,Github鏈接小編也放在下面啦~

Github鏈接:https://github.com/facebookresearch/metaseq/tree/main/projects/OPT-IML

接下來通過論文來一起了解一下OPT-IML。

論文鏈接:https://github.com/facebookresearch/metaseq/blob/main/projects/OPT-IML/optimal_paper_v1.pdf

研究方法

大型語言模型的指令微調已成為增強其零樣本和少樣本泛化能力的有效方法。在這項研究中,Meta研究人員對指令微調進行了三項重要的補充。

首先,他們編譯了一個大規模的指令微調基準,其中包含來自八個數據集集合的2,000個NLP任務,按任務類型分類。

研究人員在此基準上有選擇地構建評估拆分,以測試三種不同類型的模型泛化能力:

包括來自完全保留類別的任務(tasks from fully held-out categories)、來自已見類型的保留任務(held-out tasks from seen types)以及來自已見任務的保留實例(held-out instances from seen tasks)。?

指令微調

對模型進行微調,以使它們與遵守說明保持一致,是目前機器學習的研究方向之一。

指令微調有兩種方法。一種側重于使用人工注釋的指令和反饋對各種任務的模型進行微調;另一種,側重于通過注釋或自動向可公開訪問的基準和數據集添加指令。

在本研究中,Meta AI成員專注于第二種技術,并編譯了許多可公開訪問的數據集,其中包含改進OPT的方法。

研究過程中,Meta成員使用來自四個基準的1836個任務,提出了類似的縮放方法。最后,在調整整個測試,以突破具有挑戰性的外部基準(例如 MMLU 和 Big-Bench Hard (BBH))性能極限的同時,研究人員描述了可能影響下游性能的各種指令調整策略的權值。

多任務學習

多任務學習是基于指令的微調 (MTL) 的一種表述。

MTL 是一種流行的范例,當與共享可比較參數或表示的類似函數結合使用時,它可以提高任務的泛化性能。

近年來,MTL已應用于眾多NLP場景,主要側重于通過利用來自相關活動的信號來提高訓練任務或新領域的性能。

相比之下,基于指令的微調有助于我們提高對前所未見問題的泛化性能。它是通過指令將所有任務組合成一個概念并通過在所有任務上分配模型的權重來一起訓練它們來實現的。

什么是OPT?

大型語言模型,即具有超過 1000 億個參數的自然語言處理系統,在過去幾年中改變了NLP和AI研究。

這些模型接受了大量不同文本的訓練,展現出令人驚訝的新能力,可以生成創意文本、解決基本數學問題、回答閱讀理解問題等等。

雖然在某些情況下,公眾可以通過付費 API 與這些模型進行交互,但完整的研究訪問權限仍然僅限于少數資源豐富的實驗室。

這種受限訪問限制了研究人員理解這些大型語言模型如何工作以及為何工作的能力,阻礙了提高其魯棒性和減輕偏見等已知問題的進展。

出于對開放科學的承諾,Meta AI于今年5月發布了Open Pretrained Transformer (OPT-175B),這是一個具有 1750 億參數的模型,在公共數據集上訓練而成,之所以共享這個模型,Meta AI 希望更多的社區參與理解關于大模型的基本技術。

簡單來說,Meta將用于人工智能研究的大型語言模型訪問權限開放給大眾,從而實現大模型研究的人工智能民主化。

與老版對比

根據Meta現在發布的IML版本經過微調,在自然語言任務上的表現比舊版OPT更好。

典型的語言任務包括回答問題、總結文本和翻譯。

為了進行微調,研究人員使用了大約2000個自然語言任務。這些任務分為八個NLP基準(OPT-IML Bench),研究人員也提供了這些基準。

平均而言,以30B和175B模型為例,OPT-IML比OPT的零次學習準確度提高了約 6-7%。在32次學習中,300億參數的模型準確度有顯著改進,1750億參數的模型有輕微改進。

經過對比,Meta團隊發現OPT-IML的性能在所有基準測試上都優于OPT,并且在零樣本和少樣本學習準確度方面,比其他基于指令微調的模型更具有競爭力。