70萬預算從頭開發千億參數大模型,挑戰成功

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

預算10萬美元(約73萬人民幣),從頭訓練一個全新的千億參數大模型。

智源研究院與國內多所高校及南洋理工聯合團隊,挑戰成功。

要知道,當GPT-3的訓練成本可是高達460萬美元,近一些的Llama2據估算也大概是這個數。

這個用10萬美元訓練出的大模型名叫FLM,擁有1010億參數量,目前已經開源。

得益于研究團隊的新型訓練策略,FLM只用了2.17%的花銷,就達到了可以比肩GPT-3的效果,在開發社區引起不小關注。

那么,FLM團隊是如何把訓練成本降低近50倍的呢?

“成長策略”降低訓練成本

不管是租還是買,硬件的價格都擺在那動不了,所以只能是通過減少運算量來降低成本。

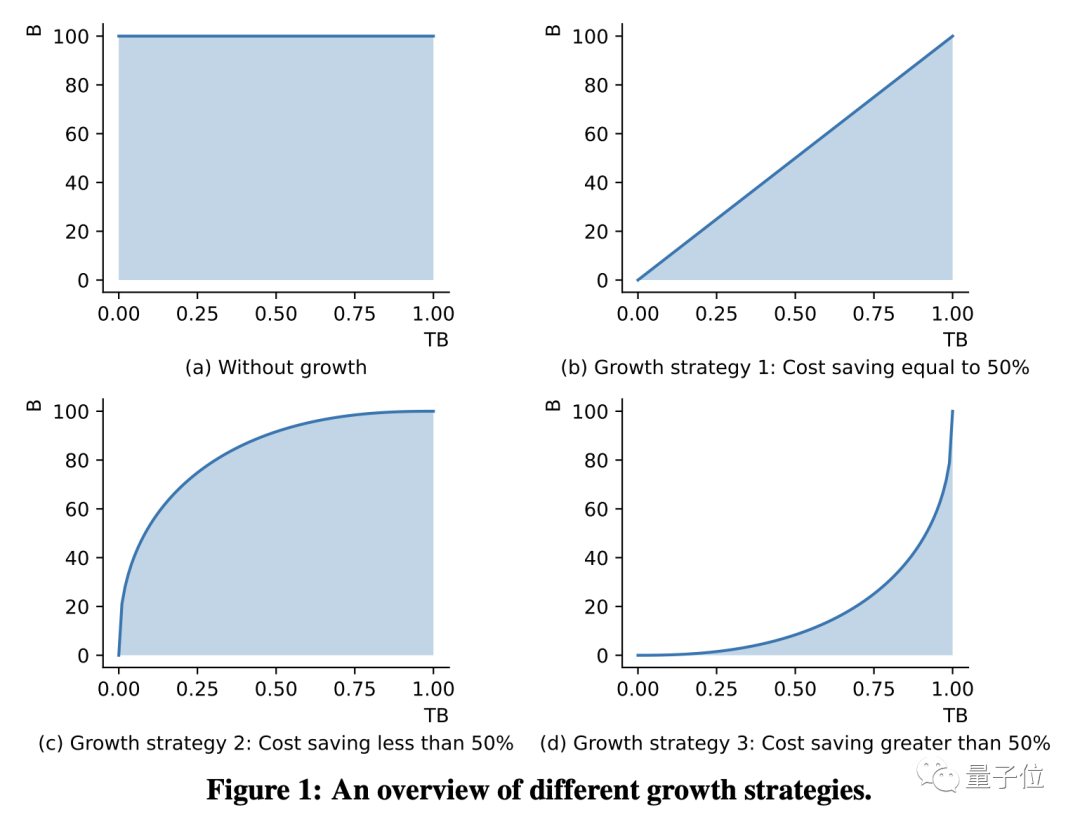

為了降低訓練過程中的運算量,研究團隊在FLM中采用了一種“成長策略”。

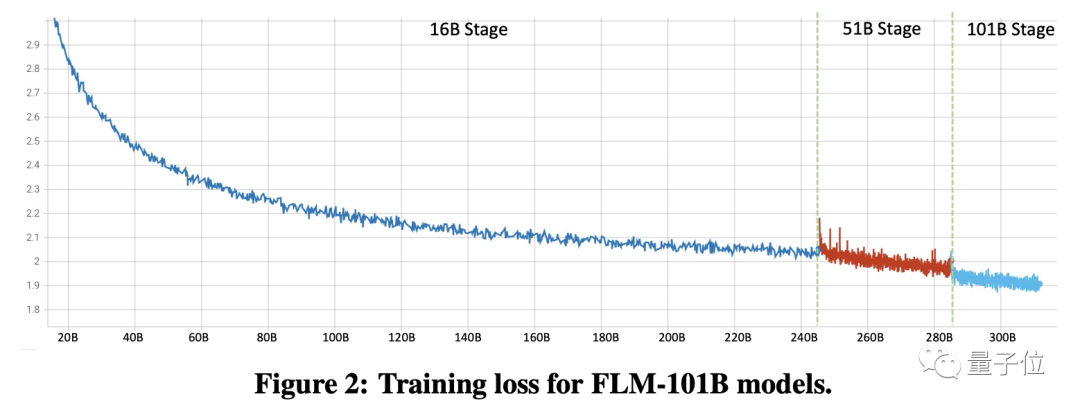

也就是先訓練16B參數的小規模模型,然后擴大到51B,最終再擴展到101B版本。

由于訓練低參數量模型的運算效率更高,這種循序漸進的訓練方式成本要低于一步登天。

看到這里也許有的讀者會有疑問,其他模型不是也有分成多個參數量的版本嗎?

是沒錯,但是這些參數量不同的同種模型是分別進行訓練的,這造成了大量的重復計算,因而成本并不低。

而FLM采用的“成長策略”在訓練大規模版本時會直接繼承低參數量模型中已有的知識,降低了重復運算率。

而具體參數的確定,應用了loss prediction技術,即根據低參數模型的訓練損失預測出高參數量模型的損失。

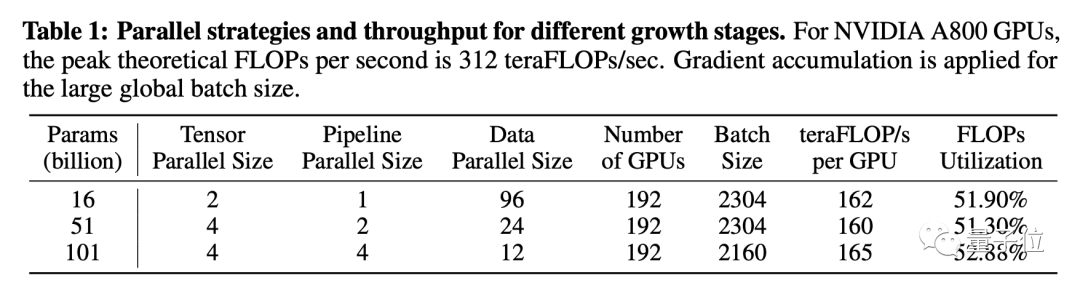

除了這種“由小及大”的“成長策略”之外,FLM的訓練過程中還通過改善并行策略來提高吞吐量。

FLM使用的是混合并行策略,將多種并行方式進行最優化配置,達到高吞吐量,單GPU利用率超過了50%。

團隊還利用序列并行和分布式優化器技術,將輸入序列和優化器狀態分配到不同GPU,減輕了單個GPU的計算和內存壓力。

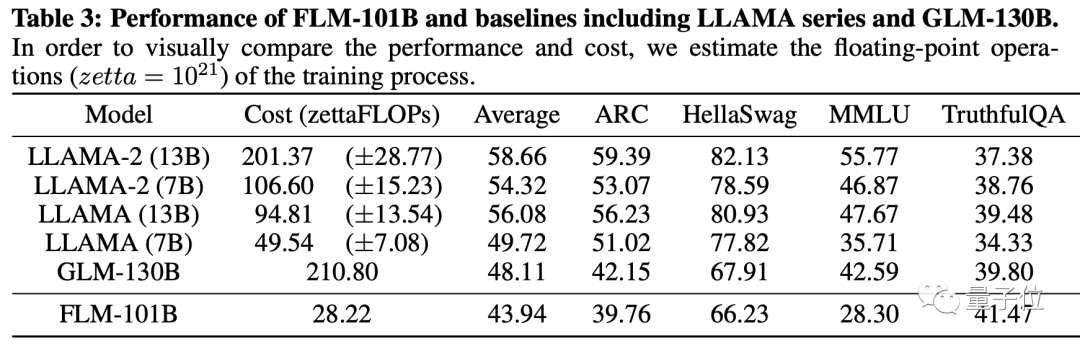

那么,這種“成長策略”訓練出的FLM表現又如何呢?作者給出了Open LLM數據集的測試結果。

FLM在四個項目中取得的平均成績接近GLM-120B和Llama-7B,但訓練成本顯著低于二者。

而在其中的TruthfulQA單項中,FLM的成績甚至超過了Llama 2。

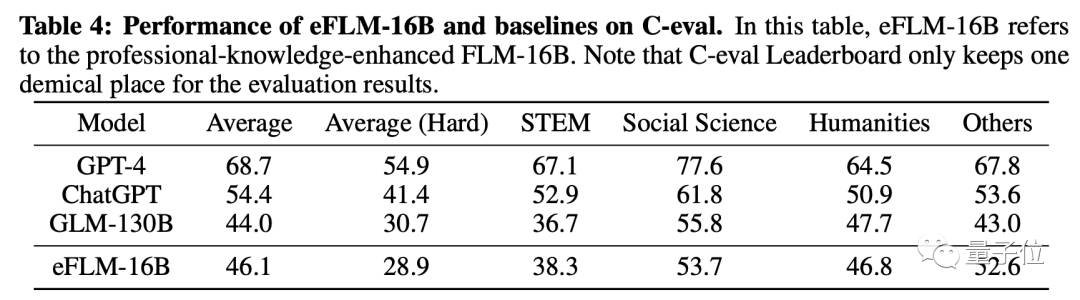

專業知識方面,16B參數的eFLM在C-eval評測中,平均成績超過了130B參數的GLM,并接近ChatGPT。

除了這些一般的benchmark,FLM團隊還提出了一項大模型“IQ測試”。

給大模型“測智商”

FLM團隊提出的大模型“智商測試”重點考察模型的推理泛化能力,而非知識儲備。

這項測試從如下四個維度進行了展開:

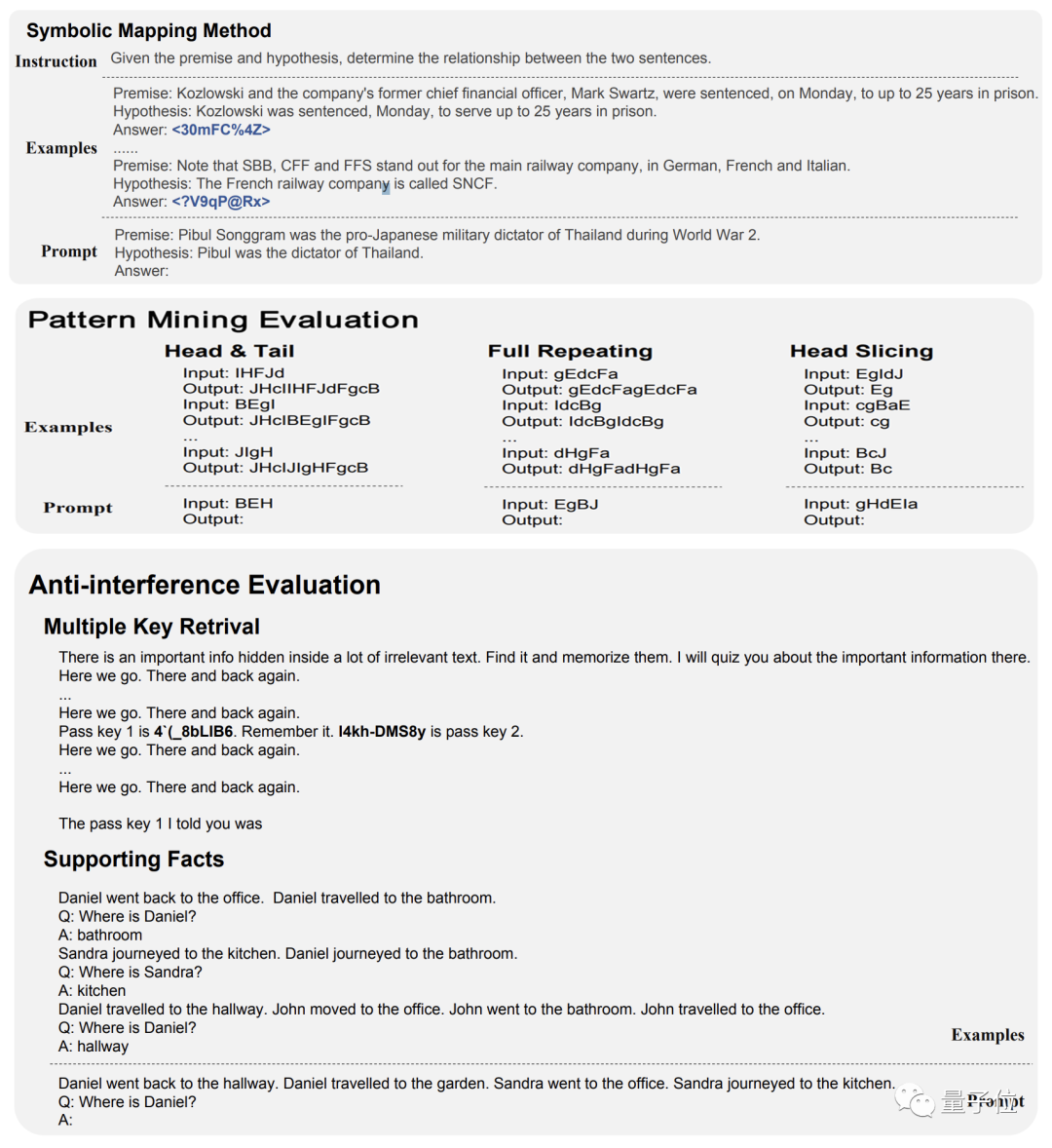

- 符號映射:使用隨機符號替換分類標簽,評估模型推理和泛化能力,避免過度擬合。

- 規則理解:檢驗模型能否按照給定規則進行操作,如“計數”、“字符串替換”等。

- 模式挖掘:給出示例,讓模型歸納推導出規律并應用,如“頭尾添加”等。

- 抗干擾能力:在噪聲環境中提取關鍵信息,包括多關鍵信息提取、單論據追蹤和雙論據追蹤三項內容。

其中第一、三、四項的示例如下圖所示:

那么,FLM面對自家提出的測評標準,成績到底怎么樣呢?

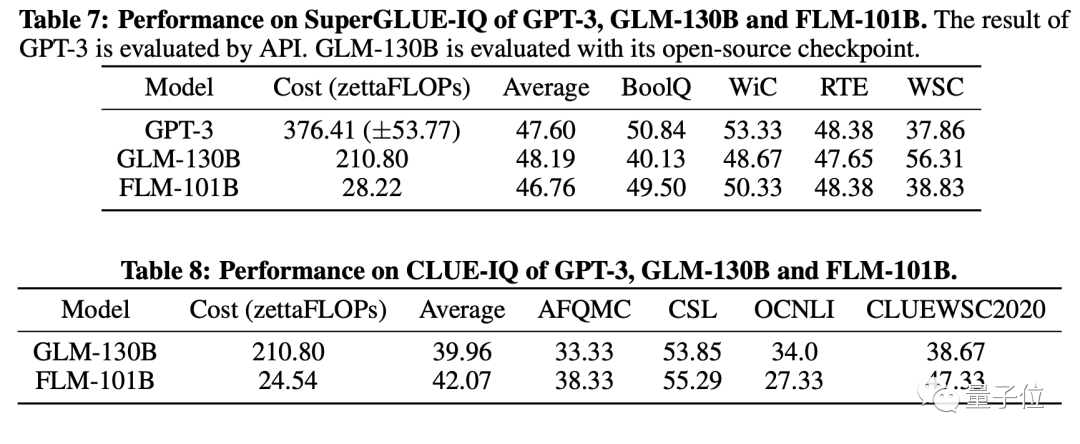

符號映射測評中,FLM以低一個數量級的運算量在SuperGLUE數據集上取得了與GLM和GPT-3相近的成績,在CLUE數據集上的表現更是超過了GLM。

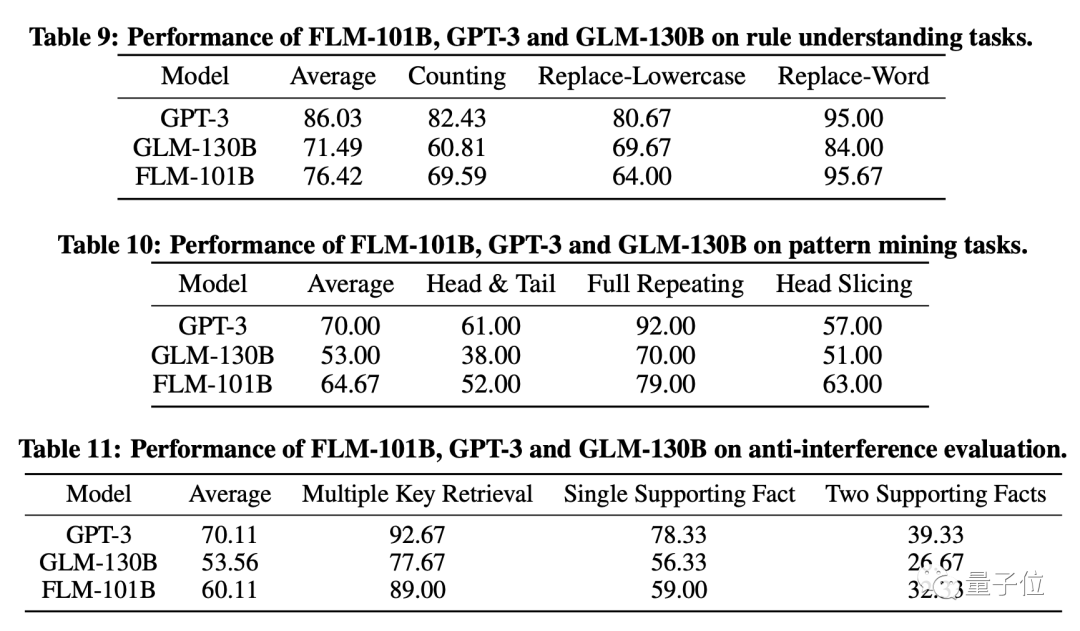

其余三個項目的成績也都超過了GLM,并接近GPT-3。

論文地址:https://arxiv.org/abs/2309.03852Hugging Face項目頁:

https://huggingface.co/CofeAI/FLM-101B