伯克利開源首個泊車場景下的高清數據集和預測模型,支持目標識別、軌跡預測

在自動駕駛技術不斷迭代的當下,車輛的行為和軌跡預測對高效、安全駕駛有著極為重要的意義。動力學模型推演、可達性分析等傳統的軌跡預測的方法雖然有著形式明晰、可解釋性強的優點,但在復雜的交通環境中,其對于環境和物體交互的建模能力較為有限。因此,近年來大量研究和應用都基于各種深度學習方法(例如 LSTM、CNN、Transformer、GNN 等),各類數據集例如 BDD100K、nuScenes、Stanford Drone、ETH/UCY、INTERACTION、ApolloScape 等也紛紛涌現,為訓練和評估深度神經網絡模型提供了強力支持,不少 SOTA 模型例如 GroupNet、Trajectron++、MultiPath 等都表現出了良好的性能。

以上模型和數據集都集中在正常的道路行駛場景下,并充分利用車道線、交通燈等基礎設施和特征輔助預測過程;由于交通法規的限制,絕大多數車輛的運動方式也較為明確。然而,在自動駕駛的 “最后一公里”—— 自動泊車場景下,我們將面對不少新的困難:

- 停車場內的交通規則和車道線要求并不嚴格,車輛也經常隨意行駛 “抄近路”

- 為了完成泊車任務,車輛需要完成較為復雜的泊車動作,包括頻繁的倒車、停車、轉向等。在駕駛員經驗不足的情況下,泊車可能成為一個漫長的過程

- 停車場內障礙物較多且雜亂,車間距離較近,稍不留神就可能導致碰撞和剮蹭

- 停車場內行人往往隨意穿行,車輛需要更多的避讓動作

在這樣的場景下,簡單套用現有的軌跡預測模型難以達到理想的效果,而重新訓練模型又缺乏相應數據的支持。當下基于停車場景的數據集例如 CNRPark+EXT 和 CARPK 等,都僅為空閑停車位檢測而設計,圖片來源于提供監控相機第一人稱視角、采樣率低、且遮擋較多,無法用于軌跡預測。

在 2022 年 10 月剛剛結束的第 25 屆 IEEE 智能交通系統國際會議 (IEEE ITSC 2022) 中,來自加州大學伯克利分校的研究者們發布了首個針對停車場景的高清視頻 & 軌跡數據集,并在此數據集的基礎上,利用 CNN 和 Transformer 架構提出了名為 “ParkPredict+” 的軌跡預測模型。

- 論文鏈接:https://arxiv.org/abs/2204.10777

- 數據集主頁、試用和下載申請:https://sites.google.com/berkeley.edu/dlp-dataset (如無法訪問,可嘗試備用頁面 https://cutt.ly/dlp-notion )

- 數據集 Python API:https://github.com/MPC-Berkeley/dlp-dataset

數據集信息

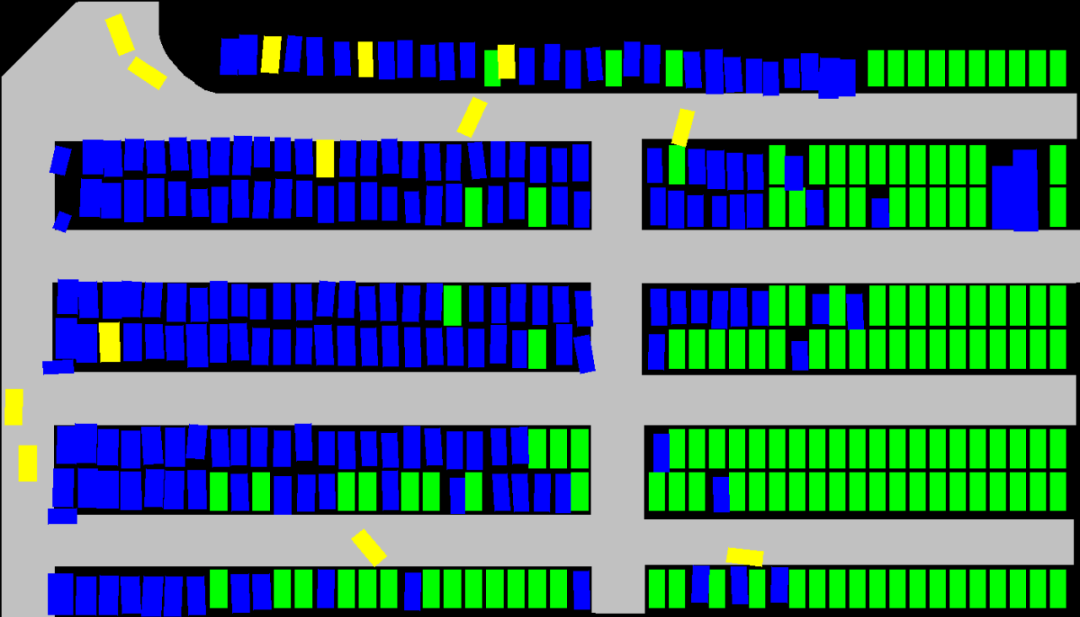

數據集由無人機進行采集,總時長為 3.5 小時,視頻分辨率為 4K,采樣率 25Hz。視野范圍覆蓋了約 140m x 80m 的停車場區域,共計約 400 個停車位。數據集經過精確標注,共采集到 1216 輛機動車、3904 輛自行車和 3904 位行人的軌跡。

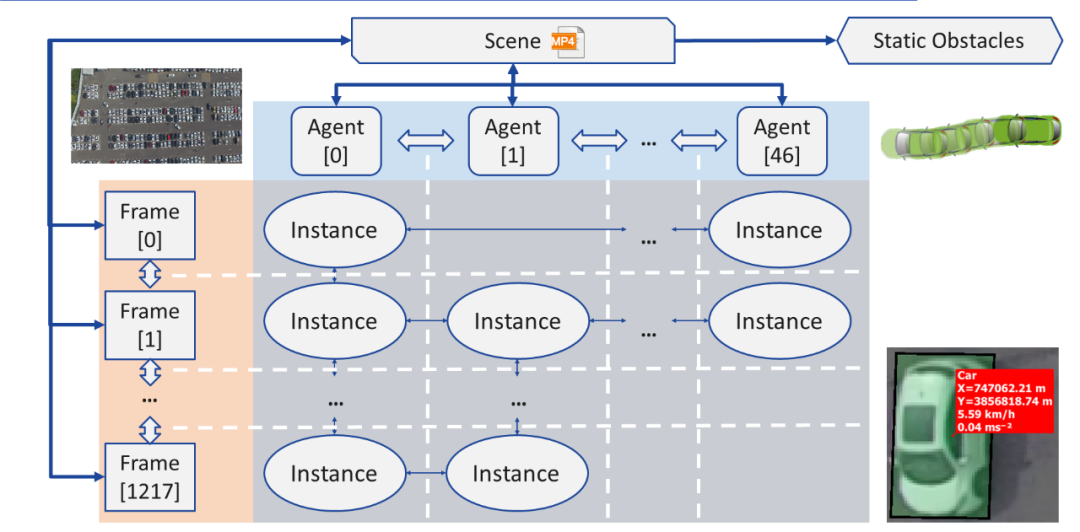

經過重新處理后,軌跡數據可以 JSON 的形式讀取,并加載為連接圖(Graph)的數據結構:

- 個體(Agent):每個個體(Agent)即為一個在當前場景(Scene)下運動的物體,具備幾何形狀、類型等屬性,其運動軌跡被儲存為一個包含實例(Instance)的鏈表(Linked List)

- 實例(Instance):每個實例(Instance)即為一個個體(Agent)在一幀(Frame)中的狀態,包含其位置、轉角、速度和加速度。每個實例都包含指向該個體在前一幀和后一幀下實例的指針

- 幀(Frame):每一幀(Frame)即為一個采樣點,其包含當前時間下所有可見的實例(Instance),和指向前一幀和后一幀的指針

- 障礙物(Obstacle):障礙物即為在此次記錄中完全沒有移動的物體,包含各個物體的位置、轉角和幾何尺寸

- 場景(Scene):每個場景(Scene)對應于一個錄制的視頻文件,其包含指針,指向該錄制的首幀和尾幀、所有個體(Agent)和所有障礙物(Obstacle)

數據集提供兩種下載格式:

僅 JSON(推薦):JSON 文件包含所有個體的類型、形狀、軌跡等信息,可以通過開源的 Python API 直接讀取、預覽、并生成語義圖像(Semantic Images)。如果研究目標僅為軌跡和行為預測,JSON 格式可以滿足所有的需求。

原視頻和標注:如果研究是基于相機原圖像(Raw Image)的目標檢測、分隔、追蹤等機器視覺領域課題,那么可能會需要下載原視頻和標注。如有此需要,需要在數據集申請中明確描述該研究需求。另外,標注文件需自行解析。

行為和軌跡預測模型:ParkPredict+

作為應用示例,在 IEEE ITSC 2022 的論文《ParkPredict+: Multimodal Intent and Motion Prediction for Vehicles in Parking Lots with CNN and Transformer》中,研究團隊利用此數據集,基于 CNN 和 Transformer 架構實現了在停車場場景下車輛的意圖(Intent)和軌跡(Trajectory)預測。

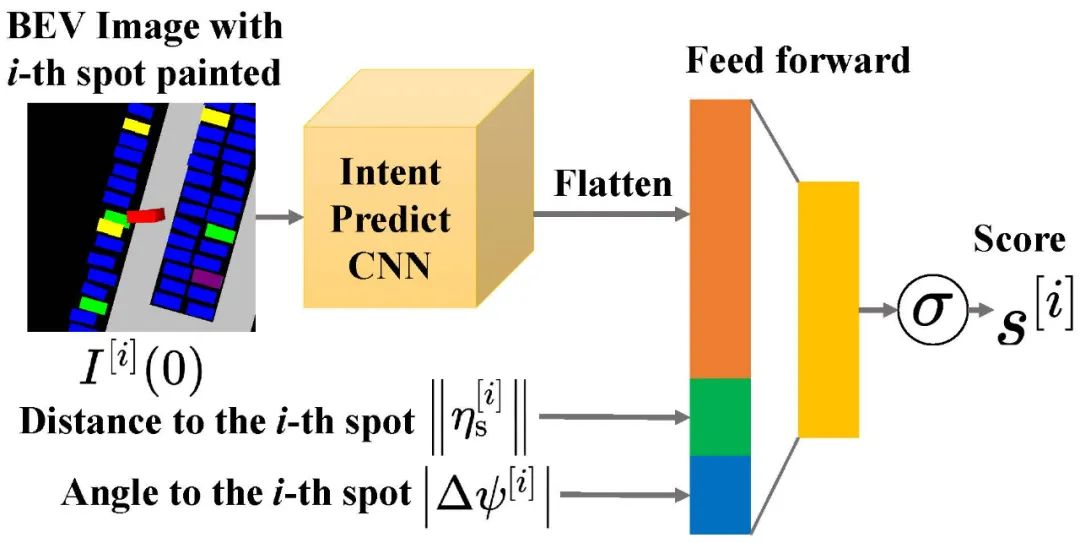

團隊利用 CNN 模型,通過構建語義圖像(Semantic Images),實現了對于車輛意圖(Intent)分布概率的預測 。該模型僅需要構建車輛局部的環境信息,且可根據當前環境,不斷變化可供選擇的意圖數量。

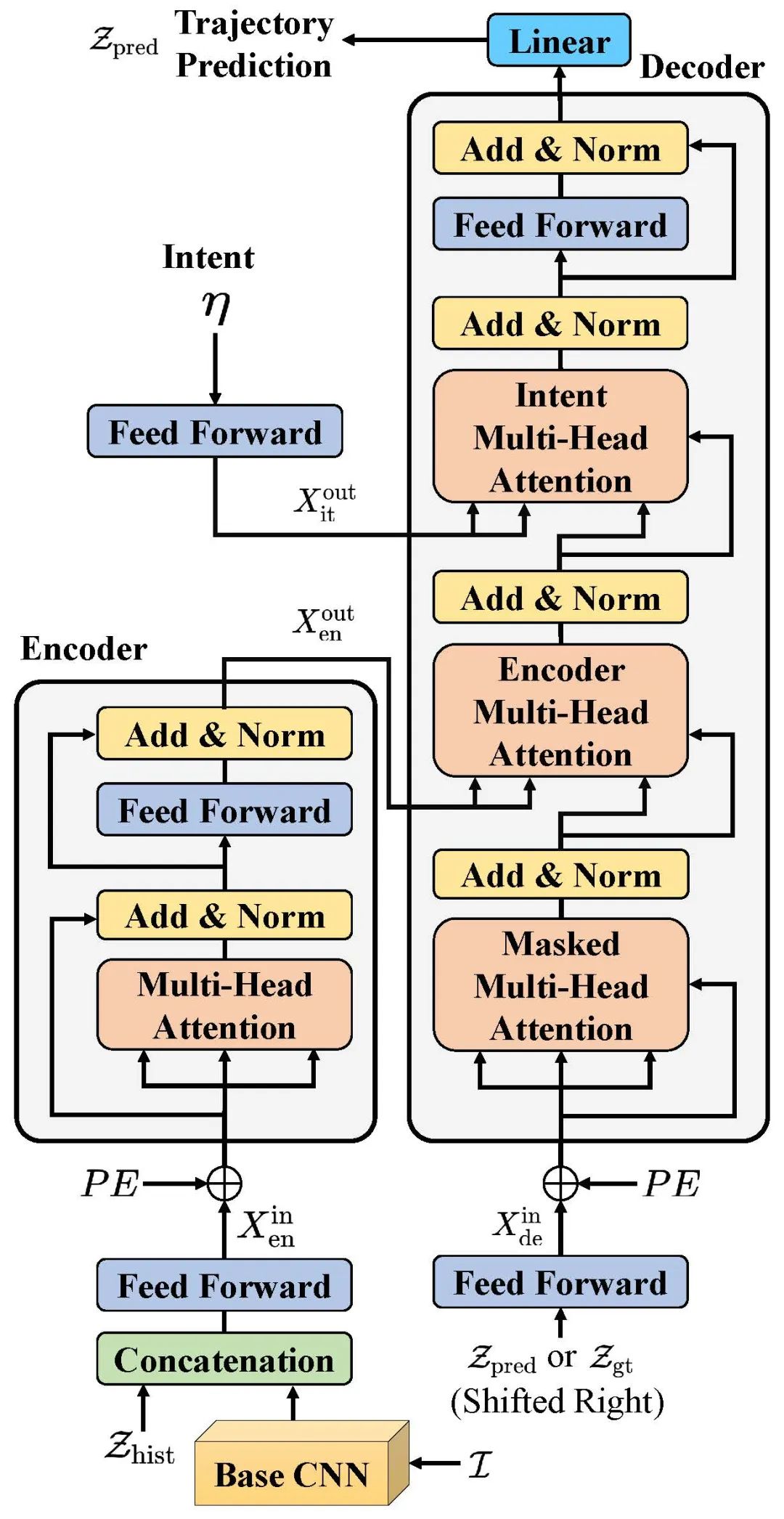

團隊通過改進 Transformer 模型,將意圖(Intent)預測結果、車輛的運動歷史、周邊環境的語義圖作為輸入提供,實現了多模態(Multi-modal)的意圖和行為預測。

總結

- 作為首個針對泊車場景的高精度數據集,Dragon Lake Parking (DLP) 數據集可為該場景下大規模目標識別和追蹤、空閑車位檢測、車輛和行人的行為和軌跡預測、模仿學習等研究提供數據和 API 支持

- 通過使用 CNN 和 Transformer 架構,ParkPredict + 模型在泊車場景下的行為和軌跡預測中展現除了良好的能力

- Dragon Lake Parking (DLP) 數據集已開放試用和申請,可通過訪問數據集主頁 https://sites.google.com/berkeley.edu/dlp-dataset 了解詳細信息(如無法訪問,可嘗試備用頁面 ??https://cutt.ly/dlp-notion?? )