無痛解決跨相機部署問題!伯克利UniDrive:首個跨相機通用3D視覺感知算法模型

寫在前面&筆者的個人理解

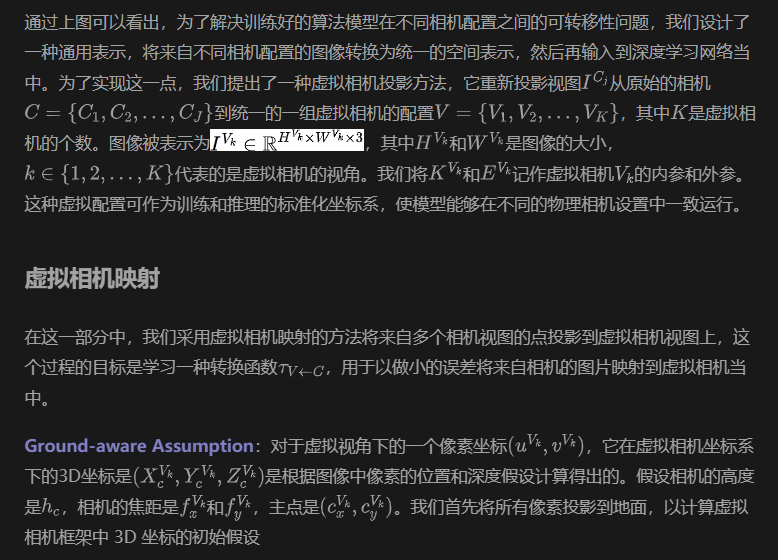

以視覺為中心的自動駕駛系統(tǒng)由于能夠使用相機等部署經(jīng)濟型傳感器實現(xiàn)感知算法模型性能的提升而受到了來自工業(yè)界和學(xué)術(shù)界的廣泛關(guān)注。以視覺輸入的感知算法通過由2D圖像信息來重建3D空間信息實現(xiàn)了3D目標(biāo)的檢測任務(wù)。這種由2D空間到3D空間的信息轉(zhuǎn)換對于使自動駕駛車輛能夠了解周圍環(huán)境、檢測目標(biāo)并安全導(dǎo)航至關(guān)重要。先前的來自學(xué)術(shù)界和工業(yè)界的相關(guān)研究通過利用 BEV空間表示來處理 2D到3D空間的信息轉(zhuǎn)換,實現(xiàn)了卓越的3D目標(biāo)感知能力。最近,許多基于視覺的3D柵格占用預(yù)測算法進一步提高了感知模塊對于動態(tài)和混亂駕駛場景的理解,突破了研究領(lǐng)域的界限。因此,基于視覺的感知系統(tǒng)已成為可擴展自動駕駛的主要解決方案之一。

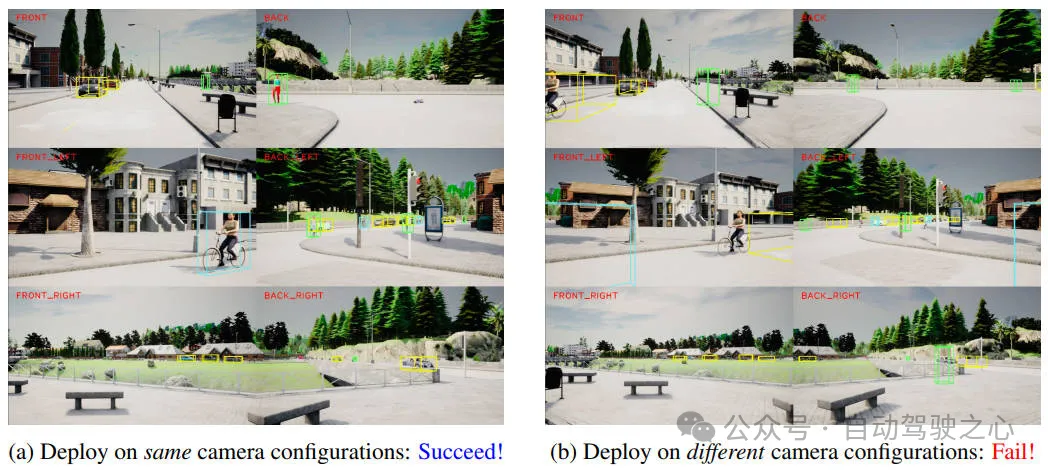

盡管基于視覺的自動駕駛技術(shù)取得了令人興奮的進展和非常不錯的成績,但目前仍然存在一個關(guān)鍵的限制:這些基于視覺的感知算法模型對于相機的配置變化比較敏感,體現(xiàn)在相機的內(nèi)參和外參兩個方面。自動駕駛模型通常依賴于經(jīng)過良好校準(zhǔn)的相機傳感器設(shè)置,即使不同車輛或平臺的攝像頭參數(shù)出現(xiàn)了輕微偏差,也會顯著降低模型的感知性能,如下圖所示。

在相同和不同配置上部署感知模型的性能結(jié)果比較

在相同和不同配置上部署感知模型的性能結(jié)果比較

由于算法模型缺乏對傳感器變化的魯棒性,因此在沒有大量重新訓(xùn)練或手動調(diào)整的情況下,已經(jīng)訓(xùn)練好的算法模型很難在不同車輛平臺之間實現(xiàn)很好的泛化和魯棒性。因此,當(dāng)遇到相機配置發(fā)生變化時,就需要為每輛車重新訓(xùn)練一個單獨的新感知算法模型,這就會消耗大量的計算資源。因此,實現(xiàn)跨攝像頭配置的泛化對于以視覺為中心的自動駕駛的實際部署至關(guān)重要。

考慮到上述提到的相關(guān)問題,我們提出了UniDrive算法模型,用于解決在多攝像頭配置下提高感知算法模型的泛化性。此外,我們提出的算法模型可作為現(xiàn)有 3D 目標(biāo)感知方法的即插即用模塊,用于提高感知算法模型對其相機參數(shù)變化的魯棒性。我們在CARLA框架中以不同的相機配置下來訓(xùn)練和驗證我們提出的算法模型,相關(guān)的實驗結(jié)果證明我們提出的算法模型在不同的相機配置下,可以顯著降低算法模型感知性能的下降,同時保持跨不同傳感器設(shè)置的適應(yīng)性。

文章鏈接:https://arxiv.org/pdf/2410.13864

網(wǎng)絡(luò)模型架構(gòu)&技術(shù)細(xì)節(jié)

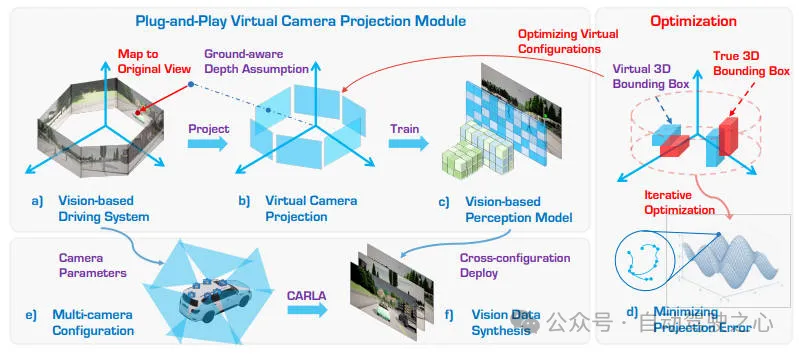

在詳細(xì)介紹本文提出的算法模型細(xì)節(jié)之前,下圖展示了我們提出的UniDrive算法模型的整體網(wǎng)絡(luò)結(jié)構(gòu),如下所示。

提出的UniDrive算法模型的整體網(wǎng)絡(luò)結(jié)構(gòu)

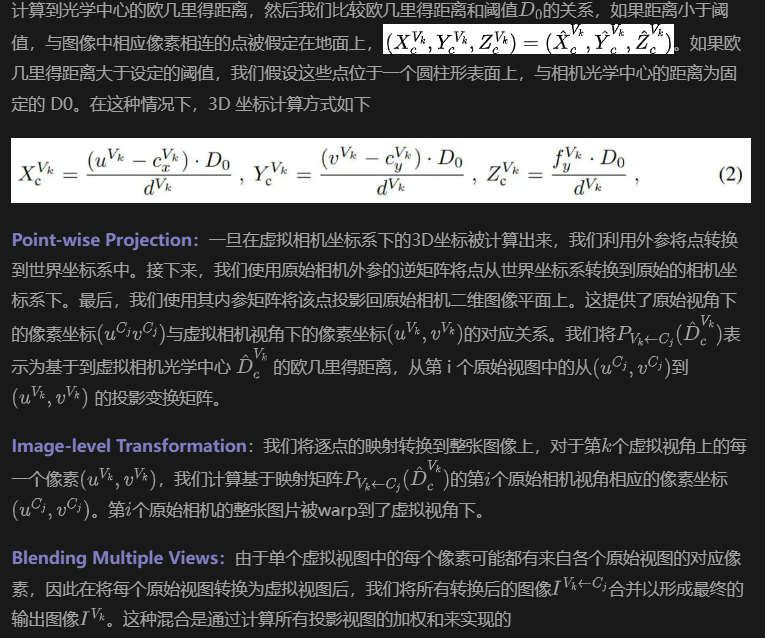

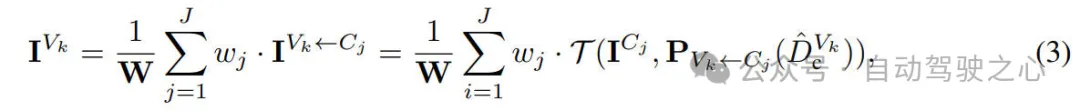

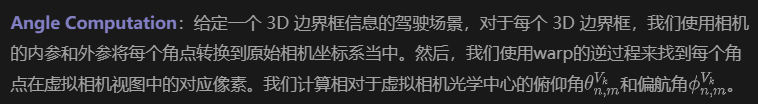

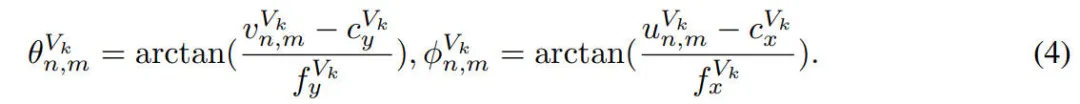

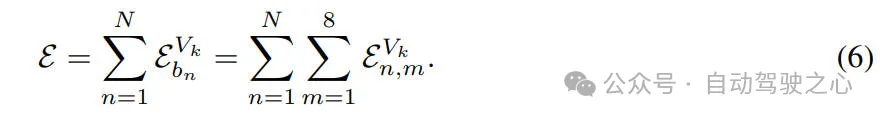

虛擬相機映射誤差

為了評估虛擬相機投影方法在 3D 物體檢測任務(wù)中的準(zhǔn)確性,我們提出了一種基于虛擬和原始相機視圖之間的角度差異的加權(quán)投影誤差度量。該方法考慮了角度偏差和與相機光學(xué)中心的距離,以提供更穩(wěn)健的誤差評估。

Angle Error Calculation:對于每個角點,我們計算原始相機投影和虛擬相機中對應(yīng)點之間的角度誤差。我們使用每個角點與原始相機光學(xué)中心的距離作為權(quán)重。3D 邊界框的總體誤差是通過將其八個角點的加權(quán)誤差相加得出的。我們將所有 3D 邊界框的投影誤差相加,以計算總投影誤差。

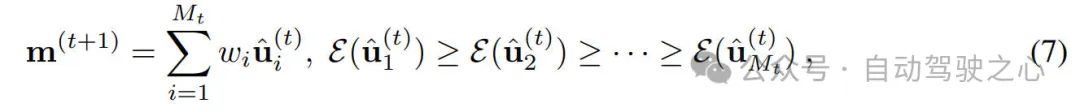

優(yōu)化虛擬相機配置

給定一組多相機系統(tǒng),我們的目標(biāo)是設(shè)計一個統(tǒng)一的虛擬相機配置,以最小化所有原始相機配置的重新投影誤差。為了實現(xiàn)這一點,我們采用基于協(xié)方差矩陣自適應(yīng)進化策略的啟發(fā)式優(yōu)化來找到一組優(yōu)化的虛擬相機配置。

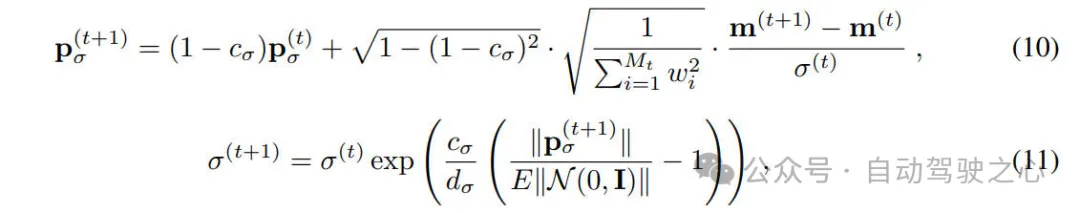

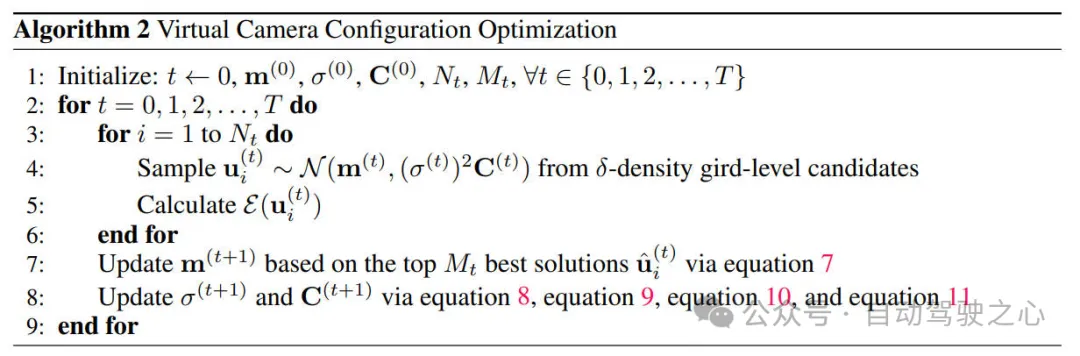

Optimization Method:我們的優(yōu)化策略首先定義一個多元正態(tài)分布,整個的優(yōu)化過程可以用數(shù)學(xué)形式表示如下。

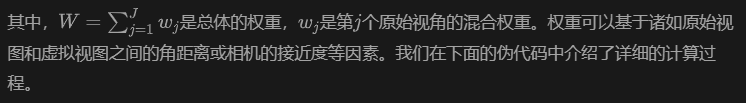

我們在下面的算法中給出了詳細(xì)的優(yōu)化過程

實驗結(jié)果&評價指標(biāo)

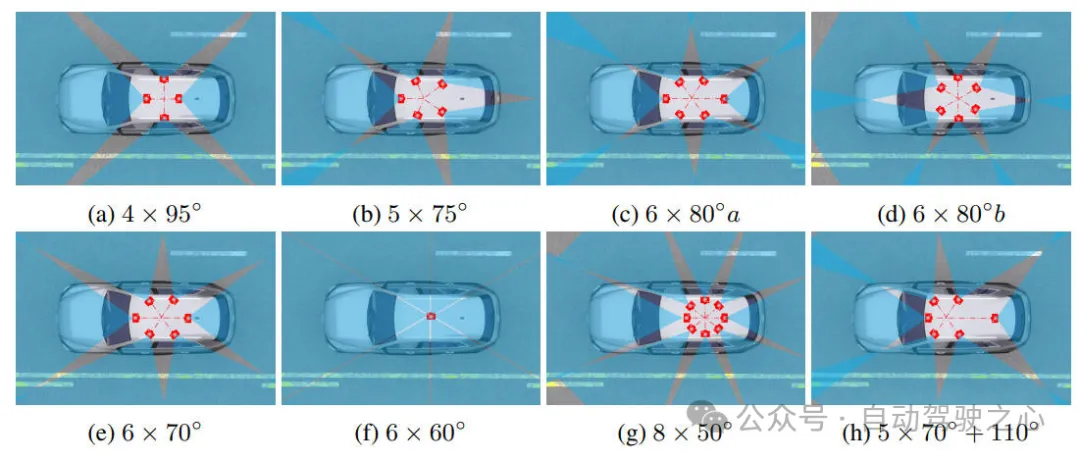

在本次實驗中,我們采用了自動駕駛汽車中幾種常用的攝像頭配置情況,這些配置具有不同的攝像頭數(shù)量、位置和視野。這些攝像頭的配置情況可以用下圖進行說明,我們還包括 nuScenes 數(shù)據(jù)集的原始配置,其中包含五個 70° 攝像頭和一個 110° 攝像頭。

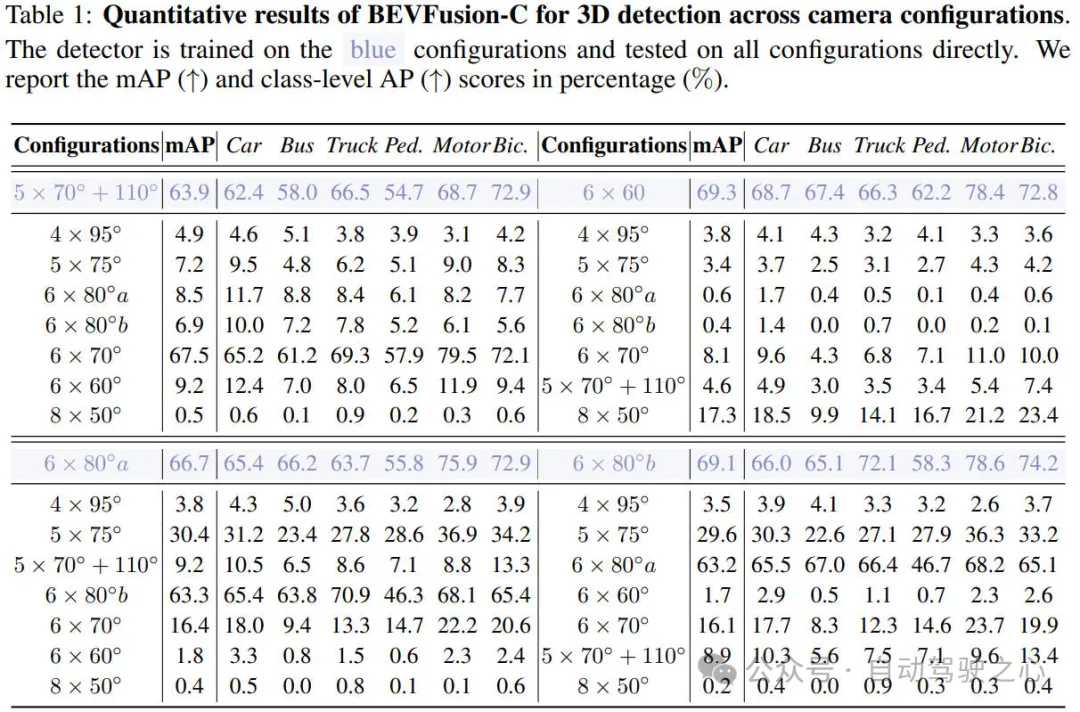

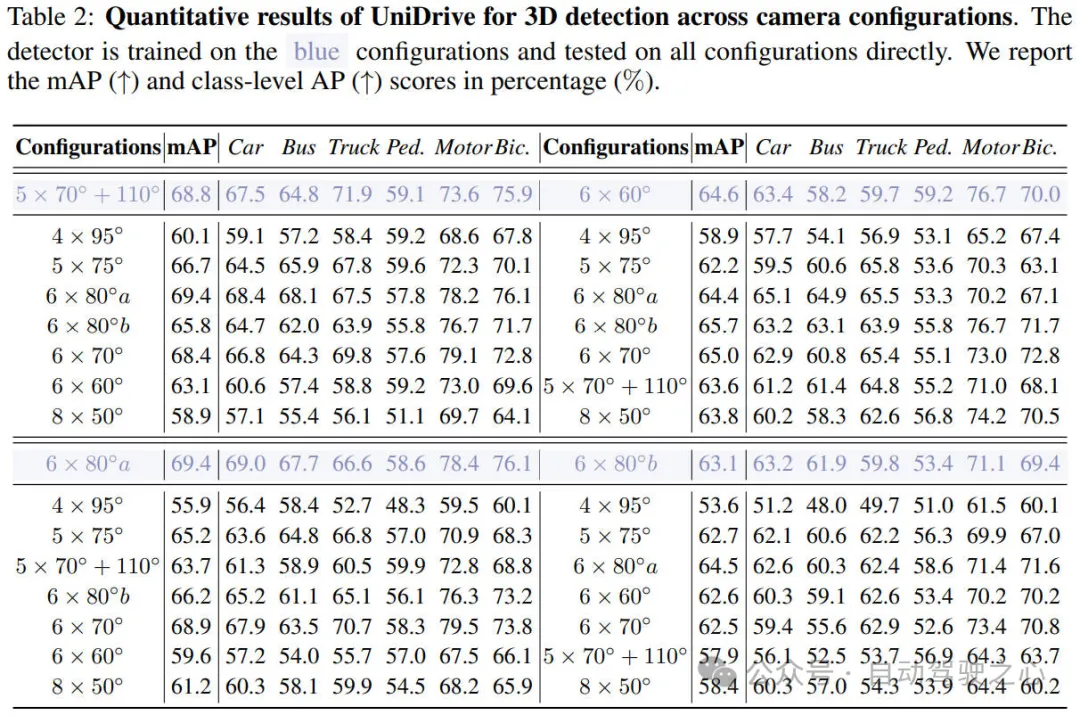

我們進行了相關(guān)的實驗來驗證我們提出的UniDrive算法模型的有效性,相關(guān)的實驗結(jié)果如下表所示。

通過上表的實驗結(jié)果可以看出,我們展示了BEVFusion和 UniDrive 的 3D 目標(biāo)檢測結(jié)果。這些模型在一種相機配置上進行訓(xùn)練,并在其他不同的相機配置上進行測試。表 1相關(guān)的實驗結(jié)果表明,BEVFusion算法模型在跨相機配置任務(wù)上部署時的性能會大幅下降,在其他配置上幾乎無法使用。如表 2 的實驗結(jié)果所示,我們使用即插即用的UniDrive 框架訓(xùn)練模型。與 BEVFusion相比,檢測性能得到顯著提高。我們的方法在跨相機配置任務(wù)上僅經(jīng)歷很小的性能下降。

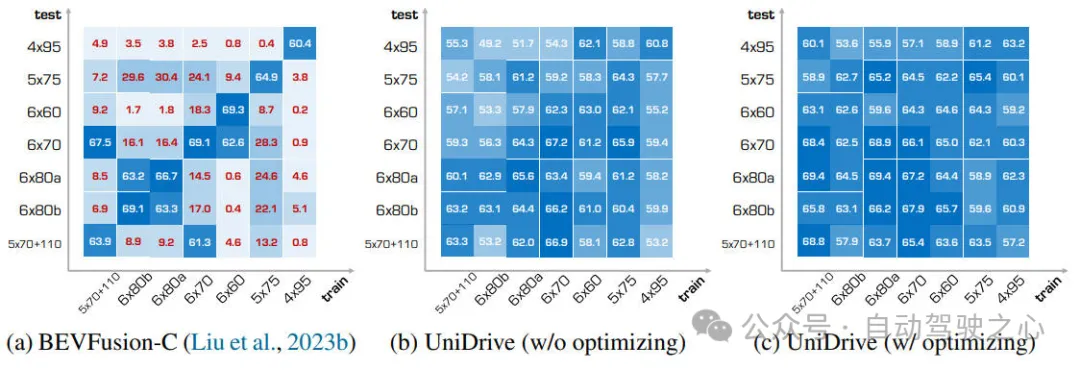

此外,為了更加直觀的展示我們算法模型的有效性,我們在下圖中展示了更多模型檢測結(jié)果,全面展示了我們框架的有效性。

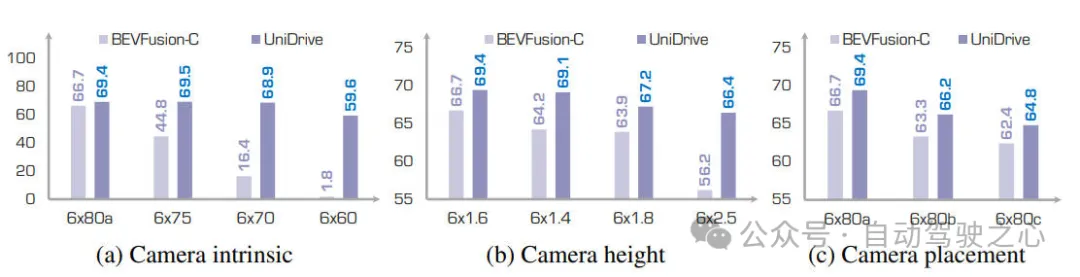

此外,為了證明優(yōu)化在 UniDrive 中的重要性,我們在上圖中比較了優(yōu)化的虛擬攝像頭配置和直觀配置之間的感知性能。直觀的虛擬攝像頭配置將所有攝像頭置于車頂?shù)闹行摹H鐖D所示,雖然與 BEVFusion相比,直觀設(shè)置(未優(yōu)化)也顯著改善了跨攝像頭配置感知性能,但它對某些配置表現(xiàn)出明顯的偏好,而對其他配置的表現(xiàn)不佳。相比之下,優(yōu)化的虛擬攝像頭參數(shù)表現(xiàn)出更大的適應(yīng)性,在各種配置中表現(xiàn)出相對一致的性能。這對于自動駕駛中多個多攝像頭感知系統(tǒng)的并發(fā)開發(fā)至關(guān)重要。

我們也驗證了攝像頭高度對于模型性能的影響。攝像頭垂直位置的變化會顯著影響感知性能,因為不同高度的攝像頭會捕捉具有不同幾何特征的圖像。我們專門針對 1.6 米、1.4 米、1.8 米和 2.5 米的不同攝像頭高度進行了實驗。我們在1.6 米上訓(xùn)練模型,并在其他配置上進行測試。如下圖所示。面對不同的攝像頭高度,BEVFusion的性能大幅下降超過 10%。相比之下,UniDrive 在不同攝像頭高度上的性能顯著提高,表現(xiàn)出增強的穩(wěn)健性,性能僅下降 3.0%。

結(jié)論

在本文中,我們提出了UniDrive算法框架,用于增強以視覺為中心的自動駕駛模型在不同攝像頭配置中的泛化能力。在CARLA 中的大量實驗驗證了我們提出的UniDrive的有效性以及強大的泛化能力。此外,我們的框架不僅可以作為現(xiàn)有 3D 感知模型的即插即用模塊,而且為更通用、更可擴展的自動駕駛解決方案提供了可能。