Transformer模仿大腦,在預測大腦成像上超越42個模型,還能夠模擬感官與大腦之間的傳輸

現在很多AI應用模型,都不得不提到一個模型結構:

Transformer。

它拋棄了傳統的CNN和RNN,完全由Attention機制組成。

Transformer不僅賦予了各種AI應用模型寫文作詩的功能,而且在多模態方面也大放異彩。

尤其是ViT(Vision Transformer)出來之后,CV和NLP之間的模型壁壘被打破,僅使用Transformer一個模型就能夠處理多模態的任務。

(誰看完不得感嘆一句它的強大啊)

雖然一開始Transformer是為語言任務而設計的,但它在模仿大腦方面也有著很大的潛力。

這不,有位科學作家寫了篇博客,就是關于Transformer是如何進行大腦建模的。

來康康他是怎么說的?

Transformer:做大腦做的事

首先,還得梳理一下它的演變過程。

Transformer機制在5年前首次出現,它能夠有這么強大的表現,很大程度上歸功于其Self-attention機制。

至于Transformer是如何模仿大腦的,繼續往下看。

在2020年,奧地利計算機科學家Sepp Hochreiter的研究團隊利用Transformer重組了Hopfield神經網絡 (一種記憶檢索模型,HNN)。

其實,Hopfield神經網絡在40年前就已經被提出,而研究團隊之所以時隔數十年選擇重組這個模型原因如下:

其一,這個網絡遵循一個普遍的規律:同時活躍的神經元之間彼此會建立很強的聯系。

其二,Hopfield神經網絡在檢索記憶的過程中與Transformer執行Self-attention機制時有一定的相似之處。

所以研究團隊便將HNN進行重組,讓各個神經元之間建立更好的聯系,以便存儲和檢索更多的記憶。

重組的過程,簡單來說,就是把Transformer的注意力機制融合進HNN,使原來不連續的HNN變為可連續態。

△圖源:維基百科

重組之后的Hopfield網絡可以作為層集成到深度學習架構中,以允許存儲和訪問原始輸入數據、中間結果等。

因此,Hopfield本人和麻省理工學院沃森人工智能實驗室的Dmitry Krotov都稱:

基于Transformer的Hopfield神經網絡在生物學上是合理的。

雖說這在一定程度上與大腦的工作原理相像,但在某些方面還不夠準確。

因此,計算神經科學家Whittington和Behrens調整了Hochreiter的方法,對重組后的Hopfield網絡做出了一些修正,進一步提高了該模型在神經科學任務中(復制大腦中的神經放電模式)的表現。

△Tim Behrens (左) James Whittington(右) 圖源:quantamagazine

簡單來說,就是在編碼-解碼時,模型不再把記憶編碼為線性序列,而是將其編碼為高維空間中的坐標。

具體而言,就是在模型中引入了TEM(Tolman-Eichenbaum Machine)。

TEM是為了模仿海馬體的空間導航作用而構建的一個關聯記憶系統。

它能夠概括空間和非空間的結構知識,預測在空間和關聯記憶任務中觀察到的神經元表現,并解釋在海馬和內嗅皮層中的重新映射現象。

將擁有這么多功能的TEM與Transformer合并,組成TEM-transformer(TEM-t)。

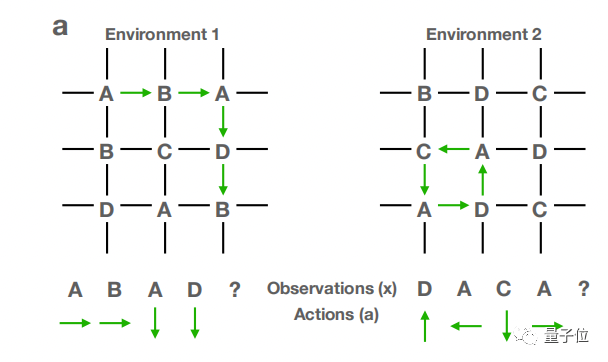

然后,再讓TEM-t模型在多個不同的空間環境中進行訓練,環境的結構如下圖所示。

在TEM-t中,它依舊擁有Transformer的Self-attention機制。這樣一來,模型的學習成果便能遷移到新環境中,用于預測新的空間結構。

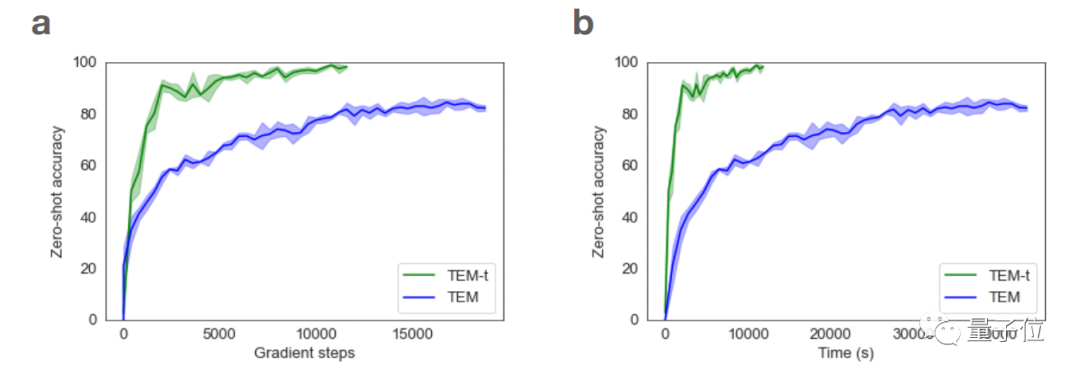

研究也顯示,相較于TEM,TEM-t在進行神經科學任務時效率更高,而且它也能在更少學習樣本的情況下處理更多的問題。

Transformer在模仿大腦模式的道路上越來越深入,其實換句話說,Transformer模式的發展也在不斷促進我們理解大腦功能的運作原理。

不僅如此,在某些方面,Transformer還能提高我們對大腦其他功能的理解。

Transformer幫助我們理解大腦

比如說,在去年,計算神經科學家Martin Schrimpf分析了43種不同的神經網絡模型,以觀察它們對人類神經活動測量結果:功能磁共振成像(fMRI)和皮層腦電圖(EEG)報告的預測能力。

其中,Transformer模型幾乎可以預測成像中發現的所有變化。

倒推一下,或許我們也可以從Transformer模型中預見大腦對應功能的運作。

除此之外,最近計算機科學家Yujin Tang和 David Ha設計了一個模型,可以通過Transformer模型以隨機、無序的方式有意識地發送大量數據,模擬人體如何向大腦傳輸感官觀察結果。

這個Transformer就像人類的大腦一樣,能夠成功地處理無序的信息流。

雖然Transformer模型在不斷進步,但也只是朝著精確大腦模型邁出的一小步,到達終點還需要更深入的研究。

如果想詳細了解Transformer是如何模仿人腦的,可以戳下方鏈接~

參考鏈接:

[1]https://www.quantamagazine.org/how-ai-transformers-mimic-parts-of-the-brain-20220912/

[2]https://www.pnas.org/doi/10.1073/pnas.2105646118

[3]https://openreview.net/forum?id=B8DVo9B1YE0?