英偉達超快StyleGAN回歸,比Stable Diffusion快30多倍,網(wǎng)友:GAN好像只剩下快了

本文經(jīng)AI新媒體量子位(公眾號ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請聯(lián)系出處。

擴散模型的圖像生成統(tǒng)治地位,終于要被GAN奪回了?

就在大伙兒喜迎新年之際,英偉達一群科學家悄悄給StyleGAN系列做了個升級,變出個PLUS版的StyleGAN-T,一下子在網(wǎng)上火了。

無論是在星云爆炸中生成一只柯基:

還是基于虛幻引擎風格渲染的森林:

都只需要接近0.1秒就能生成!

同等算力下,擴散模型中的Stable Diffusion生成一張圖片需要3秒鐘,Imagen甚至需要接近10秒。

不少網(wǎng)友的第一反應是:

GAN,一個我太久沒聽到的名字了。

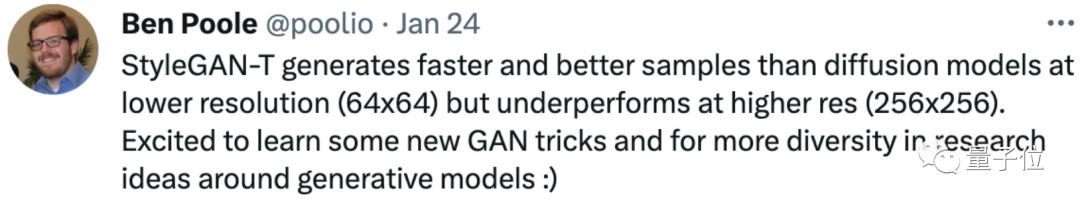

很快谷歌大腦研究科學家、DreamFusion第一作者Ben Poole趕來圍觀,并將StyleGAN-T與擴散模型做了個對比:

在低質(zhì)量圖像(64×64)生成方面,StyleGAN-T要比擴散模型做得更好。

但他同時也表示,在256×256圖像生成上,還是擴散模型的天下。

所以,新版StyleGAN生成質(zhì)量究竟如何,它又究竟是在哪些領(lǐng)域重新具備競爭力的?

StyleGAN-T長啥樣?

相比擴散模型和自回歸模型多次迭代生成樣本,GAN最大的優(yōu)勢是速度。

因此,StyleGAN-T這次也將重心放在了大規(guī)模文本圖像合成上,即如何在短時間內(nèi)由文本生成大量圖像。

StyleGAN-T基于StyleGAN-XL改進而來。

StyleGAN-XL的參數(shù)量是StyleGAN3的3倍,基于ImageNet訓練,能生成1024×1024高分辨率的圖像,并借鑒了StyleGAN2和StyleGAN3的部分架構(gòu)設(shè)計。

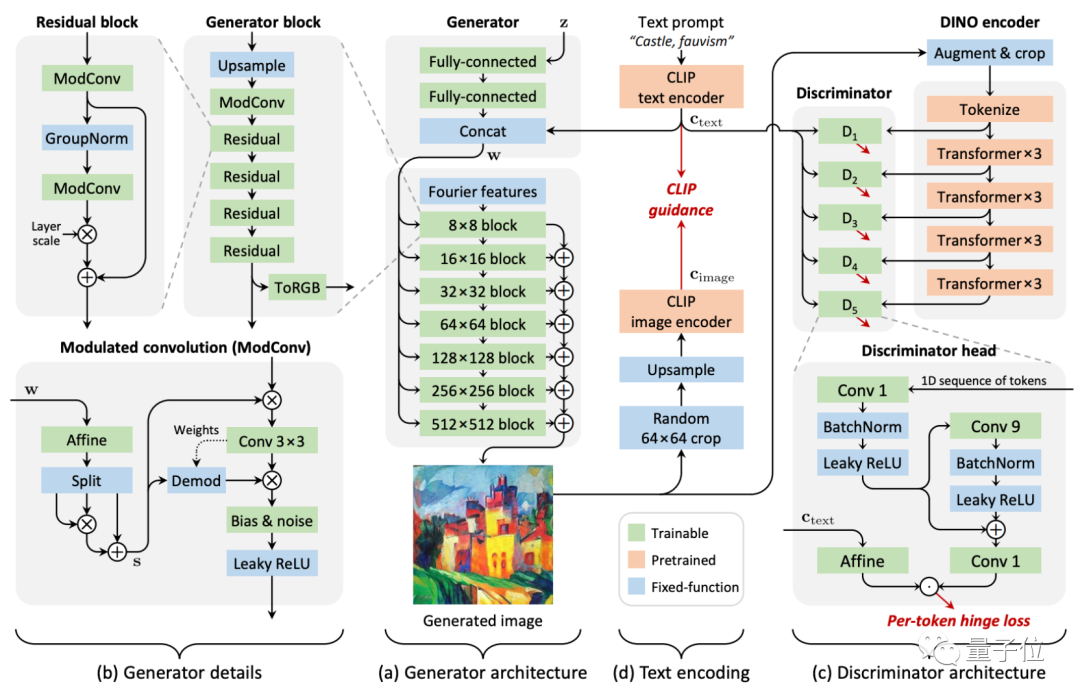

它的整體架構(gòu)如下:

具體到細節(jié)上,作者們對生成器、判別器和文本對齊權(quán)衡機制進行了重新設(shè)計,用FID對樣本質(zhì)量進行量化評估,并采用CLIP來對文本進行對齊。

在生成器上,作者們放棄了StyleGAN3中能實現(xiàn)平移同變性(equivariance)的架構(gòu),轉(zhuǎn)而采用了StyleGAN2的部分設(shè)計,包括輸入空間噪聲以及跳層連接等,以提升細節(jié)隨機變化的多樣性。

在判別器上,作者們也重新進行了設(shè)計,采用自監(jiān)督學習對ViT-S進行訓練。

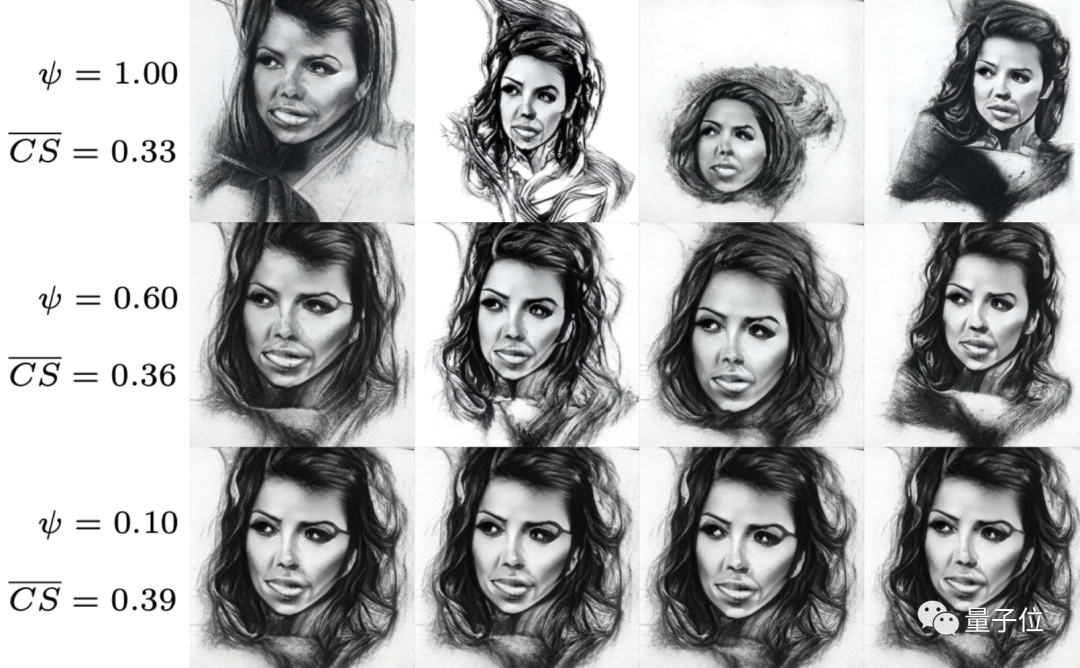

隨后,作者采用了一種特殊的截斷(truncation)方法來控制圖像生成的效果,同時權(quán)衡生成內(nèi)容的多樣性。

只需要控制參數(shù)ψ,就能在確保CLIP分數(shù)(用于評估圖像生成效果)變動不大的情況下,改善生成圖像的風格多樣性。

隨后,作者們用64個英偉達A100訓練了4周,最終得到了這版StyleGAN-T。

那么它的生成效果如何呢?

超快生成低分辨率圖像

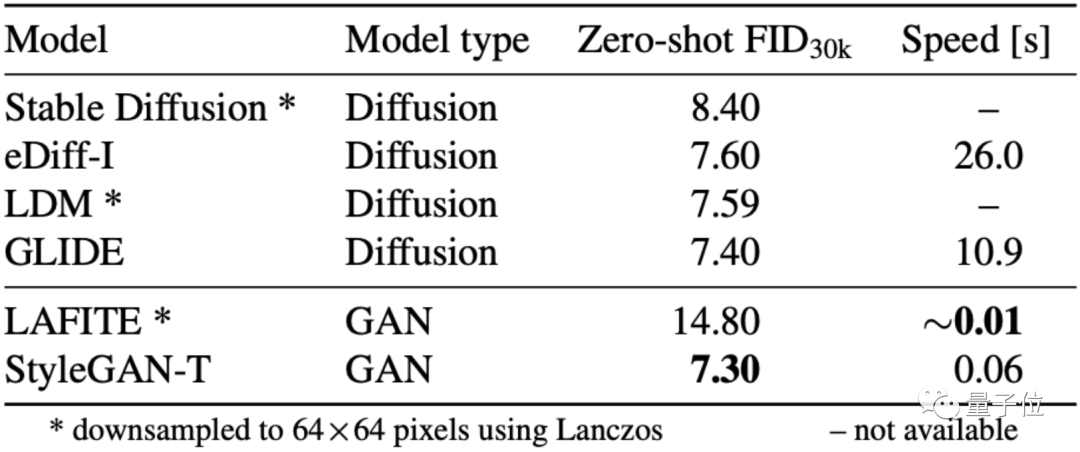

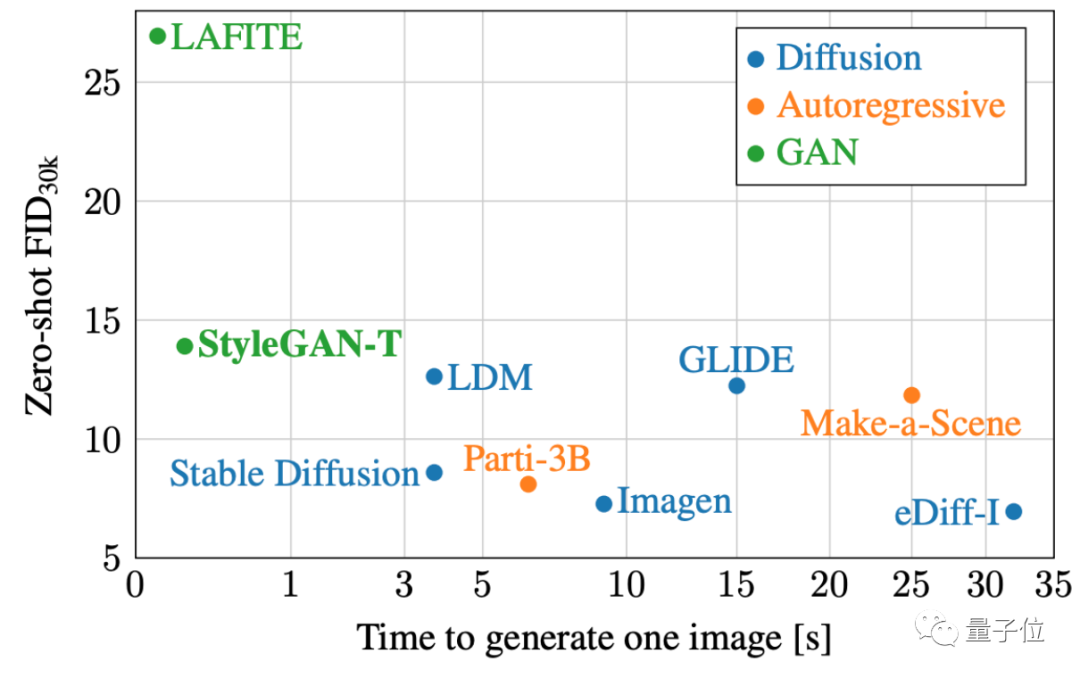

作者們對當前最好的幾種GAN、擴散模型和自回歸模型進行了評估。

在微軟的MS COCO數(shù)據(jù)集上,StyleGAN-T實現(xiàn)了64×64分辨率下最高的FID。

(其中,F(xiàn)ID是計算真實圖像和生成圖像特征向量距離的評估用值,數(shù)值越低,表示生成的效果越接近真實圖像)

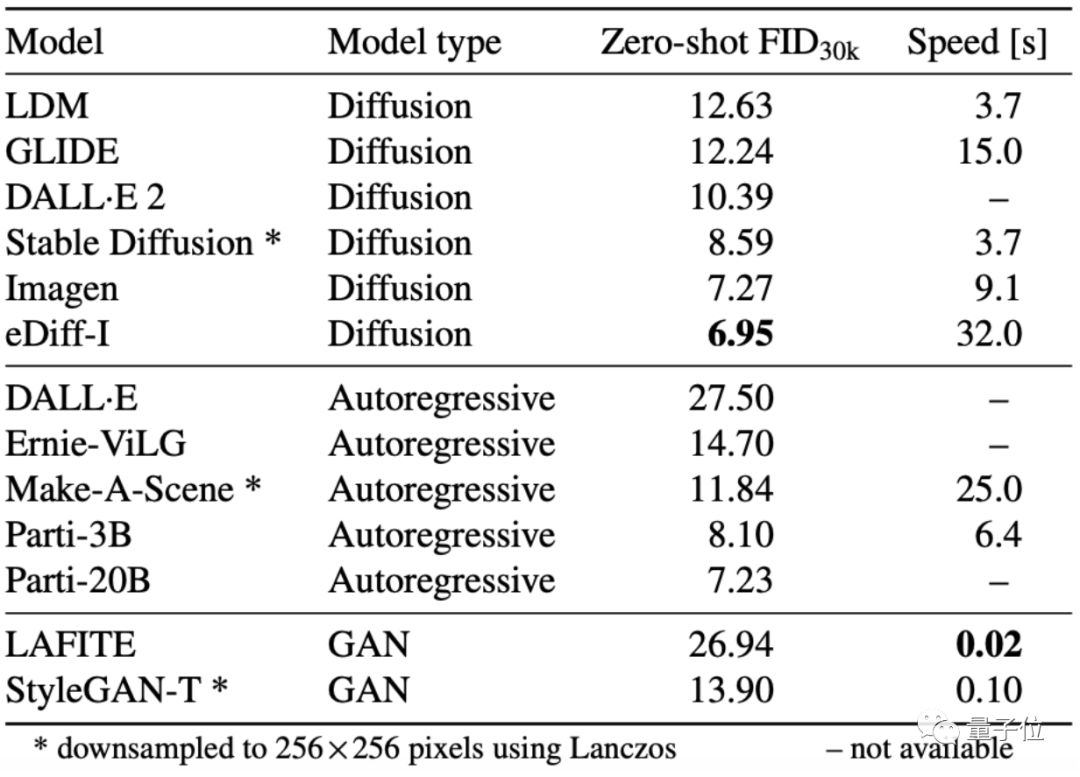

但在更高的256×256分辨率生成上,StyleGAN-T還是沒有比過擴散模型,只是在生成效果上比同樣用GAN的LAFITE要好上不少:

如果進一步將生成時間和FID分別作為縱軸和橫軸,放到同一張圖上來對比,還能更直觀地對比生成質(zhì)量和速度。

可見StyleGAN-T能保持在10FPS的速度下生成256×256分辨率圖像,同時FID值逼近LDM和GLIDE等擴散模型:

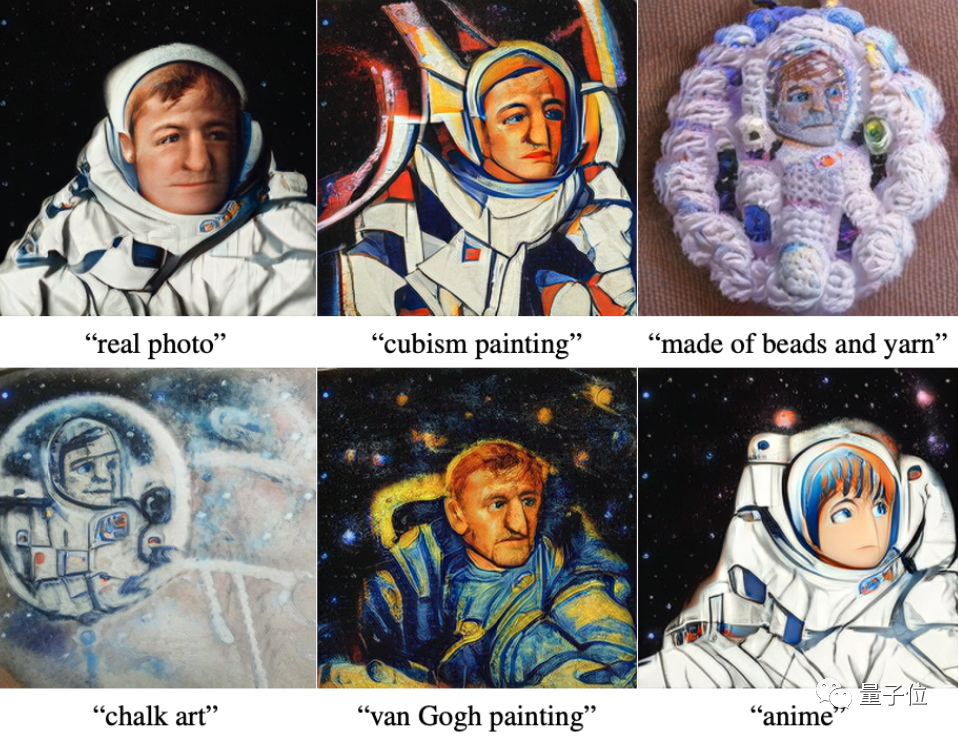

而在文本生成圖像功能上,作者們也從文本特征、風格控制等方面對模型進行了測試。

在增加或改變特定的形容詞后,生成的圖像確實符合描述:

即便是快速生成的圖像,也能迅速控制風格,如“梵高風格的畫”or“動畫”等:

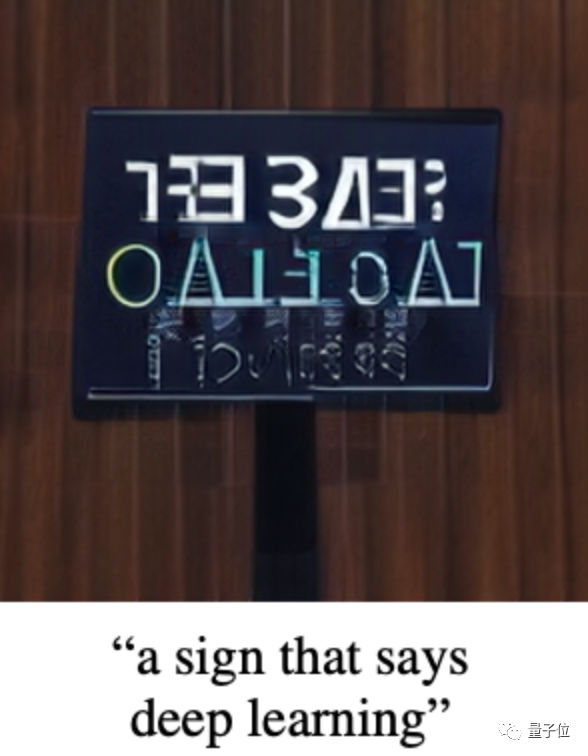

當然,偶爾也有失敗案例,最典型的就是生成帶字母要求的圖像時,顯示不出正常字母來:

作者們正在努力整理代碼,表示不久之后就會開源。

作者介紹

作者們均來自圖賓根大學和英偉達。

一作Axel Sauer,圖賓根大學博士生,此前在卡爾斯魯厄理工學院(KIT)獲得本碩學位。目前感興趣的研究方向是深度生成模型、神經(jīng)網(wǎng)絡(luò)架構(gòu)和實證研究。

二作Tero Karras,英偉達杰出研究科學家,對英偉達RTX技術(shù)有重要貢獻,也是StyleGAN系列的主要作者,主要研究方向是計算機圖形學和實時渲染。

不過在這波GAN掀起的“文藝復興”浪潮下,也出現(xiàn)了“StyleGAN時代迎來終結(jié)”的聲音。

有網(wǎng)友感慨:

在這之前,最新StyleGAN生成的圖像總能讓我們大吃一驚,然而現(xiàn)在它給我們的印象只剩下“快”了。

你認為GAN還能撼動擴散模型的統(tǒng)治地位嗎?

論文地址:https://arxiv.org/abs/2301.09515

項目地址:https://github.com/autonomousvision/stylegan-t