這段音頻火爆外網!文字、圖片一鍵生成逼真音效,音頻界AIGC來了

近期 AIGC 如同上了熱搜一般,火熱程度居高不下,當然除了名頭格外響亮,突破也是絕對斐然:輸入自然語言就可自動生成圖像、視頻甚至是 3D 模型,你說意不意外?

但在音頻音效的領域,AIGC 的福利似乎還差了一些。主要由于高自由度音頻生成需要依靠大量文本 - 音頻對數據,同時長時波形建模還有諸多困難。為了解決上述困難,浙江大學與北京大學聯合火山語音,共同提出了一款創新的、文本到音頻的生成系統,即 Make-An-Audio。其可以將自然語言描述作為輸入,而且是任意模態(例如文本、音頻、圖像、視頻等)均可,同時輸出符合描述的音頻音效,廣大網友很難不為其可控性以及泛化性點贊。

- 論文鏈接:https://arxiv.org/abs/2301.12661

- 項目鏈接:https://text-to-audio.github.io

短短兩天,Demo 視頻在 Twitter 上獲得了 45K 的播放量。

2023 年除夕后,以 Make-An-Audio、 MusicLM 等大量音頻合成文章涌現,48 小時內已經有 4 篇突破性的進展。

網友評論 1

廣大網友們紛紛表示,AIGC 音效合成將會改變電影、短視頻制作的未來。

網友評論 2

網友評論 3

更有網友發出這樣的感嘆:「audio is all you need……」

網友評論 4

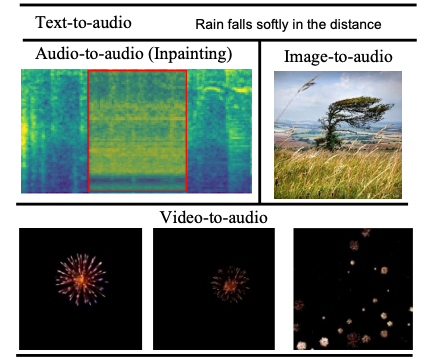

聽覺效果展示

話不多說直接看效果,根據文本生成音效原來也可以如此便捷順暢。

文本 1:a speedboat running as wind blows into a microphone

轉化音頻1音頻:00:0000:09?

文本 2:fireworks pop and explode

轉化音頻2音頻:00:0000:09?

是不是也一度因破損音頻修復而大傷腦筋?Make-An-Audio 模型一出,這事兒就變得簡單多了。

修復前

修復前音頻

修復前音頻音頻:00:0000:09?

修復后

修復后音頻

修復后音頻音頻:00:0000:09?

通過理解圖片生成音效,也不是不可以。

圖片 1

轉化音頻

圖片轉化音頻音頻:00:0000:09?

圖片 2

轉化音頻

圖片轉化音頻2音頻:00:0000:09?

根據視頻內容生成對應音效,這款模型也可以輕松做到。

視頻 1

轉化音頻

視頻1音頻:00:0000:09?

視頻 2

轉化音頻

視頻2音頻:00:0000:09?

模型內在技術原理

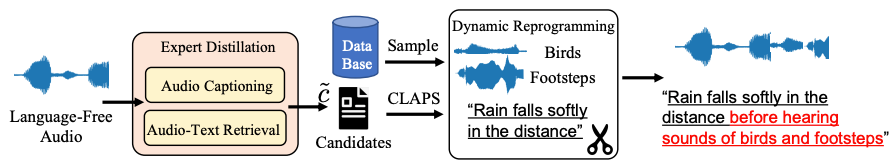

深度解析「網紅」模型的神奇內在,還要回到音頻 - 自然語言對數據稀少的客觀問題上,對此浙大北大聯合火山語音團隊協同兩大高校共同提出了Distill-then-Reprogram 文本增強策略,即使用教師模型獲得音頻的自然語言描述,再通過隨機重組獲得具有動態性的訓練樣本。

具體來說,在 Distill 環節中,使用音頻轉文本與音頻 - 文本檢索模型,找到語言缺失 (Language-Free) 音頻的自然語言描述候選 (Candidate),通過計算候選文本與音頻的匹配相似度,在閾值下取得最佳結果作為音頻的描述。該方法具有強泛化性,且真實自然語言避免了測試階段的域外文本。「在 Reprogram 環節中,團隊從額外的事件數據集中隨機采樣,并與當前訓練樣本相結合,得到全新的概念組合與描述,以擴增模型對不同事件組合的魯棒性。」 研究團隊表示。

Distill-then-Reprogram 文本增強策略框架圖

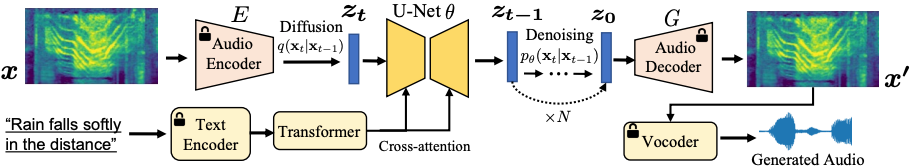

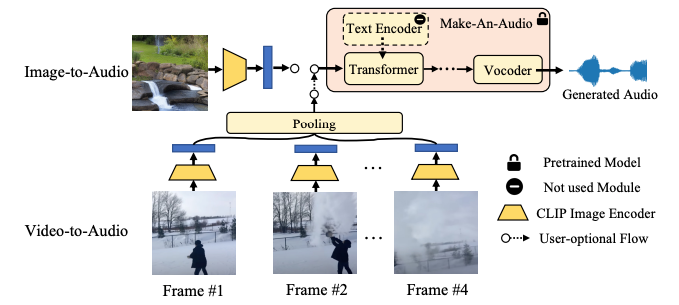

如上圖所示,自監督學習已經成功將圖片遷移到音頻頻譜,利用了頻譜自編碼器以解決長音頻序列問題,并基于 Latent Diffusion 生成模型完成對自監督表征的預測,避免了直接預測長時波形。

Make-An-Audio 模型系統框架圖

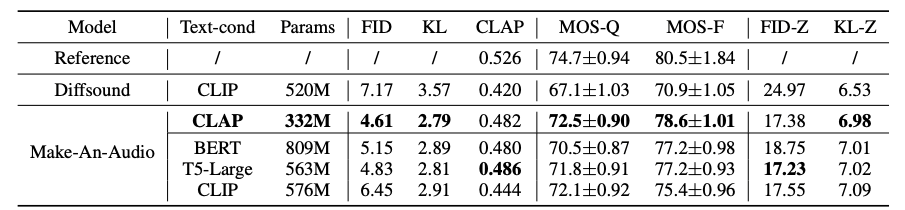

此外在研究中團隊還探索了強大的文本條件策略,包括對比式 Contrastive Language-Audio Pretraining (CLAP) 以及語言模型 (LLM) T5, BERT 等,驗證了 CLAP 文本表征的有效與計算友好性。同時還首次使用 CLAP Score 來評估生成的音頻,可以用于衡量文本和生成場景之間的一致性;使用主、客觀相結合的評估方式,在 benchmark 數據集測試中驗證了模型的有效性,展示了模型出色的零樣本學習 (Zero-Shot) 泛化性等。

Make-An-Audio 與基線模型主客觀評測實驗結果

神奇模型的應用前景知多少?

總體來看,Make-An-Audio 模型實現了高質量、高可控性的音頻合成,并提出了「No Modality Left Behind」,對文本條件音頻模型進行微調 (finetune),即能解鎖對任意模態輸入的音頻合成 (audio/image/video)。

Make-An-Audio 首次實現高可控 X - 音頻的 AIGC 合成,X 可以是文本 / 音頻 / 圖像 / 視頻

在視覺指導的音頻合成上,Make-An-Audio 以 CLIP 文本編碼器為條件,利用其圖像 - 文本聯合空間,能夠直接以圖像編碼為條件合成音頻。

Make-An-Audio 視覺 - 音頻合成框架圖

可以預見的是,音頻合成 AIGC 將會在未來電影配音、短視頻創作等領域發揮重要作用,而借助 Make-An-Audio 等模型,或許在未來人人都有可能成為專業的音效師,都可以憑借文字、視頻、圖像在任意時間、任意地點,合成出栩栩如生的音頻、音效。但現階段 Make-An-Audio 也并不是完美無缺的,可能由于豐富的數據來源以及不可避免的樣本質量問題,訓練過程中難免會產生副作用,例如生成不符合文字內容的音頻,Make-An-Audio 在技術上被定位是 “輔助藝術家生成”,可以肯定的一點,AIGC 領域的進展確實令人驚喜。

火山語音,長期以來面向字節跳動各大業務線提供全球優勢的 AI 語音技術能力以及全棧語音產品解決方案,包括音頻理解、音頻合成、虛擬數字人、對話交互、音樂檢索、智能硬件等。自 2017 年成立以來,團隊專注研發行業領先的 AI 智能語音技術,不斷探索 AI 與業務場景的高效結合,以實現更大的用戶價值。目前其語音識別和語音合成已經覆蓋了多種語言和方言,多篇技術論文入選各類 AI 頂級會議,為抖音、剪映、飛書、番茄小說、Pico 等業務提供了領先的語音能力,并適用于短視頻、直播、視頻創作、辦公以及穿戴設備等多樣化場景,通過火山引擎開放給外部企業。