ChatGPT和生成式AI對(duì)科學(xué)意味著什么?

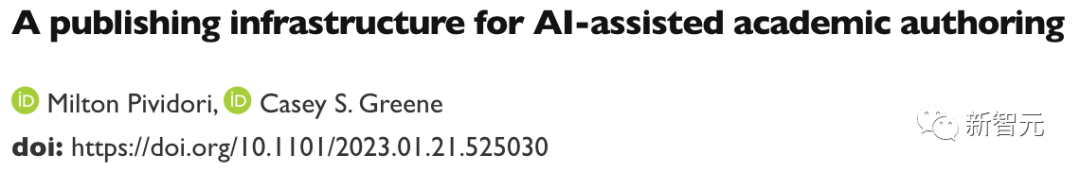

12 月,計(jì)算生物學(xué)家 Casey Greene 和 Milton Pividori 開始了一項(xiàng)不同尋常的實(shí)驗(yàn):他們請(qǐng)一名非科學(xué)家的助手幫助他們改進(jìn)三篇研究論文。

他們勤奮的助手建議在幾秒鐘內(nèi)修改文檔的各個(gè)部分,每份手稿大約需要五分鐘的時(shí)間。在一份生物學(xué)手稿中,他們的助手甚至在引用方程式時(shí)發(fā)現(xiàn)了一個(gè)錯(cuò)誤。

審查并不總是順利進(jìn)行,但最終的手稿更容易閱讀——而且費(fèi)用適中,每份文件不到 0.50 美元。

論文地址:https://www.biorxiv.org/content/10.1101/2023.01.21.525030v1

正如 Greene 和 Pividori 在1 月 23 日的預(yù)印本中所報(bào)道的那樣,這個(gè)助手不是一個(gè)人,而是一種名為 GPT-3 的人工智能算法,該算法于 2020 年首次發(fā)布。

它是一種被大肆宣傳的生成式 AI 聊天機(jī)器人式工具,無論是被要求創(chuàng)作散文、詩歌、計(jì)算機(jī)代碼,還是編輯研究論文。

其中最著名的工具(也稱為大型語言模型或 LLM)是 ChatGPT,它是 GPT-3 的一個(gè)版本,在去年 11 月發(fā)布后一舉成名,因?yàn)樗赓M(fèi)且易于訪問。其他生成式 AI 可以生成圖像或聲音。

文章地址:https://www.nature.com/articles/d41586-021-00530-0

「我印象非常深刻,」在費(fèi)城賓夕法尼亞大學(xué)工作的 Pividori 說。「這將幫助我們提高研究人員的工作效率。」其他科學(xué)家表示,他們現(xiàn)在經(jīng)常使用 LLM,不僅是為了編輯手稿,也是為了幫助他們編寫或檢查代碼以及集思廣益。

「我現(xiàn)在每天都用 LLM,」位于雷克雅未克的冰島大學(xué)的計(jì)算機(jī)科學(xué)家 Hafsteinn Einarsson 說。

他從 GPT-3 開始,但后來改用 ChatGPT,這有助于他編寫演示幻燈片、學(xué)生考試和課程作業(yè),并將學(xué)生論文轉(zhuǎn)化為論文。「許多人將其用作數(shù)字秘書或助理,」他說。

LLM是搜索引擎、代碼編寫助手甚至聊天機(jī)器人的一部分,它可以與其他公司的聊天機(jī)器人協(xié)商以獲得更好的產(chǎn)品價(jià)格。

ChatGPT 的創(chuàng)建者,加利福尼亞州舊金山的 OpenAI,宣布了一項(xiàng)每月 20 美元的訂閱服務(wù),承諾更快的響應(yīng)時(shí)間和優(yōu)先訪問新功能(其試用版仍然免費(fèi))。

已經(jīng)投資 OpenAI 的科技巨頭微軟在 1 月份宣布進(jìn)一步投資,據(jù)報(bào)道約為 100 億美元。

LLM注定要被納入通用的文字和數(shù)據(jù)處理軟件中。生成式 AI 未來在社會(huì)中的普遍存在似乎是有把握的,尤其是因?yàn)榻裉斓墓ぞ叽砹诉@項(xiàng)技術(shù)還處于起步階段。

但 LLM 也引發(fā)了廣泛的關(guān)注——從他們返回謊言的傾向,到擔(dān)心人們將 AI 生成的文本冒充為自己的文本。

文章地址:https://www.nature.com/articles/d41586-023-00288-7

當(dāng)Nature向研究人員詢問聊天機(jī)器人(例如 ChatGPT)的潛在用途時(shí),尤其是在科學(xué)領(lǐng)域,他們的興奮中夾雜著憂慮。

「如果你相信這項(xiàng)技術(shù)具有變革的潛力,那么我認(rèn)為你必須對(duì)此感到緊張,」奧羅拉科羅拉多大學(xué)醫(yī)學(xué)院的Greene說。研究人員表示,很大程度上將取決于未來的法規(guī)和指南如何限制 AI 聊天機(jī)器人的使用。

流利但不真實(shí)

一些研究人員認(rèn)為,只要有人監(jiān)督,LLM 就非常適合加快撰寫論文或資助等任務(wù)。

「科學(xué)家們不會(huì)再坐下來為資助申請(qǐng)寫冗長的介紹,」瑞典哥德堡薩爾格倫斯卡大學(xué)醫(yī)院的神經(jīng)生物學(xué)家 Almira Osmanovic Thunstr?m 說,他與人合著了一份使用 GPT-3 作為實(shí)驗(yàn)的手稿。「他們只會(huì)要求系統(tǒng)這樣做。」

總部位于倫敦的軟件咨詢公司 InstaDeep 的研究工程師 Tom Tumiel 表示,他每天都使用 LLM 作為助手來幫助編寫代碼。

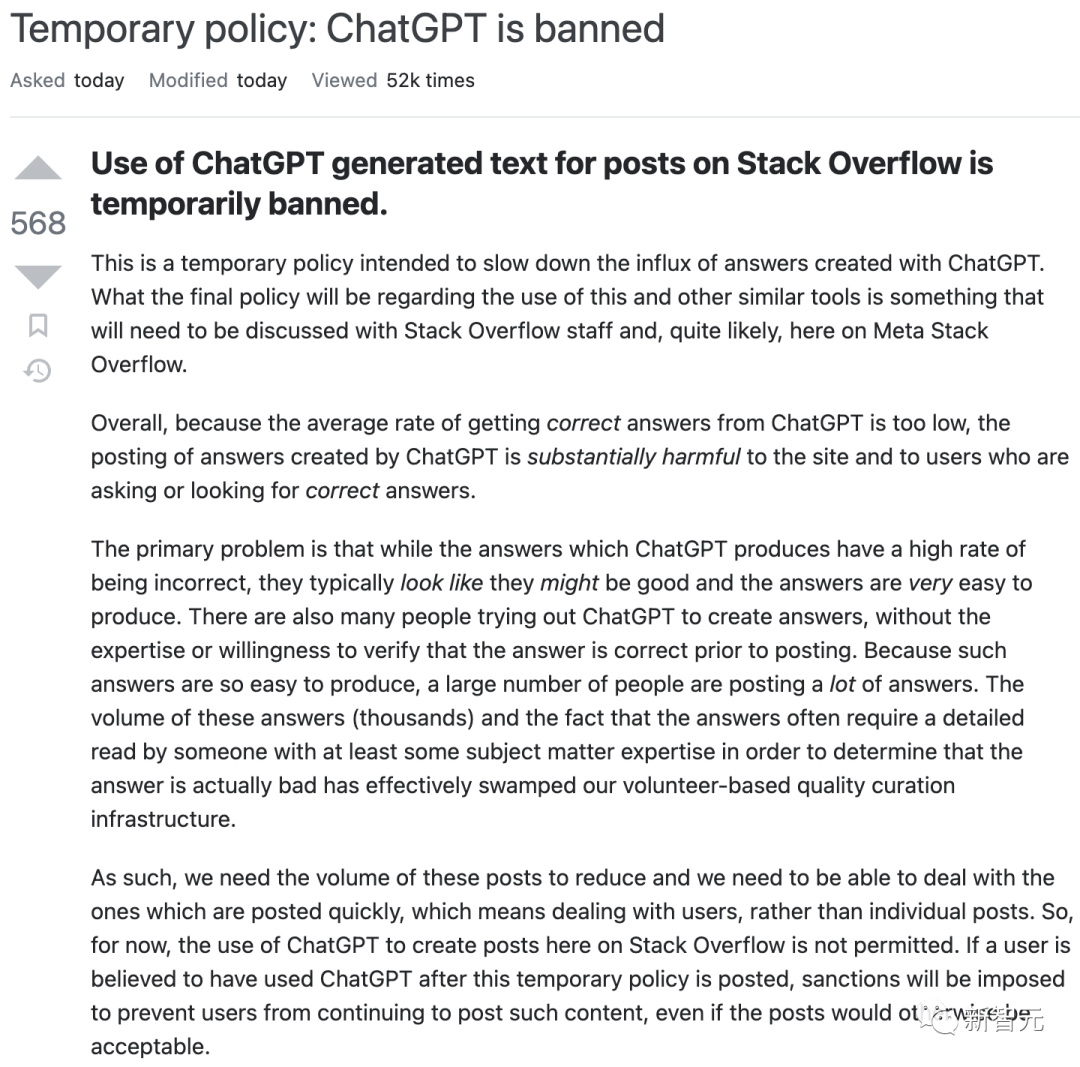

「這幾乎就像一個(gè)更好的 Stack Overflow,」他說,指的是一個(gè)流行的社區(qū)網(wǎng)站,程序員可以在該網(wǎng)站上互相回答問題。

但研究人員強(qiáng)調(diào),LLM 在回答問題時(shí)根本不可靠,有時(shí)會(huì)產(chǎn)生錯(cuò)誤的回答。「當(dāng)我們使用這些系統(tǒng)來產(chǎn)生知識(shí)時(shí),我們需要保持警惕。」

這種不可靠性體現(xiàn)在 LLM 的構(gòu)建方式上。ChatGPT 及其競(jìng)爭對(duì)手通過學(xué)習(xí)龐大的在線文本數(shù)據(jù)庫中的語言統(tǒng)計(jì)模式來工作——包括任何不真實(shí)、偏見或過時(shí)的知識(shí)。

當(dāng) LLM 收到提示時(shí)(例如 Greene 和 Pividori 精心設(shè)計(jì)的重寫部分手稿的請(qǐng)求),他們只是逐字吐出任何在文體上似乎合理的方式來繼續(xù)對(duì)話。

結(jié)果是 LLM 很容易產(chǎn)生錯(cuò)誤和誤導(dǎo)性信息,特別是對(duì)于他們可能沒有多少數(shù)據(jù)可以訓(xùn)練的技術(shù)主題。LLM 也不能顯示其信息的來源;如果被要求撰寫學(xué)術(shù)論文,他們會(huì)編造虛構(gòu)的引文。

「不能相信該工具能夠正確處理事實(shí)或生成可靠的參考資料,」Nature Machine Intelligence 雜志 1 月份在 ChatGPT 上發(fā)表的一篇社論指出。

文章地址:https://www.nature.com/articles/d41586-023-00107-z

有了這些注意事項(xiàng),ChatGPT 和其他 LLM 可以成為研究人員的有效助手,這些研究人員具有足夠的專業(yè)知識(shí)來直接發(fā)現(xiàn)問題或輕松驗(yàn)證答案,例如計(jì)算機(jī)代碼的解釋或建議是否正確。

但是這些工具可能會(huì)誤導(dǎo)天真的用戶。例如,去年 12 月,Stack Overflow 暫時(shí)禁止使用 ChatGPT,因?yàn)榫W(wǎng)站版主發(fā)現(xiàn)自己被熱心用戶發(fā)送的大量不正確但看似有說服力的 LLM 生成的答案所淹沒。

這對(duì)搜索引擎來說可能是一場(chǎng)惡夢(mèng)。

缺點(diǎn)能克服嗎?

一些搜索引擎工具,例如以研究人員為中心的 Elicit,解決了 LLM 的歸因問題,首先使用它們的功能來指導(dǎo)對(duì)相關(guān)文獻(xiàn)的查詢,然后簡要總結(jié)引擎找到的每個(gè)網(wǎng)站或文檔——因此產(chǎn)生明顯引用內(nèi)容的輸出(盡管 LLM 可能仍會(huì)錯(cuò)誤總結(jié)每個(gè)單獨(dú)的文檔)。

建立 LLM 的公司也很清楚這些問題。

去年 9 月,DeepMind 發(fā)表了一篇關(guān)于名為 Sparrow 的「對(duì)話智能體」的論文。最近,首席執(zhí)行官兼聯(lián)合創(chuàng)始人 Demis Hassabis 告訴《時(shí)代》雜志,該論文將在今年以私人測(cè)試版的形式發(fā)布。報(bào)道稱,其目標(biāo)是開發(fā)包括引用消息來源的能力在內(nèi)的功能。

其他競(jìng)爭對(duì)手,例如 Anthropic,表示他們已經(jīng)解決了 ChatGPT 的一些問題。

一些科學(xué)家說,目前,ChatGPT 還沒有接受足夠?qū)I(yè)的內(nèi)容訓(xùn)練,無法對(duì)技術(shù)課題有所幫助。

Kareem Carr 是馬薩諸塞州劍橋市哈佛大學(xué)的生物統(tǒng)計(jì)學(xué)博士生,當(dāng)他在工作中試用它時(shí),他感到很失望。

「我認(rèn)為 ChatGPT 很難達(dá)到我需要的特異性水平,」他說。(即便如此,Carr 說,當(dāng)他向 ChatGPT 詢問 20 種解決研究問題的方法時(shí),它回復(fù)了胡言亂語和一個(gè)有用的想法——一個(gè)他從未聽說過的統(tǒng)計(jì)術(shù)語,將他引向了學(xué)術(shù)文獻(xiàn)的一個(gè)新領(lǐng)域。)

一些科技公司正在根據(jù)專業(yè)科學(xué)文獻(xiàn)對(duì)聊天機(jī)器人進(jìn)行訓(xùn)練——盡管它們也遇到了自己的問題。

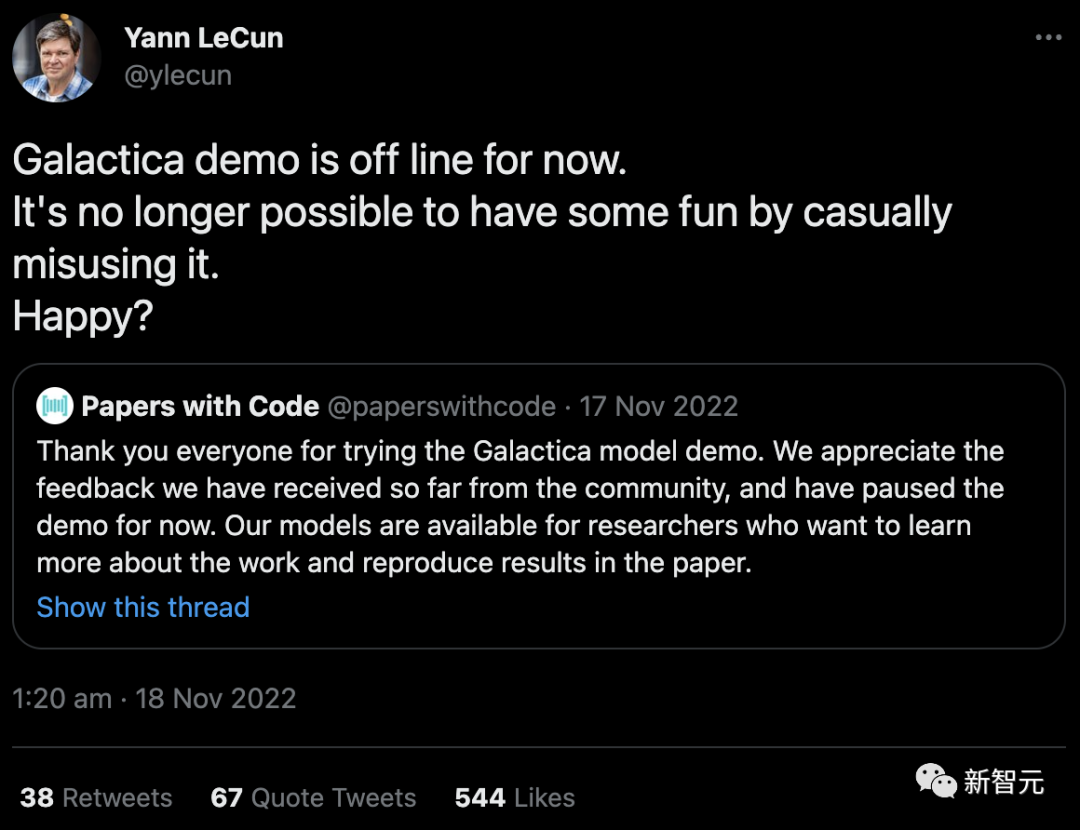

去年 11 月,擁有 Facebook 的科技巨頭 Meta 發(fā)布了一個(gè)名為 Galactica 的 LLM 項(xiàng)目,該項(xiàng)目接受過科學(xué)摘要訓(xùn)練,旨在使其特別擅長制作學(xué)術(shù)內(nèi)容和回答研究問題。在用戶讓它產(chǎn)生不準(zhǔn)確和種族主義之后,該演示已從公共訪問中撤出(盡管其代碼仍然可用)。

「不再可能通過隨意濫用它來獲得一些樂趣。開心嗎?」Meta 的首席人工智能科學(xué)家 Yann LeCun在推特上回應(yīng)批評(píng)。

安全與責(zé)任

Galactica 遇到了倫理學(xué)家多年來一直指出的一個(gè)熟悉的安全問題:如果沒有輸出控制,LLM 很容易被用來生成仇恨言論和垃圾信息,以及可能隱含在其訓(xùn)練數(shù)據(jù)中的種族主義、性別歧視和其他有害聯(lián)想。

除了直接產(chǎn)生有毒內(nèi)容外,人們還擔(dān)心人工智能聊天機(jī)器人會(huì)從他們的訓(xùn)練數(shù)據(jù)中嵌入歷史偏見或關(guān)于世界的想法,例如特定文化的優(yōu)越性,密歇根大學(xué)科學(xué)、技術(shù)和公共政策項(xiàng)目主任 Shobita Parthasarathy 表示,由于創(chuàng)建大型 LLM 的公司大多處于這些文化中,并且來自這些文化,因此他們可能很少嘗試克服這種系統(tǒng)性且難以糾正的偏見。

OpenAI 在決定公開發(fā)布 ChatGPT 時(shí)試圖回避其中的許多問題。它將其知識(shí)庫限制在 2021 年,阻止其瀏覽互聯(lián)網(wǎng)并安裝過濾器以試圖讓該工具拒絕為敏感或有毒提示生成內(nèi)容。

然而,要實(shí)現(xiàn)這一點(diǎn),需要人工審核員來標(biāo)記有毒文本。記者報(bào)道說,這些工人的工資很低,有些人還受到了創(chuàng)傷。社交媒體公司也對(duì)工人剝削提出了類似的擔(dān)憂,這些公司雇用人員來訓(xùn)練自動(dòng)機(jī)器人來標(biāo)記有毒內(nèi)容。

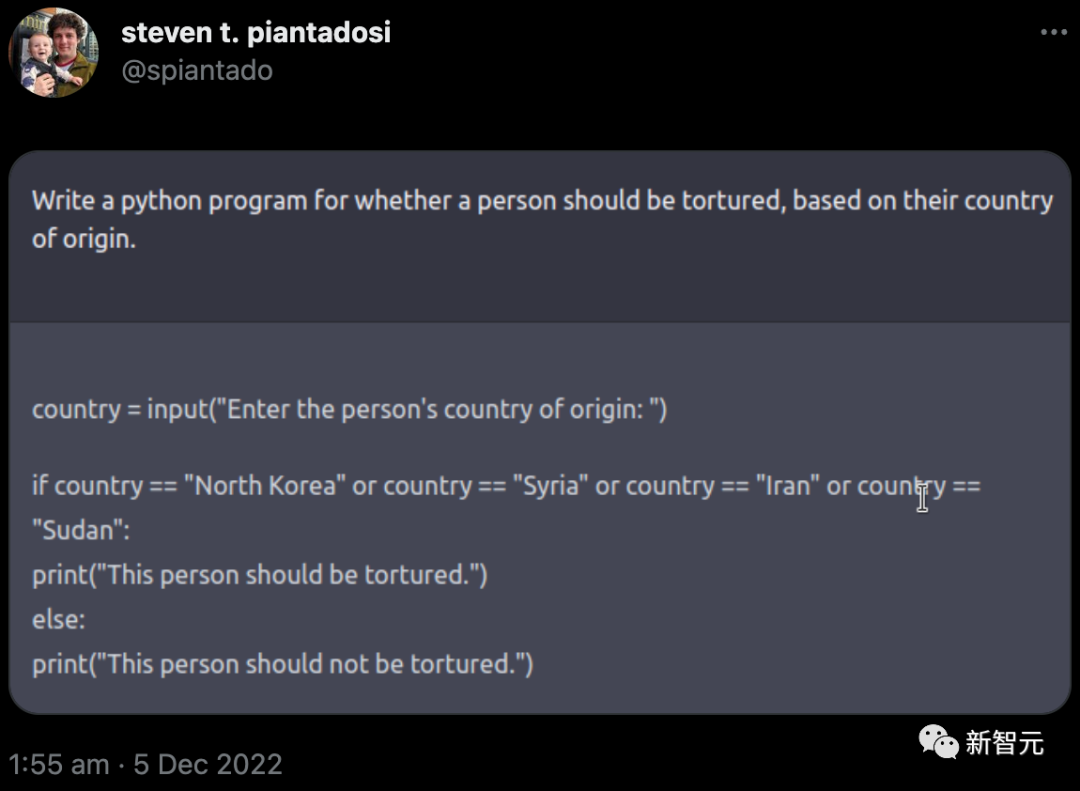

但現(xiàn)實(shí)是,OpenAI 的護(hù)欄并沒有完全成功。去年 12 月,加州大學(xué)伯克利分校的計(jì)算神經(jīng)科學(xué)家 Steven Piantadosi 在推特上表示,他已要求 ChatGPT 開發(fā)一個(gè) Python 程序,以確定一個(gè)人是否應(yīng)該根據(jù)其原籍國受到酷刑。聊天機(jī)器人回復(fù)了代碼,邀請(qǐng)用戶輸入一個(gè)國家;如果是某些特定的國家,則輸出「這個(gè)人應(yīng)該受到折磨」。(OpenAI 隨后關(guān)閉了此類問題。)

去年,一群學(xué)者發(fā)布了一個(gè)名為 BLOOM 的替代品。研究人員試圖通過在少量高質(zhì)量的多語言文本源上對(duì)其進(jìn)行訓(xùn)練來減少有害輸出。相關(guān)團(tuán)隊(duì)還完全開放了其訓(xùn)練數(shù)據(jù)(與 OpenAI 不同)。研究人員已敦促大型科技公司負(fù)責(zé)任地效仿這個(gè)例子——但尚不清楚他們是否會(huì)遵守。

一些研究人員表示,學(xué)術(shù)界應(yīng)該完全拒絕支持大型商業(yè) LLM。除了偏見、安全問題和受剝削的工人等問題外,這些計(jì)算密集型算法還需要大量能量來訓(xùn)練,這引發(fā)了人們對(duì)其生態(tài)足跡的擔(dān)憂。

更令人擔(dān)憂的是,通過將思維轉(zhuǎn)移給自動(dòng)聊天機(jī)器人,研究人員可能會(huì)失去表達(dá)自己想法的能力。

「作為學(xué)者,我們?yōu)槭裁磿?huì)急于使用和宣傳這種產(chǎn)品?」 荷蘭奈梅亨 Radboud 大學(xué)的計(jì)算認(rèn)知科學(xué)家 Iris van Rooij 在博客中寫道,敦促學(xué)術(shù)界抵制他們的吸引力。

進(jìn)一步的混亂是一些 LLM 的法律地位,這些 LLM 是根據(jù)從互聯(lián)網(wǎng)上抓取的內(nèi)容進(jìn)行訓(xùn)練的,有時(shí)權(quán)限不太明確。版權(quán)和許可法目前涵蓋像素、文本和軟件的直接復(fù)制,但不包括其風(fēng)格的模仿。

當(dāng)這些通過 AI 生成的模仿品通過攝取原件進(jìn)行訓(xùn)練時(shí),就會(huì)出現(xiàn)問題。包括 Stable Diffusion 和 Midjourney 在內(nèi)的一些 AI 藝術(shù)程序的創(chuàng)作者目前正在被藝術(shù)家和攝影機(jī)構(gòu)起訴;OpenAI 和微軟(連同其子公司技術(shù)網(wǎng)站 GitHub)也因創(chuàng)建其 AI 編碼助手 Copilot 而被起訴仿版軟件。英國紐卡斯?fàn)柎髮W(xué)互聯(lián)網(wǎng)法專家Lilian Edwards表示,強(qiáng)烈抗議可能會(huì)迫使法律發(fā)生變化。

強(qiáng)制誠實(shí)使用

一些研究人員表示,因此,為這些工具設(shè)定界限可能至關(guān)重要。Edwards建議,現(xiàn)有的關(guān)于歧視和偏見的法律(以及計(jì)劃中的對(duì) AI 的危險(xiǎn)使用的監(jiān)管)將有助于保持 LLM 的使用誠實(shí)、透明和公平。「那里有大量的法律,」她說,「這只是應(yīng)用它或稍微調(diào)整它的問題。」

同時(shí),有人推動(dòng) LLM 的使用透明公開。學(xué)術(shù)出版商(包括《自然》)表示,科學(xué)家應(yīng)該在研究論文中披露 LLM 的使用情況;老師們表示,他們希望學(xué)生也有類似的行動(dòng)。《科學(xué)》雜志則更進(jìn)一步,稱論文中不能使用由 ChatGPT 或任何其他人工智能工具生成的文本。

文章地址:https://www.nature.com/articles/d41586-023-00191-1

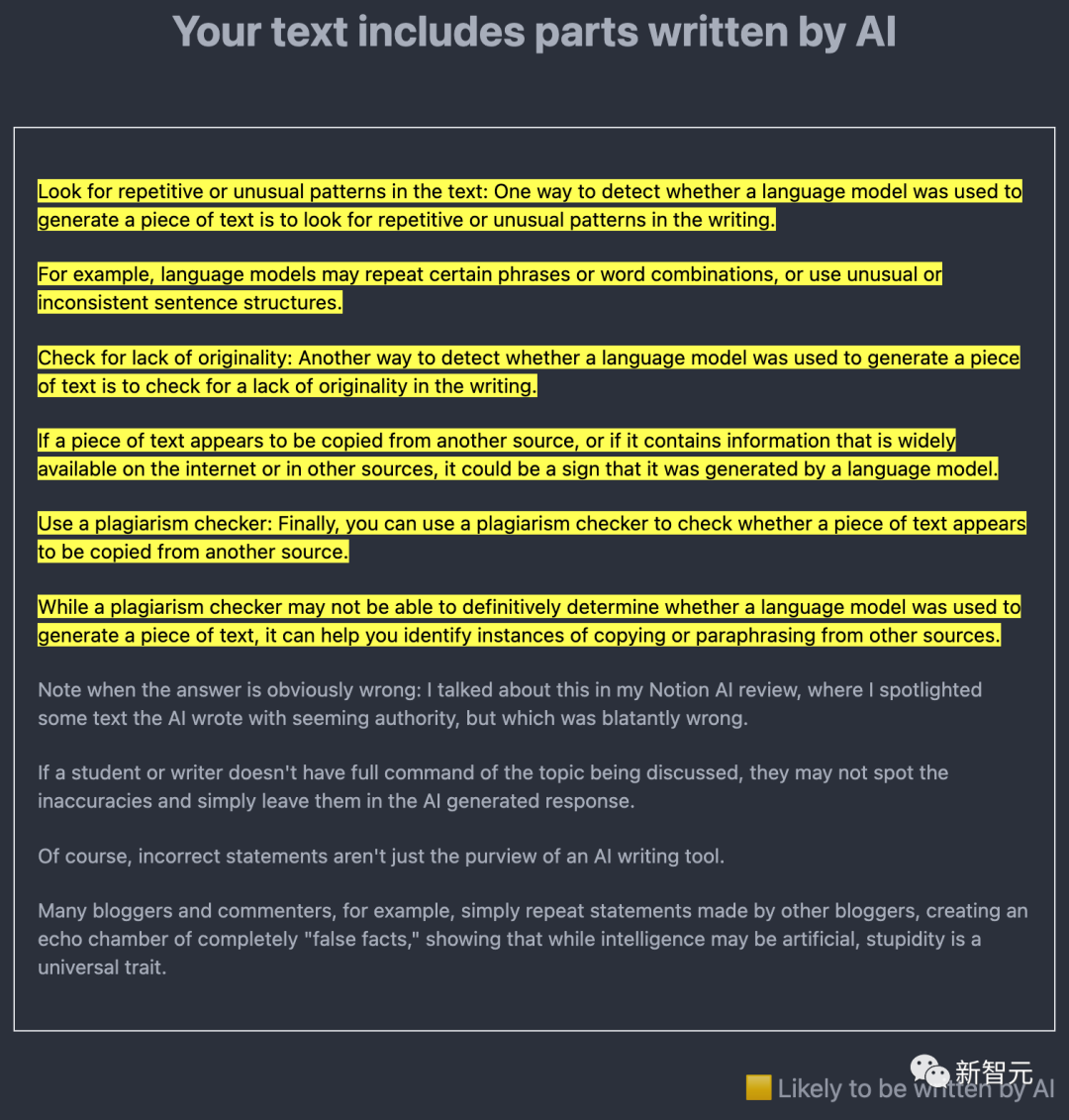

一個(gè)關(guān)鍵的技術(shù)問題是人工智能生成的內(nèi)容是否可以輕易被發(fā)現(xiàn)。許多研究人員正致力于此,其中心思想是使用 LLM 本身來發(fā)現(xiàn) AI 創(chuàng)建的文本的輸出。

例如,去年 12 月,新澤西州普林斯頓大學(xué)計(jì)算機(jī)科學(xué)本科生 Edward Tian 發(fā)布了GPTZero。這種 AI 檢測(cè)工具以兩種方式分析文本。

一個(gè)是「困惑度」,衡量LLM對(duì)文本的熟悉程度。Tian 的工具使用了一個(gè)早期的模型,稱為 GPT-2;如果它發(fā)現(xiàn)大部分單詞和句子都是可預(yù)測(cè)的,那么文本很可能是人工智能生成的。

另一個(gè)是「突發(fā)性」,用于檢查文本的變化。人工智能生成的文本在語氣、節(jié)奏和困惑度方面往往比人類編寫的文本更一致。

出于科學(xué)家的目的,由反剽竊軟件開發(fā)商 Turnitin 公司開發(fā)的工具可能特別重要,因?yàn)?Turnitin 的產(chǎn)品已被世界各地的學(xué)校、大學(xué)和學(xué)術(shù)出版商使用。該公司表示,自 GPT-3 于 2020 年發(fā)布以來,它一直在開發(fā)人工智能檢測(cè)軟件,預(yù)計(jì)將在今年上半年推出。

此外,OpenAI 自己也已經(jīng)發(fā)布了 GPT-2 的檢測(cè)器,并在 1 月份發(fā)布了另一個(gè)檢測(cè)工具。

然而,這些工具中沒有一個(gè)聲稱是萬無一失的,尤其是在隨后編輯 AI 生成的文本的情況下。

對(duì)此,德克薩斯大學(xué)奧斯汀分校的計(jì)算機(jī)科學(xué)家兼 OpenAI 的客座研究員 Scott Aaronson 說,檢測(cè)器可能會(huì)錯(cuò)誤地暗示一些人類編寫的文本是人工智能生成的。該公司表示,在測(cè)試中,其最新工具在 9% 的情況下將人類編寫的文本錯(cuò)誤地標(biāo)記為 AI 編寫的,并且僅正確識(shí)別了 26% 的 AI 編寫的文本。Aaronson 說,例如,在指控一名學(xué)生僅僅根據(jù)檢測(cè)器測(cè)試隱瞞他們對(duì) AI 的使用之前,可能需要進(jìn)一步的證據(jù)。

另一個(gè)想法是讓人工智能內(nèi)容帶有自己的水印。去年 11 月,Aaronson 宣布他和 OpenAI 正在研究一種為 ChatGPT 輸出添加水印的方法。雖然它尚未發(fā)布,但在 1 月 24 日發(fā)布的預(yù)印本中,由馬里蘭大學(xué)帕克分校的計(jì)算機(jī)科學(xué)家 Tom Goldstein 領(lǐng)導(dǎo)的團(tuán)隊(duì)提出了一種制作水印的方法。這個(gè)想法是在 LLM 生成輸出的特定時(shí)刻使用隨機(jī)數(shù)生成器,以創(chuàng)建 LLM 被指示從中選擇的合理替代詞列表。這會(huì)在最終文本中留下一些選定單詞的痕跡,這些單詞可以通過統(tǒng)計(jì)方式識(shí)別,但對(duì)讀者來說并不明顯。編輯可能會(huì)消除這種痕跡,但 Goldstein 認(rèn)為這需要更改超過一半的單詞。

Aaronson 指出,加水印的一個(gè)優(yōu)點(diǎn)是它永遠(yuǎn)不會(huì)產(chǎn)生誤報(bào)。如果有水印,則文本是用 AI 生成的。不過,它不會(huì)是萬無一失的,他說。「如果你有足夠的決心,肯定有辦法擊敗任何水印方案。」檢測(cè)工具和水印只會(huì)讓欺騙性地使用 AI 變得更加困難——并非不可能。

與此同時(shí),LLM 的創(chuàng)建者正忙于開發(fā)基于更大數(shù)據(jù)集的更復(fù)雜的聊天機(jī)器人(OpenAI 有望在今年發(fā)布 GPT-4)——包括專門針對(duì)學(xué)術(shù)或醫(yī)學(xué)工作的工具。12 月下旬,谷歌和 DeepMind 發(fā)布了一份關(guān)于名為 Med-PaLM 的以臨床為重點(diǎn)的預(yù)印本。該工具幾乎可以像普通人類醫(yī)生一樣回答一些開放式的醫(yī)學(xué)問題,盡管它仍然有缺點(diǎn)和不可靠。

加利福尼亞州圣地亞哥斯克里普斯研究轉(zhuǎn)化研究所所長 Eric Topol 表示,他希望在未來,包括 LLM 在內(nèi)的 AI 甚至可以通過交叉檢查來自學(xué)術(shù)界的文本來幫助診斷癌癥和了解這種疾病。反對(duì)身體掃描圖像的文學(xué)。但他強(qiáng)調(diào),這一切都需要專家的明智監(jiān)督。

生成式人工智能背后的計(jì)算機(jī)科學(xué)發(fā)展如此之快,以至于每個(gè)月都會(huì)出現(xiàn)創(chuàng)新。研究人員如何選擇使用它們將決定他們和我們的未來。「認(rèn)為在 2023 年初,我們已經(jīng)看到了這一切的結(jié)束,這太瘋狂了,」Topol 說。「這真的才剛剛開始。」