四少女火爆外網!ControlNet組合拳效果驚人,顛覆AI繪畫游戲規則

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

四位美少女,帶著AI畫畫在ChatGPT的熱浪中殺出了一片天地。

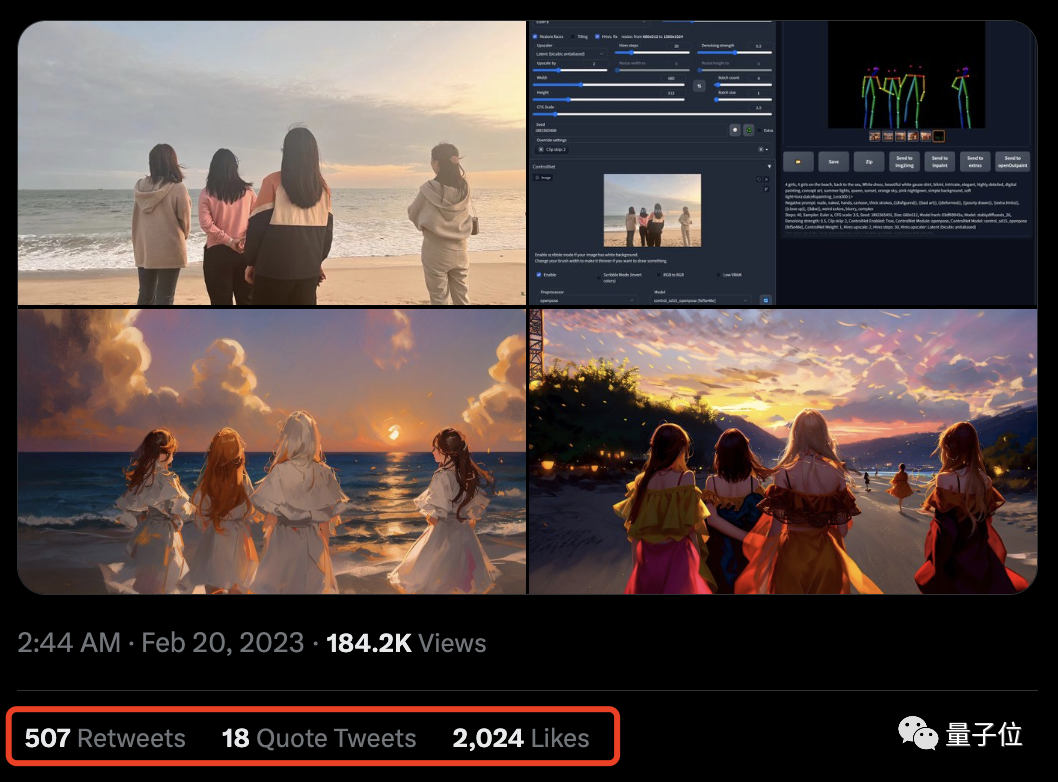

新“魔法”一出,瞬間吸引全場目光:

原本是一張四個閨蜜在沙灘邊上的普通合影照:

在新魔法的加持下,“啪的一下”畫風兩極反轉,瞬間進入唯美動漫風:

還有效果截然不同的,例如醬紫:

不僅是動漫畫風效果上的驚艷,就連人物的pose也是保持得“原汁原味”,美女們這下子算是分分鐘實現了動漫自由。

如此效果一出,也是引來了不少網友們的圍觀,直呼“在線求教程”:

也有不少人呼吁可以將這套玩法商業化了:

兩大AI高手聯動

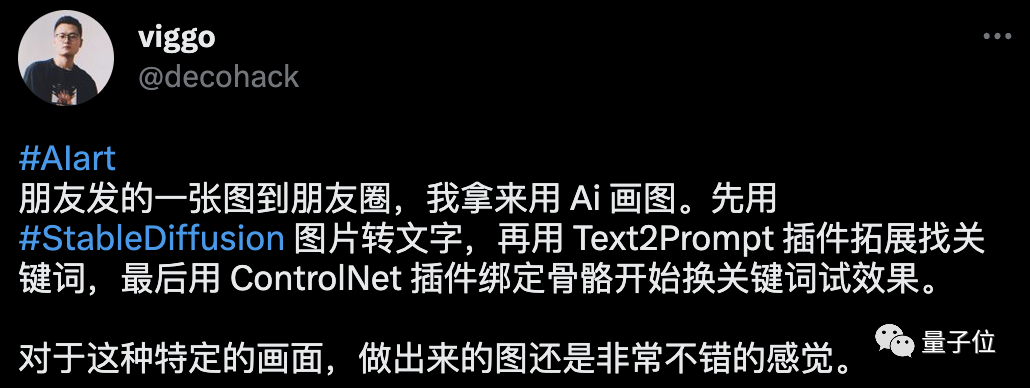

使出這套AI組合拳的,是一位叫“viggo”的華人小哥博主。

他所持的兩大法寶分別是:左手StableDiffusion,右手ControlNet。

StableDiffusion,相信很多友友們都已經很熟悉了,是根據輸入提示的文本,就可以快速出圖的AI作畫神器。

ControlNet,則是新晉當紅AI插件(GitHub上線2天狂攬4.6K星),相當于給AI作畫這事加了buff,可以精準控制手部細節和整體結構等。

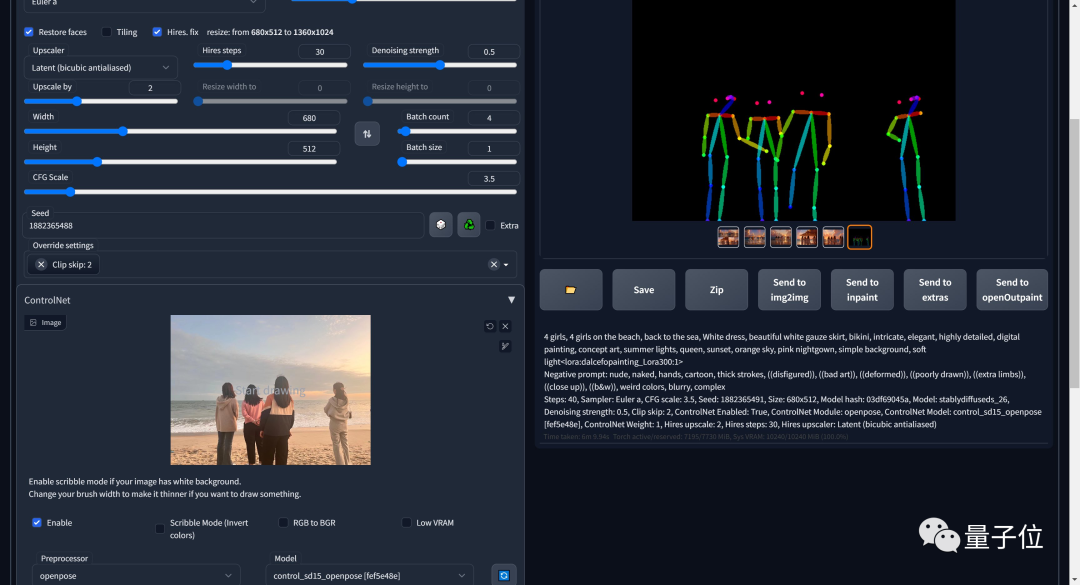

小哥的做法說起也是比較簡單,就是先將原圖導入進去,用StableDiffusion圖片轉文字。

再用Text2Prompt插件拓展找到對應的關鍵詞;最后用ControlNet插件綁定骨骼開始換關鍵詞試效果。

當然,原圖中四位美女的姿勢,也可以根據小哥繪制骨骼結構的不同發生相應的改變。例如這樣的:

相比原圖中人物的位置,上面這張中的人物更分散了一些,也站到了一排;以及上半身手臂的姿勢也發生了變化。

也是得益于StableDiffusion的能力,AI生成畫作在畫風上也能產出截然不同的效果:

效果之驚艷,已經有網友按耐不住,照著小哥的說法“復現”了一遍,并表示:

第一次接觸,很好玩,嘗試復現下,感覺良好。

不過有一說一,這位新晉AI作畫頂流插件ControlNet的“神通”可不僅于此。

簡單幾筆也可畫出真人效果

例如微博博主“海辛Hyacinth”便分享了他用ControlNet插件后“草圖變美女”的玩法。

他先是繪制了一張線稿:

然后是開啟了ControlNet的scribble模細化效果,便得到了這樣的結果:

效果之逼真,也是令人嘆服了。

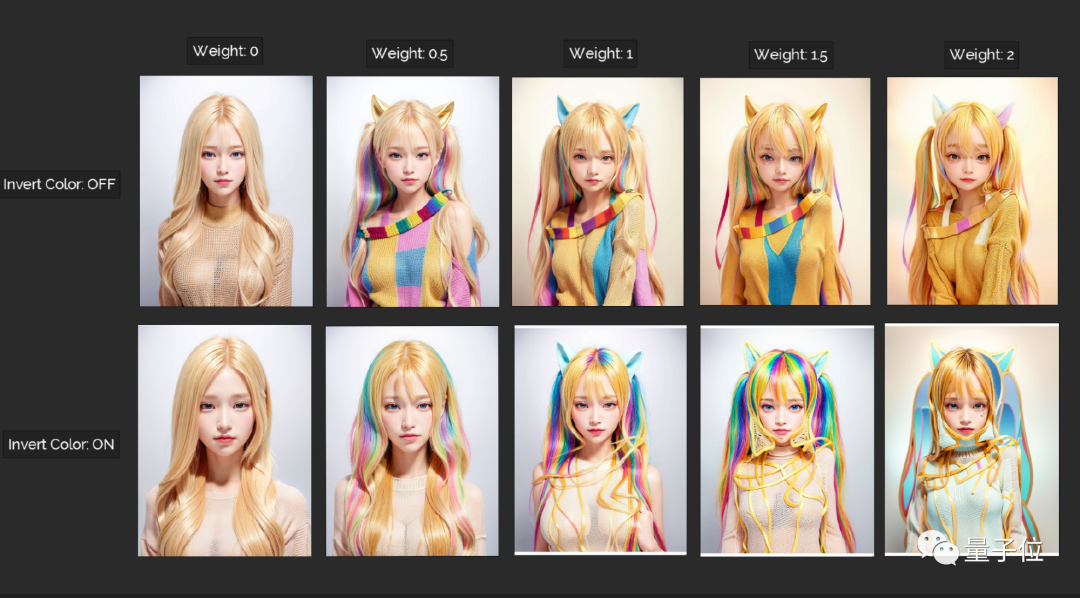

“海辛Hyacinth”還測試了在同一seed下不同參數的效果:

有小伙伴就要問了,那如果關閉了ControlNet,效果會如何?別急,博主也做了測試,效果是這樣的:

“海辛Hyacinth”的這波操作也是得到了ControlNet作者的認可:

這也把博主本人激動壞了,直呼“尖叫”:

當然,ControlNet還可以實現其它諸多的功能,例如在裝修設計上,可以輸入一張拍好的臥室圖,分分鐘輸出草圖和換了風格的效果圖:

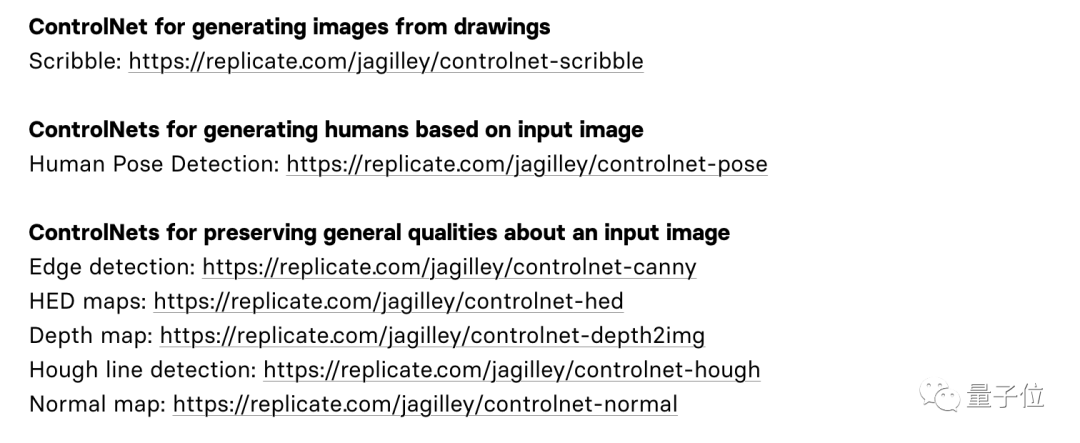

以及在ControlNet的在線網站中,也提供了許多不同功能玩法體驗,感興趣的小伙伴可以去嘗試哦:

給AI畫畫模型加buff

ControlNet的原理,本質上是給預訓練擴散模型增加一個額外的輸入,控制它生成的細節。

這里可以是各種類型的輸入,作者給出來的有8種,包括草圖、邊緣圖像、語義分割圖像、人體關鍵點特征、霍夫變換檢測直線、深度圖、人體骨骼等。

那么,讓大模型學會“按輸入條件生成圖片”的原理是什么呢?

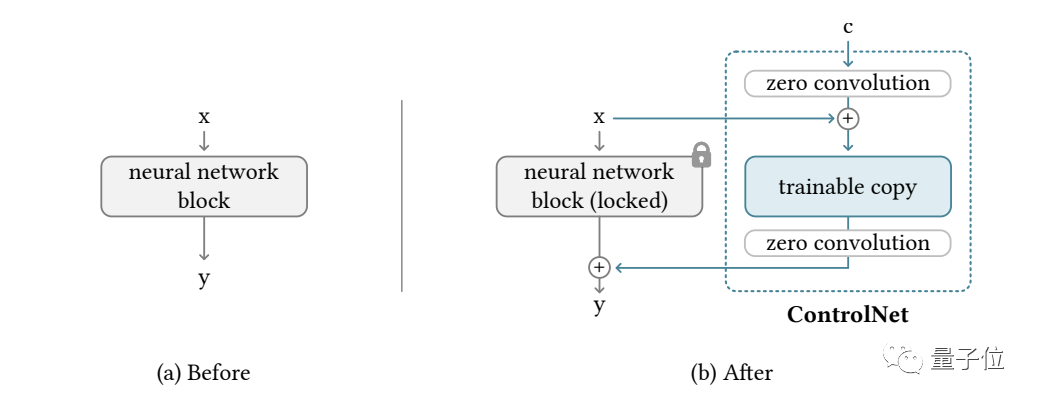

ControlNet整體思路和架構分工如下:

具體來說,ControlNet先復制一遍擴散模型的權重,得到一個“可訓練副本”(trainable copy)。

相比之下,原擴散模型經過幾十億張圖片的預訓練,因此參數是被“鎖定”的。而這個“可訓練副本”只需要在特定任務的小數據集上訓練,就能學會條件控制。

據作者表示,即使數據量很少(不超過5萬張圖片),模型經過訓練后條件控制生成的效果也很好。

“鎖定模型”和“可訓練副本”通過一個1×1的卷積層連接,名叫“0卷積層”。

0卷積層的權重和偏置初始化為0,這樣在訓練時速度會非常快,接近微調擴散模型的速度,甚至在個人設備上訓練也可以。

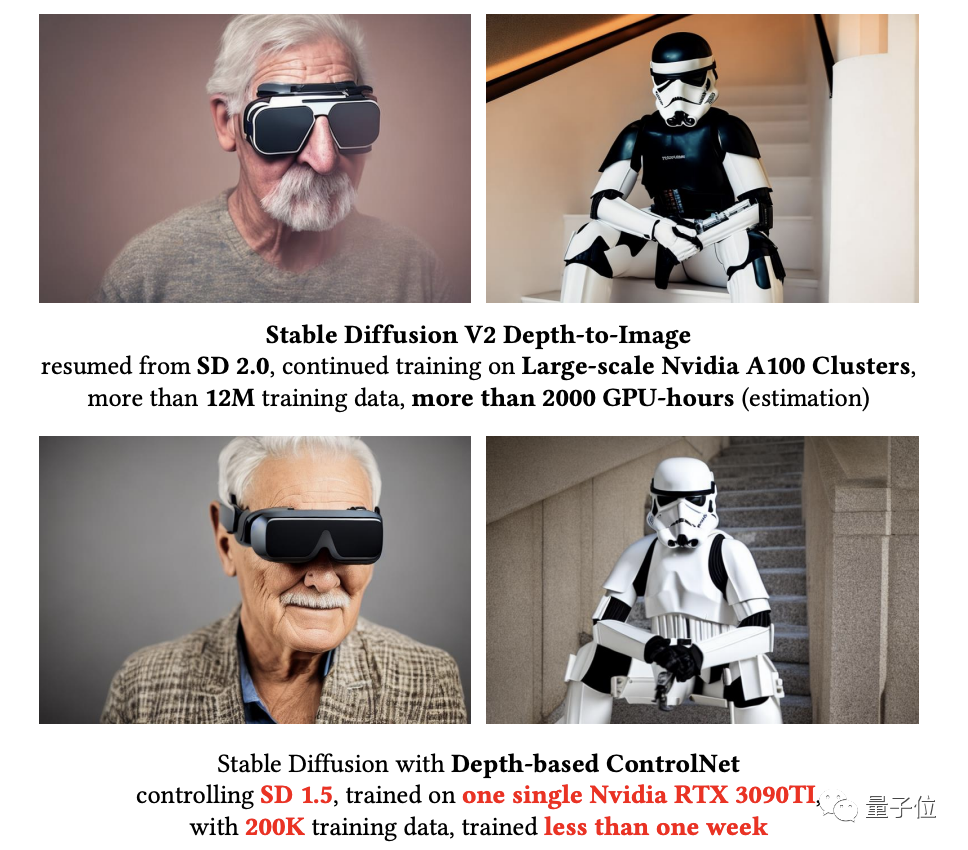

例如一塊英偉達RTX 3090TI,用20萬張圖像數據訓練的話只需要不到一個星期:

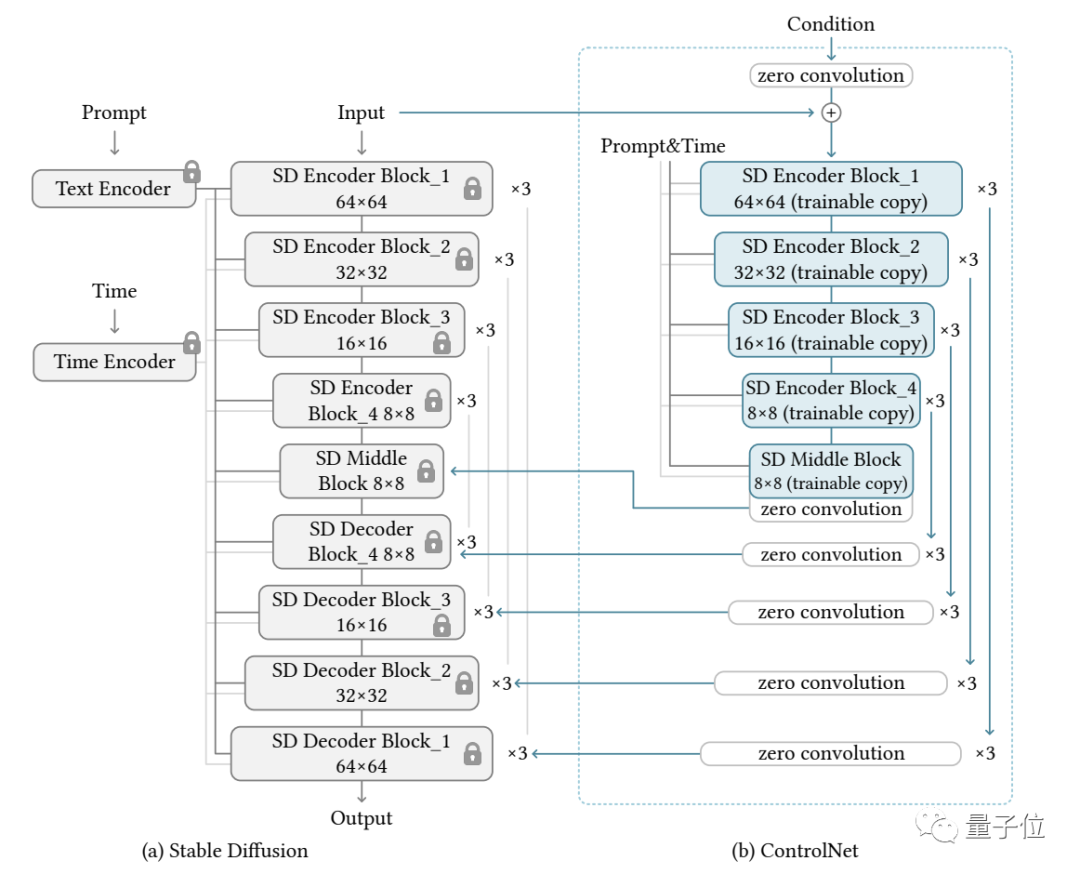

作者基于當前大火的Stable Diffusion進行了具體實現,主要架構如下:

針對不同的輸入,作者也給出了對應不同的模型,生成效果也都不錯。

具體效果,就如我們剛才所展示的那樣了。

One More Thing

最后來一個溫馨提示……男同胞們不要覺得2月14日這個情人節過完就安全了。

接下來還可能有白色情人節(3月14日)、黑色情人節(4月14日)、玫瑰情人節(5月14日)、親親情人節(6月14日)……

趕緊把這套“AI組合拳”學起來,送自己的老婆/女朋友一張唯美的禮物吧!