李志飛:關于GPT-4的八點觀察,多模態大模型競賽開始

自微軟3月初發布多模態模型 Kosmos-1 以來,一直在測試和調整 OpenAI 的多模態模型,并將其更好地兼容微軟自有產品。

果不其然,趁著GPT-4發布之際,微軟也正式攤牌,New Bing早就已經用上GPT-4了。

ChatGPT用的語言模型是 GPT-3.5,在談到GPT-4比前一個版本強大在哪里時,OpenAI稱,雖然這兩個版本在隨意的談話中看起來很相似,但「當任務的復雜性達到足夠的閾值時,差異就會出現」,GPT-4更可靠、更有創意,并且能夠處理更細微的指令。

王者加冕?關于GPT-4的八點觀察

1. 再度驚艷,強過人類

如果說GPT-3系列模型向大家證明了AI能夠在一個模型里做多個任務,指明實現AGI的路徑,GPT-4在很多任務上已經達到人類水平(human-level),甚至比人類表現更好。GPT-4在很多專業的學術考試上已經超越90%的人類,比如在模擬律師考試中,分數在應試者的前10%左右。對此,各類中小學、大學和專業教育該如何應對?

2. 「科學」煉丹

雖然OpenAI此次并未公布具體參數,但可以猜到GPT-4模型一定不小,模型太多就意味著高額訓練成本。與此同時,訓練模型也很像「煉丹」,需要做很多實驗,如果這些實驗都是在真實環境下去訓練,高昂成本壓力不是誰都能承受的。

為此,OpenAI別出心裁搞了一個所謂的「predictable scaling」,簡言之就是用萬分之一的成本來預測各個實驗的結果(loss和human eval)。如此一來,就把原本大模型「碰運氣」的煉丹訓練升級為「半科學」的煉丹。

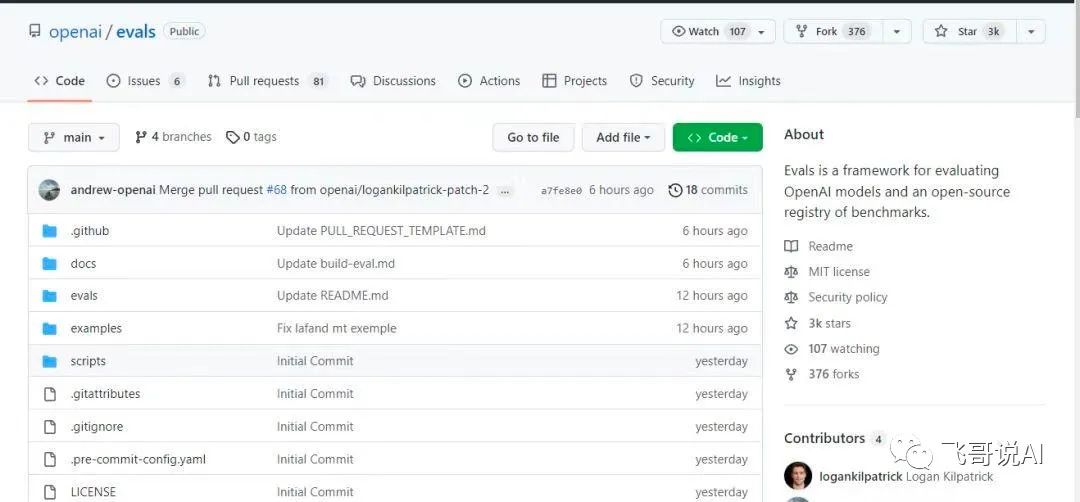

3. 眾包評測,一舉雙得

這次非常「取巧」地提供了一個open source的OpenAI Evals,用眾包方式開放給各位開發者或愛好者,邀請大家使用Evals來測試模型,同時籠絡開發者生態。這一方式,既讓大家有參與感,又能讓大家免費幫忙評估提高系統,OpenAI直接獲得問題和反饋,一石二鳥。

4. 工程補漏

這次還發布了一個System Card,是一個開放的「打補丁」工具,可以發現漏洞減少語言模型的「胡說八道」問題。系統打了各種各樣的補丁做預處理和后處理,后面還會開放代碼把打補丁能力眾包給大家,OpenAI未來也許可以讓大家幫它一起做。這標志著LLM終于從一個優雅簡單的next token prediction任務進入了各種messy的工程hack了。

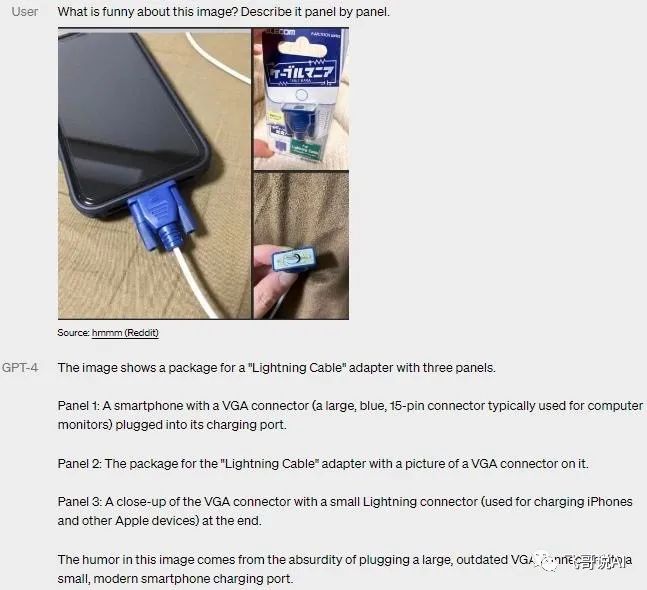

5. 多模態

自上周德國微軟透露GPT-4是多模態后,大眾可謂萬眾期待。

GPT-4千呼萬喚始出來,被譽為「堪比人腦」的多模態其實跟目前很多論文闡述的多模態能力并無太多差別,主要區別就是把文本模型的few-shot和邏輯鏈(COT)結合進來,這里有個前提是需要一個基礎能力很好的文本LLM再加多模態,會產生不錯的效果。

6. 有計劃地放出「王炸」

按照OpenAI演示GPT-4的demo視頻里的說法,GPT-4 早在去年8月就已完成訓練,但今天才發布,剩下的時間都在進行大量測試和各種查漏補缺,以及最重要的去除危險內容生成的工作。

當大家還沉浸在ChatGPT驚人的生成能力之時,OpenAI已經搞定GPT-4,這波谷歌工程師估計又要熬夜追趕了?

7. OpenAI不再Open

OpenAI在公開的論文里完全沒有提及任何模型參數和數據規模(網傳GPT-4參數已達100萬億),也沒有任何技術原理,對此解釋說是為了普惠大眾,怕大家學會了怎么做GPT-4之后會用來做惡,觸發一些不可控的事情發生,個人完全不認同這種此地無銀的做法。

8. 集中力量辦大事

論文除了各種「炫技」,還特別用了三頁把所有為GPT-4不同系統有貢獻人員都列出來,粗略估計應該已經超過百人,再次體現OpenAI內部團隊成員眾志成城、高度協作的狀態。以此對比其他幾家的團隊作戰能力,在眾志成城這方面是不是差得有點遠?

目前多模態大模型已經成為整個AI大模型發展的趨勢和重要方向,而在這場大模型AI「軍備競賽」中,谷歌、微軟、DeepMind等科技巨頭都積極推出多模態大模型(MLLM)或大模型(LLM)。

開啟新一輪軍備競賽:多模態大模型

微軟:Kosmos-1

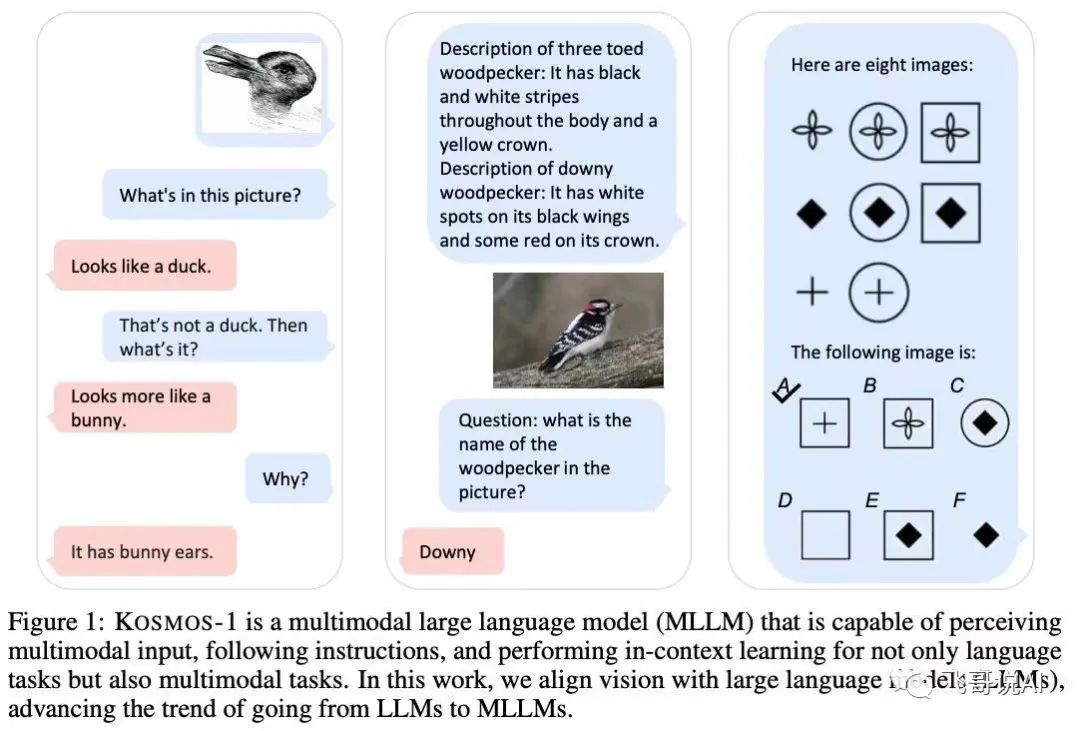

微軟在3月初發布擁有16億參數的多模態模型 Kosmos-1,網絡結構基于 Transformer 的因果語言模型。其中,Transformer 解碼器用作多模態輸入的通用接口。

除了各種自然語言任務,Kosmos-1 模型能夠原生處理廣泛的感知密集型任務,如視覺對話、視覺解釋、視覺問答、圖像字幕、簡單的數學方程式、OCR 和帶描述的零樣本圖像分類。

谷歌:PaLM-E

3月初,谷歌和柏林工業大學的研究團隊推出目前最大的視覺語言模型——PaLM-E,參數量高達5620億(PaLM-540B+ViT-22B)。

PaLM-E是一個僅有解碼器的大模型,在給定前綴(prefix)或提示(prompt)下,能夠以自回歸方式生成文本補全。模型通過加一個編碼器,模型可以將圖像或感知數據編碼為一系列與語言標記大小相同的向量,將此作為輸入用于下一個token預測,進行端到端訓練。

DeepMind:Flamingo

DeepMind在去年4月推出Flamingo視覺語言模型,模型將圖像、視頻和文本作為提示(prompt),輸出相關語言,只需要少量的特定例子既能解決很多問題,無需額外訓練。

通過交叉輸入圖片(視頻)和文本的方式訓練模型,使模型具有 few-shot 的多模態序列推理能力,完成「文本描述補全、VQA / Text-VQA」等多種任務。

目前,多模態大模型已顯示更多應用可能性,除了相對成熟的文生圖外,人機互動、機器人控制、圖片搜索、語音生成等大量應用逐一出現。

綜合來看,GPT-4不會是AGI,但多模態大模型已經是一個清晰且確定的發展方向。建立統一的、跨場景、多任務的多模態基礎模型會成為人工智能發展的主流趨勢之一。

雨果說「科學到了最后階段,便遇上了想象」,多模態大模型的未來或許正超越人類的想象。