OpenAI新生成模型開源炸場!比Diffusion更快更強,清華校友宋飏一作

圖像生成領域,看來又要變天了。

就在剛剛,OpenAI開源了比擴散模型更快、性能更好的一致性模型:

無需對抗訓練,就能生成高質量圖片!

這個重磅消息一經發出,立刻引爆學術圈。

雖說論文本身在3月份就已低調發布,但當時大伙兒普遍認為它只是個OpenAI的前沿研究,并不會真正將細節公開。

沒想到這次直接來了個開源。有網友立刻上手實測了一波效果,發現只需要3.5秒左右就能生成64張左右256×256的圖像:

游戲結束!

這是這位網友生成的圖像效果,看起來還不錯:

還有網友調侃稱:這次OpenAI終于Open了!

值得一提的是,論文一作OpenAI科學家宋飏,是一位清華校友,16歲就通過領軍計劃進入清華數理基礎科學班求學。

一起來看看這次OpenAI開源了一項怎樣的研究。

開源了一個怎樣的重磅研究?

作為一個圖像生成AI,一致性模型(Consistency Model)最大的特點在于快又好。

相比擴散模型,它主要有兩大優勢:

其一,無需對抗訓練(adversarial training),就能直接生成高質量的圖像樣本。

其二,相比擴散模型可能需要幾百甚至上千次迭代,一致性模型只需要一兩步就能搞定多種圖像任務——

包括上色、去噪、超分等,都可以在幾步之內搞定,而不需要對這些任務進行明確訓練。(當然,如果進行少樣本學習的話,生成效果也會更好)

所以一致性模型究竟是如何實現這種效果的?

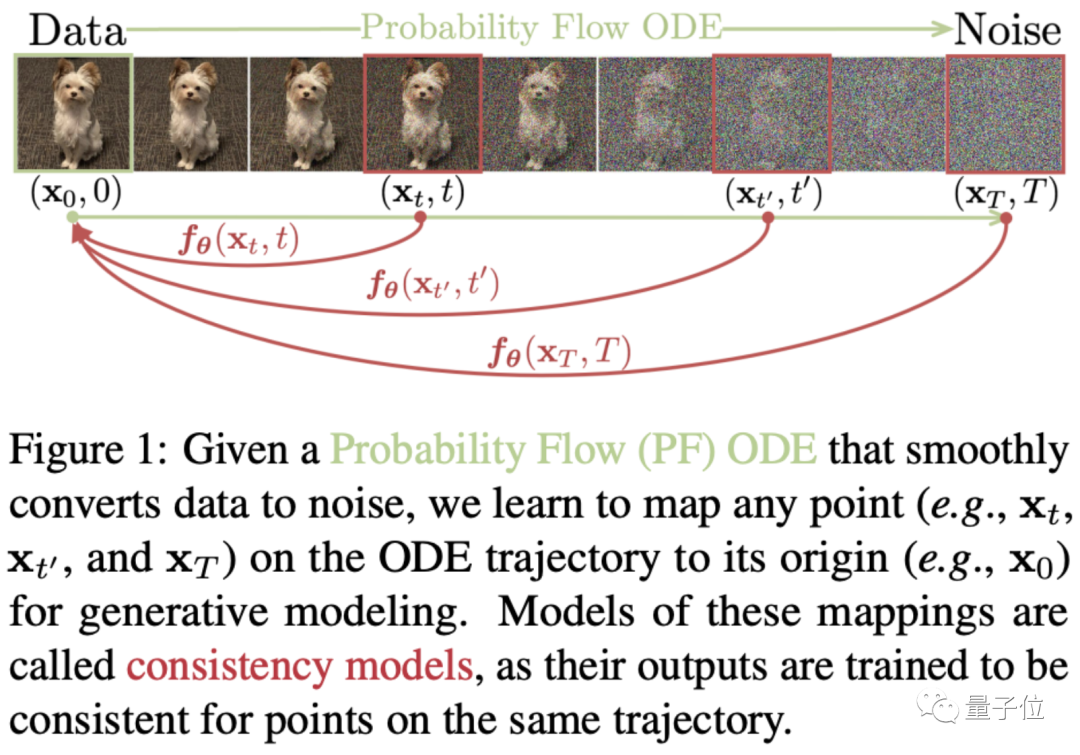

從原理來看,一致性模型的誕生與ODE(常微分方程)式生成擴散模型有關。

圖中可見,ODE會先一步步將圖片數據轉換成噪聲,隨后再進行一個逆向求解,從噪聲中學習生成圖像。

而就在這個過程中,作者們試圖將ODE軌跡上的任何點(如Xt、Xt和Xr)映射到它的原點(如X0)進行生成建模。

隨后,這個映射的模型被命名為一致性模型,因為它們的輸出都是同一軌跡上的同一點:

基于這種思路,一致性模型不需要再經過漫長的迭代,才能生成一個相對質量比較高的圖像,而是能做到一步生成。

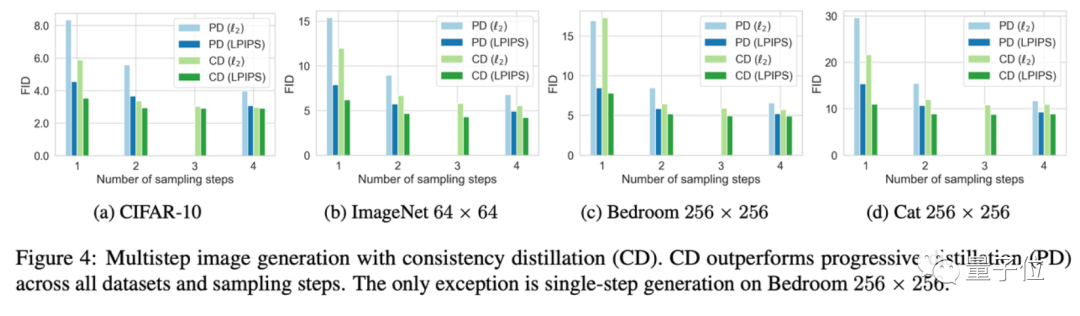

下圖是一致性模型(CD)和擴散模型(PD)在圖像生成指標FID上的對比。

其中,PD是去年斯坦福和谷歌大腦提出的一種最新擴散模型方法漸進式蒸餾(progressive distillation)的簡稱,CD(consistency distillation)則是一致性蒸餾方法。

可以看出,幾乎在所有數據集上,一致性模型的圖像生成效果都要比擴散模型更好,唯一的例外是256×256的房間數據集上:

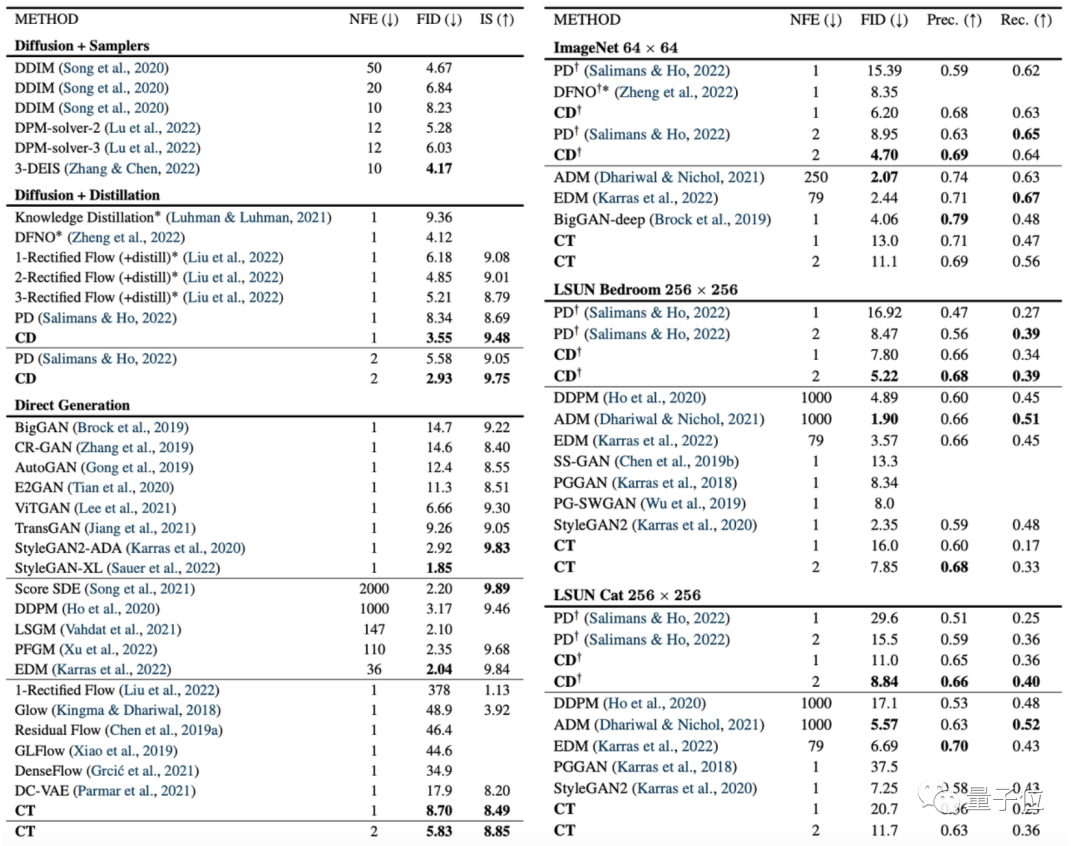

除此之外,作者們也將擴散模型、一致性模型和GAN等模型在其他各種數據集上進行了對比:

不過也有網友提到,這次開源的AI一致性模型,能生成的圖像還是太小:

很難過,這次開源的版本生成的圖像還是太小了,要是能給出生成更大圖像的開源版本,肯定會非常讓人興奮。

也有網友猜測,可能只是OpenAI還沒訓練出來。不過可能訓練出來了我們也不一定能搞到代碼(手動狗頭)。

不過對于這項工作的意義,TechCrunch表示:

你若是有一堆GPU,那用擴散模型在一兩分鐘內迭代1500多次,生成圖片的效果當然是極好的。

但如果你想在手機上或者聊天對話的時候實時生成圖片,那顯然擴散模型不是最好的選擇。

一致性模型是OpenAI下一個重要動作。

期待OpenAI會開源一波分辨率更高的圖像生成AI~

清華校友宋飏一作

論文一作宋飏,目前是OpenAI的研究科學家。

他14歲時,曾以17位評委全票通過的成績,入選“清華大學新百年領軍計劃”。在次年高考中,他又成為連云港市理科狀元,順利考入清華。

2016年,宋飏從清華大學數理基礎科學班畢業,此后赴斯坦福深造。2022年,宋飏獲斯坦福計算機科學博士學位,而后加入OpenAI。

在博士期間,他的一作論文“Score-Based Generative Modeling through Stochastic Differential Equations”還獲得過ICLR 2021的杰出論文獎。

根據其個人主頁信息,從2024年1月開始,宋飏將正式加入加州理工學院電子系和計算數學科學系,擔任助理教授。

項目地址:

???https://github.com/openai/consistency_models??

論文地址:

???https://arxiv.org/abs/2303.01469??

參考鏈接:

[1]https://twitter.com/alfredplpl/status/1646217811898011648

[2]https://twitter.com/_akhaliq/status/1646168119658831874?