大語言模型擊敗擴散模型!視頻圖像生成雙SOTA,谷歌CMU最新研究,一作北大校友

語言模型擊敗擴散模型,在視頻和圖像生成上實現雙SOTA!

這是來自谷歌CMU最新研究成果。

據介紹,這是語言模型第一次在標志性的ImageNet基準上擊敗擴散模型。

而背后的關鍵組件在于視覺分詞器(video tokenizer) ,它能將像素空間輸入映射為適合LLM學習的token。

谷歌CMU研究團隊提出了MAGVIT-v2,在另外兩項任務中超越了之前最優視覺分詞器。

大語言模型擊敗擴散模型

已經形成共識的是,大語言模型在各個生成領域都有出色的表現。比如文本、音頻、代碼生成等。

但一直以來在視覺生成方面,語言模型卻落后于擴散模型。

團隊認為,其主要原因在于缺乏一個好的視覺表示,類似于自研語言系統,能有效地對視覺世界進行建模。與自然語言不同,人類會對視覺世界尚未演化出最佳的詞匯。而這也限制了大語言模型的視覺生成能力。

基于這樣的判斷,這篇研究主要完成了三項工作:

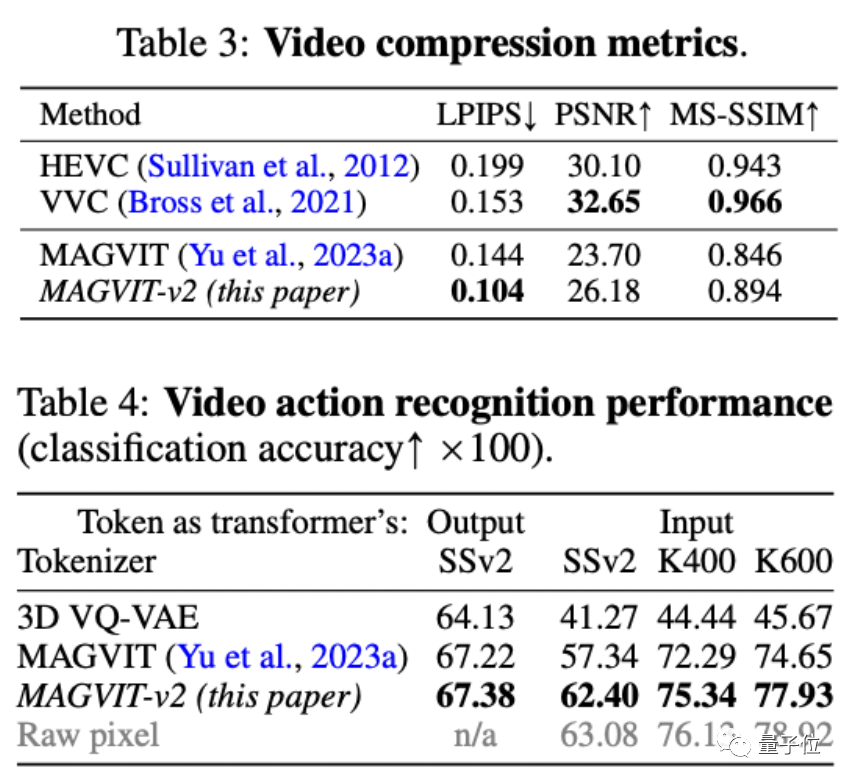

- 提出一種新的視覺tokenizer,在視覺生成、視頻壓縮以及動作識別都優于此前最優表現。

- 一種全新無查找(lookup-free)的量化方法,可通過學習大量詞匯來提高語言模型的視覺生成質量;

- 首次有證據表明,在相同訓練數據、等效模型大小和類似訓練預算的條件下,語言模型在ImageNet上擊敗擴散模型。

據作者介紹,這也是視覺分詞器首次成功地實現了與標準編解碼器相媲美的效果。

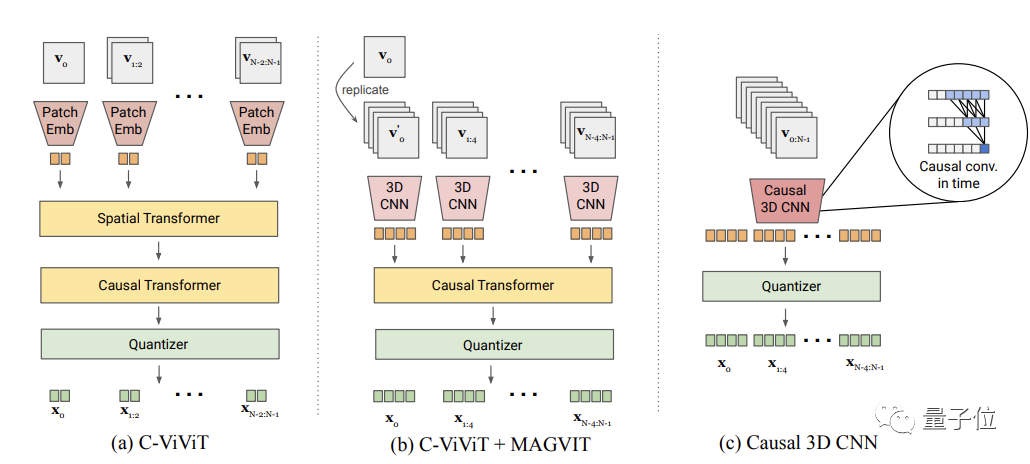

在原有SOTA視覺tokenizerMAGVIT (Masked Generative Video Transformer)基礎上,該方法主要完成了兩種設計:無查找量化(Lookup-Free Quantization ,LFQ)以及圖像-視頻聯合tokenizer。

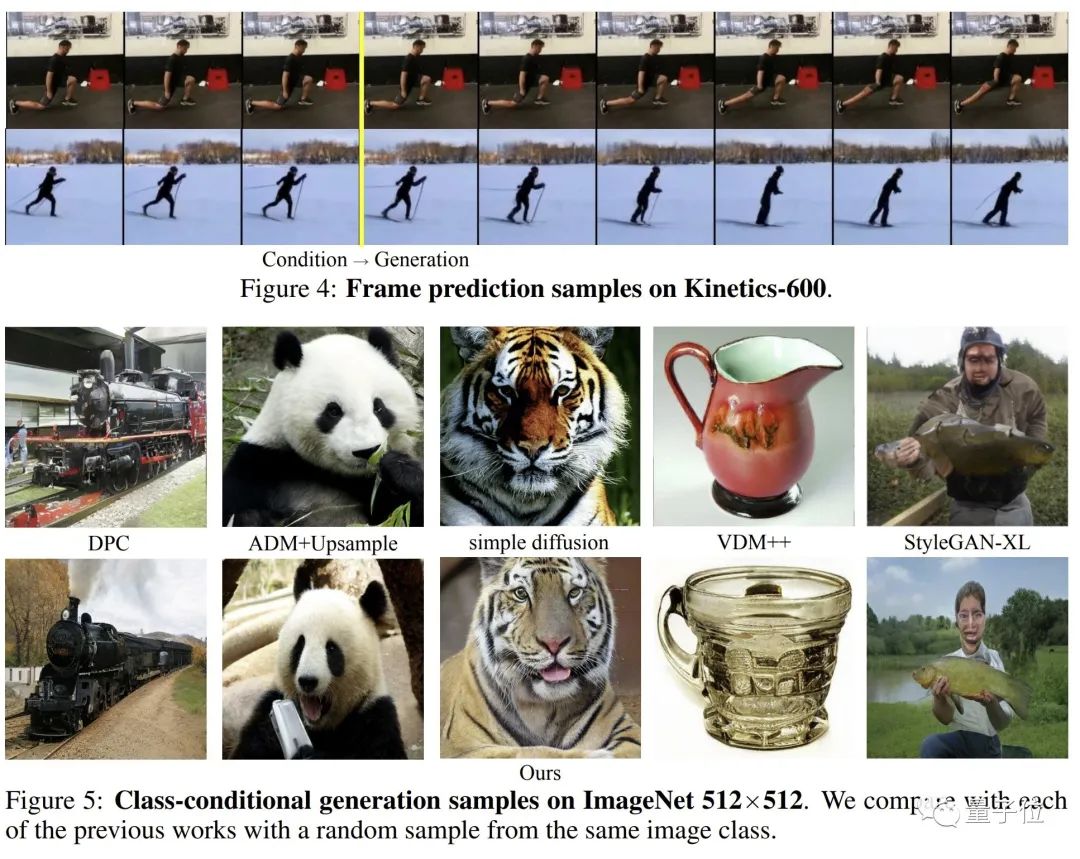

最終在視頻/圖像生成,ImageNet 512×512和Kinetics-600,都優于Diffusion Model。

而在視頻壓縮、動作識別上,也優于以往的結果。

一作是北大校友

一作于力軍目前是CMU計算機科學學院語言技術研究所博士生,師從Alexander G. Hauptmann教授,同時也是谷歌學生研究員。研究興趣在于多模態基礎模型,特別是多任務視頻生成。

在來到CMU前,他在北大獲得了計算機和經濟學雙學士學位。

在研究團隊中也看到了其他不少華人面孔。

通訊作者蔣路,目前是谷歌研究院科學家以及CMU的兼職教授。

他的研究主要針對多模態大數據科領域,特別是魯棒深度學習、生成式人工智能和多模態基礎模型。

論文鏈接:

https://arxiv.org/abs/2310.05737

https://magvit.cs.cmu.edu/v2/