無創解碼大腦信號語義,中科院自動化所研發腦-圖-文多模態學習模型

- 論文地址:https://ieeexplore.ieee.org/document/10089190

- 代碼地址:https://github.com/ChangdeDu/BraVL

- 數據地址:https://figshare.com/articles/dataset/BraVL/17024591

太長不看版

這項研究首次將大腦、視覺和語言知識相結合,通過多模態學習的方式,實現了從人類腦活動記錄中零樣本地解碼視覺新類別。本文還貢獻了三個「腦 - 圖 - 文」三模態匹配數據集。

實驗結果表明了一些有趣的結論和認知洞見:1)從人類腦活動中解碼新的視覺類別是可以實現的,并且精度較高;2)使用視覺和語言特征的組合的解碼模型比僅使用其中之一的模型表現更好;3)視覺感知可能伴隨著語言影響來表示視覺刺激的語義。這些發現不僅對人類視覺系統的理解有所啟示,而且也為將來的腦機接口技術提供了新的思路。本研究的代碼和數據集均已開源。

研究背景

解碼人類視覺神經表征是一個具有重要科學意義的挑戰,可以揭示視覺處理機制并促進腦科學與人工智能的發展。然而,目前的神經解碼方法難以泛化到訓練數據以外的新類別上,主要原因有兩個:一是現有方法未充分利用神經數據背后的多模態語義知識,二是現有的可利用的配對(刺激 - 腦響應)訓練數據很少。

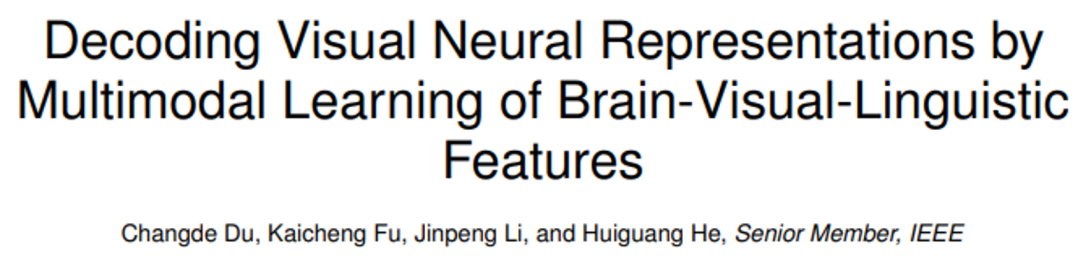

研究表明,人類對視覺刺激的感知和識別受到視覺特征和人們先前經驗的影響。例如當我們看到一個熟悉的物體時,我們的大腦會自然而然地檢索與該物體相關的知識。如下圖 1 所示,認知神經科學對雙重編碼理論 [9] 的研究認為,具體概念在大腦中既以視覺方式又以語言方式進行編碼,其中語言作為有效的先驗經驗,有助于塑造由視覺生成的表征。

因此,作者認為想要更好地解碼記錄到的腦信號,不僅應該使用實際呈現的視覺語義特征,還應該包括與該視覺目標對象相關的更豐富的語言語義特征的組合來進行解碼。

圖 1. 人類大腦中的知識雙重編碼。當我們看到大象的圖片時,會自然地在腦海中檢索到大象的相關知識(如長長的鼻子、長長的牙齒、大大耳朵等)。此時,大象的概念會在大腦中以視覺和語言的形式進行編碼,其中語言作為一種有效的先前經驗,有助于塑造由視覺產生的表征。

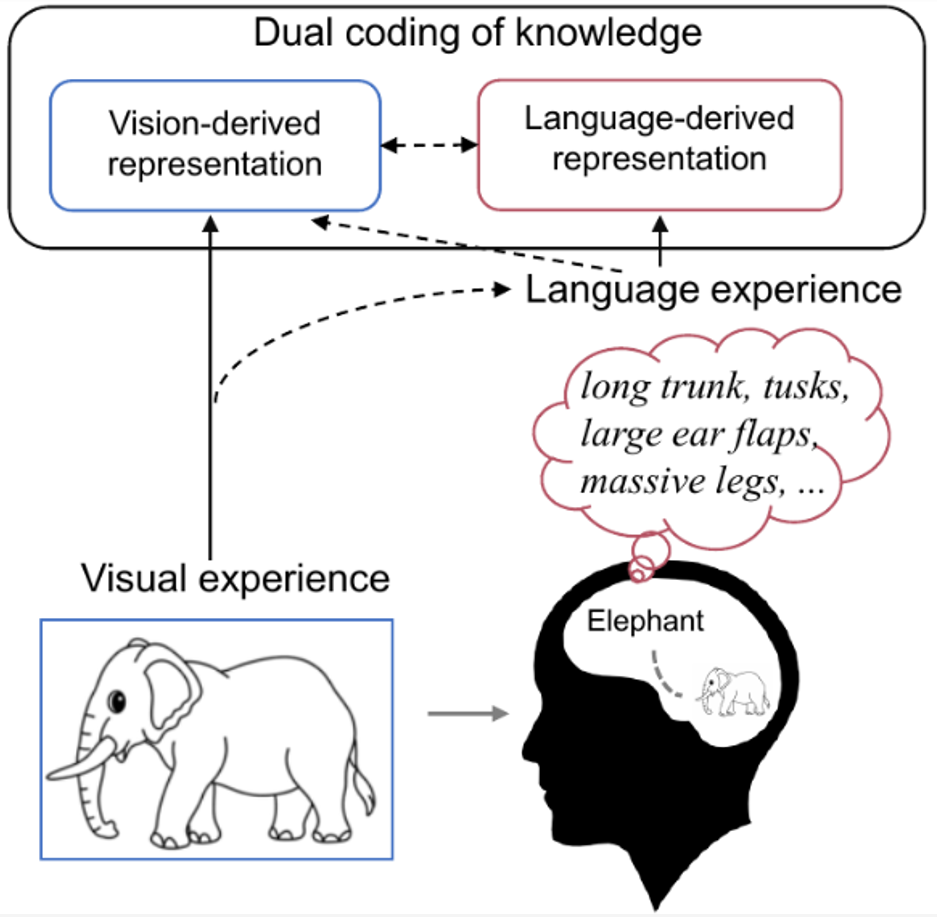

如下圖 2 所示,由于收集各種視覺類別的人腦活動非常昂貴,通常研究者只有非常有限的視覺類別的腦活動。然而,圖像和文本數據卻非常豐富,它們也可以提供額外的有用信息。本文的方法可以充分利用所有類型的數據(三模態、雙模態和單模態)來提高神經解碼的泛化能力。

圖 2. 圖像刺激、引發的大腦活動以及它們相應的文本數據。我們只能為少數類別收集大腦活動數據,但是可以很容易地收集幾乎所有類別的圖像和 / 或文本數據。因此,對于已知類別,我們假設大腦活動、視覺圖像和相應的文本描述都可用于訓練,而對于新類別,僅視覺圖像和文本描述可用于訓練。測試數據是來自新類別的大腦活動數據。

「腦 - 圖 - 文」多模態學習

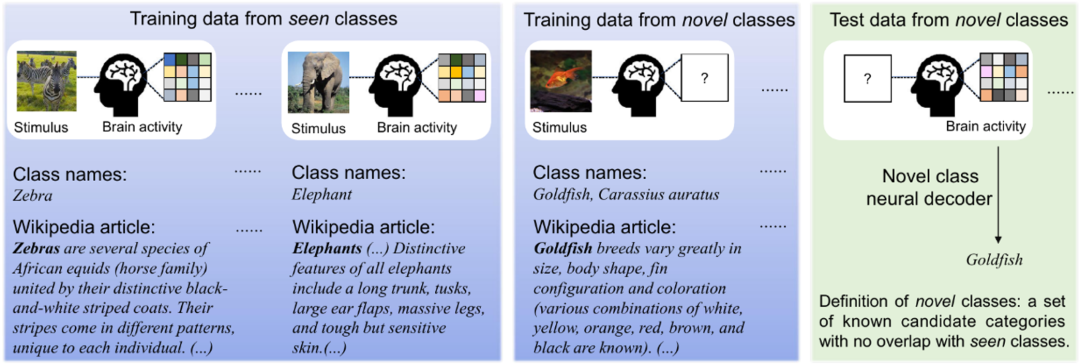

如下圖 3A 所示,本文方法的關鍵在于將每種模態學習到的分布對齊到一個共享的潛在空間中,該空間包含與新類別相關的基本多模態信息。

具體地說,作者提出了一種多模態自編碼變分貝葉斯學習框架,其中使用了專家混合相乘模型(Mixture-of-Products-of-Experts,MoPoE),推斷出一種潛在編碼,以實現所有三種模態的聯合生成。為了學習更相關的聯合表示,并在腦活動數據有限的情況下提高數據效率,作者還進一步引入了模態內和模態間的互信息正則化項。此外,BraVL 模型可以在各種半監督學習場景下進行訓練,以納入額外的大規模圖像類別的視覺和文本特征。

在圖 3B 中,作者從新類別的視覺和文本特征的潛在表示中訓練 SVM 分類器。需要注意的是,在這一步中編碼器 E_v 和 E_t 被凍結,只有 SVM 分類器(灰色模塊)會被優化。

在應用中,如圖 3C 所示,本文方法的輸入僅為新類別腦信號,不需要其他數據,因此可以輕松應用于大多數神經解碼場景。SVM 分類器之所以能夠從(B)推廣到(C),是因為這三種模態的潛在表示已經在 A 中對齊。

圖 3 本文提出的 “腦 - 圖 - 文” 三模態聯合學習框架,簡稱 BraVL。

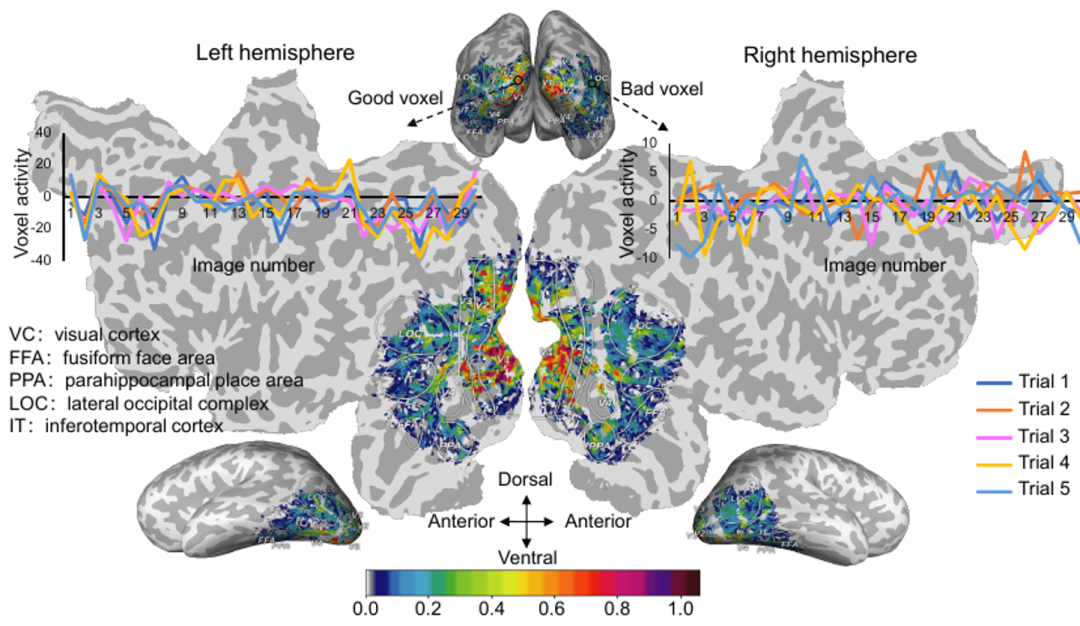

此外,腦信號會因試次(trial)的不同而發生變化,即使是相同的視覺刺激也是如此。為了提高神經解碼的穩定性,作者使用了穩定性選擇方法來處理 fMRI 數據。所有體素的穩定性分數如下圖 4 所示,作者選取穩定性最好的前 15% 體素參與神經解碼過程。這種操作可以有效地降低 fMRI 數據的維度,并抑制噪聲體素引起的干擾,而不會嚴重影響腦特征的判別能力。

圖 4. 大腦視覺皮層的體素活動穩定性分數映射圖。

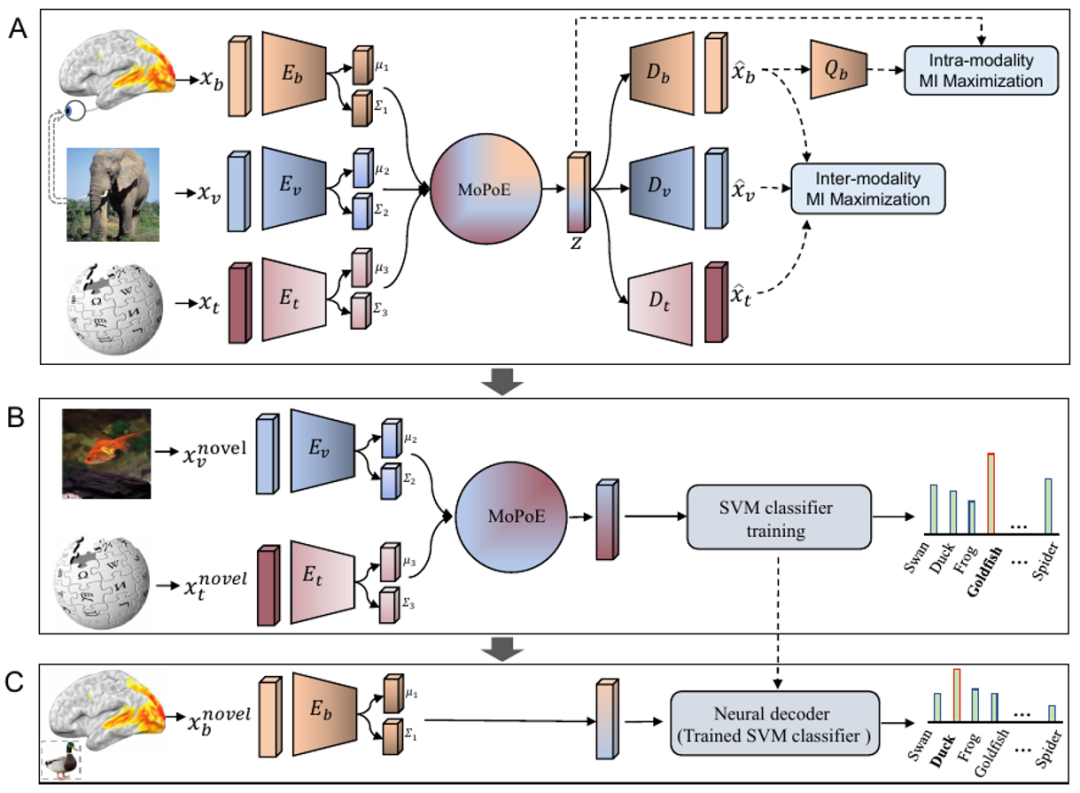

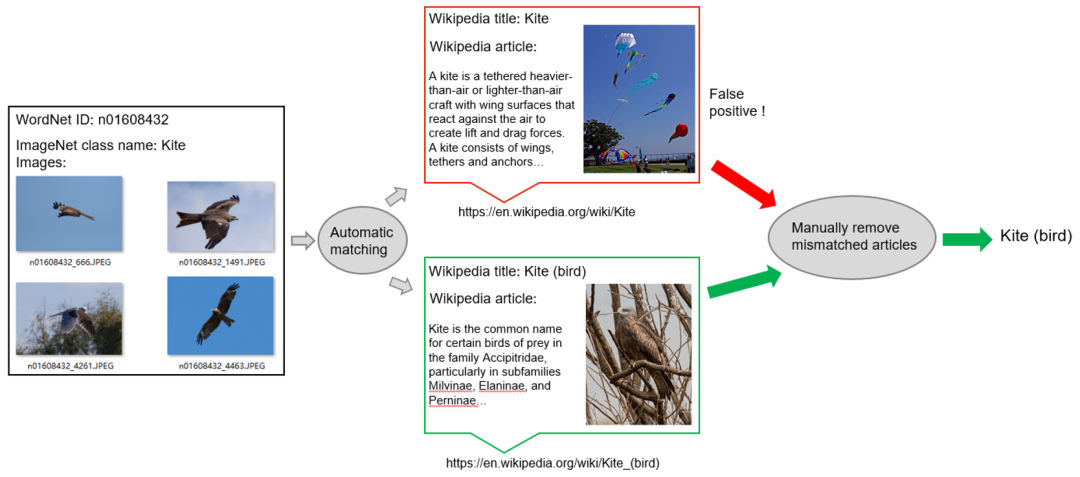

現有的神經編解碼數據集往往只有圖像刺激和腦響應。為了獲取視覺概念對應的語言描述,作者采用了一種半自動的維基百科文章抽取方法。

具體來說,作者首先創建 ImageNet 類與其對應的維基百科頁面的自動匹配,匹配是基于 ImageNet 類和維基百科標題的同義詞集單詞之間的相似性,以及它們的父類別。如下圖 5 所示,遺憾的是,這種匹配偶爾會產生假陽性,因為名稱相似的類可能表示非常不同的概念。在構建三模態數據集時,為了確保視覺特征和語言特征之間的高質量匹配,作者手動刪除了不匹配的文章。

圖 5. 半自動視覺概念描述獲取

實驗結果

作者在多個「腦 - 圖 - 文」三模態匹配數據集上進行了廣泛的零樣本神經解碼實驗,實驗結果如下表所示。可以看到,使用視覺和文本特征組合 (V&T) 的模型比單獨使用它們中的任何一種的模型表現得要好得多。值得注意的是,基于 V&T 特征的 BraVL 在兩個數據集上的平均 top-5 準確率都有顯著提高。這些結果表明,盡管呈現給被試的刺激只包含視覺信息,但可以想象,被試會下意識地調用適當的語言表征,從而影響視覺處理。

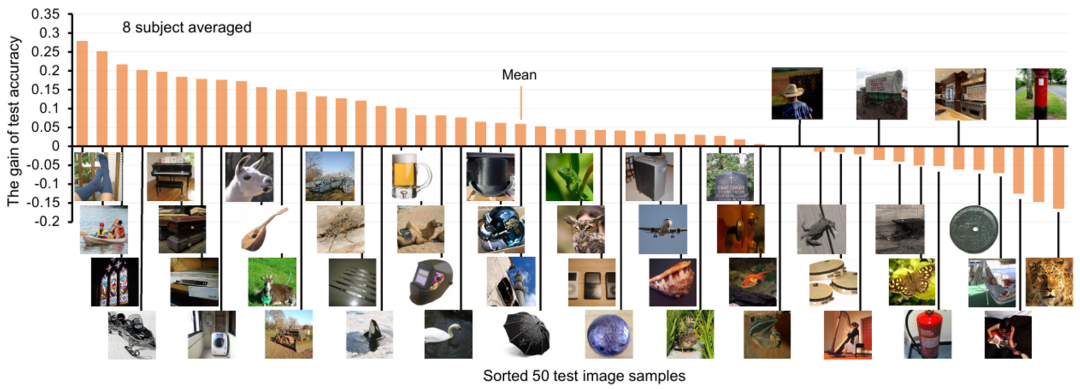

對于每個視覺概念類別,作者還展示了加入文本特征后的神經解碼準確率增益,如下圖 6 所示。可以看到,對于大多數測試類,文本特征的加入都有積極的影響,平均 Top-1 解碼精度提高了約 6%。

圖 6. 加入文本特征后的神經解碼準確率增益

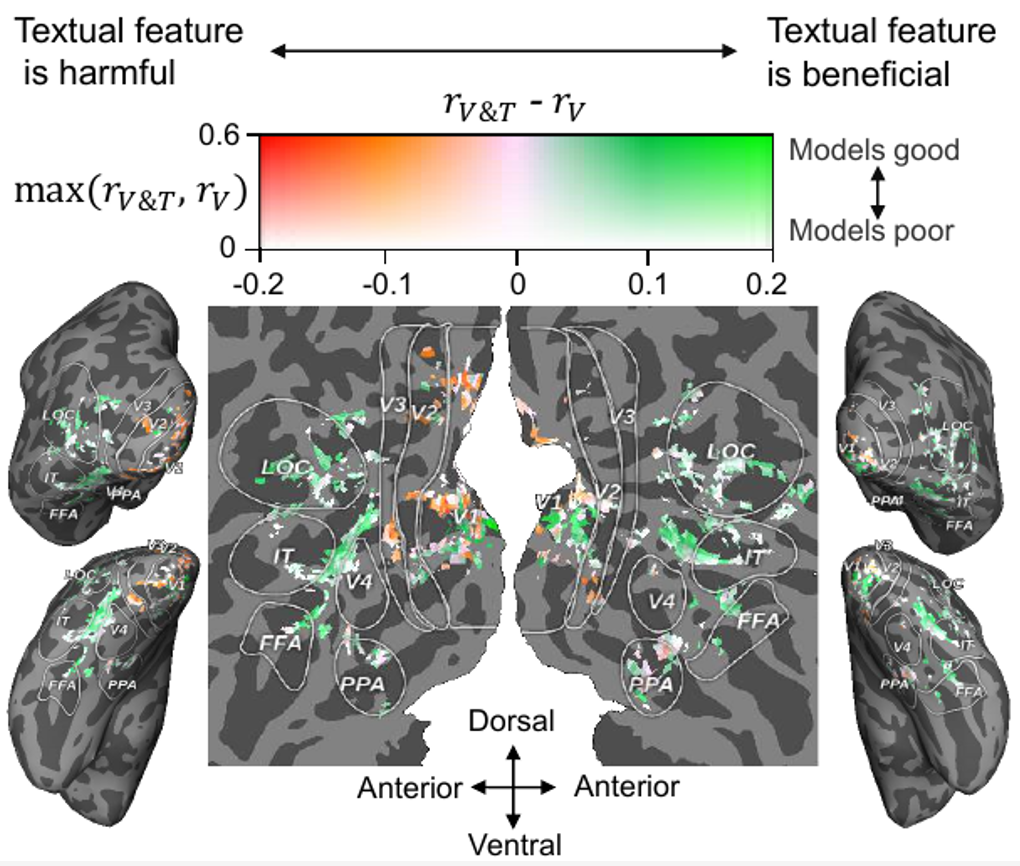

除了神經解碼分析,作者還分析了文本特征在體素級神經編碼方面的貢獻 (基于視覺或文本特征預測相應的腦體素活動),結果如圖 7 所示。可見,對于大多數高級視覺皮層 (HVC,如 FFA, LOC 和 IT),在視覺特征的基礎上融合文本特征可以提高大腦活動的預測精度,而對于大多數低級視覺皮層 (LVC,如 V1, V2 和 V3),融合文本特征是沒有好處的,甚至是有害的。

從認知神經科學的角度來看,我們的結果是合理的,因為一般認為 HVC 負責處理物體的類別信息、運動信息等更高層次的語義信息,而 LVC 負責處理方向、輪廓等底層信息。此外,最近的一項神經科學研究發現,視覺和語言語義表示在人類視覺皮層的邊界上對齊 (即「語義對齊假說」)[10],作者的實驗結果也支持這一假說

圖 7. 將文本特征貢獻投影到視覺皮層

更多實驗結果請參見原文。

總體上,本文得出了一些有趣的結論和認知洞見:1)從人類腦活動中解碼新的視覺類別是可以實現的,并且精度較高;2)使用視覺和語言特征組合的解碼模型比單獨使用兩者中的任何一種的解碼模型的性能要好得多;3)視覺感知可能伴隨著語言影響來表示視覺刺激的語義;4) 使用自然語言作為概念描述比使用類名具有更高的神經解碼性能;5) 單模態和雙模態的額外數據均能顯著提高解碼精度。

討論與展望

論文第一作者、中科院自動化所特別研究助理杜長德表示:「此工作證實了從大腦活動、視覺圖像和文本描述中提取的特征對于解碼神經信號是有效的。然而,提取的視覺特征可能無法準確反映人類視覺處理的所有階段,更好的特征集將有助于這些任務的完成。例如,可以使用更大的預訓練語言模型(如 GPT-3),來提取更具有零樣本泛化能力的文本特征。此外,盡管維基百科文章包含豐富的視覺信息,但這些信息很容易被大量的非視覺句子所掩蓋。通過視覺句子提取或者使用 ChatGPT 和 GPT-4 等模型收集更準確和豐富的視覺描述可以解決這個問題。最后,與相關研究相比,雖然本研究使用了相對較多的三模態數據,但更大更多樣化的數據集會更有益。這些方面我們留待未來的研究。」

論文通訊作者、中科院自動化所何暉光研究員指出:「本文提出的方法有三個潛在的應用:1)作為一種神經語義解碼工具,此方法將在新型讀取人腦語義信息的神經假肢設備的開發中發揮重要作用。雖然這種應用還不成熟,但本文的方法為其提供了技術基礎。2)通過跨模態推斷腦活動,本文方法還可以用作神經編碼工具,用于研究視覺和語言特征如何在人類大腦皮層上表達,揭示哪些腦區具有多模態屬性(即對視覺和語言特征敏感)。3)AI 模型內部表征的神經可解碼性可以被視為該模型的類腦水平指標。因此,本文的方法也可以用作類腦特性評估工具,測試哪個模型的(視覺或語言)表征更接近于人類腦活動,從而激勵研究人員設計更類腦的計算模型。」

神經信息編解碼是腦機接口領域的核心問題,也是探索人腦復雜功能背后的原理從而促進類腦智能發展的有效途徑。自動化所神經計算與腦機交互研究團隊已在該領域持續深耕多年,做出了一系列研究工作,發表在 TPAMI 2023、TMI2023、TNNLS 2022/2019、TMM 2021、Info. Fusion 2021, AAAI 2020 等。前期工作被 MIT Technology Review 頭條報道,并獲得 ICME 2019 Best Paper Runner-up Award。

該研究得到了科技創新 2030—“新一代人工智能” 重大項目、基金委項目、自動化所 2035 項目以及中國人工智能學會 - 華為 MindSpore 學術獎勵基金及智能基座等項目的支持。

作者簡介

第一作者:杜長德,中科院自動化所特別研究助理,從事腦認知與人工智能方面的研究,在視覺神經信息編解碼、多模態神經計算等方面發表論文 40 余篇,包括 TPAMI/TNNLS/AAAI/KDD/ACMMM 等。曾獲得 2019 年 IEEE ICME Best Paper Runner-up Award、2021 年 AI 華人新星百強。先后承擔科技部、基金委、中科院的多項科研任務,研究成果被 MIT Technology Review 頭條報道。

個人主頁:https://changdedu.github.io/

通訊作者:何暉光,中科院自動化所研究員,博導,中國科學院大學崗位教授,上海科技大學特聘教授,中科院青促會優秀會員,建國七十周年紀念章獲得者。先后承擔 7 項國家自然基金(含基金重點和國際合作重點)、2 項 863、國家重點研究計劃課題等項目。曾獲得國家科技進步二等獎兩項(分別排名第二、第三)、北京市科技進步獎兩項、教育部科技進步一等獎、中科院首屆優秀博士論文獎、北京市科技新星、中科院 “盧嘉錫青年人才獎”、福建省 “閩江學者” 講座教授。其研究領域為人工智能、腦 - 機接口、醫學影像分析等。近五年來,在 IEEE TPAMI/TNNLS、ICML 等期刊和會議上發表文章 80 余篇。他是 IEEEE TCDS、《自動化學報》等期刊編委,CCF 杰出會員,CSIG 杰出會員。