Diffusion反饋強勢助力CLIP秒變火眼金睛!北京智源&中科院自動化所

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

- 作者:王文軒(中科院自動化所-智源研究院聯培博一研究生),孫泉(智源研究院視覺模型研究中心算法研究員),張帆(智源研究院視覺模型研究中心算法研究員),唐業鵬(北交博一研究生),劉靜(中科院自動化所研究員),王鑫龍(智源研究院視覺模型研究中心負責人)

- 單位:中科院自動化所,中國科學院大學,北京智源人工智能研究院,北京交通大學

- 論文鏈接:https://arxiv.org/abs/2407.20171

- 項目主頁:https://rubics-xuan.github.io/DIVA/

- 相關代碼鏈接:https://github.com/baaivision/DIVA

動機何在?——CLIP視覺缺陷

對比語言-圖像預訓練(CLIP)在跨領域和跨模態的開放世界表示方面表現出色,已成為各種視覺和多模態任務的基礎。

自從CLIP被提出以來,近年來涌現了許多關于CLIP模型的后續研究。這些研究通過預訓練和微調CLIP模型,取得了性能提升并開發了新的能力。然而,這些方法仍然存在不可避免的局限性,因為它們高度依賴于圖像-文本數據對,無法僅在圖像數據上實現預期效果。

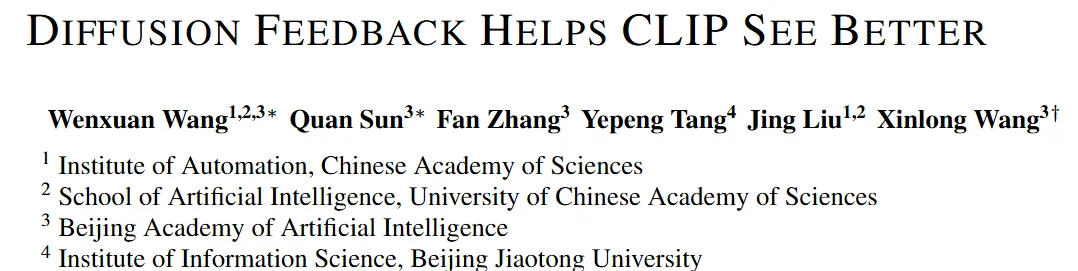

此外,最近的不少研究指出,盡管CLIP在零樣本任務中表現出色,但由于對比學習范式和訓練中使用的噪聲圖像-文本對,其在感知理解方面存在一些局限性。這些局限性包括難以準確理解長文本和難以辨別相似圖像中的細微差異。雖然一些研究試圖解決長文本理解問題,但改善CLIP的細粒度視覺感知能力的研究仍然不足。感知視覺細節的能力對于基礎模型至關重要,而CLIP在這方面的不足直接影響了以CLIP作為視覺編碼器的視覺和多模態模型的表現。

因此,在這項工作中,我們專注于通過自監督學習范式解決CLIP無法區分細粒度視覺細節的問題。基于文本到圖像的擴散模型能夠生成具有豐富細節逼真圖像的先驗,我們探索了利用擴散模型的生成反饋來優化CLIP表征的潛力。

如何解決?——Diffusion Feedback來優化CLIP視覺細節表征

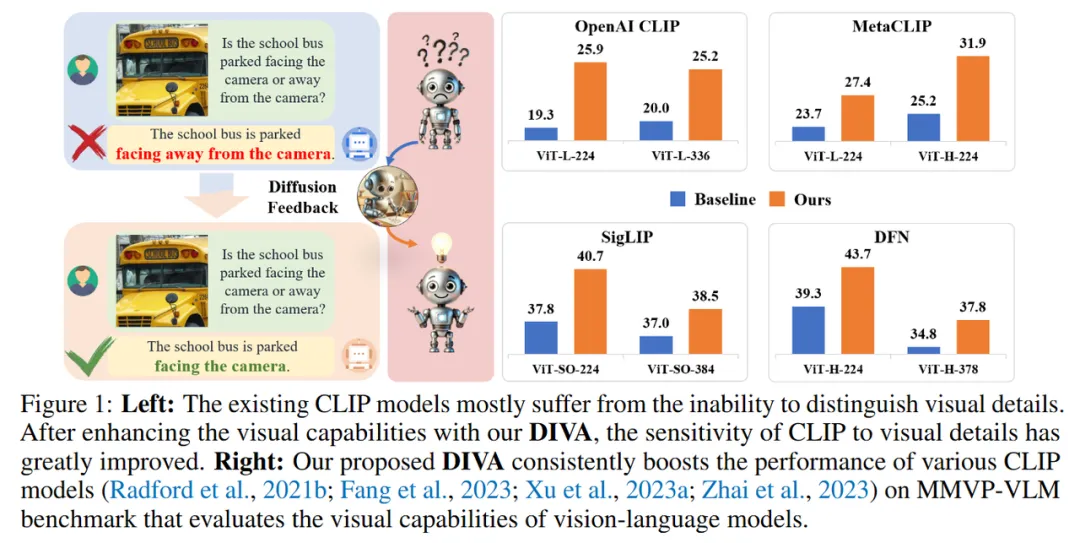

我們提出了一種簡單的CLIP模型后訓練方法,通過自監督擴散過程在很大程度上克服了其視覺缺陷。通過使用CLIP的密集視覺特征對擴散模型進行條件化,并將重建損失應用于CLIP優化,我們將擴散模型作為CLIP的視覺助手,因此我們將該框架命名為DIVA。

具體而言,如圖2所示,DIVA主要由兩個部分組成:一是需要增強視覺感知能力的CLIP模型,二是提供生成反饋的預訓練擴散模型。輸入原始圖像和空文本(圖2中標記為'Null')后,CLIP模型會編碼相應的視覺特征,這些特征將與來自擴散模型文本編碼器的空文本嵌入結合,為擴散過程提供條件。對于添加了噪聲的圖像,擴散模型嘗試在上述條件下預測從前一步到當前步驟中添加的噪聲。在訓練過程中,除了CLIP模型外,所有部分的權重都保持不變,訓練目標只是最小化重建損失(即擴散反饋指導)。通過這種方式,通過約束擴散模型更準確地預測添加的噪聲,CLIP的原始語義豐富的判別表示將通過擴散反饋逐漸優化為包含更多視覺細節的表示。

此外更有意思的是,DIVA不需要額外的文本標注數據,只需可輕易獲取的純圖片數據就能大幅使得CLIP彌補其視覺感知短板,這一點相比之前方法收集大量圖文數據對的高昂成本是非常難得的!

效果如何?——立竿見影!

為了評估DIVA的有效性并展示其增強CLIP表示的潛力,我們在多模態理解和視覺感知任務上進行了全面的實驗。

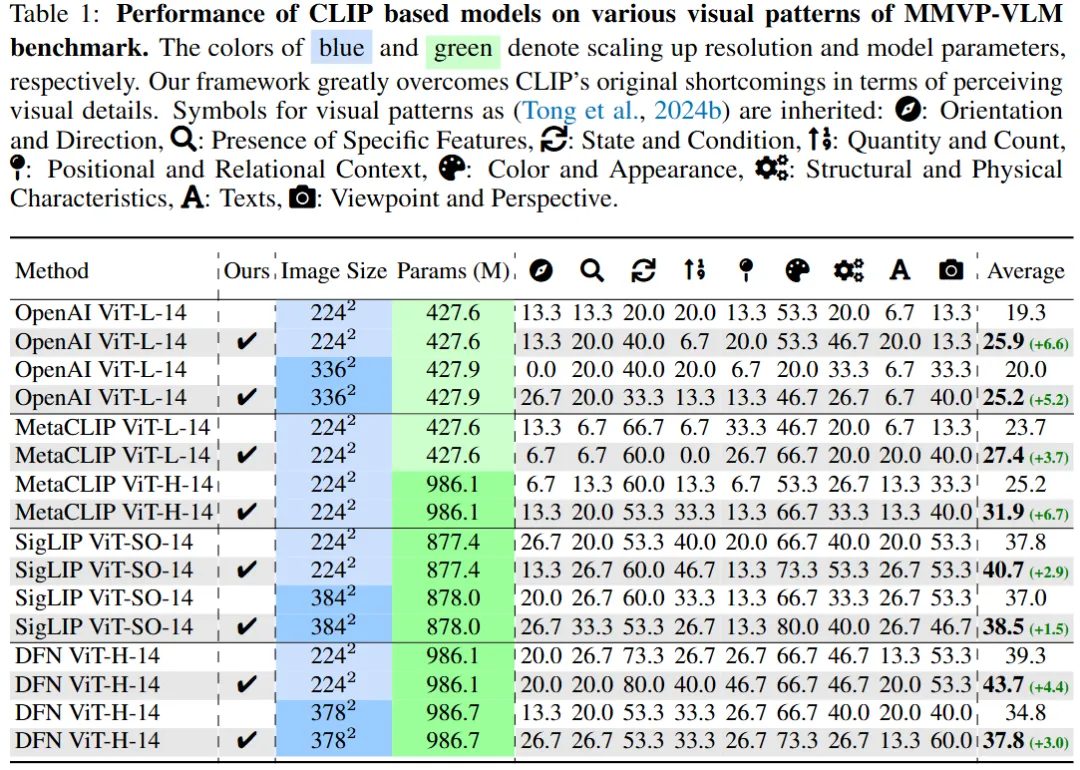

視覺細粒度感知方面

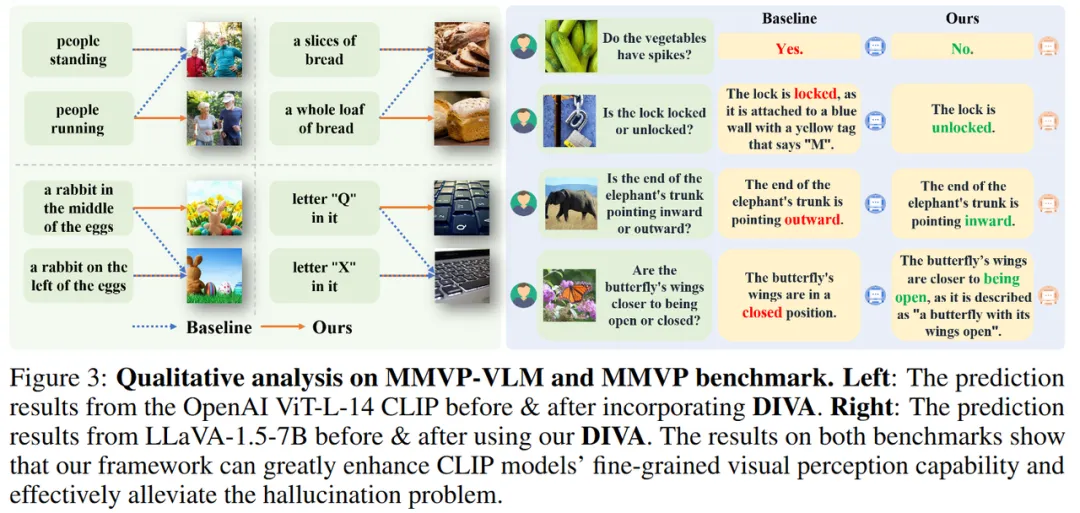

為了驗證DIVA能夠有效緩解CLIP模型固有的視覺能力不足,我們首先在各種現有的CLIP模型上進行了實驗。DIVA在評估視覺-語言模型視覺能力的MMVP-VLM基準測試中使得現有的多個CLIP模型的性能取得了顯著的提升(提高了3-7%)。

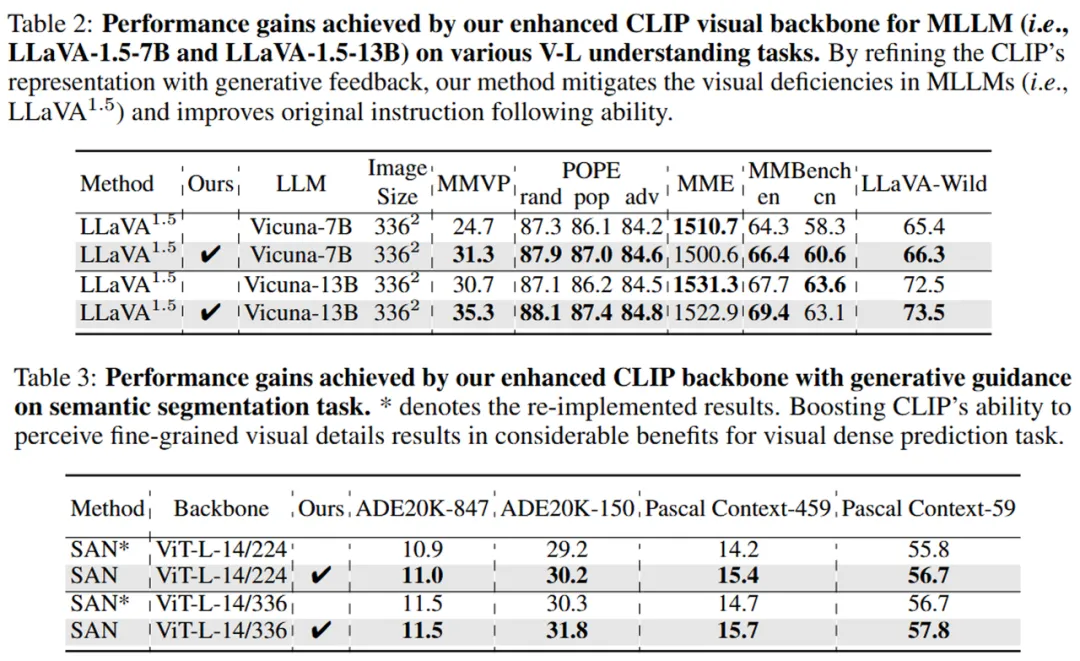

作為更強的視覺骨干網絡為多模態大模型和視覺模型帶來的收益評估

接下來,在DIVA的幫助下,我們進一步評估了增強后的CLIP骨干網絡在多模態理解和視覺感知任務中帶來的性能提升。DIVA的優勢在于它不僅僅能讓CLIP變聰明,還能讓那些基于CLIP的大型多模態語言模型以及視覺模型變得更加厲害。在這些多模態和純視覺的基準測試上準確率的顯著提升,得益于我們DIVA范式通過生成反饋大幅增強了CLIP的視覺感知能力。

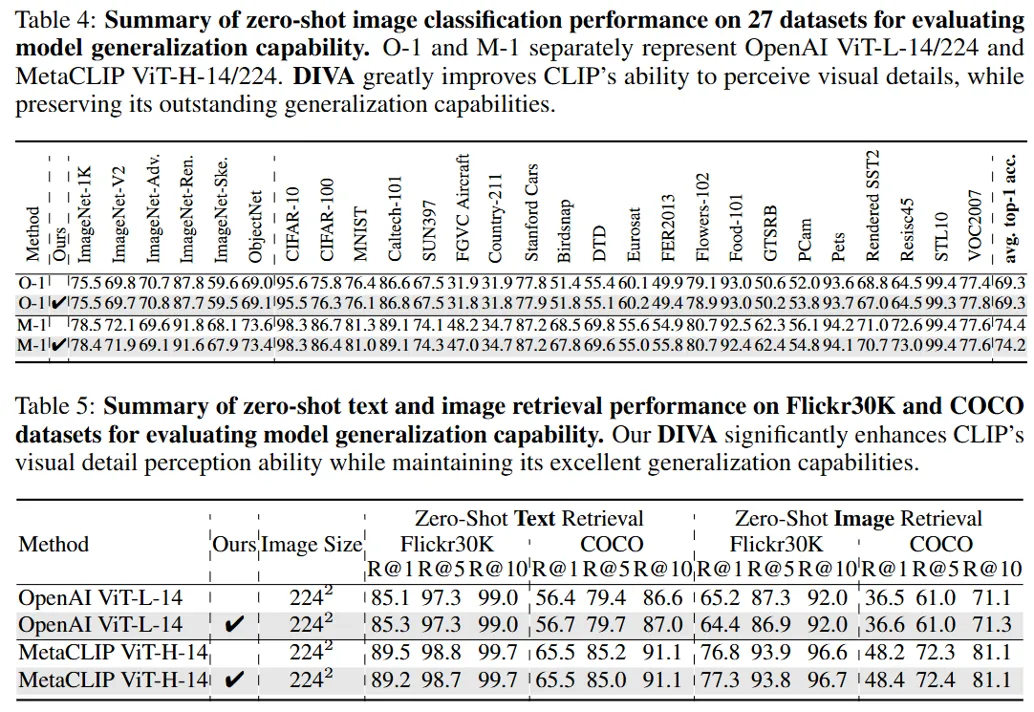

CLIP泛化能力評估

在全面驗證了我們的方法提升CLIP模型細粒度視覺感知能力的效果后,我們進行了CLIP模型原始泛化能力的全面評估。在只由純圖片數據驅動整個框架的前提上,DIVA能夠保持CLIP原本優秀的泛化性能。29個圖片分類和圖文檢索的基準測試上無論是看圖識物還是找圖配字的實驗結果都能證明,經過DIVA優化視覺表征之后的CLIP模型能夠保留CLIP原本優秀的泛化能力。

未來展望?——大有可為!

當前局限

- 數據和模型規模可進一步擴展。

- 由于這篇工作只是該方向的一個開始,目前僅展示了生成擴散模型用于提升CLIP模型表示的潛力,當前主要關注設計一個簡單但有效的框架。

未來可探討的方向

- 可以結合更細粒度的監督方案進一步提升CLIP模型的能力。

- 擴展超越圖像-文本數據的其他模態,如視頻和音頻。

- 發展基于擴散模型的更通用、更強大的框架,以增強視覺-語言基礎模型。