開源 AI 聊天機器人 MLC LLM 發布:本地運行無需聯網,集顯電腦、蘋果 iPhone 也能用

5 月 2 日消息,目前大多數 AI 聊天機器人都需要連接到云端進行處理,即使可以本地運行的也配置要求極高。那么是否有輕量化的、無需聯網的聊天機器人呢?

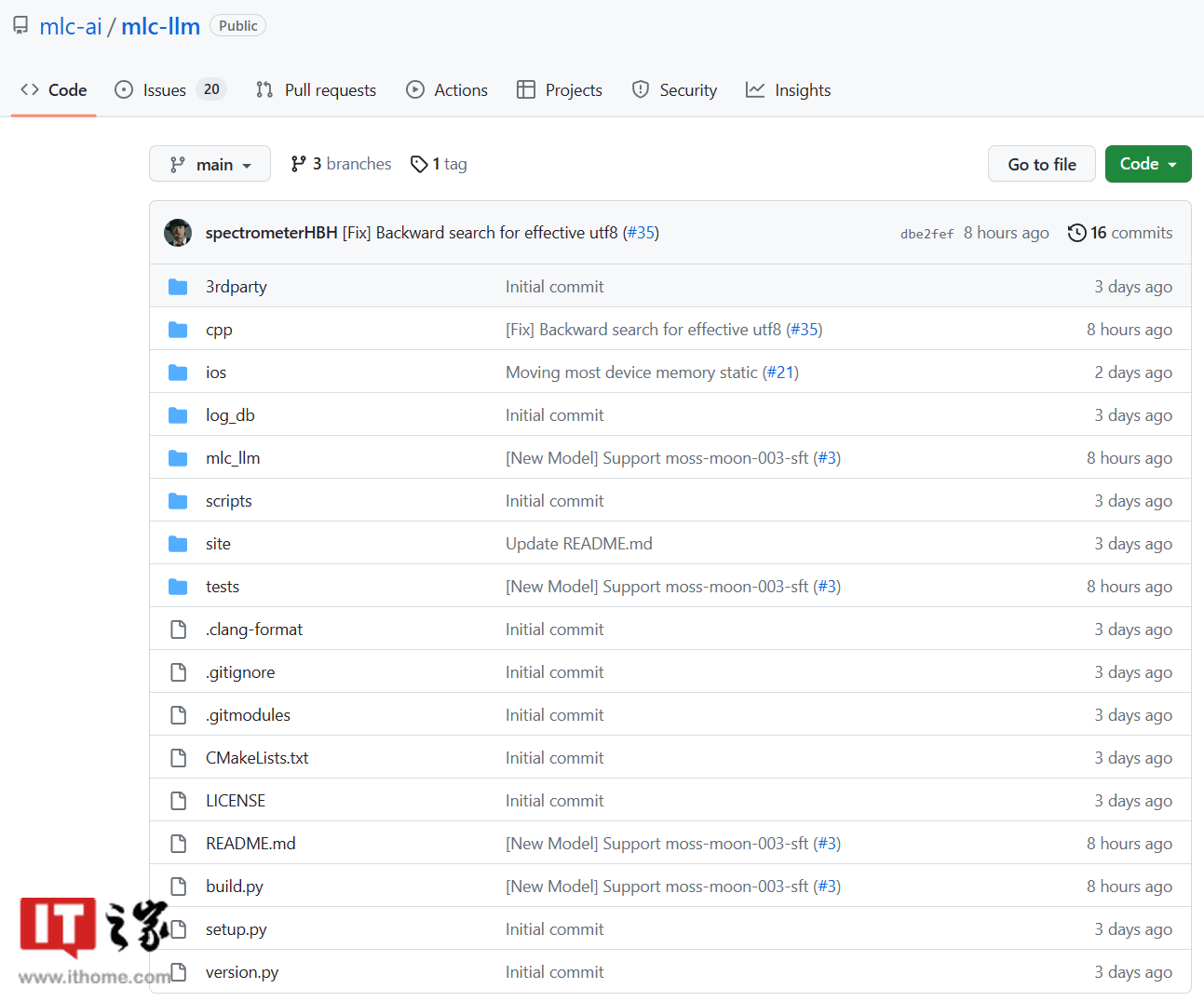

一個名為 MLC LLM 的全新開源項目已在 GitHub 上線,完全本地運行無需聯網,甚至集顯老電腦、蘋果 iPhone 手機都能運行。

MLC LLM 項目介紹稱:“MLC LLM 是一種通用解決方案,它允許將任何語言模型本地部署在一組不同的硬件后端和本地應用程序上,此外還有一個高效的框架,供每個人進一步優化自己用例的模型性能。一切都在本地運行,無需服務器支持,并通過手機和筆記本電腦上的本地 GPU 加速。我們的使命是讓每個人都能在設備上本地開發、優化和部署 AI 模型。”

▲ MLC LLM 項目官方演示

IT之家查詢 GitHub 頁面發現,這個項目的開發者來自卡內基梅隆大學的 Catalyst 計劃、SAMPL 機器學習研究小組以及華盛頓大學、上海交通大學和 OctoML 等。他們還有一個名為 Web LLM

▲ MLC 是 Machine Learning Compilation 的簡稱

MLC LLM 使用了 Vicuna-7B-V1.1,后者是一種基于 Meta 的 LLaMA 的輕量級 LLM,效果雖然不如 GPT3.5 或 GPT4,但在大小方面比較占優勢。

目前,MLC LLM 可用于 Windows、Linux、macOS 和 iOS 平臺,暫時還沒有適用于 Android 的版本。

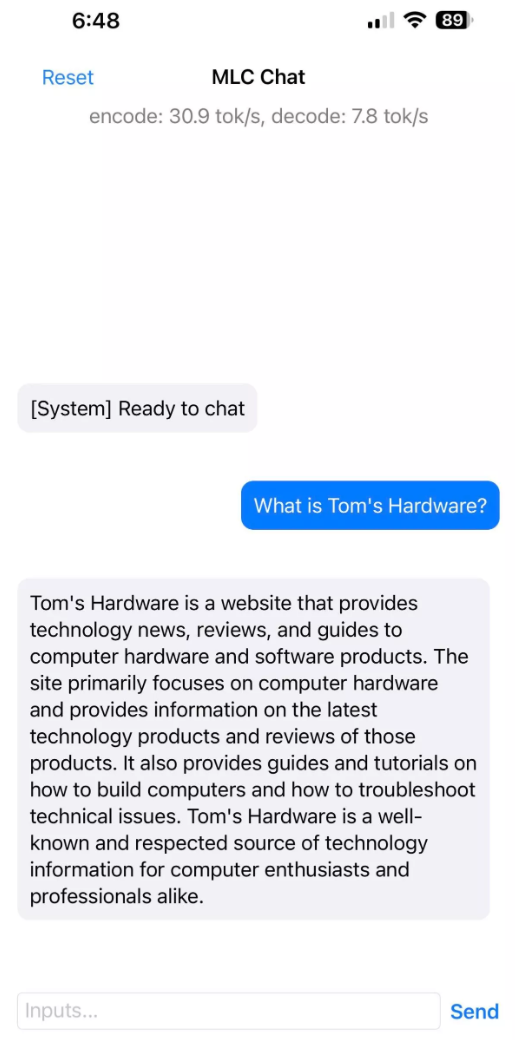

根據外媒 tomshardware 的測試,6GB 內存的蘋果 iPhone 14 Pro Max 和 iPhone 12 Pro Max 手機成功運行了 MLC LLM,安裝大小為 3GB。而 4GB 內存的蘋果 iPhone 11 Pro Max 無法運行 MLC LLM。

▲ 圖源 tomshardware

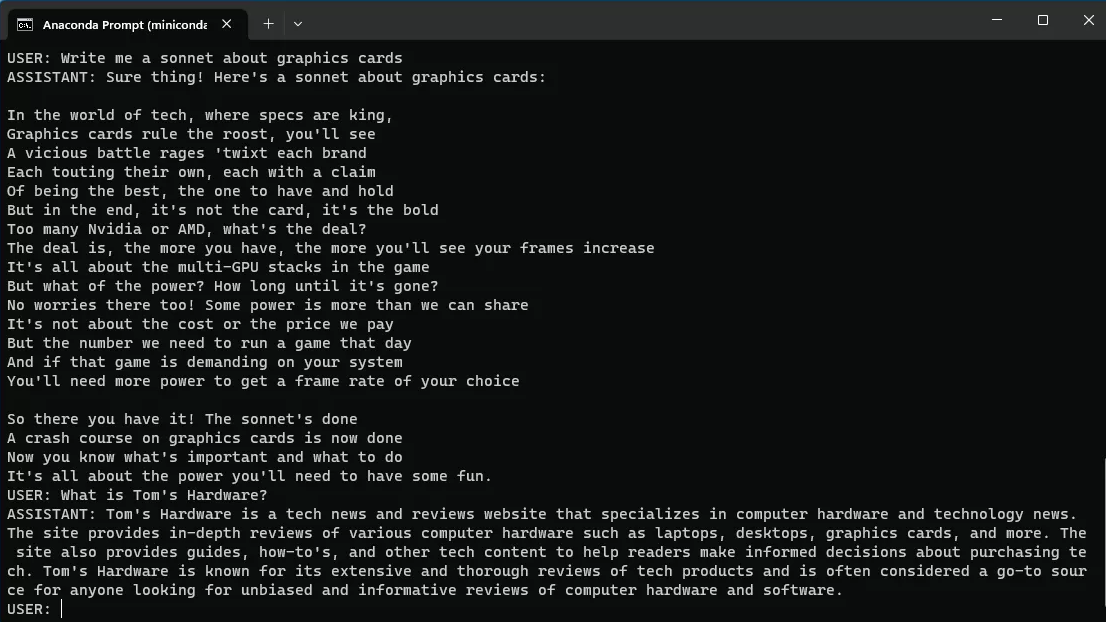

此外,ThinkPad X1 Carbon(第 6 代)也測試成功運行 MLC LLM,這是一款搭載 i7-8550U 處理器的筆記本,沒有獨立顯卡,配有英特爾 UHD 620 GPU。MLC LLM 在 PC 平臺需要通過命令行運行,外媒測試表現一般般,回復時間需要將近 30 秒,而且幾乎沒有連續對話能力,希望能在后續版本中得到改進吧。

▲ 圖源 tomshardware

MLC LLM 的 GitHub 頁面:點此查看