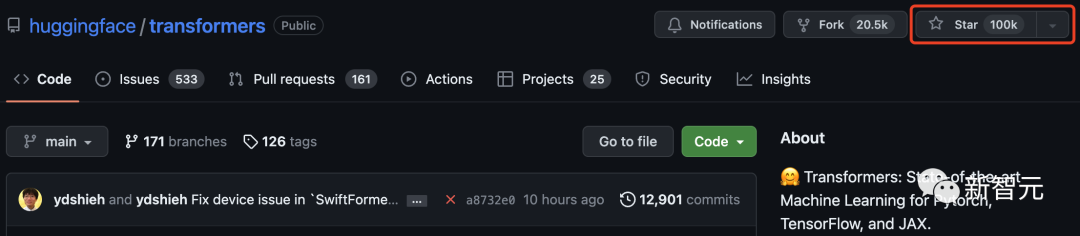

星標(biāo)破10萬!Auto-GPT之后,Transformer越新里程碑

2017年,谷歌團(tuán)隊(duì)在論文「Attention Is All You Need」提出了開創(chuàng)性的NLP架構(gòu)Transformer,自此一路開掛。

多年來,這一架構(gòu)風(fēng)靡微軟、谷歌、Meta等大型科技公司。就連橫掃世界的ChatGPT,也是基于Transformer開發(fā)的。

而就在今天,Transformer在GitHub上星標(biāo)破10萬大關(guān)!

Hugging Face,最初只是一個(gè)聊天機(jī)器人程序,因其作為Transformer模型的中心而聲名鵲起,一舉成為聞名世界的開源社區(qū)。

為了慶祝這一里程碑,Hugging Face也總結(jié)了100個(gè)基于Transformer架構(gòu)搭建的項(xiàng)目。

Transformer引爆機(jī)器學(xué)習(xí)圈

2017年6月,谷歌發(fā)布「Attention Is All You Need」論文時(shí),或許誰也沒有想到這個(gè)深度學(xué)習(xí)架構(gòu)Transformer能夠帶來多少驚喜。

從誕生至今,Transformer已經(jīng)成為AI領(lǐng)域的基石王者。19年,谷歌還專門為其申請(qǐng)了專利。

隨著Transformer在NLP領(lǐng)域占據(jù)了主流地位,還開始了向其他領(lǐng)域的跨界,越來越多的工作也開始嘗試將其引到CV領(lǐng)域。

看到Transformer突破這一里程碑,許多網(wǎng)友甚是激動(dòng)。

「我一直是許多受歡迎的開源項(xiàng)目的貢獻(xiàn)者,但看到Transformer在GitHub上達(dá)到10萬顆星,還是很特別的!」

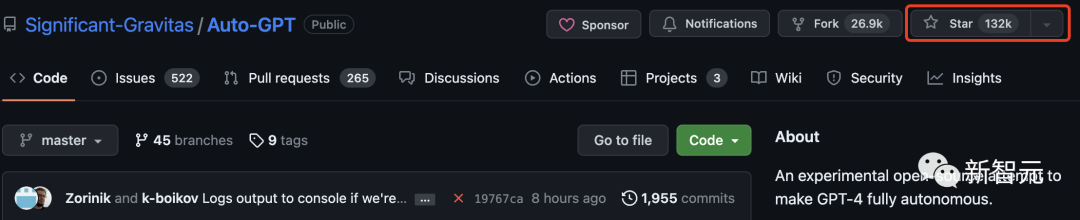

前段時(shí)間Auto-GPT的GitHub星量超過了pytorch引起了很大的轟動(dòng)。

網(wǎng)友不禁好奇Auto-GPT和Transformer相比呢?

其實(shí),Auto-GPT遠(yuǎn)遠(yuǎn)超過了Transformer,已經(jīng)有13萬星。

目前,Tensorflow有17多萬星。可見,Transformer是繼這兩個(gè)項(xiàng)目之后,第三個(gè)星標(biāo)破10萬的機(jī)器學(xué)習(xí)庫(kù)。

還有網(wǎng)友回憶起了最初使用Transformers庫(kù)時(shí),那時(shí)的名字叫「pytorch-pretrained-BERT」。

基于Transformer的50個(gè)超贊項(xiàng)目

Transformers不僅是一個(gè)使用預(yù)訓(xùn)練模型的工具包,它還是一個(gè)圍繞Transformers和Hugging Face Hub構(gòu)建的項(xiàng)目社區(qū)。

在下面列表中,Hugging Face總結(jié)了100個(gè)基于Transformer搭建的讓人驚嘆的新穎項(xiàng)目。

以下,我們節(jié)選了前50個(gè)個(gè)項(xiàng)目進(jìn)行介紹:

gpt4all

gpt4all是一個(gè)開源聊天機(jī)器人生態(tài)系統(tǒng)。它是在大量干凈的助手?jǐn)?shù)據(jù)集合上訓(xùn)練出來的,包括代碼、故事和對(duì)話。它提供開源的大型語言模型,如LLaMA和GPT-J,以助理的方式進(jìn)行訓(xùn)練。

關(guān)鍵詞: 開源,LLaMa,GPT-J,指令,助手

recommenders

這個(gè)存儲(chǔ)庫(kù)包含構(gòu)建推薦系統(tǒng)的示例和最佳實(shí)踐,以Jupiter筆記本形式提供。它涵蓋了建立有效推薦系統(tǒng)所需的幾個(gè)方面: 數(shù)據(jù)準(zhǔn)備、建模、評(píng)估、模型選擇和優(yōu)化,以及操作化。

關(guān)鍵詞:推薦系統(tǒng),AzureML

lama-cleaner

基于Stable Diffusion技術(shù)的圖像修復(fù)工具。可以從圖片中擦出任何你不想要的物體、缺陷、甚至是人,并替換圖片上的任何東西。

關(guān)鍵詞:修補(bǔ),SD,Stable Diffusion

flair

FLAIR是一個(gè)強(qiáng)大的PyTorch自然語言處理框架,可以轉(zhuǎn)換幾個(gè)重要的任務(wù):NER、情感分析、詞性標(biāo)注、文本和對(duì)偶嵌入等。

關(guān)鍵詞:NLP,文本嵌入,文檔嵌入,生物醫(yī)學(xué),NER,PoS,情感分析

mindsdb

MindsDB是一個(gè)低代碼的機(jī)器學(xué)習(xí)平臺(tái)。它將幾個(gè)ML框架作為「AI表」自動(dòng)集成到數(shù)據(jù)棧中,以簡(jiǎn)化AI在應(yīng)用程序中的集成,讓所有技能水平的開發(fā)人員都能使用。

關(guān)鍵詞:數(shù)據(jù)庫(kù),低代碼,AI表

langchain

Langchain旨在協(xié)助開發(fā)兼容 LLM 和其他知識(shí)來源的應(yīng)用程序。該庫(kù)允許對(duì)應(yīng)用程序進(jìn)行鏈?zhǔn)秸{(diào)用,在許多工具中創(chuàng)建一個(gè)序列。

關(guān)鍵詞:LLM,大型語言模型,智能體,鏈

ParlAI

ParlAI是一個(gè)用于分享、訓(xùn)練和測(cè)試對(duì)話模型的python框架,從開放領(lǐng)域的聊天,到面向任務(wù)的對(duì)話,再到可視化問題回答。它在同一個(gè)API下提供了100多個(gè)數(shù)據(jù)集,許多預(yù)訓(xùn)練模型,一組智能體,并有幾個(gè)集成。

關(guān)鍵詞:對(duì)話,聊天機(jī)器人,VQA,數(shù)據(jù)集,智能體

sentence-transformers

這個(gè)框架提供了一種簡(jiǎn)單的方法來計(jì)算句子、段落和圖像的密集向量表示。這些模型基于BERT/RoBERTa/XLM-RoBERTa等Transformer為基礎(chǔ)的網(wǎng)絡(luò),并在各種任務(wù)中取得SOTA。文本嵌入到向量空間中,這樣類似的文本就很接近,可以通過余弦相似度高效找到。

關(guān)鍵詞:密集向量表示,文本嵌入,句子嵌入

ludwig

Ludwig是一個(gè)聲明式的機(jī)器學(xué)習(xí)框架,使用一個(gè)簡(jiǎn)單而靈活的數(shù)據(jù)驅(qū)動(dòng)的配置系統(tǒng),可以輕松定義機(jī)器學(xué)習(xí)pipelines。Ludwig針對(duì)的是各類AI任,提供了一個(gè)數(shù)據(jù)驅(qū)動(dòng)的配置系統(tǒng),訓(xùn)練、預(yù)測(cè)和評(píng)估腳本,以及一個(gè)編程的API。

關(guān)鍵字:聲明式,數(shù)據(jù)驅(qū)動(dòng),ML 框架

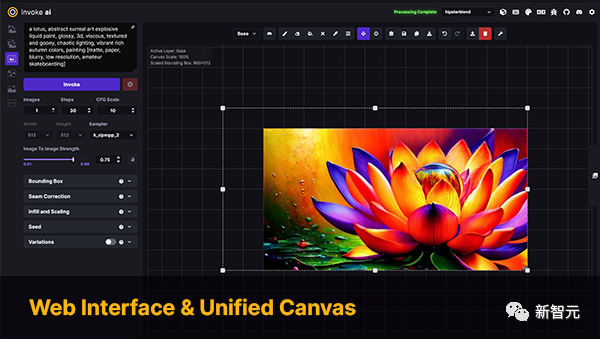

InvokeAI

InvokeAI是Stable Diffusion模型的一個(gè)引擎,面向?qū)I(yè)人士、藝術(shù)家和愛好者。它通過CLI以及WebUI來利用最新的AI驅(qū)動(dòng)技術(shù)。

關(guān)鍵詞:Stable Diffusion,WebUI,CLI

PaddleNLP

PaddleNLP是一個(gè)易于使用且功能強(qiáng)大的NLP庫(kù),特別是針對(duì)中文語言。它支持多個(gè)預(yù)訓(xùn)練的模型動(dòng)物園,并支持從研究到工業(yè)應(yīng)用的廣泛的NLP任務(wù)。

關(guān)鍵詞:自然語言處理,漢語,研究,工業(yè)

stanza

斯坦福大學(xué)NLP小組的官方Python NLP庫(kù)。它支持在60多種語言上運(yùn)行各種精確的自然語言處理工具,并支持從Python訪問Java Stanford CoreNLP軟件。

關(guān)鍵詞:NLP,多語言,CoreNLP

DeepPavlov

DeepPavlov是一個(gè)開源的對(duì)話式人工智能庫(kù)。它被設(shè)計(jì)用于開發(fā)可生產(chǎn)的聊天機(jī)器人,和復(fù)雜的對(duì)話系統(tǒng),以及在NLP領(lǐng)域的研究,特別是對(duì)話系統(tǒng)。

關(guān)鍵詞:對(duì)話,聊天機(jī)器人

alpaca-lora

Alpaca-lora包含了使用低秩適應(yīng)(LoRA)重現(xiàn)斯坦福大學(xué)Alpaca結(jié)果的代碼。該資源庫(kù)提供訓(xùn)練(微調(diào))以及生成腳本。

關(guān)鍵詞:LoRA,參數(shù)高效微調(diào)

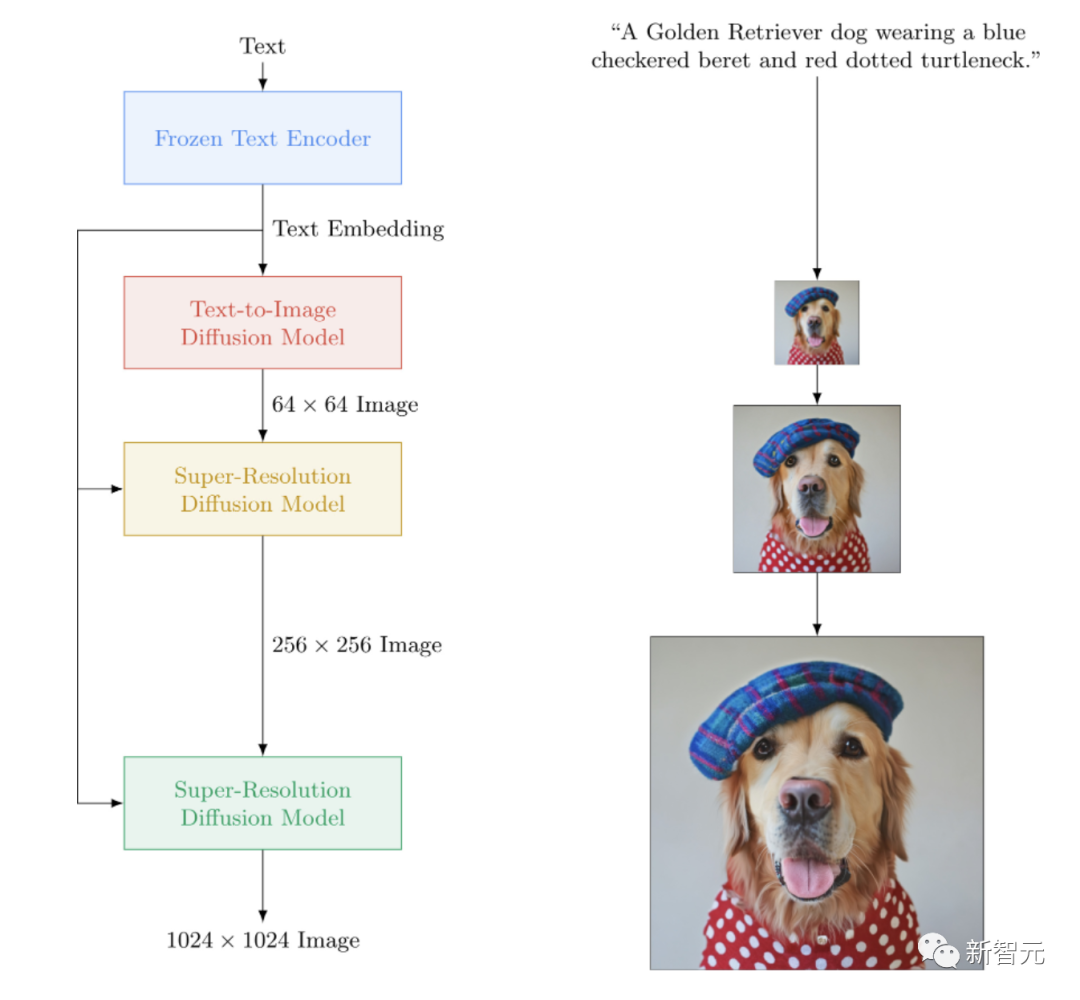

imagen-pytorch

一個(gè)Imagen的開源實(shí)現(xiàn),谷歌的封閉源文本到圖像的神經(jīng)網(wǎng)絡(luò)擊敗了DALL-E2。imagen-pytorch是用于文本到圖像合成的新SOTA。

關(guān)鍵詞:Imagen,文生圖

adapter-transformers

adapter-transformers是Transformers 庫(kù)的一個(gè)擴(kuò)展,通過納入AdapterHub,將適配器集成到最先進(jìn)的語言模型中,AdapterHub是一個(gè)預(yù)訓(xùn)練的適配器模塊的中央存儲(chǔ)庫(kù)。它是Transformers的直接替代品,定期更新以保持與Transformers發(fā)展同步。

關(guān)鍵字:適配器,LoRA,參數(shù)高效微調(diào),Hub

NeMo

NVIDIA NeMo是為從事自動(dòng)語音識(shí)別(ASR)、文本-語音合成(TTS)、大語言模型和自然語言處理的研究人員構(gòu)建的會(huì)話AI工具包。NeMo的主要目標(biāo)是幫助來自工業(yè)界和學(xué)術(shù)界的研究人員重新利用以前的工作(代碼和預(yù)先訓(xùn)練的模型),并使其更容易創(chuàng)建新的項(xiàng)目。

關(guān)鍵詞:對(duì)話,ASR,TTS,LLM,NLP

Runhouse

Runhouse允許用Python將代碼和數(shù)據(jù)發(fā)送到任何計(jì)算機(jī)或數(shù)據(jù)下層,并繼續(xù)從現(xiàn)有代碼和環(huán)境正常地與它們進(jìn)行交互。Runhouse開發(fā)者提到:

可以將它看作 Python 解釋器的擴(kuò)展包,它可以繞道遠(yuǎn)程機(jī)器或操作遠(yuǎn)程數(shù)據(jù)。

關(guān)鍵詞: MLOps,基礎(chǔ)設(shè)施,數(shù)據(jù)存儲(chǔ),建模

MONAI

MONAI是PyTorch生態(tài)系統(tǒng)的一部分,是一個(gè)基于PyTorch的開源框架,用于醫(yī)療成像領(lǐng)域的深度學(xué)習(xí)。它的目標(biāo)是:

- 發(fā)展一個(gè)學(xué)術(shù)、工業(yè)和臨床研究人員的共同基礎(chǔ)上的合作社區(qū);

- 為醫(yī)療成像創(chuàng)建SOTA、端到端訓(xùn)練的工作流程;

- 為深度學(xué)習(xí)模型的建立和評(píng)價(jià)提供了優(yōu)化和標(biāo)準(zhǔn)化的方法。

關(guān)鍵詞:醫(yī)療成像,訓(xùn)練,評(píng)估

simpletransformers

Simple Transformers讓您快速訓(xùn)練和評(píng)估Transformer模型。初始化、訓(xùn)練和評(píng)估模型只需要3行代碼。它支持各種各樣的 NLP 任務(wù)。

關(guān)鍵詞:框架,簡(jiǎn)單性,NLP

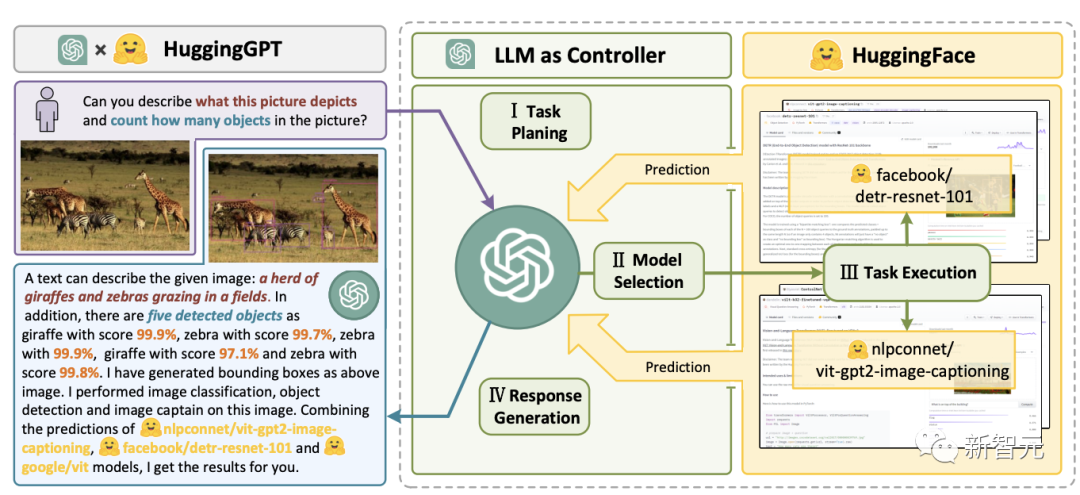

JARVIS

JARVIS是一個(gè)將GPT-4等在內(nèi)的LLM與開源機(jī)器學(xué)習(xí)社區(qū)其他模型合并的系統(tǒng),利用多達(dá)60個(gè)下游模型來執(zhí)行 LLM 確定的任務(wù)。

關(guān)鍵詞:LLM,智能體,HF Hub

transformers.js

transformers.js是一個(gè)JavaScript庫(kù),目標(biāo)是直接在瀏覽器中從transformers運(yùn)行模型。

關(guān)鍵詞:Transformers,JavaScript,瀏覽器

bumblebee

Bumblebee在Axon之上提供了預(yù)訓(xùn)練的神經(jīng)網(wǎng)絡(luò)模型,Axon是用于Elixir語言的神經(jīng)網(wǎng)絡(luò)庫(kù)。它包括與模型的集成,允許任何人下載和執(zhí)行機(jī)器學(xué)習(xí)任務(wù),只需要幾行代碼。

關(guān)鍵詞:Elixir,Axon

argilla

Argilla是一個(gè)提供高級(jí)NLP標(biāo)簽、監(jiān)控和工作區(qū)的開源平臺(tái)。它與許多開源生態(tài)系統(tǒng)兼容,例如Hugging Face、Stanza、FLAIR等。

關(guān)鍵詞:NLP,標(biāo)簽,監(jiān)控,工作區(qū)

haystack

Haystack是一個(gè)開源的NLP框架,可以使用Transformer模型和LLM與數(shù)據(jù)進(jìn)行交互。它為快速構(gòu)建復(fù)雜的決策制定、問題回答、語義搜索、文本生成應(yīng)用程序等提供了可用于生產(chǎn)的工具。

關(guān)鍵詞:NLP,F(xiàn)ramework,LLM

spaCy

SpaCy是一個(gè)用于Python和Cython中高級(jí)自然語言處理的庫(kù)。它建立在最新的研究基礎(chǔ)之上,從一開始就被設(shè)計(jì)用于實(shí)際產(chǎn)品。它通過其第三方軟件包spacy-transformers為Transformers模型提供支持。

關(guān)鍵詞:NLP,架構(gòu)

speechbrain

SpeechBrain是一個(gè)基于PyTorch的開源、一體化的會(huì)話AI工具包。我們的目標(biāo)是創(chuàng)建一個(gè)單一的、靈活的、用戶友好的工具包,可以用來輕松開發(fā)最先進(jìn)的語音技術(shù),包括語音識(shí)別、講話者識(shí)別、語音增強(qiáng)、語音分離、語言識(shí)別、多麥克風(fēng)信號(hào)處理等系統(tǒng)。

關(guān)鍵詞:對(duì)話,演講

skorch

Skorch是一個(gè)包裝PyTorch的具有scikit-learn兼容性的神經(jīng)網(wǎng)絡(luò)庫(kù)。它支持Transformers中的模型,以及來自標(biāo)記器的標(biāo)記器。

關(guān)鍵詞:Scikit-Learning,PyTorch

bertviz

BertViz是一個(gè)交互式工具,用于在諸如BERT、GPT2或T5之類的Transformer語言模型中可視化注意力。它可以通過支持大多數(shù)Huggingface模型的簡(jiǎn)單Python API在Jupiter或Colab筆記本中運(yùn)行。

關(guān)鍵詞:可視化,Transformers

mesh-transformer-jax

mesh-transformer-jax是一個(gè)俳句庫(kù),使用JAX中的xmap/pjit運(yùn)算符實(shí)現(xiàn)Transformers模型并行性。

這個(gè)庫(kù)被設(shè)計(jì)為在TPUv3上可擴(kuò)展到大約40B的參數(shù)。它是用來訓(xùn)練GPT-J模型的庫(kù)。

關(guān)鍵詞:俳句,模型并行,LLM,TPUdeepchem

OpenNRE

一種用于神經(jīng)關(guān)系提取的開源軟件包(NRE)。它的目標(biāo)用戶范圍很廣,從新手、到開發(fā)人員、研究人員或?qū)W生。

關(guān)鍵詞:神經(jīng)關(guān)系抽取,框架

pycorrector

一種中文文本糾錯(cuò)工具。該方法利用語言模型檢測(cè)錯(cuò)誤、拼音特征和形狀特征來糾正漢語文本錯(cuò)誤。可用于漢語拼音和筆畫輸入法。

關(guān)鍵詞: 中文,糾錯(cuò)工具,語言模型,Pinyin

nlpaug

這個(gè)python庫(kù)可以幫助你為機(jī)器學(xué)習(xí)項(xiàng)目增強(qiáng)nlp。它是一個(gè)輕量級(jí)的庫(kù),具有生成合成數(shù)據(jù)以提高模型性能的功能,支持音頻和文本,并與幾個(gè)生態(tài)系統(tǒng)(scikit-learn、pytorch、tensorflow)兼容。

關(guān)鍵詞:數(shù)據(jù)增強(qiáng),合成數(shù)據(jù)生成,音頻,自然語言處理

dream-textures

dream-textures是一個(gè)旨在為Blender帶來穩(wěn)定擴(kuò)散支持的庫(kù)。它支持多種用例,例如圖像生成、紋理投影、內(nèi)畫/外畫、 ControlNet和升級(jí)。

關(guān)鍵詞: Stable-Diffusion,Blender

seldon-core

Seldon core將你的ML 模型(Tensorflow、 Pytorch、 H2o等)或語言包裝器(Python、 Java等)轉(zhuǎn)換為生產(chǎn) REST/GRPC微服務(wù)。Seldon可以處理擴(kuò)展到數(shù)以千計(jì)的生產(chǎn)機(jī)器學(xué)習(xí)模型,并提供先進(jìn)的機(jī)器學(xué)習(xí)功能,包括高級(jí)指標(biāo)、請(qǐng)求日志、解釋器、離群值檢測(cè)器、A/B測(cè)試、Canaries等。

關(guān)鍵詞:微服務(wù),建模,語言包裝

open_model_zoo

該庫(kù)包括優(yōu)化的深度學(xué)習(xí)模型和一組演示,以加快高性能深度學(xué)習(xí)推理應(yīng)用程序的開發(fā)。使用這些免費(fèi)的預(yù)訓(xùn)練模型,而不是訓(xùn)練自己的模型來加速開發(fā)和生產(chǎn)部署過程。

關(guān)鍵詞:優(yōu)化模型,演示

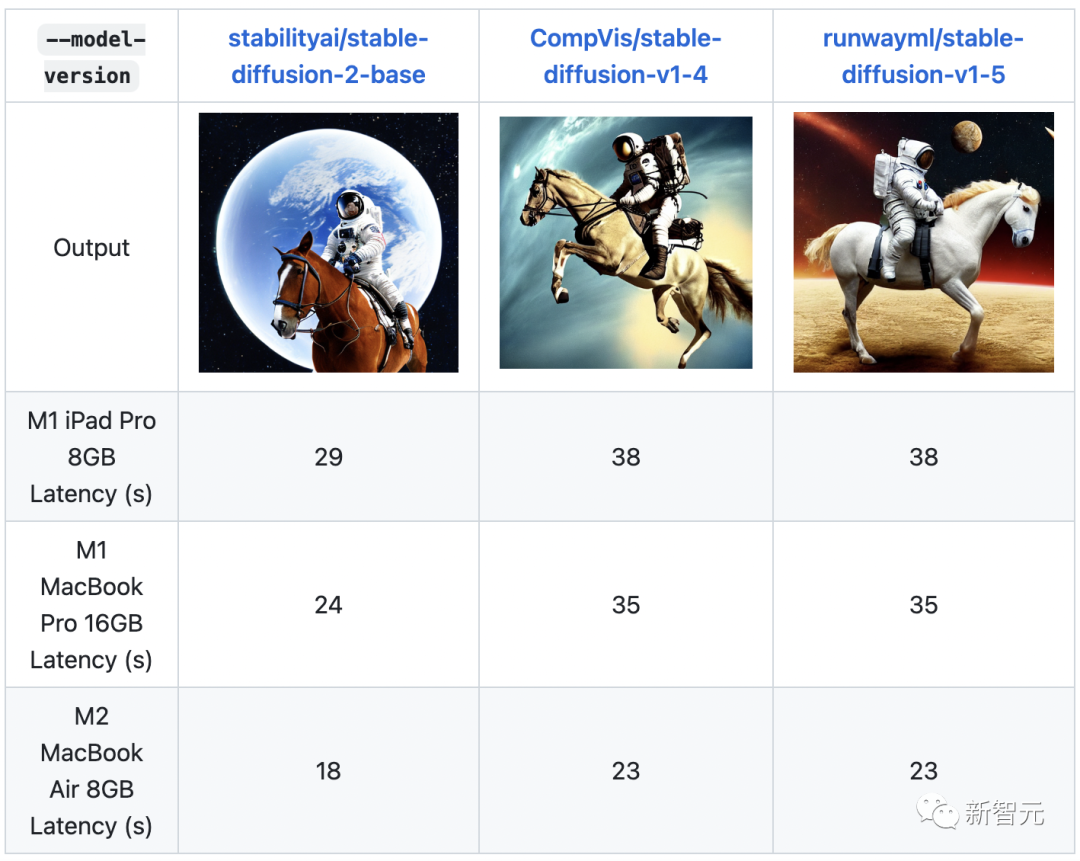

ml-stable-diffusion

ML-Stable-Diffusion是蘋果在蘋果芯片設(shè)備上為Core ML帶來Stable Diffusion支持的一個(gè)倉(cāng)庫(kù)。它支持托管在Hugging Face Hub上的穩(wěn)定擴(kuò)散檢查點(diǎn)。

關(guān)鍵詞:Stable Diffusion,蘋果芯片,Core ML

stable-dreamfusion

Stable-Dreamfusion是文本到3D模型Dreamfusion的pytorch實(shí)現(xiàn),由Stable Diffusion文本到2D模型提供動(dòng)力。

關(guān)鍵詞:文本到3D,Stable Diffusion

txtai

Txtai是一個(gè)開源平臺(tái),支持語義搜索和語言模型驅(qū)動(dòng)的工作流。Txtai構(gòu)建了嵌入式數(shù)據(jù)庫(kù),它是向量索引和關(guān)系數(shù)據(jù)庫(kù)的結(jié)合,支持SQL近鄰搜索。語義工作流將語言模型連接到統(tǒng)一的應(yīng)用程序中。

關(guān)鍵詞:語義搜索,LLM

djl

Deep Java Library (DJL)是一個(gè)用于深度學(xué)習(xí)的開源、高級(jí)、引擎無關(guān)的Java框架,易于開發(fā)人員使用。DJL像其他常規(guī)Java庫(kù)一樣提供了本地Java開發(fā)經(jīng)驗(yàn)和函數(shù)。DJL為HuggingFace Tokenizer提供了Java綁定,并為HuggingFace模型在Java中部署提供了簡(jiǎn)單的轉(zhuǎn)換工具包。

關(guān)鍵詞:Java,架構(gòu)

lm-evaluation-harness

該項(xiàng)目提供了一個(gè)統(tǒng)一的框架,以測(cè)試生成語言模型在大量不同的評(píng)估任務(wù)。它支持200多項(xiàng)任務(wù),并支持不同的生態(tài)系統(tǒng):HF Transformers,GPT-NeoX,DeepSpeed,以及OpenAI API。

關(guān)鍵詞:LLM,評(píng)估,少樣本

gpt-neox

這個(gè)資源庫(kù)記錄了EleutherAI用于在GPU上訓(xùn)練大規(guī)模語言模型的庫(kù)。該框架以英偉達(dá)的Megatron語言模型為基礎(chǔ),并以DeepSpeed的技術(shù)和一些新的優(yōu)化來增強(qiáng)。它的重點(diǎn)是訓(xùn)練數(shù)十億參數(shù)的模型。

關(guān)鍵詞:訓(xùn)練,LLM,Megatron,DeepSpeed

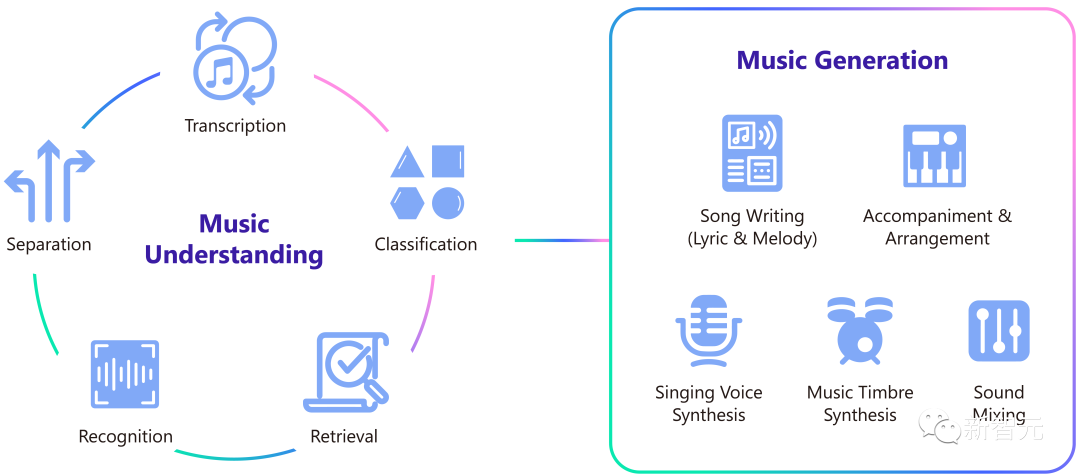

muzic

Muzic是一個(gè)關(guān)于人工智能音樂的研究項(xiàng)目,它能夠通過深度學(xué)習(xí)和人工智能來理解和生成音樂。Muzic是由微軟亞洲研究院的研究人員創(chuàng)建的。

關(guān)鍵詞:音樂理解,音樂生成

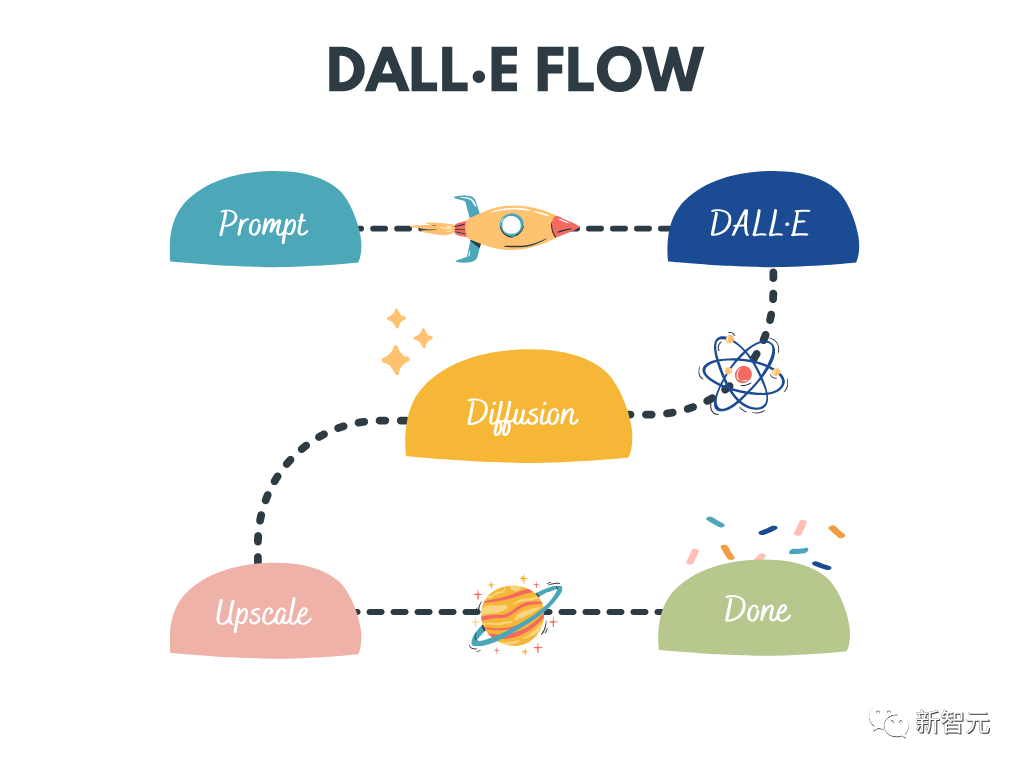

dalle-flow

DALL · E Flow是一個(gè)交互式工作流程,用于從文本提示符生成高清圖像。它利用DALL · E-Mega、GLID-3 XL和Stable Diffusion生成候選圖像,然后調(diào)用CLIP-as-service對(duì)候選圖像進(jìn)行提示排序。首選的候選者被饋送到GLID-3 XL進(jìn)行擴(kuò)散,這通常會(huì)豐富紋理和背景。最后,通過SwinIR將候選項(xiàng)擴(kuò)展到1024x1024。

關(guān)鍵詞:高清度圖像生成,Stable Diffusion,DALL-E Mega,GLID-3 XL,CLIP,SwinIR

lightseq

LightSeq是在CUDA中實(shí)現(xiàn)的用于序列處理和生成的高性能訓(xùn)練和推理庫(kù)。它能夠高效地計(jì)算現(xiàn)代NLP和CV模型,如BERT,GPT,Transformer等。因此,它對(duì)于機(jī)器翻譯、文本生成、圖像分類和其他與序列相關(guān)的任務(wù)非常有用。

關(guān)鍵詞:訓(xùn)練,推理,序列處理,序列生成

LaTeX-OCR

該項(xiàng)目的目標(biāo)是創(chuàng)建一個(gè)基于學(xué)習(xí)的系統(tǒng),該系統(tǒng)采用數(shù)學(xué)公式的圖像,并返回相應(yīng)的LaTeX代碼。

關(guān)鍵詞:OCR,LaTeX,數(shù)學(xué)公式

open_clip

OpenCLIP是OpenAI的CLIP的開源實(shí)現(xiàn)。

這個(gè)資源庫(kù)的目標(biāo)是使具有對(duì)比性的圖像-文本監(jiān)督的訓(xùn)練模型成為可能,并研究它們的屬性,如對(duì)分布轉(zhuǎn)移的魯棒性。項(xiàng)目的出發(fā)點(diǎn)是CLIP的實(shí)現(xiàn),當(dāng)在相同的數(shù)據(jù)集上訓(xùn)練時(shí),與原始CLIP模型的準(zhǔn)確性相匹配。

具體來說,一個(gè)以O(shè)penAI的1500萬圖像子集YFCC為代碼基礎(chǔ)訓(xùn)練的ResNet-50模型在ImageNet上達(dá)到32.7%的最高準(zhǔn)確率。

關(guān)鍵詞:CLIP,開源,對(duì)比,圖像文本

dalle-playground

一個(gè)playground生成圖像從任何文本提示使用Stable Diffusion和Dall-E mini。

關(guān)鍵詞:WebUI,Stable Diffusion,Dall-E mini

FedML

FedML是一個(gè)聯(lián)邦學(xué)習(xí)和分析庫(kù),能夠在任何地方、任何規(guī)模的分散數(shù)據(jù)上進(jìn)行安全和協(xié)作的機(jī)器學(xué)習(xí)。

關(guān)鍵詞:聯(lián)邦學(xué)習(xí),分析,協(xié)作機(jī)器學(xué)習(xí),分散