DragGAN第一作者Xingang Pan,正式加入南洋理工,出任助理教授!

還記得前一陣子爆火的DragGAN嗎?

沒錯,就是那個拖一拖,拽一拽,就能實現完美P圖的模型。

因為其「傻瓜式」的操作,和強大的性能,直接炸翻了作圖圈。

人們直言,現在終于能實現甲方「讓大象轉過來」的需求了!

而現在,論文的第一作者Xingang Pan也正式成為了南洋理工助理教授。

第一作者——Xingang Pan

消息一出來,業內人士也是第一時間送上了祝賀。

在Pan教授的GitHub主頁上,他的個人職務已經更新完畢。

在成為南洋理工大學的助理教授之前,他是馬克斯·普朗克計算機科學研究所的博士后研究員,由Christian Theobalt教授指導。

在此之前,他于2016年在清華大學獲得學士學位,并2021年在香港中文大學多媒體實驗室獲得博士學位,導師是湯曉鷗教授。

他的研究興趣在計算機視覺、機器學習和計算機圖形學的交叉領域。

目前,他的研究方向主要集中在生成式AI模型、AI與人類協同內容生成、3D/視頻編輯和生成、神經場景表示和渲染,以及物理感知內容生成。

目前,Pan教授開始在推特上進行「招生」宣傳,表示任何對生成式AI感興趣,想繼續跟進DragGAN的研究者都可以來。

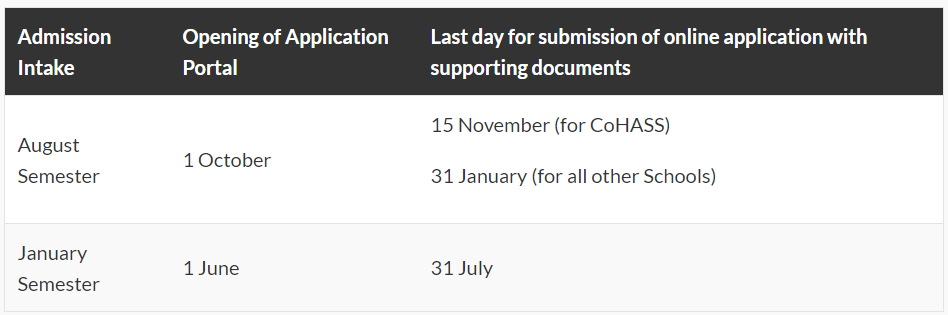

一月學期申請的DDL是7月31日,而七月學期申請的DDL是1月31日。

南洋理工大學的官網上也是給出了申請指南。

包含具體的要求、學制,以及申請費。

要知道,南洋理工大學(新加坡)是很多人心中的科研圣地。

作為一所科研密集型大學,在2023年的QS排名中,全球排名第19,亞洲排名第4。

2022年的U.S.News世界大學排名中,全球排名第33,亞洲排名第3。

DragGAN?拽完就干完了!

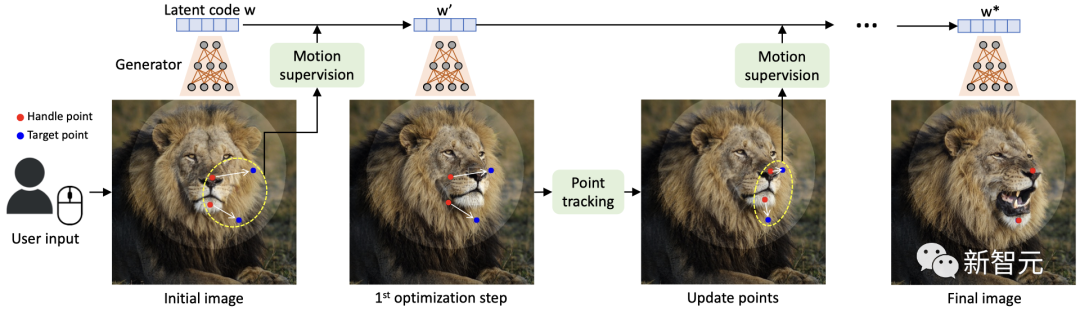

DragGAN之所以厲害,是因為研究團隊應用了一種強大但還未被充分探索的控制GAN的方法——以交互的方式將圖像中任意一點精確「拖動」至目標點。

DragGAN主要包括以下兩個主要組成部分:

- 基于特征的運動監控,驅動操作點向目標位置移動

- 一個新的點跟蹤方法,利用區分性的GAN特征持續定位操作點的位置

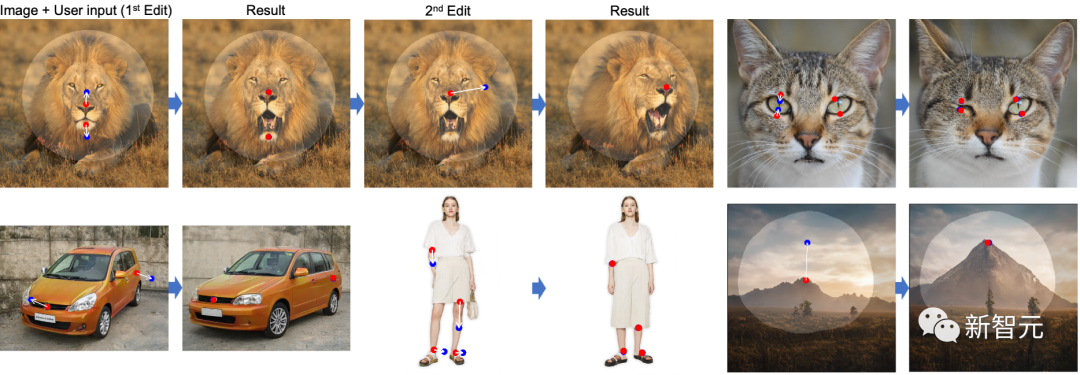

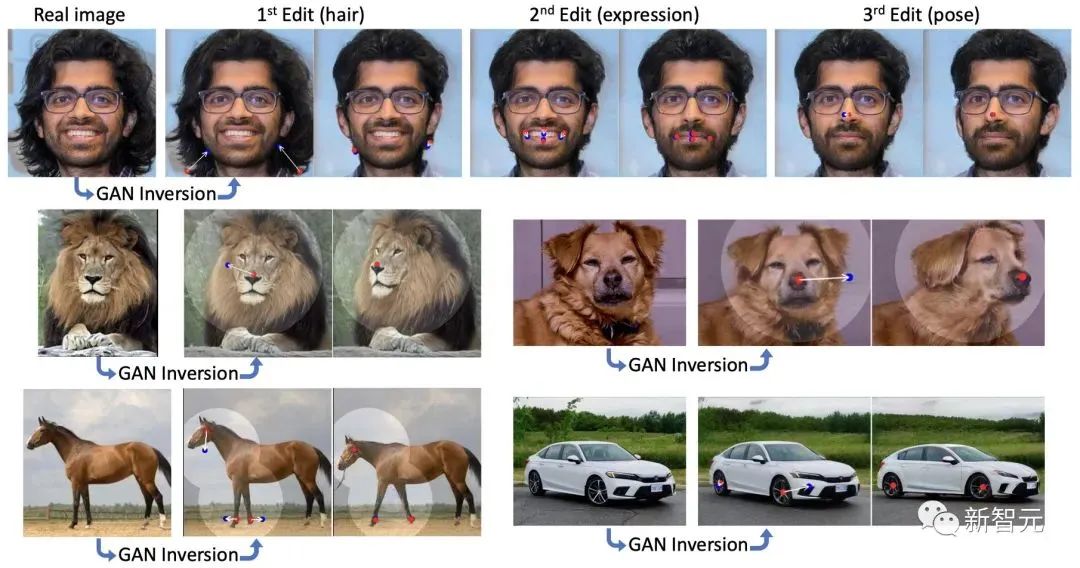

通過DragGAN,任何人都可以對像素進行精確的控制,進而編輯如動物、汽車、人類、風景等多種類別的姿態、形狀、表情和布局。

由于這些操作在GAN的學習生成圖像流形上進行,因此它們傾向于生成逼真的輸出,即使在富有挑戰性的場景下也是如此,例如被遮擋的內容和變形的圖像。

定性和定量的對比表明,DragGAN在圖像操作和點跟蹤任務中,都明顯優于先前的方法。

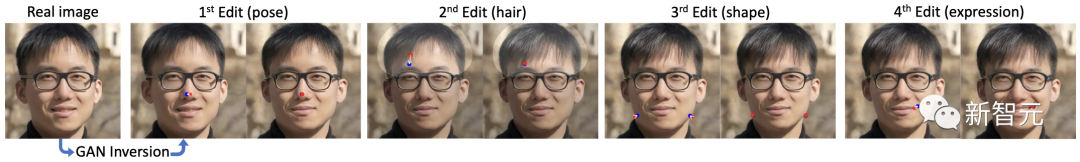

在DragGAN的加持下,用戶只需要設置幾個操作點(紅點),目標點(藍點),以及可選的表示可移動區域的mask(亮區)。然后,模型就會自動完成后續的圖像生成,

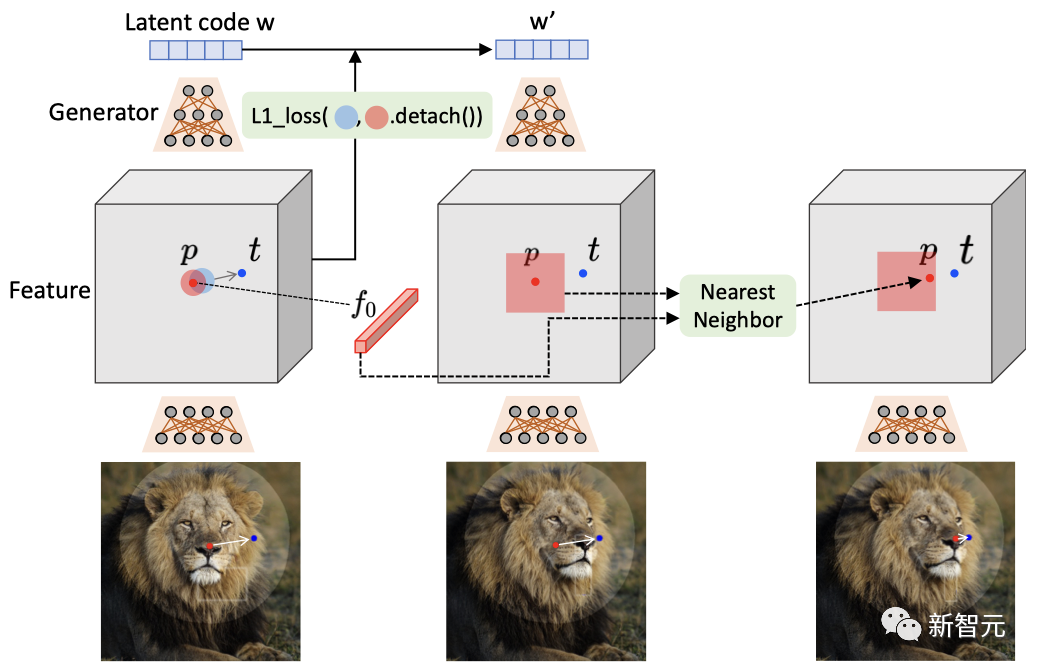

其中,動態監控步驟會讓操作點(紅點)向目標點(藍點)移動,點追蹤步驟則通過更新操作點來追蹤圖像中的對象。此過程會一直持續,直到操作點達到其相應的目標點。

具體來說,團隊通過在生成器的特征圖上的位移修補損失來實現動態監控,并在相同的特征空間中通過最近鄰搜索進行點追蹤。

值得注意的是,用戶可以通過添加mask的方式,來控制需要編輯的區域。

可以看到,當狗的頭部被mask時,在編輯后的圖像中,只有頭部發生了移動,而其他區域則并未發生變化。但如果沒有mask的話,整個狗的身體也會跟著移動。

這也顯示出,基于點的操作通常有多種可能的解決方案,而GAN會傾向于在其從訓練數據中學習的圖像流形中找到最近的解決方案。

因此,mask功能可以幫助減少歧義并保持某些區域固定。

在真實圖像的編輯中,團隊應用GAN反轉將其映射到StyleGAN的潛在空間,然后分別編輯姿勢、頭發、形狀和表情。

到目前為止,團隊展示的都是基于「分布內」的編輯,也就是使用訓練數據集內的圖像來實現編輯。

但DragGAN實際上具有強大的泛化能力,可以創建出超出訓練圖像分布的圖像。比如,一個張得巨大的嘴,以及一個被極限放大的車輪。

在某些情況下,用戶可能希望始終保持圖像在訓練分布中,并防止這種超出分布的情況發生。實現這一目標的方法可以是對潛在代碼??添加額外的正則化,但這并不是本文討論的重點。

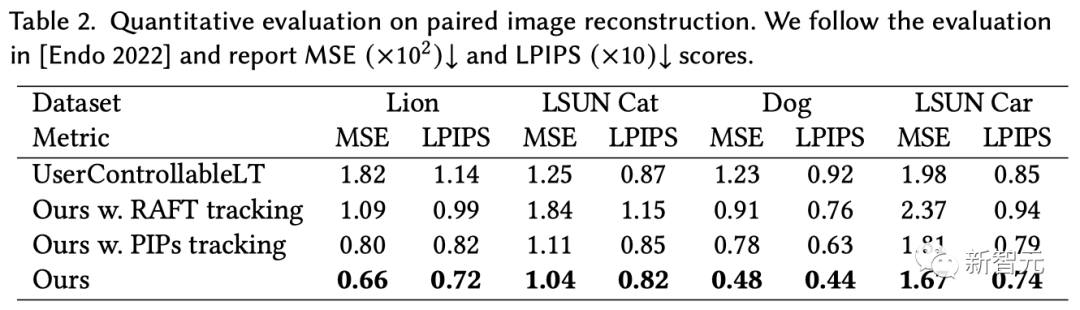

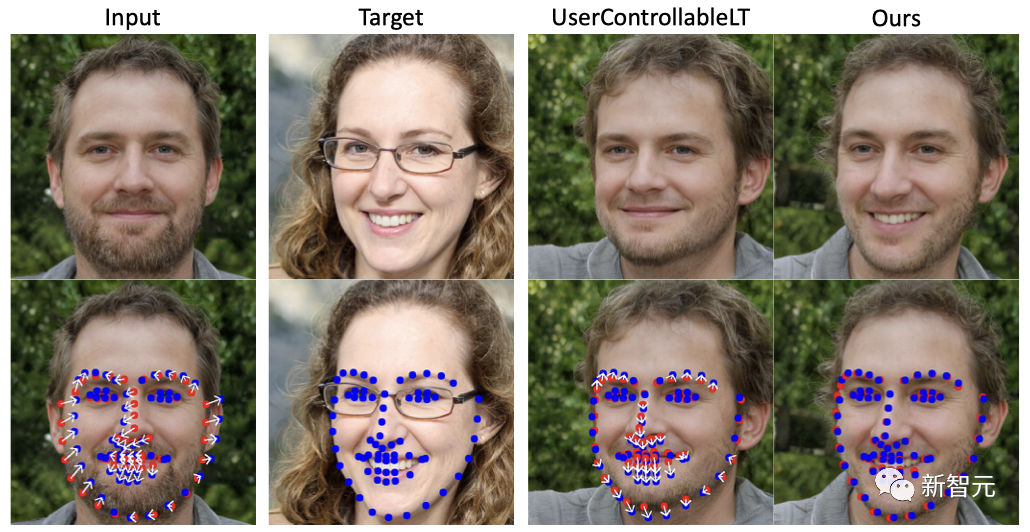

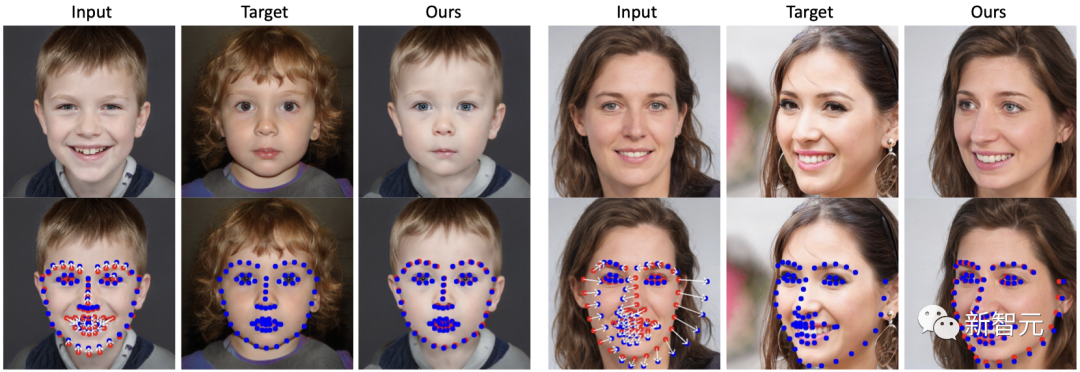

首先,與UserControllableLT相比,DragGAN能夠編輯從輸入圖像中檢測到的特征點,并使其與從目標圖像中檢測到的特征點相匹配,而且誤差很小。

從下圖中可以看出,DragGAN正確地張開了照片中人物的嘴,并調整了下巴的形狀來匹配目標的臉型,而UserControllableLT未能做到這一點。

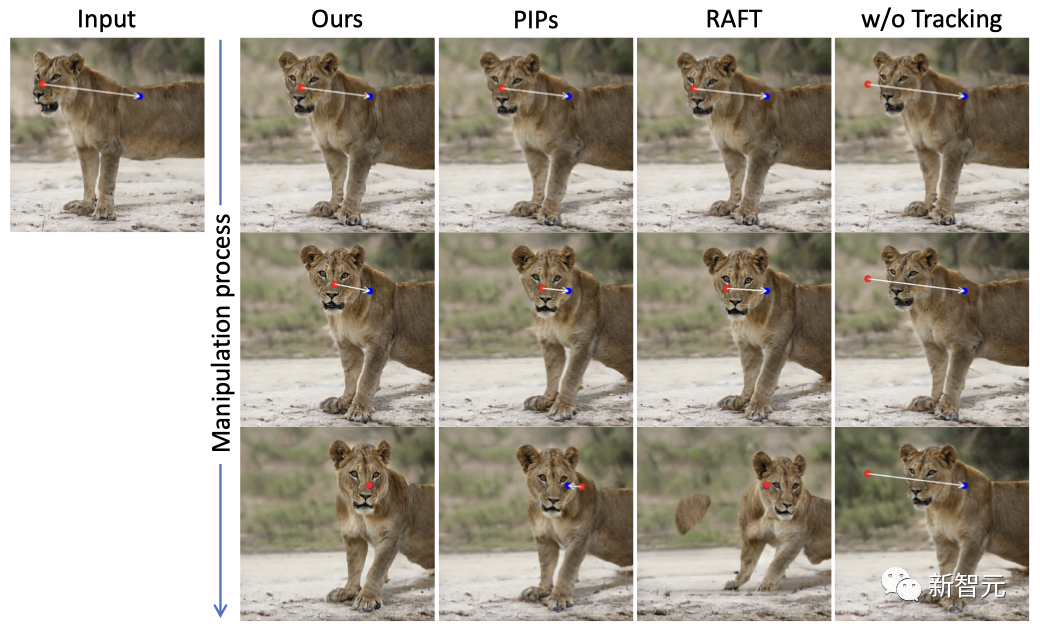

在DragGAN與RAFT、PIPs和無追蹤的定性比較中,可以看得,DragGAN可以比基線更準確地跟蹤操作點,進而能夠產生更精確的編輯。

而在移動操作點(紅點)到目標點(藍點)的任務上,定性比較的結果顯示,DragGAN在各種數據集上都取得了比UserControllableLT更加自然和優秀的效果。

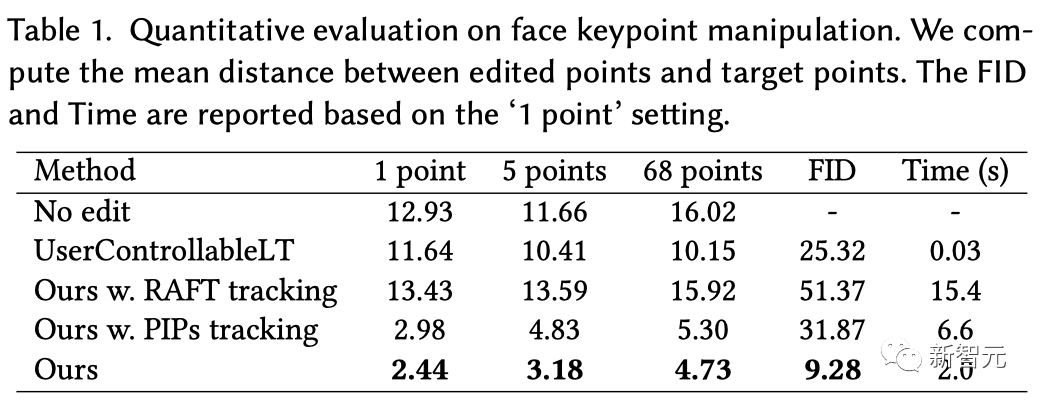

如表1所示,在不同的點數下,DragGAN都明顯優于UserControllableLT。而且根據FID的得分,DragGAN還保留了更好的圖像質量。

由于具有更強的跟蹤能力,DragGAN還實現了比RAFT和PIPs更精確的操縱。正如FID分數所顯示的,如果跟蹤不準確的話,很可能會造成編輯過度,從而降低圖像質量。

雖然UserControllableLT的速度更快,但DragGAN在很大程度上提升了這項任務的上限,在保持相對較快的運行時間的同時,實現了更靠譜的編輯。