首次,6人7天真人秀!南洋理工等發布第一視角AI生活管家數據EgoLife

當AI智能體(如Manus)接管你的大部分工作后,你是否曾想過,如何讓自己的生活變得更加輕松與智能?

試想一個未來場景:你佩戴著智能眼鏡,一個AI助理能無縫融入你的日常生活,根據你的個人習慣提供貼心的美食建議,下班后提醒你曾經購買過的物品,甚至通過分析你和家人過去的活動來主動預測你的需求。

這樣一款「生活助手」將極大提升個人效率和家庭協作,讓AI真正成為我們生活中的得力管家。

然而,要實現這個愿景,AI需要具備對超長時間跨度行為模式的理解能力,以及對社交互動細節的把握——這是現有第一人稱視角(Egocentric)人工智能系統所欠缺的。

目前已有的一些第一視角數據集(如Epic-Kitchens、Ego4D等)支持了許多視頻理解任務,但它們通常錄制時長較短,而且大多只涉及單人的視角。這些局限使得模型難以捕捉人們長期的生活習慣和復雜的社交互動細節。

換言之,目前還缺少一種跨越長時間、多人物、多模態的數據資源和方法,來訓練出真正懂得「日常生活全貌」的AI助理。

針對這一挑戰,來自LMMs-Lab和MMLab@NTU的研究者們啟動了EgoLife項目,致力于邁出打造以第一人稱視角為中心的AI生活助手的關鍵一步,其核心是在真實生活場景中收集海量多模態數據,并研發創新模型來理解和利用這些數據,最終實現對人類日常生活的智能輔助。

論文地址:https://huggingface.co/papers/2503.03803

論文地址:https://huggingface.co/papers/2503.03803

可交互項目主頁:https://egolife-ai.github.io/

技術向項目主頁:https://egolife-ai.github.io/blog/

項目代碼:https://github.com/EvolvingLMMs-Lab/EgoLife

數據和模型:https://huggingface.co/collections/lmms-lab/egolife-67c04574c2a9b64ab312c342

真實場景下的AI進化實驗:前所未有的多模態生活記錄

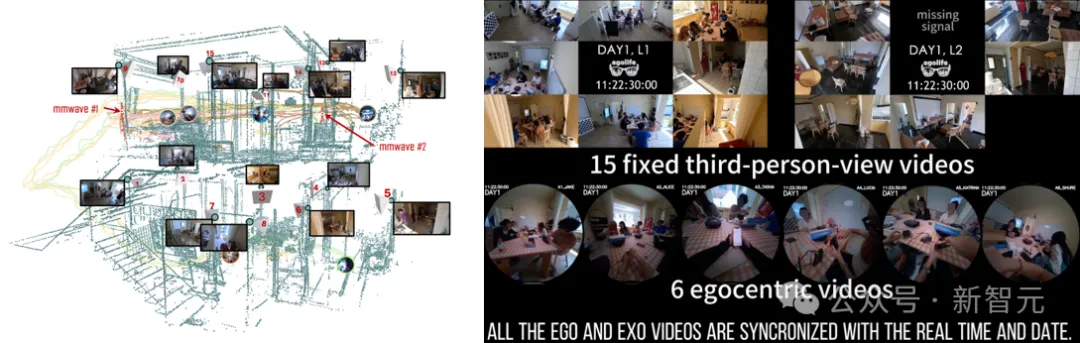

EgoLife 項目的基礎是一套規模空前的第一視角多模態生活日志數據集。項目組招募了6名志愿者,讓他們共同在一個裝備了大量傳感器的房屋中生活7天,以籌備「地球日」活動為背景。

每位參與者都佩戴了Meta Aria智能眼鏡,連續一周每天錄制約8小時的第一人稱視頻和音頻。同時,房屋中安裝了15臺固定相機和2個毫米波雷達裝置,以同步記錄第三人稱視角的視頻和動作捕捉信息。

借助這些設備,EgoLife數據集中不僅有參與者主觀視角的影像,還包括客觀環境的全景監控和精確的空間位置數據,甚至通過多攝像頭融合重建出了房屋的3D模型。

最終,項目采集到了大約300小時的多視角、多模態視頻數據——這是迄今為止極為豐富、逼真的日常生活記錄,為研究長時序行為和人際互動提供了前所未有的資料。

圖1: EgoLife邀請了6名參與者佩戴智能眼鏡同住一屋7天,錄制了總計約300小時的第一人稱視頻。研究團隊還在房屋內布置了15個第三人稱攝像頭和毫米波雷達(如圖左所示),獲取同步的環境視角數據。右側展示了所有攝像機同步的采集結果

高強度數據標注,為模型訓練和評測鋪路

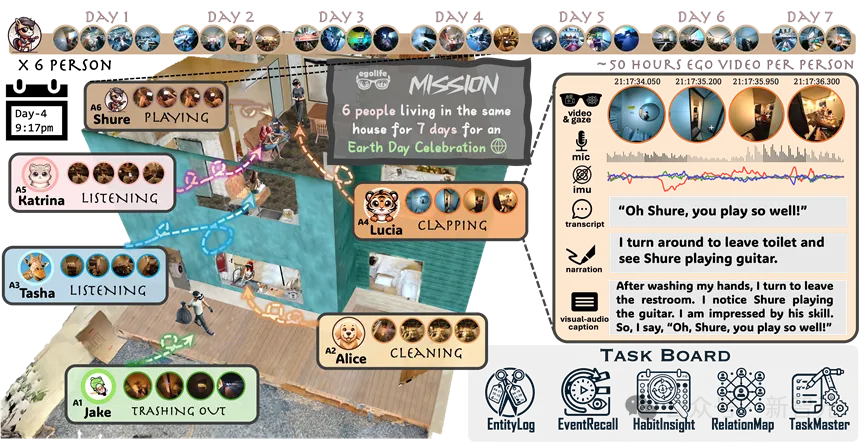

為了讓AI深入「讀懂」人們的生活,僅有原始視頻還不夠,EgoLife數據集還配備了密集而詳細的標注。研究人員為視頻標注了密集的描述和旁白:包括完整的語音轉錄文本,以及不同時間粒度的視覺-音頻敘事。

簡單來說,數據集中既有細粒度的即時字幕(描述當下看到和聽到的內容),也有每隔30秒總結性的長段說明。

圖2: 該圖是論文的主圖。右側示例展示了志愿者Lucia看到Shure正在彈吉他的片段,對應的多模態數據流(視頻+音頻+凝視軌跡+語音轉錄+音視頻描述)以及EgoLife定義的「五大任務板」(底部)

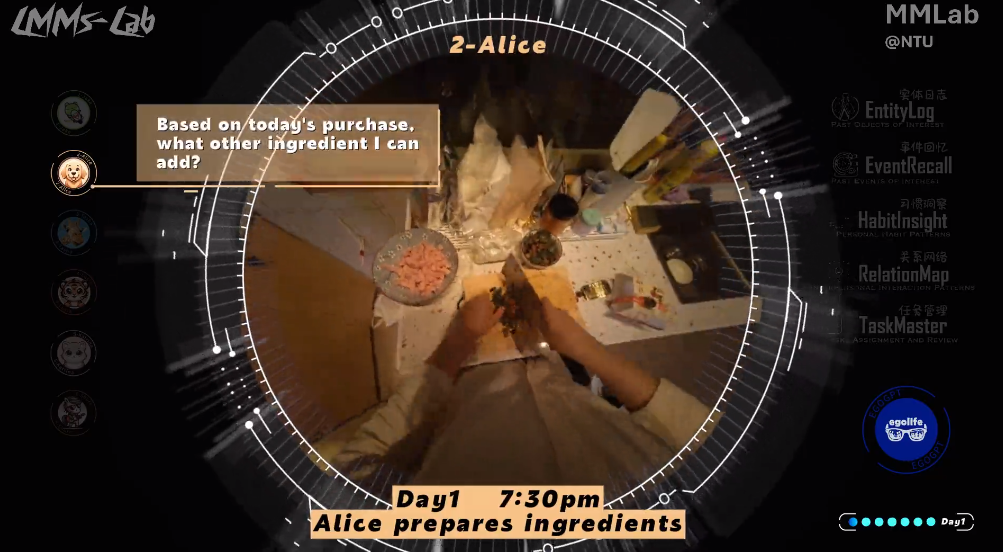

這些詳盡標注不僅為訓練AI模型提供了監督信號,也方便構建起各種高層語義任務。例如,基于這些標注,研究團隊構建了一個EgoLifeQA基準,收集了每位參與者約500個與生活相關的問題,共計3000道,以評測AI助理對長時記憶和復雜情境的理解能力。

值得一提的是,這些問題專門設計為需要「長時回溯」才能回答——66%以上的問題答案需要追溯2小時以前的事件,15%以上甚至涉及超過24小時之前的信息。

問題覆蓋了五大類生活助理任務:例如詢問物品細節和使用歷史的「實體日志(EntityLog)」 、回憶過去活動的 「事件追憶(EventRecall)」、分析個人習慣規律的習慣洞察(HabitInsight)」、理解社交互動關系的「關系圖譜(RelationMap)」 ,以及根據以往經歷輔助規劃任務的「任務管理(TaskMaster)」 。

每個問題都要求AI從用戶過去幾小時、甚至幾天的生活記錄中提取線索,給出有依據的回答。這些精心標注的數據和任務,為EgoLife項目中的核心AI系統提供了訓練和評價的平臺,也推動著智能生活助手這一新興領域的發展。

圖3: 以志愿者Katrina為例,黑色線條表示問題提問的時間,彩色線條表示需要回答該問題需要尋找的線索所在的時間

EgoButler: 雙引擎架構實現第一視角超長信息理解

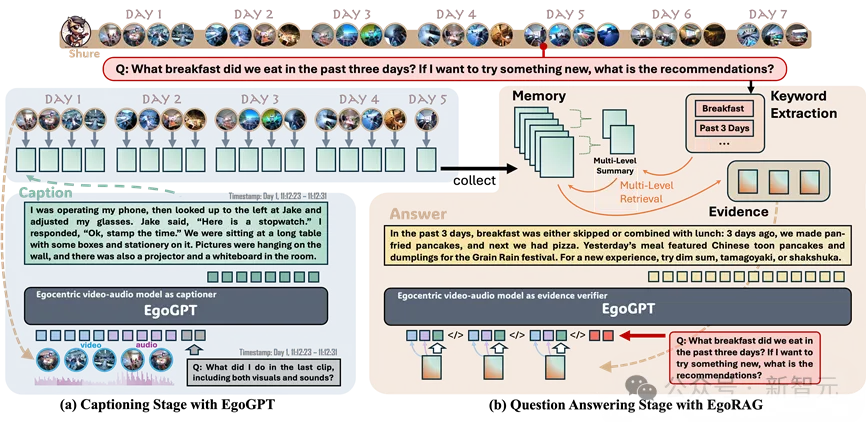

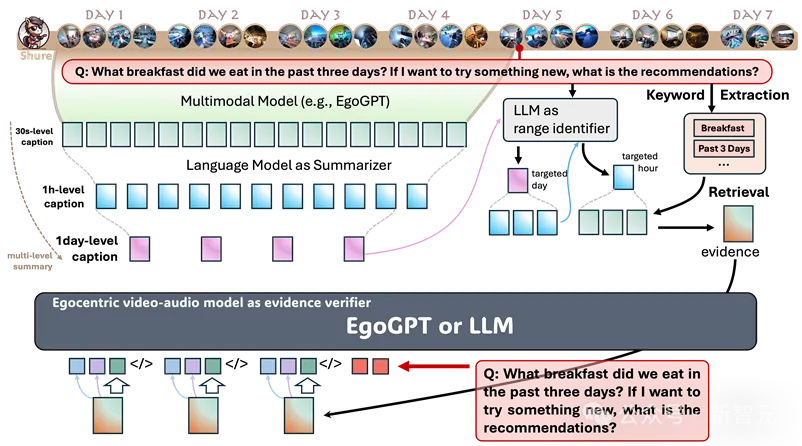

有了如此豐富的第一視角數據,EgoLife項目接下來的關鍵在于如何讓AI高效地理解和利用這些信息。研究團隊提出的解決方案是一個名為「EgoButler」的集成系統,由兩個核心組件組成:EgoGPT和EgoRAG

EgoGPT擔當「感知描述」的角色,而EgoRAG負責「記憶檢索」和「推理回答」,二者相輔相成,使AI助理既能看懂當前發生了什么,又能回憶起過去發生過什么。

EgoGPT:全模態第一視角片段理解引擎

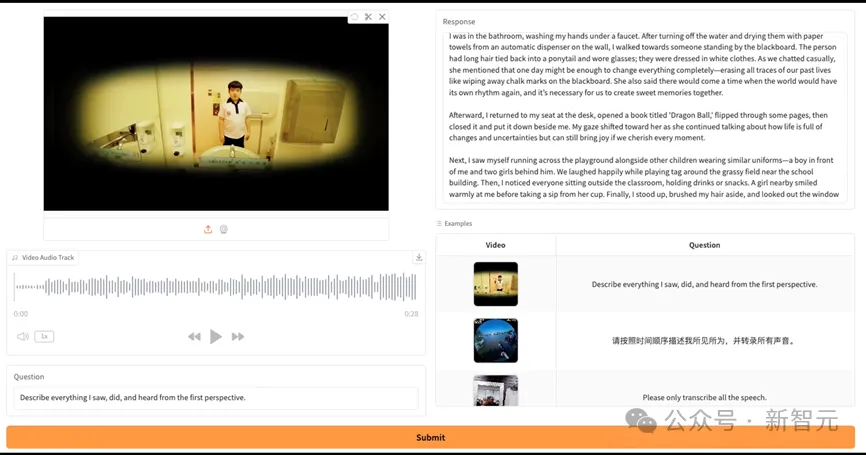

EgoGPT 是EgoLife研制的視覺-聽覺-語言模型,可以被視為AI助理的大腦中「實時描述器」和「短期分析」部分。它在現有的大型多模態模型LLaVA-OV的基礎上,專門針對第一人稱視角視頻進行了優化訓練。

與通用的視覺語言模型不同,EgoGPT具備以下顯著特點:

融合視覺和音頻,多模態「看懂」視頻片段

EgoGPT能夠同時處理來自攝像頭的視頻畫面和麥克風的音頻輸入,從而「看」和「聽」用戶所經歷的一切。研究人員為此引入了音頻編碼器(使用Whisper模型)并訓練了一個投影模塊,將聲音信號融入原有的視覺語言模型中。

經過這樣的擴展,EgoGPT成為一個真正的「omni-modal」(全模態)模型,可以對30秒左右的生活視頻片段生成詳細的字幕式描述。

例如,當用戶走進廚房時,它可以同時描述「視覺上看到有人在做飯,邊做邊在講這是什么菜」等細節,為后續理解提供豐富信息。

連續密集字幕,構建時序語義流

EgoGPT的第一個功能是對每個30秒的視頻片段連續進行描述,形成時間上密集的「活動日志」。這些生成的文字描述涵蓋了用戶視角中的關鍵事件、對象、人物對話等,為后續的記憶檢索提供了語義線索。

可以將EgoGPT看作是一個隨時記錄用戶所見所聞的「AI記錄員」,把海量的視頻變成可檢索的文本和特征,這一步極大壓縮并提煉了原始視頻數據的內容,使后續模塊不用直接處理視頻就能了解發生過的事情。

個性化的身份識別能力

EgoGPT還經過了個性化微調,能夠識別特定環境中的人物身份。研究人員利用EgoLife數據集中第1天的視頻,對EgoGPT進一步微調,使模型學會了6位參與者的長相、聲音和名字。

因此,在描述或回答問題時,EgoGPT可以提到人物名字,而不是像普通模型那樣僅僅檢測到「一個人」,讓助理具備了上下文中的身份感知。這種個性化能力對于家庭場景尤其重要,它意味著AI能區別家庭成員,從而提供更貼合用戶的協作幫助。

第一視角領域優化,性能業界領先

由于在海量的egocentric數據上進行了專門訓練,EgoGPT在第一人稱視頻理解上的表現達到了當前最先進水平。論文中的實驗對比顯示,EgoGPT在多個既有的egocentric基準任務取得領先效果。

綜上,EgoGPT為EgoLife系統提供了一個強大的「感知與敘事」引擎。它將長時間的視頻流轉化為結構化的語言和特征表述,為后續的記憶存儲和問答打下基礎。

在生活助理類比中,EgoGPT就好比一個隨身攜帶的智能「攝像師+記錄員」,源源不斷地記錄并解說著用戶視角下的故事。

圖4: 目前團隊已開源EgoGPT模型權重及訓練框架,并提供在線Demo體驗。值得注意的是,系統展現出驚人的場景理解能力:在五月天MV解析測試中,不僅能描述畫面內容,還能結合歌詞進行意境分析。體驗鏈接:https://egolife.lmms-lab.com

EgoRAG:超長時記憶檢索與問答模塊

有了EgoGPT持續產出的「生活日志」,下一步就是讓AI助理真正具備長時記憶和問答推理能力——這正是 EgoRAG 發揮作用的地方。

EgoRAG的名字來源于「Retrieval-Augmented Generation」,意味著它將信息檢索和生成式AI結合,專門用于處理超長時間跨度的提問。簡單來說,EgoRAG可以被視為AI助理的大腦中「記憶庫」與「知識檢索官」的部分。當用戶提問時,EgoRAG能夠在龐大的歷史記錄中快速找到相關片段,并結合EgoGPT等模型生成答案。

其核心步驟如下:

分層記憶庫構建

面對長達數百小時的生活記錄,EgoRAG首先通過EgoGPT生成的描述建立起一個多層級的記憶。具體而言,EgoGPT對每30秒視頻的描述會被存入記憶庫中作為細粒度記錄,同時系統會定期將一段時間內的描述匯總生成更高層次的摘要。例如,它可以把每小時的主要事件總結成一段概要,再把每天的概要進一步凝練成更粗的日記。

如此一來,EgoRAG的記憶庫中同時保存著片段級別、小時級別和天級別的多層次信息。這種分層結構讓系統能夠先粗略定位大致相關的時間范圍,再深入檢索具體片段,就像人類回憶事情時也會先想是哪一天、隨后細想當時的細節一樣。

智能檢索策略

當用戶提出一個問題時,EgoRAG會啟動兩階段的檢索機制。第一步,它會先在高層次的摘要中搜索線索,找出這個問題最可能涉及的是哪一天、哪一段時間。

例如,若用戶問「我這周哪天吃了意大利面?」,系統會先掃描每天的摘要,發現「周二晚餐」提到了意大利面。第二步,在鎖定相關的時間段后,EgoRAG會在該時間段內更精細地檢索具體的片段描述。

最終,EgoRAG會挑選出最相關的若干視頻片段作為支撐證據,將這些檢索到的相關內容發送給一個生成式模型(可以是EgoGPT本身或類似GPT-4的更強大模型),讓它基于證據來生成回答。

通過這樣的分層檢索與生成,EgoRAG能夠在浩如煙海的個人記錄中迅速定位答案要點,并確保回答所依據的信息可靠且有據可循。

高效且可擴展

EgoRAG的設計使得對超長視頻的問答變得計算上可行。相比樸素地將幾百小時的視頻硬塞給一個大模型(這幾乎不可能),EgoRAG極大地縮小了需要處理的數據范圍,每次問答只聚焦于可能相關的極小片段集合。

這種「提取式記憶」不僅提高了效率,也讓系統具備了可擴展性——無論積累了多少天的記錄,檢索的成本都在可控范圍。

此外,由于EgoRAG把視頻內容轉化為了文本和特征空間的表示進行搜索,它可以方便地持續更新記憶庫(EgoGPT不斷產生新記錄),并長久保留舊有知識,正如一個理想的生活管家,不僅能記住你昨天做過什么,幾年后的今天依然能快速翻出相關回憶供你查詢。

綜合來看,EgoRAG賦予了EgoLife助理真正的長時記憶和知識提取能力。當用戶詢問諸如「我這瓶酸奶是什么時候買的?」這樣需要跨天甚至跨周的信息時,EgoRAG能夠在龐大的回憶庫中找到相關證據,并配合EgoGPT給出答案。

例如,基于檢索到的證據,模型可能回答:「您分別在3天和5天前去過超市,這一瓶是在您五天前那一次購物采購的,您當時和其他幾瓶酸奶比價,最終選擇了這個,花了五塊錢」。

這里列舉5個實際場景的例子。

未來計劃

拓展數據維度,構建更通用的智能認知

目前基于6人單語言環境的數據已經展現出很強的潛力,而下一步,研究人員希望讓它走向更廣闊的世界。

通過引入多語言交流(如純英文、西班牙語等)、長期生活記錄以及不同家庭結構的數據,系統可以減少個體經驗的局限,建立更具普遍適用性的認知模型,不僅能讓AI更準確地理解不同文化背景下的人類行為,也能提升個性化服務的跨場景適應能力。

讓AI從「記錄」走向「推理洞察」

當前的EgoGPT+EgoRAG體系其實是一個基礎的框架,目前也有很多不完美的地方,例如對于人的辨認依然不穩定,對于語音的識別可能還停留在人的對話上,對于重要的環境聲尚且還沒有識別。在增強AI識別的精度的基礎上,研究人員還希望利用推理框架對目前方法進行重構,將長視頻搜索變得更加智能。

多視角協同,重塑環境認知

當前的數據集是一個多人同步、多視角協作的數據網絡,通過第一視角(佩戴式設備)、第三視角(固定攝像頭)、以及3D房屋模型的融合,可以解鎖更多的功能探索。

例如AI可以利用多視角視頻流和3D坐標,還原某個時間點的完整場景。例如,當用戶問「上周三客廳發生了什么?」系統可以自動結合空間信息,生成帶有完整場景語義的敘述。

展望:隱私保護

因為生活助理涉及持續記錄個人隱私數據,如何安全地存儲、處理這些信息至關重要。未來的系統需要在本地化(盡量在用戶設備上處理數據)和隱私保護算法(如差分隱私、聯邦學習)上加大投入,確保用戶的數據僅為用戶所用。只有解決了隱私顧慮,公眾才能真正安心地擁抱這樣全天候的AI助手。

開發團隊

EgoLife不僅僅是一個研究項目,更是一場關于 AI 如何真正融入人類日常生活的探索。

未來的AI生活助手不僅能理解用戶的行為、記住關鍵細節,還能主動提供幫助,讓科技成為每個人生活中不可或缺的伙伴。

這是一項長期演進的計劃,研究團隊正在不斷擴展數據規模、優化AI模型、探索新的交互方式,并推動AI生活助手的真正落地。