小模型的意見也有用!GPT-4+AutoGPT在線決策:買東西再也不用糾結了

這篇論文通過對真實世界決策任務中的Auto-GPT代理進行了全面的基準研究,探索了大型語言模型(LLM)在決策任務中的應用。

論文鏈接:https://arxiv.org/pdf/2306.02224.pdf

作者比較了多種流行的LLM(包括GPT-4,GPT-3.5,Claude和Vicuna)在Auto-GPT決策任務中的表現,并引入了一種名為「額外意見」的新算法,該算法可以將小的專家模型融入到Auto-GPT方案中,從而提高了任務性能。

作者觀點

在這一研究中最有趣的發現是大語言模型,尤其是GPT4有了類似于人類的能力,可以從不同的意見中提取有用信息,進行思考和批判然后提高自己的結果。

那么問題來了,GPT是怎么受益于不同意見的呢?

人類的心理學研究過一些人類受益于不同意見的方式以及一些模式,比如人類會給有權威的意見更多的權重,會傾向于忽略極少數的個別意見,會給自己的意見過多的權重,通常三到六個意見就足夠了等等。

這個方向還值得很多后續的研究,比如現在我們是用一個小的專家模型來提供不同意見,如果讓大模型們互相爭論呢?

主要貢獻

1.首次展示Auto-GPT可以輕松適應與真實世界場景密切相似的在線決策任務。

2.提供了流行LLM(包括GPT-4, GPT-3.5,Claude和Vicuna)之間的全面基準比較。我們提出了關于這些模型適用于自主代理的發現。

3. 證明了從小的專家模型那里獲得的第二意見可以顯著提高任務性能。這可以成為為在不進行模型微調的情況下將監督信號引入Auto-GPT的一種新的方法。

實驗設置

提示設計

在沒有進行大規模調優的情況下,我們將任務需求或問題直接作為Auto-GPT的目標,適配了Auto-GPT進行各項任務。

比如輸入像「I want to purchase a folding storage box that is easy to install, made of faux leather, and has dimensions of 60x40x40cm」的句子。

為了幫助Auto-GPT理解可用的行動,我們將每個行動表現為一個工具。

值得注意的是,在沒有示例的情況下,僅使用工具指令的效果較差。然而,只要有少量的示例,性能就會顯著提高。因此,我們在工具演示中包括一到三個few-shot示例,以利用LLM的上下文學習能力。

考慮額外意見

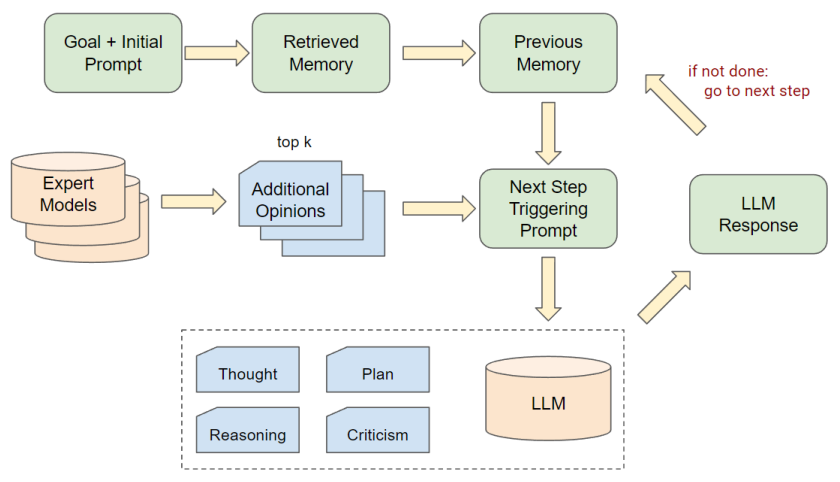

我們進一步改進了Auto-GPT的工作流,以便考慮來自外部專家模型的額外意見。

具體來說,在Auto-GPT的決策階段,我們從專家模型中抽樣出前k個意見,并將這些意見放入提示的上下文部分,以供大語言模型參考。

在這項工作中,我們簡單地使用了對于每個任務都已經準備好的IL模型作為外部專家。

提供給LLM額外意見的提示遵循這樣的模板:‘Here’s one(a few) suggestion(s) for the command: Please use this suggestion as a reference and make your own judgement. ’

Webshop實驗設置:

Webshop是一個模擬網購環境,從http://Amazon.com上抓取超過118萬個產品。

該環境提供了如搜索、點擊、導航、購買等真實的行動空間。

評估過程主要看是否成功購買了描述的產品,需要產品、屬性、選項和價格全都匹配。

基線模型是采用模仿學習(IL)方法的模型,它的動作策略組件已經過微調。這個基線模型將與采用Auto-GPT方式運行的大語言模型進行比較。

ALFWorld實驗設置

ALFWorld是一個研究環境,結合了復雜的任務導向和語言理解。該環境包含超過25000個獨特的、程序生成的任務,涵蓋廚房、客廳、臥室等真實環境。

這些任務需要復雜的解決問題的能力和對語言及環境的深入理解。初始評估使用模仿學習(IL)的DAgger代理進行,然后與采用Auto-GPT風格的生成語言模型進行比較。

實驗結果

直接比較結果

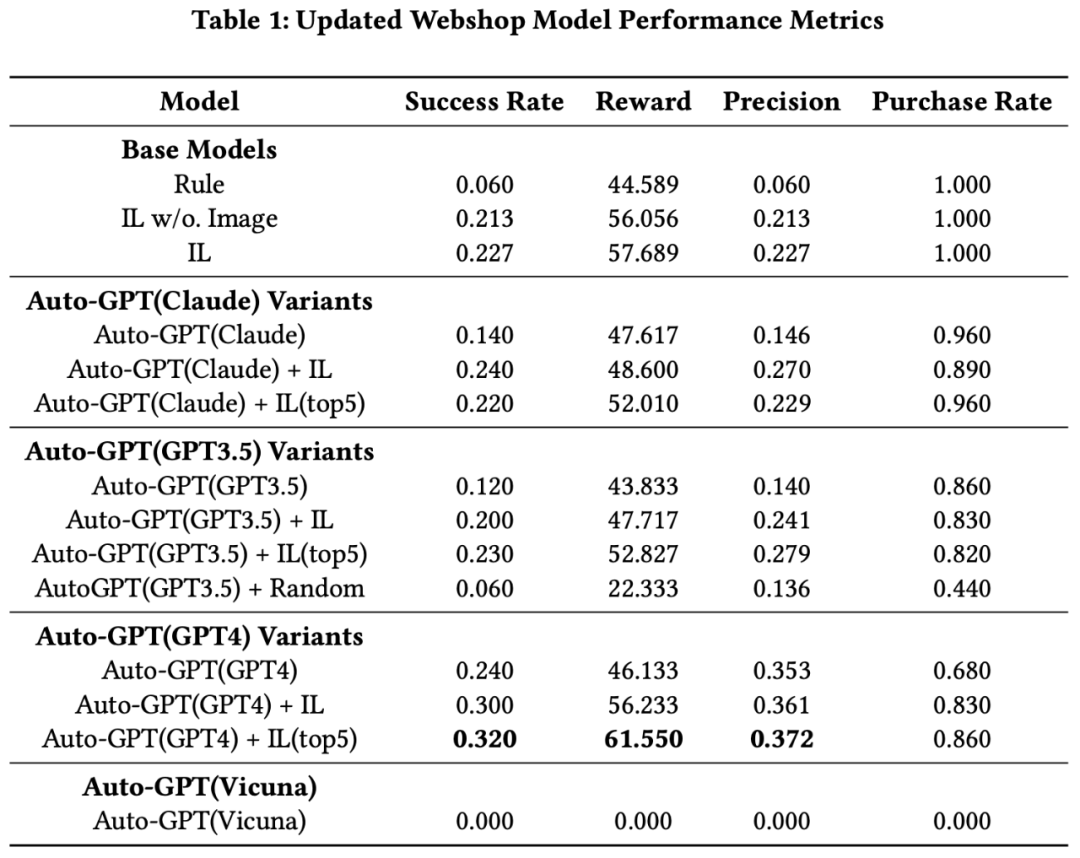

本研究主要通過運行Webshop和ALFWorld兩種實驗,比較了不同的大型語言模型(Large Language Models,LLMs)和模仿學習(Imitation Learning,IL)模型在AutoGPT配置中的表現。

首先,Webshop試驗中,GPT4表現出色,其性能超過了其他IL模型。盡管無圖像輸入的原始IL模型僅取得了適度的成功率,但是加入了圖像輸入的IL模型表現更好。

然而,只使用GPT3.5或Claude的Auto-GPT代理表現不如原始IL模型,但是,GPT4本身的性能優于所有IL模型。

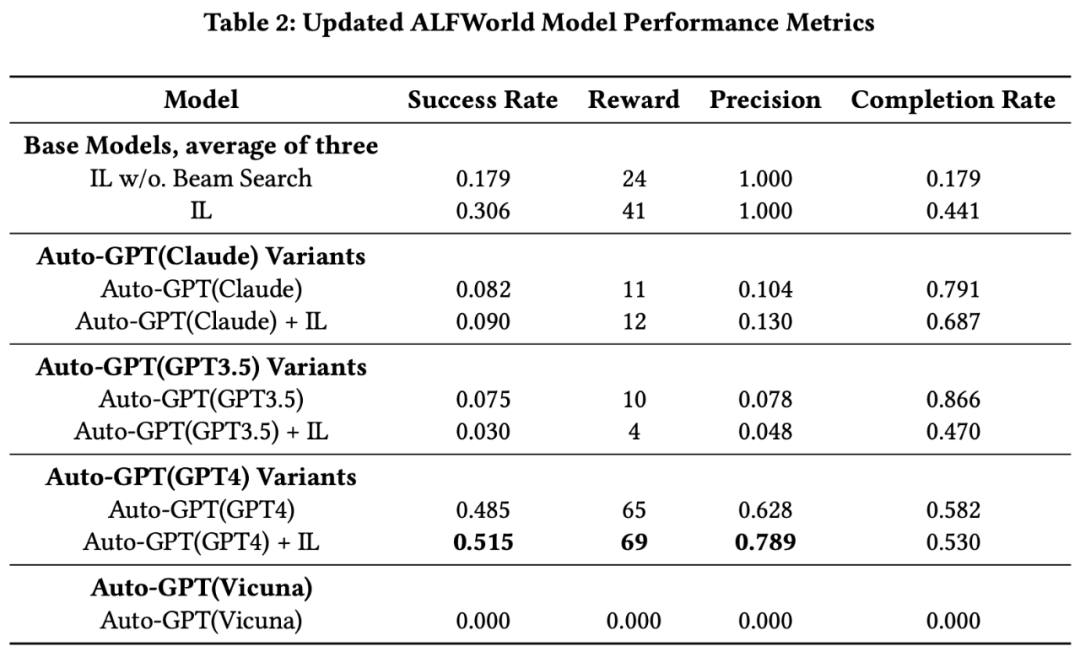

其次,在ALFWorld實驗中,IL模型與Beam Search的組合顯著優于無Beam Search的版本。而在AutoGPT設置中運行的Claude和GPT3.5的性能均未超越IL模型,但GPT4明顯超越了IL模型的性能,無論是否使用Beam Search。

此外,我們提出了一種新的研究模式,將大型語言模型(LLMs)與專家模型結合起來。

首先從專家模型中采樣出前k個附加觀點,然后將這些觀點呈現給LLMs,讓它們考慮這些觀點并做出最后的決定。這種方法在GPT4上表現得特別好,這表明GPT4在考慮來自多個弱學習模型的觀點時,可以提高其性能。

總的來說,GPT4在所有模型中表現出了最佳的性能,并且能夠有效地利用專家模型的建議來提高其決策能力。

我們推薦使用GPT4,因為它在考慮了其他模型的觀點后,其決策性能顯著提高。最后Abaltion Study證明了這些額外意見必須是有一點價值的,隨機的意見并沒有任何幫助,見AutoGPT(GPT3.5) + Random

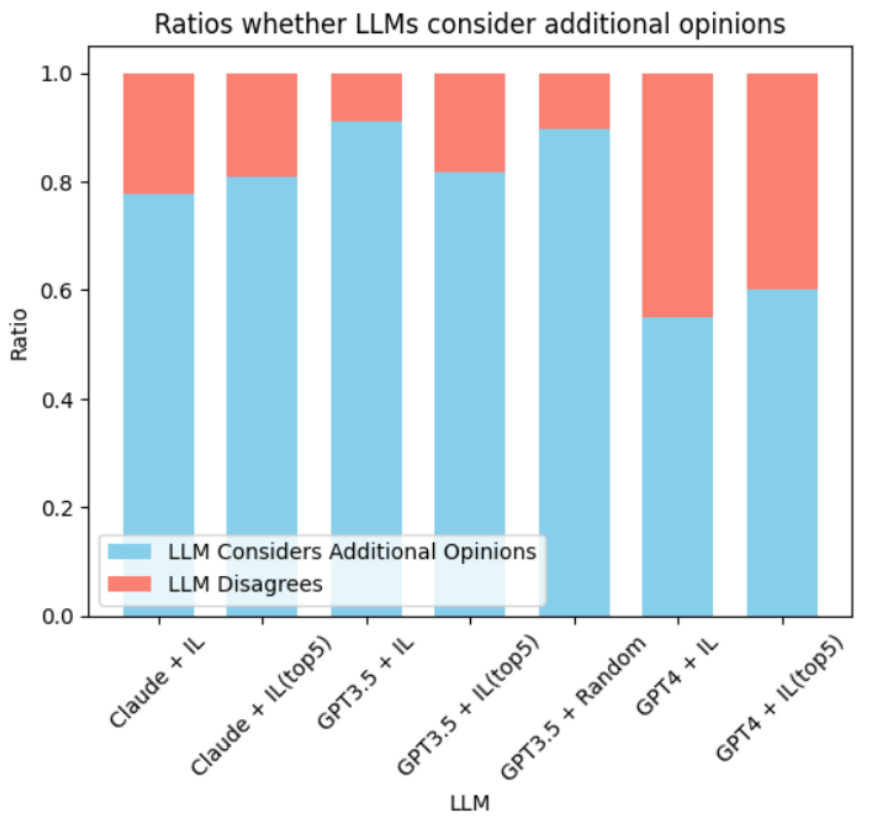

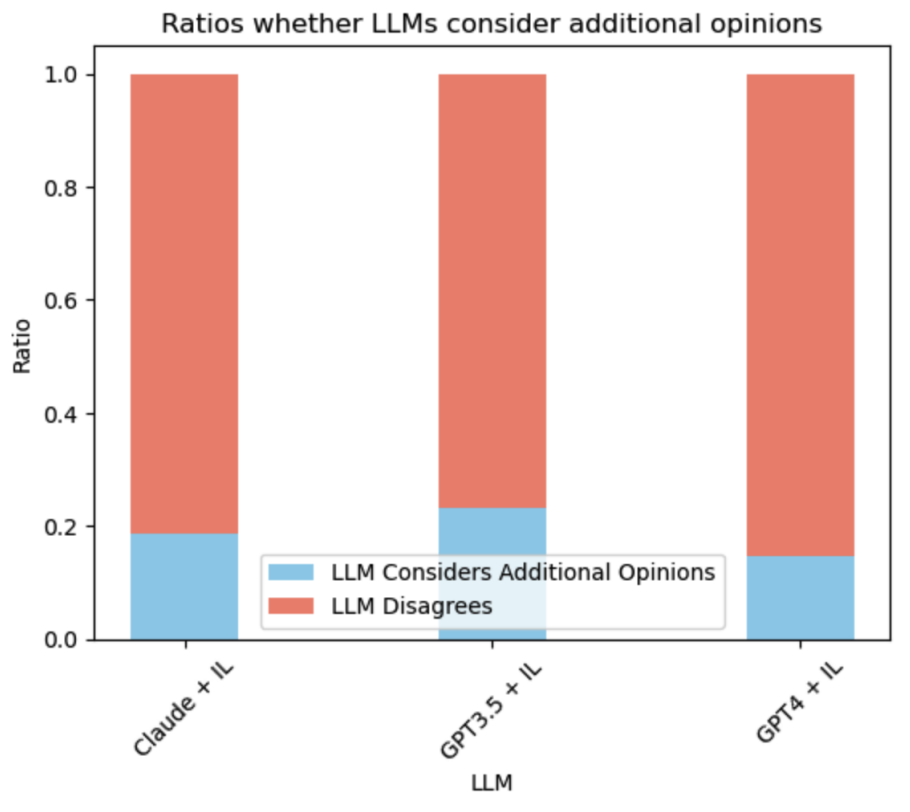

采用額外意見比例

在我們的實驗中,我們發現GPT-4模型在處理額外意見時表現出極高的辨別能力。即使在信息噪聲中,GPT-4也能區分出有益和無關的建議。

而GPT-3.5模型在面對可能導致混淆的輸入時,表現出了明顯的劣勢。總的來說,LLM與額外意見的一致性或不一致性,很大程度上取決于LLM的理解能力和額外意見的質量。