一文概述聯邦持續學習最新研究進展

由于數據隱私限制,多個中心之間的數據共享受到限制,這就影響了聯邦學習架構下多中心合作開發高性能深度學習模型的效果。持續學習(Continual Learning)作為點對點聯合學習的一種方法,可以通過共享中間模型而不是訓練數據來繞過數據隱私的限制,從而促進多中心協作開發深度學習算法。近期不斷有研究人員探索聯邦持續學習方法(Federated Continual Learning,FCL),即,研究持續學習在聯邦學習架構下多中心協作的可行性。

1、背景回顧

1.1 持續學習 (Continual Learning)

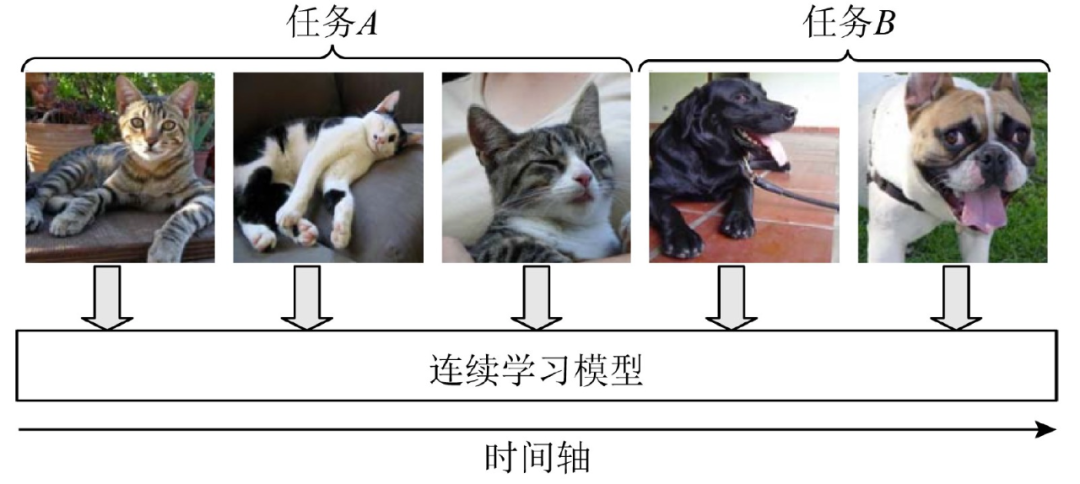

首先,我們來回顧一下什么是持續學習。當前,一般認為持續學習 (Continual Learning) 和增量學習(Incremental Learning)、終身學習 (Lifelong Learning) 是等價表述,它們都是在連續的數據流中訓練模型,隨著時間的推移,更多的數據逐漸可用,同時舊數據可能由于存儲限制或隱私保護等原因而逐漸不可用,并且學習任務的類型和數量沒有預定義 (例如分類任務中的類別數)。

當一個模型在新的數據集或任務上被重新訓練時,深度學習會遇到災難性遺忘的問題,即深度學習模型會災難性地遺忘已經學到的舊知識。持續學習技術的目的是讓機器學習模型通過新的數據進行更新,同時保留以前學到的知識。持續學習具有兩大優點:1) 不需要保存之前任務上學習過的訓練數據,從而在節約內存的同時解決了由于物理設備 (例如機器內存 ) 或學習策略 (例如隱私保護 ) 的限制所導致的數據不能被長期存儲問題;2) 模型能夠保存之前任務所學到的知識,并且能夠極大程度地將之前任務學習到的知識運用到未來任務的學習中,從而提高學習效率。

目前,持續學習的方法仍在不斷發展中,還沒有嚴格的數學定義。韓等在文章 [1] 中給出了一幅持續學習的示意圖,如圖 1 所示,“在連續學習過程中,智能體逐個對每個連續的非獨立均勻分布流數據示例進行學習,并且該智能體對每個示例只進行一次訪問。這種學 習方式與動物學習過程更為接近。如果我們忽略各個任務的先后次序問題,單獨訓練每個任務,這將導致災難性遺忘,這也是連續學習一直以來所面臨的最大問題。因此,連續學習的本質是通過各種手段高效地轉化和利用已經學過的知識來完成新任務的學習,并且能夠極大程度地降低遺忘帶來的問題。[1]”。

圖 1. 連續學習示意圖 [1]

到目前為止,已經有許多持續學習算法,主要分為三種類型:回放方法(Memory Reply)、動態結構模型(Dynamic Structural Models)和正則化方法(Regularization Model)。1)回放方法從以前的數據集中選擇有代表性的樣本,以保留所學的知識。該方法的研究重點是:「要保留舊任務的哪部分數據,以及如何利用舊數據與新數據一起訓練模型」,這對于克服數據存儲的限制是可行的,但對于多中心合作來說是不可行的,因為由于數據隱私問題,其他中心的樣本是不可用的 [6-8]。2)動態結構模型為多任務場景設計動態網絡架構或動態參數,網絡的各個部分(如某些權重或某些神經元連接)負責對應的各個任務 [9][10]。3)正則化方法使用相同的傳統神經網絡,但在損失函數中加入了新的正則化項,以保留學習知識的重要參數。該方法的主要思想是「通過給新任務的損失函數施加約束的方法來保護舊知識不被新知識覆蓋」[11][12]。

1.2 聯邦持續學習 (Federated Continual Learning)

聯邦學習的主要思想是去中心化,將模型下放到各個參與聯合訓練的客戶端本地,基于本地客戶端的數據進行模型訓練,而不需要將用戶數據上傳到中央服務器,從而保護各個客戶端中的隱私。然而,大多數現有方法假設整個聯邦學習框架的數據類別隨著時間的推移是固定不變的。實際情況中,已經參與聯邦學習的客戶端經常可能收集到新類別的數據,但考慮到每個客戶端本地設備的存儲空間非常有限,很難對其收集到的所有類別都保存下足夠數量的數據,這種情況下,現實世界中的聯邦學習模型很可能對于舊類數據的性能遇到嚴重的災難性遺忘。此外,聯邦學習框架往往還會有持續不斷的新用戶的參與,這些新用戶往往有著大量的新數據類別,這樣會進一步加劇全局模型的災難性遺忘。

近年來,有研究人員陸續提出將聯邦學習和持續學習的思想結合起來構建聯邦持續學習框架。然而,直接簡單的將聯邦學習和持續學習相結合會帶來新的問題。首先是,聯邦持續學習仍然面臨災難性遺忘,此外還會帶來來自其他客戶端潛在的干擾。因此我們需要有選擇地利用來自其他客戶端的知識,以最小化客戶端間的干擾,最大化進行客戶端間的知識轉移。第二個問題是聯邦學習之間進行通信交換知識時,可能會造成通信成本過大,“通信代價” 成為了一個不可忽視的問題。

我們通過四篇近期發表的文章概覽聯邦持續學習的最新研究進展。

- 第一篇文章提出了一個新的聯邦持續學習框架 —— 聯邦加權客戶端間的傳輸(FedWeIT)。FedWeIT 將各個客戶端的本地模型參數分解為稠密基參數(a dense base parameter)和稀疏的任務自適應參數( sparse task-adaptive parameters),以便進行更高效地通信 [2]。

- 第二篇文章提出了一種全新的全局 - 本地遺忘補償 (GLFC) 模型,即同時從全局和本地兩個角度出發,盡可能地減弱災難性遺忘,使得聯邦學習最終可訓練一個全局增量模型 [3]。

- 第三篇文章提出了一種聯邦互相關和持續學習方法。對于異構性問題,該方法利用未標記的公共數據進行通信,并構造互相關矩陣來學習域偏移(domain shift)下的可概括性的表示。同時,對于災難性遺忘,在本地更新中利用跨域和本域信息進行知識蒸餾,有效地提供域間和域內知識而不泄露參與者的隱私 [4]。

- 第四篇文章提出了一個聯邦學習架構,稱為聯邦多語者 TTS 系統 Fed-Speech。該架構使用漸進式修剪掩碼來分離參數,以保留說話人的語調。此外,應用選擇性掩碼來有效地重用任務中的知識。最后,引入 private speaker embedding 以保持用戶的隱私 [5]。

2、Federated Continual Learning with Weighted Inter-client Transfer

持續學習和聯邦學習在現實世界的深度神經網絡中都很重要。然而,對于每個客戶端從私有的循環數據流中學習一連串任務的情況,卻很少有人進行研究。這種聯邦學習的問題給持續學習帶來了新的挑戰,比如,如何有效利用其他客戶端的知識同時防止不相關知識的干擾?為了解決這些問題,本文提出了一個新穎的聯邦持續學習框架,即聯邦加權客戶端間傳輸(Federated Weighted Inter-client Transfer,FedWeIT),該框架將網絡工作權重分解為全局的聯邦參數( global federated parameters)和稀疏的特定任務參數( sparse task-specific parameters),每個客戶端可以通過對其特定任務參數進行加權組合,從其他客戶端那里獲得選擇性知識。具體是通過中央服務端獲得其他客戶端的 task-specific parameters,再對這些參數進行加權聚合得到 selective knowledge,從而最大化相似任務之間共識知識的傳遞。FedWeIT 最大限度地減少了不兼容任務之間的干擾,并且在學習過程中允許客戶端之間的積極知識轉移。

作者將 Fed-WeIT 與現有的聯邦學習和連續學習方法在不同程度的客戶端之間的任務相似性進行了驗證,本文模型明顯較優,通信成本大大降低。代碼已公布在 https://github.com/wyjeong/FedWeIT。

2.1 方法介紹

受人類從間接經驗中學習過程的啟發,作者引入了一種新的聯邦學習環境下的持續學習 --- 聯邦持續學習(Federated Continual Learning,FCL)。FCL 假設多個客戶端在私有數據流中的任務序列上進行訓練,同時與中央服務器交互所學到的參數。在標準的持續學習中(在一臺機器上),模型從一連串的任務 {T (1),T (2),...,T (T)} 中反復學習,其中 T (t) 是第 t 個任務的標記數據集。假設現實情況如下,任務序列是一個具有未知到達順序的任務流,這樣,模型只能在任務 t 的訓練期訪問 T (t),之后就無法訪問了。給定 T (t) 和到目前為止學到的模型,任務 t 的學習目標如下:

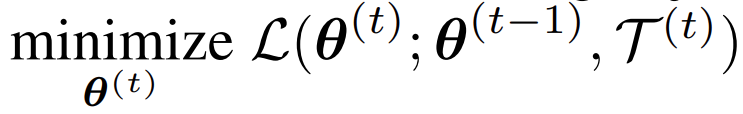

然后,將傳統的持續學習擴展到有多個客戶端和一個中央服務器的聯邦學習環境。假設有 C 個客戶端,每個客戶端 c_c∈{c_1, . . . , c_C } 在一個私人可訪問的任務序列 {T^(1)_c , T^(2)_c , ..., T^(t)_c }? T 上訓練一個模型。需要注意的是,在步驟 t 收到的跨客戶端任務之間沒有關系。

現在的目標是通過與中央服務器溝通模型參數,有效地在他們自己的私有任務流上訓練 C 類持續學習模型,中央服務器匯總每個客戶端發送的參數,并將它們重新分配給客戶端。在聯邦持續學習框架中,將參數匯總為一個全局參數 θ_G,允許客戶端間的知識轉移,因為客戶端 c_i 在第 q 輪學到的任務可能與客戶端 c_j 在第 r 輪學到的任務相似或相關。然而,作者分析使用單一的綜合參數 θ_G 可能是實現這一目標的次優選擇,因為來自不相關任務的知識可能沒有用處,甚至可能會通過將其參數改變到不正確的方向來阻礙每個客戶端的訓練,作者將此描述為客戶端間的干擾。

另一個實際上也很重要的問題是通信效率。從客戶端到中央服務器,以及從中央服務器到客戶端的參數傳輸都會產生很大的通信成本,這對于持續學習環境來說是有問題的,因為客戶端可能會在無限的任務流上進行訓練。如前所述,造成這些問題的主要原因是,在多個客戶端學到的所有任務的知識被存儲在一組參數 θ_G 中。然而,為了使知識轉移有效,每個客戶端應該有選擇地只利用在其他客戶端訓練的相關任務的知識。這種選擇性轉移也是最小化客戶端間干擾的關鍵,因為它不考慮可能干擾學習的不相關任務的知識。

作者通過分解參數來解決這個問題,這些參數分為三種不同的類型,具有不同的作用:全局參數(θ_G),捕獲所有客戶端的全局和通用知識;本地基礎參數(B),捕獲每個客戶端的通用知識;任務適應性參數(A),用于每個客戶端的每個具體任務。將一組在持續學習客戶端 c_c 的任務 t 的模型參數 θ^(t)_c 定義如下:

其中,B^(t)_c 是第 c 個客戶端的基本參數集,在客戶端的所有任務中共享。m^(t)_c 是稀疏向量掩碼的集合,它允許對任務 t 的 B^(t)_c 進行適應性轉換,A^(t)_c 是客戶端 c_c 的稀疏任務適應性參數集合。L 是神經網絡中的層數,I_l、O_l 分別是第 l 層權重的輸入和輸出維度。

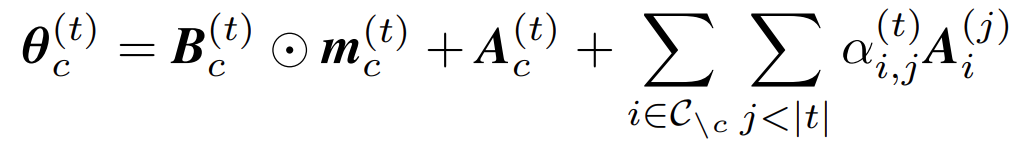

上式中的第一項允許有選擇地利用全局知識。作者希望每個客戶端的基礎參數 B^(t)_c 能夠捕獲所有客戶端的所有任務中的通用知識。如圖 2(a),在每一輪 t 中用前一次迭代的全局參數 θ^(t-1)_G 來初始化,匯總從客戶端發送的參數。這使得 B^(t)_c 也能從關于所有任務的全局知識中受益。然而,由于 θ^(t-1)_G 也包含與當前任務無關的知識,我們不是原封不動地使用它,而是學習稀疏掩碼 m^(t)_c,只為給定的任務選擇相關參數。這種稀疏的參數選擇有助于最大限度地減少客戶端之間的干擾,從而實現高效的通信。上式中的第二項是任務適應性參數 A^(t)_c。對參數進行加法分解處理后,能夠學會捕捉第一項沒有捕捉到的關于任務的知識,因此將捕捉到關于任務 T^(t)_c 的具體知識。上式中的最后一項描述了加權的客戶端間知識轉移。我們擁有一組從中央服務器傳輸的參數,其中包含了所有客戶端的所有任務適應性參數。為了有選擇地利用這些來自其他客戶端的間接經驗,進一步在這些參數上分配注意力 α^(t)_c,并采取加權組合的方式。通過學習這種注意力,每個客戶端可以只選擇有助于學習給定任務的相關任務適應性參數。盡管作者將 A^(j)_i 設計成高度稀疏的,在實踐中使用大約 2-3% 的全參數內存,但發送所有的任務知識仍然是不可取的。因此,作者選擇從知識庫中傳輸所有時間步驟的隨機抽樣的任務適應性參數,根據經驗,作者發現這種處理方式在實踐中取得了良好的效果。

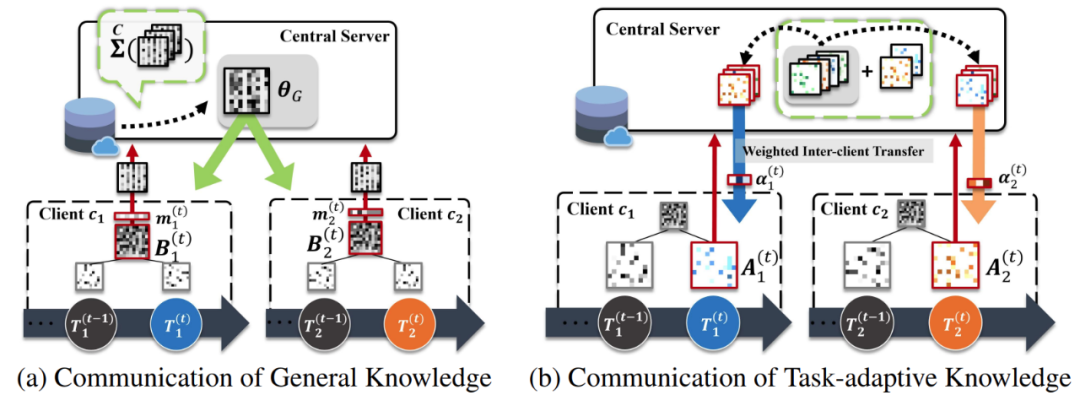

圖 2. FedWeIT 更新。(a) 客戶端發送稀疏化的聯邦參數 B_c ⊙m^(t)_c 。之后,中央服務器將聚合的參數重新分配給客戶端。(b) 知識庫存儲了客戶端先前的任務適應性參數,每個客戶端有選擇地利用這些參數,并有一個注意力掩碼訓練。我們通過優化以下目標函數來學習可分解參數 θ^(t)_c:

其中,L 是損失函數,?(?) 是所有任務自適應參數和掩碼變量的稀疏性誘導正則化項,以使它們變得稀疏。第二個正則化項用于追溯更新過去的任務適應性參數,通過反映基礎參數的變化,幫助任務適應性參數保持目標任務的原始解決方案。?B^(t)_c 是指當前時間段和前一個時間段的基礎參數之差。?A^(i)_c 是任務 i 在當前和前一時間段的任務適應性參數之間的差異。這種正則化處理對于防止災難性的遺忘至關重要。λ1 和 λ2 是控制兩個正則化作用的超參數。

客戶端。在每個輪次 r,每個客戶端 c_c 用中央服務器發送的全局參數的非零分量部分更新其基礎參數;也就是說,B_c (n) = θ_G (n),其中,n 是全局參數的非零元素。它為新任務獲得一個稀疏的基礎參數 ^Bb^(t)_c 和任務適應性參數 A^(t)_c,將這兩個參數發送到中央服務器,與 FCL 基線方法相比,成本更低。FCL 基線方法需要 | C|×R×|θ| 的資源用于客戶端到中央服務器的通信,而 FedWeIT 需要 | C|×(R×|Bb|+|A|),其中 R 是每個任務的通信輪數,|?| 是參數數量。

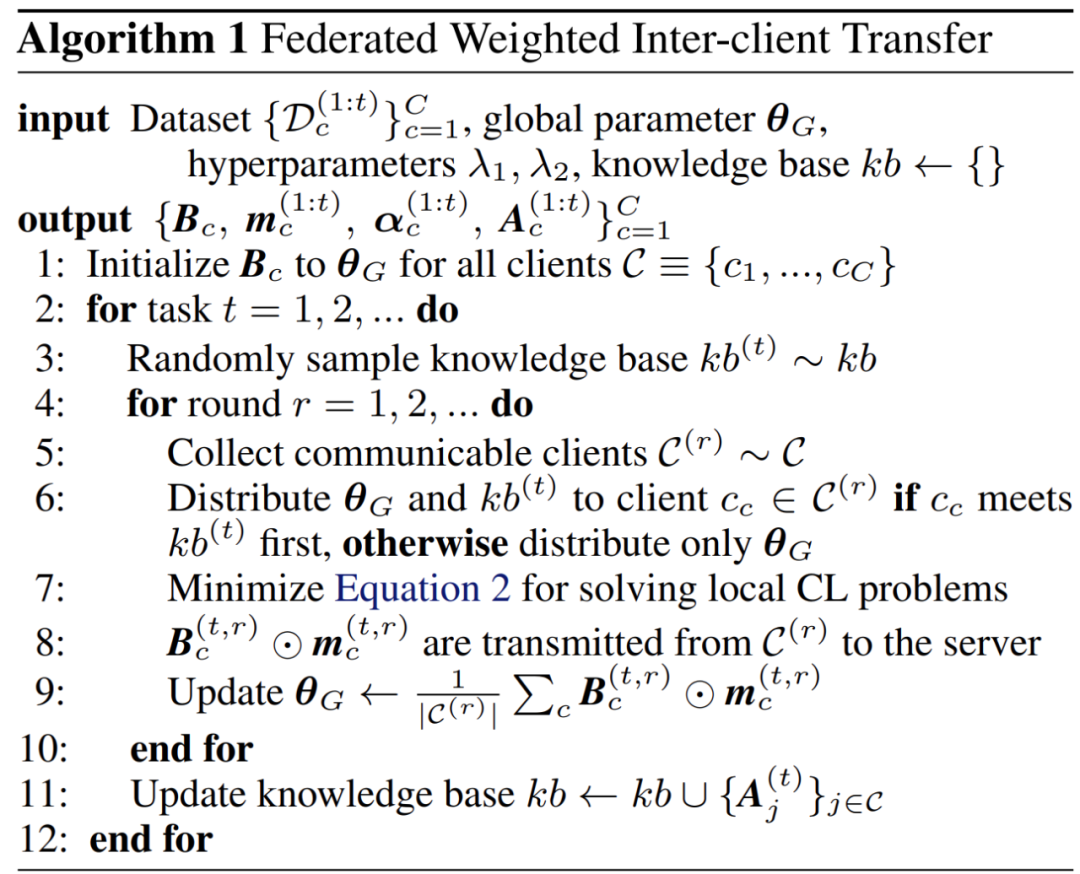

中央服務器。中央服務器首先對所有客戶端發送的基礎參數進行匯總,取其加權平均值 θ_G。然后,將 θ_G 廣播給所有客戶端。t-1 的任務適應性參數在訓練任務 t 期間在每個客戶端廣播一次。FCL 基線需要 | C|×R×|θ| 的中央服務器 - 客戶端通信成本,而 FedWeIT 需要 | C|×(R×|θG|+(|C|-1)×|A|),其中 θ_G、A 是高度稀疏的。算法 1 中描述了 FedWeIT 的算法。

2.2 實驗情況介紹

作者驗證了 FedWeIT 在不同的任務序列配置下與基線方法(Overlapped-CIFAR-100 和 NonIID-50)的對比。1) Overlapped-CIFAR-100:將 100 個 CIFAR-100 數據集類分組為 20 個 NonIID 超類任務。然后,從 20 個任務中隨機抽取 10 個任務并拆分實例,為每個任務重疊的客戶端創建一個任務序列。2) NonIID-50:使用以下八個基準數據集:MNIST、CIFAR-10/-100、SVHN、Fashion MNIST,Not MNIST 和 TrafficSigns。將 8 個數據集中的類劃分為 50 個 NonIID 任務,每個任務由 5 個類組成,這些類與用于其他任務的類不相交。

實驗中用到的對比模型如下:1)STL:單任務學習每個到達的任務。2) EWC:每個客戶端進行個人持續學習。3) Stable-SGD:每個客戶端持續學習 Stable-SGD。4) APD:每個客戶端使用 APD 進行個人持續學習。5) FedProx:使用 FedProx 算法的 FCL。6) Scaffold :使用 Scaffold 算法的 FCL。7) FedCurv:使用 FedCurv 算法的 FCL。8) FedProx-[model]:使用帶有 [model] 的 FedProx 算法進行訓練的 FCL。9) FedWeIT:FedWeIT 算法。

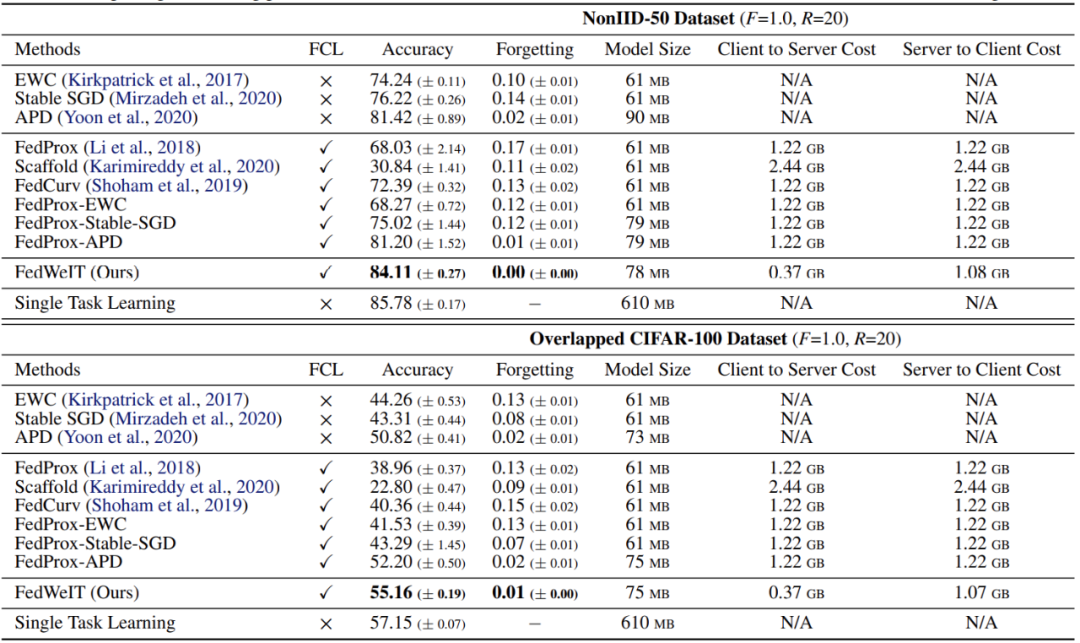

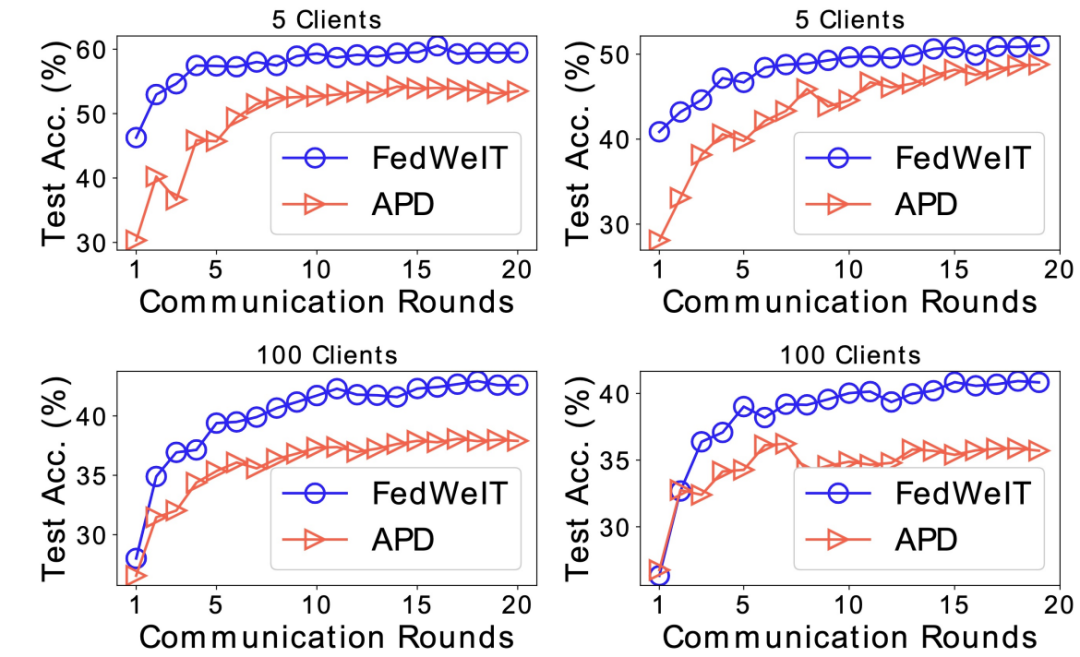

表 1 給出了在兩個數據集上完成(聯邦)連續學習后,每項任務的最終平均性能。我們觀察到,基于 FedProx 的 FCL 方法與沒有聯邦學習的相同方法相比,會降低連續學習(CL)方法的性能。這是因為在不相關的任務中學習的所有客戶端參數的匯總導致了對每個任務學習的嚴重干擾,這導致了災難性的遺忘和次優的任務適應性。Scaffold 在 FCL 上的表現很差,因為它對本地梯度的正則化處理對 FCL 是有害的,因為所有的客戶端都是從不同的任務序列中學習的。雖然 FedCurv 減少了任務間的參數差異,但它不能最大限度地減少任務間的干擾,這導致它的表現不如單機 CL 方法。另一方面,FedWeIT 在兩個數據集上的表現都明顯優于單機 CL 基線和 FCL 基線。即使有更多的客戶端(C = 100),FedWeIT 也一直優于所有基線(圖 3)。這種改進主要歸功于 FedWeIT 有選擇地利用其他客戶端的知識來迅速適應目標任務的能力,并獲得更好的最終性能。

表 1. 5 個客戶端在 FCL 期間對兩個數據集的平均每任務表現(分數 = 1.0)。在完成所有學習階段的 3 次單獨試驗后,作者測量了任務準確性和模型大小。作者還測量了訓練每個任務的 C2S/S2C 通信成本

圖 3. 訓練最后兩個(第 9 和第 10 個)任務時的平均任務適應性,有 5 個和 100 個客戶端

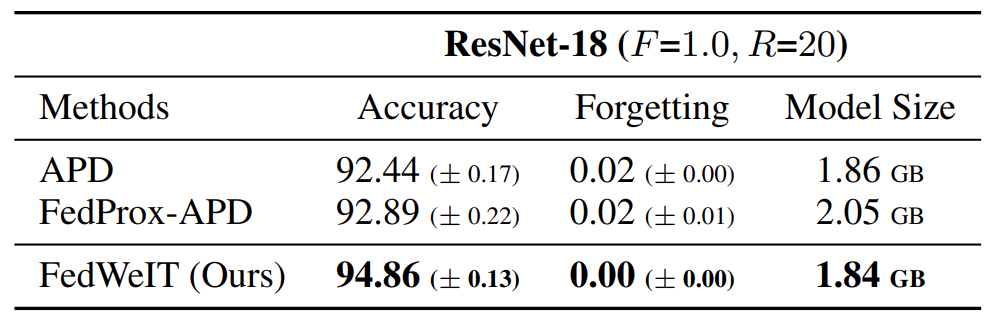

對新任務的快速適應是客戶端間知識轉移的另一個明顯優勢。為了進一步證明本文方法在更大的網絡中的實用性,作者在 ResNet-18 的 NonIID 數據集上進行了實驗(表 2),FedWeIT 在使用較少參數的情況下仍然明顯優于最強基線(FedProx-APD)。

表 2. 使用 ResNet-18 在 NonIID-50 數據集上的 FCL 結果

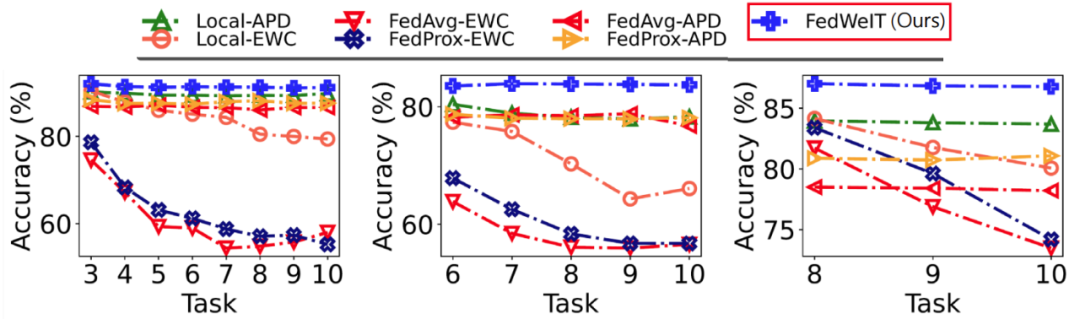

此外,作者研究了在持續學習過程中過去任務的表現如何變化,以了解每種方法的災難性遺忘的嚴重程度。圖 4 給出了 FedWeIT 和 FCL 基線在第 3、第 6 和第 8 個任務上的表現。我們觀察到,FCL 基線比帶有 EWC 的本地持續學習遭受了更嚴重的災難性遺忘,這是因為客戶端間的干擾,來自其他客戶端的不相關任務的知識覆蓋了過去的任務知識。與此相反,本文模型沒有顯示出災難性遺忘的跡象。這主要是由于選擇性地利用了通過全局 / 任務自適應參數從其他客戶端那里學到的先驗知識,這使得它能夠有效地緩解客戶端間的干擾。FedProx-APD 也不存在災難性遺忘的問題,但由于知識轉移的無效性,它們的性能較差。

圖 4. 災難性遺忘。在 NonIID-50 的聯邦持續學習過程中,在第 3、6 和 8 個任務中關于當前任務適應性的性能比較

3、Federated Class Incremental Learning

3.1 本地災難性遺忘補償

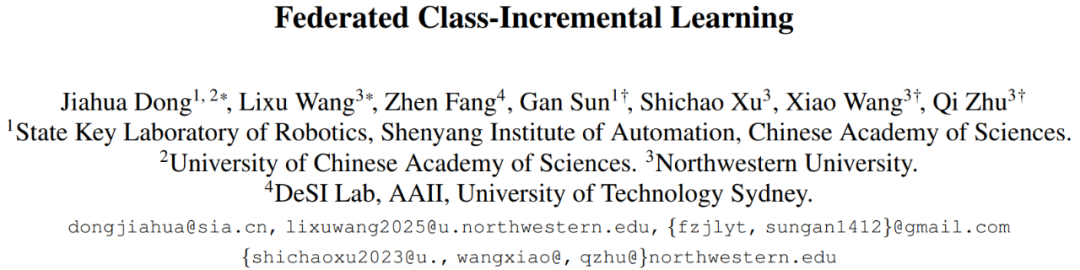

通過在分散的客戶端上進行數據私有的協作訓練,聯邦學習吸引了越來越多的關注。然而,大多數現有的方法假設整體框架的對象類別是固定的。這使得全局模型在現實世界的場景中遭受了嚴重的災難性遺忘,因為本地客戶端經常不斷地收集新的類別,而用于存儲舊的類別的存儲空間非常有限。此外,存有之前未見過的新類別數據的新客戶端可能參與 FL 訓練,這就進一步加劇了全局模型的災難性遺忘。為了應對這些挑戰,本文提出了一個新的全局 - 本地遺忘補償(Global-Local Forgetting Compensation,GLFC)模型,從本地和全局的角度學習一個全局類別增量模型來緩解災難性遺忘。作者表示,這是第一次嘗試在 FL 設置中學習全局類增量模型(a global class-incremental model)。具體來說,為了解決本地客戶端的類別不平衡引起的本地遺忘,作者設計了一個類別意識的梯度補償損失和一個類別語義關系蒸餾損失,以平衡舊類別的遺忘,并在不同任務中蒸餾出一致的類間關系。為了解決 non-i.i.d 類不平衡帶來的全局遺忘問題,作者提出了一個代理服務器,選擇最佳的舊全局模型來協助本地關系蒸餾。考慮到隱私保護,代理服務器通過基于原型梯度的通信機制從本地客戶端收集新類的擾動原型樣本,然后利用它們來監測全局模型的性能以選擇最佳模型。本文模型在代表性的基準數據集上的平均準確率比 SOTA 方法高出 4.4%~15.1%。代碼已公布在 https://github.com/conditionWang/FCIL。

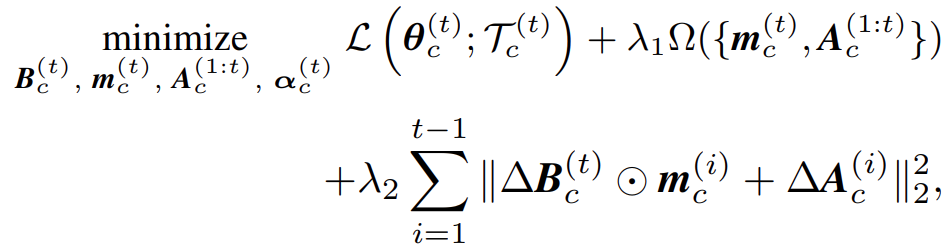

圖 5 描述了本文模型的概況。為了滿足 FCIL 的要求,本文模型通過類別意識梯度補償損失和類別語義關系蒸餾損失來解決本地遺忘問題,同時通過代理服務器為本地客戶端選擇最佳舊模型來解決全局遺忘問題。

圖 5. GLFC 模型概述。它主要由類別意識梯度補償損失 L_GC 和類別語義關系蒸餾損失 L_RD 組成,以克服本地的類別不平衡造成的本地災難性遺忘。使用代理服務器 S_P 來解決 non-ii.d. 類別不平衡帶來的跨客戶端的全局災難性遺忘,其中 S_P 和客戶端之間開發了一個原型梯度通信機制用于私人通信,同時為 L_RD 選擇最佳舊的全局模型

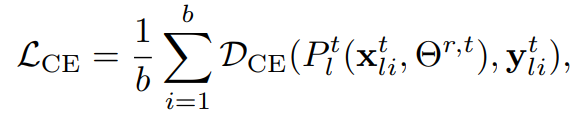

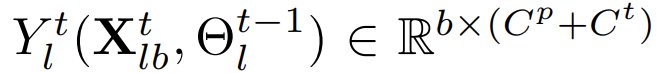

在第 t 個增量任務中,給定第 l 個本地客戶端 S_l∈S_b 的新類別訓練數據和樣本存儲器 M_l,minibatch 的分類損失 L_CE 為:

(1)

(1)

其中,b 是批次大小,Θ_r,t 是第 r 輪全局任務的分類模型,由中央服務器傳送給本地客戶端。P^t_l (x_t^(l_i, Θ_r,t) ∈R^(C^p+C^t)表示通過 Θ_r,t 預測的 sigmoid 概率,DCE (?,?) 是二元交叉熵損失。

如前所述,新舊類別(T^t_l 和 M_l)本地不平衡,使得本地訓練在舊的類別上出現了明顯的性能下降(即本地災難性遺忘)。為了防止本地遺忘,如圖 5 所示,本文為本地客戶端開發了一個類別意識的梯度補償損失和一個類別語義關系蒸餾損失,它可以糾正不平衡的梯度傳播并確保跨增量任務的類別間語義一致性。

- 類別感知梯度補償損失:在 S_G 將 Θ^r,t 分布到本地客戶端后,本地客戶端的類別不平衡分布導致 Θ^r,t 中最后輸出層的梯度反向傳播不平衡。它使得本地模型 Θ^r,t_l 的更新在本地訓練后,在新的類別中執行不同的 learning paces,在舊的類別中執行不同的 forgetting paces。當新的流媒體數據不斷成為舊的類別的一部分時,這種現象嚴重惡化了對舊類別的本地遺忘。

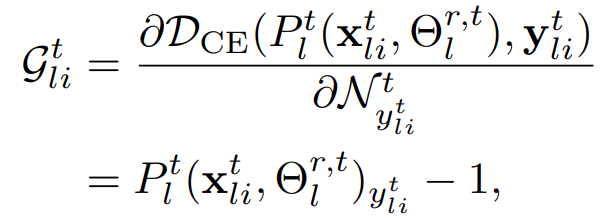

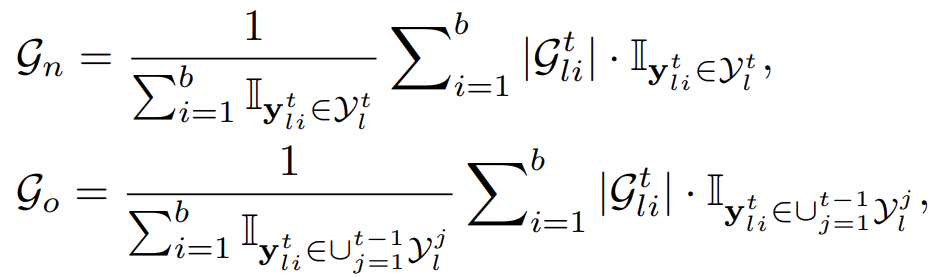

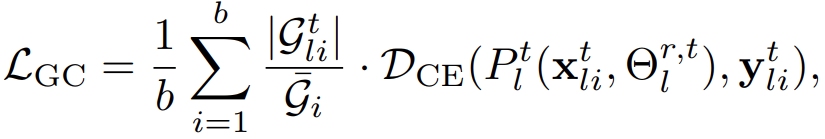

對應于此問題,本文設計了一個類別意識梯度補償損失 L_GC,通過重新加權梯度傳播,分別對新類別的學習速度和舊類別的遺忘速度進行規范。具體來說,對于單個樣本(x^t_li, y^t_li),我們得到一個相對于 Θ^r,t_l 中最后輸出層的第 y^t_li 個神經元的梯度測量 G^t_li:

(2)

(2)

為了使新類別的學習速度和舊類別的遺忘速度正常化,我們對新舊類別分別進行梯度規范化處理,并利用它來重估 L_CE。給定一個小批次 {x^t_li, y^t_li},定義如下:

(3)

(3)

作為新舊兩類別的梯度手段,其中 I (?) 是指標函數,如果下標條件為真,I (True)=1;否則,I (False)=0。因此,重新加權的 L_CE 損失表述如下:

(4)

(4)

- 類別 - 語義關系蒸餾損失。在初始化為當前全局模型 Θ^r,t 的本地模型 Θ^r,t_l 的訓練過程中,Θ^r,t_l 預測的概率表示類間語義相似關系。為了確保不同增量任務之間的類間語義一致性,作者通過考慮新舊類之間的基本關系,設計了一個類別 - 語義關系蒸餾損失 L_RD。如圖 5 所示,分別將一個小批次的數據集 {X^t_lb, Y^t_lb} 轉發到存儲的舊模型 Θ^t-1_l 和當前的本地模型 Θ^r,t_l。這些概率反映了新舊兩類之間的類間關系。與現有的知識蒸餾策略不同的是,作者通過優化 L_RD 同時考慮了新舊類之間的類間關系,只保證舊類在 Θ^t-1_l 和 Θ^r,t_l 之間的語義一致性。也就是說,利用獨熱編碼標簽 Y^t_lb 的一個變體,用 P^t-1_l (X^t_lb, Θ^t-1_l) 代替 Y^t_lb 的第一個 C^p 維度,并將這個變體表示為:

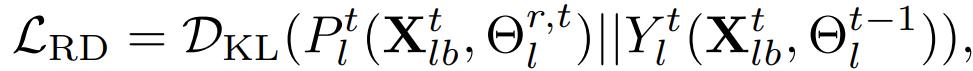

由此得到 L_RD 如下:

(5)

(5)

總的來說,第 l 個本地客戶端的優化目標為:

(6)

(6)

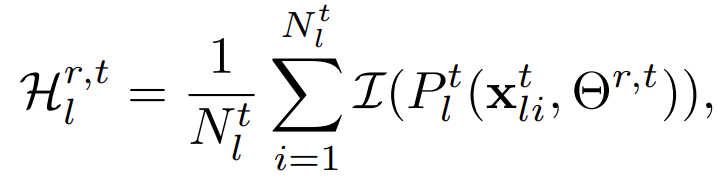

任務轉移檢測。在 FCIL 中,我們沒有關于本地客戶端何時收到新類數據的先驗知識。為了解決這個問題,作者考慮一個解決方案:識別訓練數據的標簽以前是否被觀察到過。然而,由于類別分布的 non-i.i.d. 設置,這種方法不能確定新收到的標簽是來自新的類別還是其他本地客戶端觀察到的舊的類別。另一個直觀的解決方案是使用性能下降作為收集新類的信號。這種解決方案在 FCIL 中是不可行的,因為隨機選擇 {So, Sb, Sn} 和它們的 non-i.i.d. 類分布會導致性能急劇下降,即使沒有收到新的類。為此,作者提出了一種任務轉移檢測機制,以準確識別本地客戶端何時收到新的類別。具體來說,在第 r 個全局輪次,每個客戶端通過收到的全局模型 Θ^r,t 對其當前訓練數據 T^t_l 計算平均熵 H^r,t_l:

(7)

(7)

3.2 全局災難性遺忘補償

雖然公式(6)可以解決本地的類別不平衡帶來的本地災難性遺忘,但它不能解決來自其他客戶端的異質性遺忘(即全局災難性遺忘)。換句話說,non-i.i.d. 類的不平衡分布在本地客戶端上導致了某些舊類的全局災難性遺忘,進一步惡化了本地災難性遺忘。因此,有必要從全局角度解決不同客戶端的異質性遺忘問題。如前所述,公式(5)中提出的類別 - 語義關系蒸餾損失 L_RD 需要存儲以前任務的舊分類模型 Θ^t-1_l 來提煉類間關系。一個較好的 Θ^t-1_l 可以在全局上增加以前任務的蒸餾收益,從全局上加強對舊類的記憶。因此,Θ^t-1_l 的選擇在全局災難性遺忘補償中起著重要作用,應從全局角度考慮。

然而在 FCIL 中,由于隱私保護很難選擇最佳 Θ^t-1_l。直觀的解決方案是,每個客戶端在第(t-1)個任務期間用訓練數據 T^t-1_l 存儲其最佳舊模型 {Θ^t-1_l}。不幸的是,這個解決方案是從本地角度考慮選擇 Θ^t-1_l 的,不能保證所選擇的 Θ^t-1_l 對所有的舊類都有最好的記憶,因為每個本地客戶端只有一個舊類子集(non-i.i.d)。為此,作者引入一個代理服務器 S_P,從全局角度為所有客戶端選擇最佳的 Θ^t-1,如圖 5 所描述。具體來說,當本地客戶端通過任務轉換檢測在第 t 個任務開始時識別了新的類(即 T^t_l),他們將通過基于原型梯度的通信機制將新類的擾動原型樣本傳送給 S_P。在收到這些梯度后,S_P 重建被擾動的原型樣本,并利用它們來監測全局模型 Θ^r,t(從 S_G 收到)的性能,直到找到最佳模型。當步入下一個任務(t+1)時,S_P 將最優 Θ^r,t 分發給本地客戶端,本地客戶端將其視為最優舊模型來執行 L_RD。

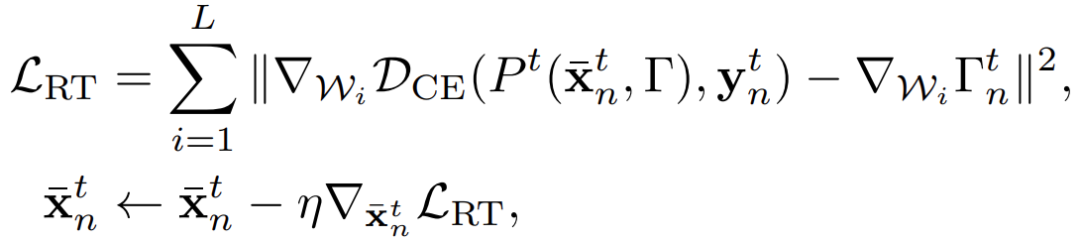

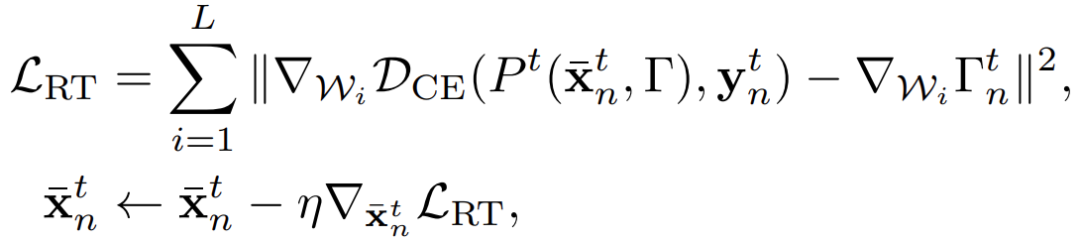

- 基于梯度的原型通信。給定第 l 個本地客戶端 Sl∈Sb∪Sn,該客戶端收到訓練數據 T^t_ l 的新類,Sl 通過任務轉換 detention 來識別新的類。然后 Sl 從 T^t_l 中為每個新的類(c = C^p_l + 1, - -, C^p_l +C^t_l)只選擇一個有代表性的原型樣本 x^t_lc?,其中 x^t_lc?的特征最接近屬于 c 類的所有樣本在潛在特征空間的平均嵌入。然后將這些原型樣本和它們的標簽送入 L 層梯度編碼網絡 Γ = {Wi},計算梯度?Γ_lc。S_P 隨機處理所有從本輪全局的選定客戶端處收到的梯度,以構建一個梯度池,假設這個池子里有 N^t_g 個梯度。這種操作可以防止 S_P 通過注釋特殊的梯度分布來追蹤某些選定的客戶端。對于?Γ^t 的第 n 個元素?Γ^t_n,我們可以通過觀察?Γ 中最后一層的梯度符號來獲得其對應的 ground-truth 標簽 y^t_n(有一個獨熱編碼標簽 y^t_n)。給定一個由標準高斯 (N0,1) 初始化的假樣本 xˉ^t_n,將所有的 {xˉ^t_n, ?Γ^t_n, y^t_n} 對轉發到 Γ = {Wi},該網絡與本地客戶端使用的梯度編碼網絡相同,以恢復每個新類的原型樣本。重建損失 L_RT 如下:

(8、9)

(8、9)

- 最優舊模型的選擇。當檢測到新的類時,S_P 只能在第 t 個任務的第一輪接收本地客戶端的梯度。然后,S_P 通過優化公式(9)重建 N^t_g 個新類別的原型樣本及其標簽(即 {xˉ^t_n, y^t_n})。在第 t 個任務中,S_P 將這些重建的樣本轉發到全局模型 Θ^r,t(從 S_G 處收到),通過評估哪個模型具有最佳精度來選擇最佳 Θ^t,直到收到下一個任務的新類的梯度。在從第二個任務開始的每一輪全局處理過程中,S_P 將上一個任務和當前任務的最優模型(即 Θ^t-1 和 Θ^t),分配給所有被選中的客戶端。如果這些被選中的客戶端在第 t 個任務中檢測到 T^t+1_l 的新類,他們將把 Θ^t 設置為舊模型 Θ^t-1_l,否則,將 Θ^t-1 設置為 Θ^t-1_l 來執行 L_RD。

擾動的原型樣本構建。盡管網絡 Γ 只有 S_P 和本地客戶端可以私下訪問,但可以竊取 Γ 和這些梯度來重建第 l 個本地客戶端的原始原型樣本 {x^t_lc? , y^t_lc? }。為了實現隱私保護,作者建議在這些原型樣本中加入擾動。即使能重建原型樣本,也只能從擾動的原型樣本中獲得很少的有用信息。給定一個原型樣本 {x^t_lc? , y^t_lc? },將其轉入通過公式(6)訓練的本地模型 Θ^r,t_l,并應用反向傳播來更新這個樣本。為了產生擾動的原型樣本,作者在原型樣本的潛在特征中引入一個高斯噪聲,然后通過公式(11)更新 x^t_lc?:

(10)

(10)

(11)

(11)

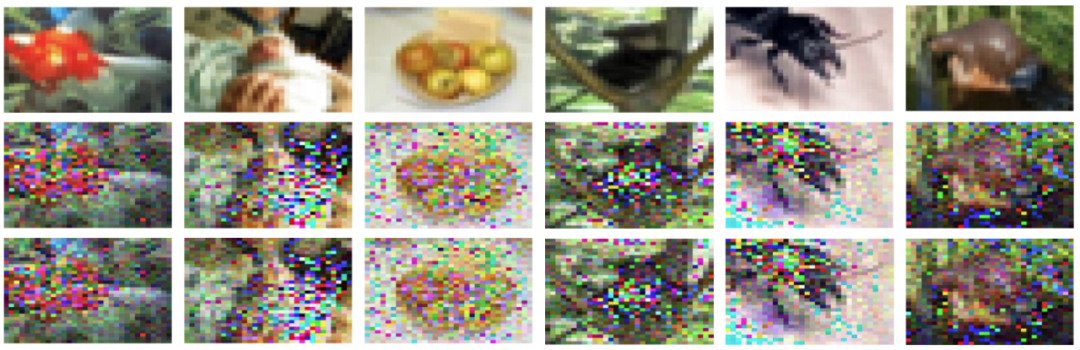

其中,Φ(x^t_lc?) 表示 x^t_lc?的潛在特征,P^t_l (Φ(x^t_lc?)+γN (0, σ2), Θ^r,t_l) 是在 Φ(x^t_lc?) 中加入高斯噪聲 N (0, σ2) 時通過 Θ^r,t_l 預測的概率。σ2 代表屬于 y^t_lc?的所有樣本的特征方差,作者根據經驗設定 γ=0.1,以控制本文中高斯噪聲的影響。圖 6 展示了一些重建的原型樣本。

圖 6. CIFAR-100 中原始原型樣本(上行)、擾動原型樣本(中行)和通過代理服務器重建的原型樣本(下行)的可視化情況

3.3 實驗情況介紹

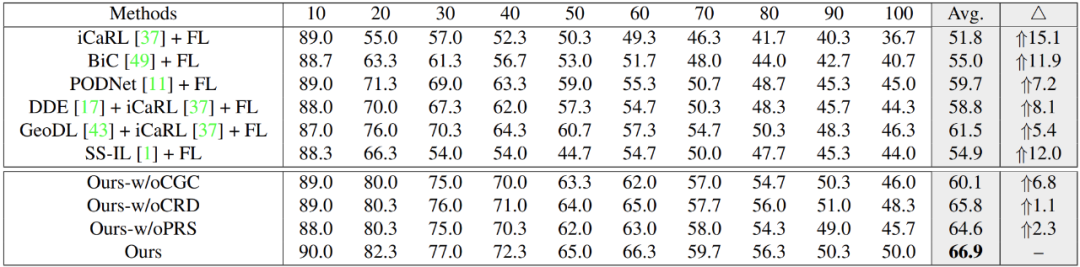

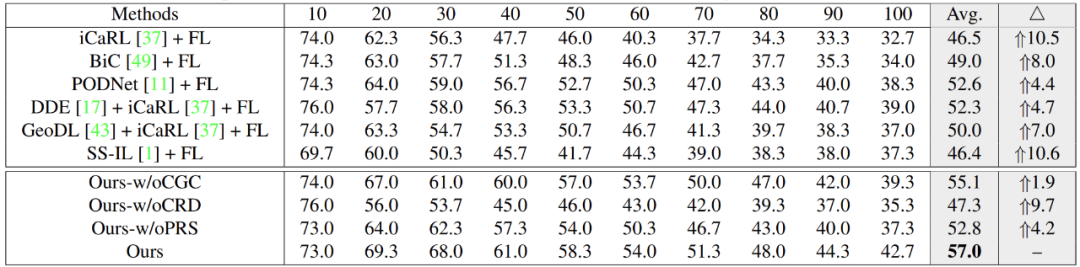

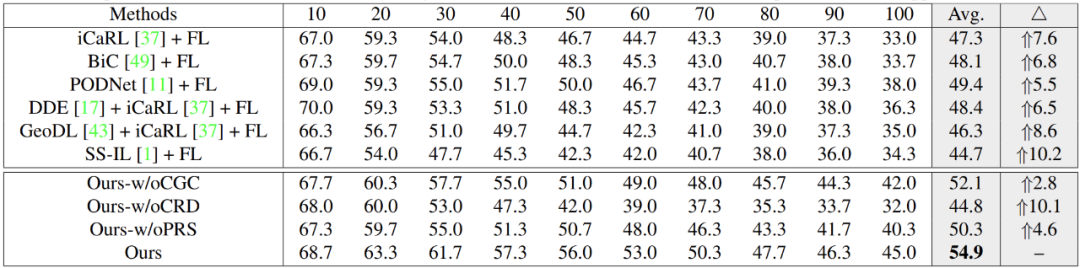

本文在 CIFAR-100、ImageNetSubset 和 TinyImageNet 上進行實驗,對比實驗結果如表 3-5。其中,△表示本文模型與其他比較方法相比的改進。我們觀察到,在 FCIL 設置中,本文模型以 4.4%~15.1% 的幅度超過了現有的 class-incremental 方法的平均精度。這驗證了本文模型可以使本地客戶端協同訓練一個全局的 class-incremental 模型。此外,與其他方法相比,本文模型在所有增量任務中都有穩定的性能提升,這驗證了本文模型在解決 FCIL 中遺忘問題的有效性。

表 3. 本文模型和其他基線方法在 CIFAR-100 上的性能比較

表 4. 本文模型和其他基線方法在 ImageNet-Subset 上的性能比較

表 5. TinyImageNet 上前 10 個任務與 20 個任務的比較

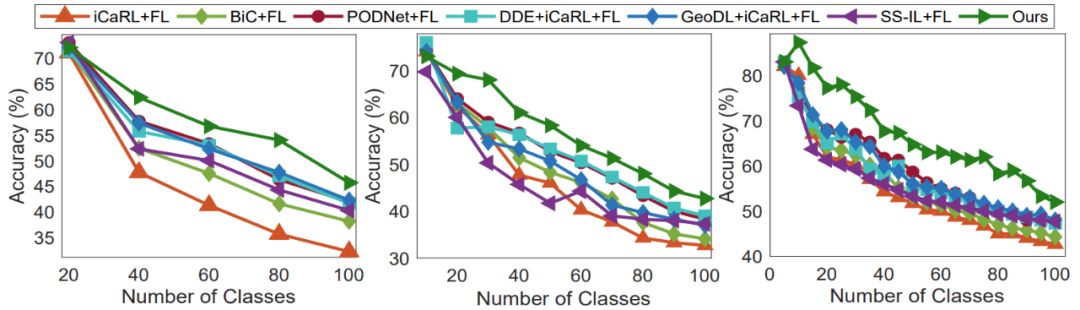

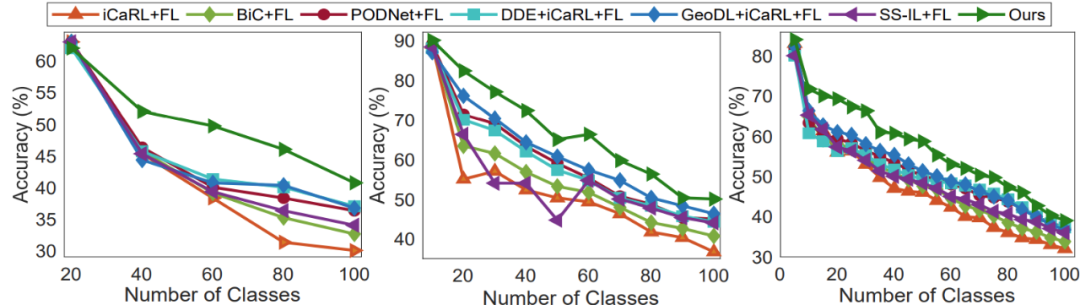

此外,作者對基準數據集上的各種增量任務(T=5、10、20)進行定性分析,以驗證 GLFC 的性能。根據這些曲線,我們可以很容易地觀察到,在不同的任務數量(T=5,10,20)的設置下,我們的模型在所有的增量任務中都比其他基線方法表現更好。這表明 GLFC 模型能夠使多個本地客戶端以流式方式學習新的類,同時解決本地和全局遺忘問題。如圖 7、8 所示。

圖 7. T=5(左)、T=10(中)和 T=20(右)時,對 CIFAR-100 上不同增量任務的定性分析

圖 8. T=5(左)、T=10(中)和 T=20(右)時,ImageNet-Subset 上增量任務的定性分析

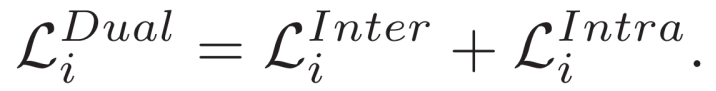

4、Learn from Others and Be Yourself in Heterogeneous Federated Learning

聯邦學習已經成為一種重要的分布式學習范式,它通常涉及與他人的協作更新和私有數據的本地更新。然而,異質性問題和災難性遺忘給聯邦學習帶來了挑戰。首先,由于 non-i.i.d 數據和異質結構,模型在其他域的性能下降,并與參與者的模型存在溝通障礙。其次,在本地更新中模型是在私有數據上單獨優化的,這很容易過度擬合當前的數據分布,忘記以前獲得的知識,導致災難性的遺忘。本文提出了聯邦交叉相關和持續學習(Federated Cross-Correlation and Continual Learning,FCCL)。對于異質性問題,FCCL 利用未標記的公共數據進行通信,并構建交叉相關矩陣來學習域偏移的可泛化表示。同時,對于災難性遺忘,FCCL 利用本地更新中的知識提煉,在不泄露隱私的情況下提供域間和域內信息。作者通過各種圖像分類任務的實證結果證明了本文方法的有效性和模塊的效率。

按照標準的聯邦學習設置,有 K 個參與者(以 i 為索引),每個參與者都有一個本地模型 θ_i 和私有數據 D_i = {(X_i,Y_i)|X_i∈R^(Ni×D), Y_i∈R^(Ni×C) },其中,N_i 表示私有數據的數量,D 表示輸入大小,C 定義為分類的類別數量。同時,私有數據分布表示為 P_i (X, Y),并改寫為 P_i (X|Y ) P_i (Y)。此外,在異質聯邦學習中,數據的異質性和模型的異質性定義如下:

- 數據的異質性。P_i (X|Y )≠P_j (X|Y )。私有數據之間存在域偏移,即私有數據的條件分布 P (X|Y) 在不同的參與者中是不同的,即使 P (Y) 是共享的。具體來說,同一個標簽 Y 在不同域有不同的特征 X。

- 模型的異質性:Shape (θ_i) ≠ Shape (θ_j )。參與者獨立定制模型,即對于分類任務,所選擇的骨干網(如 ResNet、EfficientNet 和 MobileNet)是不同的,具有不同的分類器模型。

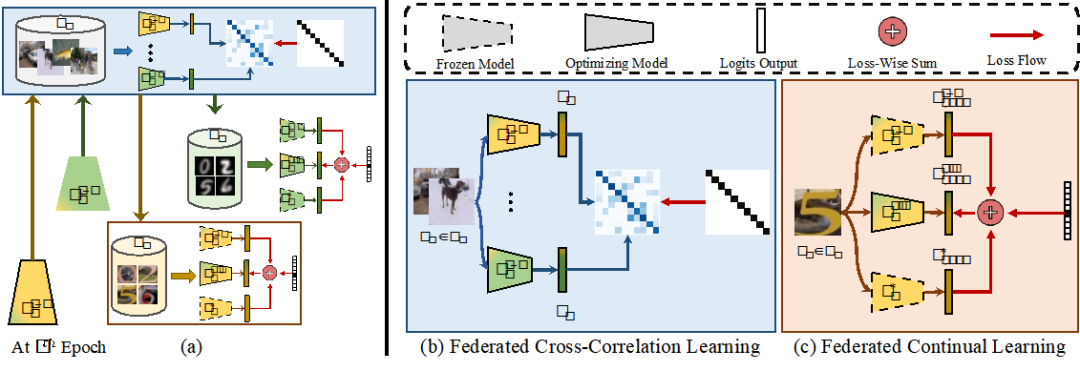

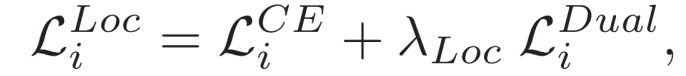

作者利用無標簽的公共數據 D_0={X_0|X_0∈R^(N0×D)} 來實現通信。公共數據在實際場景中相對容易獲取。第一名參與者的目標是達成溝通,并學習具有可概括性的模型 θ_i。此外,考慮到災難性的問題,θ_k 需要呈現更高更穩定的域間和域內性能。本文方法的框架如圖 9 所示。具體來說,在協作更新中,作者測量未標記的公共數據上輸出的 Logits 之間的交叉相關矩陣,以實現相似性和減少冗余。同時,在本地更新中,通過知識蒸餾不斷平衡多域的信息。

圖 9. FCCL 示例。(a) 本文方法的簡化示意圖,該方法通過聯邦交叉相關學習和聯邦持續學習解決了異質性問題和災難性遺忘;(b) 聯邦交叉相關學習;(c) 聯邦持續學習。梯度顏色比例反映了其他參與者的影響程度

4.1 聯邦交叉相關學習

維度級(Dimension-Level)操作的啟發。受信息瓶頸進行自監督學習的成功經驗啟發,作者提出:一個可概括的表征應該盡可能地提供關于圖像的信息,同時盡可能地對應用于該樣本的特定域的變換不產生影響。在本文工作中,域偏移導致同一標簽 Y 在不同域有不同的特征 X。因此,不同域的 logits 輸出沿批次維度的分布是不一樣的。此外,不同維度的 logits 輸出對應著不同的類別。因此,我們需要鼓勵相同維度的不變性和不同維度的多樣性。私有數據帶有特定的域信息,并且受到隱私保護,這對于進行自監督學習是不合適的,也是不可行的。因此,我們利用未標記的公共數據,這些數據通常是從多個域產生和收集的,而且很容易獲得。我們通過要求 logits 輸出不受域偏移的影響,以及在無標簽的公共數據上對 logits 輸出的不同維度進行修飾來優化私有模型。

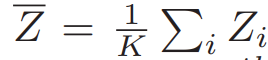

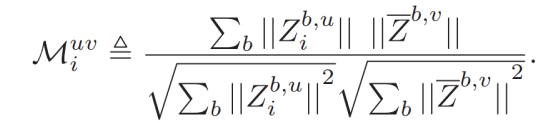

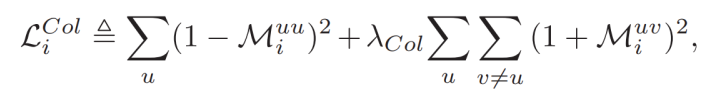

交叉相關矩陣的構建。具體來說,我們得到第 i 個參與者的 logits 輸出。Z_i =f (θ_i, X_0) ∈R^(N_0×C) 。對于第 i 個和第 j 個參與者,在未標記的公共數據上的 logits 輸出為 Z_i 和 Z_j。值得注意的是,考慮到中央服務器端的計算負擔,我們計算 average Logits 輸出:

然后,計算交叉相關矩陣,第 i 個參與者的 average logits 輸出為 M_i:

(12)

(12)

其中,b 指的是批次樣本,u、v 指的是 logits 輸出的維度,||?|| 是沿批次維度進行的歸一化操作。M_i 是一個正方形矩陣,大小為輸出維度 C,數值在 - 1(即不相似)和 1(即相似)之間。那么,第 i 個參與者的協作損失定義為:

(13)

(13)

其中,λ_Col 是一個正常數,用來權衡損失的第一項和第二項的重要性。當交叉相關矩陣的對角線項取值為 + 1 時,它鼓勵不同參與者的 logits 輸出相似。當交叉相關矩陣的對角線項取值為 - 1 時,它鼓勵 logits 輸出的多樣性,因為這些 logits 輸出的不同維度是彼此不相關的。

4.2 聯邦持續相關學習

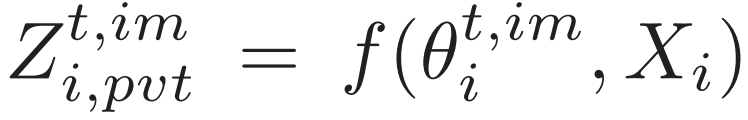

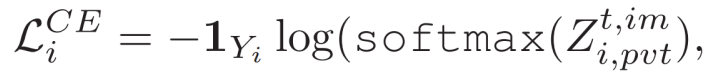

典型的監督損失。對于聯邦學習中的本地更新,目前的方法通常將這個過程作為一個監督分類問題。具體來說,在第 t 輪通信中,協作更新后,將第 i 個私有模型定義為 (θ^t,im)_i。然后,在固定 epoch 的私有數據 D_i (X_i, Y_i) 上優化 (θ^t,im)_i。給定如下 logits 輸出:

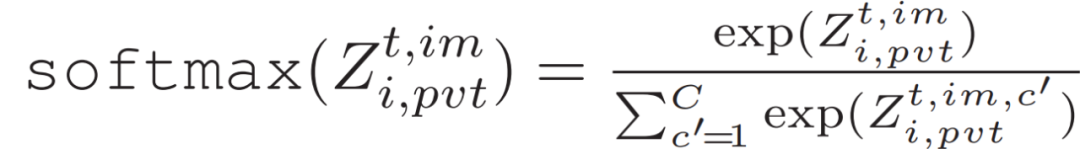

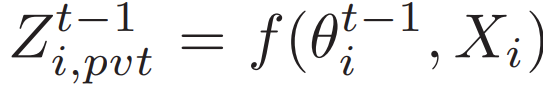

用 softmax 對交叉熵損失進行優化:

(14)

(14)

這樣的訓練目標設計可能會面臨災難性遺忘的問題,主要是由于以下兩個限制:1)在本地更新中,如果沒有其他參與者的監督,模型很容易過度擬合當前的數據分布,呈現出糟糕的域間性能。2)它只對預測進行獨立的先驗概率懲罰,這提供了有限的和 hard 的域內信息。

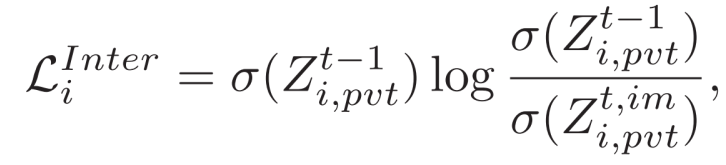

雙域知識蒸餾損失。作者開發了一種聯邦持續學習方法,通過從模型方面對目標進行正則化來解決 1)和 2)的問題。具體來說,在第 t-1 輪訓練結束時,更新的模型 (θ^t-1)_i 包含了從其他參與者學到的知識。在私有數據上計算 logits 輸出如下:

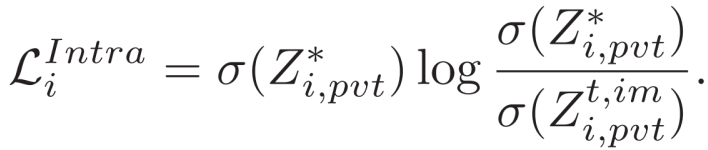

域內知識蒸餾的損失定義為:

(15)

(15)

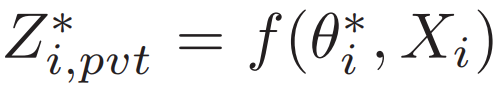

其中,σ 表示 softmax 函數。如公式(15),其目的是在保護隱私的同時不斷向他人學習,從而保證域間性能,并處理聯邦學習中的災難性遺忘問題。此外,對于第 i 個參與者,在私有數據上預訓練一個模型 (θ^?)_i 是可行的。給定如下私有數據:

域內知識蒸餾損失定義為:

(16)

(16)

帶有預訓練模型的知識蒸餾提供了 soft 而豐富的域內信息。此外,它與公式(14)中的典型監督損失(即交叉熵損失)合作,提供 soft 和 hard 的域內信息以確保域內性能。在某種程度上,上述兩個模型(即更新的模型 (θ^t-1)_i 和預訓練的模型 (θ^?)_i)分別代表了 "教師" 之間和內部的模型。通過知識蒸餾,平衡來自他人和自身的知識,同時提升了域間和域內的性能。雙域知識蒸餾的計算方法為:

(17)

(17)

公式(14)中的典型監督損失和公式(17)中的雙域知識蒸餾損失是相互補充的。前者要求模型學習對分類任務有意義的鑒別性表征,而后者則有助于用域內和域間的 soft 豐富信息使模型規范化。因此,總的訓練目標是:

完整的 FCCL 流程如下:

4.3 實驗情況介紹

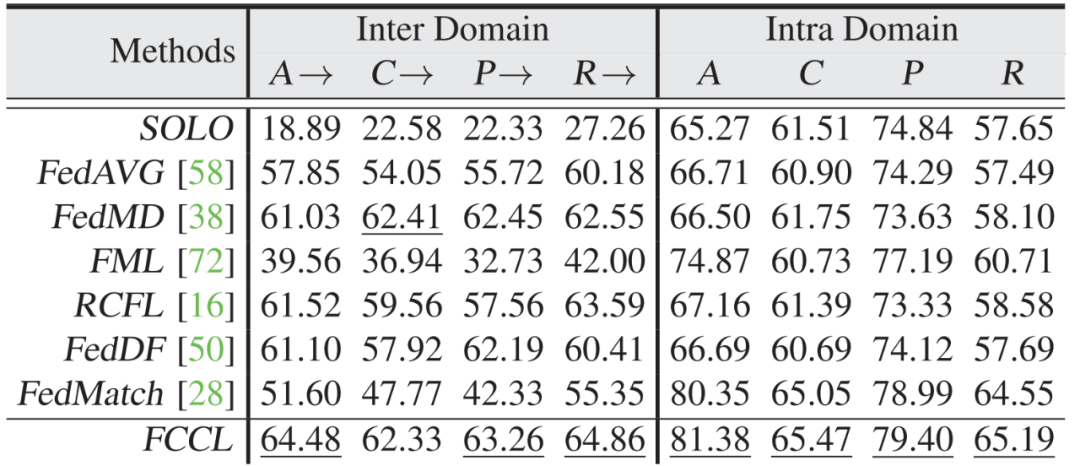

作者在兩個分類任務(如 Digits 和 Office-Home)和三個公共數據集(如 Cifar-100、ImageNet 和 Fashion-MNIST)上廣泛地評估了本文方法。具體來說,Digits 任務包括四個域(MNIST(M)、USPS(U)、SVHN(SV)和 SYN(SY)),共有 10 個類別。Office-Home 任務也有四個域(藝術(A)、剪貼畫(C)、產品(P)和現實世界(R))。請注意,對于這兩項任務來說,從不同域獲得的數據呈現出域偏移(數據異質性)特性。對于這兩個分類任務,參與者定制的模型可以從差異化的骨干網和分類器中獲得差異(模型異質性)。在實驗中,作者將這四個域的模型設置為 ResNet、EfficientNet、MobileNet 和 GoogLeNet。作者將 FCCL 與最先進的方法,包括 FedDF、FML、FedMD、RCFL 和 FedMatch,進行比較。此外,還比較了 SOLO,即參與者在沒有聯邦學習的情況下在私有數據上訓練一個模型。由于具體的實驗設置并不完全一致,作者保留了一些方法的關鍵特征進行比較。

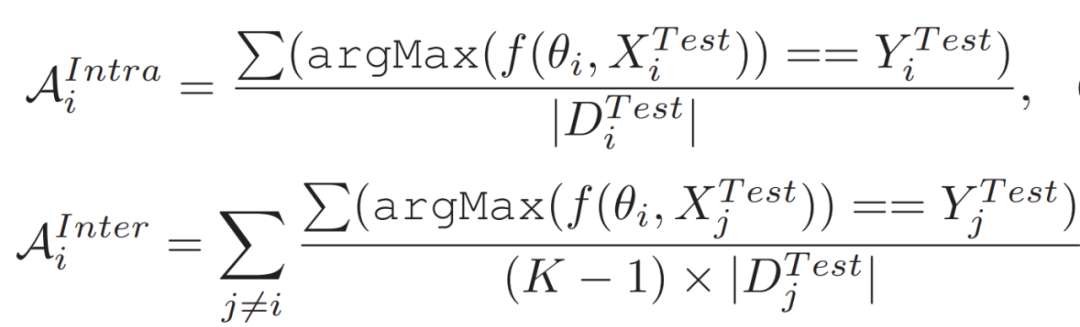

評價指標。作者報告了衡量方法質量的標準指標:準確性,將其定義為成對的樣本數除以樣本數。具體來說,為了評價域內和域間的性能,定義如下指標:

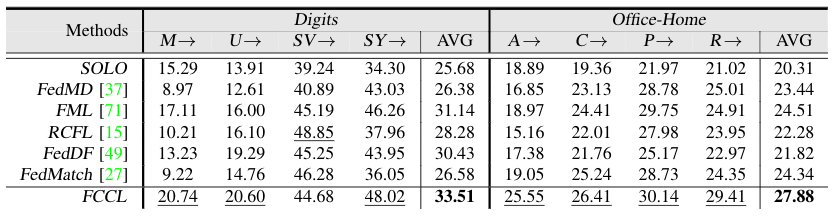

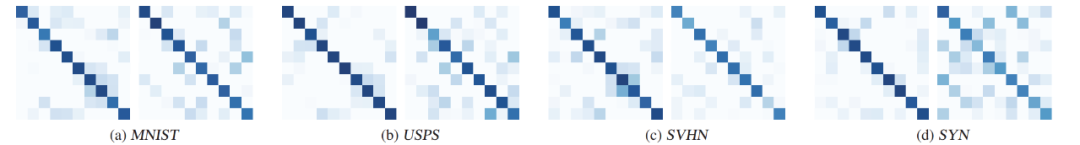

域間分析。表 6 報告了不同方法的域間性能。在域偏移的情況下,SOLO 在這兩個任務中表現得最差。我們觀察到,FCCL 的表現明顯優于其他同類方法。圖 10 顯示,FCCL 在參與者之間實現了相似的 logits 輸出,并在 logits 輸出中實現了冗余,這證實了 FCCL 在公共和私有數據上成功地執行了相同維度的相關性和不同維度的去相關性。

表 6. 域間性能與最先進方法的比較。M→表示私有數據是 MNIST,各自的模型在其他域測試。AVG 表示從每個域計算出的平均精度

圖 10. 用 Cifar-100 對不同域的數字任務進行交叉相關矩陣的可視化分析

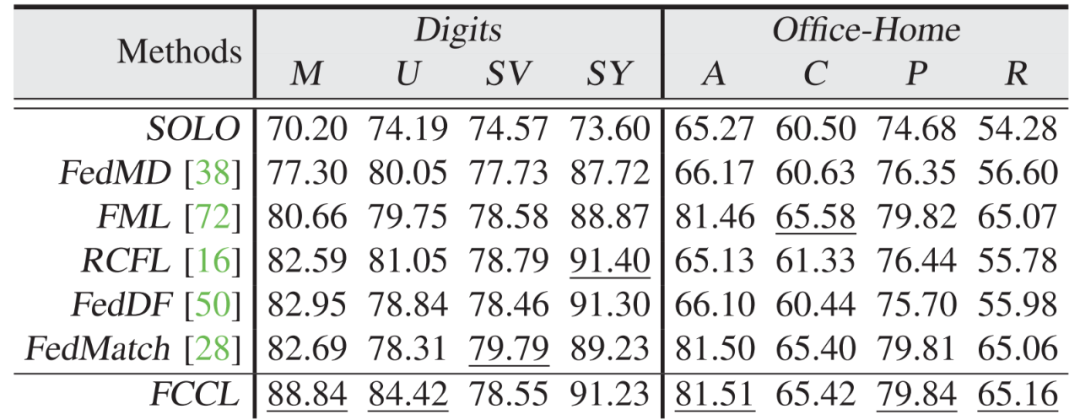

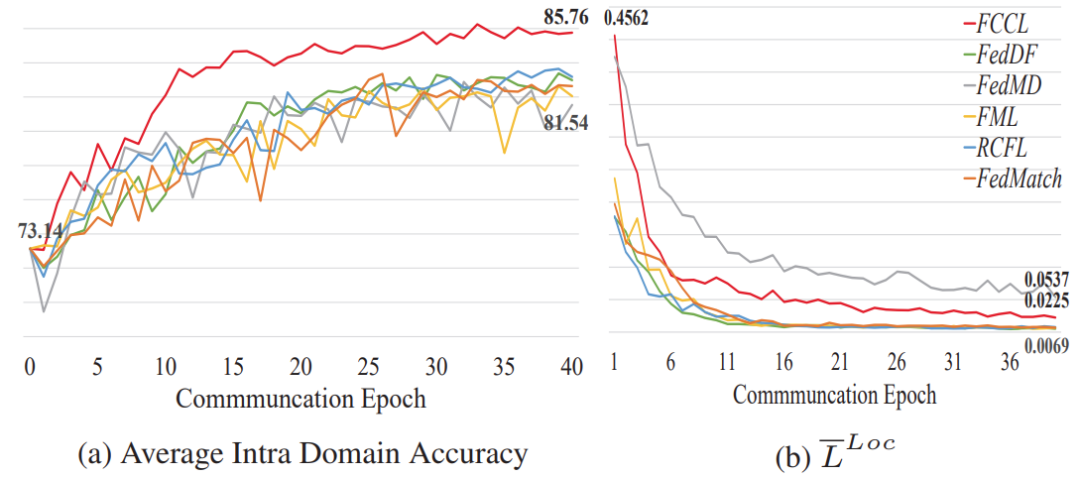

域內分析。為了比較緩解災難性遺忘的效果,表 7 報告了不同方法的域內性能。以 Cifar-100 的 Digits 任務為例,本文方法比 RCFL 要好 2.30%。此外,圖 11a 中通過增加通信輪次的域內精度和圖 11b 中的優化目標值表明,FCCL 受到的周期性性能沖擊較小,而且不容易對當前的數據分布進行過擬合(L^Loc=0.0225),說明 FCCL 能夠平衡多種知識,緩解災難性遺忘。

表 7. 用 Cifar-100 在這兩項任務上與最先進的方法進行域內性能比較

圖 11. 用 Cifar-100 通過增加通信輪次對數字任務進行本地更新時的域內性能和優化目標值的比較

模型同質性分析。作者進一步將 FCCL 與其他方法進行模型同質性比較。將共享模型設定為 ResNet-18,并在協作更新和本地更新之間添加平均參數操作。表 8 列出了域間和域內的數據,展示了 Cifar-100 在 Office-Home 任務中的域間和域內性能。

表 8. 用 Cifar-100 在 Office-Home 任務中與最先進的方法進行比較

5、FedSpeech: Federated Text-to-Speech with Continual Learning

聯邦學習可以在嚴格的隱私限制下對機器學習模型進行協作訓練,而聯邦文本到語音的應用目的是利用存儲在本地設備中的少量音頻訓練樣本合成多個用戶的自然語音。然而,聯邦文本到語音面臨著幾個挑戰:每個說話人的訓練樣本很少,訓練樣本都存儲在每個用戶的本地設備中,而且全局模型容易受到各種打擊。本文提出了一個新穎的聯邦學習架構,稱為聯邦多語者文本到語音 TTS 系統 Fed-Speech,基于持續學習方法來克服上述困難。具體如下:1)通過選擇性掩碼,FedSpeech 可以有效地從協作訓練中獲益,以減少有限訓練數據的影響。2)使用漸進式修剪掩碼來分離不同說話人的參數,以克服災難性遺忘問題。因此,FedSpeech 避免了所有說話人的語調變化問題。3) 引入私有說話人嵌入,加上上述兩類掩碼,以保護隱私并避免對說話人的各種打擊。在縮小的 VCTK 數據集上的實驗(每個說話人的訓練集減少到四分之一,以模擬低資源的語言場景)表明,FedSpeech 在語音質量方面幾乎可以與上限、多任務訓練相匹配,甚至在說話人相似性實驗中明顯優于所有系統。

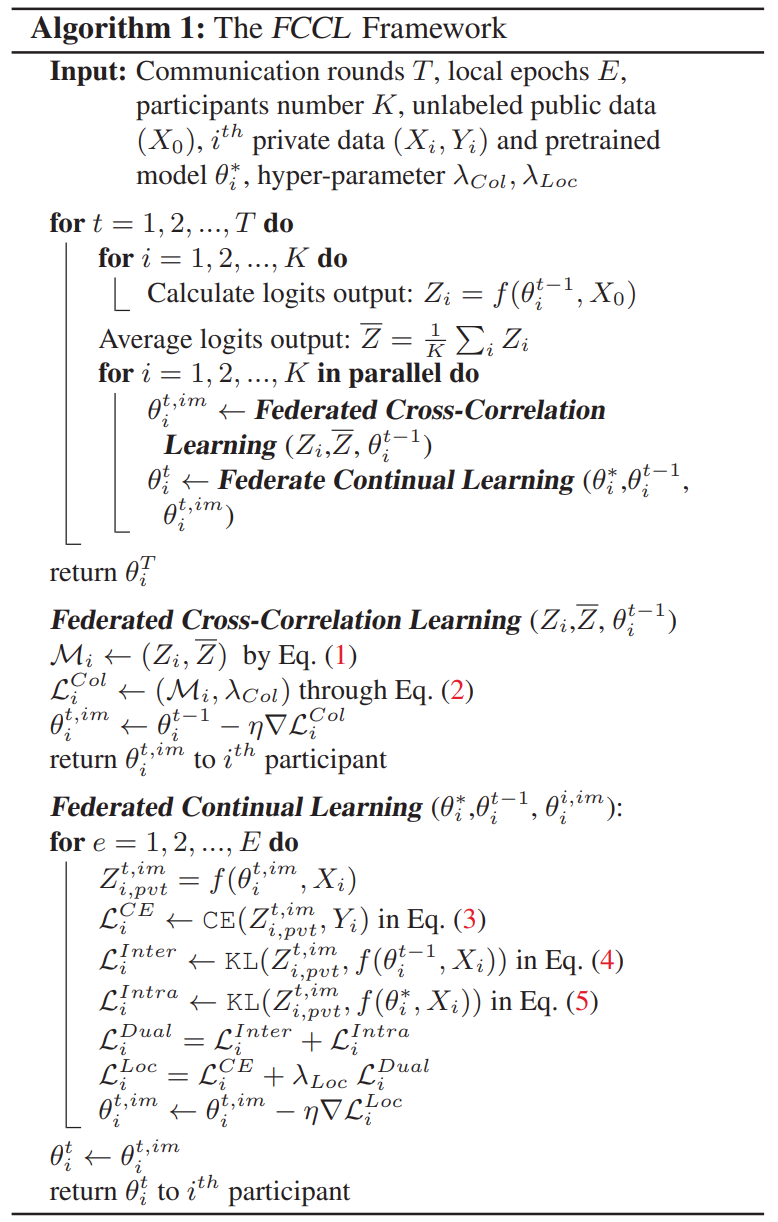

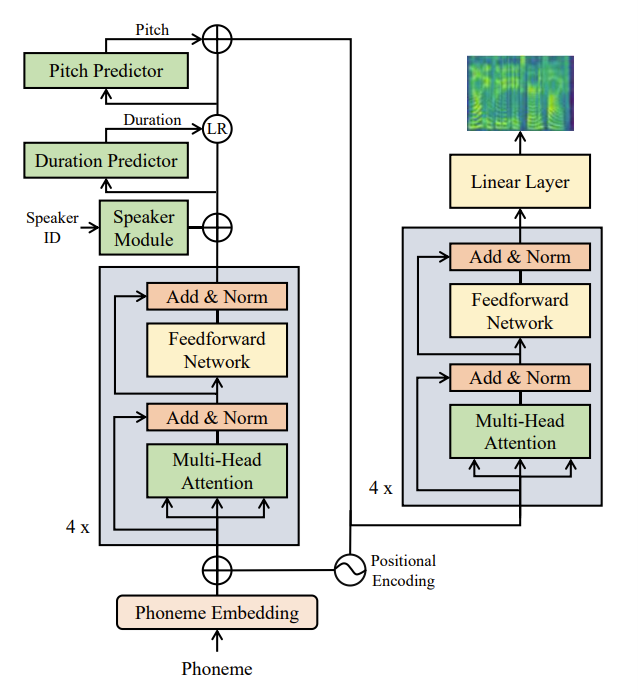

5.1 模型結構

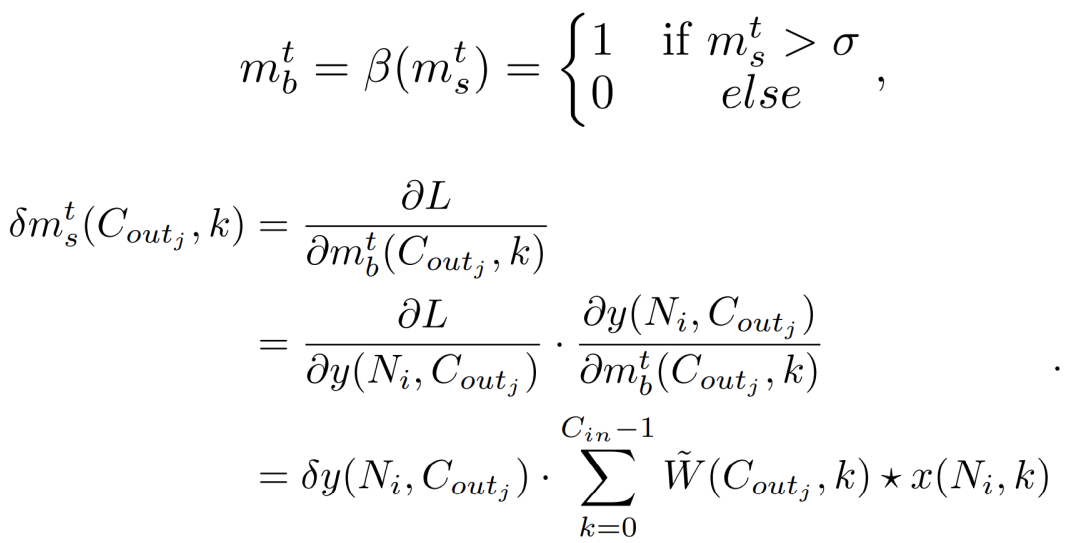

FedSpeech 的整體模型結構如圖 12 所示。編碼器將音素嵌入序列轉換為音素隱序列,然后在隱序列中加入不同的差異信息,如持續時間和語調,最后由旋律譜解碼器將適應的隱序列轉換為旋律譜序列。采用前饋轉化器(Feed-forward Transformer)模塊,它是 FastSpeech 中自注意力層和 1D-convolution 前饋網絡的疊加,作為編碼器和旋律譜圖解碼器的基本結構。此外,還采用了一個音高預測器和一個持續時間預測器來引入更多的信息。每個網絡都包括一個具有 ReLU 激活的 2 層一維卷積網絡,然后是層歸一化和 DropOut 層,以及一個額外的線性層,將隱狀態投射到輸出序列中。在訓練階段,將從錄音中提取的持續時間和語調的真實值作為輸入到隱序列中以預測目標語音。同時,用真實的時長和音高值作為目標來訓練預測器。使用這些輸出進行推理,以合成目標語音。

圖 12. FedSpeech 的整體架構。+ 表示元素相加的操作

為了通過從潛在空間估計說話人的特征來控制語音并保護隱私,作者引入了一個私有說話人模塊,它是一個可訓練的查找表,將說話人的身份號碼 S_id 作為輸入,并生成說話人表示 R={r_1, r_2, ..., r_n},其中 n 是模型的隱空間大小。然后,將說話人表示 R 傳遞到編碼器的輸出端,作為額外的關鍵信息來控制訓練和推理中的語調特征。考慮到隱私問題,每個說話人都會訓練并保持自己的模塊參數集,這樣其他人即使用他的 S_id 也無法合成他的聲音。

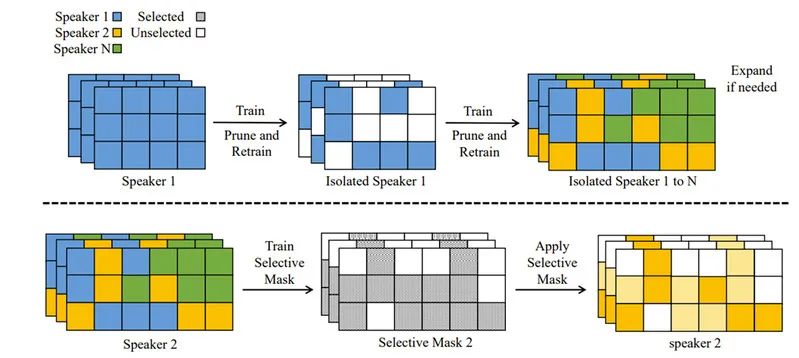

圖 13. 用 FedSpeech 進行的兩輪訓練過程。在第一輪中,逐步修剪掩碼以隔離每個說話人的權重。如果為某個說話人保留的權重小于閾值,模型就會擴大。在第二輪,以 speaker 2 為例。選擇性掩碼的訓練是為了重新利用為其他說話人保留的權重中的知識

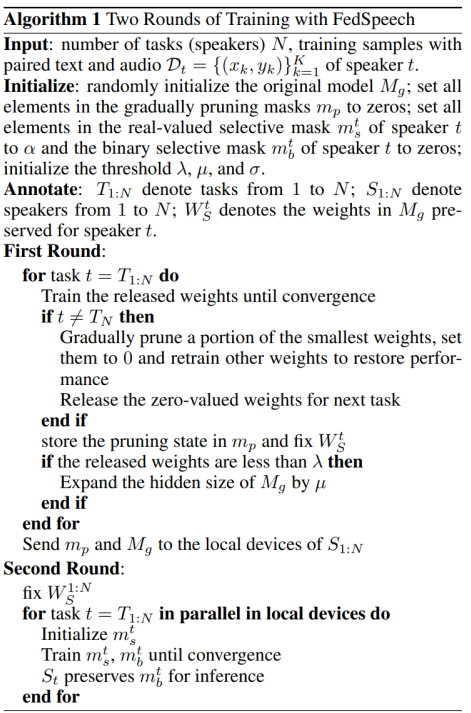

本文未采用聯邦聚合訓練的方法,因為這種方法存在災難性遺忘問題。如圖 13 所示,作者采用了持續學習中常用的連續訓練設置。在經典設置的基礎上,本文提出了兩輪的順序訓練。在第一輪訓練中,模型分別學習并固定每個說話人的一部分權重,這樣在第二輪訓練中,可以有選擇地重用前一個和后一個說話人的知識。

具體來說,在第一輪訓練中,計算得到圖 13 中的漸進修剪掩碼以隔離每個說話人的參數。將從 1 到 N 的 speaker 表示為 S_1:N。S_1:N 的任務表示為 T_1:N。以 S_t 為例。當 T_t 開始時,首先將全局模型 M_g 發送給 S_t,并使用他的私有數據進行訓練,直到收斂。將第 i 層的學習權重矩陣表示為 (W^l_i)_1。然后,逐漸修剪每層 (W^l_i)_1 中最小的權重的一部分,將其設置為 0,并重新訓練其他權重以恢復性能。最后,將權重劃分為三部分:1)后來的 speaker S_t+1:N 釋放的零值權重;2)由以前的 speaker S_1:t-1 保留的固定權重 (W^1:t-1)_S;3)由 S_t 保留的權重 W^t_S。如果后來的 speaker S_t+1:N 的釋放權重小于閾值 λ,將模型的隱藏大小擴展為 μ。修剪狀態存儲在漸進修剪掩碼中,表示為 m_p。然后固定 W^t_S,并將 m_p 和 M_g(除了 private speaker 模塊)發送到下一個 speaker S_t+1 的設備上,繼續進行順序訓練。當第一輪結束時,每個說話人都保留了某一部分權重,表示為 (W^1:N)_S,由 m_p 表示。由于每個任務的權重都是固定的,每個說話人都可以在推理中完美地保留他們的語調。最后,將 m_p 和 Mg 發送到 S_1:N 的設備上。因此,每個說話人都有 m_p、M_g 和他所保留的 private speaker 模塊的參數。

在第二輪訓練中,引入選擇性掩碼來轉移說話者的知識,以解決數據稀缺的問題。將圖 13 中的選擇性掩碼訓練為自動選擇說話人保留的有用權重。作者提出了一個修改后的選擇程序,從所有任務中選擇權重,這對 federated TTS 任務中的每個 speaker(特別是對更多的 previous speakers)都是更公平的。對于一個特定的說話人 S_t,兩輪訓練放棄了 W^t_S 和選擇性掩碼的聯邦訓練,這導致了輕微的性能下降。但是對于每個 speaker,我們使其有可能從之前和之后的任務中選擇權重,從而在整體上顯著改善了性能。

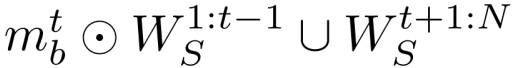

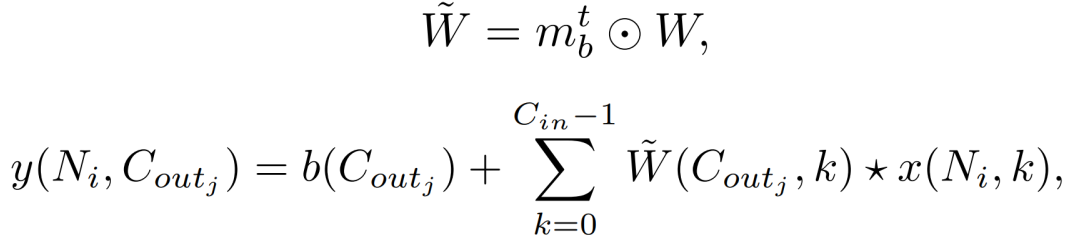

假設當第一輪結束時,M_g 的權重分成幾個部分 (W^1:N)_S,這些部分被 S_1:N 保存。為了在保持隱私的同時從協作訓練中獲益,作者引入了一個可學習的掩碼 m_b∈{0,1} 來轉移由其他說話人保留的參數的知識。本文使用 piggyback 方法,學習一個實值掩碼 m_s,并應用一個閾值進行二值化處理以構建 m_b。對于某個說話人 S_t 來說,掩碼 (m^t)_b 是在他的本地數據集上訓練出來的,通過以下方式從其他說話人位置選擇權重:

以一維卷積層中的選擇性掩碼的訓練過程為例進行描述。在任務 t,M_g(即 W^1:N_S)是固定的。將二進制掩碼表示為 m^t_b。那么,輸入 - 輸出關系的方程為:

在反向傳播過程中,m^t_b 是不可分的。所以引入實值的選擇性掩碼,表示為 (m^t)_s。將 σ 表示為選擇的閾值。在訓練二進制掩碼 (m^t)_b 時,在后向傳遞中更新實值掩碼 (m^t)_s;然后用應用于 (m^t)_s 的二進制函數 β 對 (m^t)_b 進行量化,并在前向傳遞中使用。訓練結束后,丟棄 (m^t)_s,只存儲 (m^t)_b 用于推理。將 m^t_s 的方程表述為:

為了簡單起見,作者用 S_t 的例子來描述推理階段。現在 S_t 有 m_p、(m^t)_b、M_g 和本地保存的說話人模塊的參數。使用 m_p 挑選權重 W^t_S,并使用 (m^t)_b 選擇性地重復使用 (W^1:t-1)_S∪(W^t+1:N)_S 中的權重。為了不傷害 S_t 的語調,將未使用的權重固定為零。用 FedSpeech 進行的兩輪訓練的總體過程見算法 1。

5.2 實驗結果分析

作者在 VCTK 數據集上進行了實驗,該數據集包含了約 44 小時的語音,由 109 位具有不同口音的英語母語者說出來。每個說話人讀出了約 400 個句子,其中大部分是從報紙上選出來的,再加上《彩虹傳》和一個旨在識別說話人口音的 elicitation 段落。為了模擬低資源語言場景,隨機選擇并將每個說話人的樣本分成 3 組:100 個樣本用于訓練,20 個樣本用于驗證,20 個樣本用于測試。作者隨機選擇了 10 位 speaker,分別表示為任務 1 至 10,進行評估。為了緩解發音錯誤的問題,作者用一個開源的字母到音素的轉換工具將文本序列轉換成音素序列。作者將原始波形轉換為 mel-spectrograms,并將幀大小和跳躍大小設置為 1024 和 256,采樣率為 22050。

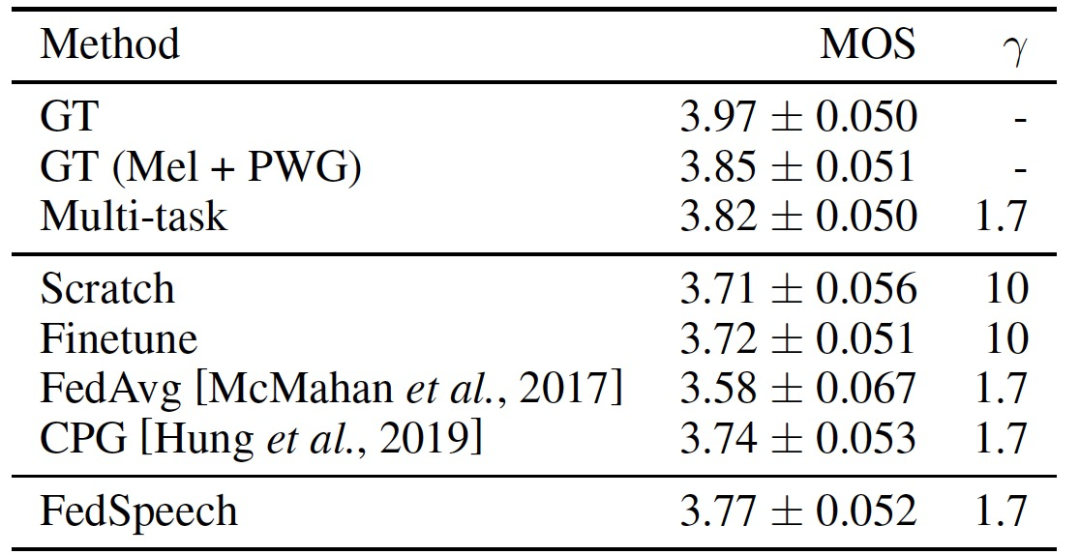

作者在測試集上評估 MOS(mean opinion score)來衡量音頻質量。不同模型之間的設置和文本內容是一致的,以排除其他干擾因素,只考察音頻質量。每個音頻都由 10 個英語為母語的人進行評判。作者將本文模型生成的音頻樣本的 MOS 與其他系統進行比較,其中包括:1)GT,VCTK 中的 ground truth 音頻。2) GT (Mel + PWG), 首先將 ground-truth 音頻轉換為 Mel-spectrograms, 然后使用 ParallelWaveGAN (PWG) 將 Mel-spectrograms 轉換為音頻;3) Multi-task, 無隱私限制的聯邦訓練;4) Scratch, 從頭開始獨立學習每個任務;5) Finetune, 從隨機選擇的前一個模型進行微調并重復 5 次(對于任務 1, Finetune 等同于 Scratch)。6)FedAvg,聚集本地信息(如梯度或模型參數)并訓練一個全局模型。7)CPG,一種用于持續學習的參數隔離方法。作者把 3)表示為上界,其他的表示為基線。相應地,3)、4)、5)、6)、7) 和 FedSpeech 中的所有系統都使用預先訓練好的 PWG 作為聲碼器進行公平比較。MOS 結果顯示在表 9 中。從表中我們可以看出,與所有基線相比,FedSpeech 取得了最高的 MOS。值得一提的是 FedSpeech 的表現優于 CPG,這說明了有選擇地重用以前和以后的 speaker 的知識的有效性。此外,FedAvg 的結果明顯比其他方法差,這意味著來自其他 speaker 的梯度極大地影響了每個 speaker 的語氣。此外,FedSpeech 在 VCTK 上的 MOS 值接近于多任務訓練(上限)。這些結果證明了 FedSpeech 在聯邦多語者 TTS 任務中的優勢。

表 9. MOS 與 95% 的置信區間。

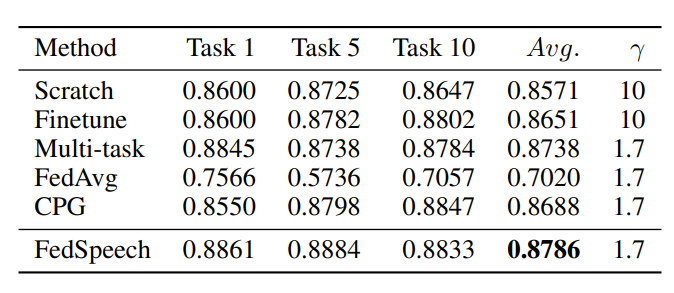

作者在測試集上進行說話人相似度評估,以衡量合成音頻和 ground-truth 音頻之間的相似度。為了排除其他干擾因素,作者在不同的模型中保持文本內容的一致性。對于每項任務,作者利用編碼器推導出總結說話人聲音特征的高級表示向量。具體來說,編碼器是一個帶有投影的 3 層 LSTM,它為提取說話人的語調嵌入進行了預訓練。余弦相似度是衡量說話人表述向量相似度的標準,其定義為 cos sim (A, B) =A - B/kAk kBk。其結果范圍從 - 1 到 1,數值越大,說明向量越相似。作者計算合成音頻的說話人表示向量和 ground-truth 音頻之間的余弦相似度作為評價標準。

最終實驗結果顯示在表 10 中。FedSpeech 的平均得分最高,甚至高于多任務的上限。這意味著 FedSpeech 可以在推理階段更好地保留每個說話人的聲音,并證明了參數隔離的有效性。此外,在任務 1 中,FedSpeech 的結果明顯高于 CPG。可以看出,有選擇地重用前一個和后一個說話人的知識給說話人帶來了很大的好處,因此,在聯邦多語者 TTS 任務中,所有的說話人都能獲得更好的聲音。

表 10. 基線和 FedSpeech 之間說話人相似度的比較。平均值是指 10 個任務的平均值,γ 是指與 256 個隱大小的 FedSpeech 相比的模型擴展率

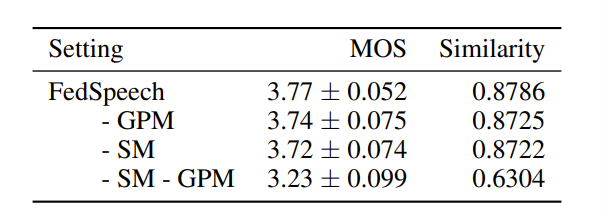

為了測量音頻質量,作者進行了 MOS 評估,每個音頻由 10 個英語母語者進行評判。如表 11 所示,去除漸進修剪掩碼或去除選擇性掩碼都不會導致明顯的質量下降,這意味著選擇性掩碼有能力自動選擇漸進修剪掩碼所保留的權重。然而,去除這兩種類型的掩碼會導致災難性的質量下降。此外,作者還進行了說話人相似性評估。如表 11 所示,稍微去除這些選擇性掩碼或漸進修剪掩碼會導致輕微的性能下降,而去除這兩個掩碼則會導致災難性的下降。可以看出,漸進修剪掩碼完美地保留了每個說話人的語調。此外,選擇性掩碼有能力自動選擇漸進修剪掩碼所保留的權重,將它們結合起來會導致更好的結果。

表 11. 在消融實驗中 MOS 和說話人相似度的比較。SM 指的是選擇性掩碼,GPM 指的是漸進修剪掩碼,相似度是余弦相似度

對于未來的工作,作者提出將繼續提高合成語音的質量,并提出新的掩碼策略來壓縮模型和加快訓練速度。此外,他們還將把 FedSpeech 應用于 zero-shot 的 multi-speaker 設置,通過使用 private speaker 模塊來生成掩碼。

6、本文小結

在這篇文章中,我們淺析了四篇聯邦連續學習相關的最新論文。這四篇文章的重點都是解決聯邦學習框架下不同客戶端間相互干擾的問題,具體選擇了將參數分解為全局參數和本地參數、著重考慮設備上存儲數據的類別意識和類別語義、增加知識蒸餾以平衡不同數據域關系等方法,在論文給出的場景中都獲得不錯的效果。不過,這些文章都沒有著重分析這種方法可能造成的通信代價。關于聯邦持續學習的實用性還有待更進一步的研究,以更好的滿足當前數據隱私保護高要求條件下的數據分析和應用需求。