「羊駝」們走到哪一步了?研究表明:最好的能達到GPT-4性能的68%

最近,大型語言模型獲得了前所未有的關注度。在更迭迅速的情況下,開源模型與閉源模型的發展并駕齊驅,同時呈現百花齊放的態勢。

但仍然令大家好奇的是,開源大模型和閉源大模型,哪一邊實力更強?又該如何對比?

近日,在推特上,華盛頓大學計算機科學博士生 Wang Yizhong 同樣對眾多指令調優數據集及開源模型的發展提出了這個疑問。

圖片

圖片

此前,一些公開的指令調優模型在宣傳時稱,自身可與功能強大的閉源專有模型 (如 ChatGPT) 相媲美,但是大部分能支持這個說法的實驗只是覆蓋了全部任務的冰山一角而已,并且這些實驗也主要依賴基于模型的評估指標。事實上,評估設置除了測試模型或人工標注的生成質量外,還應該包括測試模型的核心推理和事實回憶技能的任務,這些任務可能更開放和主觀。

在最近的一項研究中,艾倫人工智能研究所聯合華盛頓大學對指令調優資源進行了全面的評估,他們在十幾個公共語料庫上進行了大量的指令調優實驗,從 6.7B 到 65B 的模型規模都有涉及。研究還評估了特定的模型能力 (即事實知識、推理、多語言性、編碼) 和開放式的指令遵循能力,并展示了基于自動、基于模型和基于人工的評估指標的結果。

論文地址:https://arxiv.org/pdf/2306.04751.pdf

評估表明,在不同數據集上進行指令調優似乎可以提高特定的技能,沒有一個數據集能在所有評估中均提供最佳性能。他們還發現,底層基礎模型是至關重要的,更好的基礎模型 (訓練于更多 token 或是更大模型)整體表現更好。意料之外的是,研究還發現在基于模型的評估中首選的模型與在基于基準的自動評估中表現最好的模型并不匹配,這可能是由于 GPT-4 對長的、多樣化生成的強烈偏見。

評估還表明,在任何給定的評估中,最佳模型的平均性能達到 ChatGPT 的 83%、GPT-4 的 68%,這表明需要進一步構建更好的基礎模型和指令調優數據以縮小差距。

根據這些發現,研究團隊提出了「TüLU」,一套在數據源組合上進行微調的 7B 到 65B 的 LLAMA 模型。需要聲明的是,在撰寫本文時,TüLU 65B 是公開發布的最大的全指令調優 LLAMA 變體。它在 7 個流行的可用數據集上進行訓練,并產生最佳的平均性能,同時在每個單獨任務上排在最佳性能模型的 15% 以內。

研究者開源了用于訓練和評估這些大型語言模型的代碼,并發布了在不同指令數據集及其混合物上訓練的檢查點,包括 TüLU。

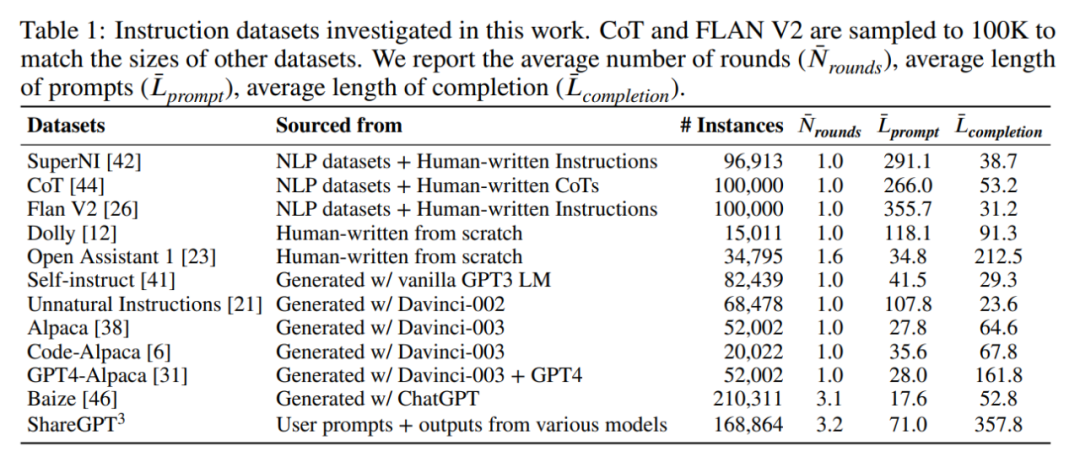

指令數據集

研究團隊試圖收集不同風格數據集的代表性樣本 (列在表 1 中),包括:

(1) 由研究人員從現有的 NLP 數據集 (SuperNI , Flan V2) 創建;

(2) 由人類從頭編寫,用于指令調優 (Dolly , Open Assistant 1 );

(3) 由專有模型生成 (Self-Instruct , Unnatural Instructions、Alpaca、Baize、GPT4-Alpaca );

(4) 由用戶共享的 prompt 和模型生成的補全組成;

(5) 為特定技能而建 (CoT 用于思維鏈,alpaca 用于代碼生成)。

圖片

圖片

預訓練模型

研究主要使用了 LLAMA 套件,這是一系列預訓練模型,大小從 6.7B 到 65B 參數不等。這些模型代表了社區可用的最大、最高質量的預訓練模型 (盡管在限制性許可下)。研究還考慮了與 LLAMA 6.7B 模型大小相當的 OPT 和 Pythia 模型,以檢查不同基礎模型的效果。

為簡單起見,研究將所有大小四舍五入為整數。團隊還注意到一些對類似或質量更好的模型進行預訓練的工作,他們相信本文的發現應該適用于這些模型以及未來更強大的開放基礎模型。

使用各種數據集訓練模型

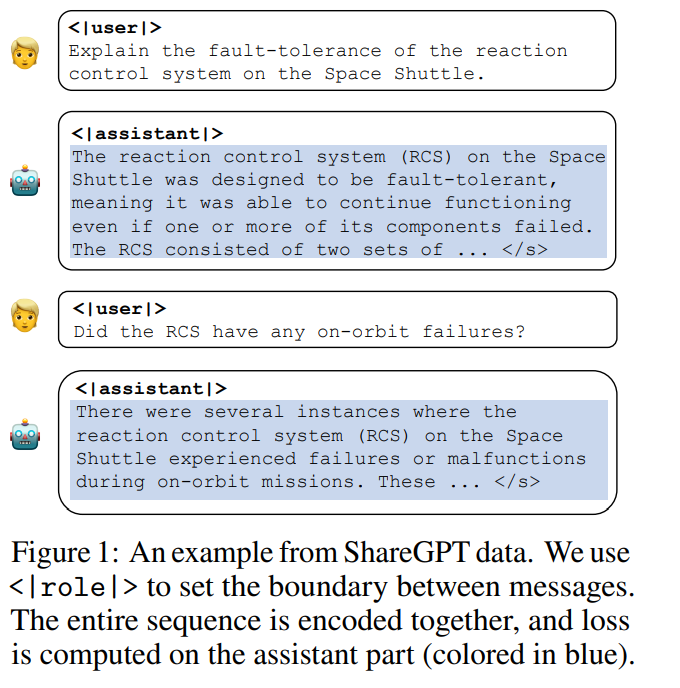

統一格式

研究將所有數據集格式化為遵循聊天機器人風格的模式,以統一指令數據集的各種風格和格式,如圖 1 所示。這讓研究團隊能夠將用戶和語言模型 (又稱「assistant」) 之間的任意輪交互擬合到一個輸入序列中,并將它們與因果語言模型一起編碼。他們在用戶話語和目標助手響應之前分別添加了特殊 token<|user|> 和 <|assistant|>,并在每個 assistant 輸出的末尾添加了一個文本結束 token,在推理時,該 token 將停止模型每輪的響應。

TüLU:整合資源,更好的指令調優模型

鑒于現有的研究表明,增加指令的多樣性能夠有效提高指令調優的性能,因此研究者將兩個數據集結合起來:

人類混合數據,由最佳的人工編寫數據集組成。包括 FLAN V2、CoT、Dolly 和 Open Assistant 1 (排除了了 SuperNI,因為 FLAN V2 已經包含了 SuperNI 中的大多數任務);

人類 + GPT 混合數據 ,包括人類混合數據和由 OpenAI GPT 模型生成的另外三個數據集,包括 GPT4-Alpaca、Code-Alpaca 和 ShareGPT。

研究團隊將這些混合數據集連接起來,并將探索更復雜的采樣混合物的工作留給未來。他們把在人類 + GPT 混合數據上訓練的 LLAMA 模型命名為 TüLU—— 不同物種之間雜交產生的雜交駱駝。

實驗結果

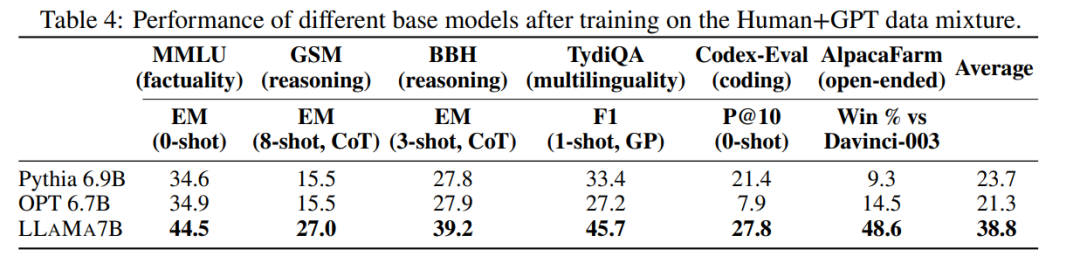

指令調優數據集和基礎模型分析

為了了解表 1 中列出的指令數據集對模型能力的貢獻,研究者使用評估套件評估了在這些數據集上訓練的 LLaMa 13B 模型。表 3 展示了基準評估集上的結果,其中 App D 的結果更為廣泛。

實驗結論如下:

- 一個跨所有任務的最佳指令調優數據集是不存在的;

- 合并數據集可以在基準任務上獲得最佳的整體性能;

- 基礎模型的質量對于下游性能非常重要。(見表 4)

圖片

圖片

挑戰開放模型的極限

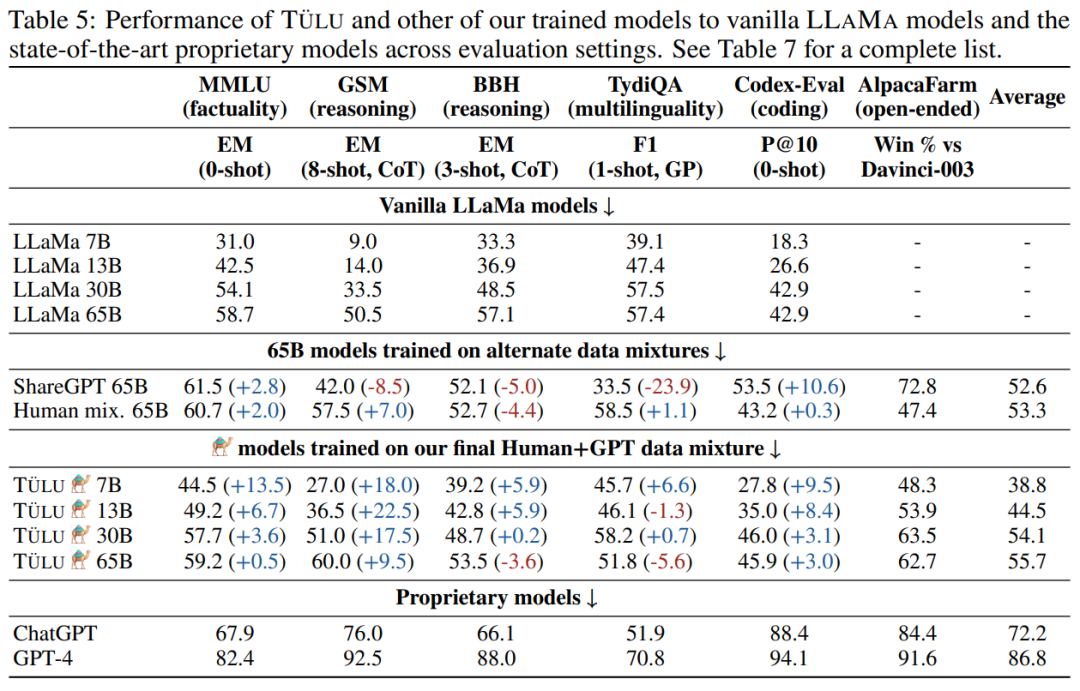

當確定「使用廣泛的數據混合是最好的」以及「使用 LLAMA 作為基礎模型比其他開放替代方案更可取」后,研究比較所有 LLAMA 尺寸的人類 + GPT 數據混合 (TüLU 模型) 上訓練的模型的性能(如表 5 所示)。

圖片

圖片

實驗結論得出:

- 指令調優給所有尺寸的 LLAMA 模型都帶來了很大的好處;

- 較小的模型從指令調優中獲益最大;

- TüLU 仍然落后于最先進的專有模型。

基于模型的開放式生成評估結果

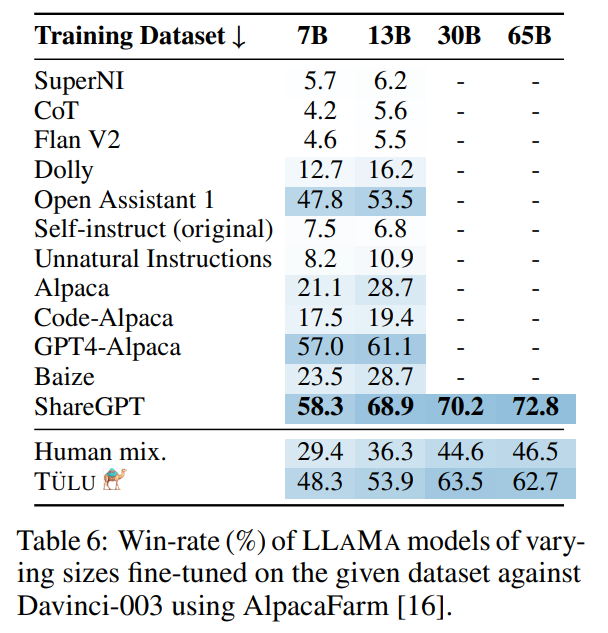

表 6 中報告了模型 AlpacaFarm 勝率。

由此可以得出以下結果:

- 基于傳統 NLP 數據集的混合模型表現不佳;

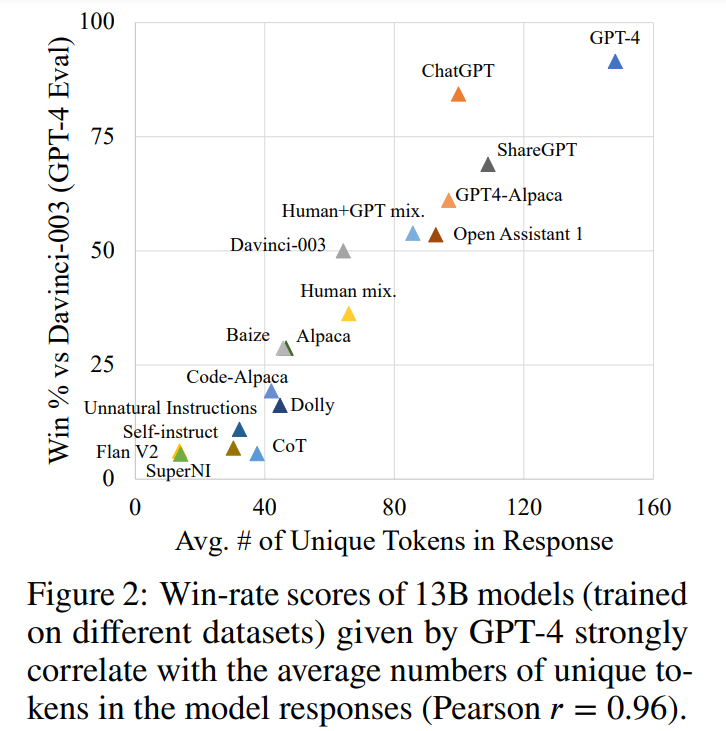

- 鼓勵長時間、多樣化代的數據集表現最好 (見圖 2);

- ShareGPT 的性能最好。

圖片

圖片

總體而言,有這些結果可以看出,雖然模型偏好評估很重要,但它并沒有提供對這些模型的整體評估。因此,在更大、更全面的評估設置里,模型偏好評估應該只作為其中的一部分。

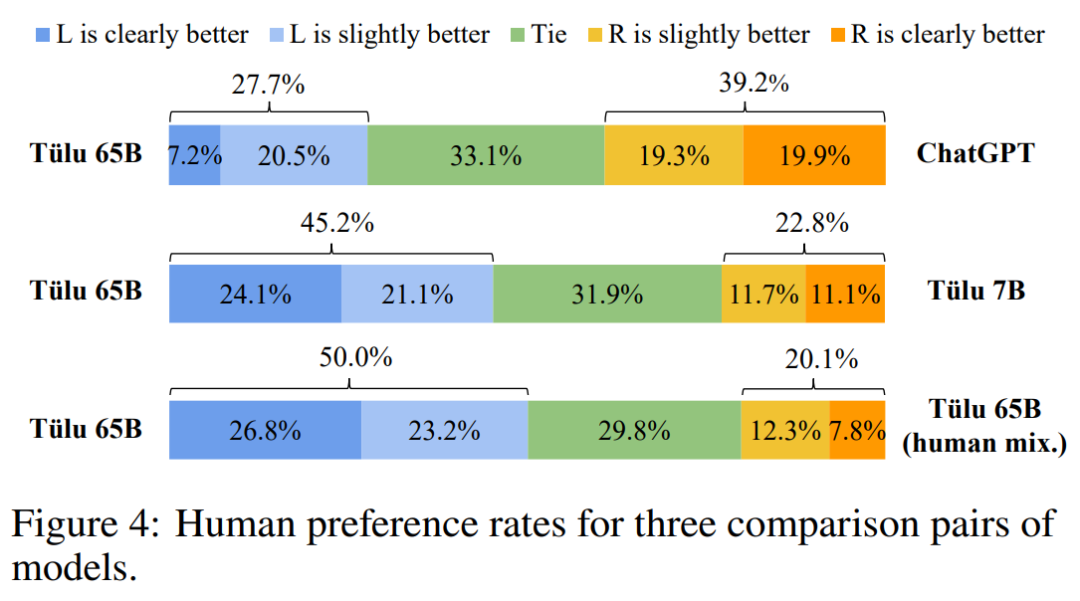

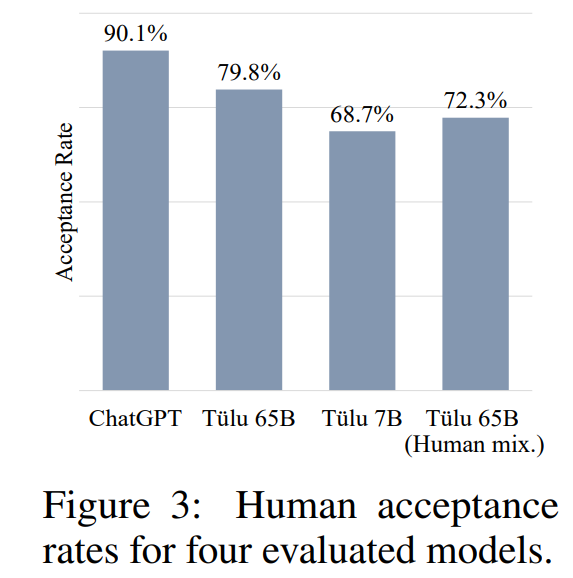

開放式生成的人工評價結果

圖 4 中展示了人工評估結果。人工評估結果與 AlpacaFarm 和基于基準的評估具有強烈相關性:所有評估表明,65B TüLU 優于 7B TüLU。這表明使用更大的基礎模型是重要的,并且在 65B TüLU 和 ChatGPT 之間仍有不小的性能差距。

圖片

圖片

除此之外,研究還發現利用蒸餾數據集可以讓性能有很大的提升,這表明相比之下人類編寫的數據集是匱乏的。這些觀察結果也與圖 3 中的可接受性分數相一致。7B TüLU 在模型偏好評估中優于 human-mix 65B TüLU,但如果比較圖 3 中的可接受性分數,則情況似乎相反。這進一步證明,模型兩兩評估可能并不始終揭示模型缺陷。在這種情況下,65B 人類混合模型比 7B 模型更有可能產生可接受的 (如果不是高質量的) 響應。

圖片

圖片

更多詳細內容,請參見原文。