這五類信息絕不能透露給AI聊天機器人

譯文譯者 | 布加迪

審校 | 重樓

人工智能聊天機器人的人氣急劇上升。雖然它們的功能令人印象深刻,但有必要承認聊天機器人并非完美無瑕。使用AI聊天機器人存在一些固有的風險,比如隱私問題和潛在的網絡攻擊。與聊天機器人進行交互時保持謹慎至關重要。

不妨探討一下與AI聊天機器人共享信息帶來的潛在危險,看看哪些類型的信息不應該透露給它們。

使用AI聊天機器人面臨的風險

與AI聊天機器人相關的隱私風險和漏洞給用戶帶來了重大的安全問題。您的聊天伙伴(比如ChatGPT、Bard、Bing AI及其他聊天機器人)可能無意中在網上暴露您的個人信息,這可能會讓您感到驚訝。這些聊天機器人依賴AI語言模型,這些模型又從您的數據中獲得洞察力。

比如說,當前版本的谷歌聊天機器人Bard在其常見問題解答(FAQ)頁面上明確表示,它收集并利用對話數據來訓練其模型。同樣,ChatGPT也存在隱私問題,因為它可以保留聊天記錄用于改進模型。但它為用戶提供了選擇退出的選項。

由于AI聊天機器人將數據存儲在服務器上,它們很容易受到黑客攻擊。這些服務器儲存有大量的信息,網絡犯罪分子可以運用各種方式利用這些信息。他們可以潛入服務器,竊取數據,然后拿到暗網市場上出售。此外,黑客還可以利用這些數據破解密碼,并獲得對您設備的未授權訪問。

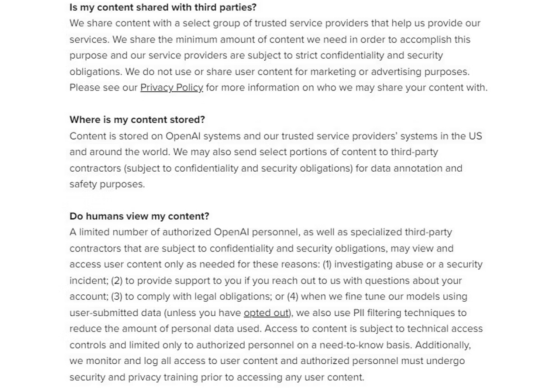

此外,您與AI聊天機器人進行交互所產生的數據不僅限于相應的公司。雖然它們堅持認為這些數據不是為了廣告或營銷目的而出售的,但出于系統維護需求,這些數據會與某些第三方共享。

ChatGPT背后的組織OpenAI承認,自己與“一小批可信賴的服務提供商”共享數據,一些“已獲得授權的OpenAI人員”可能有權訪問這些數據。這些做法進一步引發了人們對AI聊天機器人交互的安全擔憂,批評人士認為,生成式AI的安全問題可能會加劇。

因此,保護個人信息避免透露給AI聊天機器人對于保護您的隱私而言至關重要。

與AI聊天機器人有什么不能分享?

為了確保您的隱私和安全,在與AI聊天機器人進行交互時,遵循以下五個最佳實踐極為重要。

1. 財務資料

網絡犯罪分子會使用ChatGPT這樣的AI聊天機器人闖入您的銀行賬戶嗎?隨著AI聊天機器人的廣泛使用,許多用戶已經轉向這些語言模型來尋求財務建議和管理個人財務。雖然它們可以提高金融素養,但了解與AI聊天機器人分享財務資料所帶來的潛在危險卻至關重要。

將聊天機器人用作財務顧問時,您可能會將自己的財務信息暴露給潛在的網絡犯罪分子,他們可能會利用這些信息來盜取賬戶中的錢財。盡管許多公司聲稱對會話數據進行了匿名處理,但第三方和一些員工可能仍然可以訪問這些數據。這就讓人擔心信息分析活動:您的財務信息可能被用于惡意目的,比如從事勒索軟件活動或賣給營銷機構。

為了保護您的財務信息不被AI聊天機器人獲取,您必須注意自己泄露給這些生成式AI模型的內容。互動僅限于獲取一般的信息和提出寬泛的問題是明智之舉。如果您需要個性化的理財建議,可能有比完全依賴AI聊天機器人更好的選擇。AI聊天機器人可能會提供不準確或誤導性的信息,因而可能讓您的血汗錢打水漂。相反,應考慮向持有執照的財務顧問尋求建議,他們可以提供可靠且量身定制的指導。

2. 您個人的內心想法

許多用戶轉向AI聊天機器人尋求治療,卻沒有意識到這對他們的心理健康可能產生的后果。了解向這些聊天機器人泄露個人內心想法的危險至關重要。

首先,聊天機器人缺乏現實世界的知識,只能對與心理健康相關的問題提供寬泛的回答。這意味著它們建議的藥物或治療方法可能不適合您的具體需求,可能會損害您的健康。

此外,向AI聊天機器人透露個人想法引發了嚴重的隱私問題。您的隱私可能會因而受到損害,私密的想法可能會泄露到網上。不懷好意的人可能會利用這些信息來監視您,或者在暗網上出售您的數據。因此,在與AI聊天機器人進行交互時要注意保護個人想法的隱私。

將AI聊天機器人視作提供一般信息和支持的工具,而不是專業治療的替代品。如果您需要心理健康建議或治療,咨詢合格的心理健康專家始終是可取的。他們可以提供個性化的可靠指導,同時又注重您的隱私和幸福。

3. 工作場所的機密信息

用戶在與AI聊天機器人進行交互時必須避免的另一個錯誤是分享機密的工作信息。即使是蘋果、三星、摩根大通、Bard的開發者,谷歌等知名科技巨頭也限制員工們在工作場所使用AI聊天機器人。

彭博社的一篇報道曾強調了三星員工將ChatGPT用于編程目的,結果無意中將敏感代碼上傳到了生成式AI平臺的案例。這起事件導致了三星的機密信息未經授權泄露出去,促使該公司禁止使用AI聊天機器人。作為尋求AI幫助以解決編程問題的開發人員,這就是為什么您不應該將機密信息交給像ChatGPT這樣的人工智能聊天機器人來處理的原因。在共享敏感代碼或工作相關細節時,必須謹慎行事。

同樣,許多員工依靠AI聊天機器人來總結會議紀要或自動處理重復性任務,這可能會無意中暴露敏感數據。因此,保持機密工作信息的隱私性,避免與AI聊天機器人共享是至關重要的。

用戶可以通過注意與共享工作相關的數據有關的風險來保護其敏感信息,并保護其組織免受無意的泄漏或數據泄露。

4. 密碼

有必要強調的是,在網上分享您的密碼、即使是分享給語言模型,也是絕對不允許的。這些模型將您的數據存儲在公共服務器上,向它們泄露您的密碼會危及您的隱私。一旦服務器受到攻擊,黑客就可以訪問并利用您的密碼,造成經濟損失。

2022年5月發生了一起涉及ChatGPT的重大數據泄露事件,引發了人們對聊天機器人平臺安全性的嚴重擔憂。此外,由于歐盟的《通用數據保護條例》(GDPR),ChatGPT在意大利被禁止。意大利監管機構認為這款AI聊天機器人不符合隱私法,突顯了該平臺上數據泄露的風險。因此,保護您的登錄憑據、以免泄露給AI聊天機器人變得至關重要。

通過避免與這些聊天機器人模型分享您的密碼,您可以主動保護自己的個人信息,減小成為網絡威脅受害者的可能性。請記住,保護您的登錄憑據是確保在線隱私和安全的一個重要步驟。

5. 住宅資料及其他個人資料

避免與AI聊天機器人共享個人身份信息(PII)非常重要。PII包含可用于識別或定位您的敏感數據,包括您的位置、社會保險號、出生日期和健康信息。在與AI聊天機器人進行交互時,確保個人和住宅資料的隱私應該是重中之重。

為了在與AI聊天機器人進行交互時保護您的個人數據隱私,以下是幾個值得遵循的關鍵做法:

- 熟悉聊天機器人的隱私政策,以了解相關風險。

- 避免問一些可能無意中暴露您身份或個人信息的問題。

- 要謹慎行事,盡量不要與AI機器人分享您的醫療信息。

- 在SnapChat等社交平臺上使用AI聊天機器人時,應注意您數據的潛在漏洞。

避免與AI聊天機器人分享過多的信息

綜上所述,AI聊天機器人技術在取得重大進步的同時,它也帶來了嚴重的隱私風險。在與AI聊天機器人進行交互時,通過控制共享的信息來保護自己的數據至關重要。應保持警惕,并遵守最佳實踐,以減小潛在風險并確保隱私。

原文標題:5 Things You Must Not Share With AI Chatbots,作者:WASAY ALI