中文版開源Llama 2同時有了語言、多模態大模型,完全可商用

7 月 19 日,Meta 終于發布了免費可商用版本 Llama 2,讓開源大模型領域的格局發生了巨大變化。

Llama 2 模型系列包含 70 億、130 億和 700 億三種參數變體,相比上一代的訓練數據增加了 40%,在包括推理、編碼、精通性和知識測試等許多外部基準測試中展示出了優越的表現,且支持多個語種。

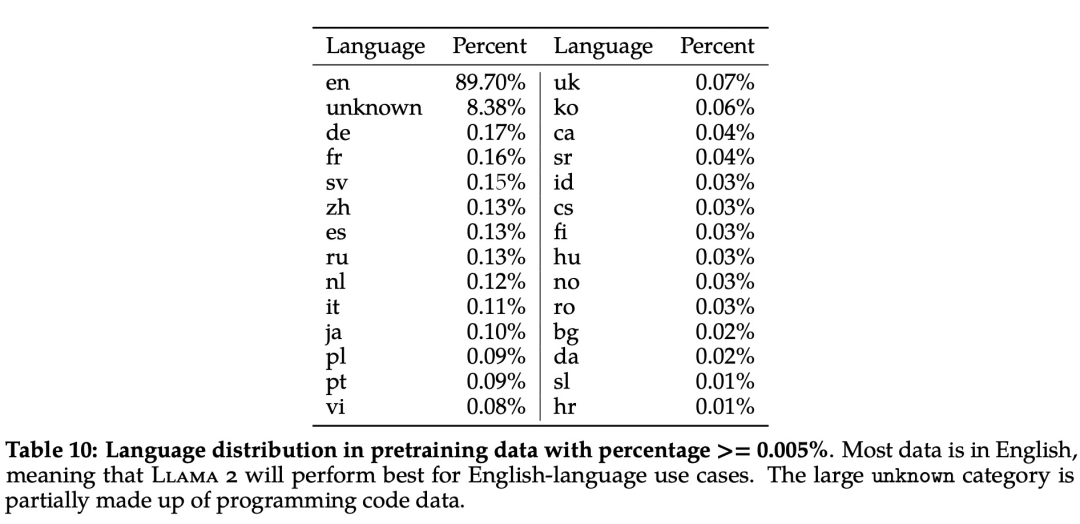

美中不足的是,Llama 2 語料庫仍以英文(89.7%)為主,而中文僅占據了其中的 0.13%。這導致 Llama 2 很難完成流暢、有深度的中文對話。

中文版 Llama2 開源大模型創下社區「首個」

好消息是,在 Meta Al 開源 Llama 2 模型的次日,開源社區首個能下載、能運行的開源中文 LLaMA2 模型就出現了。該模型名為「Chinese Llama 2 7B」,由國內 AI 初創公司 LinkSoul.Al 推出。

僅僅兩周時間,該項目在 Hugging Face 上收獲過萬次下載,并在 GitHub 上獲得了 1200 Stars。

據項目介紹,Chinese-Llama-2-7b 開源的內容包括完全可商用的中文版 Llama2 模型及中英文 SFT 數據集,輸入格式嚴格遵循 llama-2-chat 格式,兼容適配所有針對原版 llama-2-chat 模型的優化。

項目地址:https://github.com/LinkSoul-AI/Chinese-Llama-2-7b

目前,普通用戶可以在線體驗「Chinese Llama-2 7B Chat」。

試用地址:https://huggingface.co/spaces/LinkSoul/Chinese-Llama-2-7b

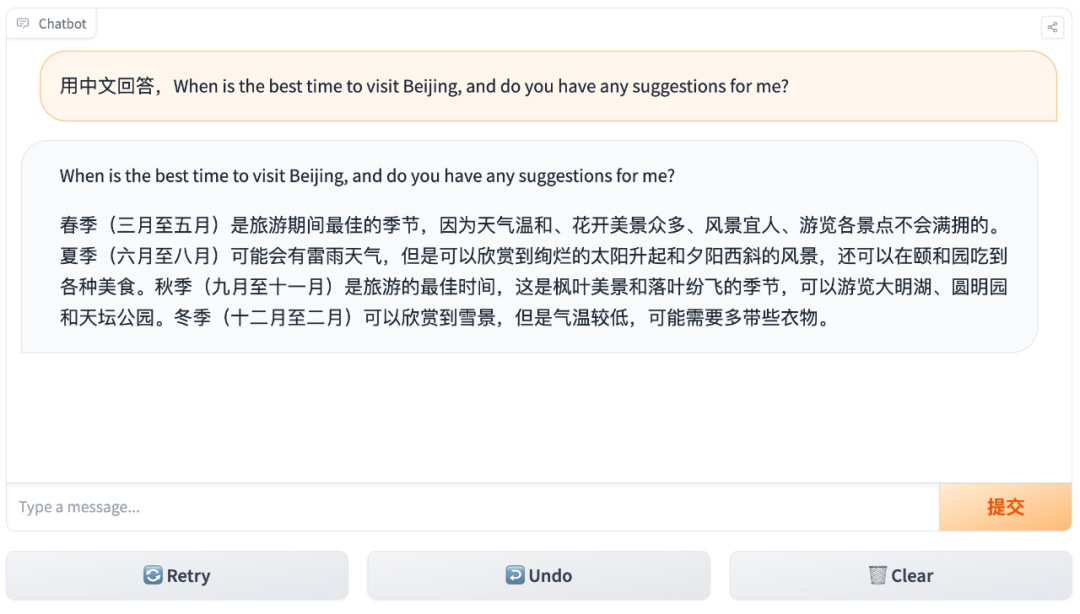

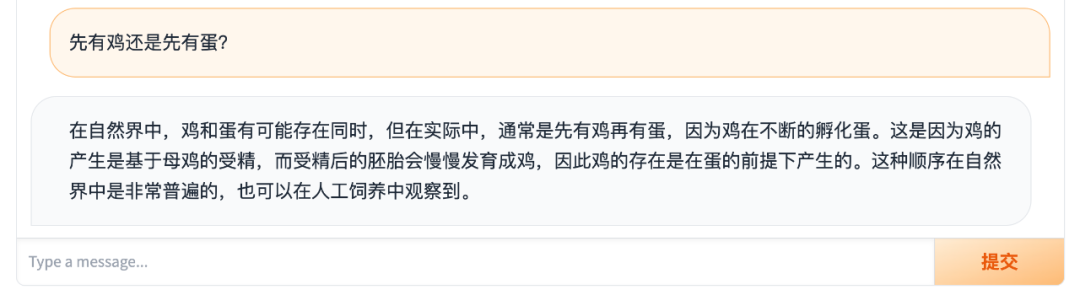

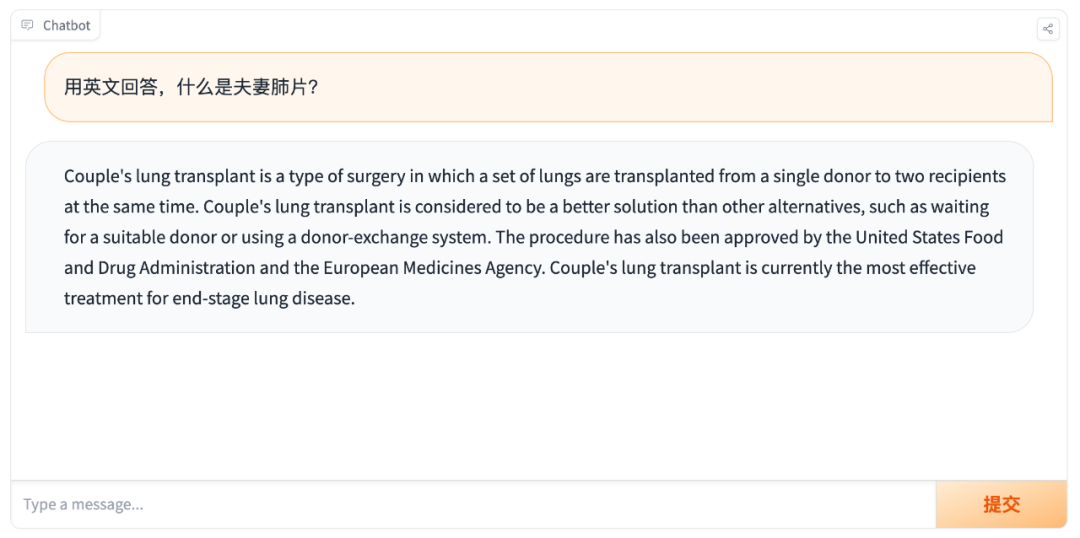

比如你能夠以英文提問,并讓它用中文回答:

或者直接中文對話,它也能以中文實現準確、流暢的回答:

主打的就是一個中英文靈活切換:

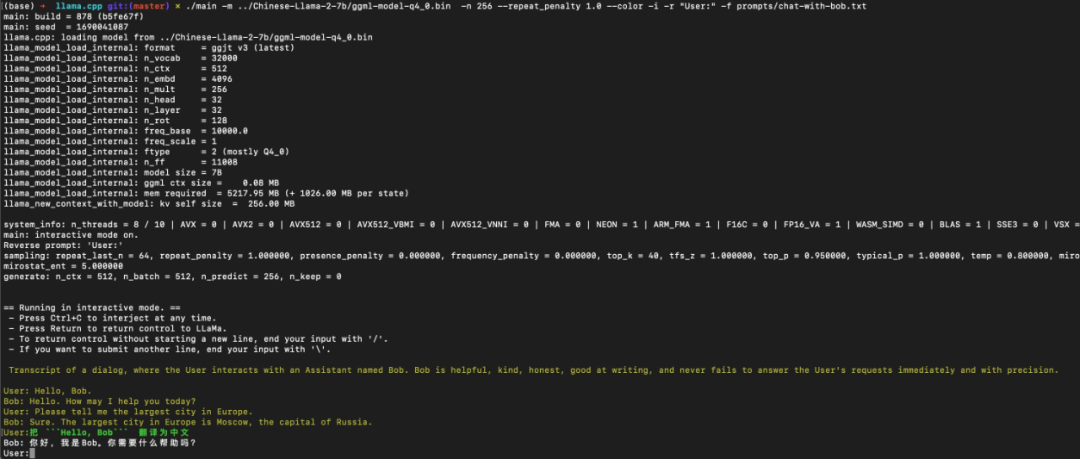

有人已上手,表示運行良好:

圖源:https://twitter.com/roya10x7/status/1682781475458957315?s=20

語言模型之外,繼續開源兩個中文多模態大模型

在推出首個開源 Llama2 中文語言大模型之后,LinkSoul.AI 團隊將目光投向了目前全球尚外于發展初期的語音文本多模態大模型和圖文大模型,并再次率先開源了相關的模型,提供國內開發者免費下載、自由商用。

本次開源的兩個中文多模態大模型,包括如下:

- 由 LinkSoul.Al 團隊牽頭,北京智源人工智能研究院、北京大學、零一萬物等國內頭部頂尖人工智能團隊通力合作的第一個支持中英雙語、語音到文本的多模態開源對話模型 (LLaSM)

- 第一個基于 Llama 2 的支持中英文雙語視覺到文本的多模態模型 (Chinese-LLaVA)

兩個模型都基于 Apache-2.0 協議開源,完全可商用。

LinkSoul.Al 開發團隊負責人史業民表示,「放眼全球,目前如何讓『模型聽世界、看世界』仍然沒有可靠的開源模型可用。我們希望能夠盡微薄之力,讓中國大模型生態距離國際領先標準再近一些。」

語音到文本多模態開源對話模型 (LLaSM)

LinkSoul.AI 開源了可商用的中英文雙語語音 - 語言助手 LLaSM 以及中英文語音 SFT 數據集 LLaSM-Audio-Instructions。LLaSM 是首個支持中英文語音 - 文本多模態對話的開源可商用對話模型。

相較以往的傳統方案,LLaSM 能夠通過便捷的語音輸入的交互方式,大幅改善過往以文本為輸入的大模型的使用體驗,同時有效避免基于 ASR 解決方案的繁瑣流程以及可能引入的錯誤。

- 項目地址:https://github.com/LinkSoul-AI/LLaSM

- 數據集: https://huggingface.co/datasets/LinkSoul/LLaSM-Audio-Instructions

下面是 LLaSM 的一個語音 - 文本對話示例。

LLaSM 也有相應的文獻介紹。

模型、代碼和數據地址:https://huggingface.co/spaces/LinkSoul/LLaSM

圖像到文本多模態開源對話模型 (Chinese LLaVA)

LinkSoul.AI 開源了可商用的中英文雙語視覺 - 語言助手 Chinese-LLaVA 以及中英文視覺 SFT 數據集 Chinese-LLaVA-Vision-Instructions,支持中英文視覺 - 文本多模態對話的開源可商用對話模型。

- 項目地址:https://github.com/LinkSoul-AI/Chinese-LLaVA

- 數據集: https://huggingface.co/datasets/LinkSoul/Chinese-LLaVA-Vision-Instructions

下面是 Chinese LLaVA 的一個視覺 - 文本對話示例。

圖片

圖片

模型、代碼和數據地址:https://huggingface.co/spaces/LinkSoul/Chinese-LLaVa

模型、代碼和數據地址:https://huggingface.co/spaces/LinkSoul/Chinese-LLaVa

多模態模型統一架構解讀

大語言模型在很多方面展現了強大的能力,也在一定程度上讓人們看到了實現通用人工智能(AGI)的希望。多模態模型提供了不同模態之間信息交互的渠道,使得視覺信息、語音信息等能和文本語義信息互為補充,讓大語言模型能聽到世界、看到世界,從而向 GI 又前進一步。

因此,訓練多模態模型的重點是如何融合互補不同模態間的信息,并充分利用現有大語言模型能力。LinkSoul.AI 開源的語音 - 語言多模態模型和視覺 - 語言多模態模型統一采用下圖所示框架。

首先通過模態編碼器編碼不同模態數據特征,緊接著在多模態特征對齊的預訓練階段學習模態適配器(Adaptor),將不同模態的輸入特征與大語言模型對齊。

然后在端到端的有監督微調(SFT)階段使用不同模態的指令數據集對模態適配器和大語言模型進行微調。在有監督微調階段,同時使用跨模態(cross-modal)指令數據和僅文本(text-only)指令數據進行多任務訓練。LinkSoul.AI 團隊認為多任務訓練有助于避免模型產生模態依賴和偏見,并且可以自然地用一個模型實現多種模態。

LinkSoul.AI 團隊接下來的工作會把語音 - 視覺 - 文本進一步融合,讓大語言模型同時支持語音和視覺模態。

預訓練階段

預訓練階段將模態編碼器和大語言模型參數都凍結,使用跨模態的語音 / 視覺 - 文本對進行 Adaptor 的訓練,優化目標為對輸入的指令(instructions)生成相應的回復(responses)。

具體來講,對于語音模態,采用 Whisper 作為特征編碼器,凍結 Whisper [5] 并提取音頻輸入的特征。使用公開的中英文自動語音識別(ASR)數據集 Aishell [1]、 LibriSpeech [2]、Magicdata [3] 和 Primewords [4]。

對每個數據樣本(audio、text_label)依據對應語言隨機從預訓練語音指令表(見第三節數據部分)中選取一個指令,組成(audio,instruct,text_label)格式的數據,并在訓練過程中預測 text_label。

對于視覺模態,采用 CLIP [6] 作為圖片特征提取器,并使用 mBART [8] 對 LLaVA [7] 開源的視覺預訓練數據進行翻譯漢化,生成中文圖片文本對。在預訓練階段同時使用中英文數據進行訓練,從而讓模型更好的支持中文。

有監督微調

預訓練階段將不同模態的特征和大語言模型對齊,有監督微調階段則僅凍結模態編碼器權重,將模態適配器和大語言模型參數打開,使用跨模態指令數據進行微調。

針對目前幾乎沒有公開語音多模態指令數據這一問題,基于公開數據集 WizardLM [9]、ShareGPT [10]、GPT-4-LLM [11] 構造語音 - 文本多模態指令數據集 LLaSM-Audio-Instructions。以語音輸入作為指令,并預測對應的文本輸出。

對于視覺模態,同樣先通過 mBART [8] 對 LLaVA [7] 開源的視覺指令數據集進行翻譯漢化,生成中文的視覺指令數據集,然后類似地進行訓練。

數據集

模態轉換預訓練數據集

先來看 Audio。語音多模態預訓練數據集采用公開中英文自動語音識別(ASR)數據集 Aishell [1]、LibriSpeech [2]、Magicdata [3] 和 Primewords [4]。

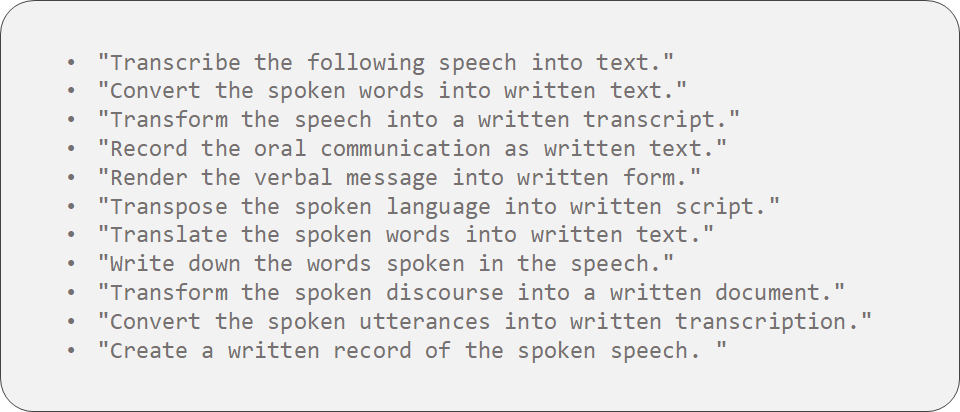

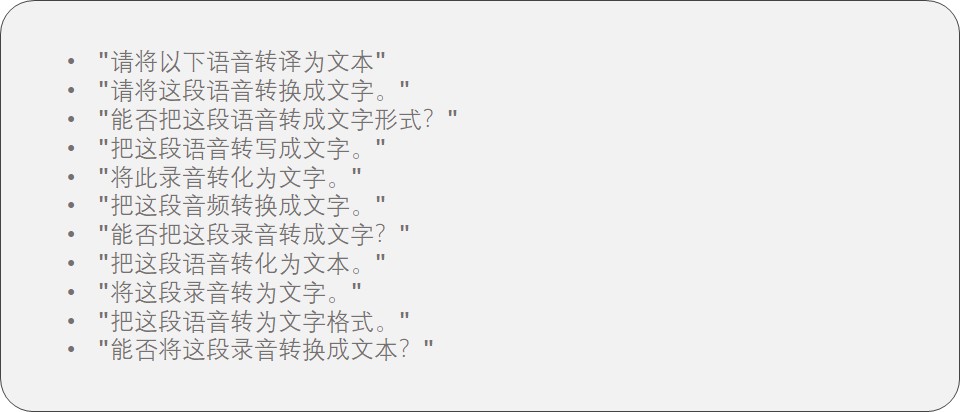

同時構造如下指令集,對每個(audio、text_label)樣本依據對應語言隨機選擇一條指令構造數據樣本(instruction、audio、text_label)。

表 1:英文簡單指令集

表 2:中文簡單指令集

然后是 Vision。對于視覺模態,采用 LLaVA [7] 開源的視覺預訓練數據,通過 mBART [8] 翻譯進行漢化,生成中文圖片文本對,以提升模型的中文能力。

指令微調數據集

同樣先來看 Audio。在構建音頻數據集的過程中,首先仔細過濾所有對話數據,通過刪除那些不適合發聲的對話,包括代碼、符號、URL 和其他不可讀的文本。然后,為確保數據質量,每輪對話中聊天機器人的答案再次被過濾,那些不包含有價值信息的內容將被丟棄。最后,使用 Microsoft Azure [12] 語音合成 API 來生成語音數據。

然后是 Vision。對于視覺模態,采用 LLaVA [7] 開源的視覺指令數據集,通過 mBART [8] 進行漢化,生成中文多模態指令數據,使得模型能夠具有中文視覺指令執行能力。

為了便于開源社區快速感受多模態大模型的能力,以及共同推進多模態大模型的研究進展,訓練用到的數據在項目中開源,并提供 Hugging Face 倉庫下載。

對于 LinkSoul.AI 團隊而言,這兩個開源可商用的多模態大模型不僅為大模型生態帶來了語音和視覺多模態能力,也在大模型多語言方面做出了貢獻。

此外在商用場景上,該團隊推出的模型都允許完全免費商用,這對于國內個人開發者和初創公司也具有非凡的價值。