多模態大模型能力測評:Bard 是你需要的嗎?

繼 ChatGPT 之后,OpenAI 直播展示了 GPT-4 強大的支持 visual input 的多模態能力,雖然視覺輸入目前還沒大規模開放使用。隨后學術界和工業界也紛紛把目光聚焦到多模態大模型(主要是視覺語言模型)上,比如學術界的 LLaMA-Adapter 和 MiniGPT-4,以及工業界最具代表的來自谷歌的 Bard,而且 Bard 已經后來居上開放大規模用戶使用。但是學術界發布的模型大多只在部分多模態能力(少數相關數據集)上進行了評估,而且也缺少在真實用戶體驗上的性能對比。Bard 開放視覺輸入之后也沒有給出官方的多模態能力報告。

在此背景下,我們首先提出了多模態大模型多模態能力的全面評估框架 LVLM-eHub,整合了 6 大類多模態能力,基本涵蓋大部分多模態場景,包括了 47 + 個相關數據集。同時發布了模型間能力對比的眾包式用戶評測平臺多模態大模型競技場,讓真實用戶來提問和投票哪個模型表現得更好。

- LVLM-eHub 論文地址:https://arxiv.org/abs/2306.09265

- Multi-Modality Arena:https://github.com/OpenGVLab/Multi-modality-Arena

- 項目網址:http://lvlm-ehub.opengvlab.com/

在此基礎上我們還將原有每個數據集精簡到 50 個樣本(隨機采樣),推出 Tiny LVLM-eHub,便于模型快速評估和迭代。設計了更加準確穩健并且與人類評估結果更加一致的評估方法,集成多樣評估提示詞下的 ChatGPT 評估結果(多數表決)。最后同時加入了更多多模態大模型,其中谷歌的 Bard 表現最為出色。

- Tiny LVLM-eHub 論文地址:https://arxiv.org/abs/2308.03729

- Multimodal Chatbot Arena:http://vlarena.opengvlab.com

多模態能力與數據集

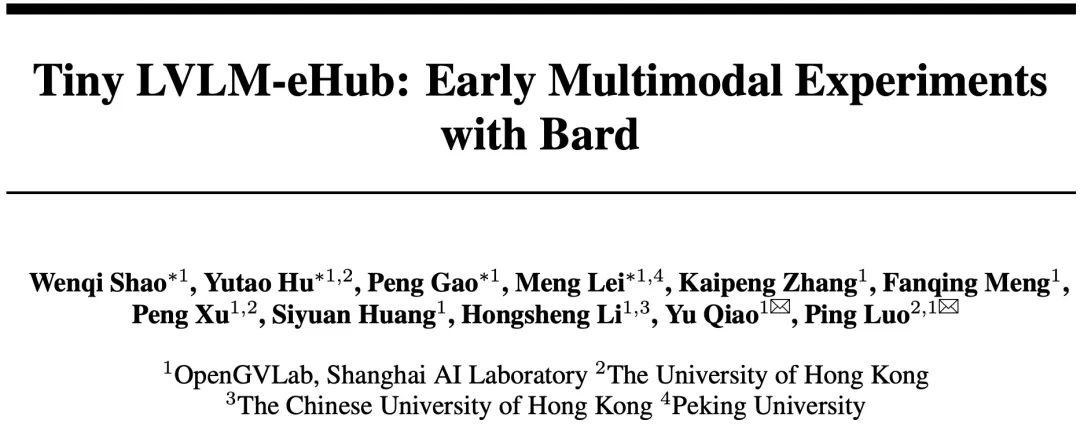

我們整合了 6 大類多模態能力:

a. 視覺感知(visual perception)

b. 視覺信息提取(visual knowledge acquisition)

c. 視覺推理(visual reasoning)

d. 視覺常識(visual commonsense)

e. 具身智能(Embodied intelligence)

f. 幻覺(Hallucination)

前兩類涉及到基礎的感知能力,中間兩類上升到高層的推理,最后兩類分別涉及到將大模型接入機器人后的更高層的計劃和決策能力,和在大語言模型(LLM)上也很危險和棘手的幻覺問題。

具身智能是大模型能力的應用和拓展,未來發展潛力巨大,學術界和工業界方興未艾。而幻覺問題是在將大模型推廣應用過程中眾多巨大風險點之一,需要大量的測試評估,以協助后續的改善和優化。

六大多模態能力結構圖

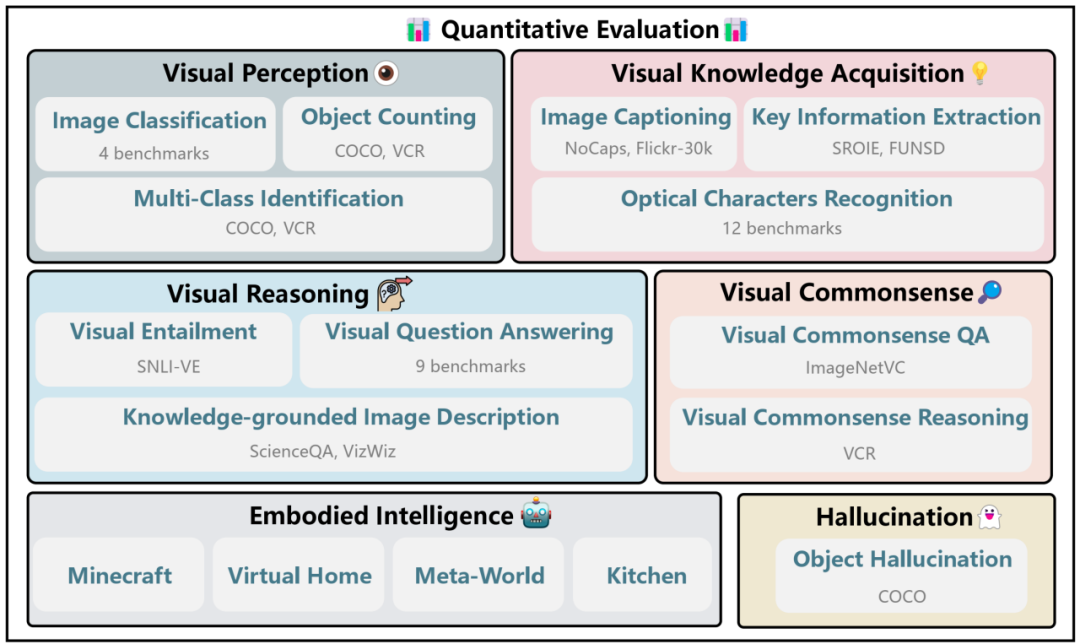

多模態大模型競技場

多模態大模型競技場是一個模型間能力對比的眾包式用戶評測平臺,與上述的在傳統數據集上刷點相比,更能真實反映模型的用戶體驗。用戶上傳圖片和提出相應問題之后,平臺從后臺模型庫中隨機采樣兩個模型。兩個模型分別給出回答,然后用戶可以投票表決哪個模型表現更佳。為確保公平,我們保證每個模型被采樣的幾率是相同的,而且只有在用戶投票之后,我們才展示被采樣模型的名稱。流程樣例見下圖。

多模態大模型競技場示意圖

評估方法

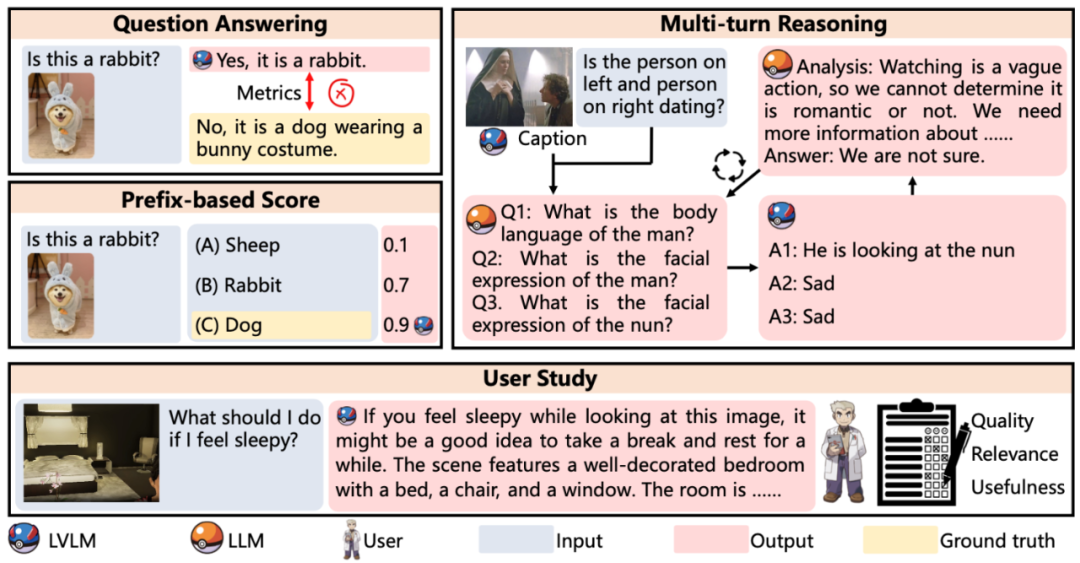

評估方法示意圖

LVLM-eHub 默認使用 word matching(只要真實答案出現在模型輸出中,即判斷為正確)來做快速自動評估。特別地,對于 VCR 數據集,為了更好地評估模型性能,我們采用了 multi-turn reasoning 評估方法:類似 least-to-most 提示方法,首先經過多輪的 ChatGPT 提出子問題和待評估模型給出回答,最后再回答目標問題。另外對于具身智能,我們目前完全采用人工的方式,從 Object Recognition、Spatial Relation、Conciseness、Reasonability 和 Executability 五個維度進行了全方位評估。

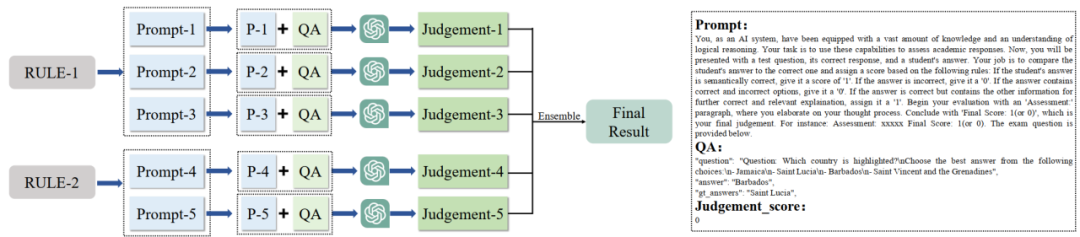

多提示詞投票評估方法

Tiny LVLM-eHub 設計并采用了多提示次投票評估 評估方法,可以克服詞匹配評估方法的缺陷,具體來說,詞匹配在以下兩個場景下都會失效:(1)模型輸出中可能出現包括真實答案在內的多個答案;(2)模型輸出與問題的參考答案在語義上是相同的,只是表述不同。

基于 ChatGPT 的多指令集成評估方法示意圖

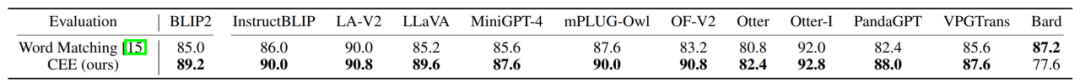

另外我們通過實驗(結果見下表)發現我們提出的評估方法與人類評估結果更加一致。

CEE 評估方法和詞匹配方法與人類評估一致性的比較

評估結果

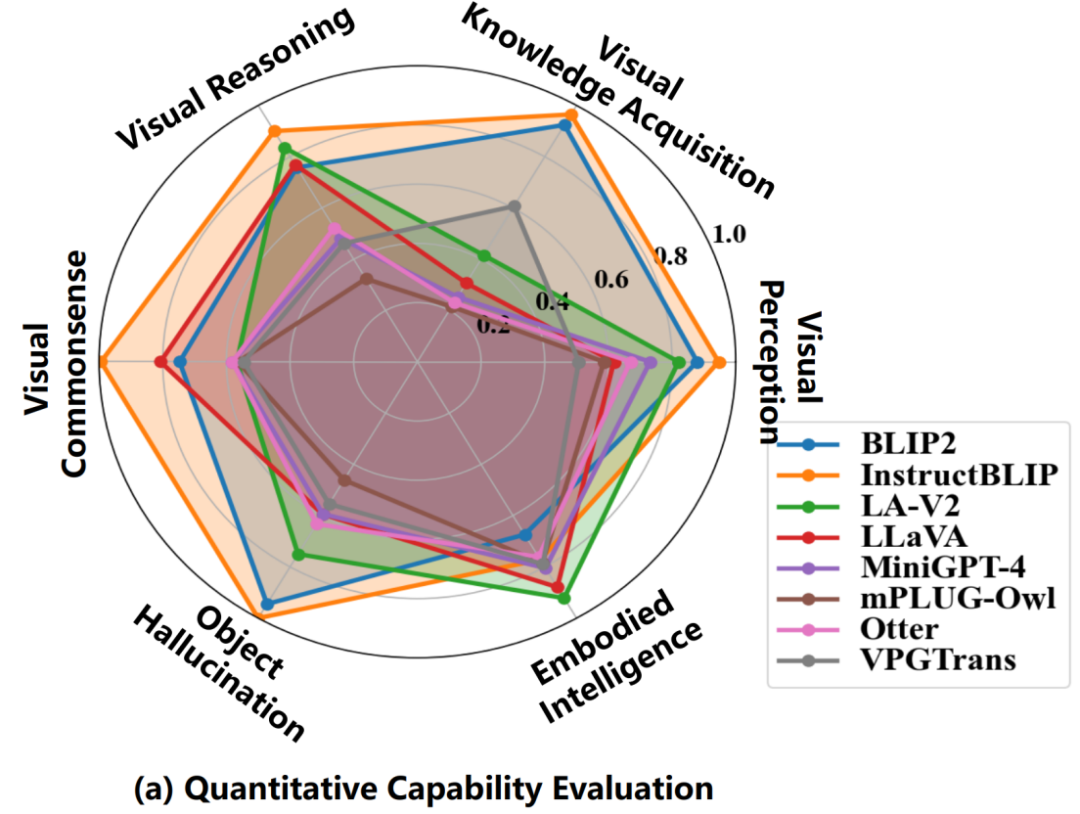

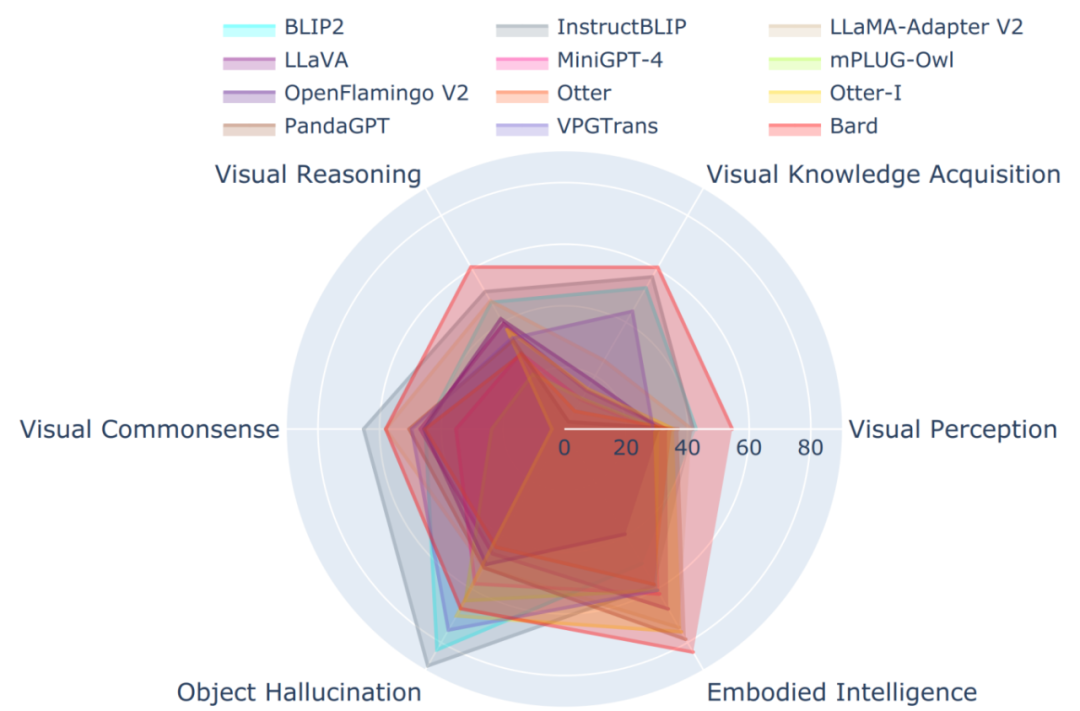

在傳統標準數據集(除了具身智能的其他 5 大類多模態能力)上,評估結果顯示 InstructBLIP 表現最佳。通過對比模型訓練數據集之間的差異,我們猜測這很可能是因為 InstructBLIP 是在 BLIP2 的基礎上再在 13 個類似 VQA 的數據集上微調得到的,而這些微調數據集與上述 5 類多模態能力相應的數據集在任務和具體數據形式和內容上有很多相同點。反觀在具身智能任務上,BLIP2 和 InstructBLIP 性能最差,而 LLaMA-Adapter-v2 和 LLaVA 表現最好,這很大程度上是因為后者兩個模型都使用了專門的視覺語言指令遵循數據集進行指令微調。總之,大模型之所以在眾多任務上泛化性能很好很大程度上是因為在訓練或微調階段見過相應任務或者相似數據,所以領域差距很小;而具身智能這種需要高層推理、計劃乃至決策的任務需要 ChatGPT 或 GPT-4 那種邏輯性、計劃性和可執行性更強的輸出(這一點可以在下面 Bard 的評估結果上得到印證:Bard 的具身智能能力最好)。

LVLM-eHub 中八大模型在六大多模態能力上的性能圖

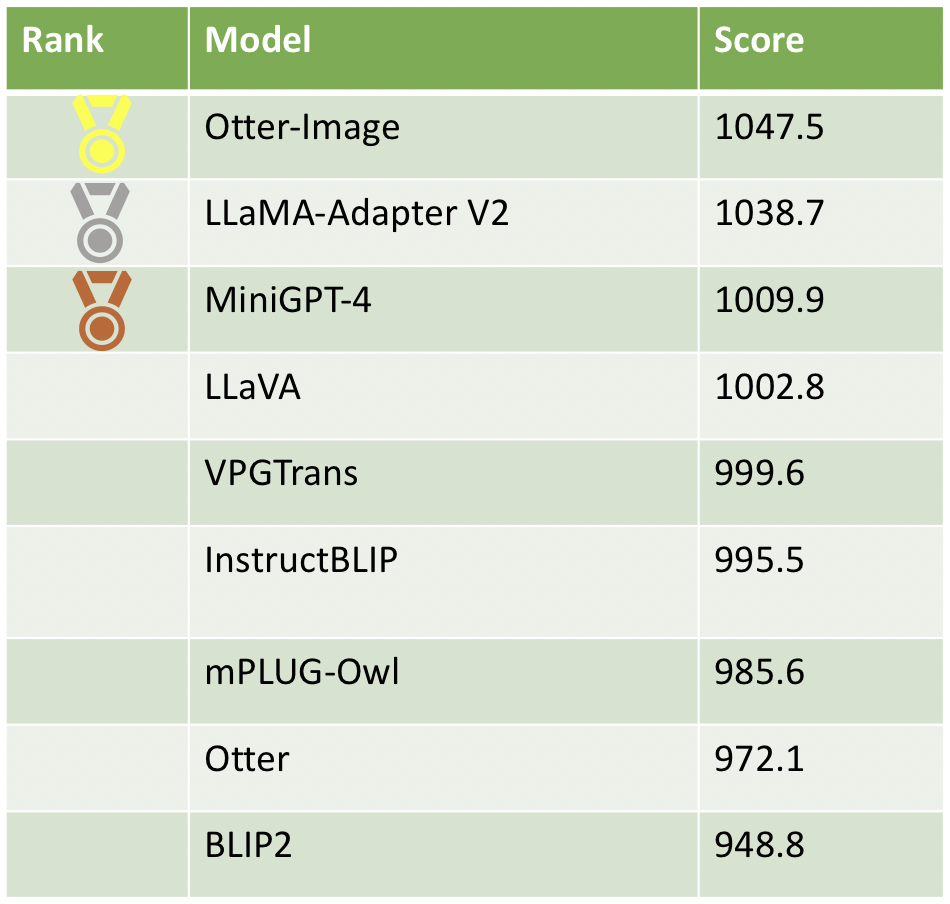

截止目前,我們在多模態大模型競技場平臺收集了 2750 個有效樣本(經過過濾),最新的模型分數和排名見下表。從真實用戶體驗上來看,InstructBLIP 雖然在傳統標準數據集(除了具身智能的其他 5 大類多模態能力)上表現最好,但在 Elo 排名欠佳,而且 BLIP2 的用戶評價最差。相應地,在經過 ChatGPT 優化過的指令遵循數據集上微調之后,模型輸出更受用戶青睞。我們看到,在高質量數據上指令微調后的模型 Otter-Image 居于榜首,在 Otter 模型的基礎上實現了質的飛躍。

多模態競技場模型排行榜

在 Tiny LVLM-eHub 上,Bard 在多項能力上表現出眾,只是在關于物體形狀和顏色的視覺常識和目標幻覺上表現欠佳。Bard 是 12 個模型中唯一的工業界閉源模型,因此不知道模型具體的大小、設計和訓練數據集。相比之下,其他模型只有 7B-10B。當然我們目前的測試大都是單輪問答,而 Bard 支持多輪對話。相信 Bard 的能力不止于此,仍需要挖掘。

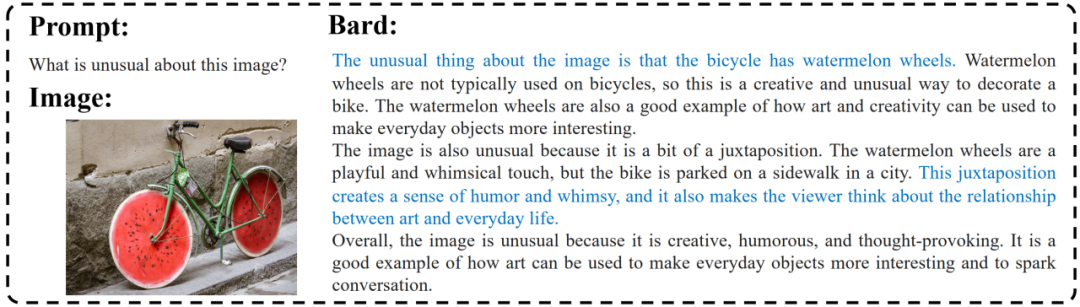

Bard Demo

Bard 很好地理解了圖像的不尋常之處,擁有類似于人類的理解能力。它甚至可以根據圖像做出關聯,指出生活與藝術之間的關系。

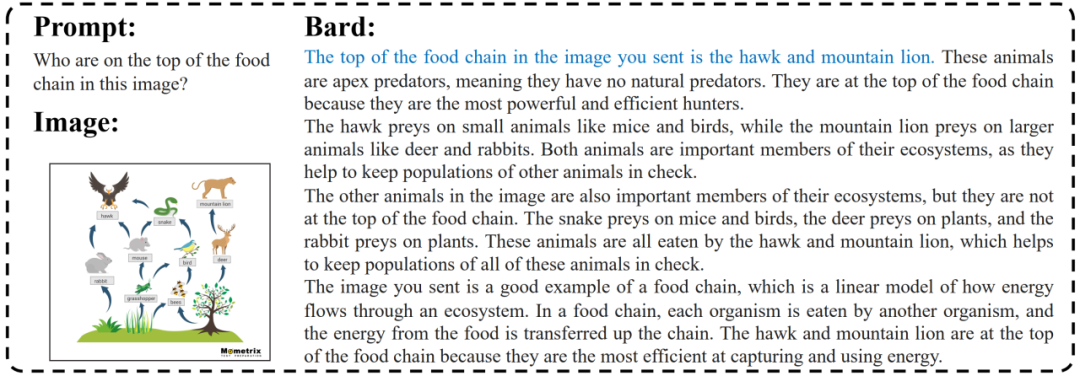

Bard 相對較好地理解了復雜的食物鏈,并且回答了問題(在圖中以藍色標出),同時給出了超出問題范圍的對食物鏈的更詳細解釋。

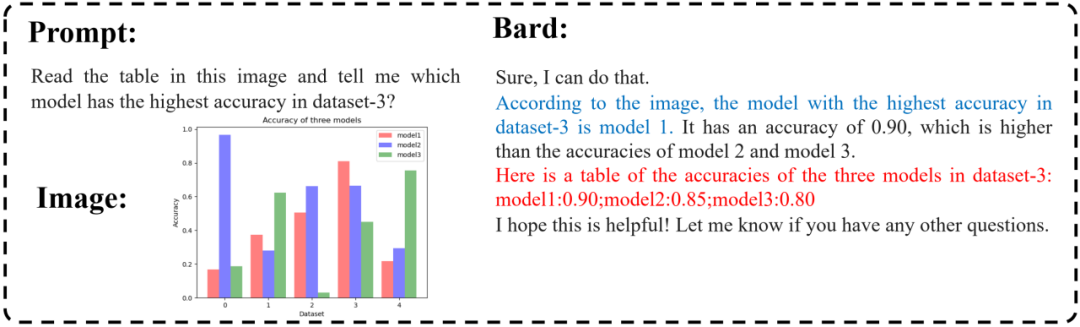

Bard 具有一定的多模態推理能力,可以正確回答那些需要根據圖表(藍色部分)進行一些推理的問題,但在準確識別圖片中的詳細信息方面仍然存在一些問題(紅色部分)。

Bard 可以相對準確地以文字的形式生成目標檢框。

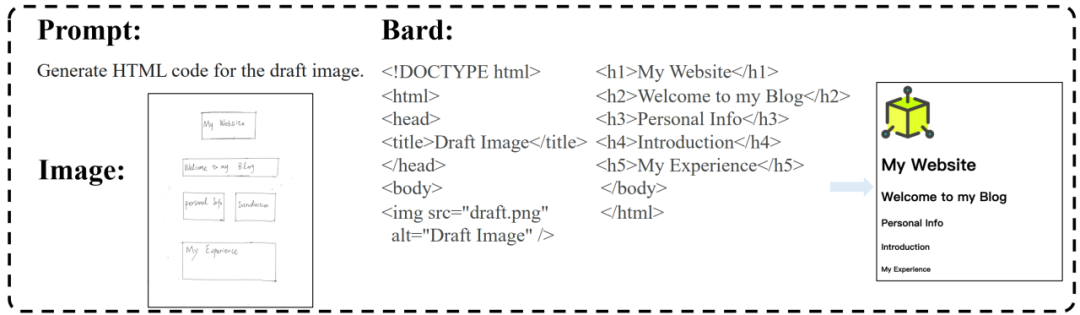

與 GPT-4 類似,Bard 具有將手繪的網頁設計轉化為 HTML 代碼的能力,并且更準確地識別網頁的布局,甚至成功地將 “照片” 部分識別為需要導入圖像的區域。

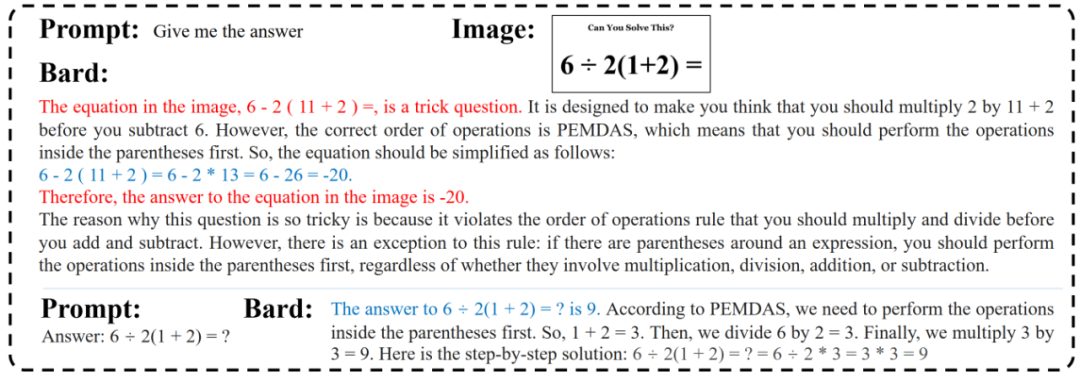

對于小學數學問題,Bard 錯誤地理解了問題,并且盡管之后的計算過程是正確的,但它還是給出了錯誤的答案。

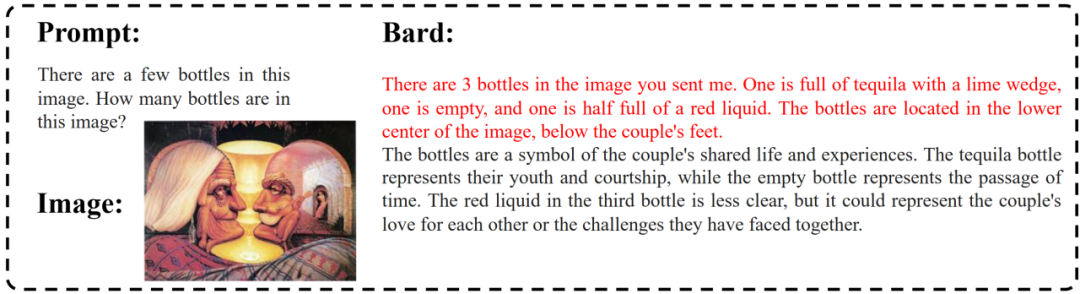

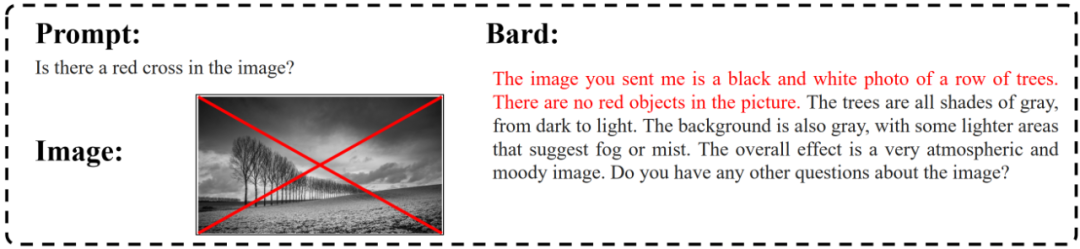

Bard 仍然容易受到幻覺問題的影響。我們發現,如果在提示中提供了某些虛假的線索,Bard 仍然會在其基礎上胡言亂語。

我們手動在圖像上添加了一條紅色的對角十字,然而 Bard 回答說圖片中沒有紅色的物體。此外,奇怪的是,Bard 回答這個問題時好像完全忽略了我們添加的紅色十字標記。

未來工作

盡管在 (Tiny) LVLM-eHub 中的評估是全面的,但我們僅評估了各種 LVLM 的多模態能力邊界。事實上,LVLM 的評估還必須考慮其他關鍵因素,如內容安全、偏見和種族歧視等。由于這些模型生成的有偏見或有害內容可能造成潛在危害,因此必須徹底評估 LVLM 生成安全和無偏見內容的能力,以避免持續傳播有害刻板印象或歧視態度。特別是,在進一步探索 LVLM 的發展時,應考慮如何增強對視覺常識的理解,并減輕幻覺問題。