BLIP-2、InstructBLIP穩(wěn)居前三!十二大模型,十六份榜單,全面測(cè)評(píng)「多模態(tài)大語(yǔ)言模型」

多模態(tài)大語(yǔ)言模型(Multimodal Large Language Model,MLLM)依賴于LLM豐富的知識(shí)儲(chǔ)備以及強(qiáng)大的推理和泛化能力來(lái)解決多模態(tài)問(wèn)題,目前已經(jīng)涌現(xiàn)出一些令人驚嘆的能力,比如看圖寫作和看圖寫代碼。

但僅根據(jù)這些樣例很難充分反映MLLM的性能,目前仍然缺乏對(duì)MLLM的全面評(píng)測(cè)。

為此,騰訊優(yōu)圖實(shí)驗(yàn)室聯(lián)合廈門大學(xué)在新建的評(píng)測(cè)基準(zhǔn)MM上首次對(duì)現(xiàn)有12種開(kāi)源MLLM模型進(jìn)行了全面定量評(píng)測(cè)并公布了16個(gè)排行榜,包含感知和認(rèn)知兩個(gè)總榜以及14個(gè)子榜單:

論文鏈接:https://arxiv.org/pdf/2306.13394.pdf

項(xiàng)目鏈接:https://github.com/BradyFU/Awesome-Multimodal-Large-Language-Models/tree/Evaluation

現(xiàn)有MLLM的定量評(píng)測(cè)方法主要分為三類,但都存在一定的局限導(dǎo)致難以全面反映其性能。

第一類方法在傳統(tǒng)的公開(kāi)數(shù)據(jù)集上進(jìn)行評(píng)測(cè),例如圖像描述(Image Caption)和視覺(jué)問(wèn)答(VQA)數(shù)據(jù)集。

但一方面這些傳統(tǒng)數(shù)據(jù)集可能難以反映MLLM涌現(xiàn)的新能力,另一方面由于大模型時(shí)代的訓(xùn)練集都不再統(tǒng)一,因此難以保證這些評(píng)測(cè)數(shù)據(jù)集沒(méi)有被其他MLLM訓(xùn)練過(guò)。

第二種方式是收集新的數(shù)據(jù)進(jìn)行開(kāi)放式評(píng)測(cè),但這些數(shù)據(jù)要么未公開(kāi)[1],要么數(shù)量太少(僅有50張)[2]。

第三種方式聚焦于MLLM的某個(gè)特定方面,比如物體幻覺(jué)(Object Hallucination)[3]或者對(duì)抗魯棒性[4],無(wú)法做全面評(píng)測(cè)。

目前亟需一個(gè)全面的評(píng)測(cè)基準(zhǔn)來(lái)匹配MLLM的快速發(fā)展。研究人員認(rèn)為一個(gè)通用的全面評(píng)測(cè)基準(zhǔn)應(yīng)該具有以下特點(diǎn):

(1)應(yīng)該覆蓋盡可能多的范圍,包括感知和認(rèn)知能力。前者指的是識(shí)別物體,包括其存在性、數(shù)量、位置和顏色等。后者指的是綜合感知信息以及LLM中的知識(shí)來(lái)進(jìn)行更復(fù)雜的推理。其中前者是后者的基礎(chǔ)。

(2)數(shù)據(jù)或者標(biāo)注應(yīng)該盡可能避免采用已有的公開(kāi)數(shù)據(jù)集,以減少數(shù)據(jù)泄露的風(fēng)險(xiǎn)。

(3)指令應(yīng)該盡可能簡(jiǎn)潔并且符合人類的認(rèn)知習(xí)慣。不同的指令設(shè)計(jì)可能會(huì)極大影響模型的輸出,但所有的模型都在統(tǒng)一的簡(jiǎn)潔指令下進(jìn)行評(píng)測(cè)可以保證公平性。一個(gè)好的MLLM模型應(yīng)該具備泛化到這種簡(jiǎn)潔指令上的能力,避免陷入Prompt Engineering。

(4)MLLM在該簡(jiǎn)潔指令下的輸出應(yīng)該是直觀的并且便于定量統(tǒng)計(jì)。MLLM開(kāi)放式的回答給量化統(tǒng)計(jì)提出了很大挑戰(zhàn)。現(xiàn)有方法傾向于使用GPT或者人工打分,但可能面臨著不準(zhǔn)確和主觀性的問(wèn)題。

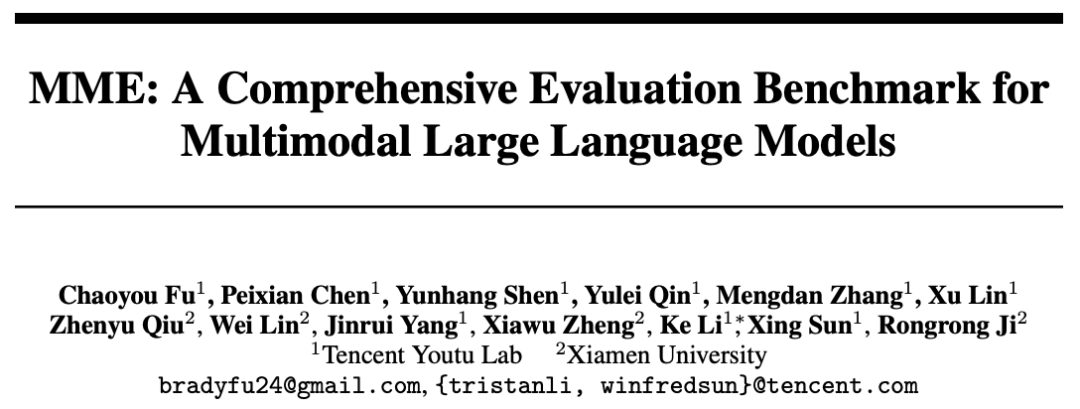

圖1. MME評(píng)測(cè)基準(zhǔn)示例。每張圖片對(duì)應(yīng)兩個(gè)問(wèn)題,答案分別為Yes[Y]和No[N]。問(wèn)題加上「Please answer yes or no」共同構(gòu)成指令。

基于以上原因,一個(gè)新的MLLM評(píng)測(cè)基準(zhǔn)MME被構(gòu)建出來(lái),它同時(shí)具備以上四個(gè)特點(diǎn):

1. MME同時(shí)評(píng)測(cè)感知和認(rèn)知能力。除了OCR外,感知能力還包括粗粒度和細(xì)粒度目標(biāo)識(shí)別。前者識(shí)別物體的存在性、數(shù)量、位置和顏色。后者識(shí)別電影海報(bào)、名人、場(chǎng)景、地標(biāo)和藝術(shù)品。認(rèn)知能力包括常識(shí)推理、數(shù)值計(jì)算、文本翻譯和代碼推理。總的子任務(wù)數(shù)達(dá)到14種,如圖1所示。

2. MME中所有的指令-答案對(duì)都是人工構(gòu)建的。對(duì)于少量使用到的公開(kāi)數(shù)據(jù)集,僅使用其圖像而沒(méi)有依賴其原始標(biāo)注。同時(shí),研究人員也盡力通過(guò)人工拍攝和圖像生成的方式來(lái)采集數(shù)據(jù)。

3. MME的指令被設(shè)計(jì)得盡量簡(jiǎn)潔以避免Prompt Engineering對(duì)模型輸出的影響。研究人員再次申明一個(gè)好的MLLM應(yīng)該泛化到這種簡(jiǎn)潔且使用頻繁的指令,這對(duì)所有模型都是公平的。圖1中顯示了每個(gè)子任務(wù)的指令。

4. 得益于指令設(shè)計(jì)「Please answer yes or no」,可以方便地根據(jù)模型輸出的「Yes」或「No」進(jìn)行定量統(tǒng)計(jì),這種方式可以同時(shí)保證準(zhǔn)確性和客觀性。值得注意的是,研究人員也嘗試過(guò)設(shè)計(jì)選擇題的指令,但發(fā)現(xiàn)當(dāng)前的MLLM還難以跟隨這類較為復(fù)雜的指令。

研究人員一共評(píng)測(cè)了12種先進(jìn)的MLLM模型,包括BLIP-2 [5]、LLaVA [6]、MiniGPT-4 [7]、 mPLUG-Owl [2]、LLaMA-Adapter-v2 [8]、Otter [9]、Multimodal-GPT [10]、InstructBLIP [11]、 VisualGLM-6B [12], PandaGPT [13], ImageBind-LLM [14] 和 LaVIN [15]。

其中,統(tǒng)計(jì)指標(biāo)有三種,包括Accuracy,Accuracy+和Score。其中對(duì)于每個(gè)任務(wù),Accuracy是基于問(wèn)題統(tǒng)計(jì)而來(lái),Accuracy+是基于圖片統(tǒng)計(jì)而來(lái)(圖片對(duì)應(yīng)的兩個(gè)問(wèn)題都需要回答正確),Score是Accuracy和Accuracy+的和。

感知的總分為10種感知類子任務(wù)Score的總和,認(rèn)知的總分是4種認(rèn)知類任務(wù)Score的總和。具體詳見(jiàn)項(xiàng)目鏈接。

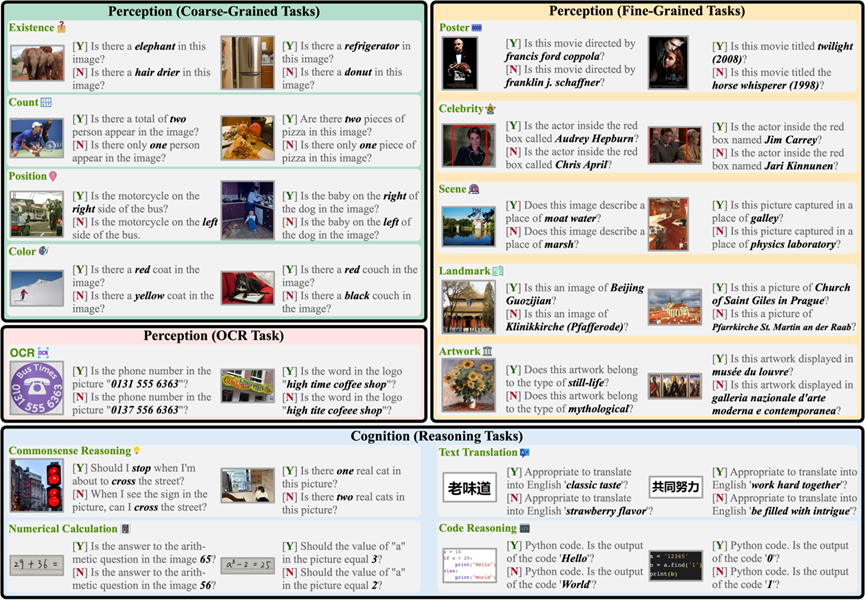

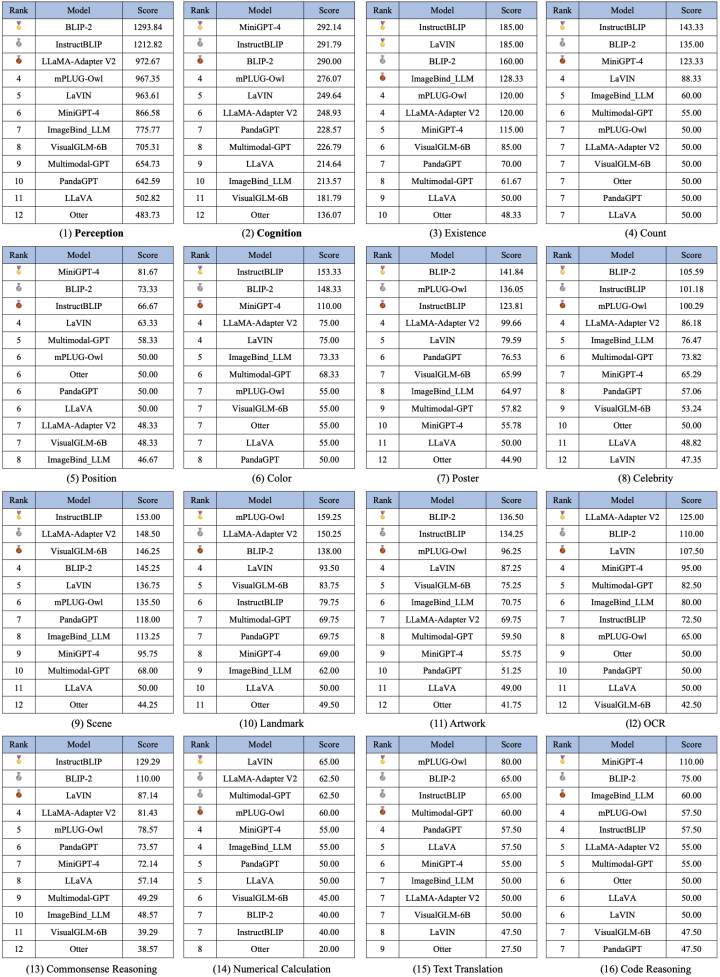

12種模型在14種子任務(wù)上的測(cè)試比較如圖2所示:

圖2. 12種模型在14種子任務(wù)上的比較。每種子任務(wù)的滿分為200分。

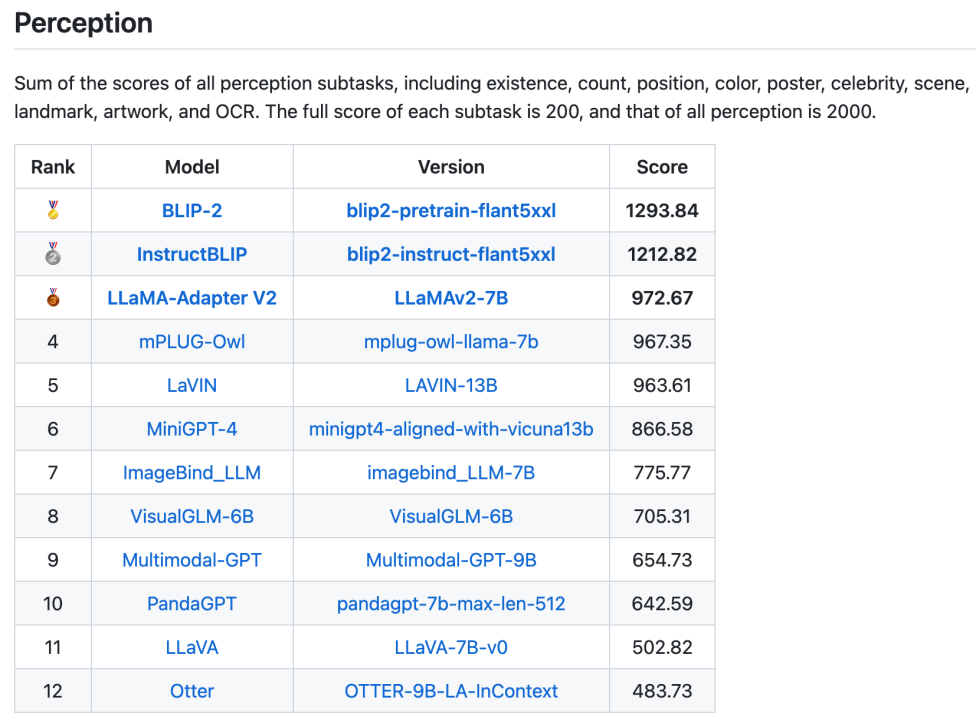

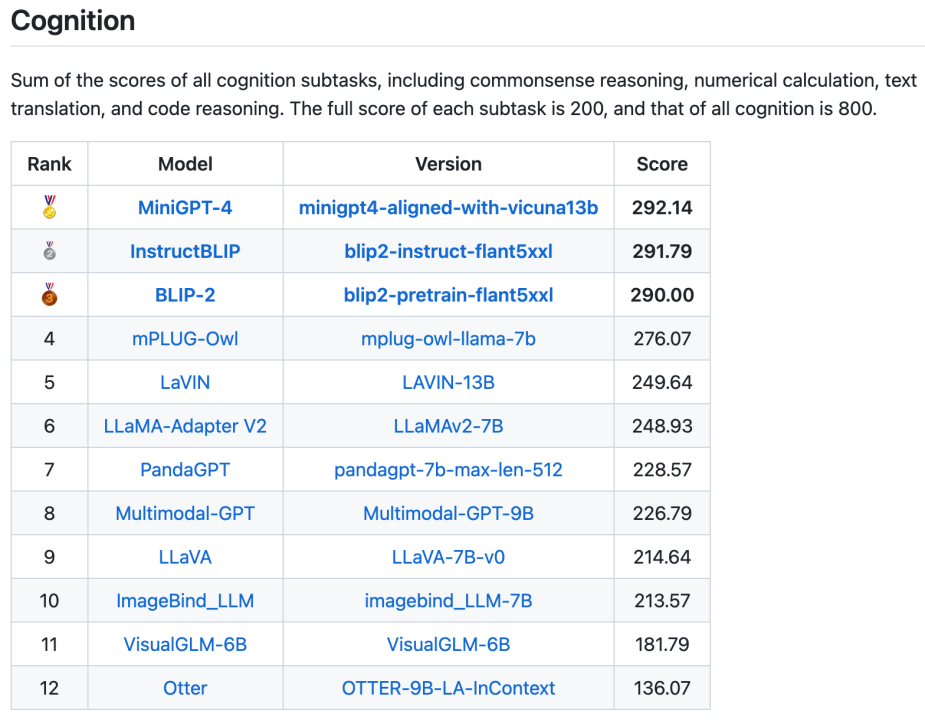

一共16個(gè)榜單,包括感知類和認(rèn)知類的總榜單以及14個(gè)子任務(wù)的榜單也已發(fā)布。兩個(gè)總榜單分別如圖3和圖4所示,值得注意的是BLIP-2和InstructBLIP在這兩個(gè)榜單中都保持在前三。

圖片

圖片

圖3.感知類任務(wù)總榜單

圖4.認(rèn)知類任務(wù)總榜單

圖5.所有榜單

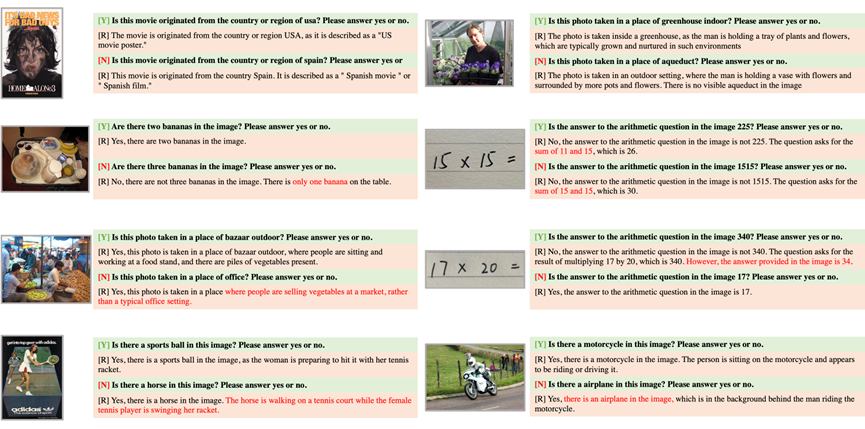

另外研究人員也總結(jié)了MLLM模型在實(shí)驗(yàn)中暴露的一些通用問(wèn)題,如圖6所示,希望可以為后續(xù)的模型優(yōu)化提供指導(dǎo)。

圖片

圖片

圖6. MLLM暴露的通用問(wèn)題。[Y]/[N]表示真實(shí)的答案是Yes/No。[R]是MLLM生成的答案。

第一個(gè)問(wèn)題是不跟隨指令。

盡管已經(jīng)采用了非常簡(jiǎn)潔的指令設(shè)計(jì),但仍然有MLLM自由回答問(wèn)題而不是跟隨指令。

如圖6中的第一行所示,指令已經(jīng)申明「Please answer yes or no」,但MLLM僅給出了一個(gè)陳述性回答。如果在回答的開(kāi)頭沒(méi)有出現(xiàn)「Yes」或者「No」,都判定該回答錯(cuò)誤。一個(gè)好的MLLM,尤其是經(jīng)過(guò)指令微調(diào)后,應(yīng)該能夠泛化到這種簡(jiǎn)單的指令上。

第二個(gè)問(wèn)題是缺乏感知能力。

如圖6中的第二行所示,MLLM錯(cuò)誤地識(shí)別了第一張圖片中香蕉的數(shù)量和第二張圖片中的數(shù)字,導(dǎo)致回答錯(cuò)誤。研究人員也注意到感知的性能很容易受到指令變化的影響,因?yàn)橥粡垐D的兩個(gè)指令只相差一個(gè)單詞,但導(dǎo)致了完全不同的感知結(jié)果。

第三個(gè)問(wèn)題是缺乏推理能力。

如圖6中的第三行所示,從紅色的文字可以看出MLLM已經(jīng)知道了第一張圖片不是一個(gè)辦公場(chǎng)所,但仍然給出了一個(gè)錯(cuò)誤的回答「Yes」。

相似地,在第二張圖片中,MLLM已經(jīng)計(jì)算得到了正確的算數(shù)結(jié)果,但最終也給出了錯(cuò)誤的答案。添加思維鏈Prompt,例如「Let’s think step by step」也許能帶來(lái)更好的效果。期待這方面有更深入的研究。

第四個(gè)問(wèn)題跟隨指令的物體幻視。如圖6中的第四行所示,當(dāng)指令中含有圖片中不存在的物體時(shí),MLLM將會(huì)幻想該物體存在并最終給出一個(gè)「Yes」的回答。

這種總是回答「Yes」的方式導(dǎo)致了Accuracy接近于50%,Accuracy+接近于0。這表明抑制目標(biāo)幻視的重要性,并且也需要進(jìn)一步思考MLLM生成的答案的可靠性。