十問復(fù)旦邱錫鵬:大模型進入安卓時代,希望有國產(chǎn)模型能代替LIama

本文經(jīng)AI新媒體量子位(公眾號ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請聯(lián)系出處。

千模大戰(zhàn)序幕拉起,復(fù)旦邱錫鵬教授這樣說。

作為國內(nèi)最早推出類ChatGPT模型的MOSS團隊帶頭人,看到大半年來國內(nèi)外大模型發(fā)展,他有了新的認知體會。

在由思佰誠科技舉辦的首屆人工智能生成內(nèi)容國際會議(AIGC 2023)上,他坦言,雖然大家都說大模型更偏工程化,但實際還有諸多科學挑戰(zhàn)仍待解決,比如訓練目標的設(shè)計、內(nèi)存優(yōu)化、自動化評測、大模型平民化、新架構(gòu)等。

在MOSS發(fā)布之后這大半年間,他所在團隊又取得了一定的成果:跨模態(tài)語音大模型SpeechGPT、優(yōu)化器LOMO可實現(xiàn)單機微調(diào)650億參數(shù)大模型;MOSS中文能力已超ChatGPT……

不過接下來,邱錫鵬透露不急于將MOSS產(chǎn)品化,而是繼續(xù)在新架構(gòu)探索,以及大模型的代碼能力、數(shù)學能力上去進一步提升。

在與量子位的交談中,他談到了LIama開源生態(tài)、國內(nèi)競爭格局、大模型產(chǎn)業(yè)落地,以及目前存在大模型幻覺、評測刷榜等現(xiàn)象在內(nèi)的十大問題。

在不改變原意的基礎(chǔ)上,量子位做了如下整理:

- 大模型進入到安卓時代,很多開源大模型中最終可能有一家勝出,現(xiàn)在來看就是LIama;

- 國內(nèi)大模型同質(zhì)化嚴重,希望有國產(chǎn)模型能代替LIama;

- 現(xiàn)在很多大模型都沒有做到RLHF這一步,后者在某些技術(shù)領(lǐng)域也不是必須的;

- 大模型幻覺并不是一件壞事,通常做法還會導(dǎo)致性能降低;

- 創(chuàng)業(yè)窗口變大,每個人都可以借助大模型來做一些自己想做的事。

談LIama開源生態(tài)

量子位:現(xiàn)在大模型進入到安卓時刻了嗎?

邱錫鵬:是的,整體上是以LIama為主的開源生態(tài)。它離GPT-4有一定差距。很多復(fù)雜應(yīng)用還是只能GPT-4去做,LIama仍需要進一步提升。

量子位:具體什么地方提升?

邱錫鵬:還得是基座。

量子位:LIama對市場格局的改變,如何看待?

邱錫鵬:一開始會有很多開源模型,最終可能有一家勝出,目前看來就是LIama。

量子位:為什么?

邱錫鵬:首先性能足夠好,然后圍繞它配套的上下游生態(tài)已經(jīng)挺多了。當你要重新提一個新模型時,就不得不考慮上下游問題。將來其他大模型要想替代LIama不是不可以,但成本就會非常非常高,相當于要打破一個生態(tài)鏈。

談國內(nèi)競爭格局

量子位:國內(nèi)是否會出現(xiàn)第二個LIama?

邱錫鵬:國內(nèi)基本上就各做各的,如果沒有顯著的差異或性能提升,所以很難建立同等的生態(tài)。希望國產(chǎn)模型能取代Llama,否則可能會限制我們將來的一些發(fā)展。

量子位:現(xiàn)在千模大戰(zhàn),未來會變成幾個大模型勝出。

邱錫鵬:肯定的。但現(xiàn)在整體都做得比較同質(zhì)化,不太可能建立用戶粘性,最終需要靠性能取勝。

談大模型產(chǎn)業(yè)落地

量子位:很多人說大模型產(chǎn)業(yè)落地到「最后一公里」了,你怎么看待?

邱錫鵬:是不是最后一公里不太確定,但肯定是極大地促進產(chǎn)業(yè)落地。大模型確實改變了之前人工智能的應(yīng)用范式。之前做一個產(chǎn)品,可能需要更多人力去標注數(shù)據(jù),這是個很大的市場需求。但現(xiàn)在大模型就不太需要太多標注數(shù)據(jù),將整個技術(shù)或者應(yīng)用門檻降得很低。但缺點就是算力要求更高。

量子位:創(chuàng)業(yè)窗口更大了嗎?

邱錫鵬:對,就是面向更終端的應(yīng)用,每個人都可以借助大模型來做一些自己想做的事情。

量子位:SFT、RLHF還沒形成很好的范式,什么時候能達到工業(yè)界應(yīng)用水平?

邱錫鵬:現(xiàn)在已經(jīng)有套完整的技術(shù)路徑,加上有很多工具能幫助大模型在垂直行業(yè)的應(yīng)用。這樣的技術(shù)路徑依賴能使門檻變得非常低。技術(shù)成熟度目前我覺得還是比較高的。

量子位:追求通用性同時,如何平衡大模型各領(lǐng)域需求?

邱錫鵬:大模型本身通用性強的話,補一些垂直領(lǐng)域知識可能就夠了,這部分并不是特別困難,成本跟預(yù)訓練相比會低很多。

量子位:像LIama2在SFT、RLHF用了100萬量級人工標注數(shù)據(jù),這種在數(shù)據(jù)量和成本上都是很大的。

邱錫鵬:現(xiàn)在很多大模型都沒有做到RLHF這一步,只是做到SFT。

量子位:這步對產(chǎn)業(yè)落地是有必要的嗎?

邱錫鵬:也不是必須的,比如在一個技術(shù)領(lǐng)域模型,就不會特別關(guān)注所謂無害性、誠實性這些特質(zhì),就像讓它寫個代碼,通常來講對齊會降低模型能力。

談評測刷榜現(xiàn)象

量子位:怎么去看待有的大模型團隊刷榜現(xiàn)象。

邱錫鵬:目前還沒有一個特別好的數(shù)據(jù)集能反映大模型各種能力的,各方都在探索。但現(xiàn)在主要問題是,總體上對于生成式算法模型的評測是相當困難的。

量子位:舉個例子。

邱錫鵬:就像ChatGPT刷榜不一定能刷過谷歌的大模型,但使用體驗上就是更好。真正的評價可能還是要來自于人類真實感受,但這種評價的成本比較高,也很難定量化。

量子位:那客觀指標還需要嗎?

邱錫鵬:還是需要的,但最好就是像以前變成學術(shù)界比方法就夠了。現(xiàn)在很多企業(yè)去刷榜,但又不公開數(shù)據(jù),也不具體說怎么做,我覺得這是一種不公平的競爭。

比如說國內(nèi)C-Eval,本身質(zhì)量還挺高但出來幾天就被刷榜了,導(dǎo)致學術(shù)價值就不大了。

談大模型幻覺問題

量子位:大模型幻覺方面,咱們是否有些相關(guān)進展?

邱錫鵬:這方面本身做的并不是特別多,目前可靠的方法還是偏應(yīng)用端去消除幻覺。除此之外,還有人通過對齊或負反饋的方式去識別。但我個人的觀點是,消除幻覺可能外部加些知識驗證就可以解決這件事,而不是從機理上去消除它。

量子位:為什么?

邱錫鵬:感覺它和模型這種思維能力是強相關(guān)的,有可能幻覺消失了,導(dǎo)致模型能力會下降。

量子位:幻覺并不是件壞事?

邱錫鵬:它可能不是件壞事,需要分場合去利用。比如有些場合繪畫創(chuàng)作、科學發(fā)現(xiàn)是利用幻覺的。

談AI對齊

量子位:OpenAI有個超級對齊團隊,最終可能是AI對齊AI,您是怎么看待這件事?

邱錫鵬:對齊確實是件很難做的事情。所謂AI對齊人類價值觀,我們?nèi)祟惐旧淼膬r值觀都很難衡量。但像AI對齊某些能力是可以的,比如像解數(shù)學題、下棋,因為它的好壞不需要人來評價,用AI對齊就更好。

量子位:數(shù)理方面,大模型能力還比較欠缺。

邱錫鵬:這一塊我覺得是需要更高質(zhì)量的數(shù)據(jù)集。

談對NLP的影響

量子位:大語言模型給自然語言處理帶來什么樣的影響?

邱錫鵬:相當于整個領(lǐng)域需要重新劃分。早期是按照不同領(lǐng)域以及任務(wù)來劃分,現(xiàn)在就要從不同階段來劃分,大體包括:預(yù)訓練、指令微調(diào)、RLHF,這就導(dǎo)致大家做的東西比較雷同,沒有像以前那樣多樣性——

現(xiàn)在大語言模型雖說有很多,但基本都是基于Transformer架構(gòu),訓練數(shù)據(jù)、訓練方法也差不多。

量子位:帶來什么樣的挑戰(zhàn)?

邱錫鵬:首先就賽道擁擠,大家都統(tǒng)一集中到這一賽道;另一個就是提示變得十分重要,有點重新回到此前特征工程里面去,還有就是算力偏高,能耗高,以及很難有客觀化的評價指標,以及外加安全問題。

這些挑戰(zhàn)其實是下沉到大模型從預(yù)訓練到應(yīng)用的各個階段的。

談大模型科學挑戰(zhàn)

量子位:普遍認知中大模型偏工程化,還有哪些科學問題需要解決?

邱錫鵬:主要有以下幾點:

- 模型架構(gòu),Transformer的缺點就是復(fù)雜度和字符長度是平方的關(guān)系,擴展規(guī)模時就會變成瓶頸,未來肯定是有些新的架構(gòu)產(chǎn)生。

- 思維鏈能力來源,要準備什么樣的數(shù)據(jù)去提升它的能力,現(xiàn)在還沒有一個公認手段。

- 訓練目標的設(shè)計,早期機器學習目標很明確,可以端到端去減少泛化誤差;但現(xiàn)在大語言模型每個階段(預(yù)訓練、精調(diào)加對齊)目標與最終目標是不是一致?如何去設(shè)計,這是需要去探索的。

- 幻覺,現(xiàn)在已經(jīng)有些流行框架去解決,比如LangChain、LIamaIndex等,但有沒有更深刻去理解背后工作依據(jù)去揚長避短,這值得研究。

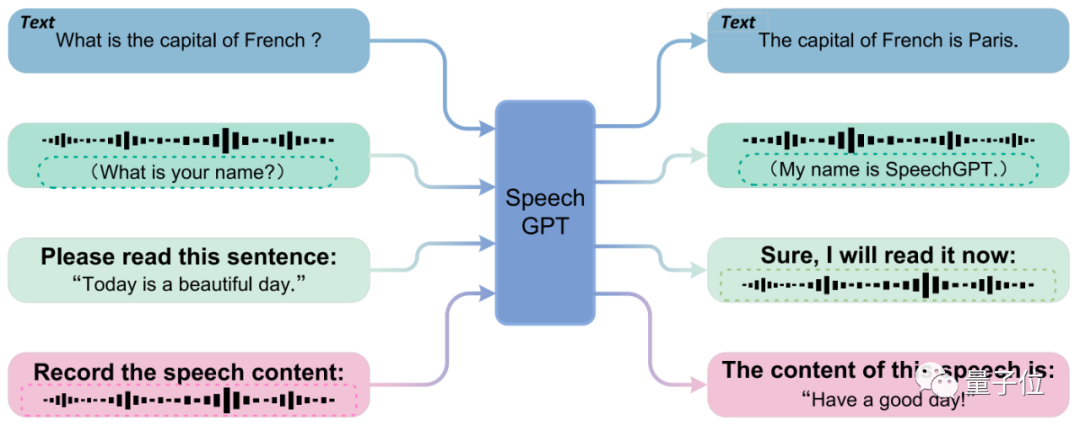

- 多模態(tài)拓展,只在符號世界的知識總歸是受限的,如何與更多模態(tài)對齊。現(xiàn)在主流方式,比如在接到大語言模型之前接一個編碼器,將多模態(tài)信息變成向量,但只是單方面對齊,模態(tài)之間沒有充分融合。

我們有做一個SpeechGPT——讓大模型直接接收語音信號,將語音離散化為Token直接輸入給大模型,大模型可以直接輸入和輸出語音。

- 知識來源,大模型已經(jīng)學到很多文本層面的知識,那今后進一步去提升,還能如何提升?比如那些文本所不能承載的知識,現(xiàn)在也有一些方法,比如多模態(tài)學習、具身學習等。

- 實時學習,如何讓大模型與人的交互中進行學習,并與參數(shù)更新結(jié)合在一起,讓其知識水平不斷提高。

- 智能體,讓大模型作為Agent的載體,賦予它各種能力去完成復(fù)雜任務(wù);進一步思考,多個智能體之間又是怎樣去交互?

- 自動化評價,現(xiàn)在大模型在推理能力、數(shù)學能力、代碼能力等方面都差得比較遠,但這些能力才足以支撐去做很多復(fù)雜的工作,因此要做一種指標去衡量這些能力,同時還要避免「刷榜」這種現(xiàn)象。

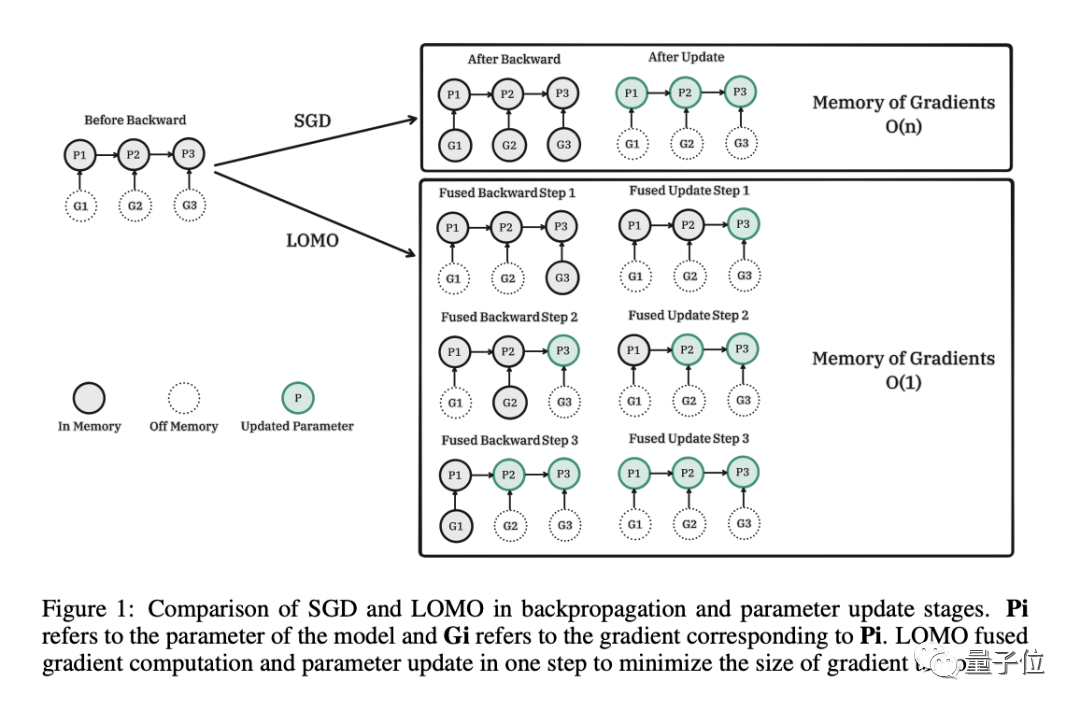

- 第十個有點偏工程,但也是個科學問題,就是大模型的平民化,如果算力要求依然很高,那將只受限于小部分人去做研究。我們在考慮一種全量的微調(diào)優(yōu)化方法。前段時間提出了一種名為LOMO(低內(nèi)存優(yōu)化)的新優(yōu)化器,并在配備8卡3090(24GB內(nèi)存)的單臺服務(wù)器,成功微調(diào)65B的LIama。

量子位:這些問題工業(yè)界需要關(guān)注嗎?

邱錫鵬:我認為值得重視,現(xiàn)在國內(nèi)一些團隊基本只看到工程化,但其實里面很多挑戰(zhàn)沒有解決。

量子位:學界和工業(yè)界之間大模型分工是怎樣的?

邱錫鵬:我覺得兩者之間不存在分工,就像OpenAI自己的研究團隊、DeepMind都有在研究這些問題。

談MOSS進展

量子位:MOSS下一步將提高哪些方面的能力?

邱錫鵬:可能在新架構(gòu),以及大模型的代碼能力、數(shù)學能力上去進一步提升。

量子位:成本的情況是怎樣的?像OpenAI之前爆出每天燒掉70萬美元。

邱錫鵬:我們沒有一個完全嚴格的數(shù)字,但每天也是有幾百張卡在跑。

量子位:未來會考慮出應(yīng)用端產(chǎn)品?

邱錫鵬:可能在更遠的將來。

量子位:為什么?

邱錫鵬:目前很多大模型但架構(gòu)比較雷同,沒有形成相較于其他大模型的獨特性。如果未來能有一些技術(shù)創(chuàng)新能形成競爭力的東西,就可以去做些商業(yè)化落地的事情。

量子位:那有沒有預(yù)期的時間?

邱錫鵬:沒有。

量子位:之前提到將推出更大參數(shù)模型,是否有在推進中。

邱錫鵬:MOSS本身沒有,但團隊有參與到其他單位大模型訓練中。

談?wù)J知變化

量子位:對大模型的認知,跟半年前有什么變化?

邱錫鵬:那當然就是一開始大家都不會理解為什么大模型能做得這么好,現(xiàn)在覺得理所當然。比如SFT指令微調(diào)之后,就可以聽懂人話之類,這件事放半年前或ChatGPT推出之前,不是所有人都能想到的。

然后放在今天,對大模型的理解就又不一樣了——已經(jīng)不把它當做一個只聊天的模型,更多是一種決策模型。讓大家可以參與到更復(fù)雜的智能決策,包括智能體之類。