多LLM協同作戰!清華等開源多智能體框架AgentVerse:合作打造Minecraft物品,還能訓練寶可夢

人類之所以能夠爬到地球的食物鏈頂端,甚至還能繼續探索外太空,除了個人的頭腦外,更離不開群體的協作力量。

對應到大型語言模型(LLM),雖然單個模型的能力已經非常強大,但想要完成更復雜的任務,或是提升任務的完成效率,還需要多個智能體之間的協作。

最近,受人類群體動力學(human group dynamics)的啟發,來自清華大學、北郵和騰訊的研究人員提出了一個多智能體框架AgentVerse,可以讓多個模型之間進行協作,并動態調整群體的組成,實現1+1>2的效果。

圖片

圖片

論文鏈接:https://arxiv.org/pdf/2308.10848.pdf

開源鏈接:https://github.com/OpenBMB/AgentVerse

AgentVerse的主要特點包括三點:

1. 高效的環境搭建:框架中提供了多個基本構建模塊,只需要在配置文件中添加幾行代碼,即可輕松搭建多智能體環境,如LLM聊天室等,研究人員只需要關注實驗過程和結果分析即可。

2. 可定制的組件:多智能體環境被分為五個功能模塊,并定義各自的接口,用戶可以基于自己的需求重新定義不同模塊的功能。

3. 工具(插件)利用:支持BMTools中提供的工具。

實驗結果表明,該框架可以有效地部署多智能體群組,其性能優于單智能體,并且涌現了協作等社會行為。

AgentVerse框架

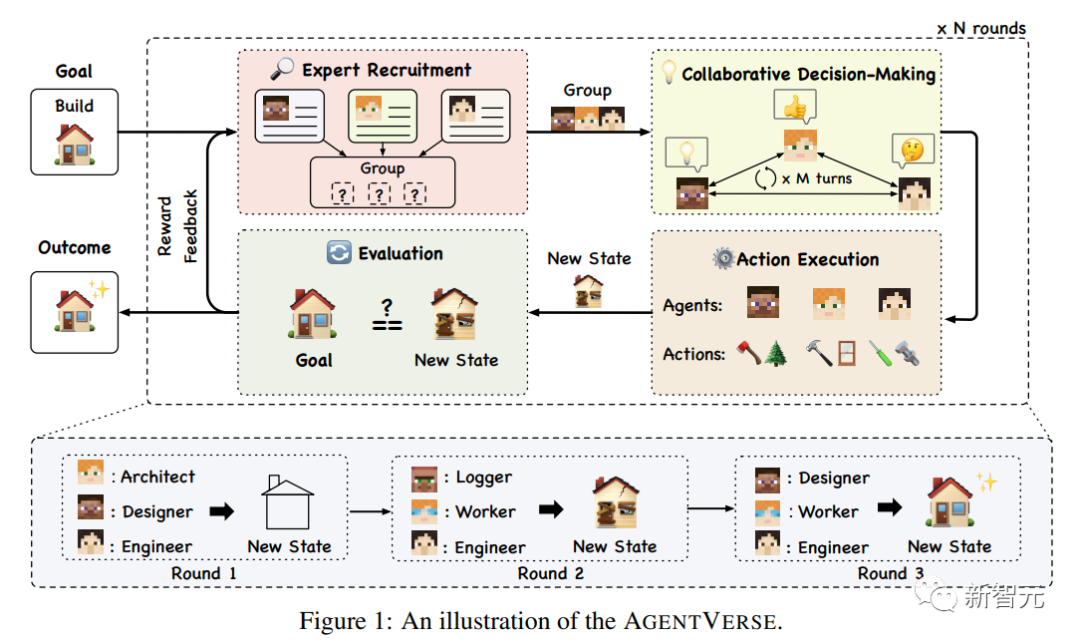

解決問題(Problem Solving)的過程是人類群體中一系列迭代階段,最初,該小組評估當前狀態和預期目標之間的差異,動態調整其組成以加強決策中的協作,隨后執行明智的行動。

為了增強自主多智能體群體實現其目標的有效性,我們模擬了一個人類群體的問題解決過程,提出了AGENTVERSE框架,該框架由四個關鍵階段組成:專家招募、協作決策、行動執行和評估。

圖片

圖片

整個過程可以建模為馬爾可夫決策過程(MDP),表征為元組(S,a,T,R,G)。這包括自主代理和環境狀態空間S、解決方案和行動空間A、轉移函數T:S × A→S、獎勵函數R和目標空間G。

1. 專家招募(Expert Recruitment)

專家招募階段決定了多智能體群體的構成,是決定群體能力上限的重要模塊,已經有經驗證據表明,人類群體內部的多樣性引入了不同的觀點,從而提高了群體在不同任務中的表現。

也有研究結果表明,為自主智能體脂定一個特定角色,類似于招募專家組建團隊,可以提高運行效率。

不過,目前為智能體分配角色描述的方法主要依賴于人類直覺和先驗知識,需要基于任務理解進行手動分配,所以可擴展性仍然不明確,尤其是在面對多樣化且復雜的問題環境時。

鑒于此,AgentVerse采用自動化的方式來招募專家,目的是增強配置智能體的可擴展性。

對于給定的目標g∈G,特定的自主智能體Mr被指定為招聘者(recruiter),類似于人力資源經理;Mr 不依賴預定義的專家描述,而是根據當前目標g動態地生成一組專家描述。

然后根據不同的專家描述提示以及目標g,得到多個不同的智能體形成專家組M = Mr(g)

并且,多智能體群體的組成將根據評估階段的反饋進行動態調整,也使得框架能夠根據當前狀態(收到的獎勵)組建最有效的多智能體群體,以便在后續回合中做出更好的決策。

2. 協同決策

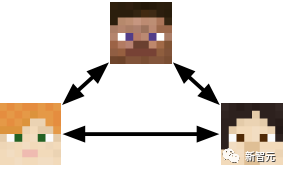

此階段主要是聚集專家智能體進行協同決策,研究人員選擇兩種經典的溝通結構來提升決策效率:

橫向溝通 ( Horizontal Communication)

圖片

圖片

每個智能體(表示為mi∈M)積極共享并細化其決策,這種民主的溝通結構鼓勵智能體之間的相互理解和協作。

然后將智能體的集體意見結合起來,使用一個集成函數f來形成當前回合的群體決策。

在需要創造性想法或需要大量協調的場景中,例如頭腦風暴、咨詢或合作游戲等,橫向溝通可能是更好的選擇。

縱向溝通 (Vertical Communication)

縱向溝通的特點是職責分工,由一個智能體提出初始決策,其余的智能體充當評審人,對解決方案提供反饋;根據反饋,不斷完善決策,直到所有的評審智能體就解決方案達成共識,或者達到最大迭代次數。

圖片

圖片

在需要針對特定目標迭代完善決策的場景中,例如軟件開發,垂直溝通是更好的選擇。

3. 行動執行(Action Execution)

在決策制定完畢后,智能體需要執行指定的動作,具體取決于實現方式,某些智能體可能會不執行任何操作,然后對環境狀態進行更新。

4. 評估(Evaluation)

評估對于下一輪專家組的構成調整和提升起到至關重要的作用,使用獎勵反饋機制評估當前狀態與期望目標之間的差距,并給出口頭反饋,解釋為什么當前狀態仍然不令人滿意并提供建設性建議,討論下一輪如何改進。

其中獎勵反饋機制可以由人工定義(人機協作循環),也可以由自動反饋模型定義,具體取決于實現方式。

如果確定尚未達到預期目標,則獎勵反饋循環回到初始階段,即專家招募;在下一輪專家招募階段會利用該反饋信號結合初始目標來調整專家組的構成,從而演化出更有效的多智能體群組,以供后續決策和行動執行。

實驗部分

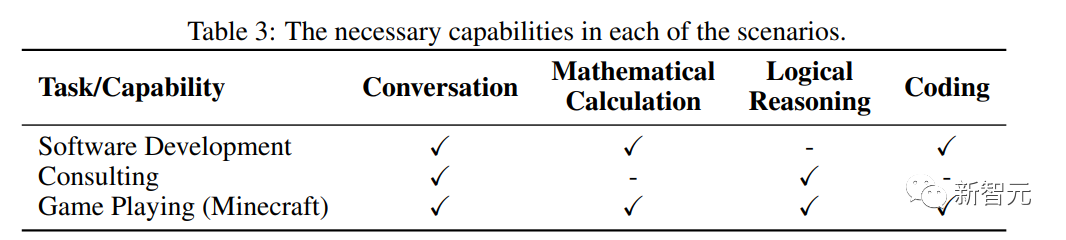

為了證明AgentVerse能夠指導智能體群組高效地完成任務,研究人員對基準任務進行了定量實驗,并對更復雜和實際的應用進行了案例研究。

實驗設置

研究人員選擇了兩個語言模型作為底層支持:GPT-3.5-Turbo-0613和GPT-4-0613

在數據集和評估指標的選擇上,主要考察多智能體群組在四個方面的能力:

1. 對話(Conversation)能力

第一個數據集為對話(Dialogue)回復數據集FED,給定多輪聊天歷史記錄,智能體需要生成回復內容,使用GPT-4作為評估器,對模型生成的回復和人類編寫的回復進行評分,并報告模型的勝率。

第二個數據集為約束生成Commongen-Challenge,給定20個概念,智能體需要生成一個語義連貫且語法正確的段落,并且應當包含盡可能多的概念。

2、數學計算(Mathematical Calculation)能力

利用MGSM 的英語子集,包含小學級別數學問題,指標為正確答案的百分比。

3. 邏輯推理(Logical Reasoning)能力

利用BigBench的邏輯網格謎題(logic grid puzzle)任務,其中包含需要多步驟邏輯推理的邏輯問題,使用準確率指標。

4. 編碼(Coding)

利用代碼補全數據集Humaneval,使用Pass@1指標進行評估。

實驗結果

性能分析

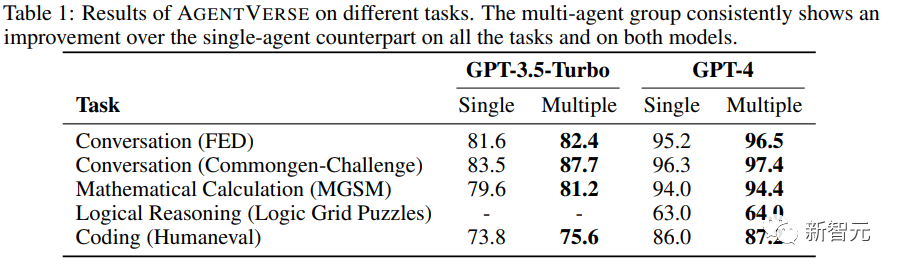

單個智能體(Single)使用給定的提示直接生成答案,而用AgentVerse構建的多智能體群組(Multiple)以協作的方式解決問題。

從結果中可以看出,無論使用GPT-3.5-Turbo還是GPT-4,多智能體始終優于單智能體。

由于GPT-3.5-Turbo很難在邏輯網格謎題數據集上給出正確的推理結果,所以表中省略了相應的實驗結果。

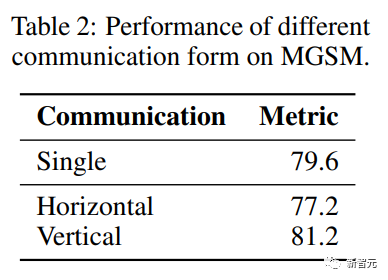

協作決策分析

圖片

圖片

與縱向溝通相比,水平溝無法促進數學計算任務 (MGSM) 上的多智能體群組有效決策,進一步分析可以發現,溝通架構對于塑造決策結果來說至關重要。

在橫向溝通中,智能體以順序的方式進行溝通,某個智能體可能會提出有缺陷的解決方案或質疑其他智能體的正確主張,其他智能體往往不會糾正錯誤,而是遵循錯誤的決策,導致性能低于單智能體。

而在縱向溝通中,其他智能體只需要提供反饋,雖然建議可能會存在缺陷,但大多數智能體有建設性的批評通常會緩解錯誤,從而使核心智能體可以保留準確的解決方案。

不過這也不意味著橫向溝通效率較低,只是說在需要精確答案的任務上,縱向溝通更合適;而在咨詢等需要不同解決方案的任務中,橫向溝通更合適。

案例研究:軟件開發

研究人員在文中設計了三個案例任務,下面以軟件開發為例

圖片

圖片

任務描述

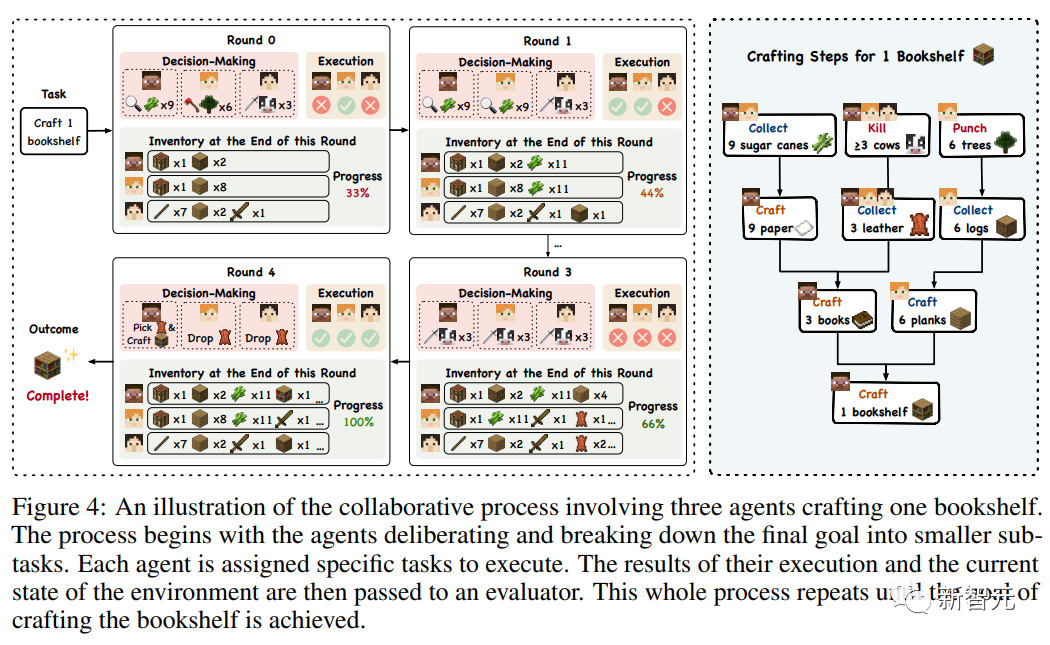

視頻游戲中往往會提供復雜的虛擬環境,可以有效測試智能體的能力邊界,研究人員以沙盒游戲《我的世界》(Minecraft)為實驗平臺,游戲的機制和大量可制作的物品集合要求智能體不僅要執行任務,還要計劃、協調和適應動態場景。

研究人員的目標是利用AgentVerse整合多個智能體來合作制作特定的物品,測試智能體在復雜的環境中共享知識、資源和協作的能力。

實驗分析

實驗中,要求三個智能體合作制作一個書架,其過程至少包含九個基本步驟,如收集木材和皮革等材料,制作書籍等中間物品,最后組裝書架。

圖片

圖片

由于游戲中只有玩家一種身份,所以AgentVerse框架中的專家招募階段可以省略,直接通過提示指定模型扮演《我的世界》中經驗豐富的玩家即可。

智能體可以將制作書架的整體目標分解成正確的子任務,戰略性地分配并分發執行。

一個值得注意的觀察是智能體的適應性和合作本能,例如,在最初的幾輪比賽中,當Alice努力淘汰皮革所需的三頭奶牛時,Bob輔助完成了指定的任務,他注意到了Alice面臨的困難,從而介入并提供幫助。

類似的涌現行為非常關鍵,凸顯了智能體在面臨意想不到的挑戰時的健壯性和靈活性。

參考資料:

https://github.com/OpenBMB/AgentVerse