AmodalSynthDrive:一個用于自動駕駛的合成非模態感知數據集

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

- 論文鏈接:https://arxiv.org/pdf/2309.06547.pdf

- 數據集鏈接:http://amodalsynthdrive.cs.uni-freiburg.de

摘要

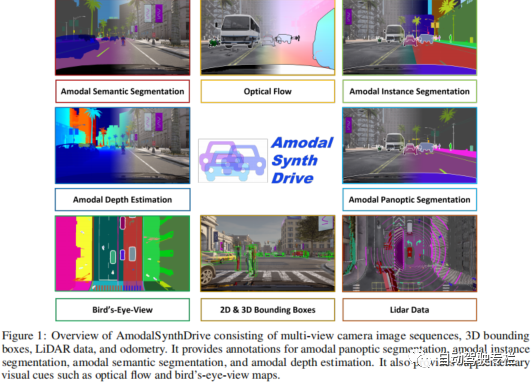

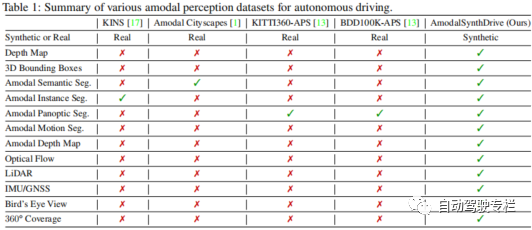

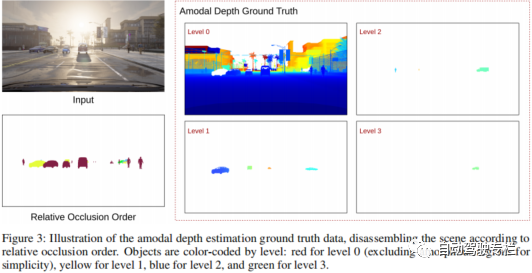

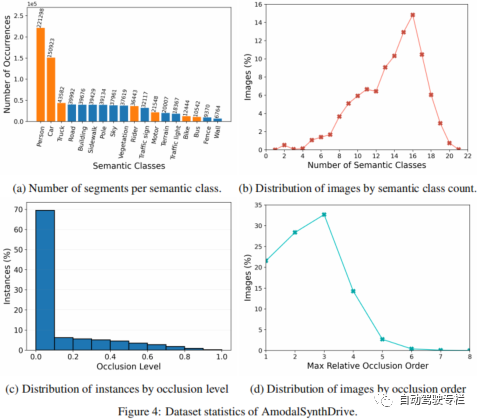

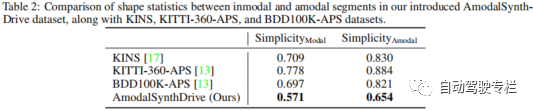

本文介紹了AmodalSynthDrive:一個用于自動駕駛的合成非模態感知數據集。與人類不同,即使在部分遮擋的情況下,人類也可以毫不費力地估計物體的整體,而現代計算機視覺算法仍然發現這一方面極具挑戰性。由于缺乏合適的數據集,利用這種非模態感知進行自動駕駛在很大程度上仍未得到開發。這些數據集的生成主要受到昂貴標注成本的影響,以及需要減輕標注者在準確標注遮擋區域的主觀性帶來的干擾。為了解決這些限制,本文引入了AmodalSynthDrive,這是一種合成的多任務非模態感知數據集。該數據集提供了150個駕駛序列的多視圖相機圖像、3D邊界框、激光雷達數據和里程計,其包括了在各種交通、天氣和光照條件下超過1M的目標標注。AmodalSynthDrive支持多種非模態場景理解任務,包括引入的非模態深度估計用于增強空間理解。本文為每項任務評估若干基線,以說明挑戰并且設置公開基準服務器。

主要貢獻

本文的貢獻總結如下:

1)本文提出了AmodalSynthDrive數據集,這是一種針對城市駕駛場景的全面合成非模態感知數據集,具有多種數據來源;

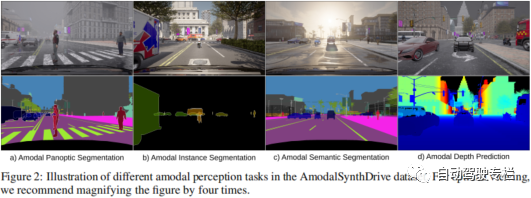

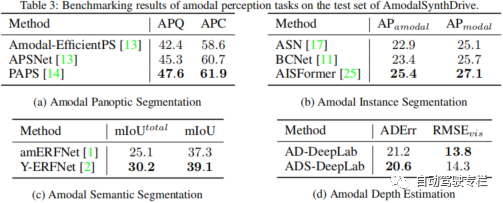

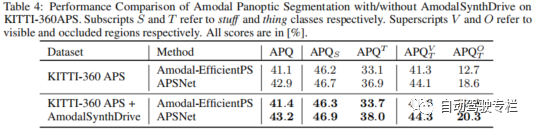

2)本文提出了針對非模態感知任務的基準,即非模態語義分割、非模態實例分割和非模態全景分割;

3)新型的非模態深度估計任務旨在促進增強空間理解。本文通過若干基線證明了這項新任務的可行性。

論文圖片和表格

總結

感知是自動駕駛汽車的一項關鍵任務,但是目前的方法仍然缺少對復雜交通場景解釋所需的非模態理解。為此,本文提出了AmodalSynthDrive,這是一個用于自動駕駛的多模態合成感知數據集。通過合成的圖像和激光雷達點云,我們提供了一個全面的數據集,其包括用于基本非模態感知任務的真值標注數據,同時還引入一種新的任務來增強空間理解,稱為非模態深度估計。本文提供了超過60000個單獨的圖像集,每個圖像集與非模態實例分割、非模態語義分割、非模態全景分割、光流、2D&3D邊界框、非模態深度以及鳥瞰圖相關。通過AmodalSynthDrive,本文提供了各種基線,并且相信這項工作將為動態城市環境的非模態場景理解的新型研究鋪平道路。

原文鏈接:https://mp.weixin.qq.com/s/7cXqFbMoljcs6dQOLU3SAQ