生成模型構建交互式現實世界模擬器,LeCun覺得非常酷

基于互聯網數據訓練的生成模型徹底改變了文本、圖像和視頻內容的創建方式。有研究者預測,也許生成模型的下一個里程碑是能夠模擬人類體驗世界的方方面面,比如在公路上如何駕駛汽車,又比如如何準備飯菜。

現如今,借助非常全面的真實世界模擬器(real-world simulator),人類可以與不同場景和物體進行交互,機器人也可以從模擬經驗中進行學習,從而避免出現物理損壞的風險。

然而,構建這樣一個真實世界模擬器的主要障礙之一在于可用的數據集。雖然互聯網上有數十億的文本、圖像和視頻片段,但不同的數據集涵蓋不同的信息軸,必須將這些數據集中在一起才能模擬出對世界的真實體驗。例如,成對的文本圖像數據包含豐富的場景和對象,但很少有動作,視頻字幕和問答數據包含豐富的高級活動描述,但很少有低級運動細節, 人類活動數據包含豐富的人類動作但很少有機械運動,而機器人數據包含豐富的機器人動作但數量有限。

以上列舉的信息差異是自然的且難以克服,這給構建一個旨在捕捉現實世界真實體驗的真實世界模擬器帶來了困難。

本文中,來自 UC 伯克利、Google DeepMind、MIT 等機構的研究者探索了通過生成模型學習真實世界交互的通用模擬器 UniSim,邁出了構建通用模擬器的第一步。例如 UniSim 可以通過模擬「打開抽屜」等高級指令和低級指令的視覺結果來模擬人類和智能體如何與世界交互。

- 論文地址:https://arxiv.org/pdf/2310.06114.pdf

- 論文主頁:https://universal-simulator.github.io/unisim/

本文將大量數據(包括互聯網文本 - 圖像對,來自導航、人類活動、機器人動作等的豐富數據,以及來自模擬和渲染的數據)結合到一個條件視頻生成框架中。然后通過仔細編排沿不同軸的豐富數據,本文表明 UniSim 可以成功地合并不同軸數據的經驗并泛化到數據之外,通過對靜態場景和對象的細粒度運動控制來實現豐富的交互。

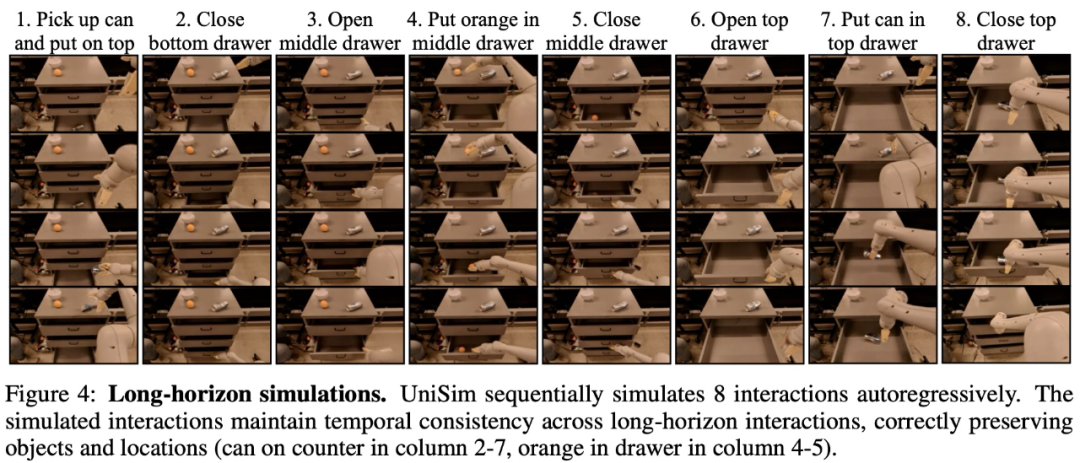

下面視頻演示了 UniSim 如何模擬具有長交互視界的示例,視頻顯示 UniSim 一口氣模擬了機器人八個動作指令:

UniSim 對人類動作的模擬:

UniSim 對 RL 策略的模擬部署如下所示:

對于這項研究,Meta 首席 AI 科學家 Yann LeCun、英偉達高級研究科學家 Jim Fan 等業界人士進行了轉發。LeCun 給出一個「Cool」字的評價。

Jim Fan 表示,這項工作非常有趣,視頻擴散模型被用作了數據驅動物理模擬,其中智能體可以規劃、探索和學習最優行動,并且無需接觸機器人硬件也不會造成損害。可以說 LLM 不僅是一個 OS,還化身為完整的現實模擬器。

論文一作、UC 伯克利博士生 Sherry Yang 表示,「學習現實世界模型正在成為現實」。

模擬現實世界的交互

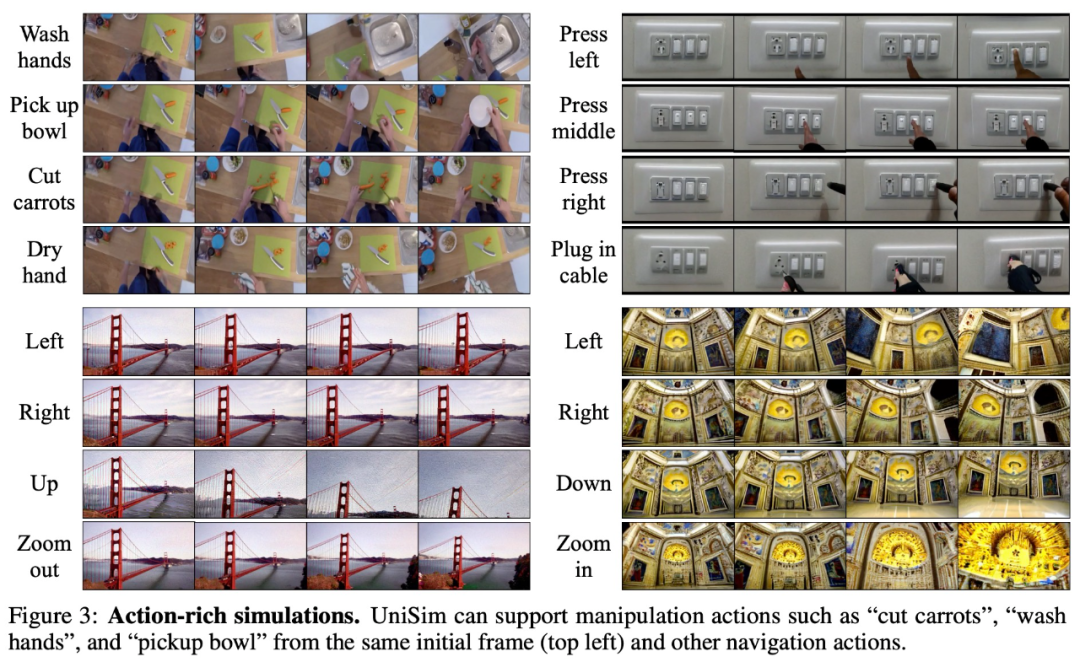

如下圖 3 所示,UniSim 能夠模擬一系列豐富動作,例如廚房場景中洗手、拿碗、切胡蘿卜、擦干手這一系列動作;圖 3 右上是按下不同的開關;圖 3 下是兩個導航場景。

對應上圖 3 右下的導航場景

對應上圖3右下的導航場景

在長程模擬方面,下圖 4 是一個 UniSim 自回歸地順序模擬 8 個交互的例子:

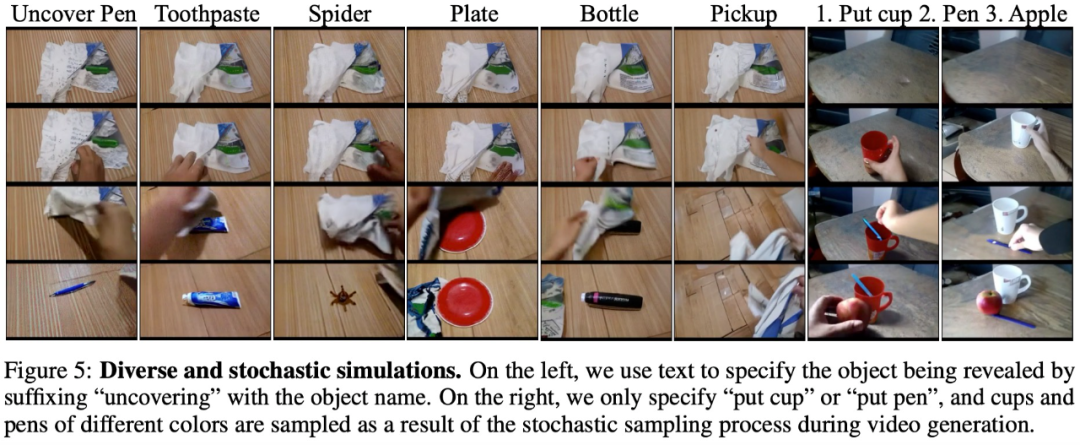

除了支持豐富動作和長程交互,UniSim 還支持高度多樣化和隨機的環境變換,例如移除頂部毛巾后顯示的對象具有多樣性(下圖 5 左)。

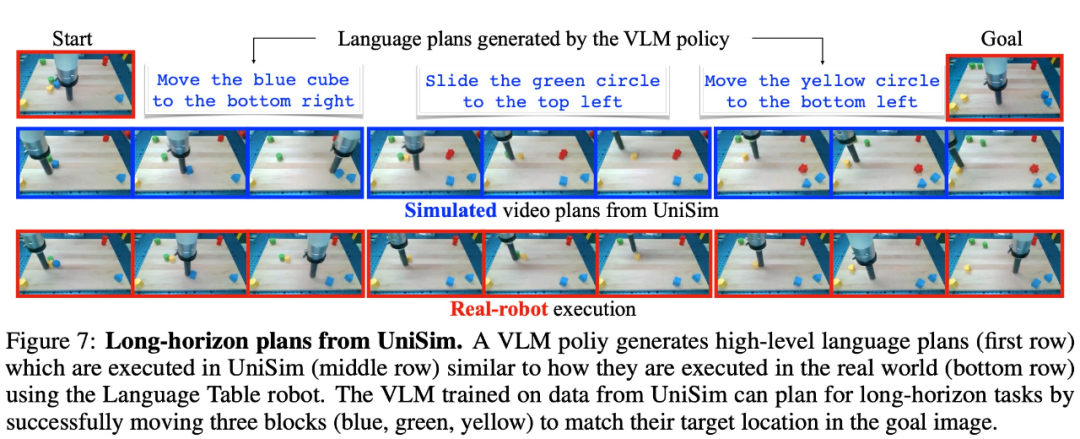

UniSim 在真實世界遷移的結果。UniSim 的真正價值在于模擬現實世界,圖 7 顯示了 VLM 生成的語言規劃,UniSim 根據語言規劃生成的視頻,以及在真實機器人上的執行情況。

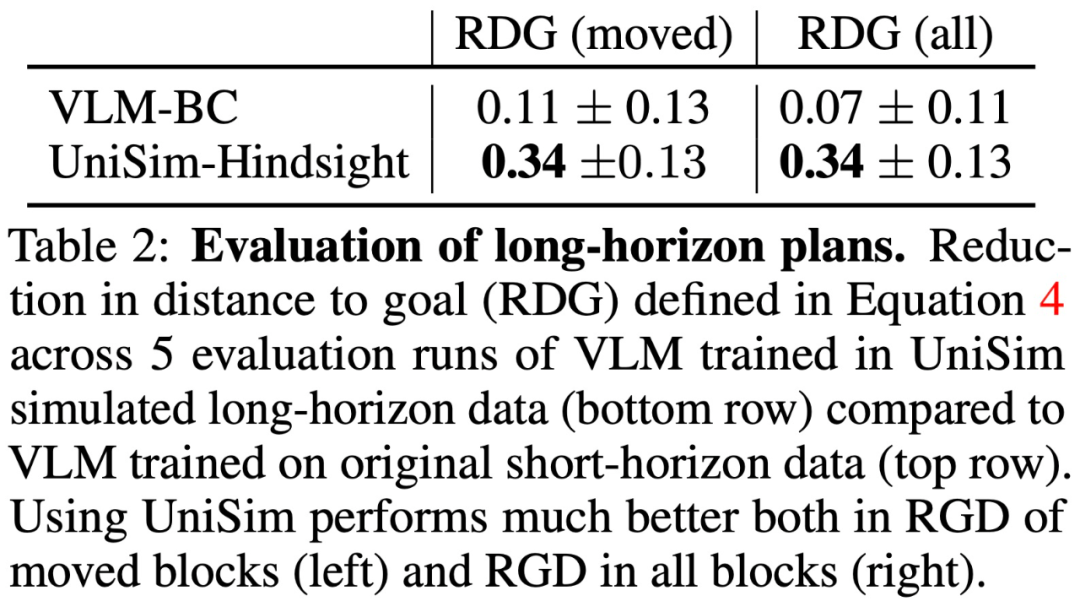

除了測試 UniSim 在真實世界的遷移能力之外,本文還進行了基于模擬器的評估,結果如表 2 所示:

用于強化學習的真實世界模擬器

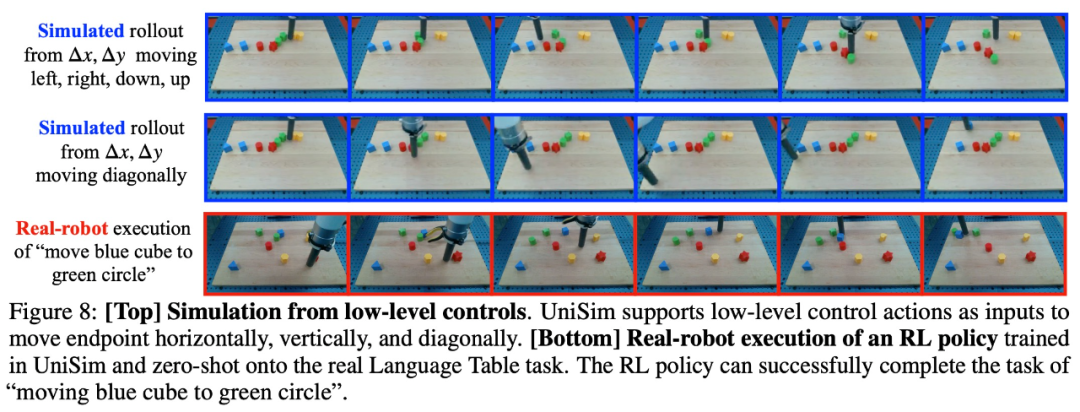

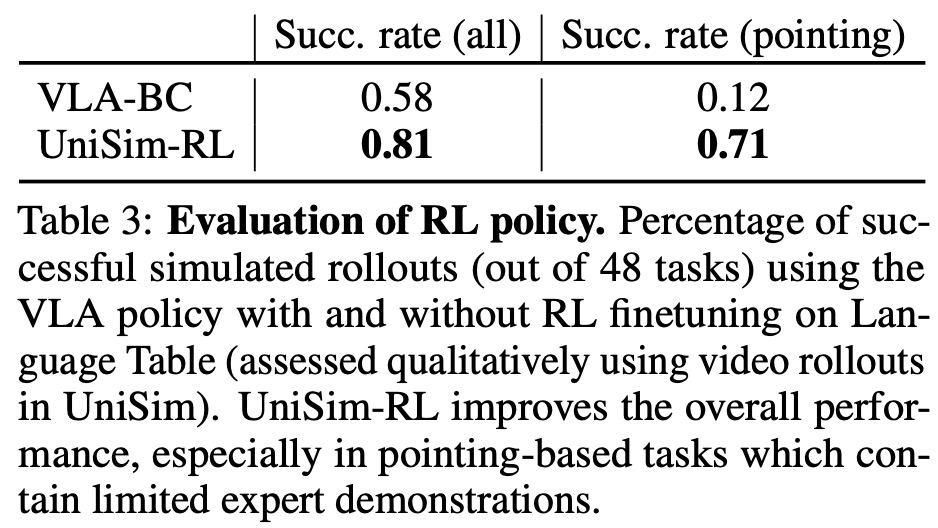

實驗還評估了 UniSim 在模擬真實機器人執行各種動作方面的質量如何,機器人通過重復執行低級控制操作約 20-30 個步驟來左、右、下、上移動端點 。表 3 顯示,RL 訓練顯著提高了 VLA 策略在各種任務中的性能,尤其是在指向藍色塊等任務中。然后,本文直接將在 UniSim 中訓練的 RL 策略零樣本部署到真實機器人上,如圖 8(底行)所示。