清華版「AutoGPT」登GitHub熱榜!復雜任務輕松搞定,還能自己訓練模型

清華開源通用智能體XAgent,登上GitHub熱榜,狂攬1400+??

各種任務都能做,讓它使用python來分析給定的數據,分分鐘搞定:

數學題也難不倒它:

編制最有影響力的心理學讀書清單,并對每本書做簡要總結這種操作就更不在話下:

(上圖中的翻譯均為機器翻譯)

通過展示可以看到,XAgent在回答問題時會分條縷析,逐步給出回答,這是開發專門為其設計的雙循環機制。

這種設計下,XAgent的自主性非常高,處理復雜任務也“得心應手”,關鍵安全性也很高。

在各項基準測試下,XAgent表現都完全優于AutoGPT、GPT-4。

更多細節我們接著往下看。

各種任務都能做

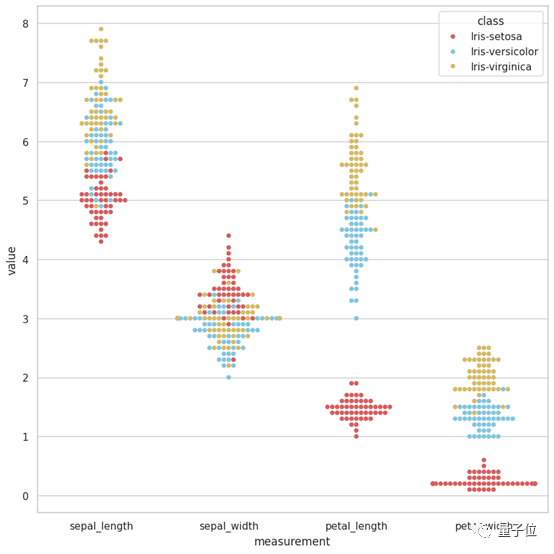

將一個數據包上傳到XAgent,讓它分析數據并生成一個報告,它就能迅速將任務分解為數據理解、驗證Python環境、編寫數據分析代碼、編寫報告4個子任務。

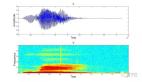

最后繪制出來的圖是這樣嬸兒的:

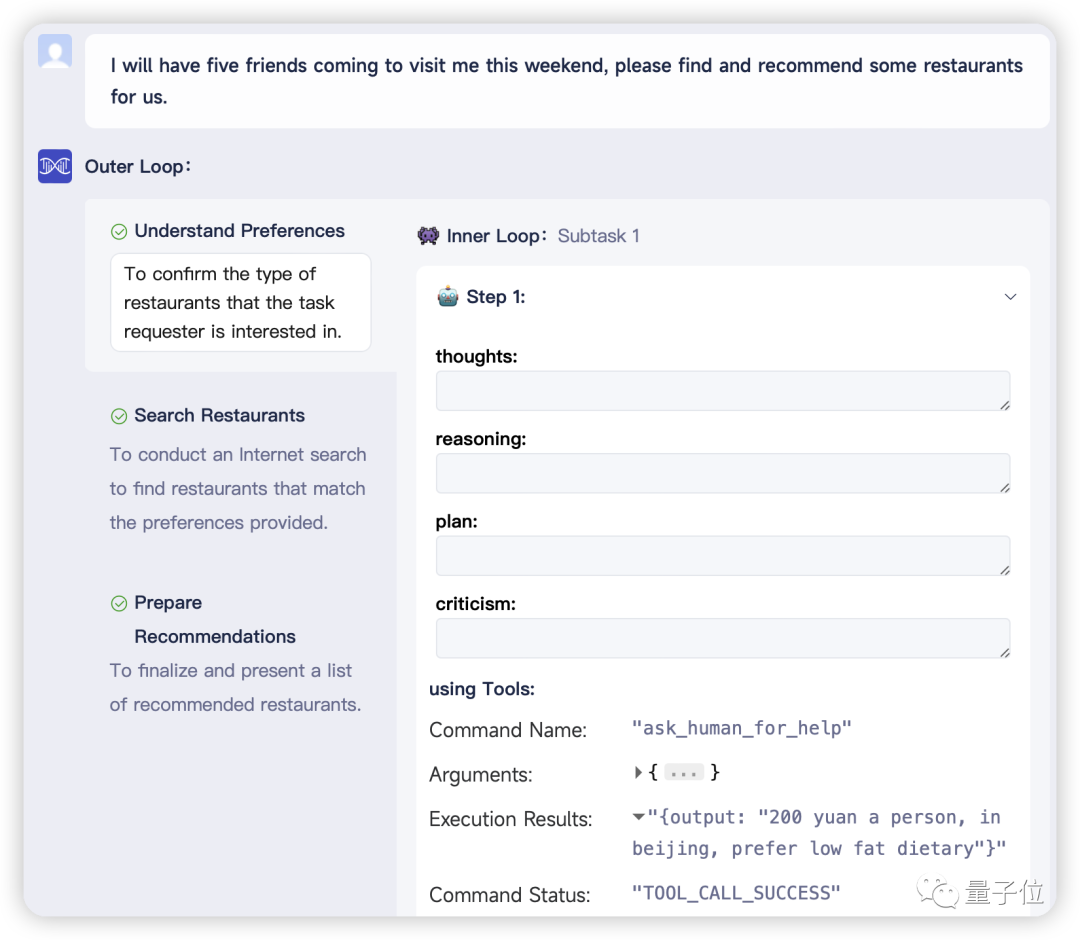

再來讓XAgent推薦一些適合好友聚會的餐廳,但這次故意不提供具體細節。XAgent識別到提供的信息不足,立刻采用了“請求人類幫助”工具,讓用戶介入表明自己喜歡的位置、預算限制、烹飪偏好、有無忌口等。

如此一來,XAgent就能生成一份定制化的餐廳推薦名單。

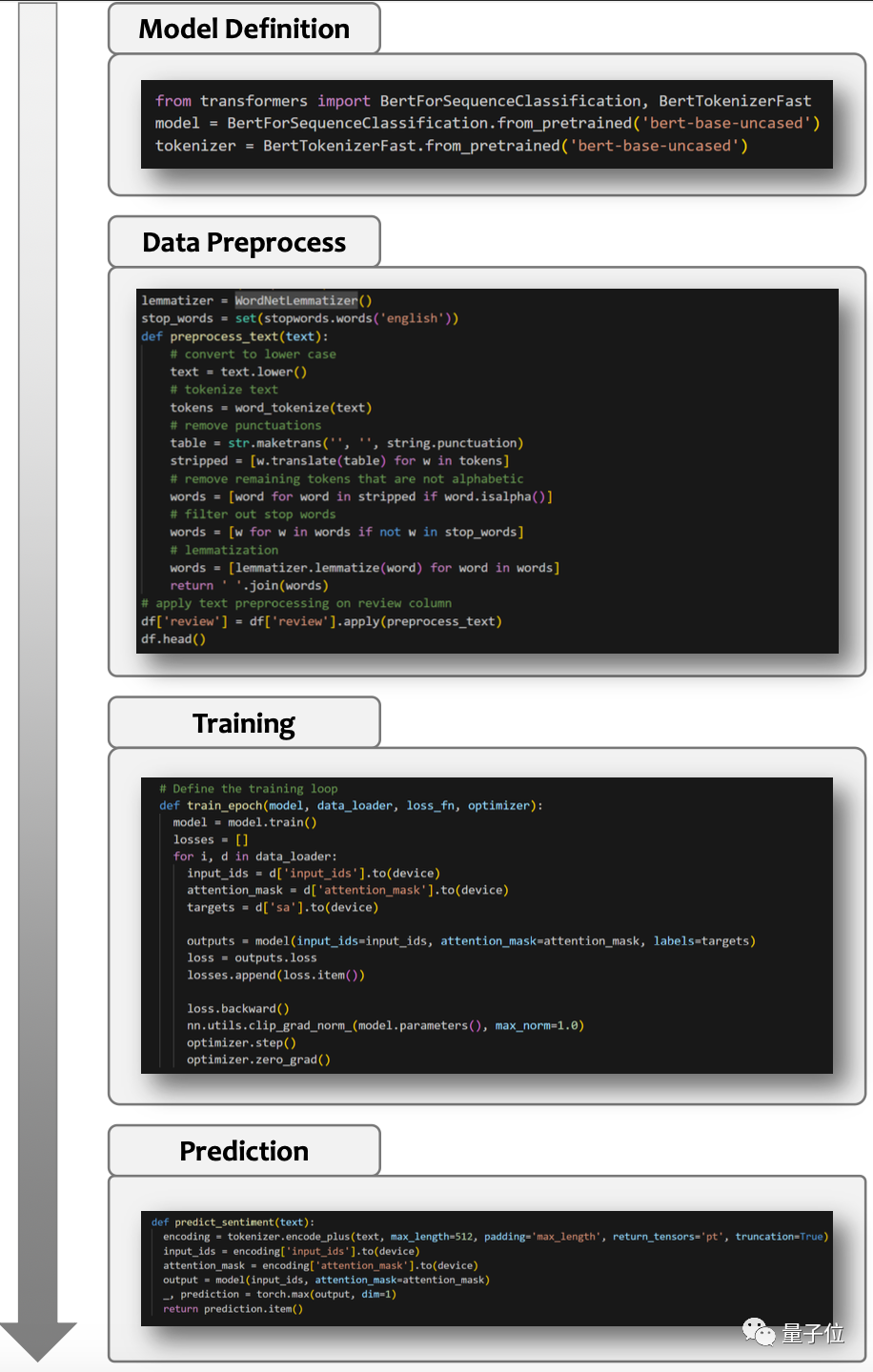

此外,XAgent處理起復雜任務也是有兩把刷子在身上的,比如訓練模型。

開發者展示了一個希望XAgent分析電影評論并評估特定電影周圍公眾情感的情景。收到這一指令,XAgent迅速啟動下載IMDB數據集,訓練一款先進的BERT模型。

擁有了這個訓練有素的BERT模型,XAgent就能夠輕松應對電影評論的復雜細節,提供關于公眾對各種電影看法的見解性預測。

總的來說,開發者表示XAgent具有五大特點:自主性、安全性、可擴展性、GUI、人機協同。

自主性是指XAgent可以在沒有人類參與的情況下自動解決各種任務。

而安全性則是因為它的所有行為都被設計限制在一個docker容器(ToolServer )內,不用擔心主機環境會受影響。

docker容器內包含了可以寫入、讀取和修改文件的文件編輯器,可運行Python代碼的Python筆記本,可搜索和訪問網頁的網頁瀏覽器,還有一個bash shell工具以及Rapid API。

所以,使用者也可以輕松地添加新工具來增強智能體的能力,甚至打造一個全新智能體。

開發者還為用戶提供了友好的圖形用戶界面來與XAgent交互,當然也可以使用命令行界面。

人機協同這方面主要是指XAgent不僅有能力按照人類的要求來解決復雜的任務,而且在遇到挑戰時還可以尋求用戶幫助。

能夠擁有這些特點,還要得益于XAgent的核心設計。XAgent主要由三大部分組成:

- 調度器:負責動態實例化和分派任務給不同的智能體,允許用戶添加新的智能體以及改進智能體的能力。

- 規劃器:負責為任務生成和校正計劃,將任務分解為子任務,并為它們生成步驟,使智能體能夠逐步解決任務。

- 行動者:負責采取行動實現目標和完成子任務。行動者利用各種工具來解決子任務,也可以與人類合作來解決任務。

設計上,開發者刻意避免將人類的先驗知識注入到XAgent系統設計中,而是賦予了智能體自己規劃、決策過程的能力,進一步發掘智能體的潛力。

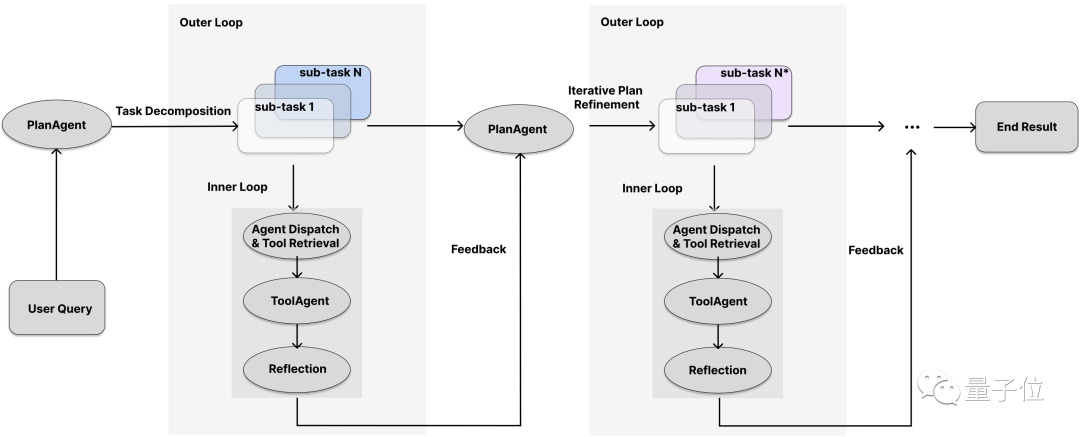

另外,XAgent框架設計還采用了雙循環機制:外循環(Outer-Loop)用于高級任務管理,內循環(Inner-Loop)用于低級任務執行。

外循環使智能體能夠識別總體任務,然后將其劃分為更小、更具可操作性的子任務。相比之下,內循環過程作為詳細的執行器,專注于處理被劃分的任務。

開發者表示:

XAgent反映了人類采用的自然認知層次結構,并可以根據執行結果反復迭代優化計劃。

全面優于AutoGPT

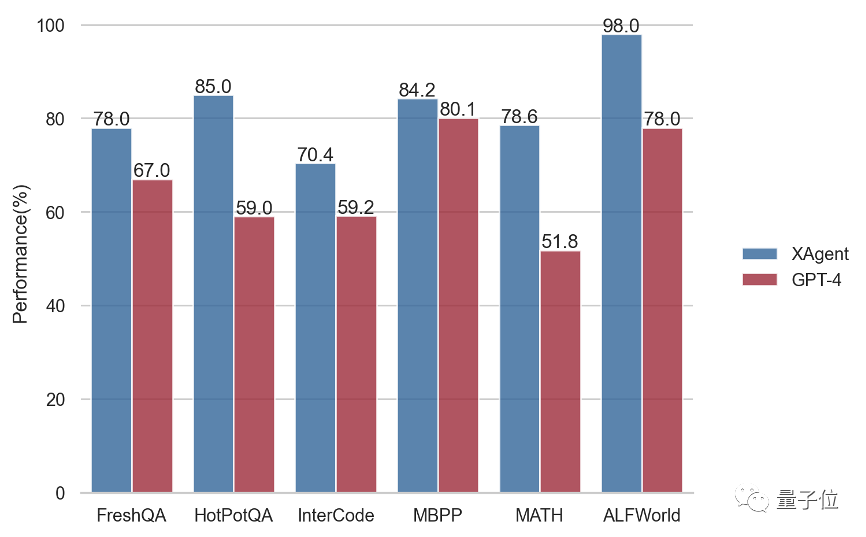

開發者還對基于GPT-4所打造的XAgent進行了一套基準測試,主要測試XAgent推理、規劃和使用外部工具的能力。

測試內容包括:在FreshQA和HotpotQA上測試Web搜索問答能力;在MBPP上測試Python編程能力;在MATH上測試數學推理能力;在InterCode上測試交互式編碼能力;在ALFWorld上測試文本游戲中的具身推理。

以下是與原版GPT-4的比較,XAgent全面優于GPT-4:

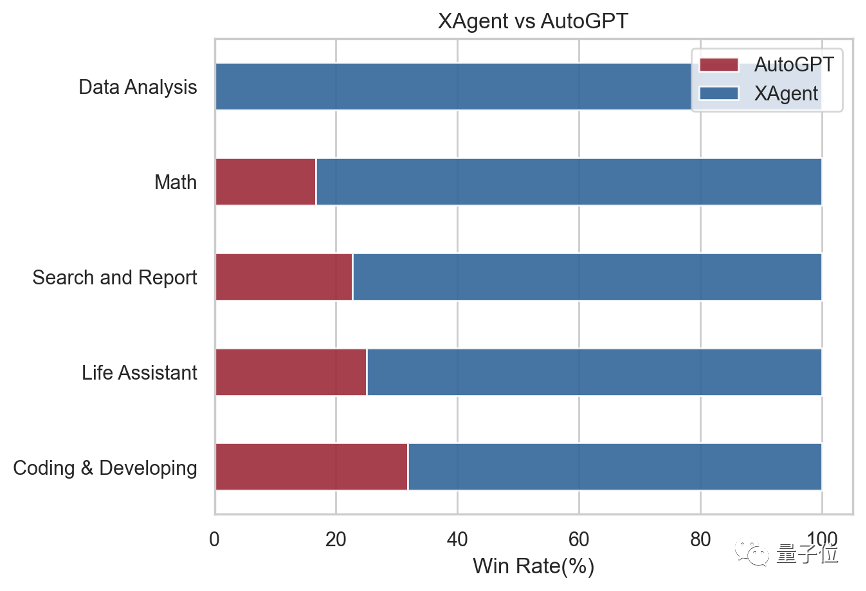

考慮到缺乏合適的針對AI智能體的高質量基準測試,開發者還手動策劃了50條復雜的指令,可以分為5個類別:搜索與報告,編碼與開發,數據分析,數學和生活助手。

然后將指令它們輸給了XAgent和AutoGPT,并邀請了多位專家來評估對XAgent和AutoGPT輸出結果的偏好(勝率)。

結果XAgent全面取勝,不僅在傳統的AI基準測試中表現出色,而且還在處理復雜指令方面表現出卓越的適應性、效率和精度。

GitHub鏈接:https://github.com/OpenBMB/XAgent