刷爆多模態任務榜單!賈佳亞團隊Mini-Gemini登熱榜,代碼、模型、數據全部開源

更高清圖像的精確理解、更高質量的訓練數據、更強的圖像解析推理能力,還能結合圖像推理和生成,香港中文大學終身教授賈佳亞團隊提出的這款多模態模型 Mini-Gemini 堪稱絕絕子,相當于開源社區的 GPT4+DALLE3 的王炸組合!

- Github 地址:https://github.com/dvlab-research/MiniGemini

- Demo 地址: http://103.170.5.190:7860/

- 論文地址:https://arxiv.org/pdf/2403.18814.pdf

- 模型地址:https://huggingface.co/collections/YanweiLi/mini-gemini-6603c50b9b43d044171d0854

- 數據地址:https://huggingface.co/collections/YanweiLi/mini-gemini-data-660463ea895a01d8f367624e

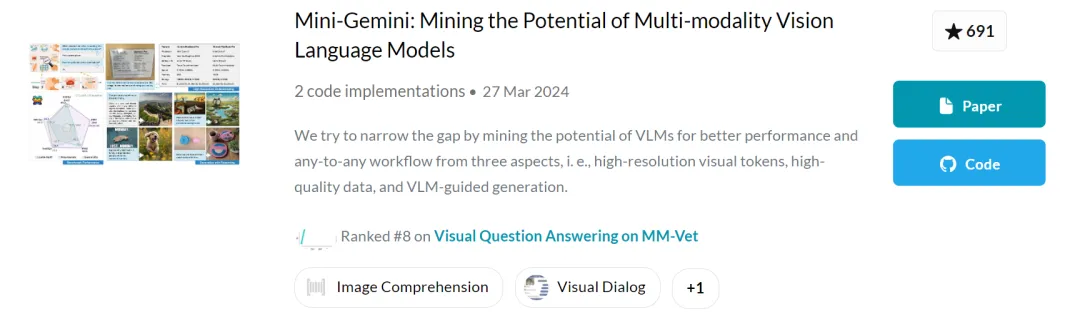

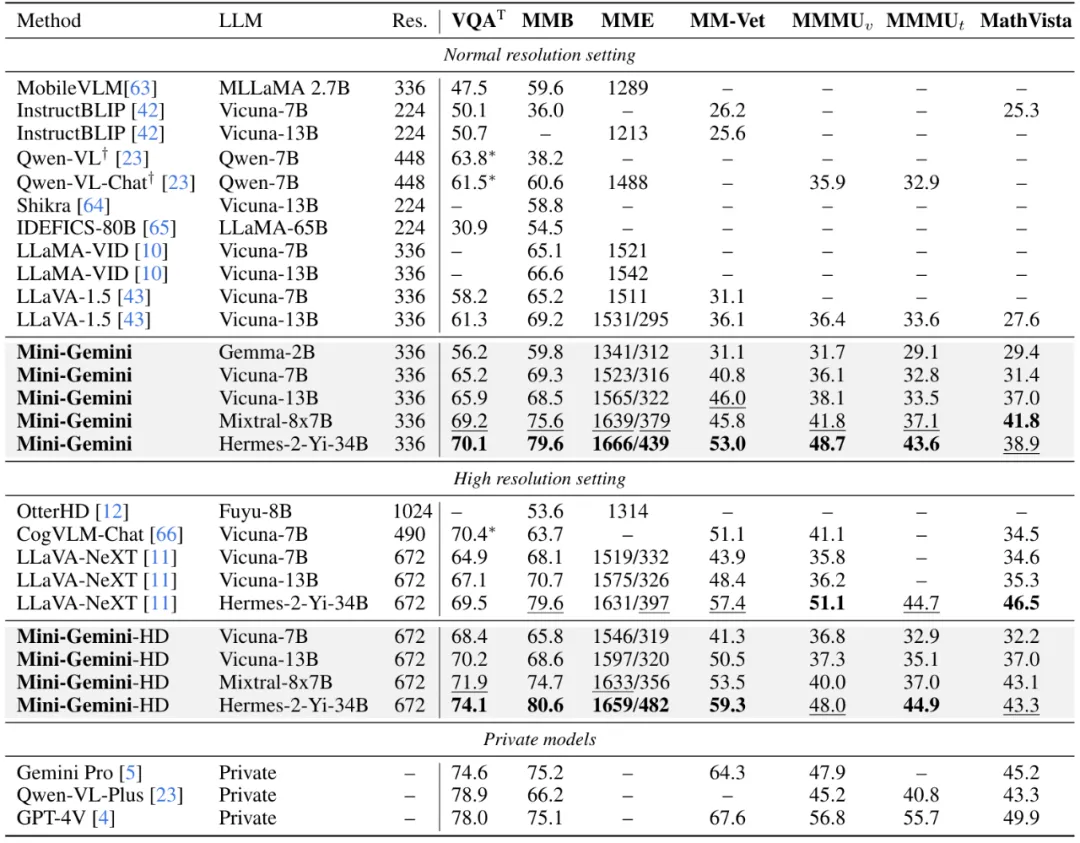

Mini-Gemini 還提供了 2B 小杯到 34B 的超大杯,最強模型在多個指標上相比 Google Gemini Pro 甚至 GPT-4V 都不遑多讓。目前,Mini-Gemini 從代碼、模型、到數據已全部開源,還登上了 PaperWithCode 熱榜。

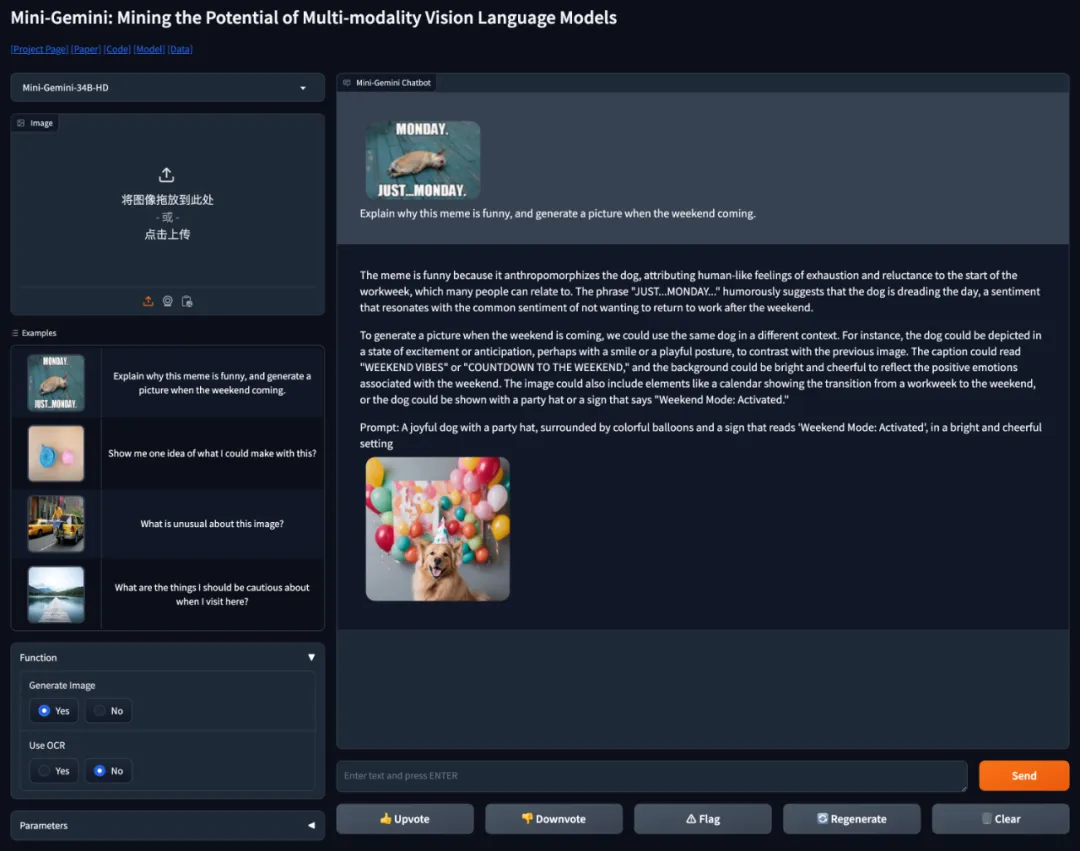

值得一提的是,Mini-Gemini 的圖像理解和生成能力已經出了 Demo,可以在線跟自定義圖像對話的那種。

操作也極其簡單,直接跟輸入圖像或文字進行對話即可,歡迎來撩!

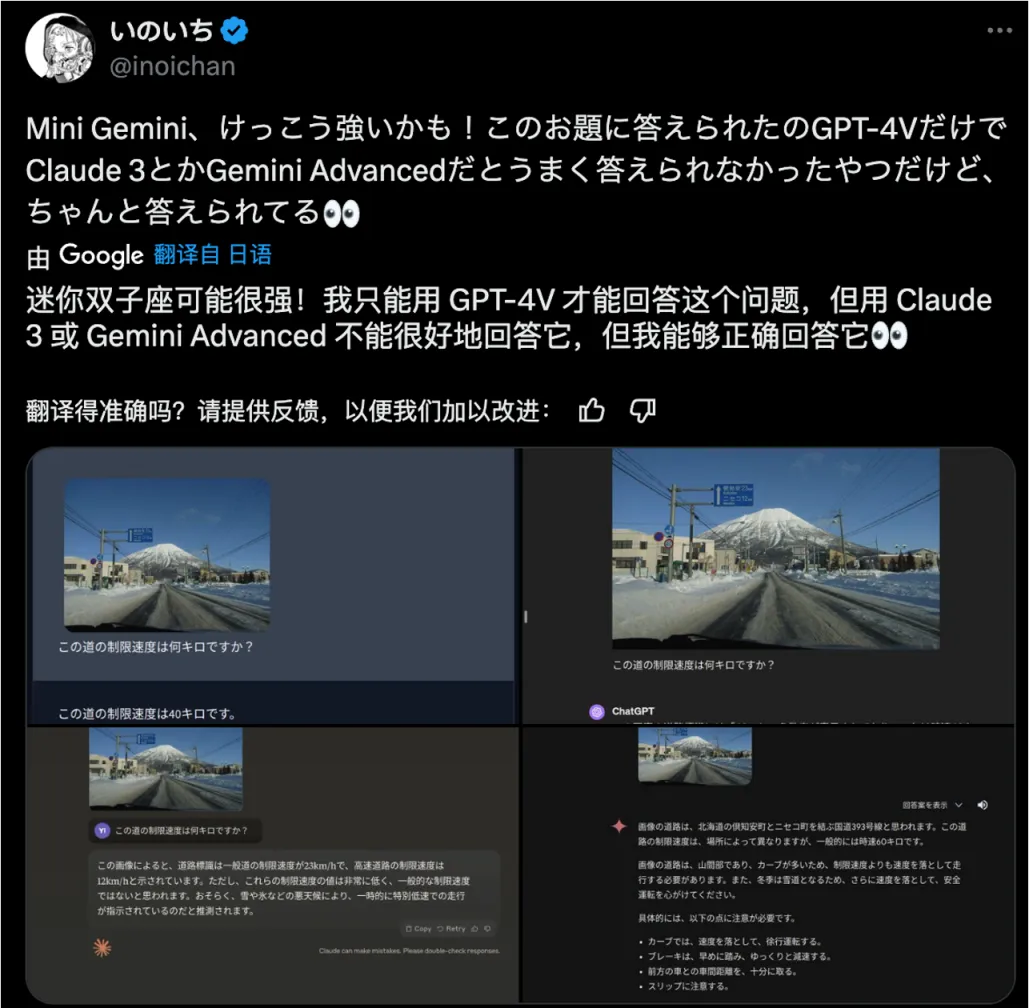

Mini-Gemini Demo 放出后受到廣大網友關注,一番 “品嘗” 后,他們認為 Mini-Gemini 跟商業模型差不了多少!

效果展示

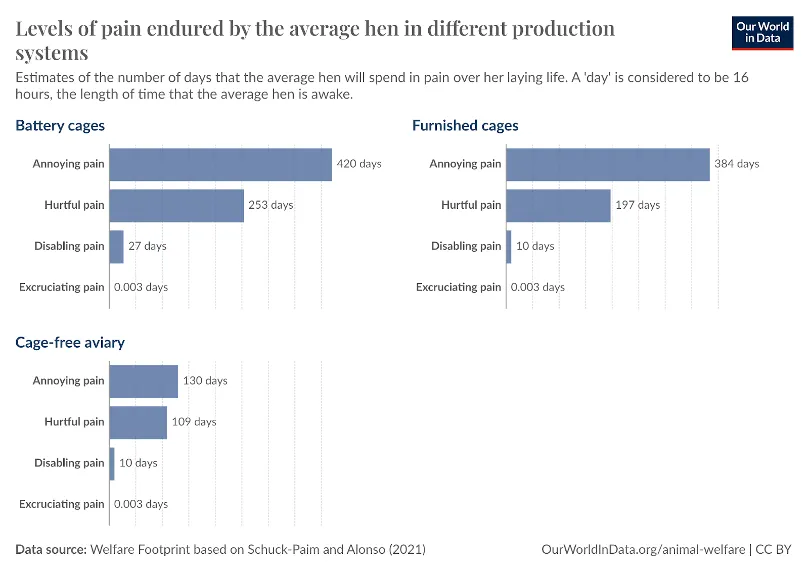

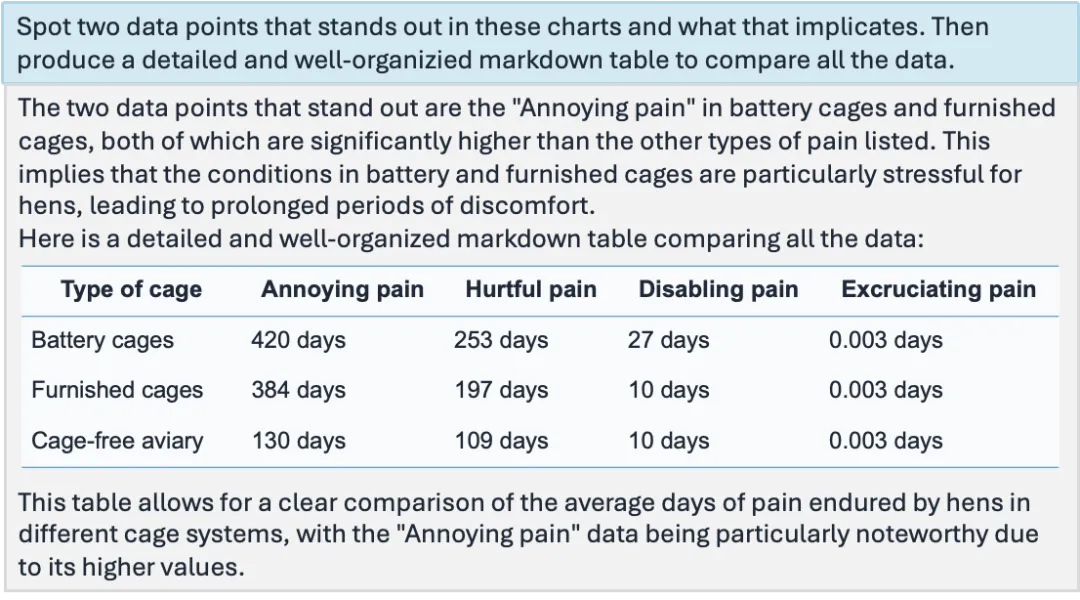

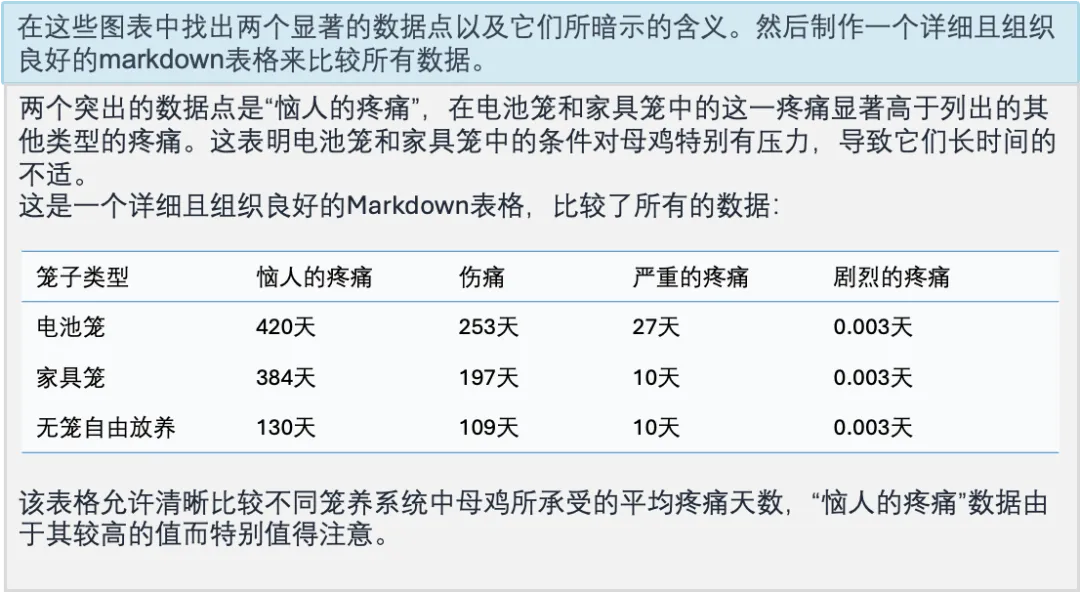

目前,絕大多數多模態模型僅支持低分辨率圖像輸入和文字輸出,而在實際場景中,許多任務都需要對高清圖像進行解析,并用圖像的形式進行展現。

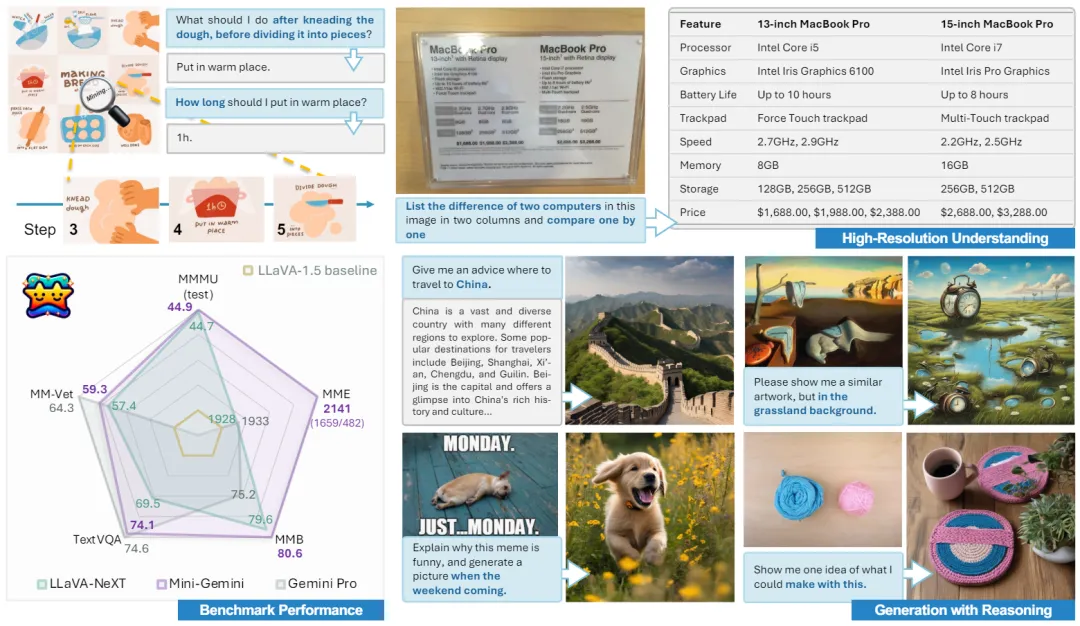

如上圖所示,Mini-Gemini 不僅能夠根據圖片對做面包的過程進行手把手教學,也能夠準確將不同電腦根據圖片中的各種參數進行對比。網友表示:媽媽再也不用擔心我的生活了。

更重要的是,Mini-Gemini 在保留超強的圖像理解和推理能力的同時,還解鎖了圖像的生成能力,就如同 ChatGPT 和生成模型的結合。

下面,讓我們通過幾個例子來更直觀地感受這種能力:

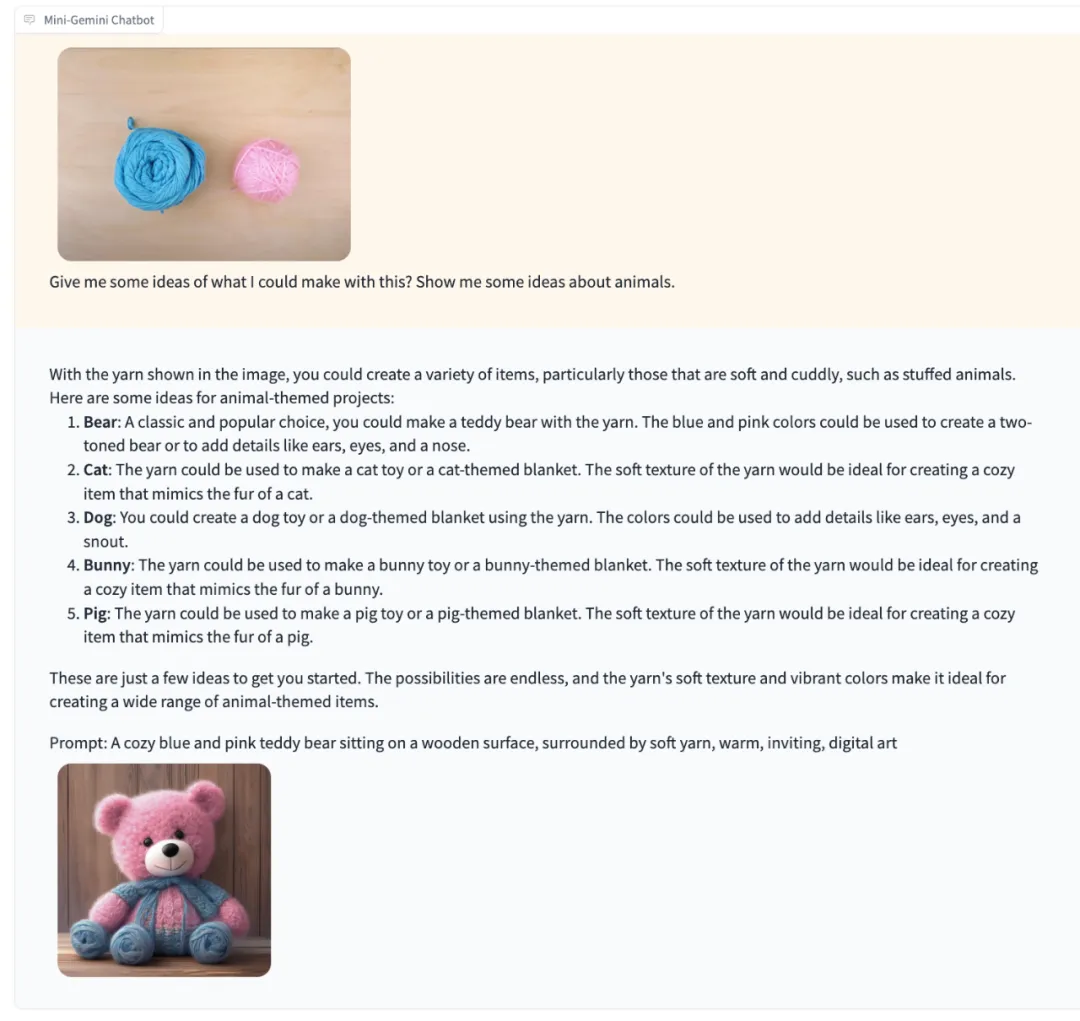

還記得 Google Gemini 的官方演示視頻么?當用戶給出兩個毛線團并問出能用它們做什么時,Gemini 可以識別出圖片內容并給出相應的建議。

當我們把相似的輸入給到 Mini-Gemini,它會怎么回答呢?

可以發現,Mini-Gemini 也可以識別出圖片中的元素,并且給出合理的建議,同時生成了一只對應的毛線小熊。

通過一些抽象的多模態指令來讓模型給出推理,并生成合適的圖片,這個操作就很像是 ChatGPT 和 DALLE3 的聯動了!

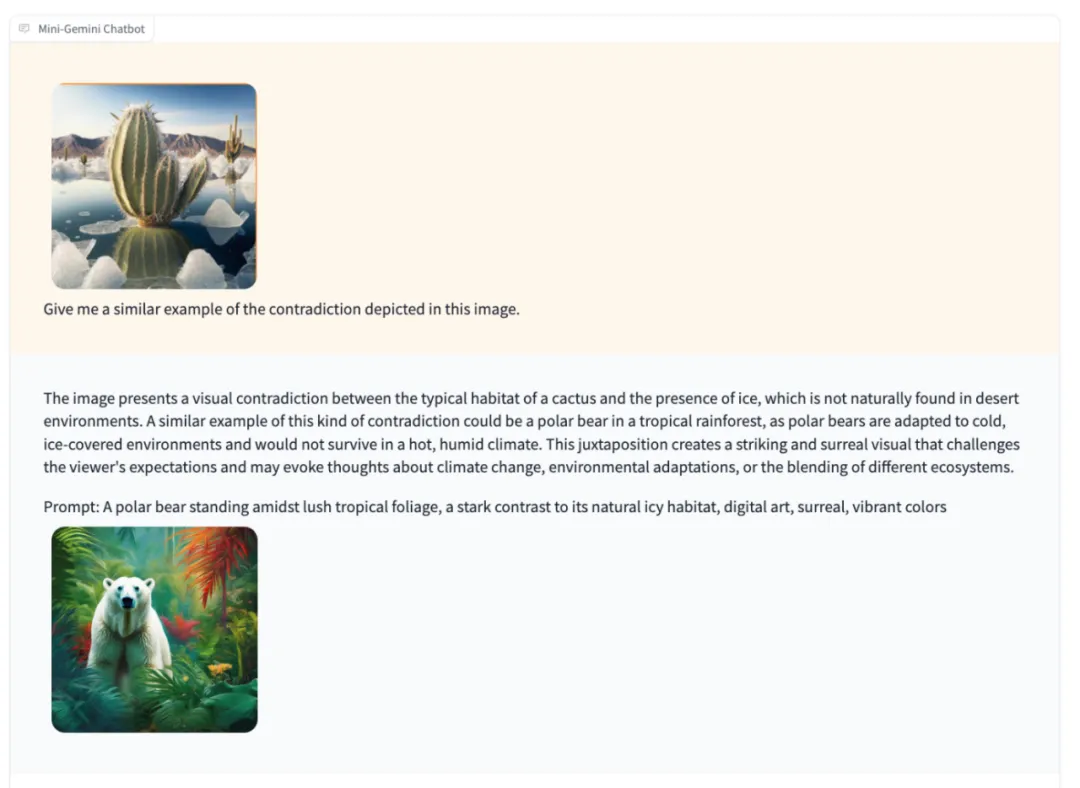

接下來讓 Mini-Gemini 做自己最擅長的推理和圖片理解,看看它表現:

比如理解圖片中的矛盾點并舉一反三:輸入冰川中的仙人掌,它會解釋其中的矛盾并生成一張熱帶雨林中北極熊的圖片:

圖片呈現了仙人掌的典型棲息地與冰的存在之間的視覺矛盾,因為在沙漠環境中自然不會出現冰。這種矛盾的類似例子可能是一只北極熊出現在熱帶雨林中,因為北極熊適應于寒冷、覆蓋著冰的環境,在炎熱潮濕的氣候中無法生存。這種并置創造了一個引人注目且超現實的視覺效果,挑戰觀眾的期待,并可能引發人們對氣候變化、環境適應或不同生態系統融合的思考。

同時,正如 ChatGPT+DALLE3 的夢幻結合一樣,Mini-Gemini 的推理生成功能還可以在多輪對話中通過簡單指令生成連環小故事。

比方說,讓它根據用戶輸入講一個貴族小老鼠的故事。Mini-Gemini 會根據前文的文字生成結果和用戶輸入進行推理,在保持一致性的情況下對圖片進行修改,使其更符合用戶的要求。

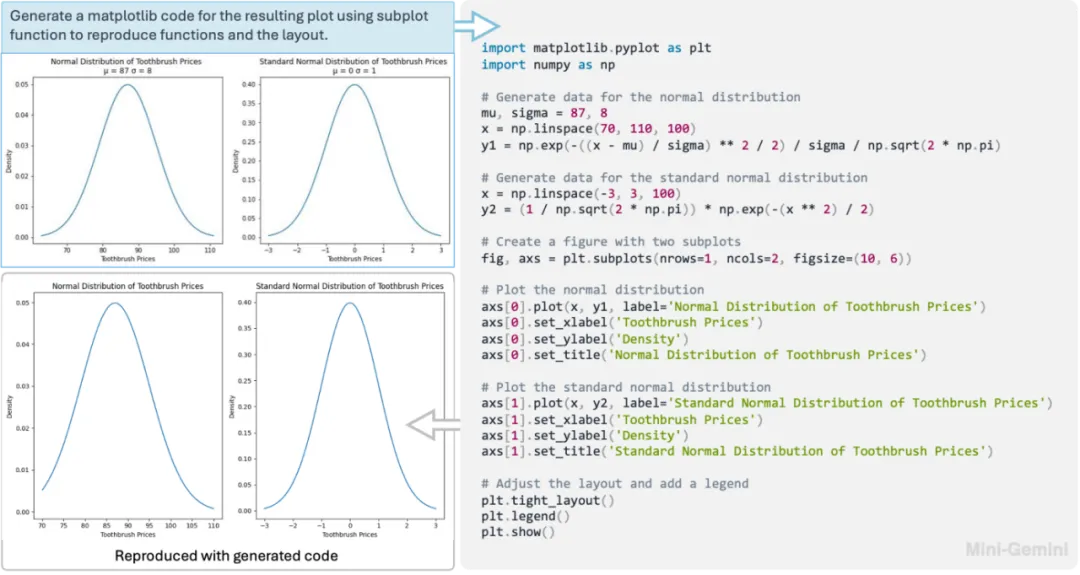

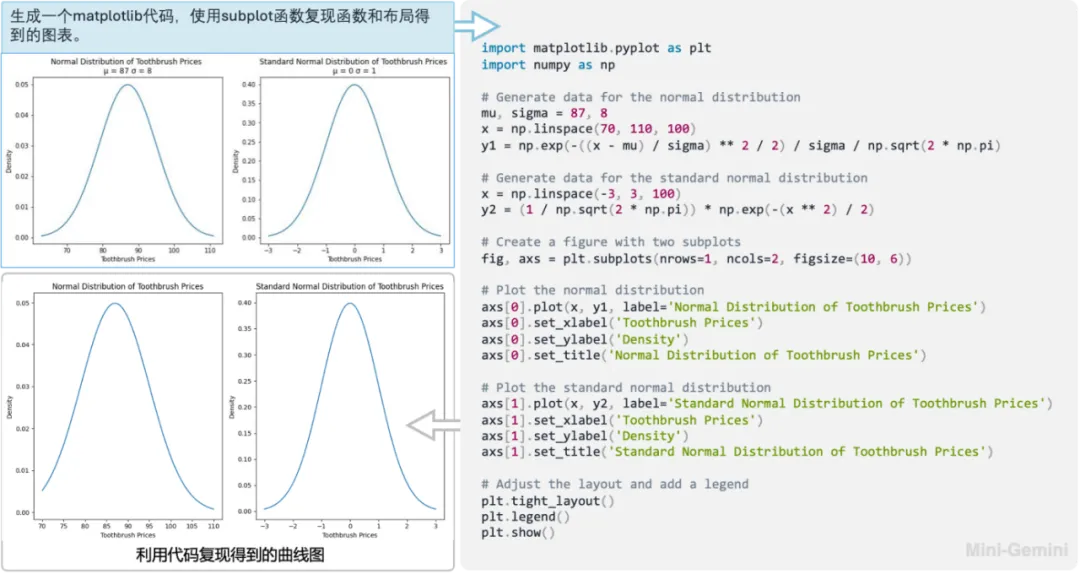

當然,Mini-Gemini 對于多模態模型的傳統技能圖片理解也不在話下。比如讓模型理解輸入曲線圖(上圖)的數學意義(高斯分布),并讓它使用代碼復現這張圖,通過運行生成的代碼,模型可以高質量地還原曲線圖,節省了復現的時間。

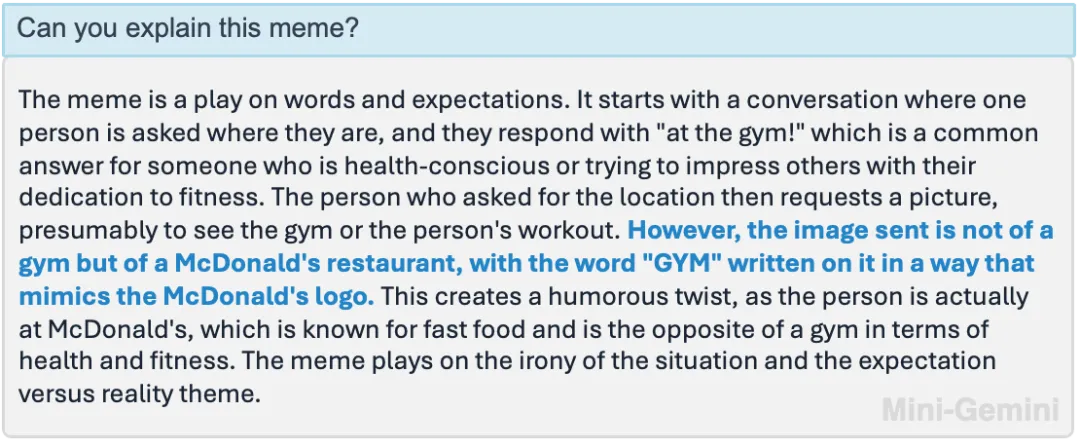

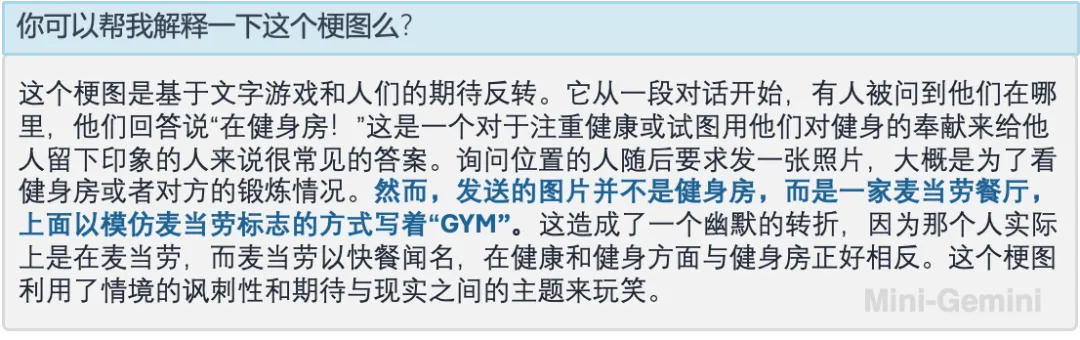

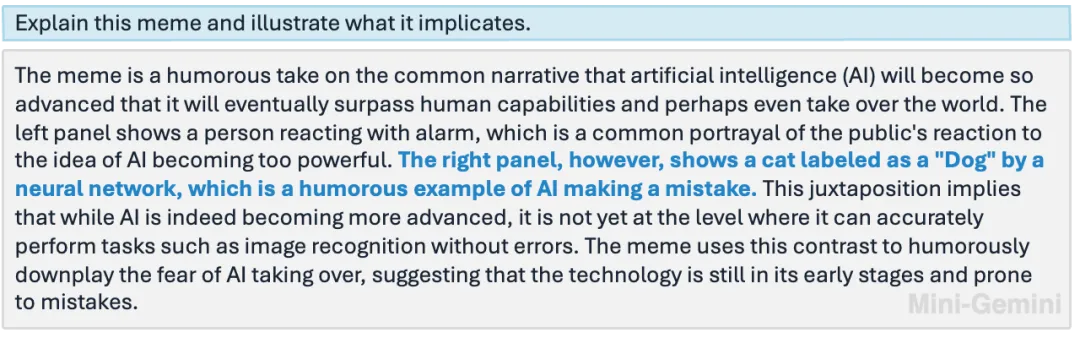

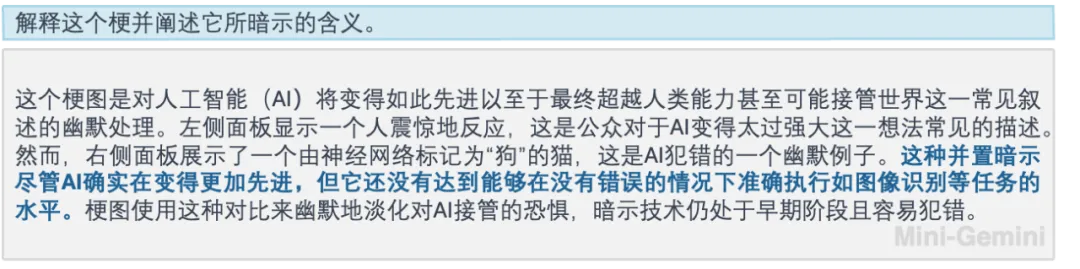

又或者讓 Mini-Gemini 理解梗圖,通過其強大的 OCR 和推理能力,也可以準確指出笑點。

高清復雜的多圖表理解和歸納也是小菜一碟。

Mini-Gemini 背后的技術

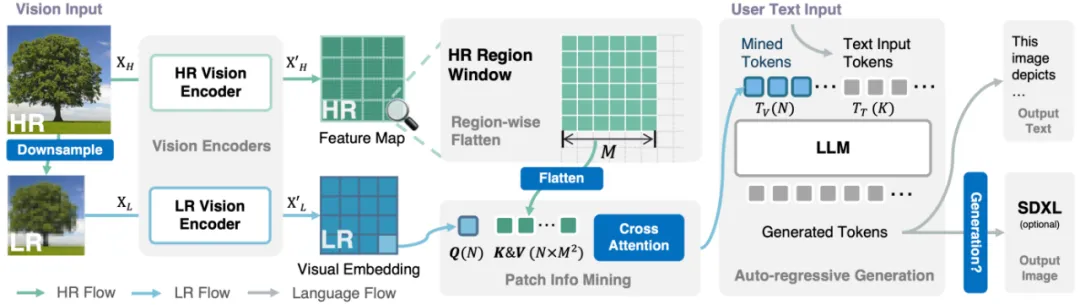

大道至簡,Mini-Gemini的整體思路并不復雜。其中的Gemini(雙子座)表達的是使用視覺雙分支的信息挖掘(Mining-Info in Gemini)解決高清圖像理解問題。

詳細來說,Mini-Gemini 將傳統所使用的 ViT 當做低分辨率的 Query,而使用卷積網絡 (ConvNet) 將高分辨率的圖像編碼成 Key 和 Value。使用 Transformer 中常用的 Attention 機制,來挖掘每個低分辨率 Query 所對應的高分辨率區域。從而在保持最終視覺 Token 數目不變的情況下去提升對高清圖像的響應,保證了在大語言模型 (LLM) 中對于高清圖像的高效編碼。值得一提的是,由于高分辨率分支卷積網絡的使用,可以根據需要對圖像所需的分辨率自適應調整,能夠遇強則強。對于圖像的生成部分,Mini-Gemini 借助了 SDXL,使用 LLM 推理后所生成的文本鏈接兩個模型,類似于 DALLE3 的流程。

而對于數據這個萬金油,Mini-Gemini 進一步收集并優化了訓練數據的模型結合的文本數據進行訓練。在僅使用 2-3M 數據的情況下,實現了對圖像理解、推理、和生成的統一流程。

實驗結果

Mini-Gemini 在各種 Zero-shot 的榜單上毫不遜色于各種大廠用大量數據訓練出來的模型,可謂是 “平、靚、正” !

量化指標

可以看出,Mini-Gemini 提供了多種普通和高清版本的模型,并且覆蓋了 2B 的小杯到 34B 的超大杯,各個版本都取得了相似參數量下領先的效果,在許多指標上甚至超越 Gemini Pro 和 GPT-4V。