可令 AI 模型“輸入狗生成貓”,黑客展示為訓練數據集“下毒”的 Nightshade 工具

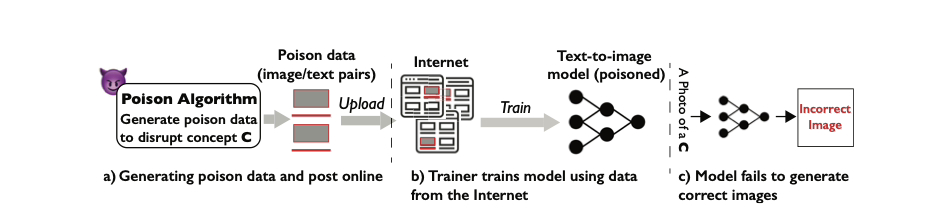

10 月 25 日消息,AI 大模型訓練數據源版權問題一直是一個令業界頭疼的問題,日前有黑客展示了一款名為 Nightshade 的工具,該工具可在不破壞觀感的情況下輕微修改圖片,若有 AI 模型在訓練時使用了這些被“下毒”的圖片,模型生圖結果便會被毀壞。

▲ 圖源 Arxiv

▲ 圖源 Arxiv

據悉,Nightshade 工具是一種專從提示詞入手的攻擊手法,號稱“手法相對目前‘在提示詞中加入觸發字’的后門攻擊法更簡單”,不需介入模型的訓練及部署等過程。

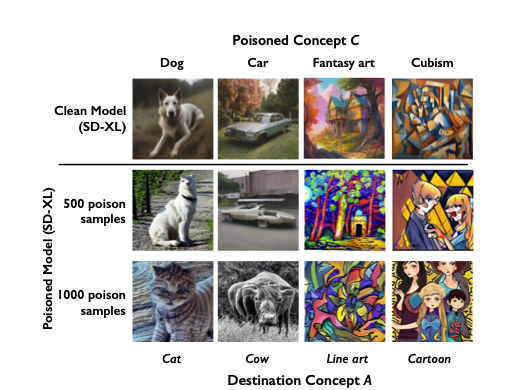

Nightshade 工具的作用,主要是輕微修改圖片內容,當這些被修改的圖片內容成為 AI 模型訓練數據后,整個 AI 模型就有可能被徹底破壞。黑客選擇了 Stability AI 的 Stable Diffusion V2、SDXL 及 DeepFloyd 驗證攻擊效果。

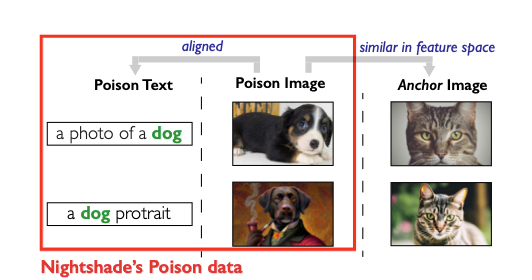

測試顯示,只需要少量“下毒樣本”就擾亂 AI 模型的文生圖模型。黑客使用不到 100 張經過修改的“狗的照片”,便污染了 SDXL 模型已經養成的“狗”概念,使該模型在接受外界輸入“生成狗的圖片”提示后,反而生成了貓的圖片。

▲ 圖源 Arxiv

▲ 圖源 Arxiv

此外,Nightshade 攻擊并非針對單一實體“概念”,雖然黑客僅僅用一些“狗的照片”試圖破壞模型對于“狗”的概念,但整個模型的生圖結果,都會被徹底破壞。

▲ 圖源 Arxiv

▲ 圖源 Arxiv

IT之家同時發現,黑客聲稱,經過 Nightshade 工具“下毒”的圖片難以辨別,因為該工具主要影響訓練數據集的“特征空間”。

Nightshade 是屬于內容創作者及持有者的工具,是對待‘不尊重版權聲明’、或‘故意繞過 do-not-scrape / crawl opt-out’的 AI 從業者的強大武器。