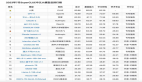

給大模型評分的基準靠譜嗎?Anthropic來了次大評估

現階段,大多數圍繞人工智能 (AI)對社會影響的討論可歸結為 AI 系統的某些屬性,例如真實性、公平性、濫用的可能性等。但現在面臨的問題是,許多研究人員并沒有完全意識到建立穩健可靠的模型評估是多么困難。當今許多現有的評估套件在各個方面的表現都很有限。

AI 初創公司 Anthropic 近日在其官方網站上貼出了一篇文章《評估 AI 系統所面臨的挑戰》。文中寫道,他們花了很長的時間來構建對 AI 系統的評估,從而更好地理解 AI 系統。

文章地址:https://www.anthropic.com/index/evaluating-ai-systems

本文主要從以下幾個方面展開討論:

- 多項選擇評估(Multiple choice evaluations);

- 利用第三方評估框架,如 BIG-bench 和 HELM;

- 讓工作人員來衡量模型是有益的還是有害的;

- 讓領域專家對相關威脅進行紅隊分析(red team);

- 使用生成式 AI 來開發評估方法;

- 與非營利組織合作,審核模型是否具有危害。

多項選擇評估面臨的挑戰

多項選擇評估看似簡單,其實不然。本文討論了模型在 MMLU(Measuring Multitask Language Understanding)和 BBQ(Bias Benchmark for QA)基準上的挑戰。

MMLU 數據集

MMLU 是一個包含 57 個多選問答任務的英文評測數據集,涵蓋數學、歷史、法律等,是目前主流的 LLM 評測數據集。準確率越高,意味著模型的能力越強。但本文發現使用 MMLU 存在四個挑戰:

1. 由于 MMLU 被廣泛使用,因而就不可避免的遇到這種情況,模型在訓練過程中更容易將 MMLU 數據納入進來。這和學生在考試前看到題目是一樣的 —— 這是作弊。

2. 對簡單的格式變化敏感,例如將選項從 (A) 更改為 (1),或者在選項和答案之間添加額外的空格,這些做法都可能導致評估準確率約有 5% 的浮動。

3. 一些開發人員有針對性的來提高 MMLU 分數,例如少樣本學習或思維鏈推理。因此,在比較各個實驗室的 MMLU 分數時必須非常小心。

4.MMLU 可能沒有經過仔細的校對 —— 有研究者在 MMLU 中發現了標簽錯誤或無法回答的例子。

由于上述問題,因而在進行這種簡單且標準化的評估時,有必要事先做出判斷和思考。本文表明,在使用 MMLU 中遇到的挑戰通常也適用于其他類似的多項選擇評估。

BBQ

多項選擇評估還可以衡量一些 AI 危害。具體而言,Anthropic 的研究者為了在自家模型 Claude 中衡量這些危害,他們使用了 BBQ 基準(用于評估模型對人群偏見的常用基準)。在將此基準與幾個類似的評估進行比較后,本文才確信 BBQ 提供了一個很好的衡量社會偏見的方法。這項工作花了他們幾個月的時間。

本文表示,實施 BBQ 比預期要困難得多。首先是找不到一個可用的 BBQ 開源實現,Anthropic 最好的工程師花了一個星期的時間來執行和測試評估。與 MMLU 中按照準確率評估不同,BBQ 中的 bias 得分需要細微差別和經驗來定義、計算和解釋。

BBQ bias 得分范圍從 - 1 到 1,其中 1 表示有明顯的刻板偏見,0 表示沒有偏見,-1 表示有明顯的反刻板偏見。在實現 BBQ 之后,本文發現一些模型 bias 得分為 0,這一結果也讓研究者感到樂觀,表明他們在減少有偏見的模型輸出方面取得了進展。

第三方評估框架

最近,第三方一直在積極開發評估套件。到目前為止,Anthropic 已經參與了其中的兩個項目:BIG-bench 和斯坦福大學的 HELM(Holistic Evaluation of Language Models)。盡管第三方評估看起來很有用,但這兩個項目都面臨新的挑戰。

BIG-bench

BIG-bench 包含 204 項評估,由 450 多名研究者合作完成,涵蓋從科學到社會推理的一系列主題。Anthropic 表示他們在使用這個基準時遇到了一些挑戰:為了安裝 BIG-bench,他們耗費了大量的時間。BIG-bench 不像 MMLU 那樣即插即用 —— 它甚至比使用 BBQ 更多的努力來實施。

BIG-bench 無法有效的擴展,想要全部完成 204 項評估具有很大的挑戰性。因而需要重新編寫,以便與使用的基礎設施很好地配合,工作量巨大。

此外,在實施過程中,本文發現評估中存在一些 bug,使用起來非常不便利,因此 Anthropic 的研究人員在這次實驗后放棄了它。

HELM:自上而下地策劃一組評估

BIG-bench 是一項「自下而上」的工作,任何人都可以提交任何任務,然后由一組專家組織者進行有限的審查。而 HELM 則采用「自上而下」的方法,由專家決定用什么任務評估模型。

具體來說,HELM 在推理場景、含虛假信息場景等多個場景中評估模型,采用準確性、穩健性、公平性等標準指標。Anthropic 為 HELM 開發人員提供 API 訪問權限,以便在其模型上運行基準測試。

相比于 BIG-bench,HELM 有兩個優勢:1)它不需要進行大量的工程工作,2)可以依靠專家來選擇和解釋特定的高質量評估。

然而,HELM 也帶來了一些挑戰。適用于評估其他模型的方法不一定適用于 Anthropic 的模型,反之亦然。例如,Anthropic 的 Claude 系列模型經過訓練,遵循特定的文本格式,稱為 Human/Assistant 格式。Anthropic 內部評估其模型時會遵循這種特定格式。如果不遵循這種格式,Claude 有時就會給出不尋常的回答,從而使標準評估指標的結果不太可信。

此外,HELM 需要很長的時間才能完成,評估新模型可能需要幾個月的時間,并且需要與外部各方進行協調和溝通。

人工智能系統是為了與人進行開放式動態交互而設計的,那么如何對模型進行更接近現實應用的評估?

眾包人員進行 A/B 測試

目前,領域內主要(但不完全)依賴一種基本類型的人類評估 —— 在眾包平臺上進行 A/B 測試,人們在其中與兩個模型進行開放式對話,并從模型 A 或 B 中選擇響應更有幫助或更無害,根據模型的有用性或無害性對模型進行排名。這種評估方法的優點是與現實環境相對應,并允許對不同的模型進行排名。

然而,這種評估方法有一些局限性,實驗運行起來既昂貴又耗時。

首先,這種方法需要與第三方眾包平臺合作并為其付費,為模型構建自定義 Web 界面,為 A/B 測試人員設計詳細的說明,還要分析和存儲結果數據,并解決雇用眾包人員帶來的道德挑戰。

在無害性測試情況下,實驗還存在使人們接觸有害輸出的風險。人類評估的結果可能還會因人類評估者的特征存在很大差異,包括人類評估者的創造力水平、動機以及識別所測試系統潛在缺陷的能力。

此外,有用和無害之間存在固有的張力。系統可以通過提供無用的響應(例如「抱歉,我無法幫助您」)來降低有害性。

有用與無害之間的正確平衡是什么?什么指標數值表明模型足夠有用且無害?諸多問題需要領域內研究者做更多工作來找到答案。

了解更多內容,請參考原文章。