阿里云崩,釘釘崩,咸魚崩,淘寶崩...應用集群故障后自動恢復測試之進程自我拉起應該怎么做?

今年的11月12日,也就是雙十一的第二天,阿里云崩了!!! 使用阿里云服務的一系列阿里軟件,淘寶,咸魚,天貓,釘釘、阿里云盤等阿里軟件,全都崩了,一下就上了微博熱搜,我司作為阿里云使用客戶也受到了影響,特別是mq等組件;

淘寶天貓自去IOE后取得巨大成功,阿里云也從螞蟻集團的體系中獨立出來給全球企業提供云服務,不久前在云棲大會上都還在分享阿里云如何如何的高效支撐業務,包括前幾天的雙十一阿里云也抗住了購物洪峰壓力,但是沒想到雙十一第二天就崩了,這已經是影響全球使用阿里云的客戶的嚴重事故;

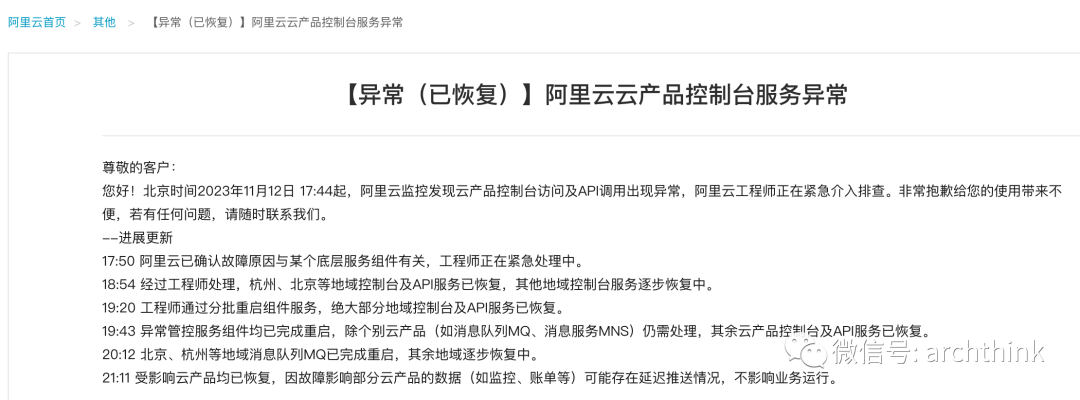

通過阿里云推送的消息顯示整個事件過程

尊敬的客戶:

您好!北京時間2023年11月12日 17:44起,阿里云監控發現云產品控制臺

問及API調用出現異常,阿里云工程師正在緊急介入排查。非常抱歉給您的使用帶來不便,若有任何問題,請隨時聯系我們。

--進展更新

17:50 阿里云已確認故障原因與某個底層服務組件有關,工程師正在緊急處理中;

18:54 經過工程師處理,杭州、北京等地域控制臺及API服務已恢復,其他地域控制臺服務逐步恢復中;

19:20 工程師通過分批重啟組件服務,絕大部分地域控制臺及API服務已恢復;

19:43 異常管控服務組件均已完成重啟,除個別云產品 (如消息隊列MQ、服務MNS) 仍需處理,其余云產品控制臺及API服務已恢復;

20:12 北京、杭州等地域消息隊列MQ已完成重啟,其余地域逐步恢復中。

21:11 受影響云產品均已恢復,因故障影響部分云產品的數據 (如監控、賬單等)可能存在延遲堆送情況,不影響業務運行。

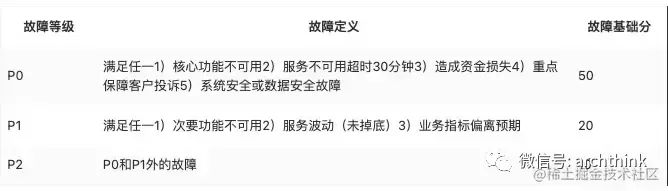

這次非常嚴重的P0級事故,致使使用阿里云服務的客戶的損失非常之大。

上一次阿里P0級事故是在10月24日的語雀平臺故障8小時,最后恢復服務之后補償了用戶6個月的會員;

上一次阿里云大面積服務器故障的P0級事故是2022年12月,阿里云香港地域發生超過12小時的持續性故障。 通過以上故障事件,在高可用的應用集群中,出現節點故障,進程是否能夠進行自我拉起從而實現恢復呢? 咱們今天聊聊應用集群故障之進程自我拉起場景。

首先是進程概念:

一個正在運行的程序或者軟件就是一個進程,它是操作系統進行資源分配的基本單位,也就是說每啟動一個進程,操作系統都會給其分配一定的運行資源(內存資源)保證進程的運行。

應用集群故障后自動恢復測試之進程自我拉起測試場景:

當服務的進程異常掛掉后,能夠自動將進程拉起,恢復服務,實現高可用;

測試目的:

考察服務進程自我拉起有效性。

測試步驟:

1、測試場景采用混合交易模型交易配比;

2、測試執行時,采取穩定壓力施壓,以被測試系統最大處理能力的80%或預設壓力,穩定運行5分鐘;

3、通過kill -9命令 kill 掉某進程;

4、場景持續運行5分鐘,通過PS -ef|grep 服務名稱,命令觀察被kill 的進程是否自動拉起。

預期結果:

步驟3后,進程被Kill;

步驟4后,進程自我拉起。

監控點:

TPS、交易失敗率、系統資源使用率等。

測試指標:

服務進程自我拉起有效性(除了能夠拉起還有時效要求,為60秒之內)為有效。