讓Stable Diffusion一秒出圖!清華碩士加速神器爆火,已有公司接入

AI圖像生成,已經進入了秒速級別,只要4步推理就能完成繪制,最快更是能在1秒之內完成。

現在,清華大學聯合HuggingFace的研究人員,推出了全新的繪圖模型加速模塊。

作者給出的體驗版當中,點擊生成按鈕后,模型只用了幾秒鐘就繪制出了4張清晰的圖像。

這個加速模塊叫做LCM-LoRA,發布后不久就斬獲了2k+次GitHub星標。

它不僅加速能力強、泛化性能好,適配的模型也很廣泛,SD系和LoRA模型都能用它來加速。

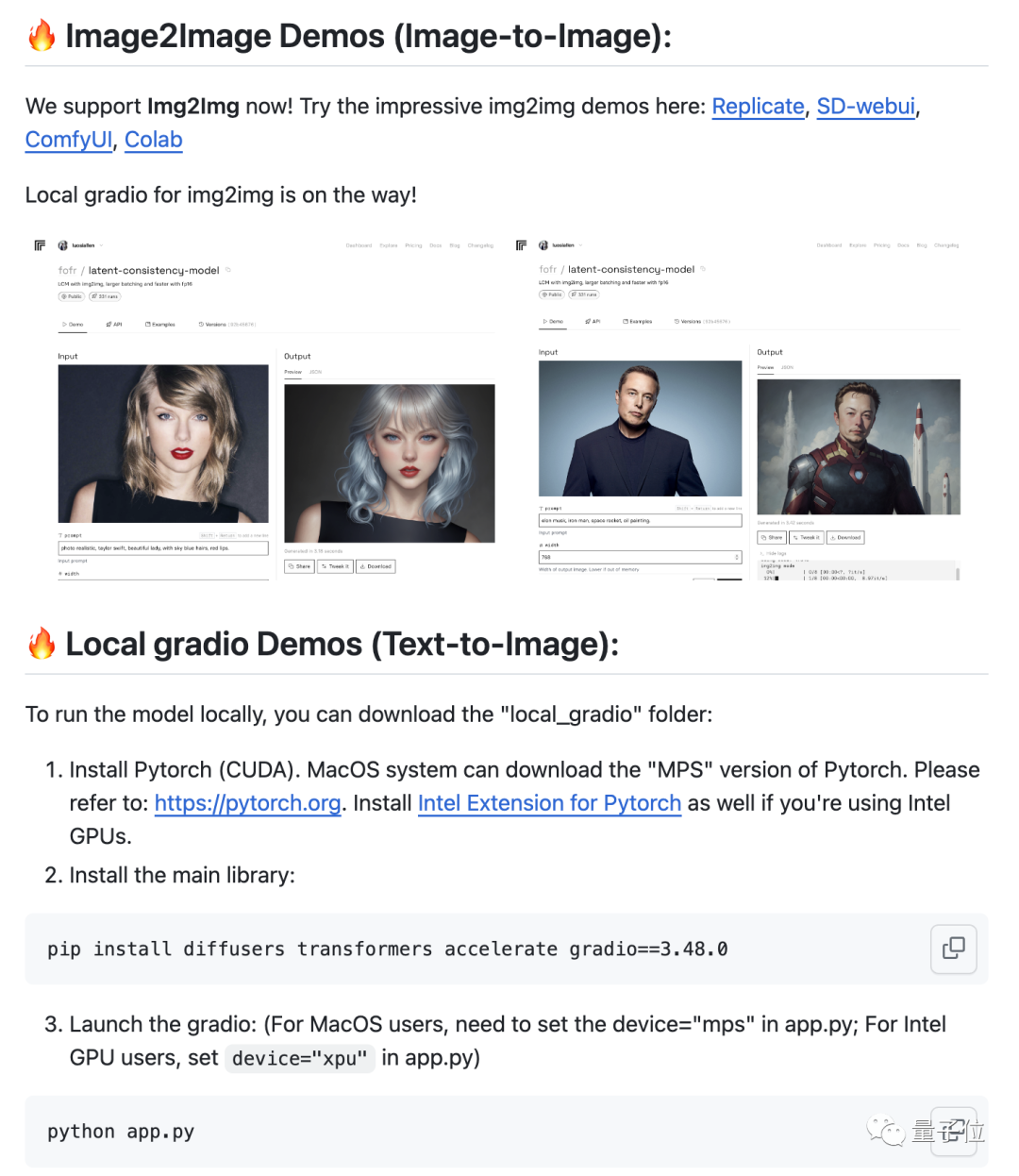

團隊基于LCM-LoRA自行優化的文生圖模型已在HuggingFace上開放體驗,圖生圖模型也推出了CoLab等版本。

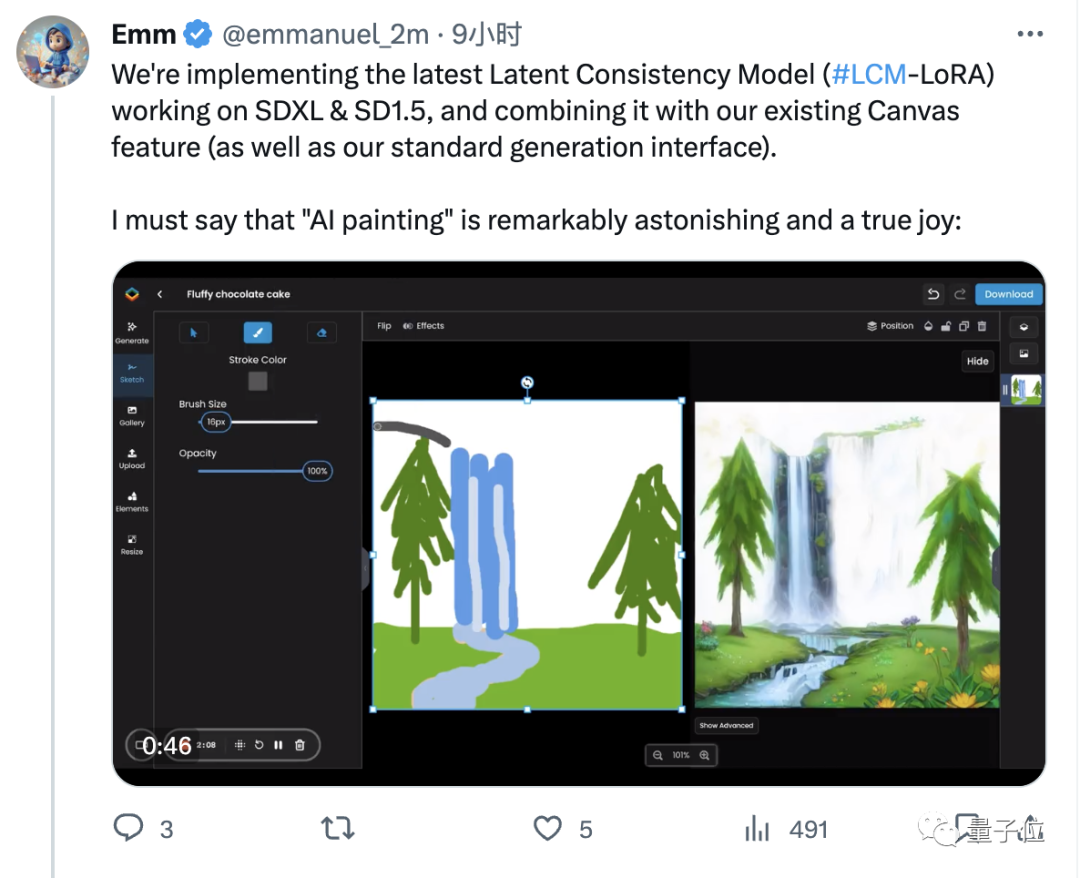

AI繪圖工具迅速接入

LCM-LoRA開源后不久,就有AI繪圖工具廠商Scenario宣布將基于它推出“實時繪圖”功能。

Scenario的CEO還在??上親自展示了即將上線的實時繪圖功能DEMO。

只見一邊在繪制草圖,另一邊AI就把相應的畫作繪制好了,時間上幾乎同步。

調整提示詞和有關參數,模型響應得也是干脆利落。

這些DEMO發布后,引發了眾人的一致贊嘆。

那么,LCM-LoRA這個加速模塊到底有多強,又是怎樣實現的呢?

“跳步”降低內存開銷

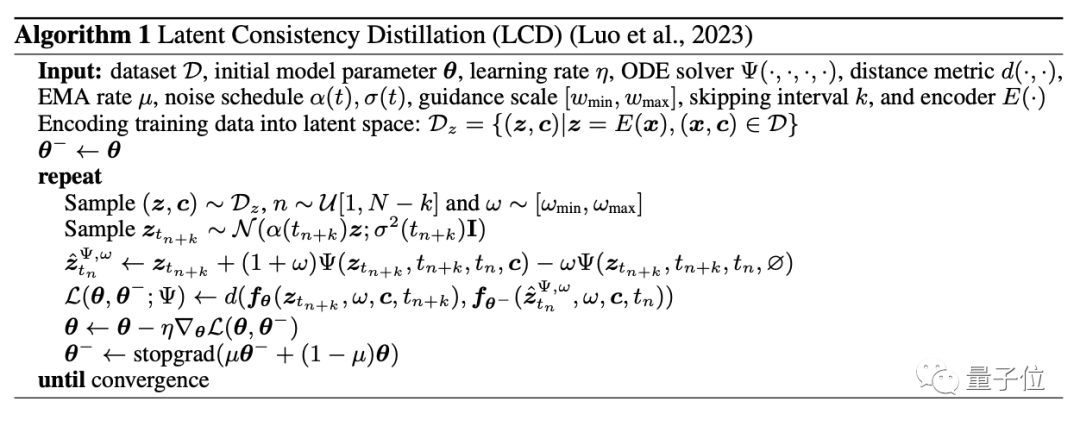

LCM-LoRA將LoRA引入潛在一致性模型(LCM)的蒸餾過程,顯著減少了訓練內存開銷,從而提高性能。

而LCM是從潛擴散模型(LDM)中蒸餾出來的,“蒸餾”的過程也可以看做是對擴散模型的微調。

它的核心思想是在圖像的隱變量空間中學習一致性映射函數,該函數可以直接將擴散過程中的任意點映射到終點,即微分方程的解。

通過這種一致性映射,LCM可以跳過迭代采樣過程,直接進行少步甚至一步采樣,從而極大地加速了圖像的生成。

而隱變量空間操作相比基于像素空間的方法,計算復雜度和內存需求也更低。

結合LoRA后,只需要訓練低秩分解矩陣,可訓練參數量和內存開銷進一步減少,應用范圍也從單純的文生圖擴展到了圖生圖和視頻生成。

最直觀體現的就是我們看到的秒速出圖,而訓練時間上,LCM-LoRA優化后的模型在A100上訓練只需32個GPU時。

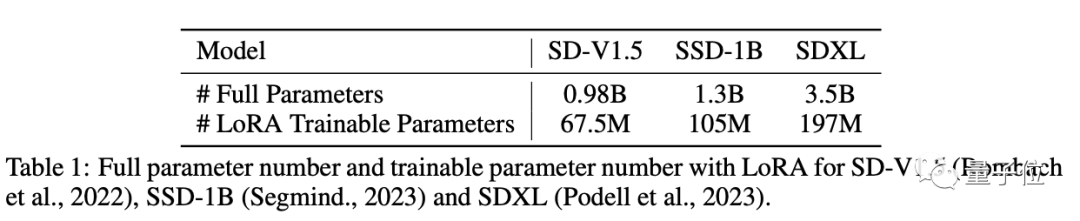

訓練時間縮短的背后,也于訓練參數量大幅減少密切相關:

- SD-V1.5全量參數為980億,使用LoRA后可訓練參數減少到6750萬,約減少了99.9%。

- SSD-1B參數從130億減少到1.05億,約減少了99%。

- SDXL參數從350億減少到1.97億,約減少了99.4%。

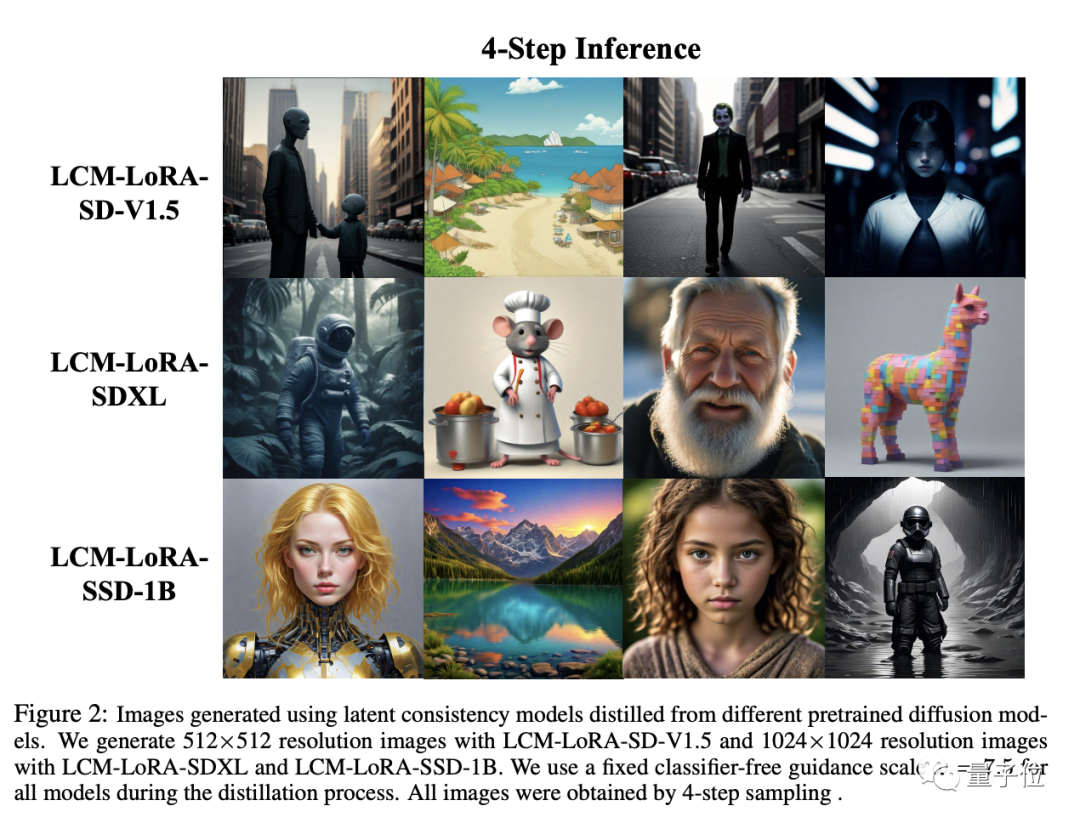

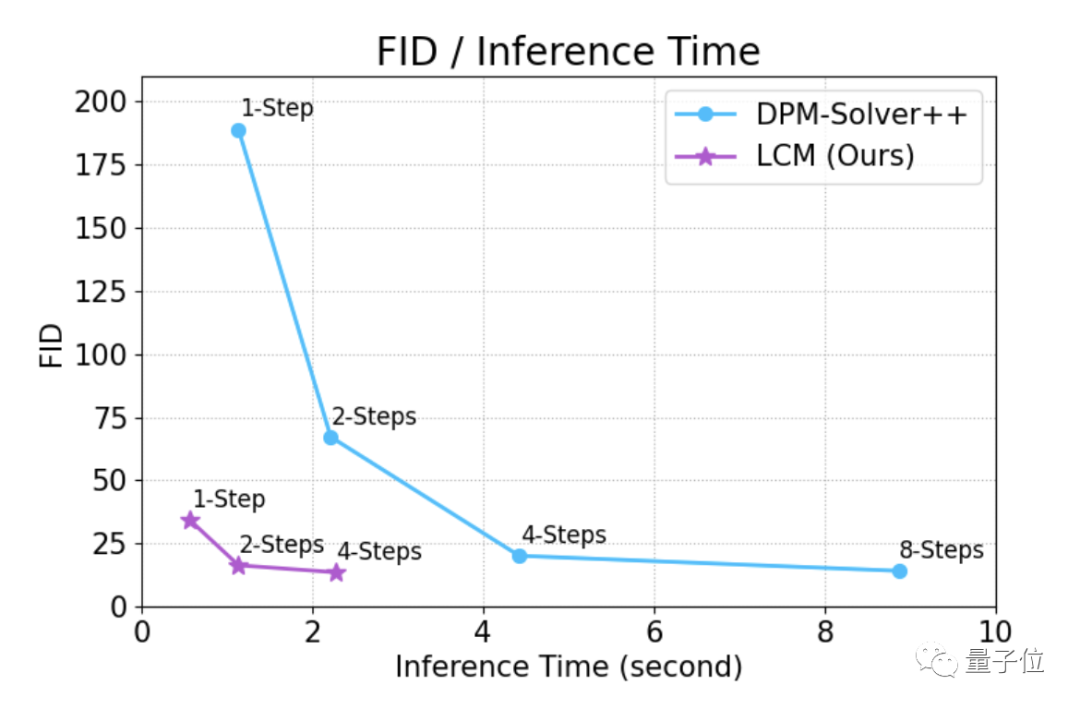

不僅是訓練消耗的降低,推理過程中的步數也大幅減少,一般只需要4步推理就能繪制出質量不錯的圖像。

有時甚至只要一步就能完成,用時還不到1秒,FID分數(越低越好)在50以下。

不僅加速性能優異,LCM-LoRA的適配性也十分廣泛。

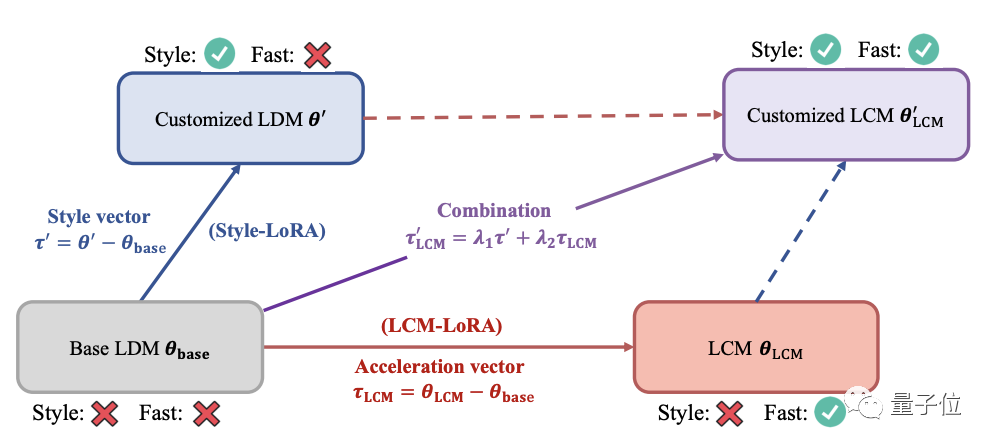

LCM-LoRA訓練得到的LoRA參數又稱為加速向量,可以數據集上微調得到的LoRA參數直接線性組合,不需要額外訓練。

這種組合方式使得LCM-LoRA成為一個可直接插接到各種微調模型中的通用圖像生成加速模塊。

作者簡介

LCM和LCM-LoRA論文的兩位主要作者是來自清華大學交叉信息研究院的研究生駱思勉(Simian Luo)和Yiqin Tan。

清華叉院的黃隆波副教授、李建副教授和趙行助理教授也參與了這兩項研究。

在LCM-LoRA的工作中,來自HuggingFace的研究人員亦有貢獻。

論文地址:

[1]https://arxiv.org/abs/2310.04378

[2]https://arxiv.org/abs/2311.05556