Stable Diffusion又出大招!「文生動(dòng)畫」震撼發(fā)布淘汰導(dǎo)演,DC英雄一秒變身

Stability AI又放大招!

現(xiàn)在,Stable Diffusion也能生成視頻了。AI屆,實(shí)在是太卷了。

昨天,Stability AI發(fā)布了一款專為藝術(shù)家和開發(fā)人員設(shè)計(jì)的工具——Stable Animation SDK。用戶可以通過(guò)多種方式創(chuàng)建令人驚嘆的動(dòng)畫效果。

此前,Runway的Gen-2就相當(dāng)炸裂,宣傳詞非常霸氣——「say it,see it」。

現(xiàn)在,Stability AI也有比肩Gen-2的視頻生成工具了!

Stable Diffusion能做視頻了

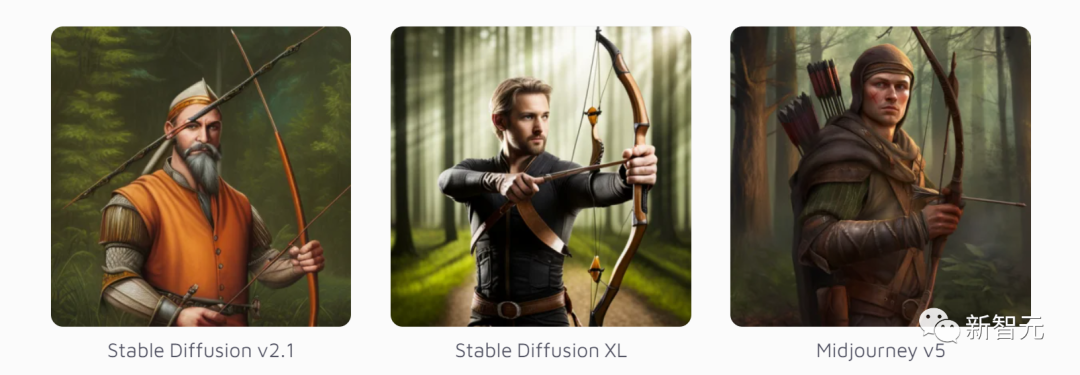

借助Stability AI的動(dòng)畫端點(diǎn),美術(shù)師可以使用所有Stable Difusion模型來(lái)生成動(dòng)畫,包括Stable Diffusion 2.0和Stable Diffusion XL。

不過(guò),有別于之前發(fā)布的開源模型,Stable Animation目前僅能通過(guò)SDK和付費(fèi)API使用。

現(xiàn)在,用這三種方式,都可以創(chuàng)建動(dòng)畫了——

- 經(jīng)典的prompt

就像使用Stable Diffusion、Midjourney或DALL-E 2一樣,用文本生成動(dòng)畫。

輸入prompt,調(diào)整各種參數(shù),就能生成動(dòng)畫。

- prompt+圖像

提供一個(gè)初始圖像,作為動(dòng)畫的基礎(chǔ)。之后,結(jié)合prompt和這個(gè)初始圖像,就能生成最終輸出的動(dòng)畫。

- prompt+視頻

提供一個(gè)初始視頻,作為動(dòng)畫的基礎(chǔ)。同樣,通過(guò)各種參數(shù)的調(diào)整,外加prompt的引導(dǎo),最終得到輸出的動(dòng)畫。

1塊錢,就能生成100幀動(dòng)畫

該軟件似乎仍處于測(cè)試階段。Stability AI并沒有通過(guò)他們的瀏覽器平臺(tái)(如DreamStudio或ClipDrop)提供,而是僅提供軟件開發(fā)套件(SDK)和付費(fèi)API。

當(dāng)然,這并不妨礙第三方通過(guò)服務(wù)提供這種動(dòng)畫模型。

不過(guò),目前想試用這個(gè)功能的話,門檻還比較高,因?yàn)镾DK和API要通過(guò)Python腳本來(lái)調(diào)用。

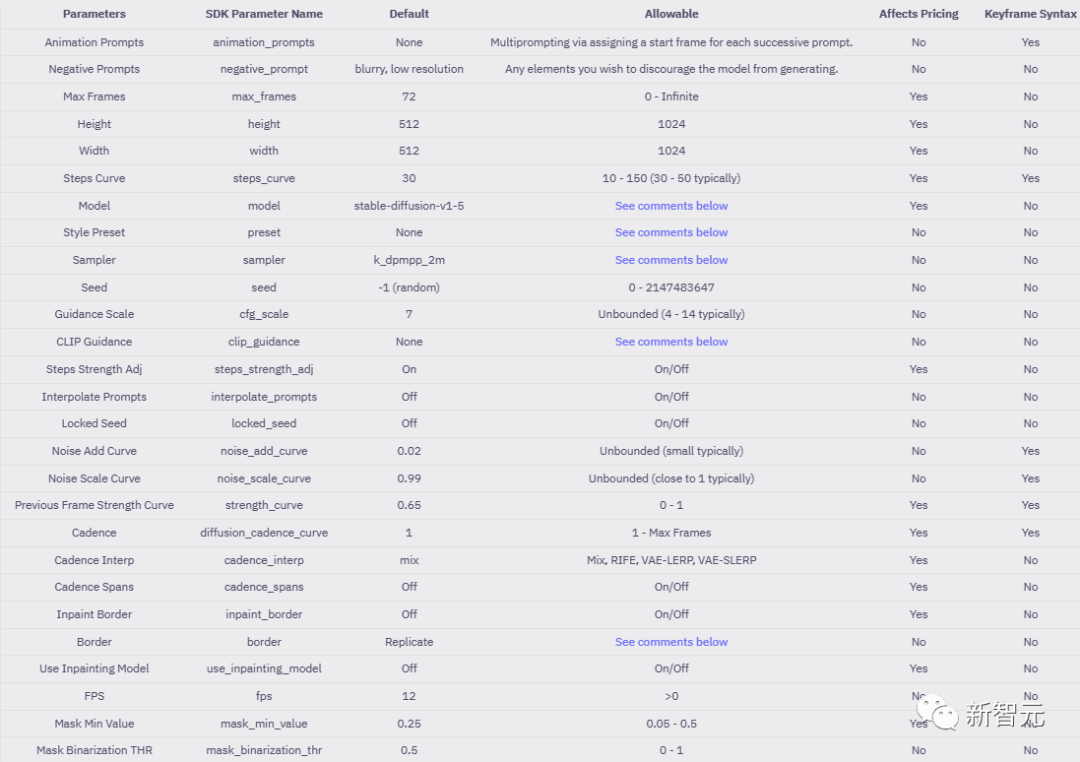

與Stability AI的圖像模型類似,Stable Animation也可以設(shè)置許多參數(shù),例如step、sampler、scale或seed。此外,還提供了諸如outpainting或prompt interpolation等功能。

不同的參數(shù)也會(huì)影響價(jià)格。所以創(chuàng)建一個(gè)視頻要花費(fèi)多少錢,并不確定。

Stability給出的報(bào)價(jià)范圍是,在不同設(shè)置下,每100幀的價(jià)格從3美分到18美分不等。

Stability AI以輸出動(dòng)畫的積分值作為收費(fèi)的依據(jù),用戶生成的動(dòng)畫會(huì)被換算成一個(gè)積分,每1000個(gè)積分消耗1美元。

小編算了一下,根據(jù)官方公布的積分計(jì)算方法,一塊錢人民幣大概能生成一段100幀的1024*1024分辨率的動(dòng)畫。

但是其他的參數(shù)也會(huì)影響價(jià)格,官方給了一個(gè)表來(lái)說(shuō)明支持調(diào)整的參數(shù),以及是否會(huì)影響到生成動(dòng)畫的價(jià)格。

與Stable Diffuision XL兼容

Stable Animation可以與每個(gè)版本的Stable Diffusion結(jié)合使用。

它的默認(rèn)版本是1.5,但我們也可以選擇使用新版的Stable Diffusion XL。

里面有很多樣板,包括動(dòng)漫、漫畫書、低多邊形、像素藝術(shù)。

原始分辨率是512 x 512像素,可以增加到1,024 x 1,024像素。此外,可以使用升頻器。

Stable Animation的默認(rèn)值是72 幀(12幀每秒),但根據(jù)說(shuō)明,它可以增加到無(wú)窮大。

此前,Stability AI就已經(jīng)有了基于Stable Diffusion的動(dòng)畫工具,比如,我們可以通過(guò)prompt interpolation(不斷改變prompt的某些屬性)生成一小段動(dòng)圖。

這次的升級(jí)的不同之處在于,table Animation生成視頻的能力更全面、更成熟。

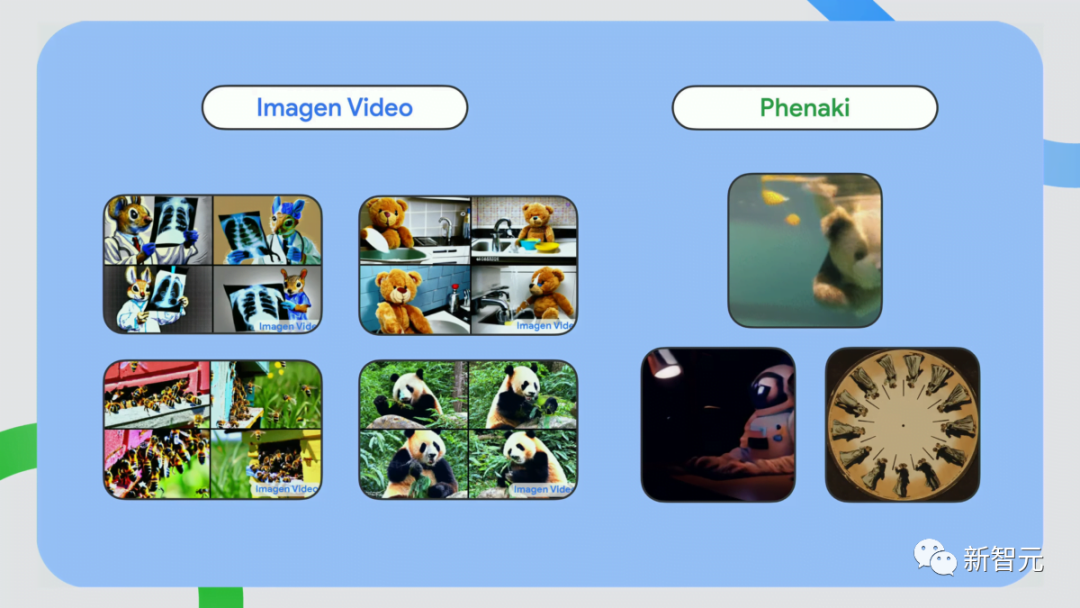

雖然現(xiàn)在,AI還沒進(jìn)化到讓我們按個(gè)按鈕就能生成電影,但Stable Animation、Runway ML、Phenaki、Imagen Video等模型的超強(qiáng)進(jìn)化,已經(jīng)預(yù)示了視覺生成AI的視頻生成功能,會(huì)越來(lái)越驚艷。

網(wǎng)友實(shí)測(cè)

Stable Animation一發(fā)布,網(wǎng)友們就按捺不住自己渴望嘗試的小手。

比如,npaka就分享了自己的使用體驗(yàn)。

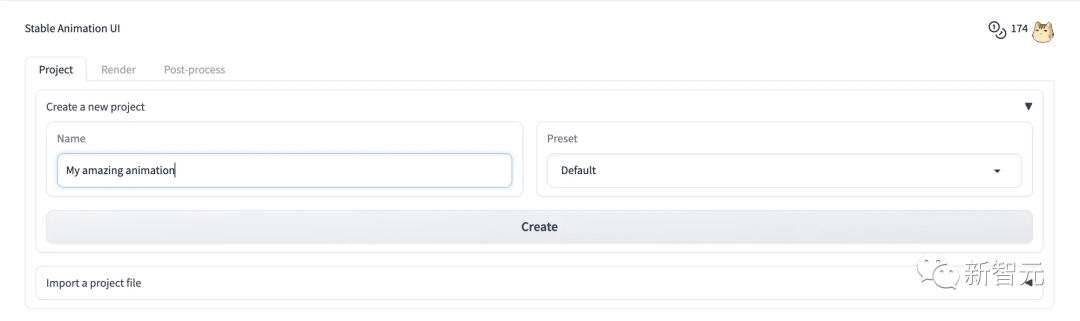

首先,將DreamStudio的API密鑰設(shè)置為本機(jī)的環(huán)境變量。

然后,準(zhǔn)備Python虛擬環(huán)境,并安裝stability_sdk并啟動(dòng)Animation GUI。

$ pip install 'stability_sdk[anim_ui]'

$ python -m stability_sdk animate --guiRunning on local URL: http://127.0.0.1:7860用瀏覽器打開顯示的網(wǎng)址后,就可以在「Project」選項(xiàng)卡中創(chuàng)建項(xiàng)目了。

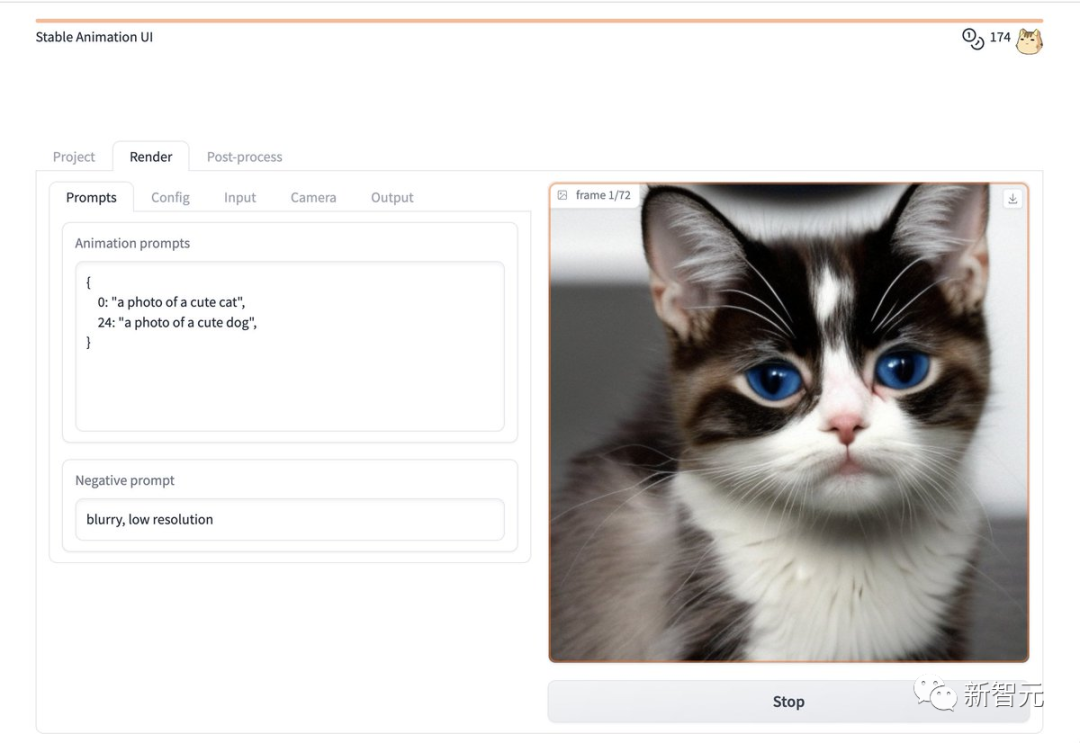

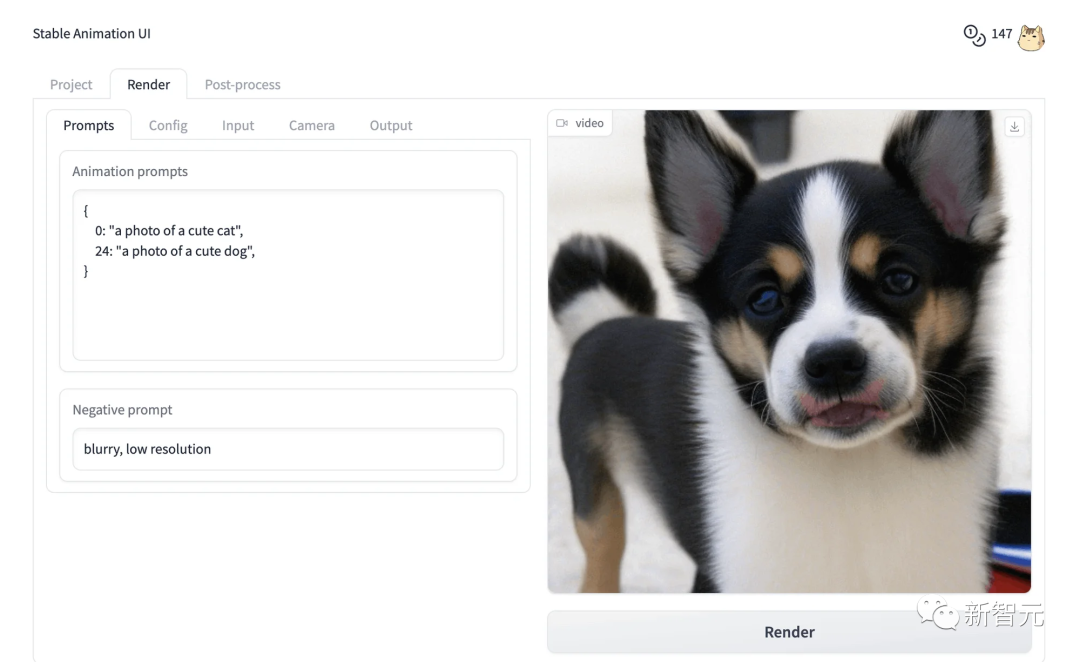

在「Render」選項(xiàng)卡中設(shè)置文本提示,然后按「Render」按鈕。

最后,動(dòng)畫就做好啦。

此外,還有一些網(wǎng)友也分享了自己的作品。

AI離生成電影還有多遠(yuǎn)

AI生成視頻的功能如此強(qiáng)大,已經(jīng)有網(wǎng)友打算投資AI動(dòng)畫工作室了。

這位表示,腦洞已準(zhǔn)備好,就等一個(gè)用戶友好的動(dòng)畫工具了。

網(wǎng)友們的暢想并不遙遠(yuǎn),最近,Wes Anderson的《指環(huán)王》的新預(yù)告片中,就用到了不少AI工具。

,時(shí)長(zhǎng)01:30

OpenAI前AI主管Andrej Karpathy猜測(cè),這部預(yù)告片中至少用到了Midjourney/Stable Diffusion、ControlNet、 ElevenLabs、D-Id、ChatGPT、Adobe等工具。

看來(lái),AI視覺工具再這么進(jìn)化下去,取代好萊塢大導(dǎo)不會(huì)太遠(yuǎn)了。

參考資料:

https://stability.ai/blog/stable-animation-sdk

https://twitter.com/StabilityAI/status/1656691563995512834

https://the-decoder.com/stable-animation-stability-ai-makes-images-move/