Stable Video Diffusion問世!3D合成功能引關注,網友:進步太快

Stable Diffusion官方終于對視頻下手了——

發(fā)布生成式視頻模型Stable Video Diffusion(SVD)。

Stability AI官方博客顯示,全新SVD支持文本到視頻、圖像到視頻生成:

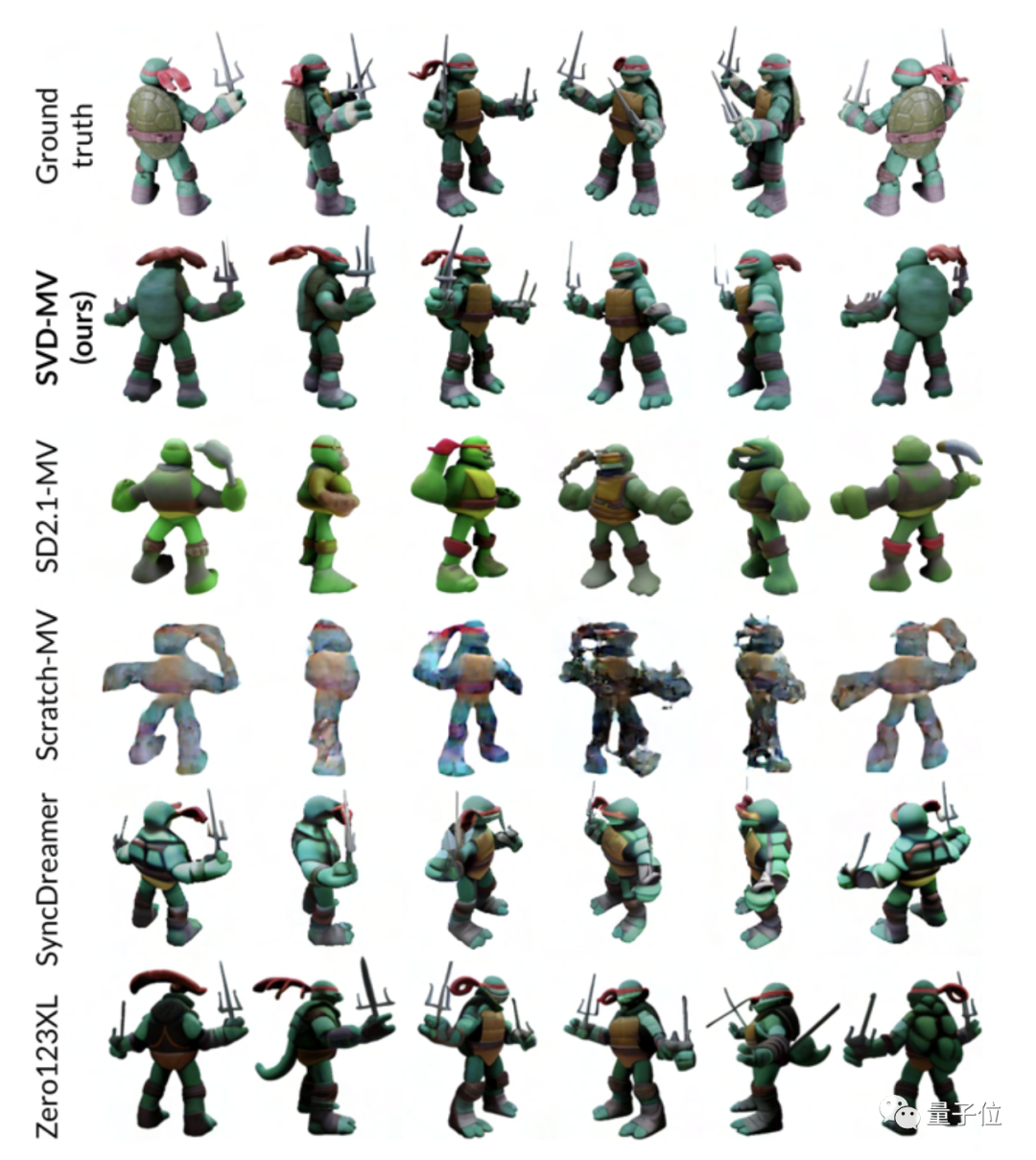

并且還支持物體從單一視角到多視角的轉化,也就是3D合成:

根據外部評估,官方宣稱SVD甚至比runway和Pika的視頻生成AI更受用戶歡迎。

雖然目前只發(fā)布了基礎模型,但官方透露“正計劃繼續(xù)擴展,建立類似于Stable Diffusion的生態(tài)系統”。

目前論文代碼權重已上線。

最近視頻生成領域不斷出現新玩法,這次輪到Stable Diffusion下場,以至于網友們的第一反應就是“快”,進步太快!

但僅從Demo效果來說,更多網友們表示并沒有感到很驚喜。

雖然我喜歡SD,而且這些Demo也很棒……但也存在一些缺陷,光影不對、而且整體不連貫(視頻幀與幀之間閃爍)。

總歸來說這是個開始,網友對SVD的3D合成功能還滿是看好:

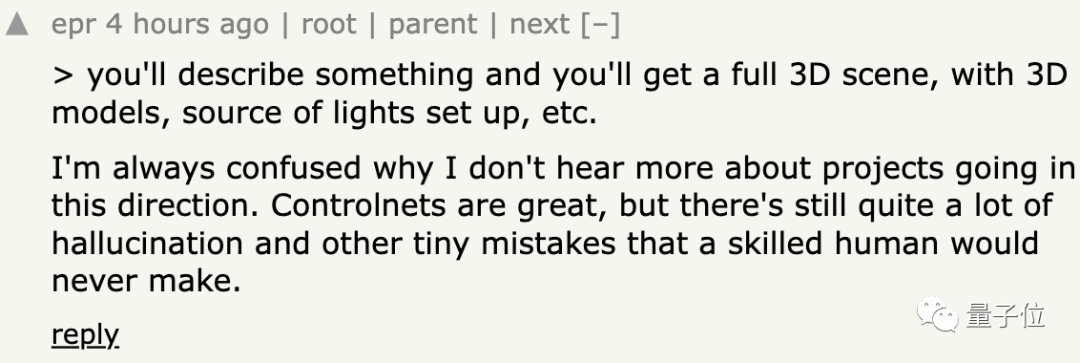

我敢打賭,很快就會有更好的東西出來,到時候只要描述一下,就會得到一個完整的3D場景。

SD視頻官方版來襲

除了上面展示的,官方還發(fā)布了更多Demo,先來看一波:

太空漫步也安排上:

背景不動,只讓兩只鳥動也可以:

SVD的研究論文目前也已發(fā)布,據介紹SVD基于Stable Diffusion 2.1,用約6億個樣本的視頻數據集預訓練了基礎模型。

可輕松適應各種下游任務,包括通過對多視圖數據集進行微調從單個圖像進行多視圖合成。

微調后,官方公布的是兩種圖像到視頻模型,可以以每秒3到30幀之間的自定義幀速率生成14(SVD)和25幀(SVD-XT)的視頻:

之后又微調了多視角視頻生成模型,叫做SVD-MV:

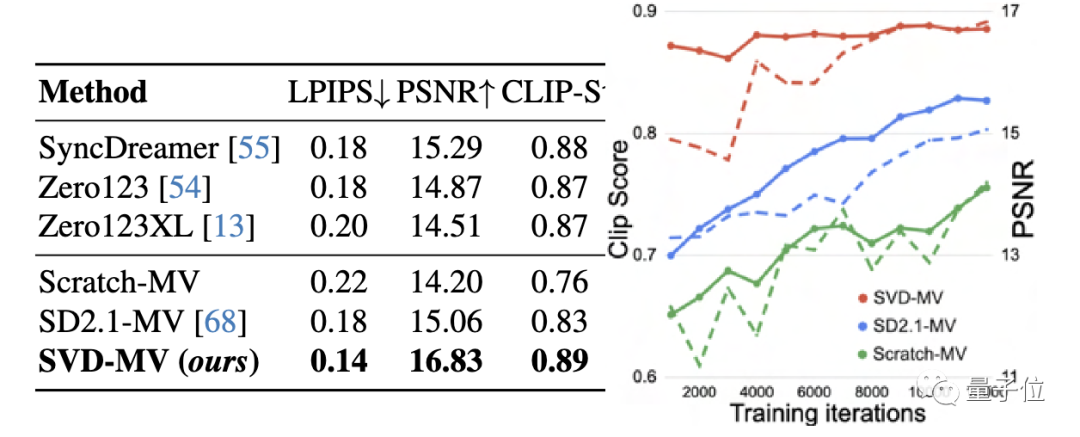

根據測試結果,在GSO數據集上,SVD-MV得分優(yōu)于多視角生成模型Zero123、Zero123XL、SyncDreamer:

值得一提的是,Stability AI表示SVD目前僅限于研究,不適用于實際或商業(yè)應用。SVD目前也不是所有人都可以使用,但已開放用戶候補名單注冊。

視頻生成大爆發(fā)

最近視頻生成領域呈現出一種“混戰(zhàn)”的局面。

前有PikaLabs開發(fā)的文生視頻AI:

后又有號稱“史上最強大的視頻生成AIMoonvalley推出:

最近Gen-2的“運動筆刷”功能也正式上線,指哪畫哪:

這不現在SVD又出現了,又有要卷3D視頻生成的可能。

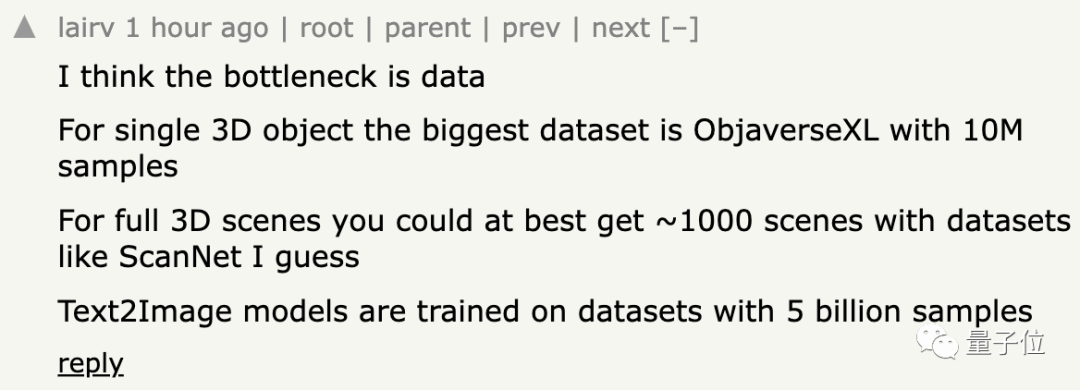

但文本到3D生成方面好像還沒有太多進展,網友對這一現象也很是困惑。

有人認為數據是阻礙發(fā)展的瓶頸:

還有網友表示原因在于強化學習還不夠強:

家人們對這方面的最新進展有了解嗎?歡迎評論區(qū)分享~

論文鏈接:https://static1.squarespace.com/static/6213c340453c3f502425776e/t/655ce779b9d47d342a93c890/1700587395994/stable_video_diffusion.pdf