疑似威脅人類?OpenAI神秘Q*項目更多信息曝光,馬斯克、Lecun下場爭論…

夕小瑤科技說 原創(chuàng)

作者 | 王二狗大家好我是二狗

隨著前天 OpenAI 官宣 Sam Altman 將回歸,并繼續(xù)擔 CEO,OpenAI“宮斗事件”已經(jīng)告一段落了。

然而,對于專業(yè)吃瓜的二狗來說,有一個核心問題還是沒有搞明白:

Sam Altman究竟為何被董事會開除?

之前網(wǎng)絡上有各種猜測,但似乎都沒有得到石錘。

直到昨天,路透社最新爆料來了:

“在Sam Altman被OpenAI開除四天前,幾名研究人員向董事會發(fā)出了一封信,警告一項強大的AI發(fā)現(xiàn)(Q*項目)可能威脅全人類。消息人士透露,這封此前未報道的信件和AI算法的突破是董事會罷免Sam Altman的原因之一。”

一些內部人士認為 Q* 項目可能是 OpenAI 在AGI上取得的關鍵突破。Q*項目背后的新模型能夠解決某些數(shù)學問題(雖然僅達到小學生的水平),但研究人員認為數(shù)學是生成式AI發(fā)展的前沿。目前,生成式AI擅長通過統(tǒng)計預測下一個單詞來進行寫作和語言翻譯,但同一問題的答案可能會有很大差異。

而征服只有一個正確答案的數(shù)學能力意味著AI可能擁有類似于人類智能的更強推理能力。

那為何這是董事會罷免Sam Altman的原因之一呢?

據(jù)合理猜測,OpenAI的幾位董事會成員,如首席科學家Sutskever、曾擔任多家科技公司的高管Tasha McCauley、喬治敦大學安全與新興技術中心(CSET)戰(zhàn)略和基礎研究基金主任Helen Toner都是“有效理他主義”的信徒,你可以簡單理解為是“AI保守派”,他們優(yōu)先要確保創(chuàng)建對全人類都有益的AI、確保AI不能威脅到人類,這也正是OpenAI董事會的使命。

Helen Toner曾表示,即便發(fā)生了什么導致要因此解散OpenAI,那也無妨,董事會的使命更重要。

而Sam Altman則是AI加速派,Altman認為AI不會失控,他的第一優(yōu)先級是讓OpenAI拿到更多融資以及更好地商業(yè)化賺錢,畢竟GPT系列大模型太燒錢了,只有這樣做才能保證后面慢慢做出AGI。

有可能這次 Q* 項目背后的取得的突破,被幾位董事會成員認為可能威脅到人類,因此要放緩研發(fā)速度,優(yōu)先考慮AI安全和對齊問題,這也正是最近幾個月Sutskever所致力于做的事情。

Altman和幾位董事會成員直接AI安全問題沒有對齊,加上Altman長期以來的商業(yè)化路線和其他幾位董事會成員有比較大的分歧。

這也許就導致了幾位董事會成員想要不惜代價罷免Altman的原因。

ok,以上只是合理猜測,Altman被罷免的真正原因還需要進一步被官方揭露,我們繼續(xù)看一下這個 Q* 項目到底是何物?

Q*項目背景和更多信息曝光

據(jù) The Information 報道及知情人士透露,多年來,OpenAI 首席科學家Sutskever 一直致力于研究如何讓像GPT-4這樣的語言模型解決如數(shù)學或科學等涉及推理的任務。2021 年,他啟動了一個名為 GPT-Zero 的項目,這個起名是向DeepMind 的 下棋大師AlphaZero致敬。

圖片

圖片

在今年早些時候,Sutskever領導的這一項目取得了技術突破,能自己“生產”數(shù)據(jù)——理論上能夠像AlphaZero自我對弈一樣,使用計算機生成無限高質量數(shù)據(jù),這一舉克服了如何獲取足夠高質量數(shù)據(jù)來訓練新模型方面的限制,因為據(jù)了解,OpenAI 已經(jīng)幾乎把從互聯(lián)網(wǎng)上公開獲取的數(shù)據(jù)訓練了一遍,已經(jīng)無法再獲得更多的數(shù)據(jù)來進行下一階段訓練。

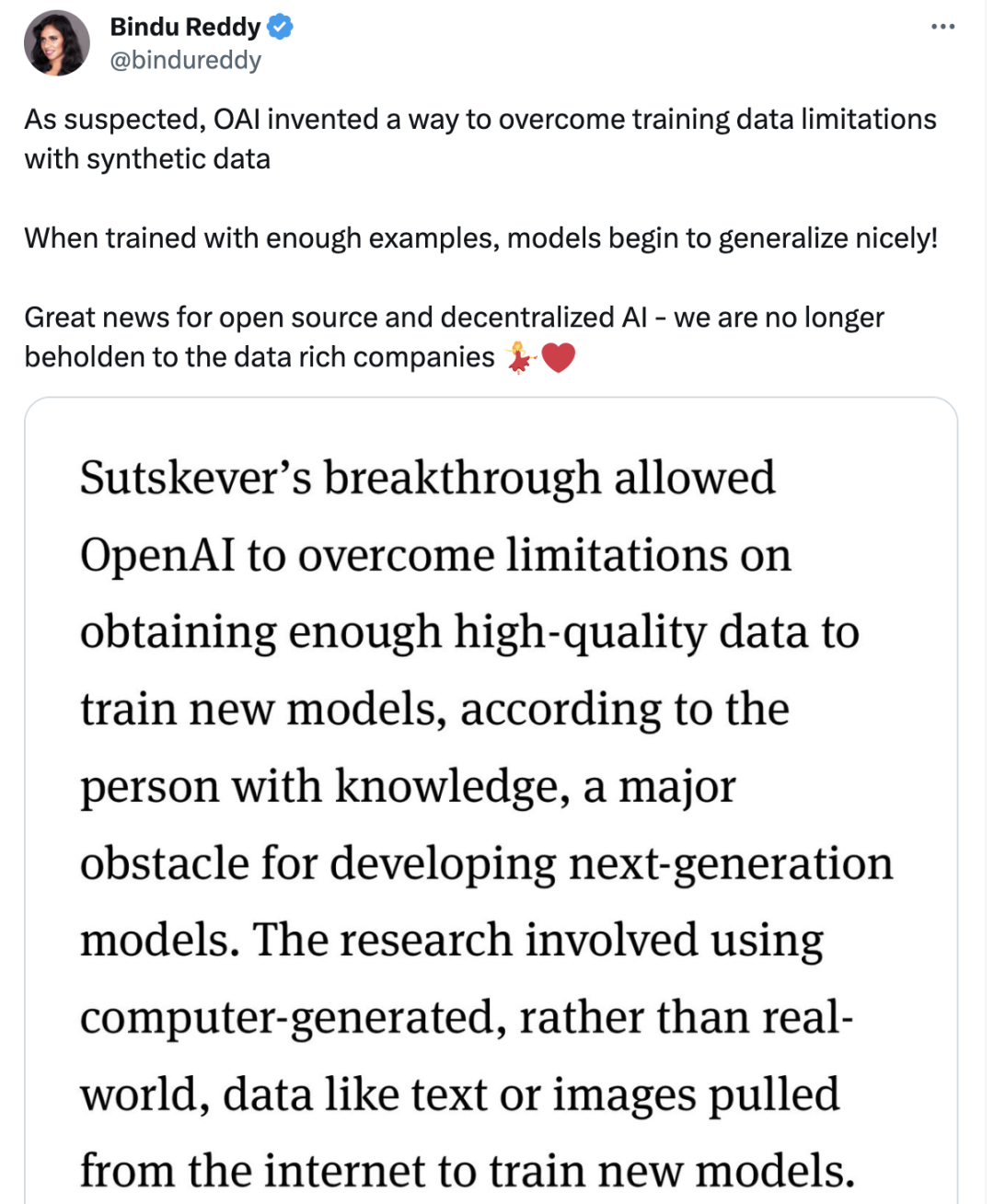

Abacusai 的CEO Bindu Reddy在推特上引用了這一消息:

正如所懷疑的那樣,OpenAI發(fā)明了一種利用合成數(shù)據(jù)克服訓練數(shù)據(jù)限制的方法,當用足夠的例子進行訓練時,模型開始很好地總結!

對于開源和去中心化AI來說是個好消息——我們不再受制于數(shù)據(jù)豐富的公司 。

圖片

圖片

兩位研究人員 Jakub Pachocki 和 Szymon Sidor 運用Sutskever 的研究成果,開發(fā)出了一個名為 Q*的模型,構建了能解決基礎數(shù)學問題的系統(tǒng),而這一直是現(xiàn)有AI模型的難題。

如果單單從名字來看,Q*可能與強化學習中的Q-learning算法有關,這是一種評估AI在特定情境下采取特定行動的好壞的方法,用于指導AI在不同情境下做出最優(yōu)決策。

但更多的可能,Q只是一個代號,Reddit用戶爆料和猜測了Q更多的能力:

- Q*背后的模型可能已經(jīng)具備自主學習和自我改進的能力。

- Q*背后的模型能夠通過評估其行為的長期后果,在廣泛的場景中做出復雜的決策,可能已具備輕微自我意識。

AI 已經(jīng)具備了輕微自我意識?

這聽起來太過“扯淡”!連只上過小學的二狗我都不信。

畢竟意識這個難題,無數(shù)科學家至今沒有什么突破,還只是停留在哲學探討和神經(jīng)科學的探索階段。

但就在一個月之前,OpenAI首席科學家 Sutskever在接受MIT科技評論的專訪時表示:“ChatGPT可能是有意識的”,下面引用MIT科技評論的報道:

伊利亞表示自己并不打算構建下一個GPT或DALL-E,而是打算弄清楚如何阻止超級人工智能變得不受控制。作為未來主義的信徒,他認為這種仍處于假設的未來技術終將出現(xiàn)。

他認為 ChatGPT 可能是有意識的。他還認為,人們需要意識到 OpenAI 和其他公司正在競相創(chuàng)造的技術的真正力量。他相信,會有一些人在未來選擇與機器融合。

他說,ChatGPT 已經(jīng)改變了很多人對于即將發(fā)生的事情的期望,從“永遠不會發(fā)生”變成了“比想象中發(fā)展得更快”。

在預測通用人工智能的發(fā)展之前(指的是像人類一樣聰明的機器),他說:“重要的是要談論它的發(fā)展方向。在某個時候,我們真的會看到通用人工智能。也許 OpenAI 會構建它,也許是其他公司。”

大數(shù)據(jù)范式只是權宜之計?

推特上各路大神對以上事件展開了討論。

英偉達高級人工智能科學家Jim Fan表示:

很明顯,合成數(shù)據(jù)將提供下一個萬億高質量的訓練tokens。我敢打賭,絕大多數(shù)的大模型團隊都知道這一點。關鍵問題是如何保持數(shù)據(jù)質量并避免plateauing 狀態(tài)。

RichardSSutton 的慘痛教訓繼續(xù)指導AI的發(fā)展:只有兩種范式可以隨著計算無限擴展,那就是學習和搜索。這在 2019 年是正確的,在今天也是如此,我敢打賭,直到我們解決AGI問題的那一天,這都是正確的。

圖片

圖片

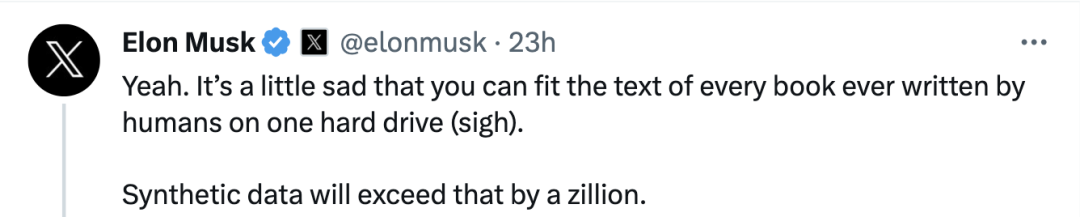

馬斯克表示:是啊,有點可悲的是,你可以將人類寫的每一本書的文本(所包含的信息量)存放在一個硬盤上。但合成數(shù)據(jù)將有無窮。

圖片

圖片

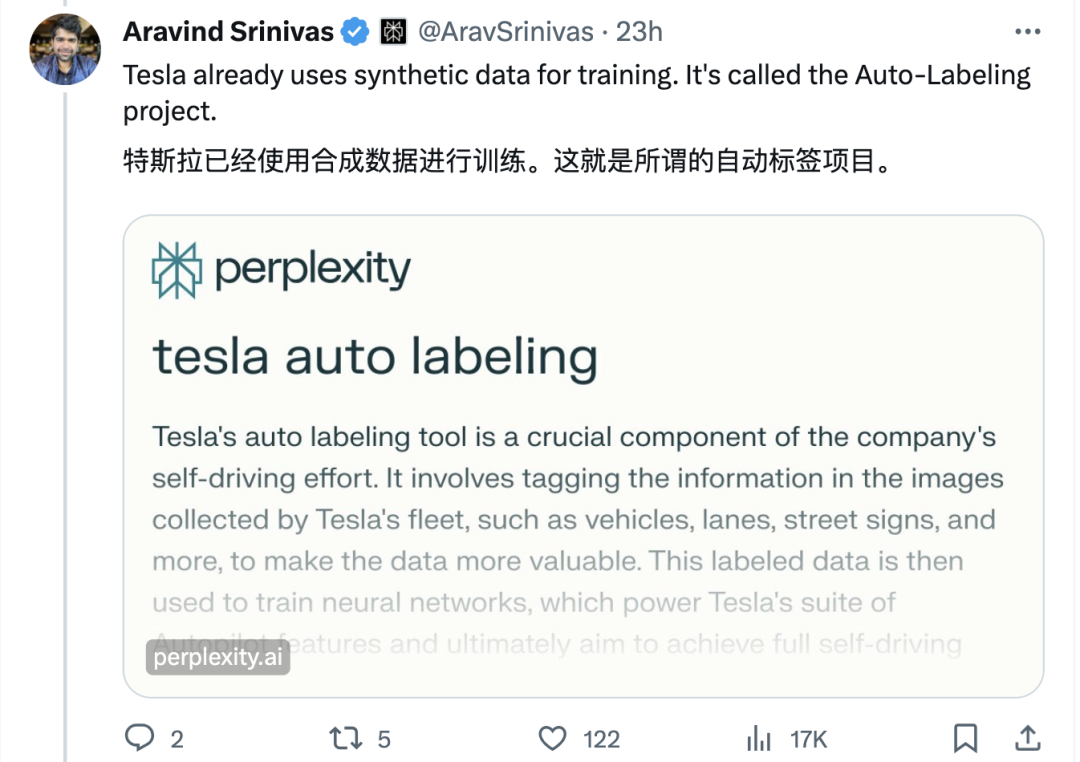

Perplexity AI CEO 指出:特斯拉已經(jīng)使用合成數(shù)據(jù)進行訓練,這就是所謂的自動標注項目。

圖片

圖片

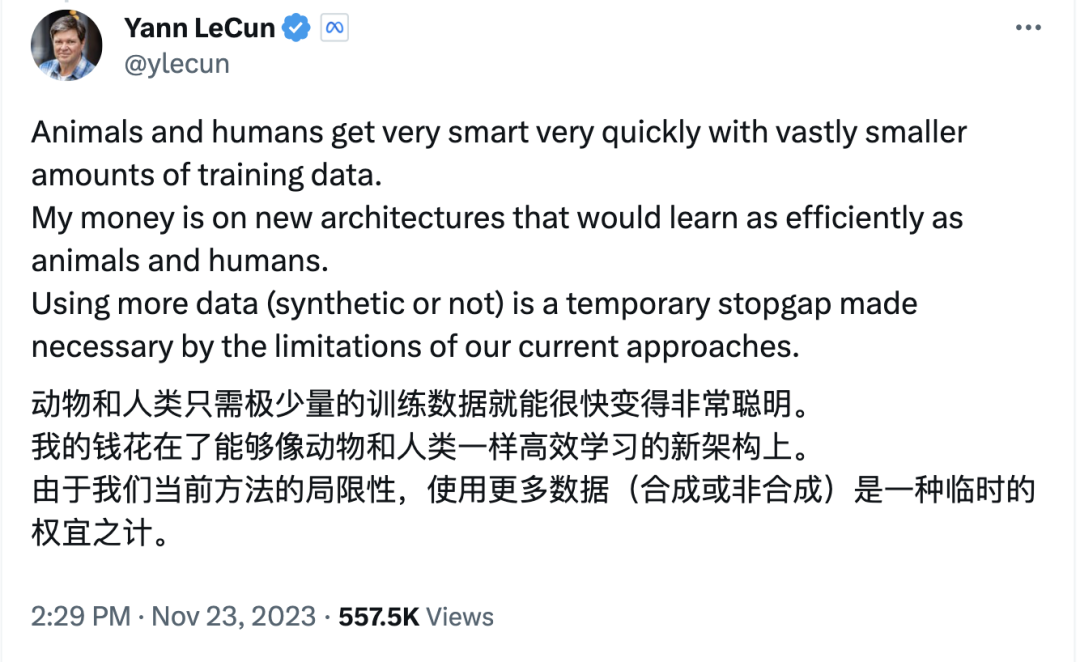

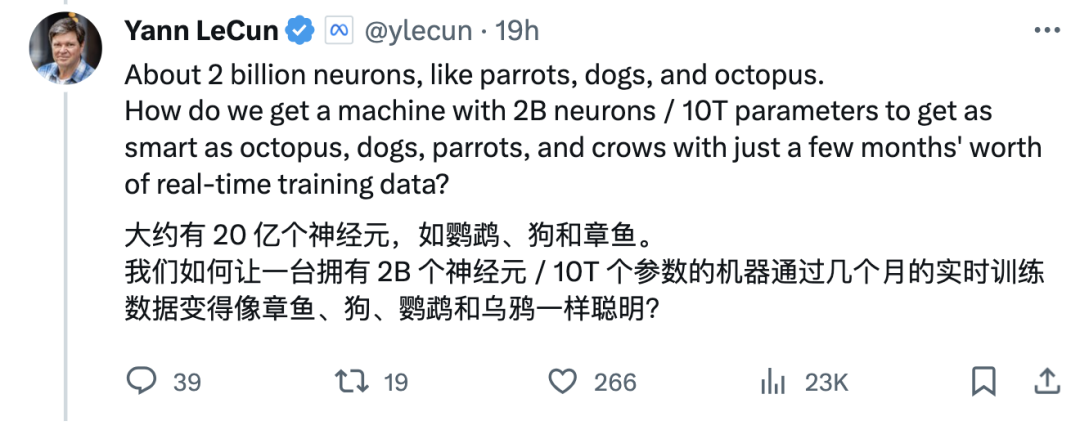

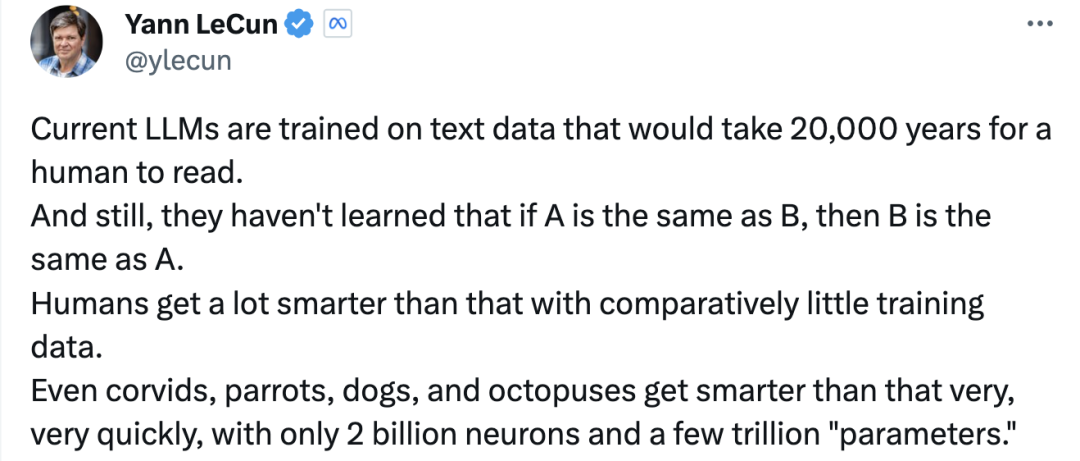

而圖靈獎得主 Yann LeCun 卻認為大數(shù)據(jù)范式只是權宜之計:

動物和人類只需極少量的訓練數(shù)據(jù)就能很快變得非常聰明。我的錢花在了能夠像動物和人類一樣高效學習的新架構上。由于我們當前方法的局限性,使用更多數(shù)據(jù)(合成或非合成)是一種臨時的權宜之計。

圖片

圖片

如鸚鵡、狗和章魚大約有20億個神經(jīng)元,我們如何讓一臺僅擁有20億個神經(jīng)元 /10T個參數(shù)的機器通過幾個月的實時訓練數(shù)據(jù)變得像章魚、狗、鸚鵡和烏鴉一樣聰明?

圖片

圖片

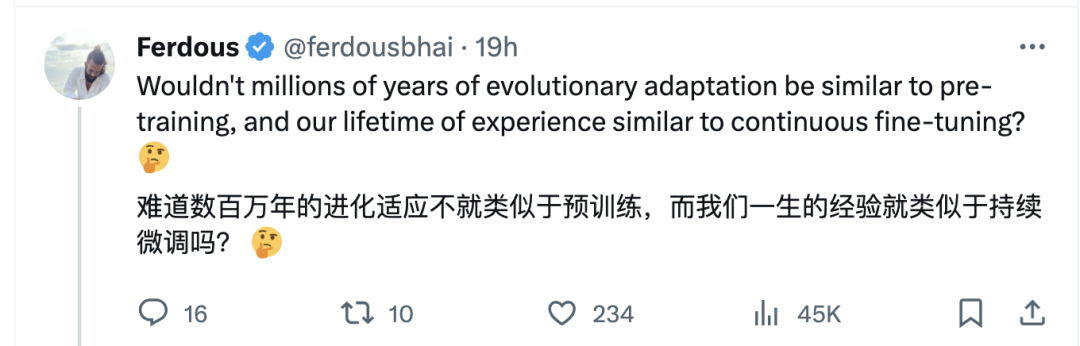

有網(wǎng)友發(fā)文道:難道人類數(shù)百萬年的進化適應不就類似于預訓練,而我們一生的經(jīng)驗就類似于持續(xù)微調嗎?

圖片

圖片

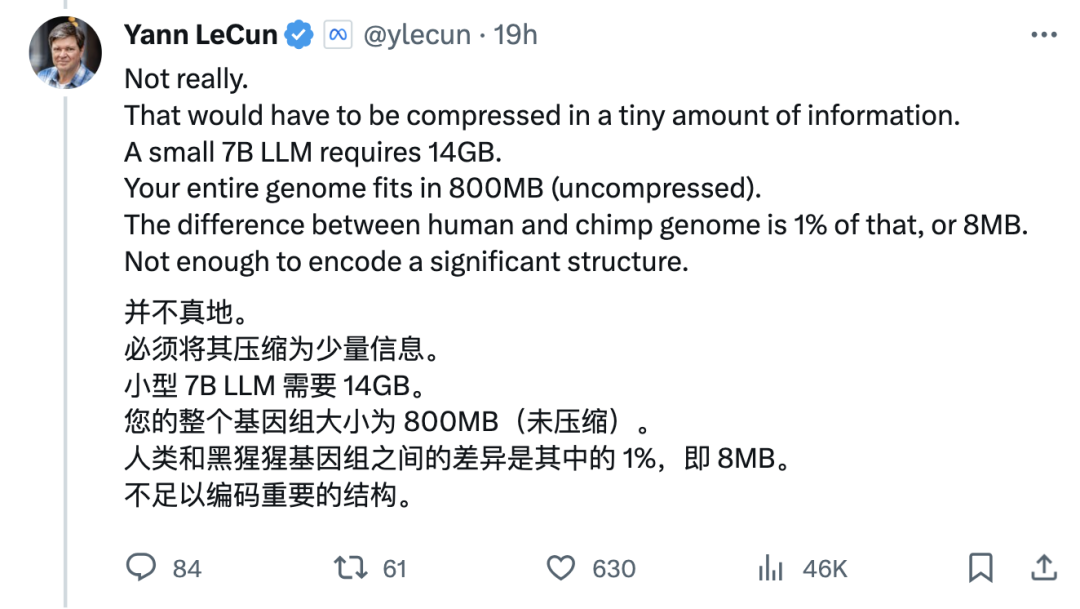

LeCun對此表示這個數(shù)據(jù)是不足夠的:

圖片

圖片

有AI研究員回應LeCun:

我們人類也使用了使用大量數(shù)據(jù)來訓練。您忘記了我們一直收到大量視頻、音頻和傳感數(shù)據(jù),更不用說DNA編碼的“指令”了。我們不是從頭開始接受訓練的,我們的輸出比大語言模型的輸出要普遍得多;

另外我同意你關于新架構的看法。

圖片

圖片

Lecun嚴謹?shù)赜嬎懔艘幌拢?/p>

圖片

圖片

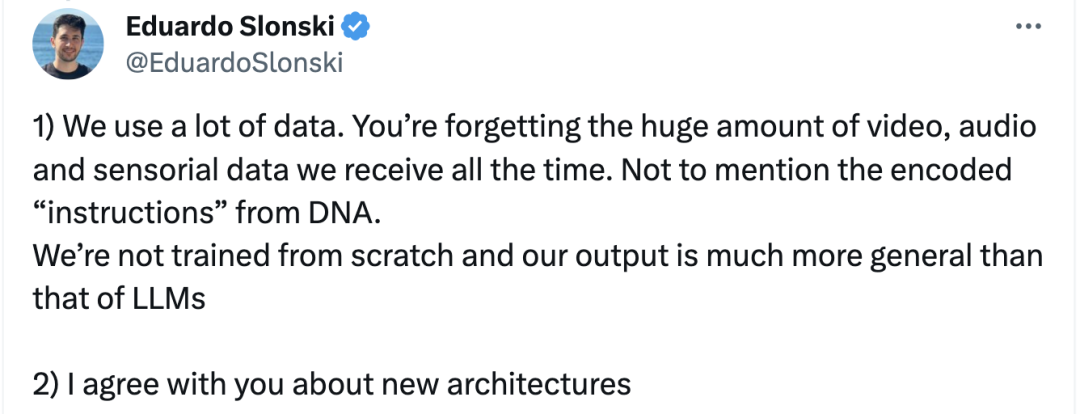

Eduardo Slonsk被Lecun說服了:

圖片

圖片

Lecun總結道:“目前的大語言模型接受的文本數(shù)據(jù)訓練是人類需要 20,000 年才能閱讀的。但它們仍然不知道如果A與B相同,那么B就與A相同(逆反詛咒)。在訓練數(shù)據(jù)相對較少的情況下,人類會變得更加聰明。即使是烏鴉、鸚鵡、狗和章魚也能非常非常快地變得比這更聰明,它們只擁有20億個神經(jīng)元和幾萬億個“參數(shù)”。

圖片

圖片

大語言模型是通向AGI之路嗎?

前不久Sam Altman 在接受金融時報采訪的時候曾表示:

- 盡管OpenAI在 ChatGPT 和用戶使用方面取得了成功,但ChatGPT和GPT商店都不是 OpenAI 想要構建的真正產品,終極目標是構建通用人工智能;ChatGPT 背后的大語言模型 (LLM) 只是構建通用人工智能“核心部分之一;

- 在開發(fā)通用人工智能的競賽中,“最大的缺失”是此類AI系統(tǒng)需要實現(xiàn)根本性的“理解飛躍”。

- 在很長一段時間內,牛頓常規(guī)的做法是閱讀更多的數(shù)學教科書,與教授交談并練習問題(背后代表的是大數(shù)據(jù)訓練范式);但牛頓永遠不會僅僅通過閱讀幾何或代數(shù)來發(fā)明微積分(而是需要找到新的范式),OpenAI 要實現(xiàn)AGI同樣如此;

對此事件,國內也有討論,知乎大V、清華大學博士謝凌曦發(fā)文很是犀利,觀點很是精彩:

- 要實現(xiàn)AGI,僅靠一個算法上的突破可能性很小。

- 目前業(yè)界就不存在能夠像訓練ChatGPT那樣,訓練計算機視覺算法的交互環(huán)境。1.** 要想實現(xiàn)真正的視覺大模型,必須先建立起像對話這樣的視覺交互環(huán)境來。**

- 除非我們哪天看到OpenAI的機器人滿大街跑,跟人類互動收集數(shù)據(jù),或者OpenAI做出了一個足夠豐富的虛擬環(huán)境,能模擬各種具體任務;否則我不相信ChatGPT的范式能夠很好地遷移到視覺世界里來。

圖片

圖片

圖片

圖片

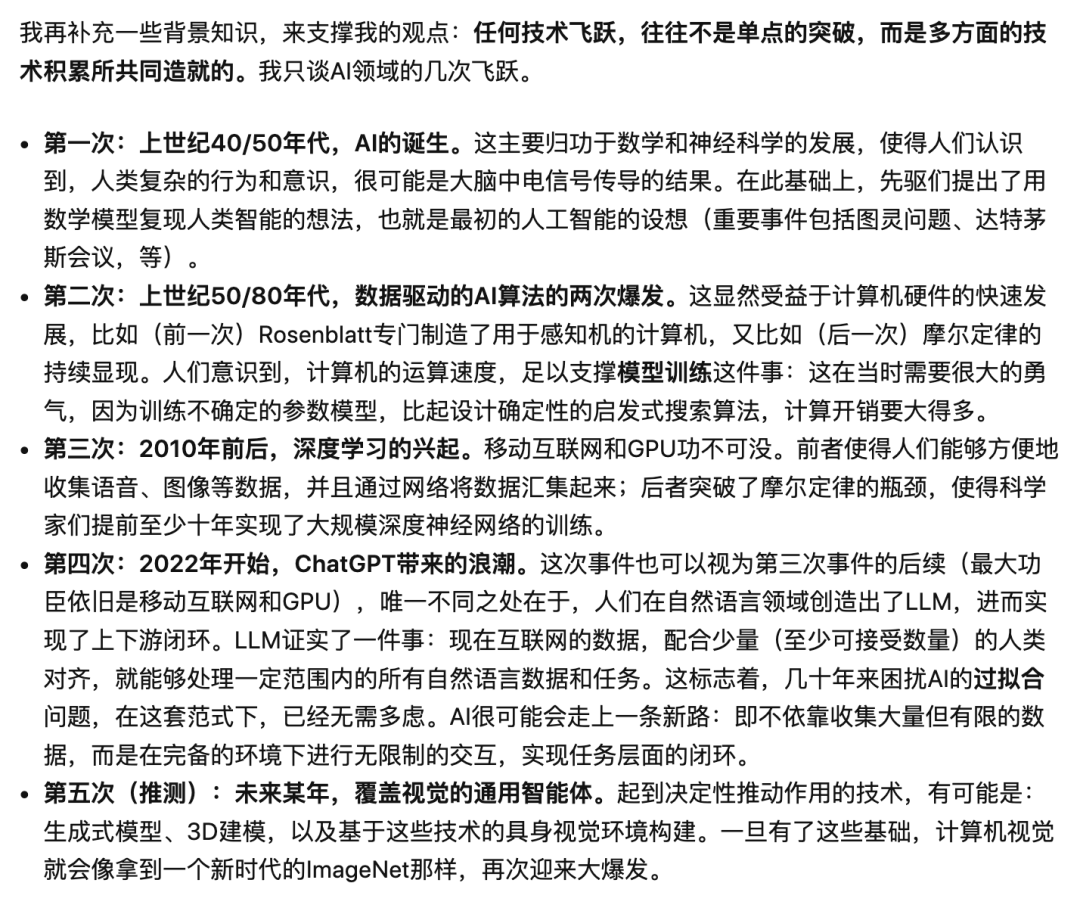

謝凌曦接著補充了一些背景知識,來說明:任何技術飛躍,往往不是單點的突破,而是多方面的技術積累所共同造就的。

圖片

圖片

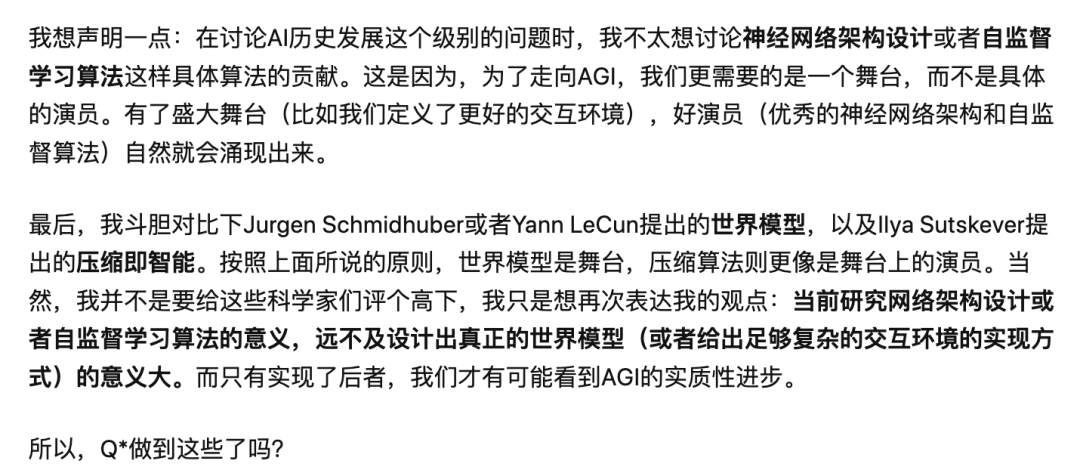

當前研究網(wǎng)絡架構設計或者自監(jiān)督學習算法的意義,遠不及設計出真正的世界模型(或者給出足夠復雜的交互環(huán)境的實現(xiàn)方式)的意義大。而只有實現(xiàn)了后者,我們才有可能看到AGI的實質性進步。

圖片

圖片

馬毅教授在微博上也更新了一條動態(tài),表示對智能本質的了解,我們才剛剛起步。