LCM:大大加快生成高質(zhì)量圖像的新方法

譯文作者丨Mike Young

譯者 | 布加迪

審校 | 重樓

出品 | 51CTO技術(shù)棧(微信號(hào):blog51cto)

圖片

圖片

得益于一種名為潛在一致性模型(LCM)的新技術(shù),文本轉(zhuǎn)換成圖像的AI即將迎來(lái)重大飛躍。潛在擴(kuò)散模型(LDM)等傳統(tǒng)方法在使用文本提示生成詳細(xì)、創(chuàng)造性的圖像方面令人印象深刻,然而它們的致命弱點(diǎn)是速度慢。使用LDM生成單單一個(gè)圖像可能需要數(shù)百個(gè)步驟,這對(duì)于許多實(shí)際應(yīng)用來(lái)說(shuō)實(shí)在太慢了。

LCM通過(guò)大幅減少生成圖像所需的步驟數(shù)量來(lái)改變游戲規(guī)則。LDM需要數(shù)百步才能費(fèi)勁地生成圖像,LCM只需1到4步就能獲得質(zhì)量相似的結(jié)果。這種效率是通過(guò)將預(yù)訓(xùn)練的LDM提煉成更精簡(jiǎn)的形式來(lái)實(shí)現(xiàn)的,所需的算力和時(shí)間大大減少。我們將剖析一篇介紹LDM模型的近期論文,看看它是如何工作的。

本文還介紹了一種名為L(zhǎng)CM-LoRA的創(chuàng)新,這是一種通用的Stable-Diffusion加速模塊。該模塊可以插入到各種Stable--Diffusion微調(diào)模型,無(wú)需任何額外的訓(xùn)練。它是一種普遍適用的工具,可以加速各種圖像生成任務(wù),使其成為利用AI創(chuàng)建圖像的潛在利器。我們還將剖析論文的這個(gè)部分。

1、高效訓(xùn)練LCM

神經(jīng)網(wǎng)絡(luò)領(lǐng)域的一大挑戰(zhàn)是需要絕對(duì)龐大的算力,尤其在訓(xùn)練它們以解決復(fù)雜方程時(shí)。這篇論文背后的團(tuán)隊(duì)用一種名為提煉的巧妙方法正面解決了這個(gè)問(wèn)題。

研究團(tuán)隊(duì)是這么做的:他們先使用一個(gè)文本與圖像配對(duì)的數(shù)據(jù)集訓(xùn)練一個(gè)標(biāo)準(zhǔn)的潛在擴(kuò)散模型(LDM)。一旦這個(gè)LDM啟動(dòng)并運(yùn)行起來(lái),他們把它用作一種導(dǎo)師,以生成新的訓(xùn)練數(shù)據(jù)。這些新數(shù)據(jù)隨后被用于訓(xùn)練潛在一致性模型(LCM))。這里最吸引人的部分是LCM學(xué)會(huì)從LDM的能力中學(xué)習(xí),不需要使用龐大數(shù)據(jù)集從頭開(kāi)始訓(xùn)練。

真正重要的是這個(gè)過(guò)程的效率。研究人員僅使用單個(gè)GPU就在大約32小時(shí)內(nèi)完成了高質(zhì)量LCM的訓(xùn)練。這很重要,因?yàn)樗纫郧暗姆椒斓枚唷?shí)用得多。這意味著現(xiàn)在更多的人和項(xiàng)目都可以創(chuàng)建這種先進(jìn)的模型,而不是只有享有超級(jí)計(jì)算資源的人才能創(chuàng)建。

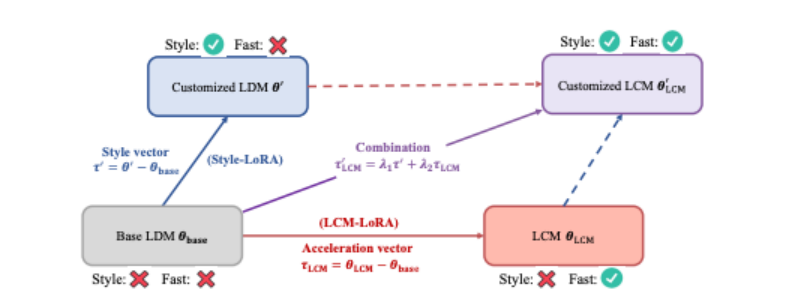

圖1、LCM-LoRA概述

圖1、LCM-LoRA概述

通過(guò)將LoRA引入到LCM的提煉過(guò)程中,我們顯著降低了提煉的內(nèi)存開(kāi)銷(xiāo),這使得我們可以用有限的資源訓(xùn)練更龐大的模型,比如SDXL和SSD-1B。更重要的是,通過(guò)LCM-LoRA訓(xùn)練獲得的LoRA參數(shù)(“加速向量”)可以直接與通過(guò)針對(duì)特定樣式的數(shù)據(jù)集進(jìn)行微調(diào)獲得的其他LoRA參數(shù)(“樣式向量”)結(jié)合起來(lái)。無(wú)需任何訓(xùn)練,由加速向量和樣式向量的線性組合獲得的模型獲得了以最少的采樣步驟生成特定繪畫(huà)樣式的圖像這種能力。

2、結(jié)果

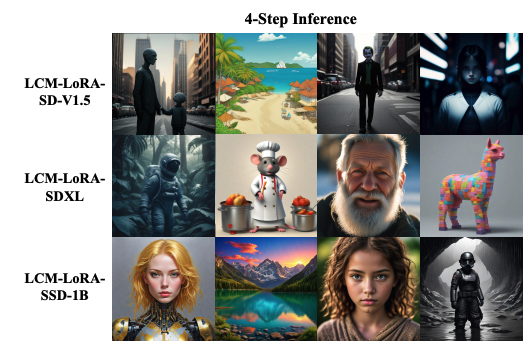

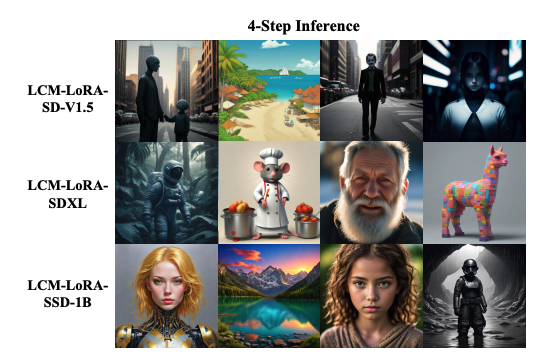

該研究展示了基于潛在一致性模型(LCM)利用AI生成圖像方面的重大進(jìn)展。LCM擅長(zhǎng)僅用四個(gè)步驟就能創(chuàng)建高質(zhì)量的512x512圖像,與潛在擴(kuò)散模型(LDM)等傳統(tǒng)模型所需的數(shù)百個(gè)步驟相比有了顯著改進(jìn)。這些圖像擁有清晰的細(xì)節(jié)和逼真的紋理,這個(gè)優(yōu)點(diǎn)在下面的例子中尤為明顯。

圖片

圖片

圖2、論文聲稱(chēng):“使用從不同的預(yù)訓(xùn)練擴(kuò)散模型中提取的潛在一致性模型生成的圖像。我們使用LCM-LoRA-SD-V1.5生成512×512分辨率的圖像,使用LCM-LoRA-SDXL和LCM-LoRA-SSD-1B生成1024×1024分辨率的圖像。”

這些模型不僅可以輕松處理較小的圖像,還擅長(zhǎng)生成更龐大的1024x1024圖像。它們展示了一種擴(kuò)展到比以前大得多的神經(jīng)網(wǎng)絡(luò)模型的能力,展示了其適應(yīng)能力。論文中的示例(比如LCM-LoRA-SD-V1.5和LCM-LoRA-SSD-1B版本的示例)闡明了該模型在各種數(shù)據(jù)集和實(shí)際場(chǎng)景中的廣泛適用性。

3、局限性

LCM的當(dāng)前版本存在幾處局限性。最重要的是兩個(gè)階段的訓(xùn)練過(guò)程:首先訓(xùn)練LDM,然后用它來(lái)訓(xùn)練LCM。在未來(lái)的研究中,可能會(huì)探索一種更直接的LDM訓(xùn)練方法,因而可能不需要LDM。論文主要討論無(wú)條件圖像生成,條件生成任務(wù)(比如文本到圖像的合成)可能需要做更多的工作。

4、主要的啟示

潛在一致性模型在快速生成高質(zhì)量的圖像方面邁出了一大步。這些模型只需1到4步就能生成與較慢的LDM相媲美的結(jié)果,這可能會(huì)徹底改變文本到圖像模型的實(shí)際應(yīng)用。雖然目前存在一些局限性,特別是在訓(xùn)練過(guò)程和生成任務(wù)的范圍方面,但LCM標(biāo)志著在基于神經(jīng)網(wǎng)絡(luò)的實(shí)用圖像生成方面取得了重大進(jìn)展。提供的示例強(qiáng)調(diào)了這些模型具有的潛力。

5、LCM-LoRA作為通用加速模塊

正如我在引言中提到,該論文分為兩部分。論文的第二部分討論了LCM-LoRA,這種技術(shù)允許使用少得多的內(nèi)存對(duì)預(yù)訓(xùn)練模型進(jìn)行微調(diào),使其更高效。

這里的關(guān)鍵創(chuàng)新是將LoRA參數(shù)集成到LCM中,從而生成結(jié)合兩者優(yōu)點(diǎn)的混合模型。這種集成對(duì)于創(chuàng)建特定樣式的圖像或響應(yīng)特定任務(wù)特別有用。如果選擇和組合不同的LoRA參數(shù)集,每個(gè)參數(shù)集又都針對(duì)獨(dú)特的樣式進(jìn)行微調(diào),研究人員創(chuàng)建了一個(gè)多功能模型,可以用最少的步驟生成圖像,不需要額外的訓(xùn)練。

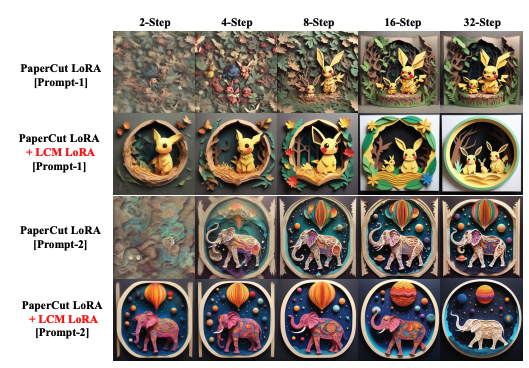

他們?cè)谘芯恐型ㄟ^(guò)將針對(duì)特定繪畫(huà)樣式進(jìn)行微調(diào)的LoRA參數(shù)與LCM-LoRA參數(shù)相結(jié)合的例子來(lái)證明這一點(diǎn)。這種組合允許在不同的采樣步驟(比如2步、4步、8步、16步和32步)創(chuàng)建樣式迥異的1024 × 1024分辨率圖像。它們表明,這些組合的參數(shù)無(wú)需進(jìn)一步訓(xùn)練即可生成高質(zhì)量圖像,強(qiáng)調(diào)了這種模型的效率和通用性。

這里值得關(guān)注的一個(gè)地方是使用所謂的“加速向量”(τLCM)和“樣式向量”(τ),兩者使用特定的數(shù)學(xué)公式(λ1和λ2是這些公式中的可調(diào)整因子)組合在一起。這種組合產(chǎn)生的模型可以快速地生成定制樣式的圖像。

論文中的圖3(如下所示)通過(guò)展示特定樣式LoRA參數(shù)與LCM-LoRA參數(shù)結(jié)合的結(jié)果,表明了這種方法的有效性。這證明了該模型能夠快速高效地生成樣式不同的圖像。

圖3

圖3

總之,本文的這部分強(qiáng)調(diào)了LCM-LoRA模型如何代表一種通用的、高效的解決方案,可用于快速生成高質(zhì)量的特定樣式的圖像,只需使用極少的計(jì)算資源。這項(xiàng)技術(shù)的實(shí)際應(yīng)用很廣泛,有望徹底改變從數(shù)字藝術(shù)到自動(dòng)化內(nèi)容創(chuàng)作等各個(gè)領(lǐng)域生成圖像的方式。

6、結(jié)論

我們研究了潛在一致性模型(LCM),這是一種顯著加快從文本生成圖像過(guò)程的新方法。不像傳統(tǒng)的潛在擴(kuò)散模型(LDM)需要數(shù)百個(gè)步驟來(lái)創(chuàng)建一個(gè)圖像,LCM只需1到4個(gè)步驟就可以生成質(zhì)量相似的圖像。這種效率的大幅提升是通過(guò)提煉方法實(shí)現(xiàn)的,即使用預(yù)訓(xùn)練的LDM來(lái)訓(xùn)練LCM,因而不需要大量計(jì)算。

此外,我們還探索了LCM-LoRA,這是一種使用低秩自適應(yīng)(LoRA)對(duì)預(yù)訓(xùn)練模型進(jìn)行微調(diào)的增強(qiáng)技術(shù),降低了內(nèi)存需求。這種集成允許以最少的計(jì)算步驟創(chuàng)建特定樣式的圖像,而不需要額外的訓(xùn)練。

著重強(qiáng)調(diào)的關(guān)鍵結(jié)果包括LCM僅用幾個(gè)步驟就能創(chuàng)建高質(zhì)量的512x512和1024x1024圖像,而LDM卻需要數(shù)百個(gè)步驟。然而,目前存在的局限性是LDM依賴(lài)兩步訓(xùn)練過(guò)程,因此你仍需要LDM開(kāi)始入手!未來(lái)的研究可能會(huì)簡(jiǎn)化這個(gè)過(guò)程。

LCM特別是在提議的LCM-LoRA模型中與LoRA結(jié)合使用時(shí),是一種非常巧妙的創(chuàng)新。它們提供了更快速、更高效地創(chuàng)建高質(zhì)量圖像這個(gè)優(yōu)點(diǎn),我認(rèn)為它們?cè)跀?shù)字內(nèi)容創(chuàng)建方面有著廣泛的應(yīng)用前景。

參考鏈接:https://notes.aimodels.fyi/lcm-lora-a-new-method-for-generating-high-quality-images-much-faster/