微軟亞洲研究院韋福如:人工智能基礎創新的第二增長曲線

從人工智能的發展歷程來看,GPT 系列模型(例如 ChatGPT 和 GPT-4)的問世無疑是一個重要的里程碑。由它所驅動的人工智能應用已經展現出高度的通用性和可用性,并且能夠覆蓋多個場景和行業 —— 這在人工智能的歷史上前所未有。

然而,人工智能的科研工作者們不會滿足于此。從某種意義上來說,大模型只是人工智能漫長研究道路上一個精彩的「開局」。但當我們滿懷雄心壯志邁向下一個里程碑時,卻發現僅僅依賴現有的技術和模型已經難以應對新的挑戰,我們需要新的突破和創新。

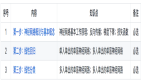

Transformer 網絡架構、「語言」模型(Next-Token Prediction,或自回歸模型)學習范式,規模法則(Scaling Law),以及海量的數據和計算資源,是構成當前人工智能基礎大模型范式遷移的核心技術要素。在這套「黃金組合」的基礎上,目前人工智能基礎大模型的大部分工作都集中在繼續增加訓練數據量和擴大模型規模。但我們認為,這套范式并不足以支撐人工智能未來的發展。當我們被束縛在既有的架構中,只追求增量式的創新時,也就意味著我們已經看到了現有技術路徑的局限性,人工智能基礎創新的第一增長曲線的頂峰已然近在咫尺。

「無論把多少架馬車連續相加,都不能造出一輛火車。只有從馬車跳到火車的時候,才能取得十倍速的增長。」約瑟夫?熊彼特的經典名言表明,第二增長曲線從不會誕生于對現有成果的簡單疊加,我們需要在人工智能基礎模型的組成要素中,尋找撬動第二增長曲線的驅動力。

因此,在微軟亞洲研究院,我們將目光聚焦到了人工智能的第一性原理,從根本出發,構建能實現人工智能效率與性能十倍甚至百倍提升,且具備更強涌現能力的基礎模型,探索引領人工智能走向第二增長曲線的途徑。

人工智能基礎創新的第二增長曲線

基礎模型是人工智能的第一性原理

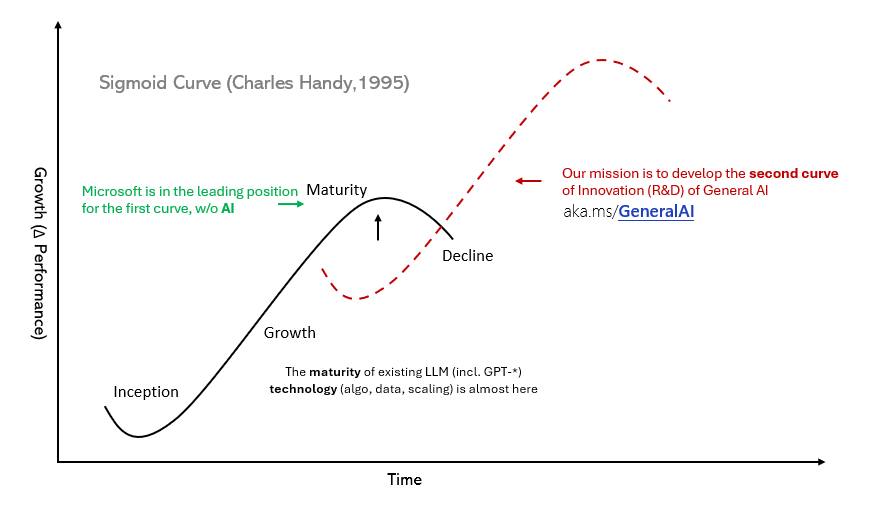

如果對人工智能的「組件」進行一次「二維展開」,我們認為它將呈現出以下幾個部分:處于最上層的是自主智能體(Autonomous Agent),它的目標是能通過自主學習和適應性調整來完成各種任務。最底層是「智能」本質的科學理論支撐,可以幫助我們理解「智能」(尤其是人工智能)的邊界和機理。位于兩者之間的部分,我們將其稱為基礎模型(Foundation Model)。在數據、算力和新的軟硬件等基礎設施的支持下,基礎模型是將科學理論轉化成智能體的實際行為。

通用型人工智能基礎研究的組成部分

在勾畫人工智能的未來藍圖時,基礎模型無疑是人工智能的第一性原理,其中,基礎網絡架構(Model Architecture)和學習范式(Learning Paradigm)是其兩大核心基礎。

對上層而言,基礎模型驅動自主智能體的創建,為更多革命性的應用和場景提供動力,就像為上層應用持續供電的發電機。對下,基礎模型則可以促進智能的科學理論(Science of Intelligence)的深入研究。事實上,無論是萬億級參數的大模型所展現出的「暴力」美學,還是通過擴展規律(Scaling Law)來尋找關鍵的物理指標,都應該成為科學研究的一部分。隨著智能的科學理論的推進,未來我們或許可以僅通過簡潔的公式就能描述和推導出人工智能的規律。

要實現這些目標,我們需要一個強大的基礎模型作為核心。對基礎模型的重構,為人工智能基礎創新的第二發展曲線提供了關鍵的突破口。

接下來的問題是,我們應該如何改進基礎模型?

正如之前所提到的,現有的「黃金組合」依舊是基礎模型的技術根本,但是我們需要更加根本和基礎的研究突破以引領未來的人工智能基礎模型的構建和開發。我們期望通過對這一組合進行根本性的變革,使其成為引領未來人工智能訓練范式的基石,讓基礎模型能真正成為人類社會的基礎設施。而新一代的基礎模型應當具備兩大特質:強大且高效。其中,強大體現在其性能、泛化能力和抵抗幻覺能力等方面的出色表現,高效則是指低成本、高效率和低能耗。

目前已有的大模型通過不斷增加數據量與算力規模,或者說規模法則已經在一定程度上解決了第一個問題,但這是以成本效率為代價來實現的。為了突破這些局限,我們推出了如 RetNet 和 BitNet 等旨在取代 Transformer 的新型網絡架構。同時,我們也在持續推動多模態大語言模型(MLLMs)的演進,并探索新的學習范式,「三管齊下」來構建全新的基礎模型,為人工智能的未來發展奠定堅實的基礎。

推理效率

是新一代基礎模型網絡架構革新的關鍵驅動力

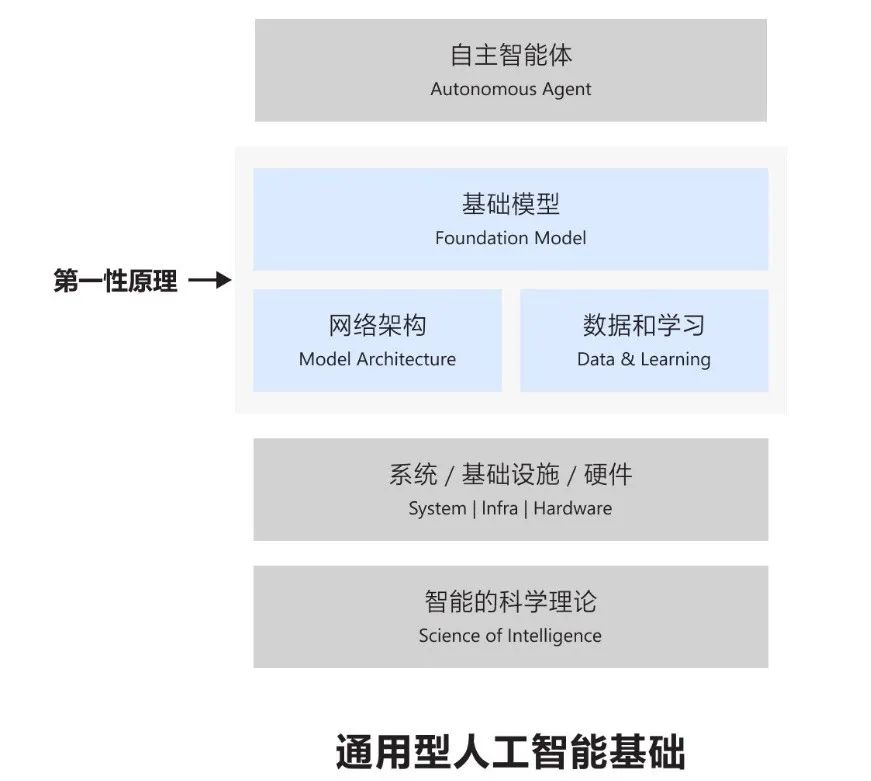

基礎網絡架構是人工智能模型的骨干,只有基礎架構足夠完善,才能保證上層的學習算法和模型訓練高效運行。目前,Transformer 架構被廣泛應用于大語言模型,并且利用其并行訓練的特點顯著提高了模型的性能,成功解決了基于循環神經網絡架構在長程依賴建模方面的不足。但與此同時,它也帶來了提升推理效率的巨大挑戰。

根據當前大模型的發展趨勢,如果繼續在 Transformer 架構上訓練模型,我們很快就會發現,現有的計算能力將難以滿足下一階段人工智能發展的需求。

這就明確了一個問題 —— 推理效率已經成為現有基礎網絡架構演進的瓶頸,也是推動未來基礎網絡架構變革的關鍵驅動力。提升推理效率不僅意味著降低成本,更代表著我們可以將基礎模型真正變成像水和電一樣的基礎設施和資源,使每個人都能方便地獲取和使用。

而近期,我們推出的一種新型基礎網絡架構 Retentive Network(RetNet),成功突破了所謂的「不可能三角」難題,實現了帕累托(Pareto)優化。也就是說,RetNet 在保持良好的擴展性能和并行訓練的同時,實現了低成本部署和高效率推理。我們的實驗還證實,RetNet 的推理成本與模型序列長度無關,這表示無論是處理長文本序列,還是長圖像序列,亦或是未來更長的音視頻序列,RetNet 都可以保持穩定的高效推理。這些優勢讓 RetNet 成為繼 Transformer 之后大語言模型網絡架構的有力繼承者。

模型網絡架構之「不可能三角」問題

另外,隨著模型規模的不斷擴展,計算能耗問題也日益凸顯,成為當前網絡架構中限制人工智能發展的另一大障礙。我們推出的 BitNet 則有效緩解了這一問題。

BitNet 是第一個支持訓練 1 比特大語言模型的新型網絡結構,具有強大的可擴展性和穩定性,能夠顯著減少大語言模型的訓練和推理成本。與最先進的 8 比特量化方法和全精度 Transformer 基線相比,BitNet 在大幅降低內存占用和計算能耗的同時,表現出了極具競爭力的性能。此外,BitNet 擁有與全精度 Transformer 相似的規模法則(Scaling Law),在保持效率和性能優勢的同時,還可以更加高效地將其能力擴展到更大的語言模型上,從而讓 1 比特大語言模型(1-bit LLM)成為可能。

如果說 RetNet 是從平行推理效能的角度革新了網絡架構,那么 BitNet 則從正交的角度提升了推理效率。這兩者的結合,以及融合其他提升模型效率的技術比如混合專家模型(MoE)和稀疏注意力機制(Sparse Attention),將成為未來基礎模型網絡架構的基礎。

推動多模態大語言模型演進

邁向多模態原生

未來基礎模型的一個重要特征就是擁有多模態能力,即融合文本、圖像、語音、視頻等多種不同的輸入和輸出,讓基礎模型能夠像人類一樣能聽會看、能說會畫。而這也是構建未來人工智能的必然方向。

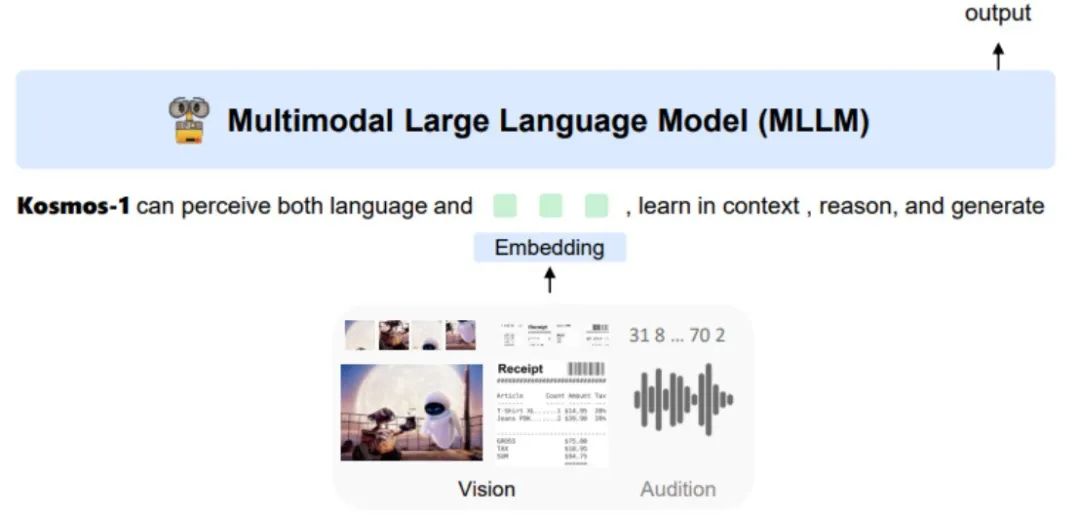

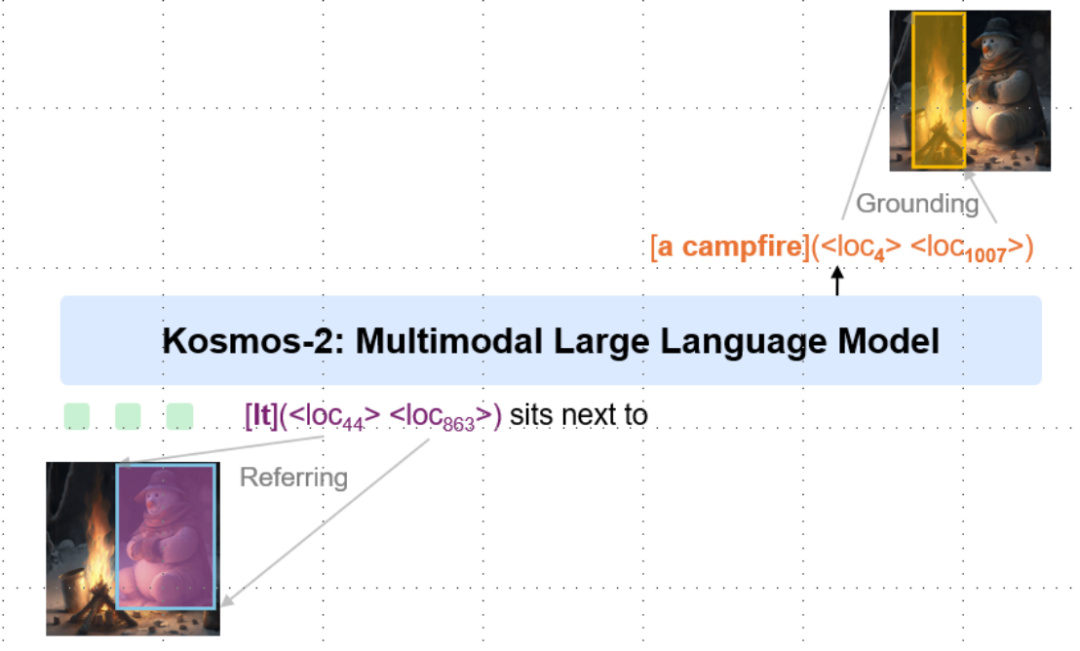

在這一背景下,我們針對多模態大語言模型 Kosmos 展開了一系列研究。其中,Kosmos-1 能夠按照人類的推理模式,處理文本、圖像、語音和視頻等任務,構建了全能型人工智能的雛形。Kosmos-2 則進一步加強了感知與語言之間的對齊,它不僅能夠用語言描述圖像,還能識別圖像中的實體,解鎖了多模態大語言模型的細粒度對齊(Grounding)能力。這種能力為具身智能(Embodied AI)奠定了基礎,展示出了多模態模型在語言、感知、行動和物理世界中大規模融合的可能性。

在 Kosmos-2 的基礎上,我們又推出了 Kosmos-2.5 。這一版本為多模態大語言模型賦予了通用的識字能力,使其能夠解讀文本密集的圖像,為智能文檔處理和機器人流程自動化等應用提供技術基礎。在接下來的 Kosmos-3 中,我們將在基礎網絡架構革新和創新學習范式的雙重驅動下,進一步推動人工智能基礎模型的發展。

Kosmos 系列整體架構圖:Kosmos-1 和 2 多模態大語言模型支持多模態輸入輸出,細粒度的對齊,遵循用戶指示,并可針對多模態任務(包括自然語言任務)進行上下文學習

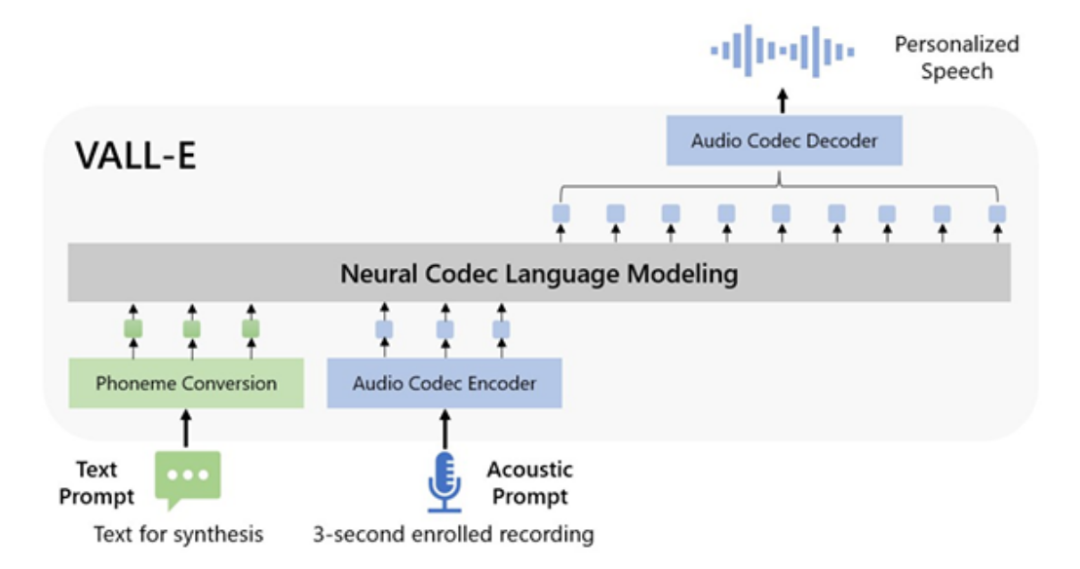

此外,語音無疑是未來多模態大語言模型的核心能力之一。因此,我們還推出了語音多模態大語言模型 VALL-E,并支持零樣本文本的語音合成。只需短短三秒的語音提示樣本,VALL-E 就能將輸入的文本用與輸入的提示語音相似的聲音朗讀出來。與傳統的非基于回歸任務訓練的語音模型不同,VALL-E 是直接基于語言模型訓練而成的。通過直接將語音合成轉化為一個語言模型任務,這一探索進一步加強了語言和語音兩種模態的融合。

VALL-E 首先通過語音 codec 模型把連續的語音輸入轉化為離散的 token,從而可以進行統一的語音 - 文本語言模型訓練

Kosmos 系列模型和 VALL-E 都是我們在多模態大語言模型方面的早期探索,我們讓大語言模型具備了基本的多模態感知和生成的能力。但是,這還遠遠不夠,我們認為未來的多模態大語言模型和人工智能基礎模型要能夠多模態原生(Multimodal Native),以實現真正的多模態推理,跨模態遷移以及新的涌現能力。

專注顛覆式創新

持續推進通用型人工智能基礎研究第二增長曲線

除了不斷推進基礎模型架構和多模態大語言模型的創新,我們還需要更多在基礎研究上的顛覆式突破。我們相信目前大模型應用中的很多問題,比如成本問題、長序列建模 / 長期記憶(Long-term Memory)、幻覺問題以及安全問題等也需要從根本性的角度得到解決。

首先是大語言模型學習的理論框架和根本原理,現有的工作基本都是以實驗和經驗為主的,未來的基礎創新需要從更加根本和理論的角度推進。目前已經有一些基于壓縮的工作,我們相信在不遠的未來就有可能看到很大的突破性進展。

另外,大模型的發展使得我們可以實現在很多任務上達到或者超過人類(如數據生產者或標注員)的能力,這就需要我們探索一種在模型比人類強的前提下的新一代人工智能研究范式,包括且不限于基本的學習框架、數據和監督信號來源以及評測等等。比如合成數據(Synthetic Data)會變得越來越重要,一方面是數據會變得不夠用,另一方面是模型自動生成的數據質量也越來越高了。還有一個機會是小數據大模型的學習,我們可以通過模型的自動探索與學習,結合強化學習,從而讓人工智能可以更接近人類從少量數據中就能高效學習的學習方式。這也是進一步通過規模化算力(Scaling Compute)提升智能的可行方向之一。

還有一個機會是小數據大模型的學習,我們可以通過模型的自動探索與學習,結合強化學習,從而讓人工智能可以更接近人類從少量數據中就能高效學習的學習方式。這也是進一步通過規模化算力(Scaling Compute)提升智能的可行方向之一。

最后,越來越多的研究工作表明,未來人工智能的模型、系統基礎設施和硬件的發展會有更多聯合創新、共同演進的機會。

在對人工智能的漫長探索中,我們正站在一個前所未有的歷史節點。現在我們可能正處于人工智能領域的「牛頓前夜(Pre-Newton)」,面臨著諸多未知和挑戰,同樣也有很多的機會,每一次的探索和突破都預示著未來無限的可能性。希望藉由我們的研究,人們能夠更深入地洞悉基礎模型和通用型人工智能的理論和技術的發展趨勢,揭示關于未來人工智能的「真理」。

我們相信,人工智能今后必將更加全面地融入我們的日常生活,改變我們工作、生活和交流的方式,并為人類解決最有挑戰和最為重要的難題,甚至對人類社會帶來深刻的影響。接下來的 5 到 10 年是人工智能最值得期待和激動人心的時刻,我和我的同事們也將繼續專注于推動人工智能基礎研究的突破和創新應用的普及,讓其成為促進人類社會發展和進步的強大動力。

本文作者

韋福如博士現任微軟亞洲研究院全球研究合伙人,領導團隊從事基礎模型、自然語言處理、語音處理和多模態人工智能等領域的研究。最近,他還致力于推進通用型人工智能的基礎研究和創新。韋博士還擔任西安交通大學兼職博士生導師,香港中文大學教育部-微軟重點實驗室聯合主任。

韋博士在頂級會議和期刊上發表了 200 多篇研究論文(引用超過 30000 次,H-Index 84),并獲得 AAAI 2021 年最佳論文提名獎以及 KDD 2018 最佳學生論文獎。

韋博士分別于 2004 年和 2009 年獲得武漢大學學士學位和博士學位。2017 年,他因對自然語言處理的貢獻入選《麻省理工技術評論》中國 35 歲以下創新者年度榜單(MIT TR35 China)。