史上最快3D數(shù)字人生成器:半小時完成訓(xùn)練,渲染僅需16毫秒,蘋果出品

之前要兩天才能訓(xùn)練好的數(shù)字人,現(xiàn)在只用半小時就能完成了!

到了推理階段,更是只要16毫秒,就能得到動作流暢、細節(jié)到位的場景視頻。

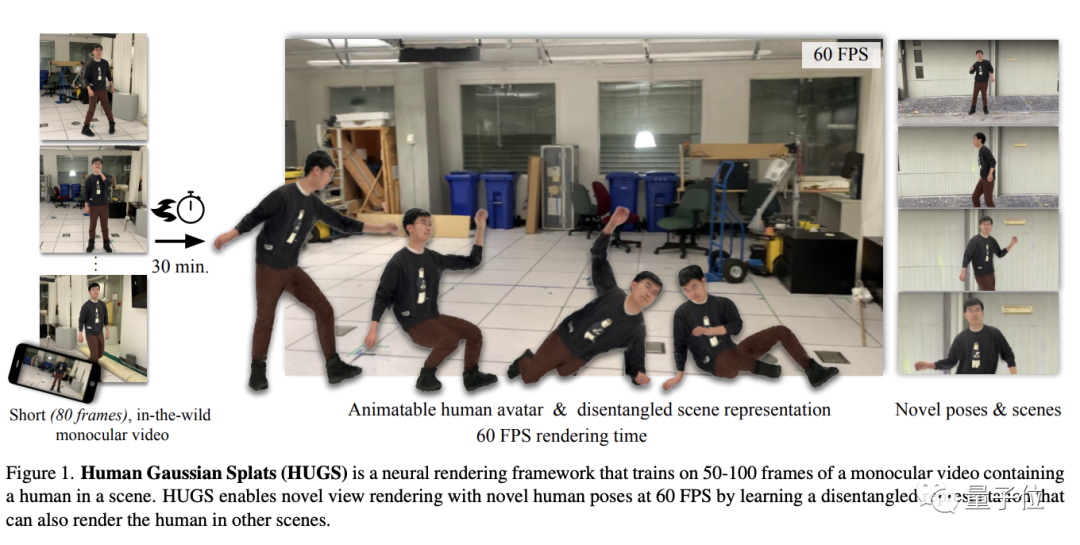

而且無需復(fù)雜的采樣和建模,只要隨便拍一段50-100幀的視頻就足夠了,換算成時間不過幾秒鐘。

這正是由蘋果聯(lián)合德國馬普所推出的,基于高斯函數(shù)的3D數(shù)字人合成工具HUGS。

它可以從一段簡單的視頻當中提取出人物骨骼,從而合成數(shù)字分身并驅(qū)動它做出任意動作。

這個數(shù)字人可以絲滑地融合到其他場景,甚至幀率還能超越原始素材,達到60FPS。

Hugging Face的“首席羊駝官”O(jiān)mar Sanseviero看到后,也給HUGS送上了hug。

那么,HUGS可以實現(xiàn)怎樣的效果呢?

100倍速生成60FPS視頻

從下面這張動圖可以看出,新生成的數(shù)字人可以在不同于訓(xùn)練素材的場景中做出不同的動作。

而新合成的畫面也比原始素材更加流暢——盡管原素材只有24FPS,但HUGS合成的視頻幀率達到了60FPS。

同時,HUGS也支持把多個人物融合進同一個場景。

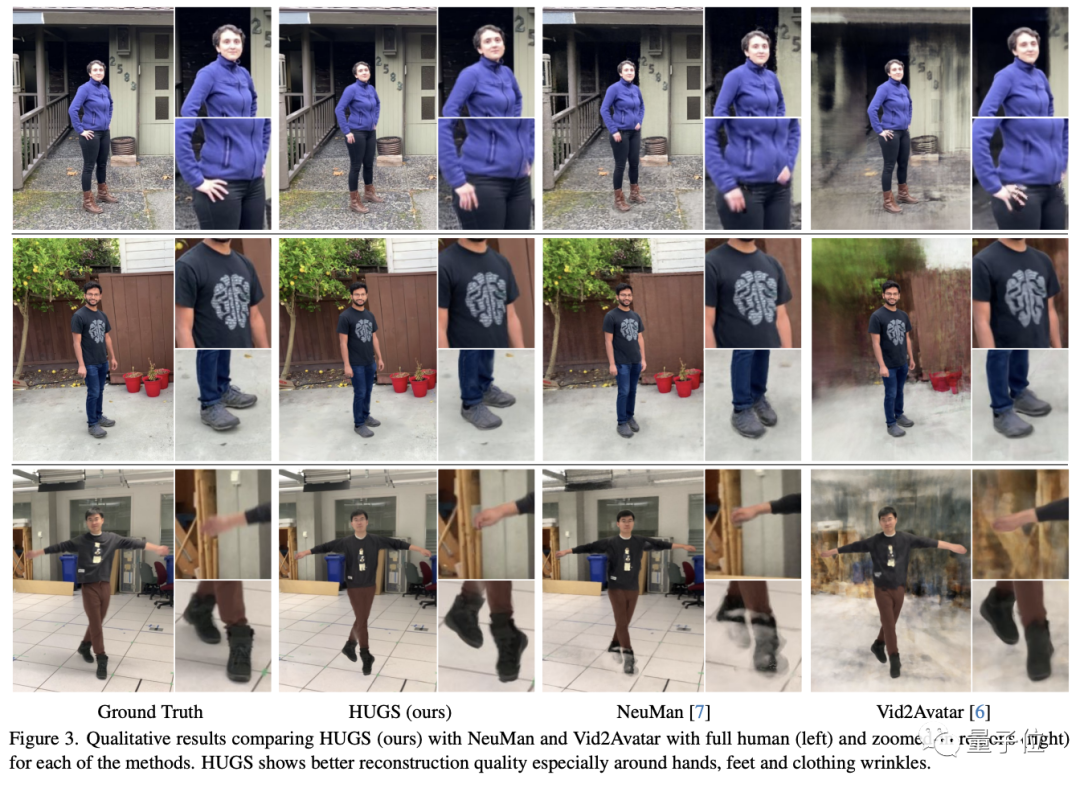

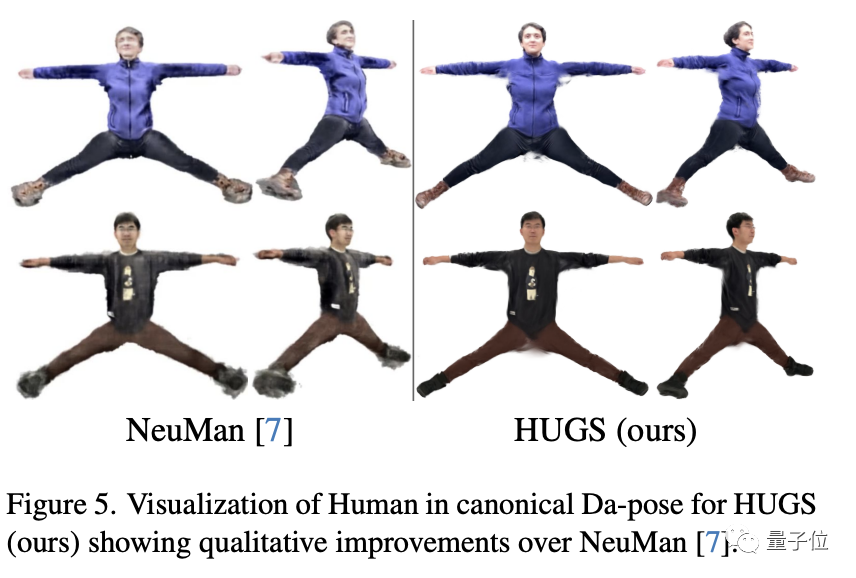

細節(jié)刻畫上,HUGS也比Neuman和Vid2Avatar這兩個前SOTA更清晰細膩,也更加真實。

如果放到規(guī)范空間中,Neuman和HUGS的細節(jié)對比將變得更加明顯。

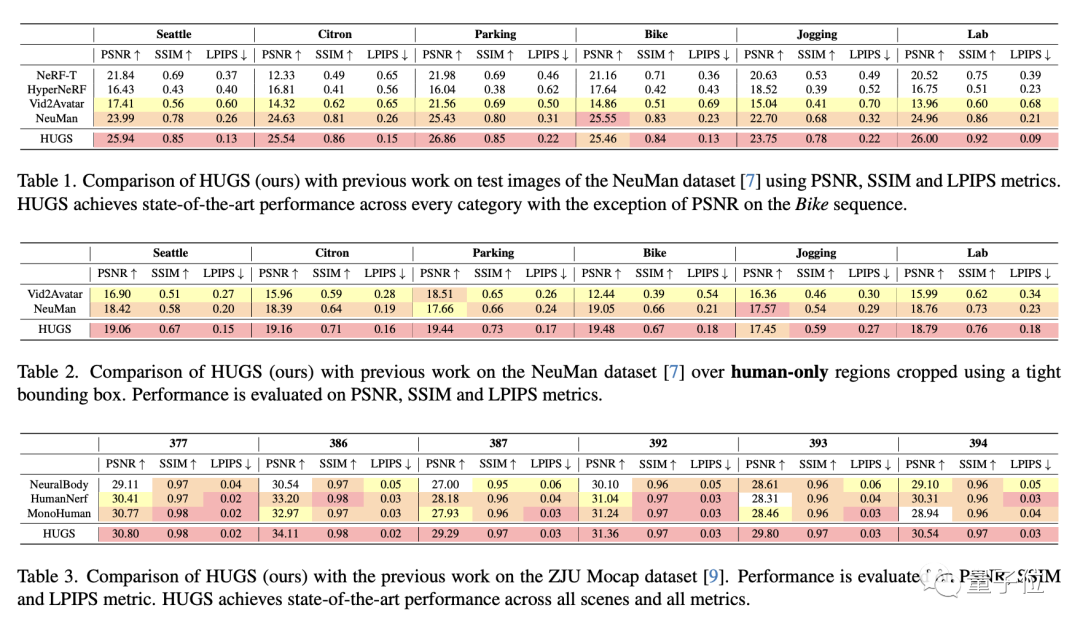

測試數(shù)據(jù)上看,HUGS在NeuMan數(shù)據(jù)集的五個場景中的PSNR和SSIM評分都達到了SOTA水平,LPIPS誤差則處于最低位。

在ZJU Mocap數(shù)據(jù)集上,針對5個不同受試者,HUGS也都超越了NerualBody、HumanNeRF等Baseline方法。

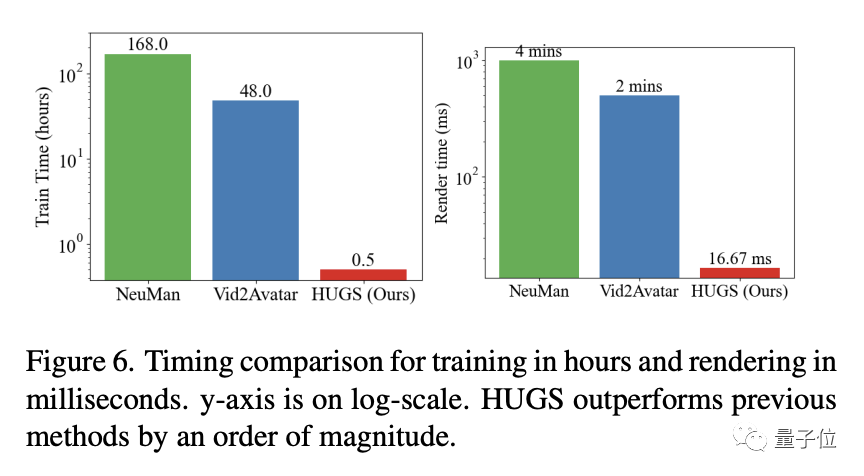

速度方面,HUGS的訓(xùn)練只需半小時就能完成,而此前最快的VidAvtar也要48小時,速度提升了近百倍。

渲染速度也是如此,用Baseline方法進行渲染需要2-4分鐘,但HUGS只用16.6毫秒就能完成,比人眨眼的速度還快。(下圖為對數(shù)坐標系)

那么,HUGS是如何實現(xiàn)既迅速又細膩地生成3D數(shù)字人的呢?

像搭積木一樣渲染

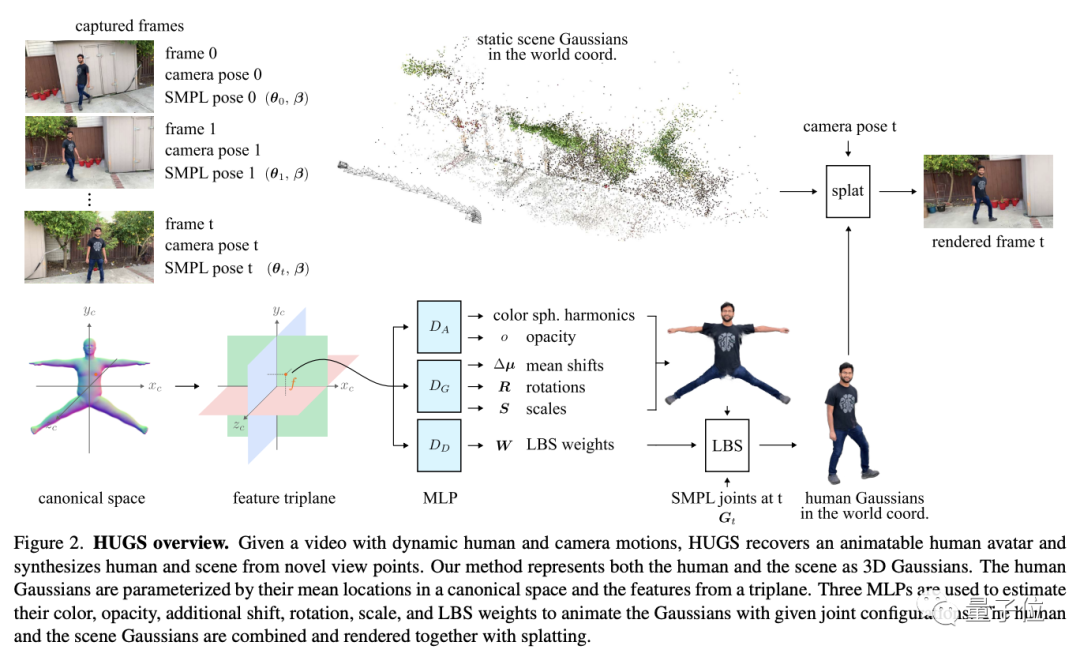

HUGS首先將人物和場景分別轉(zhuǎn)化為3D高斯斑點。

其中,人物部分的高斯斑點由三個多層感知機(MLP)來預(yù)測,并通過SMPL(一種人體形狀模型)進行初始化。

SMPL可以用極少的參數(shù)建立實體人物到三維網(wǎng)格的映射,只需要10個主要參數(shù)就可以表示99%的人體形狀變化。

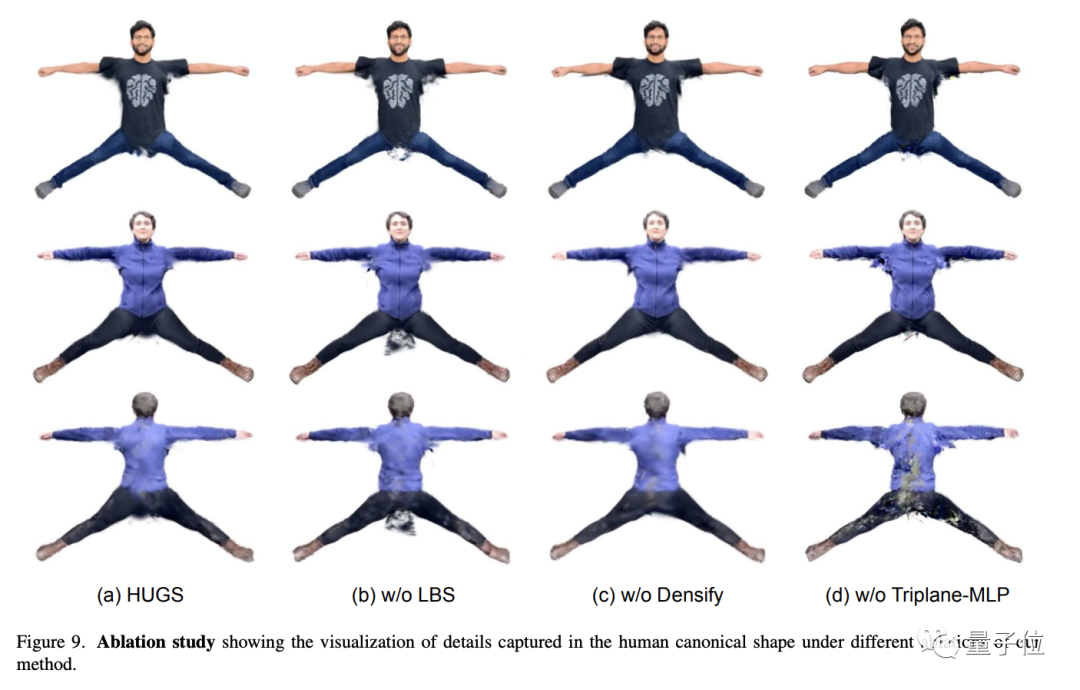

同時,為了刻畫頭發(fā)和衣服等細節(jié),HUGS也允許高斯函數(shù)在一定程度上偏離SMPL。

場景的高斯斑點通過特征三平面提供的位置編碼,由多個MLP預(yù)測得到。

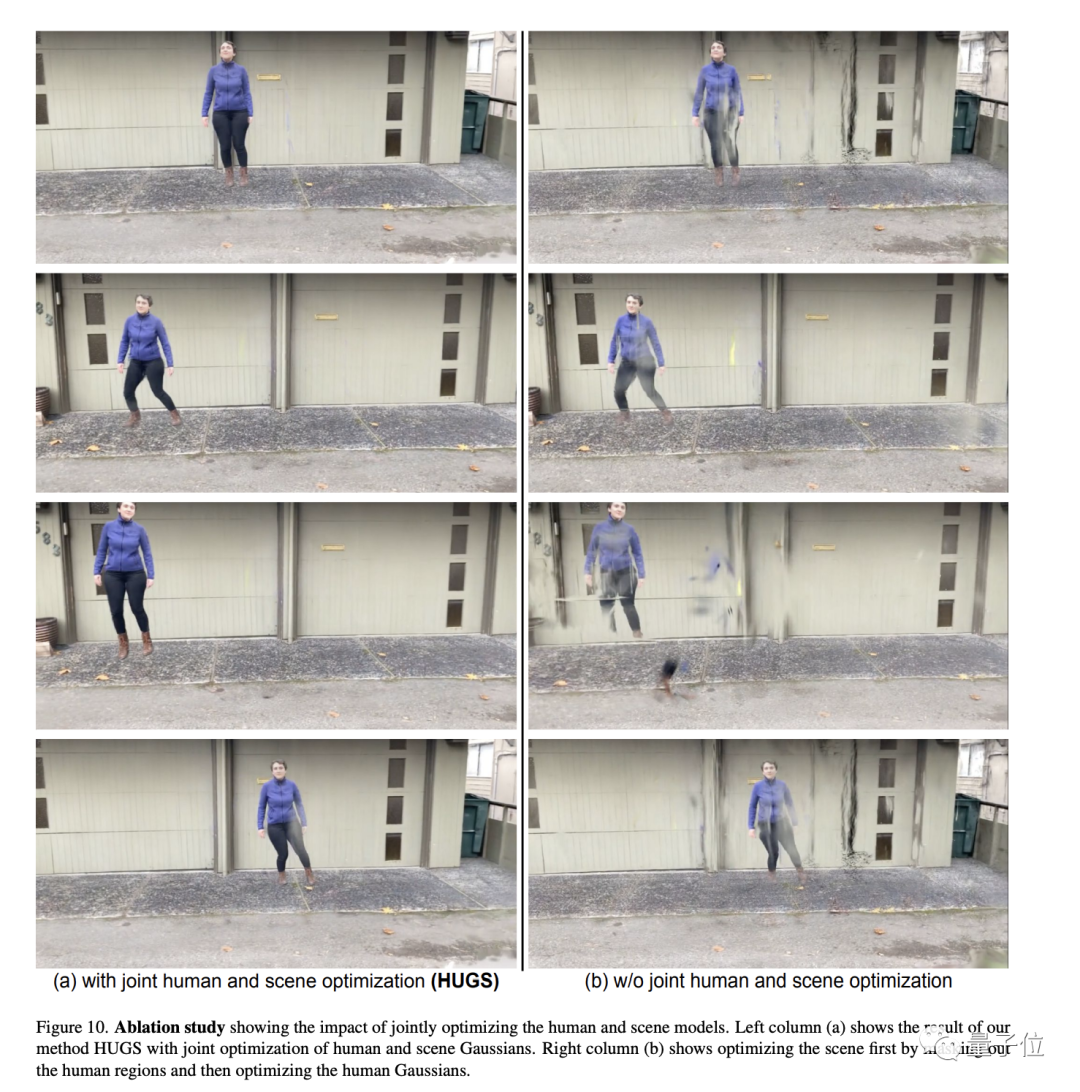

得到人體和場景模型的高斯斑點后,研究者對它們進行了聯(lián)合優(yōu)化。

得到的高斯斑點還會被進行克隆和拆分,從而增大斑點密度,不斷接近真實的目標幾何表面,這一過程稱為Densify。

此外,研究人員還引入了線性混合動畫(LBS)技術(shù),在運動過程中對高斯斑點進行驅(qū)動。

轉(zhuǎn)換為高斯斑點形式后,研究人員訓(xùn)練了神經(jīng)網(wǎng)絡(luò)對高斯函數(shù)的屬性進行預(yù)測,形成真實的人體形狀。

同時,神經(jīng)網(wǎng)絡(luò)還定義了高斯函數(shù)與人體骨骼的綁定關(guān)系,從而實現(xiàn)人物的運動。

這樣,HUGS的渲染過程就像搭積木一樣,不需要重新調(diào)用神經(jīng)網(wǎng)絡(luò),從而實現(xiàn)了高速渲染。

消融實驗結(jié)果表明,LBS、Densify和三平面MLP都是HUGS中的重要環(huán)節(jié),缺少任何一個都會對合成效果造成影響。

而人物與場景的聯(lián)合優(yōu)化,同樣是實現(xiàn)剛好融合效果的關(guān)鍵因素。

One More Thing

蘋果產(chǎn)生研究數(shù)字人的想法已經(jīng)有一段時間了。

在蘋果MR頭顯Apple Vision Pro中,就出現(xiàn)過高細節(jié)版本的數(shù)字分身概念——

在FaceTime通話時,頭顯可以創(chuàng)建一個“數(shù)字人”,并用它來代表用戶。

那么,對蘋果的這個“數(shù)字人生成器”,你怎么看呢?

論文地址:https://arxiv.org/abs/2311.17910