沒有3D卷積的3D重建方法,A100上重建一幀僅需70ms

從姿態圖像重建 3D 室內場景通常分為兩個階段:圖像深度估計,然后是深度合并(depth merging)和表面重建(surface reconstruction)。最近,多項研究提出了一系列直接在最終 3D 體積特征空間中執行重建的方法。雖然這些方法已經獲得出令人印象深刻的重建結果,但它們依賴于昂貴的 3D 卷積層,限制其在資源受限環境中的應用。

現在,來自 Niantic 和 UCL 等機構的研究者嘗試重新使用傳統方法,并專注于高質量的多視圖深度預測,最終使用簡單現成的深度融合方法實現了高精度的 3D 重建。

?

- 論文地址:https://nianticlabs.github.io/simplerecon/resources/SimpleRecon.pdf

- GitHub 地址:https://github.com/nianticlabs/simplerecon

- 論文主頁:https://nianticlabs.github.io/simplerecon/

該研究利用強大的圖像先驗以及平面掃描特征量和幾何損失,精心設計了一個 2D CNN。所提方法 SimpleRecon 在深度估計方面取得了顯著領先的結果,并且允許在線實時低內存重建。

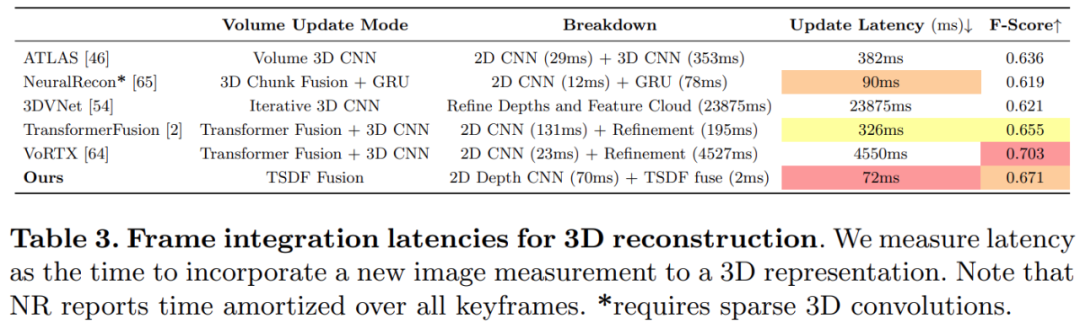

如下圖所示,SimpleRecon 的重建速度非常快,每幀僅用約 70ms。

SimpleRecon 和其他方法的比較結果如下:

方法

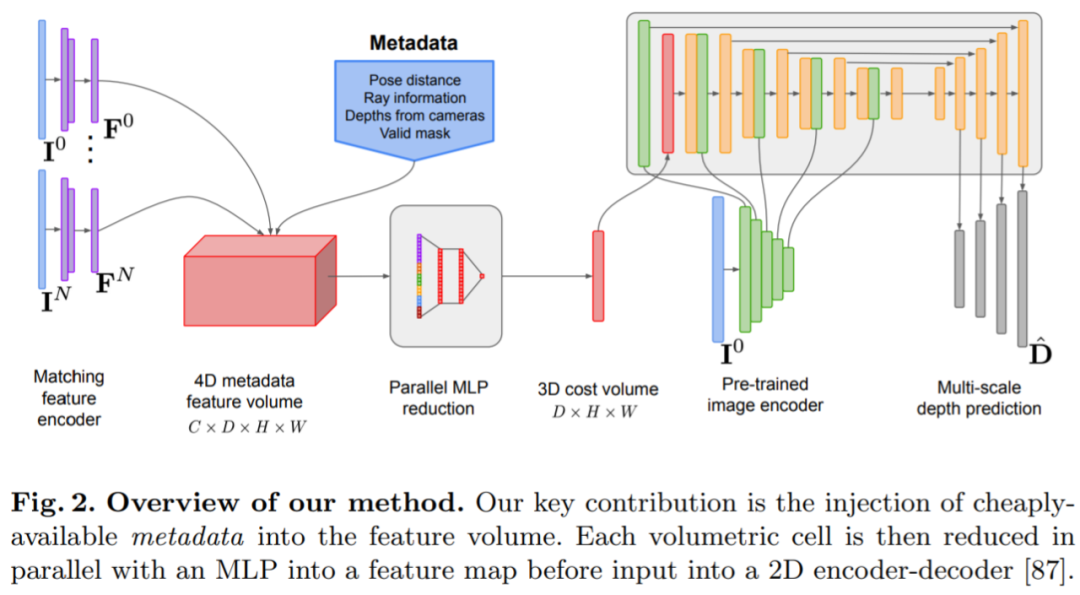

深度估計模型位于單目深度估計與平面掃描 MVS 的交點,研究者用 cost volume(代價體積)來增加深度預測編碼器 - 解碼器架構,如圖 2 所示。圖像編碼器從參考圖像和源圖像中提取匹配特征,以輸入到 cost volume。使用 2D 卷積編碼器 - 解碼器網絡來處理 cost volume 的輸出,此外研究者還使用單獨的預訓練圖像編碼器提取的圖像級特征進行增強。

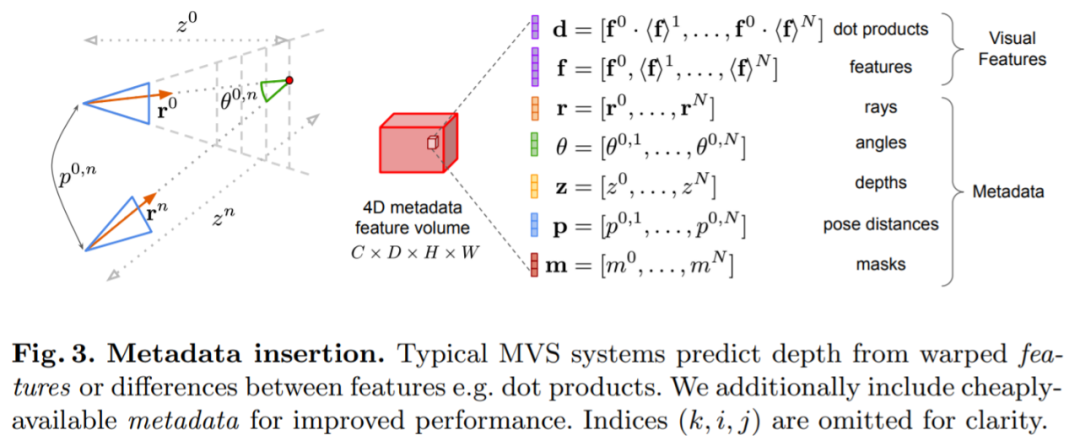

該研究的關鍵是將現有的元數據與典型的深度圖像特征一起注入到 cost volume 中,以允許網絡訪問有用的信息,如幾何和相對相機姿態信息。圖 3 詳細地顯示了 feature volume 構造。通過整合這些之前未開發的信息,該研究的模型能夠在深度預測方面顯著優于之前的方法,而無需昂貴的 4D cost volume 成本、復雜的時間融合以及高斯過程。

該研究使用 PyTorch 來實現,并使用 EfficientNetV2 S 作為主干,其具有類似于 UNet++ 的解碼器,此外,他們還使用 ResNet18 的前 2 個塊進行匹配特征提取,優化器為 AdamW ,在兩塊 40GB A100 GPU 上耗時 36 小時完成。

網絡架構設計

網絡是基于 2D 卷積編碼器 - 解碼器架構實現的。在構建這種網絡時,研究發現有一些重要的設計選擇可以顯著提高深度預測準確率,主要包括:

基線 cost volume 融合:雖然基于 RNN 的時間融合方法經常被使用,但它們顯著增加了系統的復雜性。相反,該研究使得 cost volume 融合盡可能簡單,并發現簡單地將參考視圖和每個源視圖之間的點積匹配成本相加,可以得到與 SOTA 深度估計相競爭的結果。

圖像編碼器和特征匹配編碼器:先前研究表明,圖像編碼器對深度估計非常重要,無論是在單目和多視圖估計中。例如 DeepVideoMVS 使用 MnasNet 作為圖像編碼器,其具有相對較低的延遲。該研究建議使用很小但更強大的 EfficientNetv2 S 編碼器,雖然這樣做的代價是增加了參數量,并降低了 10% 的執行速度,但它大大提高了深度估計的準確率。

融合多尺度圖像特征到 cost volume 編碼器:在基于 2D CNN 的深度立體和多視角立體中,圖像特征通常與單尺度上的 cost volume 輸出相結合。最近,DeepVideoMVS 提出在多尺度上拼接深度圖像特征,在所有分辨率上增加圖像編碼器和 cost volume 編碼器之間的跳躍連接。這對基于 LSTM 的融合網絡很有幫助,該研究發現這對他們的架構也同樣重要。

實驗

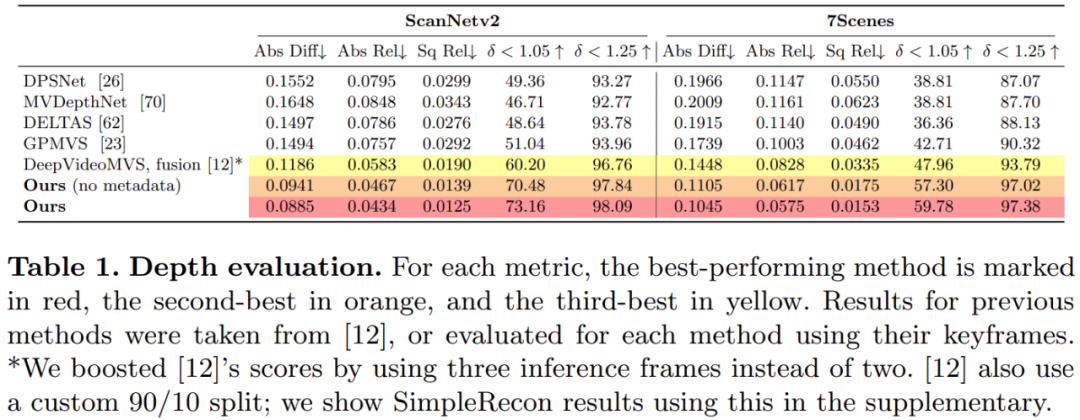

該研究在 3D 場景重建數據集 ScanNetv2 上訓練和評估了所提方法。下表 1 使用 Eigen 等人 (2014) 提出的指標來評估幾個網絡模型的深度預測性能。

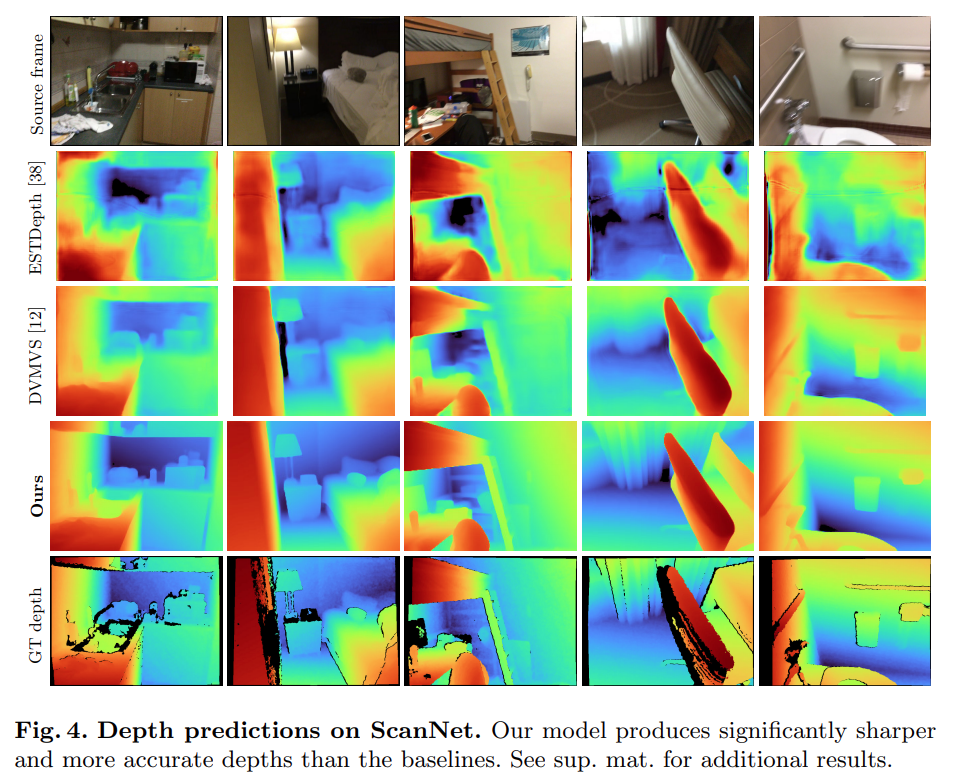

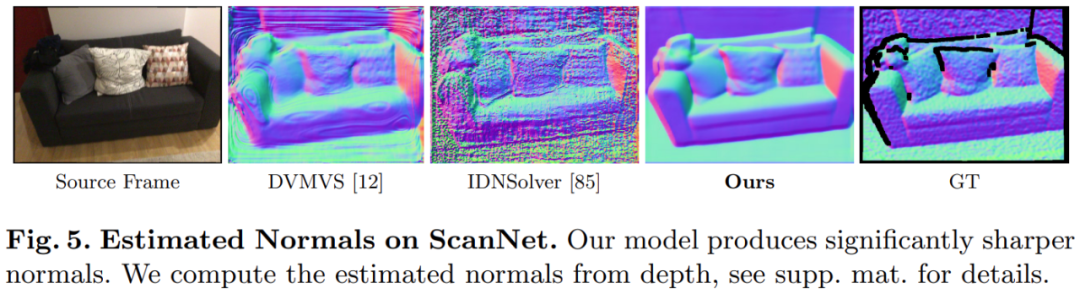

令人驚訝的是,該研究所提模型不使用 3D 卷積,在深度預測指標上卻優于所有基線模型。此外,不使用元數據編碼的基線模型也比以前的方法表現更好,這表明精心設計和訓練的 2D 網絡足以進行高質量的深度估計。下圖 4 和圖 5 顯示了深度和法線的定性結果。

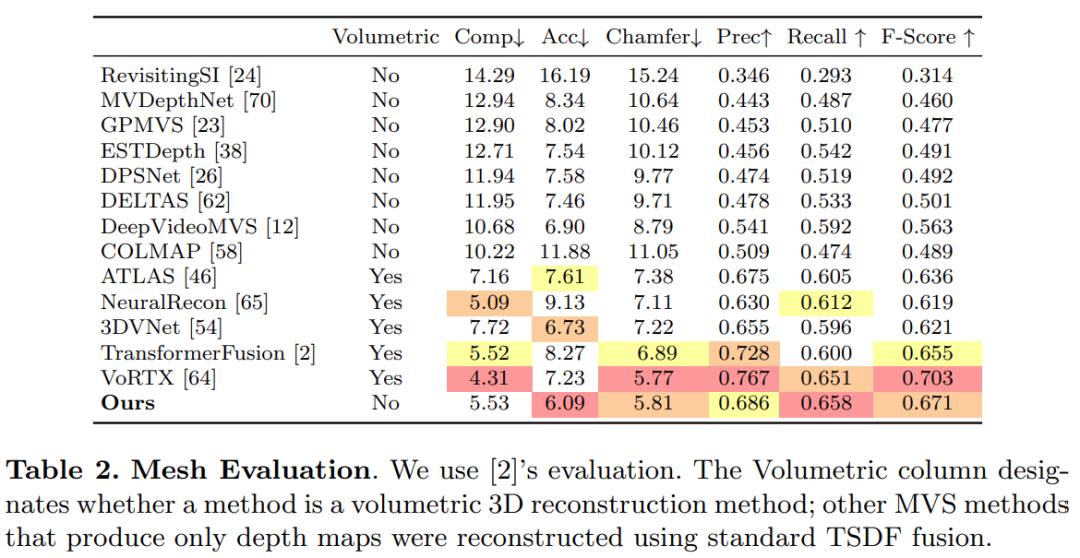

?該研究使用 TransformerFusion 建立的標準協議進行 3D 重建評估,結果如下表 2 所示。

對于在線和交互式 3D 重建應用,減少傳感器延遲是至關重要的。下表 3 展示了給定一個新的 RGB 幀,各個模型對每幀的集成計算時間。

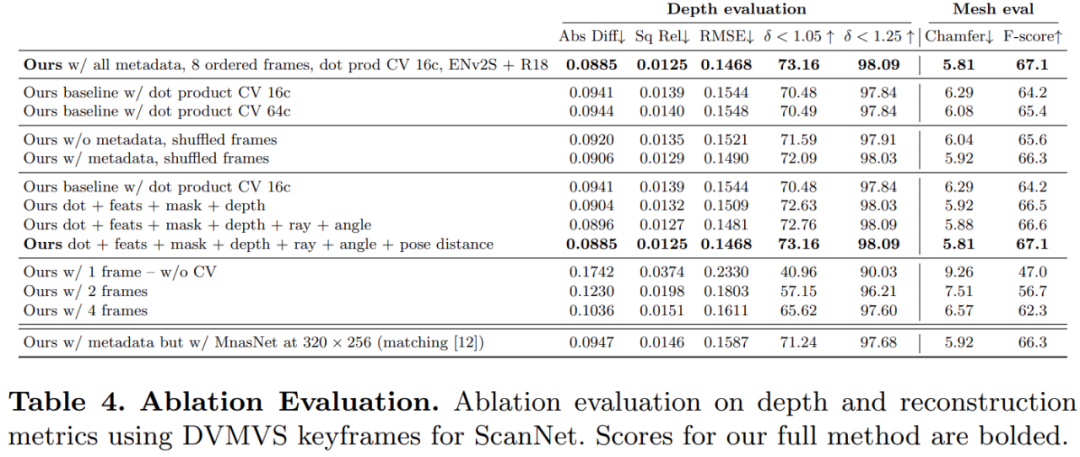

為了驗證該研究所提方法中各個組件的有效性,研究者進行了消融實驗,結果如下表 4 所示。

感興趣的讀者可以閱讀論文原文,了解更多研究細節。