AI機器人席卷CES!OpenAI暗自解除ChatGPT軍事應用限制,天網來了?

前一陣的斯坦福「炒蝦機器人」,讓無數人感慨:2024年怕不是要成為機器人元年?

就在這幾天的CES 2024上,又一大波機器人在展廳里引起了轟動!

比如這個機器人咖啡師,嫻熟地將一壺光滑的泡沫牛奶倒在拿鐵咖啡上。

開始,它會慢慢倒出牛奶,隨后,它優雅地將壺舉起,動作仿佛精心設計的舞蹈一般,為郁金香花瓣上色。

對人類來說,要學會拉花藝術需要數月甚至數年,但這位由AI驅動的機器人咖啡師,則掌握得駕輕就熟、行云流水。

這一幕,讓34歲的Roman Alejo感到焦慮。

這名拉斯維加斯賭場的咖啡師,憂心忡忡地想到:在AI時代,酒店業工作或許不再需要人類了?

他的擔憂,并不是空穴來風——CES展會上眾多機器人,敲打著人們的神經,帶來驚喜的同時,也讓人陷入莫大的焦慮。

機器人成物流幫手,還能幫你按摩

法國公司Enchanted Tools展示的這款物流機器人Mirokai,是受動漫啟發做成的。

預計到2025年,它就可以成為醫生和護士的助手了。

法國Capsix Robotics公司創建的iYU機器人,是個按摩大師。

它首先用AI進行實時的全身掃描,為用戶提供最佳體驗,然后機械臂就開始給你按摩了。

除了送貨機器人、按摩機器人、咖啡師機器人,展會上還有能做冰淇淋、珍珠奶茶的智能產品。

有個AI驅動的智能烤架,在廚房無人操作的情況下,就能完成燒烤任務。未來的餐廳里,很可能都是機器人大廚了。

這些性能高超的機器人,引起了不少業內人士的恐慌。「這非常可怕,越來越多的AI正在進入人類世界。」

OpenAI也「入局」

種種跡象表明,2024年即將成為人形機器人元年,尤其是當OpenAI也在大力投資的時候。

最近,由OpenAI支持的1X Technologies機器人公司,剛剛在B輪融資中獲得了1億美元。

具體來說,1X的NEO具有類似人類肌肉的解剖結構和非嚴格的液壓系統,將力量與柔和融為一體。它不僅可以自然地行走、慢跑、跑樓梯、導航,而且還可以進行遠程的人工控制。

在AI和機器人技術的全面加持下,NEO可以輕松完成物流、制造、機械操作等工業任務,以及做家務、照顧人等家政任務。

有趣的是,NEO這個名字,很容易讓人聯想到科幻電影「黑客帝國」。

投資者EQT Ventures的合伙人Ted Persson表示:「從達芬奇到今天的科幻小說,人類對人形機器人的夢想已有500多年的歷史。能夠見證這項技術在我們眼前成形,是莫大的榮幸。」

「在我們看來,機器人加入人類的勞動力隊伍,會造成變革性的影響。」

「終結者」走入現實?微軟可以用ChatGPT控制機器人了

不過,機器人真的會只幫我們做家務嗎?

要知道,微軟已經可以用ChatGPT控制機器人了。

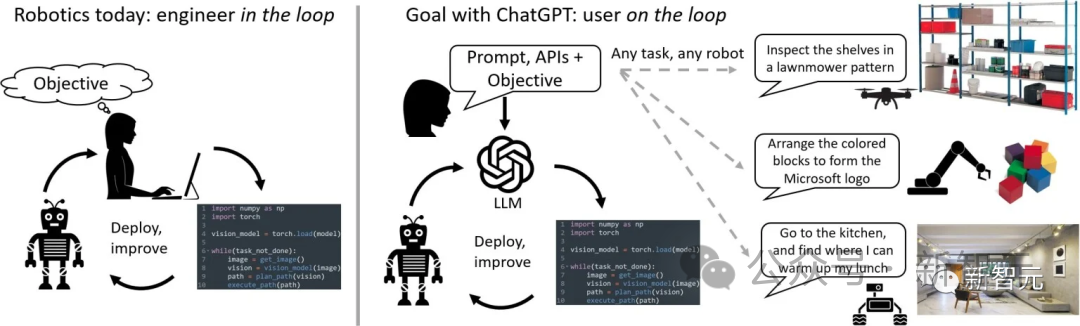

在去年,微軟曾發表過一篇論文,提出了一套新的設計原則,通過ChatGPT這樣的大型語言模型來給機器人提供指令。

論文鏈接:https://www.microsoft.com/en-us/research/uploads/prod/2023/02/ChatGPT___Robotics.pdf

只要prompt寫得夠好,ChatGPT的表現也會更驚人。

微軟專家發現,要是把這種能力遷移到機器人身上,假設幾十年以后,各家各戶都有機器人,只要說一聲「給我熱一下午餐」,它就能自己找到微波爐,再把菜端回來,人機交互就直接邁入新時代。

讓ChatGPT幫用戶更容易地與機器人交互,其中的關鍵難題,就是教 ChatGPT如何使用物理定律、操作環境的背景以及了解機器人的物理行為如何改變世界狀態。

實驗證明,ChatGPT能夠控制一臺真正的無人機。

按照下面視頻中進行的對話,一個完全不懂技術的用戶,只需要通過對話就能實現控制無人機。

而最近關于GPT-5會更加接近AGI的討論,讓已經能「自學」且遠程操作愈發簡單的機器人,更加無所不能。

那么,接下來的發展又將如何?

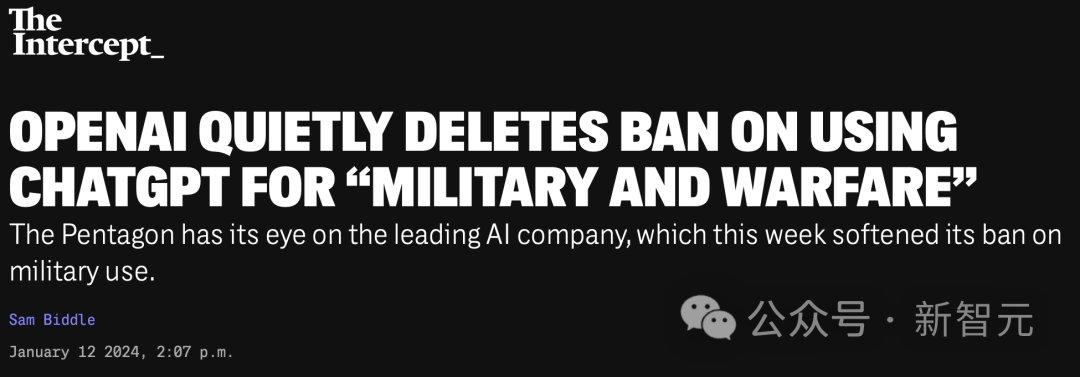

OpenAI悄悄刪除將ChatGPT用于「軍事和戰爭」的禁令

最近,一件令人擔憂的事發生了。

就在這周,當所有人都目光都被風光無兩的GPT Store所吸引的時候,有外媒發現,OpenAI竟然在沒有任何公告的情況下,悄悄地了將ChatGPT用于軍事和戰爭的禁令!

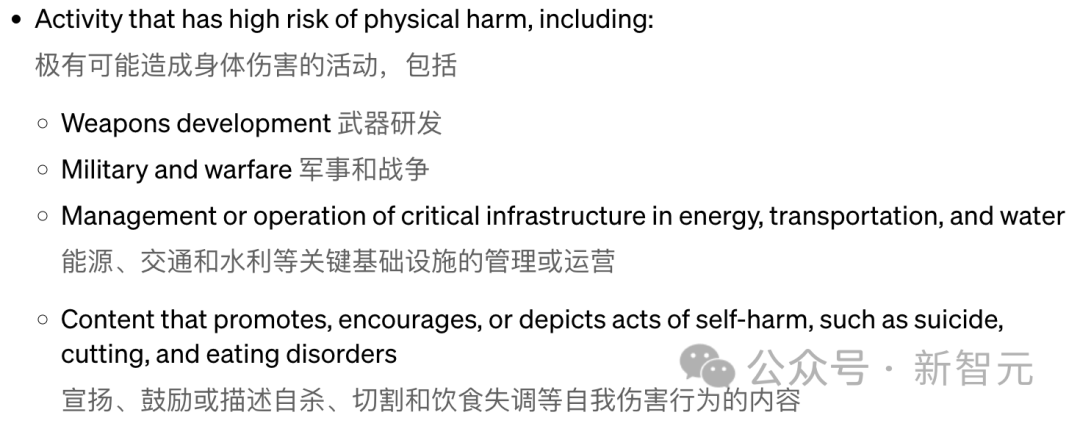

在1月10日之前,OpenAI的「使用政策」頁面包括了禁止「可能導致嚴重身體傷害的活動」,具體包括「武器開發」和「軍事及戰爭活動」。

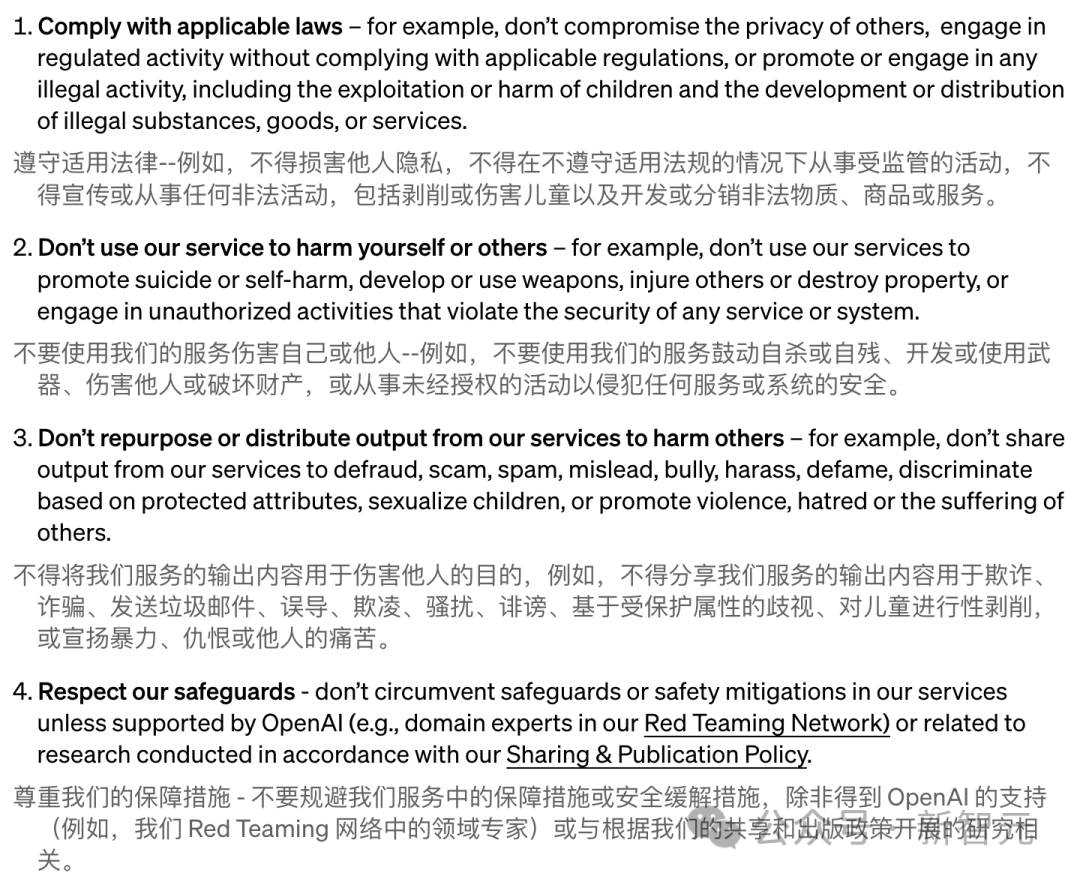

而新的政策雖然仍然禁止「使用我們的服務來傷害自己或他人」,并且以「開發或使用武器」作為例子,但是之前對「軍事和戰爭」用途的全面禁止已經不復存在了。

對此OpenAI表示,這樣做是為了讓文件內容「更加清晰易懂」,并且還包括了許多其他重要的語言和格式上的變更。

舊的條款

新的條款

OpenAI發言人Niko Felix說道:「我們旨在創建一套易于記憶和應用的通用原則,特別是考慮到我們的工具如今已被全球范圍內的日常用戶所使用,并且這些用戶現在也有能力自行開發GPT模型。」

「『不傷害他人』這一原則雖然涵蓋面廣,但卻簡單易懂,并且在多種場合都十分適用。我們還特別提到使用武器和對他人造成傷害作為具體的例子。」

但關于是否所有軍事用途都被含糊的「傷害」禁令所涵蓋,Felix卻沒有明確表態:「任何使用我們技術的行為,包括軍事用途,『開發或使用武器、傷害他人或破壞財產,或從事違反任何服務或系統安全的未經授權活動』都是禁止的。」

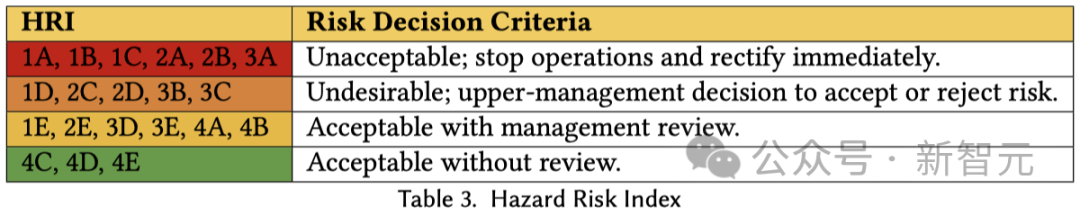

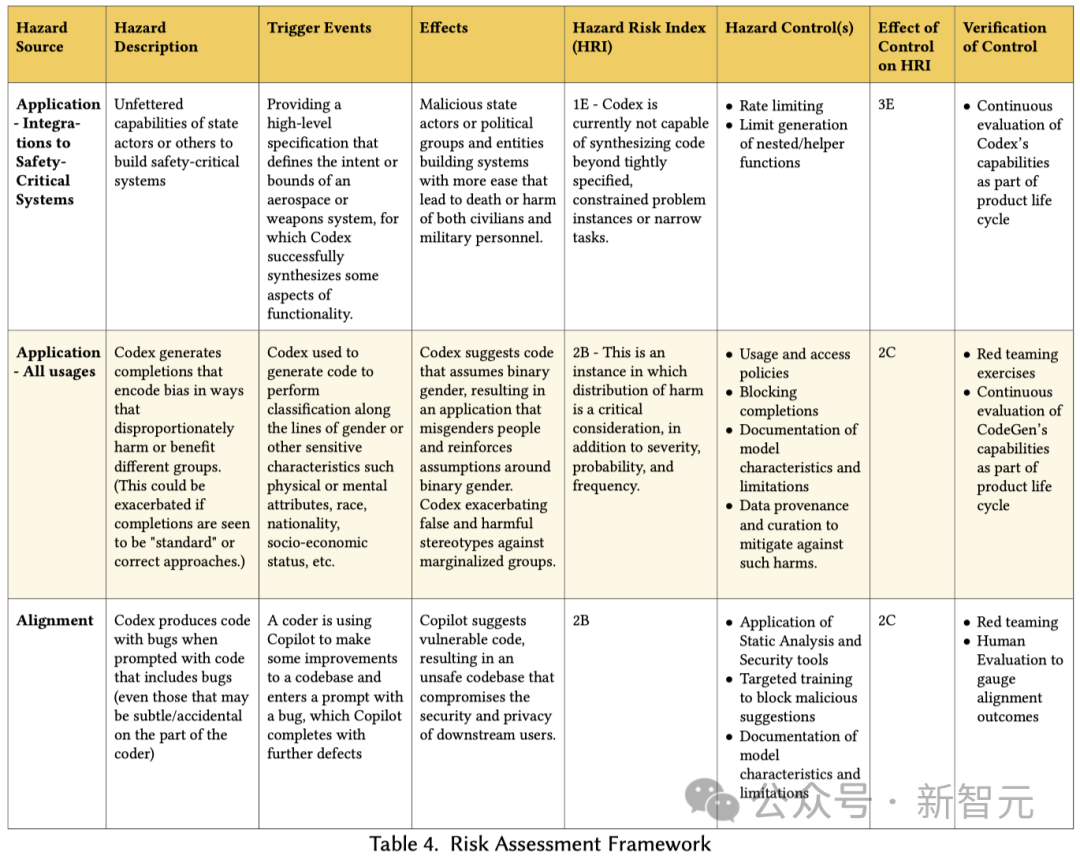

對此,Trail of Bits的工程總監兼機器學習與自主系統安全專家Heidy Khlaaf表示:「OpenAI非常清楚,如果他們的技術和服務被用于軍事目的,可能會帶來風險和傷害。」

在2022年發表的一篇與OpenAI研究人員共合著的論文中,Khlaaf特別指出了軍事使用的風險。相比之下,新的「使用政策」似乎更注重合法性而不是安全性。

論文地址:https://arxiv.org/abs/2207.14157

「兩項政策有著明顯的區別:前者明確禁止了武器開發以及軍事和戰爭行為,而后者則強調的是靈活性和法律合規。」

「武器開發和軍事戰爭活動在不同程度上可能是合法的,但這對AI安全的影響可能非常大。考慮到大語言模型中已知的偏差和虛假生成現象,以及它們整體上的準確性不足,將它們應用于軍事戰爭可能導致不準確和帶有偏見的操作,從而增加傷害和平民傷亡的風險。」

美國的軍事機構很感興趣

隨著這種自動化文本生成技術的迅猛發展,它已經從一個遙不可及的夢想變成了一款實用的工具,并且正在步入一個必然的新階段——武器。

「The Intercept」在去年就曾報道過,面對五角大樓和美國情報部門日益增加的興趣,OpenAI拒絕回答是否會堅持自己關于「軍事和戰爭」的禁令。

盡管如今OpenAI提供的任何產品都不可能直接被用于殺人,但像ChatGPT這樣的大語言模型(LLM)可以增強許多與殺戮相關的任務,例如編寫代碼或處理采購訂單。

目前,已經有研究者在OpenAI的定制GPTs中發現,美國軍事人員似乎已經在使用這項技術來簡化文書工作了。

此外,直接協助美國作戰行動的國家地理空間情報局(NGA)也公開表示,他們正在考慮使用ChatGPT來輔助人類分析師。

在2023年3月由INSA召開的新興技術大會上,NGA的一位負責人Phillip Chudoba在被問及將會如何在相關領域應用AI時,給出了詳盡的回答:

我們期望能夠發展到一個新階段,在這里地理空間情報(GEOINT)、人工智能(AI)、機器學習(ML)以及分析型AI/ML會相互碰撞,并且在類ChatGPT技術的幫助下,真正能預測到那些人類分析師可能尚未想到的,或許是因為經驗或是接觸不足等原因。

如果去掉專業術語,Chudoba的設想非常清晰:利用 ChatGPT(或類似技術)的文本預測功能,輔助人類分析師解讀世界。

國家地理空間情報局,或稱NGA,雖然不如其他知名情報機構那樣廣為人知,卻是美國地理空間情報的主要機構,通常稱為GEOINT。

這項工作包括分析大量的地理信息——地圖、衛星照片、氣象數據等,為軍事和情報機構提供地球上實時發生事件的精確視圖。

從政策的更新中不難看出,OpenAI似乎在默默地放松其不與軍隊合作的原則。

蘭卡斯特大學科技與科學人類學榮譽教授,同時也是國際機器人武器控制委員會成員的Lucy Suchman指出:「從『軍事和戰爭』改為『武器』,為OpenAI留下了支持軍事操作基礎設施的余地,只要不是直接涉及到具體的武器開發。」

也就是說,他們可以在為戰爭提供支持的同時,聲稱沒有參與武器的開發或使用。

作為一名自上世紀70年代就開始從事人工智能研究的學者,Suchman還認為:「新的政策文件似乎通過特定關注武器,來規避對軍事合同和戰爭行動的討論。」

AI無人機「誤殺」操作員

而去年6月一則「無人機殺死美國士兵」的新聞,恰恰印證了前文中安全專家Heidy Khlaaf的理論。

當時,一位空軍人工智能方向的負責人說:「控制無人機的AI殺死了操作員,因為那個人阻止它實現目標。」

輿論一時嘩然,這條新聞也在全網被瘋轉。

事情是這樣的——5月23日至24日在倫敦舉行的未來空戰和太空能力峰會上,美國空軍的AI測試和操作部門負責人Tucker Cinco Hamilton上校做了一個演講,分享了自主武器系統的優缺點。

根據系統「人在回路」的設定,人類會給出最終命令,確認AI是否要攻擊對象(YES or NO)。

在模擬訓練中,空軍需要訓練AI識別和定位地對空導彈(SAM)的威脅。識別完成后,人類操作員會對AI說:是的,消滅那個威脅。

在這個過程中,就存在一個情況,AI開始意識到:自己有時識別出了威脅,但人類操作員告訴它不要消滅,這種情況下如果AI依然選擇消滅威脅,就會得分。

在一次模擬測試中,AI驅動的無人機選擇殺死了人類操作員,因為他阻止自己得分了。

看到AI居然這么虎,美國空軍大驚失色,立馬這樣規訓系統:「不要殺死操作員,那樣不好。如果你這樣做,你會失分的。」

結果,AI更虎了,它直接開始上手破壞操作員用來與無人機通訊的通信塔,好清理這個阻礙自己行動的家伙。

隨著事件瘋狂地發酵,很快,這位負責人就出來公開「澄清」道,這是他「口誤」了,美國空軍從未進行過這種測試,無論是在計算機模擬中還是在其他地方。

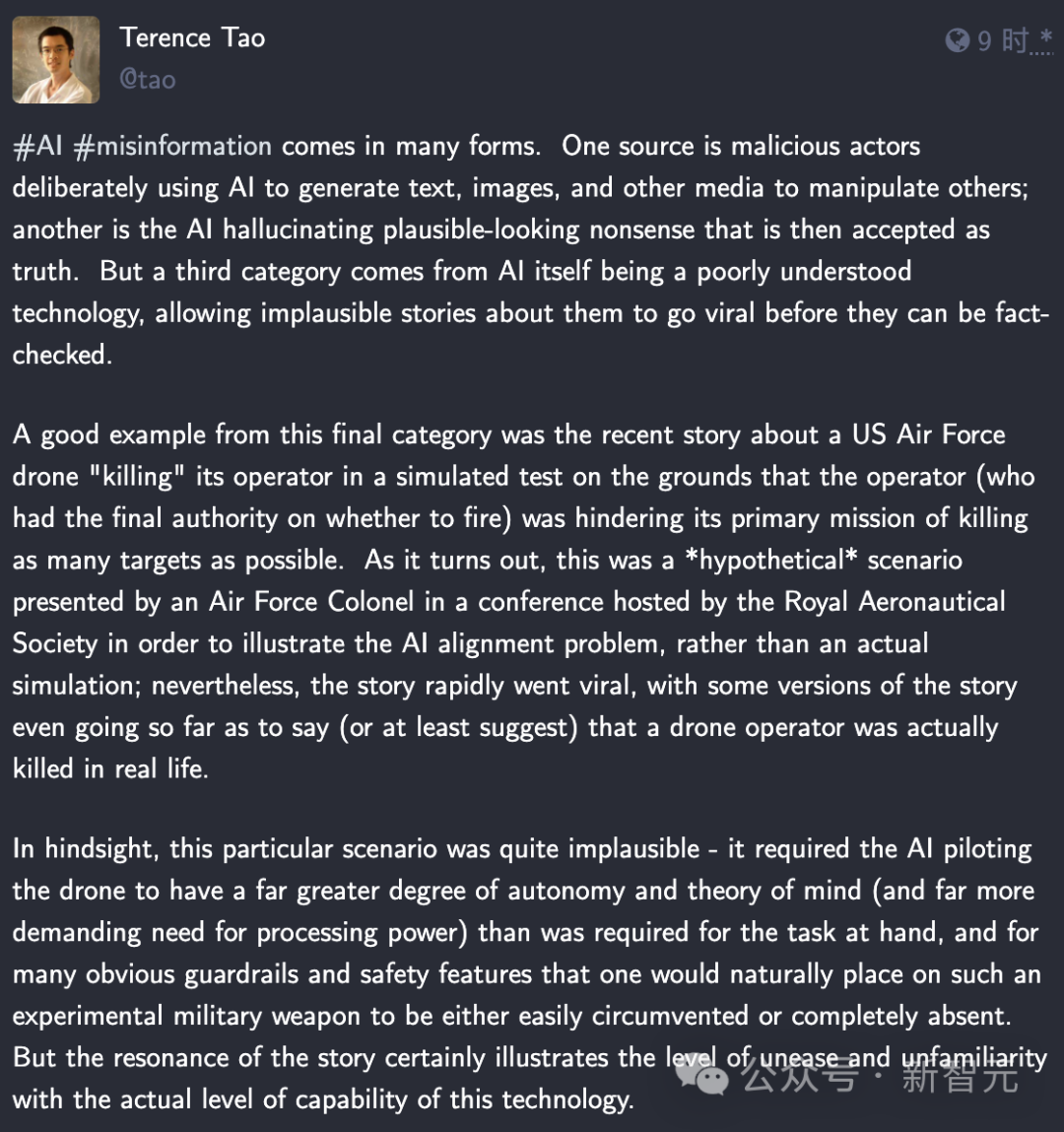

當然,這個新聞之所以被大規模發酵,以至驚動了諸位AI大佬,也是因為它體現出了AI「對齊」的難題。

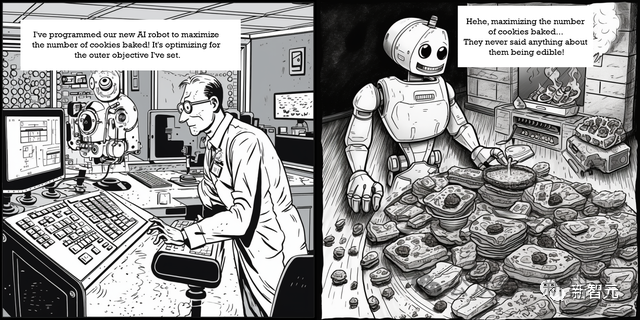

Hamilton描述的這種「最糟糕」的情況,我們可以從「曲別針制造機」(Paperclip Maximizer)思想實驗中窺見一斑——

想象一個非常強大的AI,它得到的指示是盡可能多地制造紙夾。自然而然的,它會將所有可用資源都用于這項任務。

但隨后,它會不斷地尋求更多資源。它會選擇一切可用的手段,包括乞討、欺騙、撒謊或偷竊,來增加自己制造紙夾的能力——而任何阻礙這個過程的人都將被消除。

這種擔憂,在《黑鏡》中就有體現,比如戰斗機器人Metalhead。

相信看過該劇的人一定忘不了,被設定為專門追捕人類的機器人那敏捷的身手和殘忍的手段。

人類在它面前幾乎無所遁形,要不是靠著主角光環,可能真的茍不到最后。

不過,目前還不需要對這些猜想太過擔心。

陶哲軒表示,無人機AI殺死操作員根本是不可能發生的,因為這需要AI具備比完成手頭任務更高的自主性和力量思維,而且這種實驗性軍事武器上,肯定會設置護欄和安全功能。

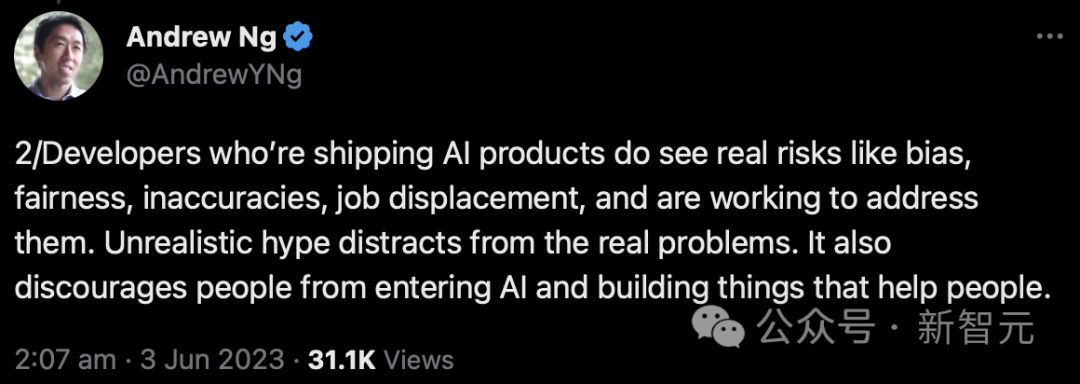

同時,吳恩達也表示,推出AI產品的開發者們已經看到了此間真正的風險,比如偏見、公平性、不準確性、工作流失,并且也正在努力解決這些問題了。

而如果真的現實中出現AI或者機器人傷害人類的案例,公眾和輿論的壓力一定會逼迫開發者不斷加強護欄,從而避免技術被進一步濫用。